Maison >Périphériques technologiques >IA >Pré-formation sans attention ; apprentissage en contexte piloté par GPT

Pré-formation sans attention ; apprentissage en contexte piloté par GPT

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-14 17:31:031193parcourir

Papier 1 : ClimateNeRF : Rendu neuronal basé sur la physique pour la synthèse climatique extrême

- Auteur : Yuan Li et al

- Adresse du papier : https://arxiv.org/pdf/2211.13226 . pdf

Résumé : Cet article présente une nouvelle méthode de fusion de simulations physiques avec des modèles NeRF de scènes pour générer des films réalistes des phénomènes physiques dans ces scènes. En termes de résultats concrets, la méthode peut simuler de manière réaliste les effets possibles du changement climatique : à quoi ressemblerait un terrain de jeu après une inondation à petite échelle ? Et après le grand déluge ? Et après le blizzard ?

Recommandation : Brumeux, hivernal et inondé en une seconde, le nouveau modèle NeRF restitue des superproductions physiques réalistes.

Passage 2 : Pré-entraînement sans attention

- Auteur : Junxiong Wang et al

- Adresse du papier : https://arxiv.org/pdf/2212.10544.pdf

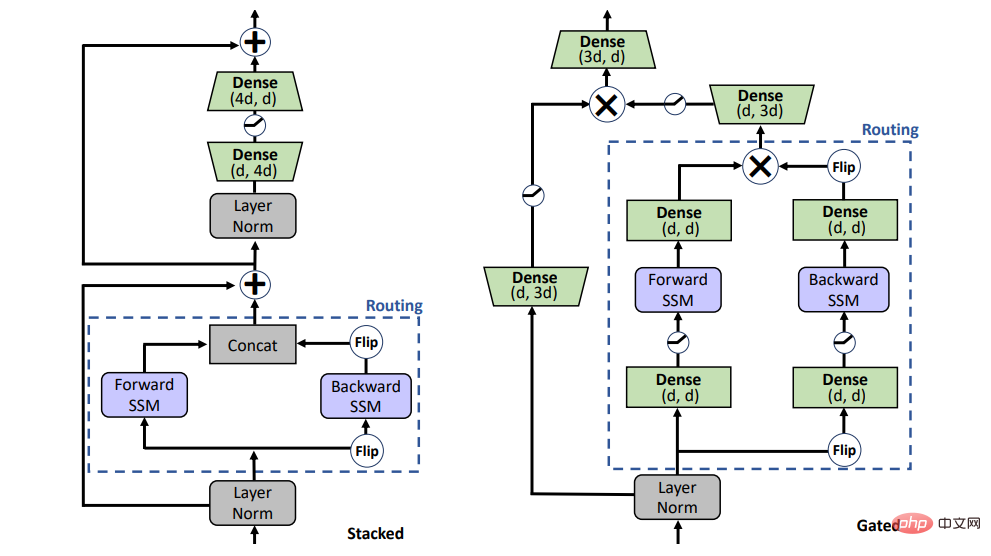

Résumé : Cet article propose un modèle SSM bidirectionnel (BiGS), qui combine la couche de routage basée sur le modèle spatial d'état (SSM) et l'architecture de modèle basée sur une porte de multiplication, qui peut reproduire les résultats de pré-formation BERT. sans faire attention, et peut être étendu à un pré-entraînement à longue portée de 4096 jetons sans avoir besoin d'approximation.

Recommandation : La pré-formation ne nécessite aucune attention et la mise à l'échelle jusqu'à 4096 jetons n'est pas un problème, comparable au BERT.

Article 3 : Un modèle pour les éditer tous : Manipulation d'images pilotées par texte de forme libre avec modulations sémantiques

- Auteur : Yiming Zhu et al

- Adresse de l'article : https : / /arxiv.org/pdf/2210.07883.pdf

Résumé : Récemment, l'utilisation de texte pour guider l'édition d'images a fait l'objet de grands progrès et d'une grande attention, notamment sur la base de modèles de diffusion débruitants tels que StableDiffusion ou DALLE. Cependant, l'édition texte-image basée sur le GAN présente encore quelques problèmes qui attendent d'être résolus. Par exemple, dans le StyleCILP classique, un modèle doit être formé pour chaque texte. Cette approche de texte unique à modèle unique n'est pas pratique en pratique. candidatures.

Cet article propose FFCLIP et résout ce problème. Pour des saisies de texte différentes et flexibles, FFCLIP n'a besoin que d'un seul modèle pour éditer l'image en conséquence, sans avoir besoin de recycler le modèle pour chaque texte, et sur plusieurs ensembles de données. Tout a été très bien réalisé. résultats. Cet article a été accepté par NeurIPS 2022.

Recommandé : Un nouveau paradigme pour l'édition de texte et d'images, un modèle unique réalise l'édition d'images guidées multi-textes.

Papier 4 : AUTO-INSTRUCTION : Aligner le modèle de langage avec les instructions auto-générées

- Auteur : Yizhong Wang et al

- Adresse du papier : https://arxiv.org/pdf / 2212.10560v1.pdf

Résumé : L'Université de Washington et d'autres institutions ont récemment publié conjointement un article proposant un nouveau cadre SELF-INSTRUCT qui améliore la conformité aux instructions des modèles de langage pré-entraînés en guidant le modèle. propre capacité de processus de génération. SELF-INSTRUCT est un processus semi-automatique qui effectue le réglage des instructions sur un LM pré-entraîné en utilisant les signaux d'instruction du modèle lui-même.

Recommandé : Pas besoin d'annotation manuelle, le cadre d'instructions auto-généré élimine le goulot d'étranglement des coûts des LLM tels que ChatGPT. I Article 5 : Calcul AB Initio de solides réels via le réseau neuronal Ansatz

Auteur : xiang Li et autres

- Adresse de l'article : https://www.nature com/articles. /s41467-022-35627-1

- Résumé : L'apprentissage automatique peut traiter des données massives, résoudre des problèmes scientifiques dans des scénarios complexes et mener l'exploration scientifique vers de nouveaux domaines qui étaient inaccessibles dans le passé. Par exemple, DeepMind utilise le logiciel d'intelligence artificielle AlphaFold pour faire des prédictions très précises de presque toutes les structures protéiques connues de la communauté scientifique ; la méthode de vélocimétrie par image de particules (PIV) basée sur l'apprentissage profond proposée par Christian Lagemann a grandement amélioré le réglage original purement manuel. de paramètres. Le champ d’application du modèle revêt une importance vitale pour la recherche dans de nombreux domaines tels que l’automobile, l’aérospatiale et le génie biomédical.

Récemment, le travail "Calcul ab initio de solides réels via un réseau neuronal ansatz" de l'équipe de recherche du ByteDance AI Lab et du groupe de recherche de Chen Ji à l'École de physique de l'Université de Pékin a donné une nouvelle idée pour étudier la physique de la matière condensée. proposé Développement de la première fonction d'onde de réseau neuronal de l'industrie adaptée aux systèmes solides, réalisation de calculs de principes fondamentaux pour les solides et poussée des résultats de calcul jusqu'à la limite thermodynamique. Cela prouve clairement que les réseaux de neurones sont des outils efficaces pour étudier la physique du solide, et indique également que la technologie d’apprentissage profond jouera un rôle de plus en plus important dans la physique de la matière condensée. Les résultats de recherche pertinents ont été publiés dans la principale revue internationale Nature Communication le 22 décembre 2022.

Recommandé : La première fonction d'onde de réseau neuronal de l'industrie adaptée aux systèmes solides a été publiée dans une sous-revue Nature.

Papier 6 : Pourquoi GPT peut-il apprendre en contexte ? Les modèles de langage effectuent secrètement une descente de gradient en tant que méta-optimiseurs

Auteur : Damai Dai et al

- Adresse du papier : https : / /arxiv.org/pdf/2212.10559v2.pdf

- Résumé : L'apprentissage en contexte (ICL) a obtenu un grand succès sur de grands modèles de langage pré-entraînés, mais son mécanisme de fonctionnement reste une question ouverte question. Dans cet article, des chercheurs de l'Université de Pékin, de l'Université Tsinghua et de Microsoft comprennent l'ICL comme une sorte de réglage fin implicite et fournissent des preuves empiriques pour prouver que l'ICL et le réglage précis explicite fonctionnent de la même manière à plusieurs niveaux.

Recommandé : Pourquoi l'apprentissage en contexte, piloté par GPT, fonctionne-t-il ? Le modèle effectue une descente de gradient en secret.

Article 7 : Indications expérimentales des fonctions cérébrales non classiques

Auteur : Christian Matthias Kerskens et al

- Adresse de l'article : https://iopscience.iop.org/article / 10.1088/2399-6528/ac94be

- Résumé : Depuis des décennies, les scientifiques explorent les mécanismes informatiques et de réflexion du cerveau humain. Cependant, la structure du cerveau humain est trop complexe, contenant des dizaines de milliards de neurones, l'équivalent de milliards de puces, il nous est donc difficile de la découvrir. Roger Penrose, qui a remporté le prix Nobel de physique pour sa contribution à l'étude des trous noirs, a un jour proposé avec audace l'idée de « conscience quantique », c'est-à-dire que le cerveau humain lui-même est une structure quantique, ou un ordinateur quantique. Mais ce point de vue a été remis en question.

Une étude récente de la Trinity University de Dublin suggère que notre cerveau effectue des calculs quantiques, arguant qu'il existe un enchevêtrement dans le cerveau humain médié par les fonctions cérébrales liées à la conscience. Si ces fonctions cérébrales doivent fonctionner de manière non classique, cela signifie que la conscience n'est pas classique, c'est-à-dire que les processus cognitifs du cerveau impliquent des calculs quantiques.

Recommandation : Il existe de nouvelles preuves de cette spéculation selon laquelle la pensée du cerveau est l’informatique quantique.

Radio hebdomadaire ArXiv

Heart of Machine coopère avec la radio hebdomadaire ArXiv initiée par Chu Hang et Luo Ruotian pour sélectionner cette semaine des articles plus importants sur la base de 7 articles, dont 10 articles sélectionnés dans les domaines de la PNL, du CV et du ML, et fournit le format audio Le résumé de l'article, les détails sont les suivants :

10 NLP PapersAudio : 00:0020:18

10 articles en vedette sur la PNL semaine Oui :

1. L'induction grammaticale non supervisée a-t-elle besoin de pixels ?. (de Serge Belongie, Kilian Q. Weinberger, Jitendra Malik, Trevor Darrell)

2. Zero -Shot Debiasing. (de Bernhard Schölkopf)

3. Lutter contre l'ambiguïté avec des images : traduction automatique multimodale améliorée et évaluation contrastée (de Cordelia Schmid, Ivan Laptev)

4. Vision - Alignement des relations linguistiques (de Ruslan Salakhutdinov, Louis-Philippe Morency)

5 Sur l'utilisation de données parallèles pour l'estimation de la qualité de la traduction)

6. - Comme l'évaluation pour la génération de langage naturel avec analyse d'erreurs. (de Dacheng Tao)

7. Les modèles de dialogue orientés tâches actuels peuvent-ils automatiser des scénarios du monde réel dans la nature ? (de Kyunghyun Cho)

8. Sur les angles morts des mesures d'évaluation basées sur un modèle pour la génération de texte. (de Kyunghyun Cho)

9. Au-delà de l'apprentissage contrastif : un modèle génératif variationnel pour la récupération multilingue (de William W. Cohen)

10. L'impact des représentations symboliques sur l'apprentissage en contexte pour le raisonnement à quelques coups (de Li Erran Li, Eric Xing)

10 CV PapersAudio :00:0023:15

Les 10 articles de CV sélectionnés cette semaine sont :

1 Revisiter les réseaux résiduels pour la robustesse adverse : une perspective architecturale (de Kalyanmoy Deb)

2. Relations spatiales dans la génération de texte en image. (d'Eric Horvitz)

3. Une brève enquête sur la reconnaissance des personnes à distance (de Rama Chellappa)

4. Rama Chellappa) Leonidas Guibas, William T. Freeman)

5. L'alias est un moteur d'attaques contradictoires (d'Antonio Torralba)

6. . Hi- LASSIE : Découverte de formes articulées et de squelettes haute fidélité à partir de Sparse Image Ensemble (de Ming-Hsuan Yang)

8. Augmentation de points au niveau de l'objet d'apprentissage pour la détection d'objets 3D semi-supervisée. Yang)

9. Libérer la puissance de l'invite visuelle au niveau des pixels (d'Alan Yuille)

.10. Des images aux invites textuelles : VQA Zero-shot avec de grands modèles de langage gelés. (de Dacheng Tao, Steven C.H. Hoi)

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI