Maison >Périphériques technologiques >IA >La multimodalité à nouveau unifiée ! Meta lance l'algorithme auto-supervisé data2vec 2.0 : l'efficacité de l'entraînement est multipliée par 16 !

La multimodalité à nouveau unifiée ! Meta lance l'algorithme auto-supervisé data2vec 2.0 : l'efficacité de l'entraînement est multipliée par 16 !

- 王林avant

- 2023-04-14 16:10:031304parcourir

La plupart des avancées dans le domaine de l'intelligence artificielle ces dernières années ont été motivées par l'apprentissage auto-supervisé. Par exemple, le MLM (Masked Language Model) proposé dans BERT, en masquant certains mots dans le texte puis en les réutilisant. -prédire, des données textuelles massives non étiquetées peuvent être utilisées pour entraîner des modèles, ce qui a depuis ouvert une nouvelle ère de modèles pré-entraînés à grande échelle. Cependant, les algorithmes d’apprentissage auto-supervisés présentent également des limites évidentes. Ils ne conviennent généralement qu’aux données dans une seule modalité (telles que les images, le texte, la parole, etc.) et nécessitent une grande puissance de calcul pour apprendre à partir de données massives. En revanche, les humains apprennent beaucoup plus efficacement que les modèles d’IA actuels et peuvent apprendre à partir de différents types de données.

En janvier 2022, Meta AI a publié le cadre d'apprentissage auto-supervisé data2vec, qui intègre trois modalités de données (voix, vision et texte) dans un seul cadre. tendance à unifier la multimodalité. Récemment Meta AI a publié data2cec version 2.0 , qui a principalement amélioré la génération précédente en termes de performances : avec la même précision, la vitesse d'entraînement est comparée à celle des autres l'algorithme a été amélioré jusqu'à 16 fois !

Lien papier : https://ai.facebook.com/research/publications/e efficace -apprentissage-auto-supervisé-avec-représentations-cibles-contextualisées-pour-la-vision-parole-et-langage

Lien de code :https://github.com /facebookresearch/fairseq/tree/main/examples/data2vec

data2vec 1.0

Actuellement, la plupart des modèles d'apprentissage automatique sont toujours basés sur des modèles d'apprentissage supervisé, qui nécessitent des annotateurs pour étiqueter les données cibles, mais pour certaines tâches (comme les milliers de langues humaines sur la planète), la collecte de données étiquetées n'est pas réalisable.

En revanche, l'apprentissage auto-supervisé n'a pas besoin d'indiquer au modèle ce qui est correct et faux, mais permet à la machine d'apprendre la structure des images, de la parole et du texte en observant le monde. Les résultats de recherches connexes ont favorisé le développement de la parole (par exemple, wave2vec 2.0), de la vision par ordinateur (par exemple, l'encodeur automatique masqué) et du traitement du langage naturel (par exemple, BERT).

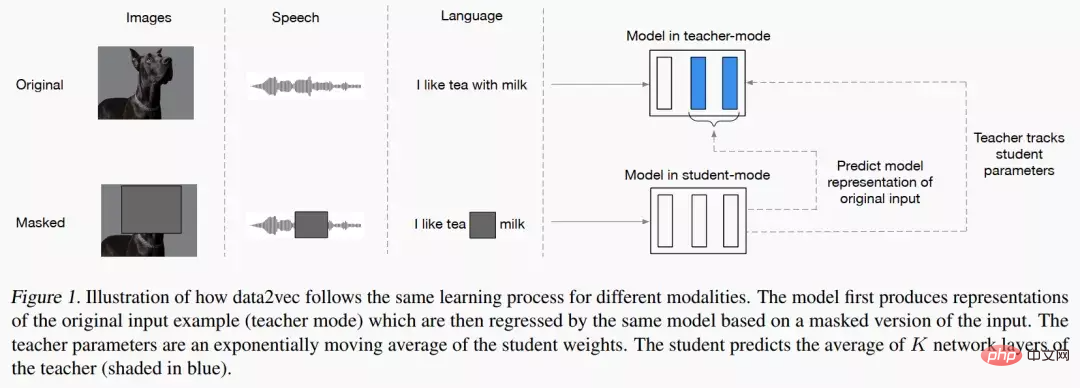

L'idée principale de data2vec est d'abord de construire un réseau d'enseignants et de calculer d'abord la représentation cible à partir d'images, de texte ou de discours. Les données sont ensuite masquées pour masquer certaines parties de l'entrée, et le processus est répété avec un réseau d'étudiants pour prédire les représentations obtenues par le modèle d'enseignant.

En d'autres termes, le modèle étudiant ne peut prédire que la représentation de « données d'entrée complètes » tout en acceptant des « informations d'entrée incomplètes ». Afin d'assurer la cohérence des deux modèles, les paramètres des deux modèles sont partagés, mais les paramètres du modèle Enseignant seront mis à jour plus rapidement dans les premières étapes de la formation. En termes de résultats expérimentaux, data2vec a considérablement amélioré les performances par rapport au modèle de base en matière de parole, de vision, de texte et d'autres tâches.

data2vec 2.0

data2vec propose un cadre général d'apprentissage auto-supervisé qui unifie l'apprentissage de trois données modales de la parole, de la vision et du langage, et data2vec2.0 résout principalement les problèmes Autrement dit, la création d'un modèle auto-supervisé nécessite une grande quantité de puissance de calcul GPU pour terminer la formation. Semblable à l'algorithme data2vec original, data2vec 2.0 prédit les représentations contextualisées de données ou les couches de réseaux neuronaux, plutôt que de prédire les pixels des images, les mots des segments de texte ou la parole.

Contrairement à d'autres algorithmes courants, ces soi-disant représentations cibles sont contextuelles, ce qui signifie que l'algorithme doit prendre en compte l'ensemble de l'exemple de formation.

Par exemple, le modèle apprend la représentation du mot banque sur la base de la phrase entière contenant banque, ce qui facilite la déduction du sens correct du mot, par exemple en distinguant s'il fait spécifiquement référence à « financier » institution » ou « terrain au bord de la rivière » ». Les chercheurs pensent que les objectifs contextualisés faciliteront des tâches d’apprentissage plus riches et permettront à data2vec 2.0 d’apprendre plus rapidement que les autres algorithmes.

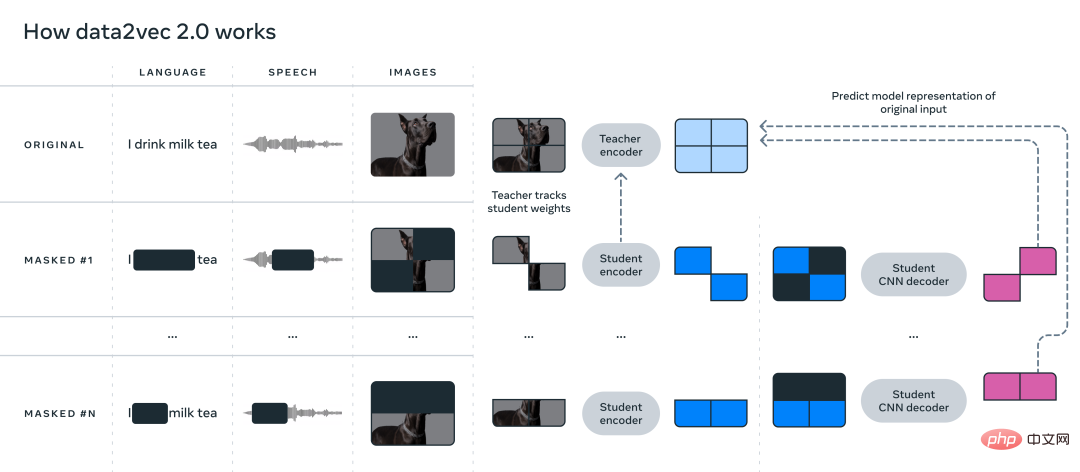

data2vec 2.0 améliore l'efficacité de l'algorithme data2vec d'origine des trois manières suivantes :

1. Construisez une représentation cible pour un exemple d'entraînement spécifique et réutilisez cette représentation dans le masque version. Dans la version masquée, différentes parties des exemples de formation sont masquées de manière aléatoire. Les représentations apprises par les deux versions sont ensuite introduites dans le modèle d'étudiant, qui prédit la même représentation cible contextualisée pour différentes versions de masque, amortissant ainsi l'effort de calcul requis pour créer la représentation cible.

2. Semblable à l'auto-encodeur masqué (MAE), le réseau d'encodeurs dans le modèle étudiant n'exploite pas la partie masquée des exemples de formation. Dans les expériences d’images, environ 80 % des sections étaient vierges, ce qui a permis d’importantes économies de cycles de calcul.

3. Un modèle de décodeur plus efficace est utilisé, qui ne repose plus sur le réseau Transformer, mais s'appuie sur un réseau convolutif multicouche.

Section expérimentale

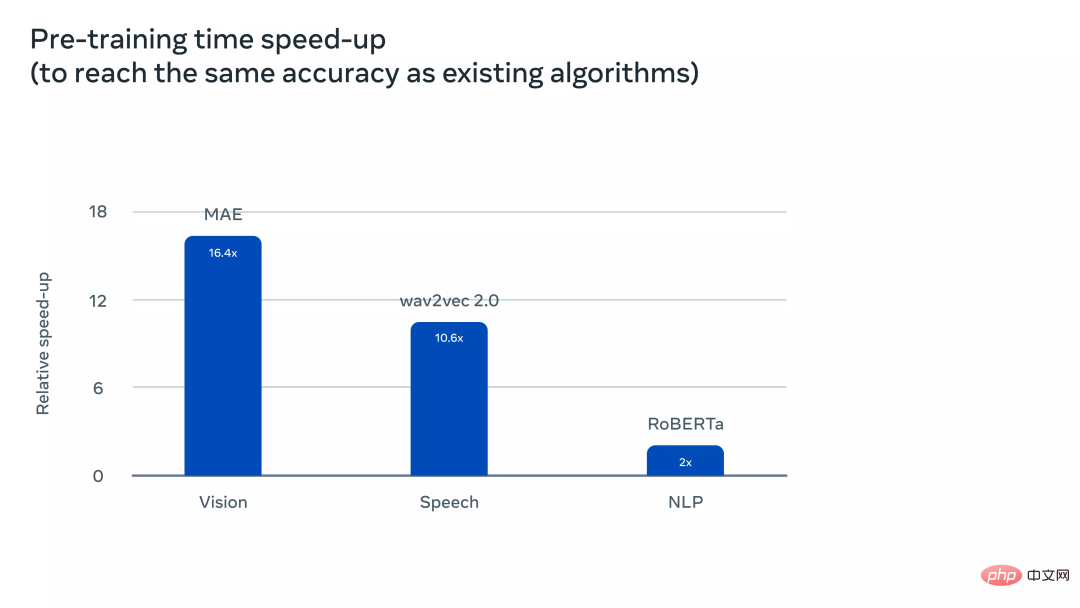

Pour comprendre plus intuitivement à quel point data2vec 2.0 est plus efficace que data2vec et d'autres algorithmes similaires, les chercheurs ont mené des expériences approfondies sur des benchmarks liés aux tâches de vision par ordinateur, de parole et de texte. Dans l'expérience, la précision finale et le temps nécessaire au pré-entraînement du modèle ont été principalement pris en compte. L'environnement expérimental était sur le même matériel (modèle GPU, quantité, etc.) pour mesurer la vitesse d'exécution de l'algorithme.

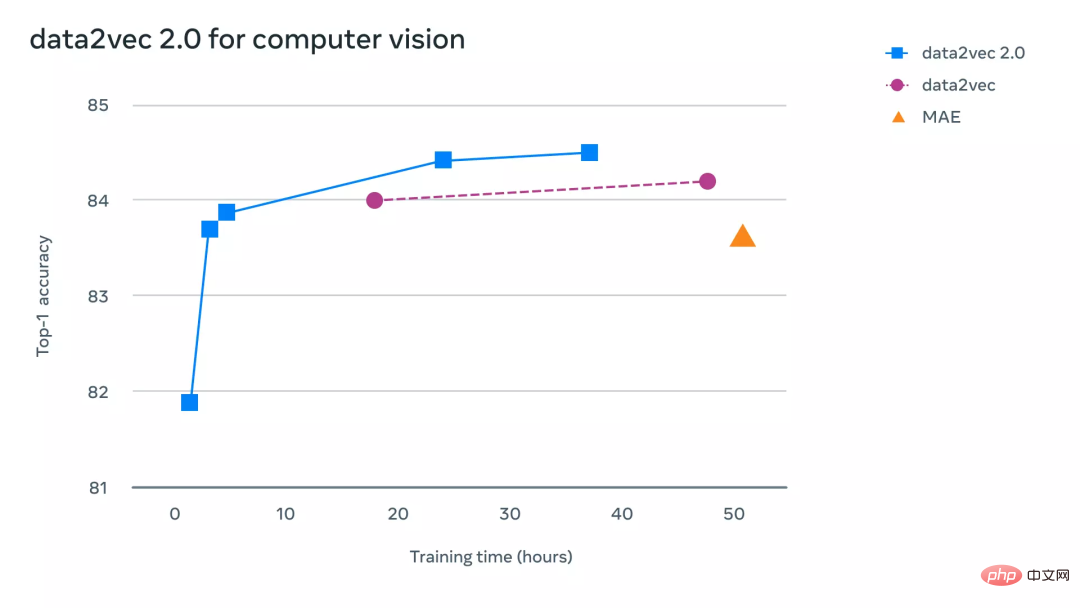

Sur les tâches de vision par ordinateur, les chercheurs ont évalué data2vec 2.0 sur le benchmark standard de classification d'images ImageNet-1K, un ensemble de données à partir duquel le modèle apprend les représentations d'images. Les résultats expérimentaux montrent que data2vec 2.0 peut égaler la précision de l'auto-encodeur masqué (MAE), mais est 16 fois plus rapide.

Si vous continuez à donner plus de temps d'exécution à l'algorithme data2vec 2.0, il peut atteindre une plus grande précision tout en étant plus rapide que MAE.

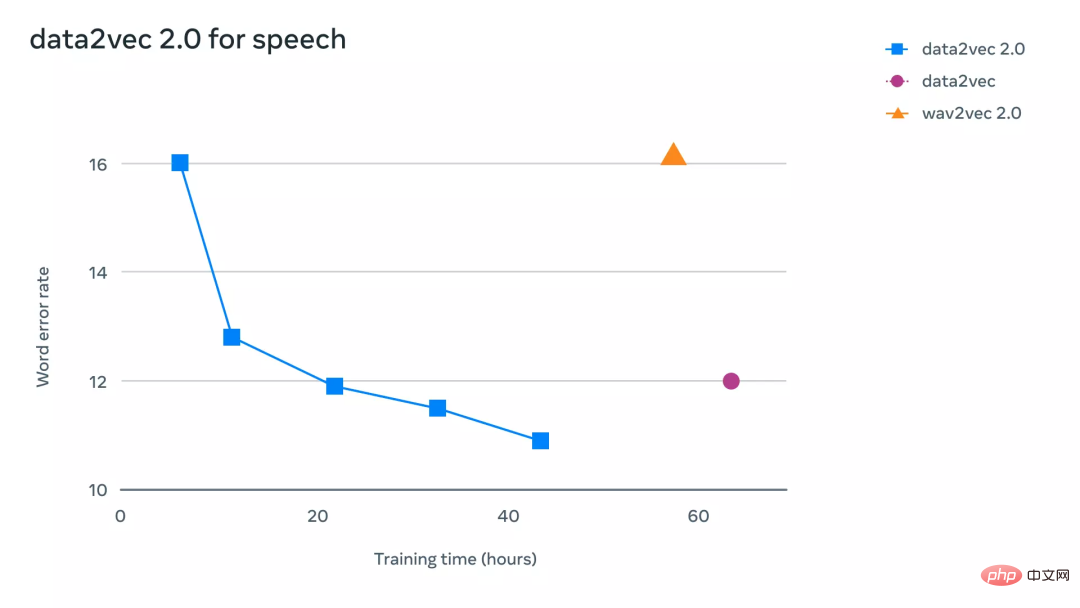

Sur la tâche vocale, les chercheurs l'ont testé sur le benchmark de reconnaissance vocale LibriLanguage, et il était plus de 11 fois plus précis que wave2vec 2.0.

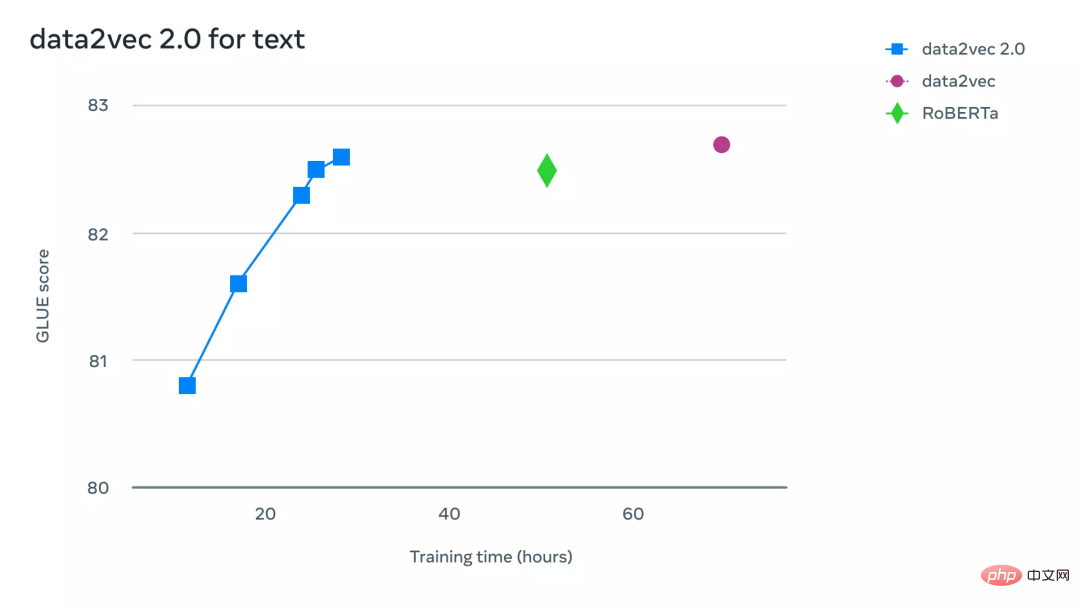

Pour les tâches de traitement du langage naturel, les chercheurs ont évalué data2vec 2.0 sur le benchmark General Language Understanding Evaluation (GLUE), obtenant la même précision que RoBERTa, une réimplémentation de BERT, en seulement la moitié du temps de formation.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI