Maison >Périphériques technologiques >IA >DetectGPT : détection de texte générée par machine sans tir à l'aide d'une courbure probabiliste

DetectGPT : détection de texte générée par machine sans tir à l'aide d'une courbure probabiliste

- PHPzavant

- 2023-04-14 10:13:021584parcourir

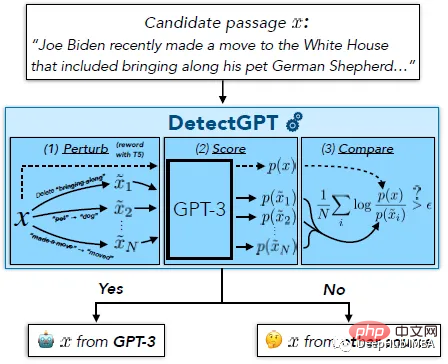

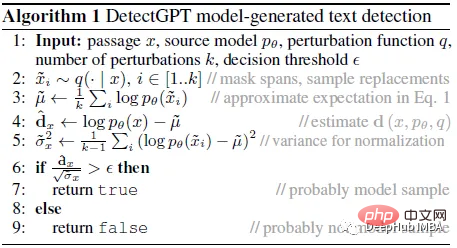

Le but de DetectGPT est de déterminer si un morceau de texte a été généré par un llm spécifique, tel que GPT-3. Pour classer le paragraphe x, DetectGPT génère d'abord une petite perturbation sur le paragraphe ~xi à l'aide d'un modèle commun pré-entraîné (par exemple, T5). DetectGPT compare ensuite la probabilité logarithmique de l'échantillon d'origine x avec chaque échantillon perturbé ~xi. Si le rapport logarithmique moyen est élevé, l'échantillon provient probablement du modèle source.

ChatGPT est un sujet brûlant. Des discussions sont en cours pour savoir s'il est possible de détecter qu'un article a été généré par un grand modèle de langage (LLM). DetectGPT définit un nouveau critère basé sur la courbure pour juger s'il faut générer à partir d'un LLM donné. DetectGPT ne nécessite pas de formation d'un classificateur distinct, de collecte d'un ensemble de données de passages réels ou générés, ni de filigrane explicite du texte généré. Il utilise uniquement les probabilités logarithmiques calculées par le modèle d'intérêt et les perturbations aléatoires d'article provenant d'un autre modèle de langage pré-entraîné à usage général (par exemple, T5).

1. DetectGPT : permutations et hypothèses aléatoires

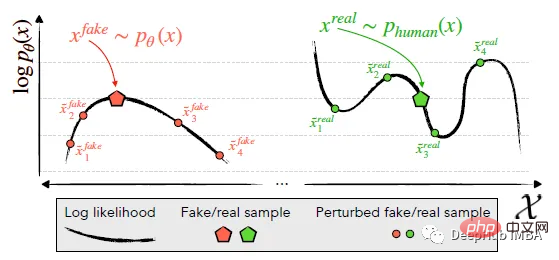

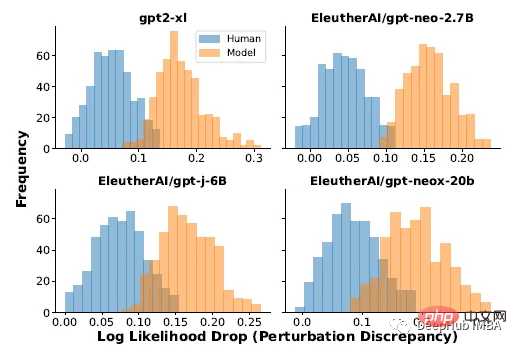

identifie et exploite la tendance des canaux générés par la machine x~pθ (à gauche) à se situer dans la région de courbure négative de logp (x), où les échantillons proches ont une moyenne inférieure Probabilité du journal du modèle. En revanche, le texte écrit par l'homme x~preal(.) (à droite) a tendance à ne pas occuper de régions présentant une courbure de log-probabilité négative significative.

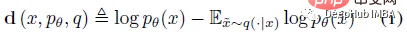

DetectGPT est basé sur l'hypothèse selon laquelle les échantillons du modèle source pθ se trouvent généralement dans la région de courbure négative de la fonction de probabilité logarithmique pθ, qui est différente du texte humain. Si nous appliquons une petite perturbation à un morceau de texte x~pθ, donnant ~x, le nombre d'échantillons générés par la machine log pθ(x) - log pθ(~x) devrait être relativement grand par rapport au texte écrit par l'homme. En utilisant cette hypothèse, considérons d'abord une fonction de perturbation q(.|x), qui donne une distribution sur ~x, une version légèrement modifiée de x avec une signification similaire (considérez généralement un texte approximatif de la longueur d'un paragraphe x). Par exemple, q(.|x) pourrait être le résultat de la simple demande à un humain de réécrire l'une des phrases pour x tout en préservant le sens de x. En utilisant le concept de fonction de perturbation, la différence de perturbation d (x; pθ, q) peut être définie :

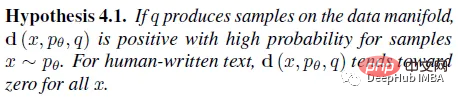

Par conséquent, l'hypothèse suivante 4.1 est :

Si q(.|x ) est Avec des échantillons provenant d'un modèle de remplissage de masque (tel que T5) plutôt que des réécritures humaines, l'hypothèse 4.1 peut alors être testée empiriquement de manière automatisée et évolutive.

2. DetectGPT : Test automatique

Après la réécriture d'un article, la diminution moyenne de log probabilité (différence de perturbation) des articles générés par le modèle est toujours supérieure à celle des articles écrits manuellement

Pour de vrai data , en utilisant 500 articles de presse de l'ensemble de données XSum. Utilisation de la sortie de quatre llms différents lorsque vous êtes invité à indiquer les 30 premiers jetons de chaque article dans XSum. La perturbation est appliquée à l'aide de T5-3B, masquant une plage de 2 mots échantillonnée au hasard jusqu'à ce que 15 % des mots de l'article soient masqués. L'espérance mathématique de l'équation (1) ci-dessus est approximée par 100 échantillons dans T5.

Les résultats expérimentaux ci-dessus montrent qu'il existe une différence significative dans la distribution des différences de perturbation entre les articles écrits par des humains et les échantillons modèles présentent souvent de grandes différences de perturbation. Sur la base de ces résultats, il est possible de détecter si un morceau de texte a été généré par le modèle p en seuillant simplement la différence de perturbation.

La normalisation des différences de perturbation par l'écart type des observations utilisées pour estimer E~x q(.|x) log p (~x) permet une meilleure détection, augmentant généralement l'AUROC d'environ 0,020, donc dans les expériences Une version normalisée du la différence de perturbation est utilisée dans .

Pseudo-code du processus de détection de DetectGPT

La différence de perturbation peut être utile, ce qu'elle mesure ne peut pas être clairement expliqué, c'est pourquoi l'auteur utilise la courbure pour expliquer dans la section suivante.

3. Interpréter la différence de perturbation comme une courbure

La différence de perturbation est approximativement une mesure de la courbure locale de la fonction de probabilité log à proximité du passage candidat, plus précisément, elle est proportionnelle à la trace négative de la matrice de Hesse du log fonction de probabilité.

Cette section a beaucoup de contenu, je ne l'expliquerai donc pas en détail ici. Si vous êtes intéressé, vous pouvez lire l'article original, qui est grossièrement résumé comme suit :

.L'échantillonnage dans l'espace sémantique garantit que tous les échantillons restent proches du collecteur de données, car la probabilité log devrait toujours diminuer si des marqueurs de perturbation sont ajoutés de manière aléatoire. L'objectif peut donc être interprété comme une contrainte approximative sur la courbure de la variété de données.

4. Affichage des résultats

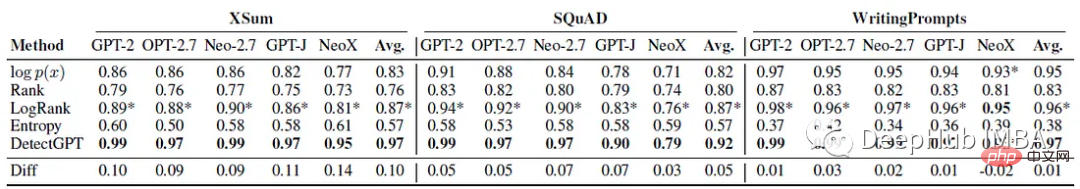

Détection de texte généré par machine sans tir

Chaque expérience utilise 150 à 500 exemples pour l'évaluation. Le texte généré par la machine est généré en invitant les 30 premiers jetons du texte réel. Utilisez AUROC) pour évaluer les performances.

On peut voir que DetectGPT maximise la précision de détection moyenne des histoires XSum (AUROC amélioré de 0,1) et du contexte Wikipédia SQuAD (AUROC amélioré de 0,05).

Pour 14 combinaisons d'ensembles de données et de modèles sur 15, DetectGPT offre les performances de détection les plus précises, avec une amélioration moyenne de l'AUROC de 0,06.

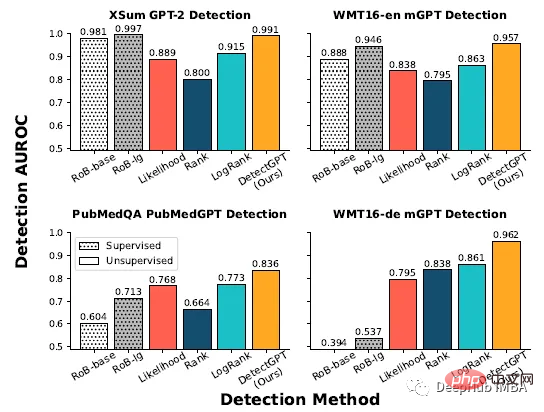

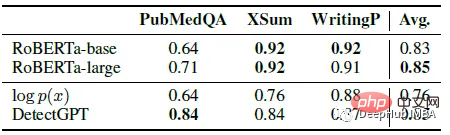

Comparaison avec des détecteurs supervisés

Un modèle de détection de texte supervisé généré par une machine, formé sur un vaste ensemble de données de texte réel et généré, fonctionne aussi bien que DetectGPT sur du texte en distribution (rangée du haut), ou même mieux. La méthode Zero-shot est appliquée à de nouveaux domaines (rangée du bas) tels que les textes médicaux PubMed et les données d'actualité allemandes dans WMT16.

Évaluée sur 200 échantillons de chaque ensemble de données, les performances de détection du détecteur supervisé sur les données en diffusion telles que les actualités en anglais sont similaires à celles de DetectGPT, mais dans le cas de la rédaction scientifique en anglais, ses performances sont nettement pires que celles du zéro-shot. méthode, alors qu'en écriture allemande, elle échoue complètement.

DetectGPT L'AUROC moyen de GPT-3 est comparable aux modèles supervisés formés spécifiquement pour la détection de texte généré par machine.

150 exemples extraits des ensembles de données PubMedQA, XSum et writingprompt. Deux modèles de détecteurs pré-entraînés basés sur Roberta sont comparés à DetectGPT et à la ligne de base du seuil probabiliste. DetectGPT peut fournir des détections qui rivalisent avec des modèles supervisés plus puissants.

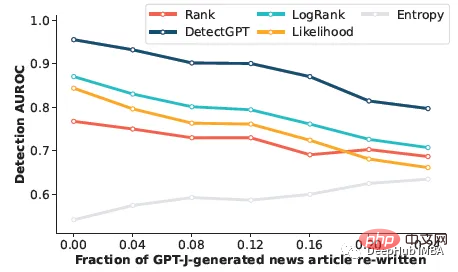

Variation de la détection de texte généré par la machine

Cette partie sert à voir si le détecteur peut détecter le texte généré par la machine modifié par l'homme. La révision manuelle a été simulée en remplaçant 5 mots du texte par des échantillons de T5 à 3B jusqu'à ce que r% du texte soit remplacé. DetectGPT est capable de maintenir la détection AUROC au-dessus de 0,8 même si près d'un quart du texte de l'échantillon modèle a été remplacé. DetectGPT affiche les performances de détection les plus élevées sur tous les niveaux de révision.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI