Maison >Périphériques technologiques >IA >Le MoE modulaire deviendra le modèle de base pour l'apprentissage visuel multitâche

Le MoE modulaire deviendra le modèle de base pour l'apprentissage visuel multitâche

- WBOYavant

- 2023-04-13 12:40:031910parcourir

L'apprentissage multi-tâches (MTL) présente de nombreux défis car les gradients entre les différentes tâches peuvent être contradictoires. Pour exploiter la corrélation entre les tâches, les auteurs introduisent le modèle Mod-Squad, qui est un modèle modulaire composé de plusieurs experts. Le modèle peut optimiser de manière flexible la mise en correspondance des tâches et des experts, et sélectionner certains experts pour la tâche. Le modèle permet à chaque expert de correspondre seulement à une partie des tâches, et à chaque tâche de correspondre seulement à une partie des experts, maximisant ainsi l'utilisation des liens positifs entre les tâches. Mod-Squad intègre les couches Mixture of Experts (MoE) dans le modèle Vision Transformer et introduit une nouvelle fonction de perte qui encourage des dépendances clairsemées mais fortes entre les experts et les tâches. De plus, pour chaque tâche, le modèle ne peut conserver qu’une petite partie du réseau d’experts et atteindre les mêmes performances que le grand modèle original. Le modèle a obtenu les meilleurs résultats sur l'ensemble de données Big Data Taskonomy et l'ensemble de données PASCALContext de 13 tâches de vision.

Adresse papier : https://arxiv.org/abs/2212.08066

Adresse du projet : https://vis-www.cs.umass.edu/mod-squad/

Adresse Github : https://github.com/UMass-Foundation-Model/Mod-Squad

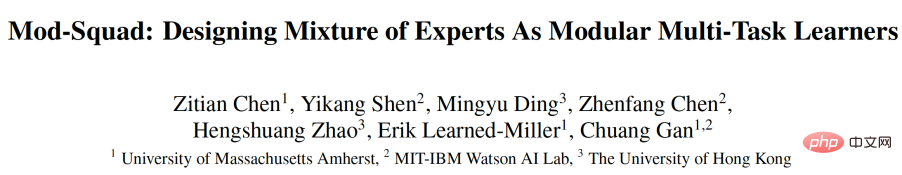

Le but de l'apprentissage multi-tâches (MTL) est de modéliser la relation entre les tâches et de fournir Créez un modèle unifié pour plusieurs tâches. Comme le montre la figure 1, la principale motivation de Mod-Squad est de permettre aux experts d'être mis à jour uniquement pour certaines tâches au lieu de toutes les tâches, et seule une partie des experts est mise à jour pour chaque tâche. Cela permet d’utiliser toute la capacité du modèle tout en évitant les interférences entre les tâches.

Figure 1. Mod-Squad : Les experts et les tâches se choisissent. MoE ViT : tous les spécialistes sont utilisés pour toutes les tâches.

Ce qui suit est une brève introduction à l'article.

Structure du modèle

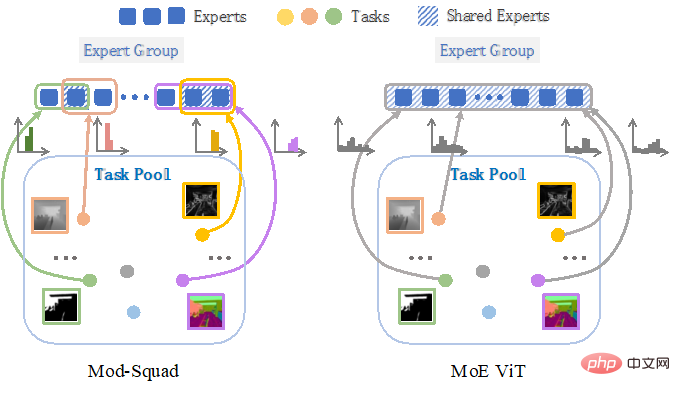

Figure 2. Mod-Squad : Insérez le mélange d'experts dans Vision Transformer.

Comme le montre la figure 2, la structure de Mod-Squad consiste à introduire le mélange d'experts (MoE) dans Vision Transformer (ViT). MoE est un modèle d'apprentissage automatique dans lequel plusieurs experts forment un modèle hybride. Chaque expert est un modèle indépendant, et chaque modèle contribue différemment à différentes entrées. Enfin, les contributions de tous les experts sont pondérées et combinées pour obtenir le résultat final. L’avantage de cette approche est qu’elle peut sélectionner dynamiquement le meilleur expert en fonction du contenu de l’image d’entrée et contrôler l’effort de calcul.

Après la convergence du modèle MoE précédent, différents experts peuvent être utilisés selon différentes images, mais pour une certaine tâche, le modèle convergera pour avoir tendance à utiliser tous les experts. Mod-Squad permet au modèle d'utiliser différents experts pour les images, et après convergence, le modèle peut atteindre un état où seule une partie des experts est utilisée pour une tâche. Nous présenterons ensuite comment cela est réalisé.

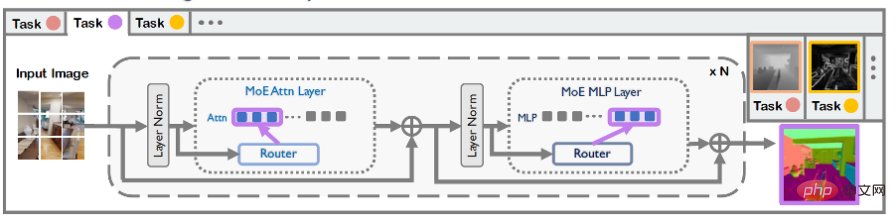

Maximiser l'information mutuelle entre experts et tâches

Cet article propose un modèle de probabilité conjoint de tâches et d'experts pour optimiser l'allocation entre les experts E et les tâches T. Ce modèle probabiliste sera utilisé pour calculer les informations mutuelles entre les experts et les tâches, et servira de fonction de perte supplémentaire pour optimiser le réseau de poids dans le MoE. La formule d'information mutuelle est la suivante. Les probabilités de E et T peuvent être obtenues à partir du réseau de pondération du MoE. Pour plus de détails, veuillez vous référer à l'article.

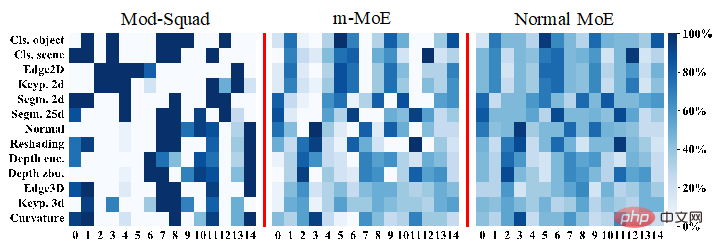

Après avoir maximisé les informations mutuelles entre les tâches et les experts, le modèle peut permettre aux experts et aux tâches d'avoir des dépendances clairsemées et très fortes, comme le montre la figure 3. Celui à l’extrême gauche est la fréquence experte d’utilisation des tâches Mod-Squad. Comme on peut le constater, Mod-Squad a des fréquences plus clairsemées mais plus pointues entre les missions et les spécialistes.

Figure 3. Comparaison des graphiques de fréquence des tâches utilisant différents experts. L'axe horizontal représente différents experts, l'axe vertical représente différentes tâches et les couleurs plus foncées représentent une fréquence d'utilisation plus élevée. Le tracé des fréquences de Mod-Squad est plus clairsemé et plus net.

L'avantage d'une dépendance faible et très forte entre cette tâche et les experts est :

1 Les tâches similaires ont tendance à utiliser le même expert

2. d'utilisation positive des tâches pertinentes ;

3. La capacité du modèle est entièrement utilisée, mais chaque tâche n'utilise qu'une partie de la capacité, et la capacité d'utilisation peut être ajustée en fonction de la tâche

4. être utilisé pour des tâches spécifiques à partir d'un grand modèle multitâche. Extrayez un petit modèle monotâche et obtenez les mêmes performances que le grand modèle. Cette fonctionnalité peut être utilisée pour extraire de petits modèles monotâches à partir de modèles très multitâches.

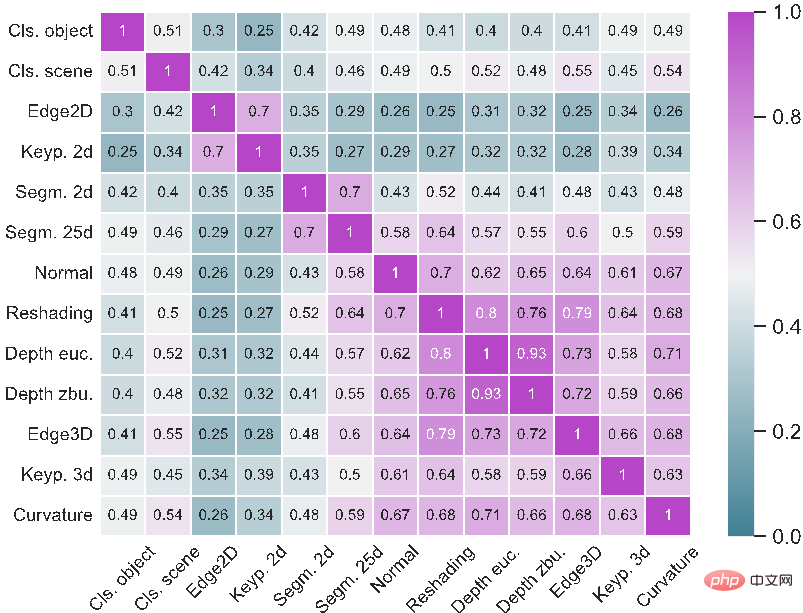

En fonction de la fréquence de partage des experts entre les tâches, le modèle peut également calculer la similarité entre les tâches, comme le montre la figure ci-dessous. On constate que les tâches orientées 3D ont tendance à faire appel aux mêmes experts et sont donc plus similaires.

Partie expérimentale

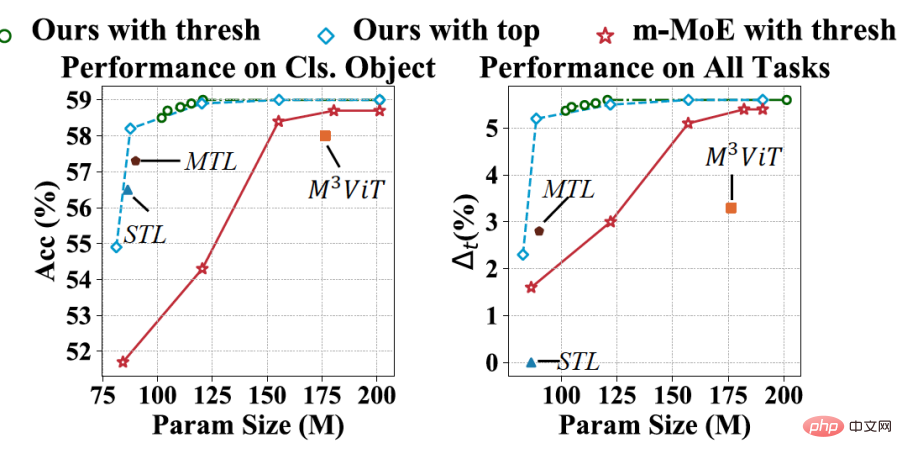

Mod-Squad peut élaguer une seule tâche sans perdre en précision. L'axe vertical de la figure ci-dessous est la performance et l'axe horizontal est la quantité de paramètres.

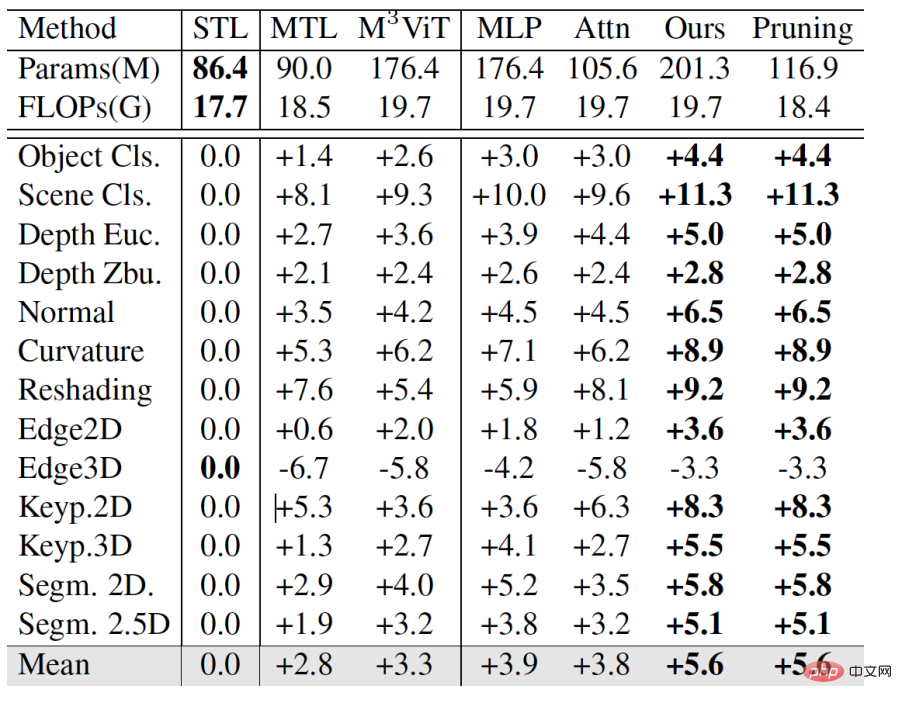

a également été grandement amélioré sur le grand ensemble de données Taskonomy. On peut voir que Mod-Squad est en moyenne 2,8 points plus élevé que le MTL pur, et maintient les mêmes performances après l'élagage.

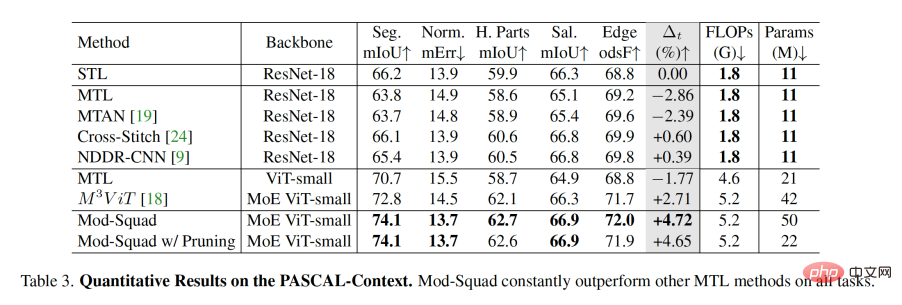

En comparaison avec d'autres méthodes sur PASCAL-Context, Mod-Squad est en moyenne près de deux points de plus que les autres méthodes du MoE.

Veuillez vous référer au texte original pour des détails spécifiques.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI