Maison >Périphériques technologiques >IA >Lao Huang détient une « bombe nucléaire » spéciale pour que ChatGPT fasse exploser la scène, et le NVIDIA H100 Extreme Edition est 10 fois plus rapide !

Lao Huang détient une « bombe nucléaire » spéciale pour que ChatGPT fasse exploser la scène, et le NVIDIA H100 Extreme Edition est 10 fois plus rapide !

- 王林avant

- 2023-04-13 10:10:021326parcourir

NVIDIA, vous gagnez !

Lors de la conférence GTC qui vient de se terminer, avec l'écran plein d'« IA générative » et une puce H100 NVLINK qui prend en charge la puissance de calcul ChatGPT et accélère 10 fois, Huang a presque écrit ces mots sur son visage : « Je suis le gagnant".

ChatGPT, Microsoft 365, Azure, Stable Diffusion, DALL-E, Midjourney...tous ces produits d'IA populaires et explosifs, NVIDIA peut en obtenir une part.

La popularité mondiale de ChatGPT au début de cette année a fait monter en flèche le cours de l'action de Nvidia et sa valeur marchande a directement augmenté de plus de 70 milliards de dollars américains. Actuellement, la capitalisation boursière de Nvidia s’élève à 640 milliards de dollars.

Maintenant, le moment de l'IA iPhone est arrivé, la quatrième révolution technologique est sur le point de commencer, et Nvidia, avec ses A100 et H100, pourrait devenir le plus grand gagnant.

Lors de la conférence GTC, Huang a annoncé les progrès remarquables de NVIDIA dans les GPU, les bibliothèques d'accélération, la lithographie informatique et les plates-formes cloud, et a même fait une déclaration audacieuse : NVIDIA va être le TSMC dans le cercle de l'IA !

Maintenant, certaines personnes ont émis l'hypothèse que le discours d'aujourd'hui avait été entièrement généré à l'aide du modèle AIGC sur le H100.

Le GPU dédié ChatGPT est là

La plus grande annonce de cette conférence est le NVIDIA H100 NVLINK conçu pour ChatGPT.

En raison de l'énorme demande de puissance de calcul, NVIDIA a lancé un nouveau GPU Hopper pour l'inférence de LLM tels que ChatGPT, PCIE H100 équipé d'un double GPU NVLINK, avec 94 Go de mémoire.

En fait, l'histoire du deep learning est étroitement liée à NVIDIA depuis 2012.

Lao Huang a déclaré qu'en 2012, le vétéran de l'apprentissage profond Hinton et les étudiants Alex Kerchevsky et Ilya Suskever ont utilisé la GeForce GTX 580 lors de la formation d'AlexNet.

Par la suite, AlexNet a remporté le concours de classification d'images ImageNet d'un seul coup, devenant ainsi le point singulier de l'explosion du deep learning.

Et après 10 ans, Ilya Suskever d'OpenAI a également utilisé le DGX de NVIDIA pour entraîner GPT3 et GPT3.5 derrière ChatGPT.

Lao Huang a déclaré fièrement qu'actuellement, le seul GPU sur le cloud capable de gérer ChatGPT est le HGX A100.

Mais comparé à l'A100, un serveur équipé de quatre paires de H100 et d'un double GPU NVLINK est 10 fois plus rapide ! Parce que H100 peut réduire le coût de traitement du LLM d'un ordre de grandeur.

L'IA est à un point d'inflexion car l'IA générative crée une vague d'opportunités, entraînant une augmentation progressive des charges de travail d'inférence.

Dans le passé, concevoir un centre de données cloud pour gérer l'IA générative était un défi de taille.

D'une part, il serait idéalement préférable d'utiliser un seul accélérateur pour rendre le centre de données élastique ; mais d'un autre côté, aucun accélérateur ne peut gérer de manière optimale la diversité des algorithmes, des modèles, des types et des tailles de données. La plate-forme One Architecture de NVIDIA offre à la fois des capacités d'accélération et de la flexibilité.

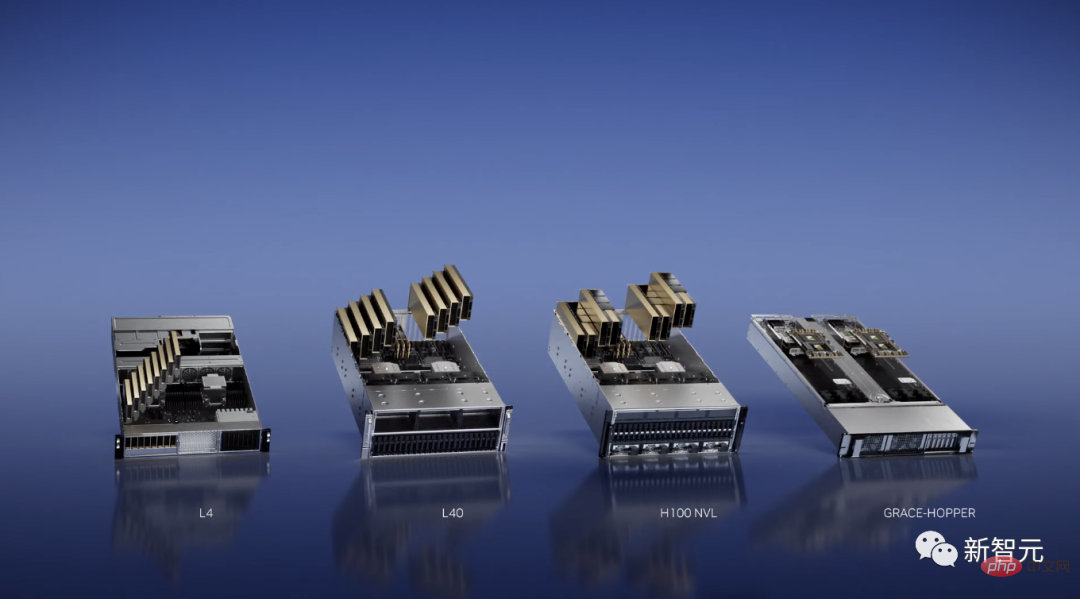

Et aujourd'hui, NVIDIA a annoncé le lancement d'une nouvelle plateforme d'inférence. Chaque configuration est optimisée pour un certain type de charge de travail.

Par exemple, pour les charges de travail vidéo IA, NVIDIA a lancé L4, qui a optimisé le décodage et le transcodage vidéo, l'examen du contenu vidéo et les fonctions d'appel vidéo.

Et un serveur L4 à 8 GPU remplacera plus d'une centaine de serveurs CPU à double socket utilisés pour traiter les vidéos IA.

Dans le même temps, NVIDIA a également lancé L40 pour l'IA générative telle que Omniverse, le rendu graphique et la conversion texte-image/vidéo. Ses performances sont 10 fois supérieures à celles du GPU d’inférence cloud T4 le plus populaire de Nvidia.

Actuellement, les puissantes capacités des modèles d'IA générative Gen-1 et Gen-2 lancés par Runway s'appuient sur les GPU NVIDIA.

De plus, NVIDIA a également lancé une nouvelle super puce Grace-Hopper, adaptée aux systèmes de recommandation et aux bases de données vectorielles.

Défier les limites des puces en accélérant la lithographie informatique de 40 fois

Dans le domaine des puces, NVIDIA, en collaboration avec TSMC, ASML et Synopsys, a finalement réalisé une percée majeure dans la technologie de lithographie informatique après 4 ans - NVIDIA cuLitho computational lithographie Keku.

Après avoir atteint la limite du procédé 2nm, la photolithographie est le point de rupture.

La lithographie informatique simule le comportement de la lumière lorsqu'elle interagit avec la résine photosensible après avoir traversé l'élément optique. En appliquant des algorithmes de physique inverse, nous pouvons prédire le motif sur le masque pour générer le motif final sur la plaquette.

La lithographie computationnelle constitue la charge de travail informatique la plus importante dans le domaine de la conception et de la fabrication de puces, consommant des dizaines de milliards d'heures CPU chaque année. En revanche, le nouvel algorithme créé par NVIDIA permet d’exécuter en parallèle des flux de travail de lithographie informatique de plus en plus complexes sur des GPU.

En résumé, cuLitho peut non seulement augmenter la vitesse de calcul de 40 fois, mais également réduire la consommation d'énergie jusqu'à 9 fois.

Par exemple, le H100 de Nvidia nécessite 89 masques.

S'il est traité par CPU, chaque masque prendra deux semaines. Si vous exécutez cuLitho sur le GPU, le traitement d'un masque ne prend que 8 heures.

Et TSMC peut également utiliser 4 000 GPU Hopper dans 500 systèmes DGX H100 pour terminer le travail qui nécessitait auparavant jusqu'à 40 000 serveurs basés sur CPU, et la puissance sera réduite de 35 MW à 5 MW.

Il est à noter que la bibliothèque d'accélération cuLitho est également compatible avec les GPU à architecture Ampere et Volta, mais Hopper est la solution la plus rapide.

Lao Huang a déclaré que puisque la technologie de photolithographie est déjà à la limite de la physique, les usines de plaquettes peuvent augmenter leur production et se préparer au développement du 2 nm et au-delà.

Le moment iPhone d'AI

Au cours des derniers mois, ChatGPT a été écrasant et est sur le point de déclencher la quatrième révolution technologique. Le dicton « Nous sommes à l’heure de l’IA sur iPhone » a également été largement diffusé.

Lors de la conférence GTC, Lao Huang a répété cette phrase avec enthousiasme à trois reprises.

Le moment de l'iPhone arrive, des startups telles qu'OpenAI sont en compétition pour créer des produits et des modèles commerciaux révolutionnaires, tandis que des entreprises établies comme Google et Microsoft cherchent des moyens d'y faire face.

Toutes leurs actions sont dues au sentiment d'urgence dans la formulation de stratégies d'IA déclenchées par l'IA générative dans le monde entier.

Le calcul accéléré NVIDIA commence avec le supercalculateur DGX AI, qui est également le moteur des avancées actuelles dans les modèles de langage à grande échelle.

Chez GTC, Lao Huang a déclaré avec fierté que j'avais personnellement remis le premier DGX au monde à OpenAI.

Depuis, la moitié des entreprises Fortune 100 ont installé des supercalculateurs DGXAI.

DGX est équipé de 8 modules GPU H100 et le H100 est équipé d'un moteur Transformer, qui peut gérer des modèles étonnants comme ChatGPT.

8 modules H100 sont connectés les uns aux autres via le commutateur NVLINK, permettant une communication complète non bloquante. Huit H100 fonctionnent ensemble comme un GPU géant.

Ce qui rend Lao Huang encore plus enthousiasmé, c'est que Microsoft a annoncé qu'Azure ouvrirait une version d'aperçu privée de son supercalculateur H100 AI.

et a déclaré : "Le supercalculateur DGX est une usine d'IA moderne. Nous sommes à l'heure de l'IA sur iPhone.

A fait ressortir à lui seul ChatGPT

Au cours de la dernière décennie, la combinaison de l'accélération et de la verticale. L'expansion a permis à diverses applications d'atteindre des centaines de dizaines de milliers de fois l'amélioration des performances.

L'exemple le plus impressionnant est l'introduction du framework d'apprentissage profond AlexNet en 2012.

À cette époque, Alex Krizhevsky, Ilya Suskever et Hinton ont suivi une formation en utilisant 14 millions d'images sur une GeForce GTX 580, qui peut gérer 262 pétaflops d'opérations en virgule flottante.

Dix ans plus tard, Transformer sortait.

Ilya Suskever a entraîné GPT-3 pour prédire le mot suivant, ce qui a nécessité un million de fois plus d'opérations en virgule flottante que l'entraînement du modèle AlexNet.

Ainsi, une IA qui a choqué le monde a été créée - ChatGPT.

Pour résumer en une phrase de Lao Huang :

Cela signifie qu'une nouvelle plate-forme informatique est née et que le « moment iPhone » de l'IA est arrivé. L’informatique accélérée et la technologie de l’IA sont devenues réalité.

La bibliothèque d'accélération est au cœur du calcul accéléré. Ces bibliothèques d'accélération connectent diverses applications, puis se connectent à diverses industries, formant un réseau au sein du réseau.

Après 30 ans de développement, des milliers d'applications ont été accélérées par les bibliothèques NVIDIA, couvrant presque tous les domaines scientifiques et industriels.

Actuellement, tous les GPU NVIDIA sont compatibles CUDA.

Les 300 bibliothèques d'accélération et 400 modèles d'IA existants couvrent un large éventail de domaines tels que l'informatique quantique, le traitement des données et l'apprentissage automatique.

Lors de cette conférence GTC, NVIDIA a annoncé en avoir mis à jour 100.

La plateforme NVIDIA Quantum se compose de bibliothèques et de systèmes qui permettent aux chercheurs de faire progresser les modèles de programmation quantique, les architectures système et les algorithmes.

cuQuantum est une bibliothèque d'accélération pour la simulation de circuits quantiques. Des sociétés telles qu'IBM et Baidu ont intégré cette bibliothèque d'accélération dans leurs frameworks de simulation.

Open Quantum CUDA est le modèle de programmation hybride GPU-Quantum de NVIDIA.

Nvidia a également annoncé le lancement d'un lien de contrôle quantique, développé en partenariat avec Quantum Machines. Il peut connecter des GPU Nvidia à des ordinateurs quantiques pour effectuer une correction d'erreurs à des vitesses extrêmement rapides.

Une nouvelle bibliothèque RAFT a également été lancée pour accélérer l'indexation, le chargement des données et la recherche du voisin le plus proche.

De plus, NVIDIA a également annoncé DGX Quantum, construit avec DGX et exploitant le dernier open source CUDA Quantum. Cette nouvelle plate-forme offre aux chercheurs engagés dans l'informatique quantique une architecture révolutionnaire à hautes performances et à faible latence.

NVIDIA a également lancé le logiciel NVIDIA Triton Management Service pour mettre à l'échelle et orchestrer automatiquement les instances d'inférence Triton dans l'ensemble du centre de données. Convient à l'inférence multi-GPU et multi-nœuds de grands modèles de langage comme GPT-3.

CV-CUDA pour la vision par ordinateur et VPF pour le traitement vidéo sont les nouvelles bibliothèques d'accélération à l'échelle du cloud de NVIDIA.

Lao Huang a annoncé que CV-CUDA Beta optimise le pré-traitement et le post-traitement, obtenant un débit cloud plus élevé et réduisant les coûts et la consommation d'énergie d'un quart.

Actuellement, Microsoft gère la recherche visuelle et Runway gère son processus de traitement vidéo génératif d'IA, qui utilisent tous deux les bibliothèques CV-CUDA et VRF.

De plus, le calcul accéléré par NVIDIA a également aidé la génomique à réaliser des développements marquants. Grâce aux instruments alimentés par NVIDIA, la réduction du coût du séquençage complet du génome à 100 dollars est devenue une autre étape importante.

La bibliothèque d'accélération NVIDIA Parabrics peut être utilisée pour l'analyse génomique de bout en bout dans le cloud ou au sein de l'instrument, et convient à diverses plateformes de cloud public et de génomique.

ChatGPT fonctionne, NVIDIA gagne de l'argent

Maintenant, ChatGPT, Stable Diffusion, DALL-E et Midjourney ont éveillé la conscience mondiale de l'IA générative.

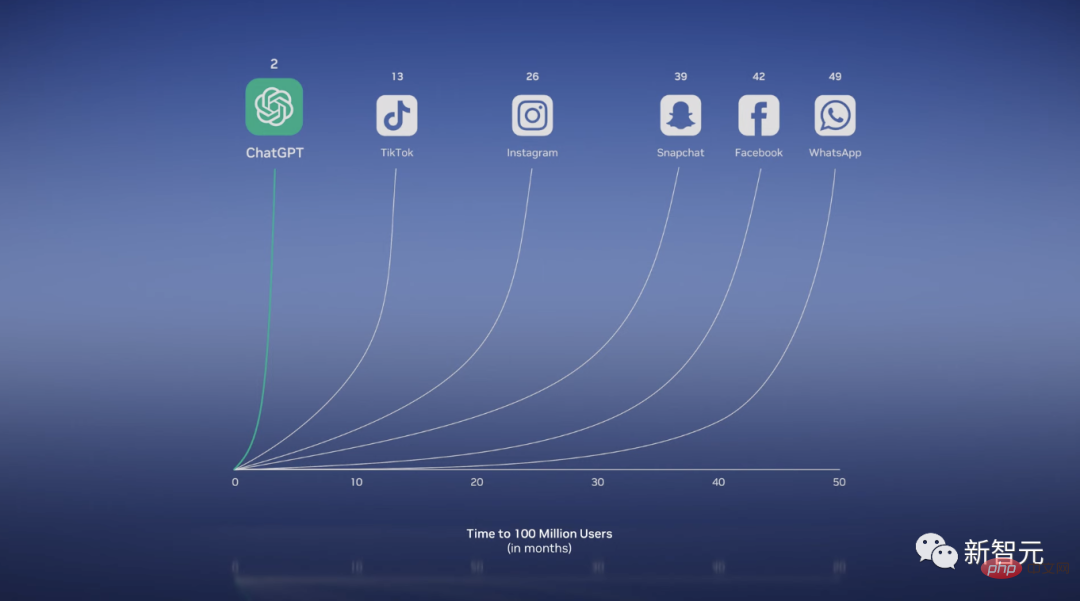

Le populaire poulet frit ChatGPT a dépassé les 100 millions d'utilisateurs mensuels seulement 2 mois après son lancement et est devenu l'application à la croissance la plus rapide de l'histoire.

On peut dire que c'est un ordinateur. Non seulement vous pouvez générer du texte, écrire de la poésie, réécrire des articles de recherche, résoudre des problèmes mathématiques et même programmer.

De nombreux résultats révolutionnaires ont donné naissance à l’IA générative d’aujourd’hui.

Transformer est capable d'apprendre le contexte et la signification des relations et des dépendances des données de manière massivement parallèle. Cela permet aux LLM d'apprendre à partir de quantités massives de données et d'effectuer des tâches en aval sans formation explicite.

De plus, un modèle de diffusion inspiré de la physique peut générer des images grâce à un apprentissage non supervisé.

Lao Huang a conclu qu'en seulement une douzaine d'années, nous sommes passés de l'identification des chats à la génération de chats en combinaison spatiale marchant sur la lune.

On peut désormais dire que l'IA générative est un nouveau type d'ordinateur, un ordinateur qui peut être programmé en langage humain.

Auparavant, commander à l'ordinateur de résoudre des problèmes était le privilège exclusif des programmeurs, mais désormais, tout le monde peut être programmeur.

Comme Bill Gates, Huang a également donné une définition similaire : l'IA générative est une nouvelle plate-forme informatique, similaire au PC, à Internet, aux appareils mobiles et au cloud.

Grâce à Debuild, nous pouvons directement concevoir et déployer des applications Web à condition de clarifier ce que nous voulons.

Il est clair que l’IA générative va remodeler presque tous les secteurs.

Pour être le "TSMC" de l'industrie de l'IA

Dans ce contexte, les entreprises professionnelles doivent utiliser leurs propres données propriétaires pour construire des modèles personnalisés.

Ensuite, Lao Huang a fièrement annoncé que l'industrie avait besoin d'une fonderie similaire à TSMC pour construire de grands modèles de langage personnalisés, et NVIDIA est ce « TSMC » !

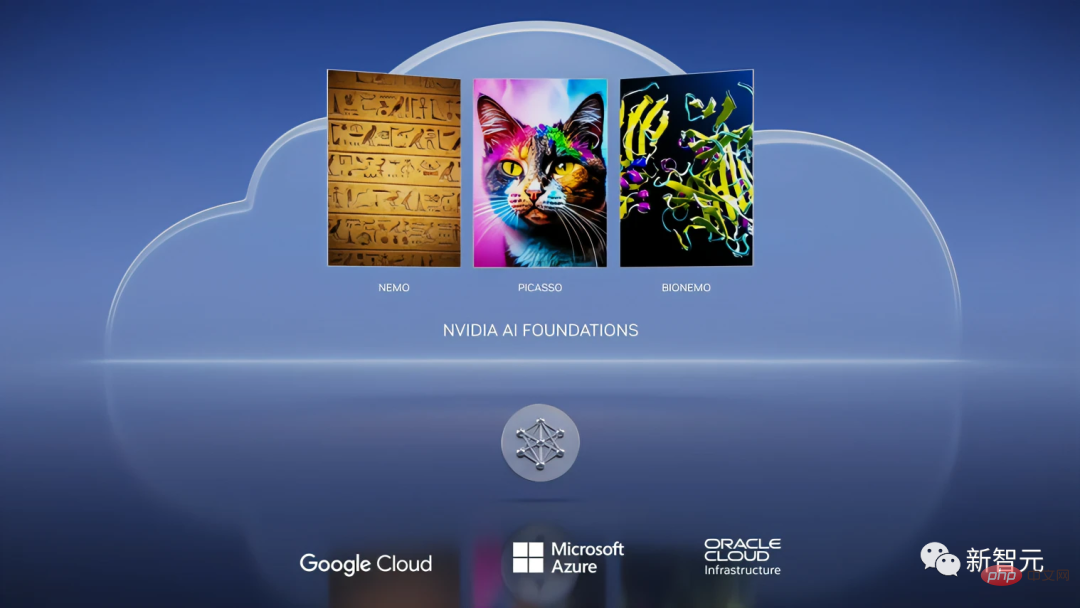

Lors de la conférence, NVIDIA a annoncé le lancement du service cloud NVIDIA AI Foundations, permettant aux clients de personnaliser le LLM et l'IA générative.

Ce service cloud comprend des services de production de langage, de vision et de modèles biologiques.

Parmi eux, Nemo est utilisé pour construire un modèle génératif texte-texte de langage personnalisé.

Et Picasso est un créateur de modèles de langage visuel qui peut être utilisé pour former des modèles personnalisés, notamment des images, des vidéos et des applications 3D.

Envoyez simplement un appel API avec des invites textuelles et des métadonnées à Picasso, et Picasso utilisera le modèle sur DGX Cloud pour renvoyer le matériel généré à l'application.

Ce qui est encore plus étonnant, c'est qu'en important ces matériaux dans NVIDIA Omniverse, vous pouvez créer des applications métaverses réalistes et des simulations de jumeaux numériques.

De plus, NVIDIA travaille également avec Shutterstock pour développer des modèles génératifs Edify-3D.

Dans le même temps, la coopération entre NVIDIA et Adobe continue de se développer, intégrant l'IA générative dans le flux de travail quotidien des spécialistes du marketing et des créatifs, et accordant une attention particulière à la protection des droits d'auteur des artistes.

Le troisième domaine est la biologie.

Aujourd'hui, la valeur de l'industrie de la recherche et du développement de médicaments a atteint près de 2 000 milliards de yuans, avec des investissements en R&D pouvant atteindre 250 milliards de dollars américains.

NVIDIA Clara est un cadre d'applications médicales et sanitaires pour l'imagerie, l'instrumentation, l'analyse génomique et la recherche et le développement de médicaments.

Récemment, une direction populaire dans la biosphère consiste à utiliser l'IA générative pour découvrir des cibles de maladies et concevoir de nouvelles molécules ou médicaments protéiques.

En conséquence, BIONEMO permet aux utilisateurs d'utiliser des données propriétaires pour créer, affiner et fournir des modèles personnalisés, y compris des modèles de prédiction de protéines tels qu'AlphaFold, ESMFold et OpenFold.

Enfin, Lao Huang a conclu que NVIDIA AI Foundations est un service cloud et une fonderie permettant de créer des modèles de langage personnalisés et une IA générative.

Laohuang Cloud Service, la location mensuelle est de 36 999 $ US

NVIDIA a également lancé un service cloud cette fois-ci.

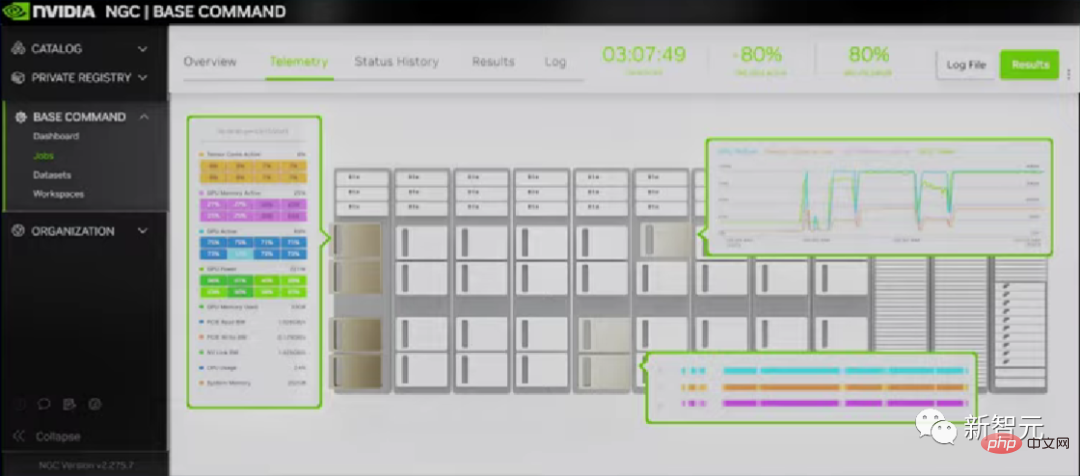

L'entreprise a parfaitement compris les besoins des clients en matière d'accès plus facile et plus rapide à NVIDIA AI et a donc lancé NVIDIA DGX Cloud.

DGX Cloud coopère avec Microsoft Azure, Google GCP et Oracle OCI. Avec juste un navigateur et un supercalculateur NVIDIA DGX AI, vous pouvez accéder instantanément à toutes les entreprises !

Sur ce cloud, vous pouvez exécuter la suite de bibliothèques d'accélération NVIDIA AI Enterprise pour résoudre directement le développement et le déploiement de bout en bout de l'IA.

De plus, le cloud fournit non seulement NVIDIA AI, mais également plusieurs grands fournisseurs de services cloud dans le monde.

Et le premier NVIDIA DGX Cloud de NVIDIA est Oracle Cloud Infrastructure (OCI).

En OCI, NVIDIA CX-7 et BlueField-3 se combinent pour créer un supercalculateur puissant.

Selon les rapports, les entreprises peuvent désormais louer DGX Cloud, à partir de 36 999 $ US par mois.

Enfin, bien sûr, il y a le programme réservé de la conférence annuelle GTC-Omniverse. Lao Huang a annoncé la mise à jour de la plateforme métaverse Omniverse.

Maintenant, Microsoft et NVIDIA se préparent à proposer Omniverse à des centaines de millions d'utilisateurs de Microsoft 365 et Azure.

De plus, il y a des nouvelles selon lesquelles afin de permettre l'exportation du H100 vers la Chine dans le respect de la réglementation, Lao Huang a spécialement conçu un "H800" basé sur l'expérience du précédent A800, réduisant le taux de transmission de données entre les puces. à H100 Environ 50%.

En résumé, Lao Huang a clairement indiqué lors de cette conférence que NVIDIA veut être le TSMC dans le domaine de l'IA, fournissant aux OEM une usine de plaquettes, et sur cette base, d'autres entreprises du secteur peuvent former des algorithmes.

Ce modèle économique peut-il réussir ?

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI