Maison >Périphériques technologiques >IA >300 ans d'intelligence artificielle ! Le père du LSTM écrit un article de 10 000 mots : Explication détaillée de l'histoire du développement de l'IA moderne et de l'apprentissage profond

300 ans d'intelligence artificielle ! Le père du LSTM écrit un article de 10 000 mots : Explication détaillée de l'histoire du développement de l'IA moderne et de l'apprentissage profond

- WBOYavant

- 2023-04-13 08:16:021528parcourir

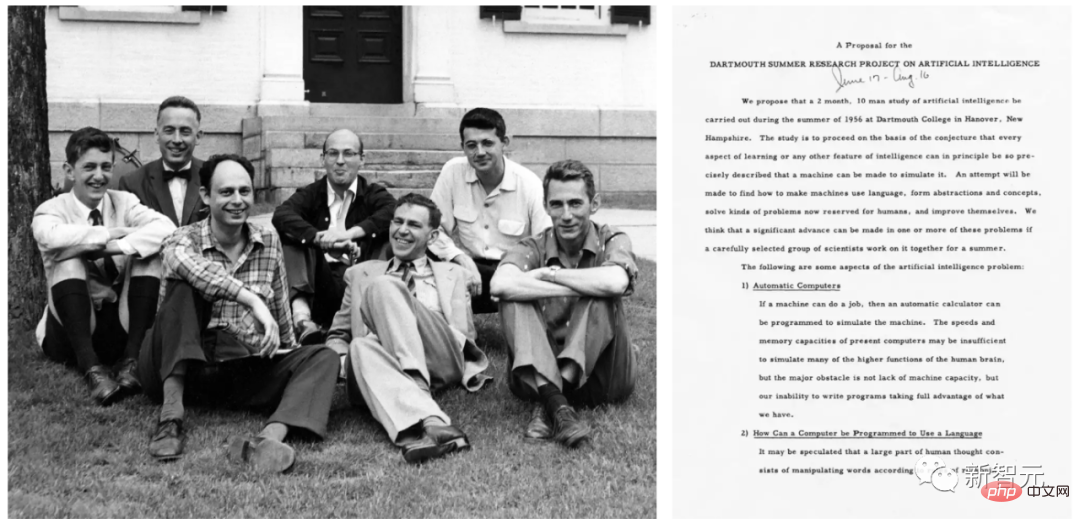

Le terme « intelligence artificielle » a été formellement proposé pour la première fois lors de la conférence de Dartmouth en 1956 par John McCarthy et d'autres.

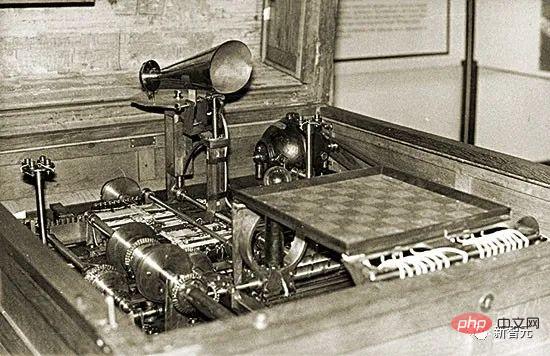

L'IA pratique a été proposée dès 1914. À cette époque, Leonardo Torres et Quevedo construisaient le premier joueur de terminal de machine d'échecs fonctionnel. À l’époque, les échecs étaient considérés comme une activité réservée aux créatures intelligentes.

Quant à la théorie de l'intelligence artificielle, elle remonte à 1931-34. À l’époque, Kurt Gödel avait identifié les limites fondamentales de tout type d’intelligence artificielle informatique.

Le temps arrive dans les années 1980, et l'histoire de l'IA à cette époque mettra l'accent sur des sujets tels que la preuve de théorèmes, la programmation logique, les systèmes experts et la recherche heuristique.

L'histoire de l'IA au début des années 2000 aurait mis davantage l'accent sur des sujets tels que les machines à vecteurs de support et les méthodes du noyau. Le raisonnement bayésien et d'autres concepts probabilistes et statistiques, les arbres de décision, les méthodes d'ensemble, l'intelligence en essaim et le calcul évolutif sont des techniques qui conduisent à de nombreuses applications d'IA réussies.

La recherche sur l'IA dans les années 2020 est plus « rétro », par exemple, mettant l'accent sur des concepts tels que la règle de la chaîne et les réseaux neuronaux artificiels non linéaires profonds entraînés par descente de gradient, en particulier les réseaux récurrents basés sur la rétroaction.

Schmidhuber a déclaré que cet article corrige la précédente "histoire de l'apprentissage profond" trompeuse. Selon lui, les histoires antérieures de l’apprentissage profond ont ignoré une grande partie des travaux fondateurs mentionnés dans l’article.

De plus, Schmidhuber a réfuté une idée fausse courante selon laquelle les réseaux de neurones "ont été introduits dans les années 1980 comme un outil pour aider les ordinateurs à reconnaître des modèles et à simuler l'intelligence humaine". Car en réalité, les réseaux de neurones sont apparus avant les années 1980.

1. 1676 : La règle en chaîne de l'attribution inversée de crédits

En 1676, Gottfried Wilhelm Leibniz a publié la règle en chaîne du calcul dans ses mémoires . Aujourd’hui, cette règle est au cœur de l’attribution de crédits dans les réseaux de neurones profonds et constitue le fondement de l’apprentissage profond moderne.

Gottfried Wilhelm Leibniz

Un réseau neuronal comporte des nœuds ou des neurones qui calculent les fonctions différentiables des entrées d'autres neurones. Les fonctions différentiables des entrées d'autres neurones sont également calculées. Si vous souhaitez connaître les changements dans le résultat final de la fonction après avoir modifié les paramètres ou les poids des fonctions précédentes, vous devez utiliser la règle de chaîne.

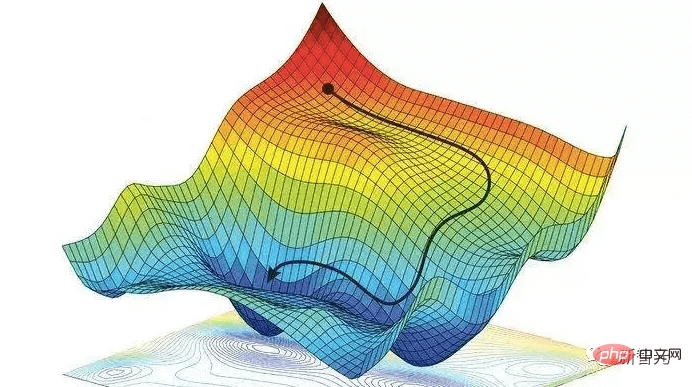

Cette réponse est également utilisée pour la technique de descente de gradient. Afin d'apprendre au réseau neuronal à transformer le modèle d'entrée de l'ensemble d'apprentissage en modèle de sortie souhaité, tous les poids du réseau neuronal sont légèrement modifiés de manière itérative dans le sens d'une amélioration locale maximale pour créer un réseau neuronal légèrement meilleur, et ainsi de suite, progressivement Proche de la combinaison optimale de poids et de biais pour minimiser la fonction de perte.

Il est à noter que Leibniz fut également le premier mathématicien à découvrir le calcul. Lui et Isaac Newton ont découvert le calcul indépendamment, et les symboles mathématiques du calcul qu'il a utilisés sont plus largement utilisés. Les symboles inventés par Leibniz sont généralement considérés comme plus complets et ont une gamme d'applications plus large.

De plus, Leibniz fut « le premier informaticien du monde ». Il a conçu la première machine en 1673 capable d'effectuer les quatre opérations arithmétiques, jetant ainsi les bases de l'informatique moderne.

2. Début du 19ème siècle : Réseaux de neurones, régression linéaire et apprentissage superficiel

En 1805, Adrien-Marie Legendre publie ce qu'on appelle aujourd'hui communément un contenu de réseau de neurones linéaire.

Adrien Marie Legendre

Plus tard, Johann Carl Friedrich Gauss était également célèbre pour des recherches similaires. Il a reçu des éloges.

Ce réseau neuronal d'il y a plus de 2 siècles comporte deux couches : une couche d'entrée avec plusieurs unités d'entrée et une couche de sortie. Chaque cellule d'entrée peut contenir une valeur réelle et est connectée à la sortie via une connexion avec des poids réels.

La sortie d'un réseau de neurones est la somme des produits des entrées et de leurs poids. Étant donné un ensemble d’entraînement de vecteurs d’entrée et une valeur cible attendue pour chaque vecteur, ajustez les poids pour minimiser la somme des erreurs quadratiques entre la sortie du réseau neuronal et la cible correspondante.

Bien sûr, cela ne s'appelait pas un réseau de neurones à l'époque. C'est ce qu'on appelle les moindres carrés, également connus sous le nom de régression linéaire. Mais c'est mathématiquement la même chose que les réseaux de neurones linéaires d'aujourd'hui : même algorithme de base, même fonction d'erreur, mêmes paramètres/poids adaptatifs.

Johann Carl Friedrich Gauss

Ce réseau neuronal simple effectue un "apprentissage superficiel", par opposition à un "apprentissage profond" avec de nombreuses couches non linéaires. En fait, de nombreux cours sur les réseaux de neurones commencent par une introduction à cette approche, puis passent à des réseaux de neurones plus complexes et approfondis.

Aujourd'hui, il est obligatoire pour les étudiants de toutes les matières techniques de suivre des cours de mathématiques, notamment d'analyse, d'algèbre linéaire et de statistiques. Dans tous ces domaines, de nombreux résultats et méthodes importants sont attribués à Gauss : le théorème fondamental de l'algèbre, la méthode d'élimination gaussienne, la distribution gaussienne des statistiques, etc.

L'homme connu comme « le plus grand mathématicien depuis l'Antiquité » a également été un pionnier de la géométrie différentielle, de la théorie des nombres (son sujet préféré) et de la géométrie non euclidienne. Sans ses réalisations, l’ingénierie moderne, y compris l’IA, serait impensable.

III. 1920-1925 : Le premier réseau neuronal récurrent

Semblable au cerveau humain, un réseau neuronal récurrent (RNN) a des connexions de rétroaction afin qu'il puisse suivre des connexions dirigées de certains nœuds internes vers d'autres nœuds, et se termine enfin. au point de départ. Ceci est essentiel pour activer la mémoire des événements passés pendant le traitement de la séquence.

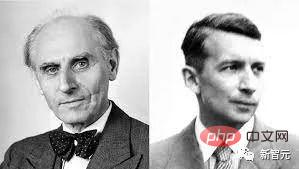

Wilhelm Lenz (à gauche) ; Ernst Ising (à droite)

Les physiciens Ernst Ising et Wilhelm Lenz ont présenté et analysé la première architecture RNN sans apprentissage dans les années 1920 : le modèle Ising. Il entre dans un état d'équilibre basé sur les conditions d'entrée et constitue la base du premier modèle d'apprentissage RNN.

En 1972, Shun-Ichi Amari a rendu l'architecture de boucle du modèle Ising adaptative, apprenant à associer les modèles d'entrée aux modèles de sortie en modifiant leurs poids de connexion. Il s'agit du premier RNN d'apprentissage au monde.

Shunichi Amari

Actuellement, le RNN le plus populaire est le réseau de mémoire à long terme et à court terme LSTM proposé par Schmidhuber. Il est devenu le réseau neuronal le plus cité du XXe siècle.

4. 1958 : Réseau neuronal à action prospective multicouche

En 1958, Frank Rosenblatt a combiné un réseau neuronal linéaire et une fonction de seuil pour concevoir un perceptron multicouche (MLP) plus profond.

Frank Rosenblatt

Le perceptron multicouche suit les principes du système nerveux humain, apprend et fait des prédictions de données. Il apprend d'abord, puis stocke les données à l'aide de poids, et utilise des algorithmes pour ajuster les poids et réduire les biais pendant l'entraînement, c'est-à-dire l'erreur entre les valeurs réelles et les valeurs prédites.

Étant donné que la formation de réseaux feedforward multicouches utilise souvent l'algorithme de rétro-propagation des erreurs, il est considéré comme un algorithme d'apprentissage supervisé standard dans le domaine de la reconnaissance de formes et continue d'être étudié dans les domaines de la neurologie computationnelle et du parallèle. sujet du traitement distribué.

5. 1965 : Le premier apprentissage profond

L'apprentissage réussi des architectures de réseau à rétroaction profonde a commencé en Ukraine en 1965, lorsque Alexey Ivakhnenko et Valentin Lapa ont introduit le premier MLP profond avec un nombre arbitraire de couches cachées. algorithme d'apprentissage.

Alexey Ivakhnenko

Étant donné un ensemble d'entraînement de vecteurs d'entrée avec des vecteurs de sortie cibles correspondants, les couches sont progressivement développées et entraînées par analyse de régression, puis élaguées à l'aide d'un ensemble de validation séparé, où la régularisation est utilisée pour supprimer les unités redondantes. Le nombre de couches et d'unités par couche sont appris en fonction du problème.

Comme les réseaux de neurones profonds ultérieurs, le réseau d'Ivakhnenko a appris à créer des représentations internes hiérarchiques et distribuées des données entrantes.

Il ne les a pas appelés réseaux de neurones d’apprentissage profond, mais c’est ce qu’ils sont. En fait, le terme « apprentissage profond » a été introduit pour la première fois dans le domaine de l’apprentissage automatique par Dechter en 1986, et Aizenberg et al. ont introduit le concept de « réseau neuronal » en 2000.

VI. 1967-68 : Descente de gradient stochastique

En 1967, Junichi Amari a proposé pour la première fois la formation de réseaux de neurones par descente de gradient stochastique (SGD).

Shunichi Amari et son élève Saito ont appris les représentations internes dans un MLP à cinq couches avec deux couches modifiables, qui ont été entraînées à classer des classes de motifs non linéairement séparables.

Rumelhart et Hinton et al ont effectué un travail similaire en 1986 et l'ont nommé algorithme de rétropropagation.

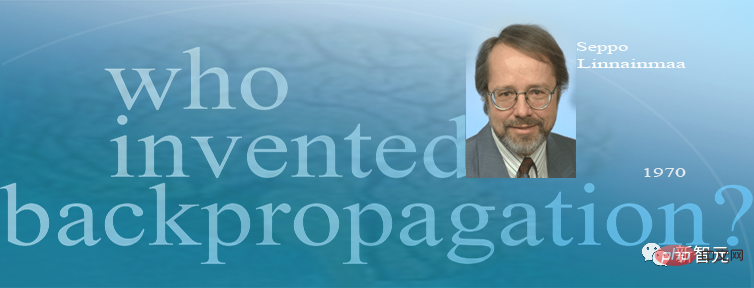

7. 1970 : Algorithme de rétropropagation

En 1970, Seppo Linnainmaa a été le premier à publier l'algorithme de rétropropagation, qui est un célèbre algorithme d'allocation de crédits de réseau de nœuds différenciables, également connu sous le nom de « mode inverse différentiel automatique ».

Seppo Linnainmaa

Linnainmaa décrit pour la première fois une méthode efficace de rétropropagation d'erreurs pour les réseaux de neurones dans le cas de connexions clairsemées arbitraires et discrètes. Il constitue désormais la base de progiciels de réseaux neuronaux largement utilisés tels que PyTorch et Tensorflow de Google.

La rétropropagation est essentiellement un moyen efficace de mettre en œuvre la règle de chaîne de Leibniz pour les réseaux profonds. La descente de gradient, proposée par Cauchy, est utilisée au fil de nombreuses expériences pour affaiblir progressivement certaines connexions des réseaux neuronaux et en renforcer d'autres.

En 1985, alors que les coûts informatiques étaient environ 1 000 fois inférieurs à ceux de 1970, lorsque les ordinateurs de bureau devenaient monnaie courante dans les riches laboratoires universitaires, David Rumelhart et d'autres ont mené des analyses expérimentales de méthodes connues.

David Rumelhart

Grâce à des expériences, Rumelhart et al. ont démontré que la rétropropagation peut produire des représentations internes utiles dans les couches cachées des réseaux neuronaux. Au moins pour l'apprentissage supervisé, la rétropropagation est souvent plus efficace que l'apprentissage en profondeur mentionné ci-dessus par Amari Shunichi via la méthode SGD.

Avant 2010, de nombreuses personnes pensaient que la formation des réseaux neuronaux multicouches nécessitait une pré-formation non supervisée. En 2010, l'équipe de Schmidhuber et Dan Ciresan ont montré que les FNN profonds peuvent être formés par simple rétropropagation et ne nécessitent aucune formation préalable non supervisée pour les applications importantes.

8. 1979 : Le premier réseau de neurones convolutifs

En 1979, Kunihiko Fukushima développe un modèle de réseau de neurones pour la reconnaissance de formes au STRL : Neocognitron.

Kunihiko Fukushima

Mais dans les termes actuels, ce Neocognitron s'appelle un réseau neuronal convolutionnel (CNN). C'est l'une des plus grandes inventions de la structure de base des réseaux neuronaux profonds et du courant. Technologie d'intelligence artificielle. Technologie de base intelligente.

Le Neocognitron introduit par le Dr Fukushima est le premier réseau neuronal à utiliser la convolution et le sous-échantillonnage, et est également le prototype du réseau neuronal convolutif.

Le réseau neuronal artificiel multicouche doté de capacités d'apprentissage conçu par Fukushima Kunihiko peut imiter le réseau visuel du cerveau. Cette « perspicacité » est devenue la base de la technologie moderne de l'intelligence artificielle. Les travaux du Dr Fukushima ont donné lieu à une gamme d'applications pratiques, allant des voitures autonomes à la reconnaissance faciale, de la détection du cancer à la prévision des inondations, et bien d'autres à venir.

En 1987, Alex Waibel a combiné le réseau neuronal avec convolution avec partage de poids et rétropropagation, et a proposé le concept de réseau neuronal retardé (TDNN).

Depuis 1989, l’équipe de Yann LeCun contribue à l’amélioration de CNN, notamment dans les images.

Yann LeCun

Fin 2011, l'équipe de Schmidhuber a considérablement accéléré la formation des CNN profonds, les rendant plus populaires dans la communauté de l'apprentissage automatique. L'équipe a lancé un CNN basé sur GPU : DanNet, qui est plus profond et plus rapide que les premiers CNN. La même année, DanNet est devenu le premier CNN purement profond à remporter un concours de vision par ordinateur.

Le réseau de neurones résiduels (ResNet) proposé par quatre chercheurs de Microsoft Research a remporté la première place au concours de reconnaissance visuelle à grande échelle ImageNet 2015.

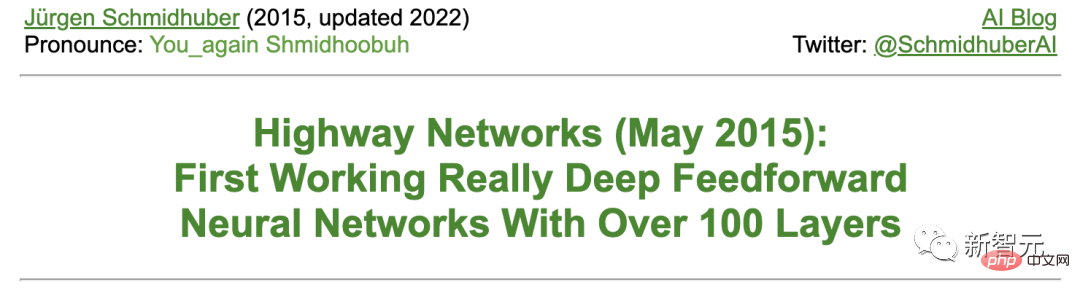

Schmidhuber a déclaré que ResNet est une première version du réseau neuronal à haut débit (Highway Net) développé par son équipe. Il s’agit du premier réseau neuronal à rétroaction profonde véritablement efficace comportant des centaines de couches, par rapport aux réseaux neuronaux précédents qui ne comptaient que des dizaines de couches au maximum.

9. 1987-1990 : réseau neuronal graphique et règle delta stochastique

L'architecture d'apprentissage en profondeur capable de manipuler des données structurées (telles que des graphiques) a été proposée par Pollack en 1987 et développée au début des années 1990 par Sperduti, Goller. et Küchler pour les extensions et améliorations. Aujourd'hui, les réseaux de neurones graphiques sont utilisés dans de nombreuses applications.

Paul Werbos et R. J. Williams et al. ont analysé la méthode de mise en œuvre de la descente de gradient dans RNN. La carte auto-organisée de Teuvo Kohonen est également devenue populaire.

Teuvo Kohonen

En 1990, Stephen Hanson a introduit la règle stochastique delta, une méthode stochastique de formation des réseaux neuronaux par rétropropagation. Des décennies plus tard, cette méthode est devenue populaire sous le surnom de « dropout ».

10 février 1990 : Generative Adversarial Network/Curiosity

Generative Adversarial Network (GAN) a été publié pour la première fois en 1990 sous le nom de "Artificial Intelligence Curiosity".

Deux NN contradictoires (un générateur de probabilité et un prédicteur) tentent de maximiser les pertes de chacun dans un jeu à limite minimale. Où :

- Le générateur (appelé le contrôleur) génère des sorties probabilistes (en utilisant des unités stochastiques, comme plus tard StyleGAN).

- Le prédicteur (appelé modèle mondial) voit les sorties du contrôleur et prédit comment l'environnement y réagira. En utilisant la descente de gradient, le prédicteur NN minimise son erreur, tandis que le générateur NN essaie de maximiser cette erreur - la perte d'un réseau est le gain de l'autre réseau.

4 ans avant l'article de 2014 sur le GAN, Schmidhuber résumait ainsi le NN contradictoire génératif de 1990 dans la célèbre enquête de 2010 : « Les réseaux de neurones en tant que modèles mondiaux prédictifs sont utilisés pour maximiser le contrôle. La récompense intrinsèque de la machine est proportionnelle à la erreur de prédiction du modèle.

Le GAN publié plus tard n'est qu'un exemple. Lorsque les expériences sont très courtes, l'environnement renvoie simplement 1 ou 0 selon que la sortie du contrôleur (ou du générateur) se trouve dans un ensemble donné.

Les principes de 1990 sont largement utilisés dans l'exploration de l'apprentissage par renforcement et la synthèse d'images réalistes, bien que ce dernier domaine ait été récemment repris par Latent Diffusion de Rombach et al.

En 1991, Schmidhuber a publié une autre méthode de ML basée sur deux NN contradictoires, appelée minimisation de la prévisibilité, pour créer des représentations distinctes de données partiellement redondantes, qui a été appliquée aux images en 1996.

Novembre, avril 1990 : Générer des sous-objectifs/travailler sur des instructions

Au cours des derniers siècles, la plupart des NN se sont consacrés à la simple reconnaissance de formes plutôt qu'au raisonnement avancé.

Cependant, au début des années 1990, des exceptions sont apparues pour la première fois. Ce travail injecte le concept de l'intelligence artificielle hiérarchique « symbolique » traditionnelle dans un NN « sous-symbolique » distinctif de bout en bout.

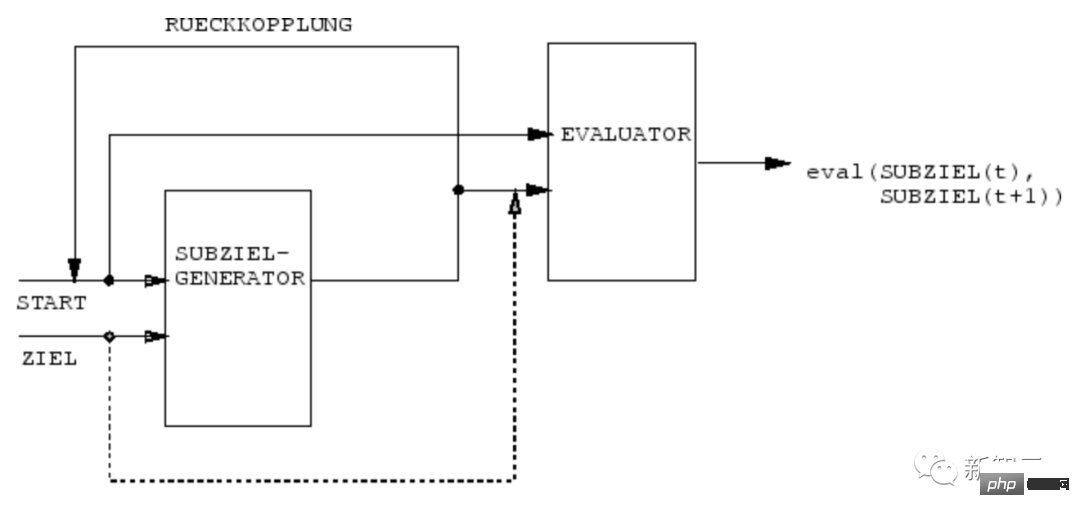

En 1990, l'équipe NN de Schmidhuber a appris à utiliser le générateur de sous-objectifs de NN différentiable de bout en bout pour générer des plans d'action hiérarchiques pour l'apprentissage par renforcement hiérarchique (HRL).

Une machine RL reçoit une entrée de commande supplémentaire sous la forme de (démarrage, cible). Un estimateur NN apprend à prédire la récompense/le coût actuel du début à l'objectif. Un générateur de sous-objectifs basé sur (R)NN voit également (début, objectif) et apprend une séquence de sous-objectifs intermédiaires le moins coûteux via une descente de gradient à l'aide d'une (copie) de l'évaluateur NN. La machine RL tente d'utiliser cette séquence de sous-objectifs pour atteindre l'objectif final.

Le système apprend des plans d'action à plusieurs niveaux d'abstraction et à plusieurs échelles de temps, et résout en principe ce que l'on a récemment appelé des « problèmes ouverts ».

Douze, mars 1991 : Transformateur avec auto-attention linéaire

Transformer avec "auto-attention linéaire" a été publié pour la première fois en mars 1991.

Ces soi-disant « programmeurs de poids rapide » ou « contrôleurs de poids rapides » séparent le stockage et le contrôle, tout comme les ordinateurs traditionnels, mais dans une approche de différenciation de bout en bout, adaptative et de réseau neuronal.

De plus, les Transformers d'aujourd'hui font largement appel à la pré-formation non supervisée, une méthode d'apprentissage en profondeur publiée pour la première fois par Schmidhuber en 1990-1991.

13 avril 1991 : Apprentissage profond grâce à une pré-formation auto-supervisée

Les NN les plus puissants d'aujourd'hui ont tendance à être très profonds, c'est-à-dire qu'ils comportent de nombreuses couches de neurones ou de nombreuses phases de calcul ultérieures.

Cependant, avant les années 1990, la formation basée sur le gradient ne fonctionnait pas pour les NN profonds (uniquement pour les NN peu profonds).

Différent du feedforward NN (FNN), RNN a des connexions de rétroaction. Cela fait de RNN un ordinateur de séquence parallèle puissant et polyvalent, capable de traiter des séquences d'entrée de n'importe quelle longueur (telles que la parole ou la vidéo).

Cependant, avant les années 1990, RNN n'a pas réussi à apprendre de profonds problèmes dans la pratique.

À cette fin, Schmidhuber a établi une hiérarchie RNN auto-supervisée pour tenter de parvenir à un « apprentissage profond universel ».

Avril 1991 : Distiller un NN en un autre NN

En utilisant la procédure de distillation de NN proposée par Schmidhuber en 1991, la représentation interne hiérarchique du compresseur d'histoire neuronale décrite ci-dessus peut être compressée en un seul NN récursif (RNN ).

Ici, les connaissances de l'enseignant NN sont « distillées » dans l'élève NN en entraînant l'élève NN à imiter le comportement de l'enseignant NN (tout en recyclant également l'élève NN pour s'assurer que les compétences acquises précédemment ne seront pas oublié) . La méthode de distillation NN a également été rééditée plusieurs années plus tard et est aujourd’hui largement utilisée.

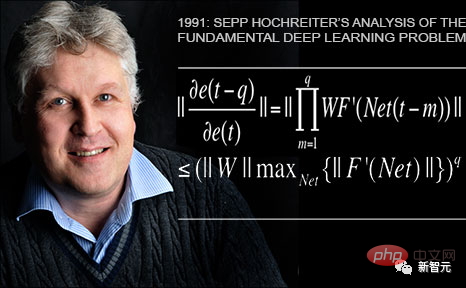

14 juin 1991 : Problème de base - disparition du gradient

Le premier étudiant de Schmidhuber, Sepp Hochreiter, a découvert et analysé les problèmes fondamentaux d'apprentissage profond dans sa thèse de fin d'études de 1991.

Les NN profonds souffrent du désormais célèbre problème du gradient de disparition : dans les réseaux profonds ou récurrents typiques, le signal d'erreur rétropropagé diminue rapidement ou dépasse les limites. Dans les deux cas, l’apprentissage échoue.

15 juin 1991 : La base de LSTM/Highway Net/ResNet

Le réseau neuronal récurrent à mémoire à long terme et à court terme (LSTM) dépasse la profondeur fondamentale soulignée par Sepp Hochreiter dans le 1991 mentionné ci-dessus. problèmes d'apprentissage de la thèse de fin d'études.

Après avoir publié un article évalué par des pairs en 1997 (aujourd'hui l'article NN le plus cité au 20e siècle), les étudiants de Schmidhuber, Felix Gers et Alex Graves, entre autres, ont encore amélioré le LSTM et ses procédures de formation.

La variante LSTM publiée en 1999-2000 - "l'architecture vanille LSTM" avec portes d'oubli - est encore utilisée aujourd'hui dans Tensorflow de Google.

En 2005, Schmidhuber a publié pour la première fois un article sur la rétropropagation complète et la propagation bidirectionnelle du LSTM dans le temps (également largement utilisé).

Une méthode de formation marquante en 2006 est la « Classification Temporelle Connexionniste » (CTC), qui est utilisée pour aligner et identifier simultanément des séquences.

L'équipe de Schmidhuber a appliqué avec succès le LSTM formé par CTC à la parole (il existe également des piles LSTM en couches) en 2007, obtenant pour la première fois d'excellents résultats de reconnaissance vocale neuronale de bout en bout.

En 2009, grâce aux efforts d'Alex, LSTM formé par CTC est devenu le premier RNN à remporter des concours internationaux, notamment trois concours d'écriture manuscrite ICDAR 2009 (français, farsi, arabe). Cela a suscité un grand intérêt dans l’industrie. LSTM a été rapidement utilisé dans toutes les situations impliquant des données de séquence, telles que la parole et la vidéo.

En 2015, la combinaison CTC-LSTM a grandement amélioré les performances de reconnaissance vocale de Google sur les smartphones Android. Jusqu'en 2019, la reconnaissance vocale de Google sur le terminal mobile reposait encore sur le LSTM.

1995 : Modèle de langage probabiliste neuronal

En 1995, Schmidhuber a proposé un excellent modèle de texte probabiliste neuronal, et ses concepts de base ont été réutilisés en 2003.

En 2001, Schmidhuber a montré que le LSTM peut apprendre des langages que les modèles traditionnels tels que le HMM ne peuvent pas apprendre.

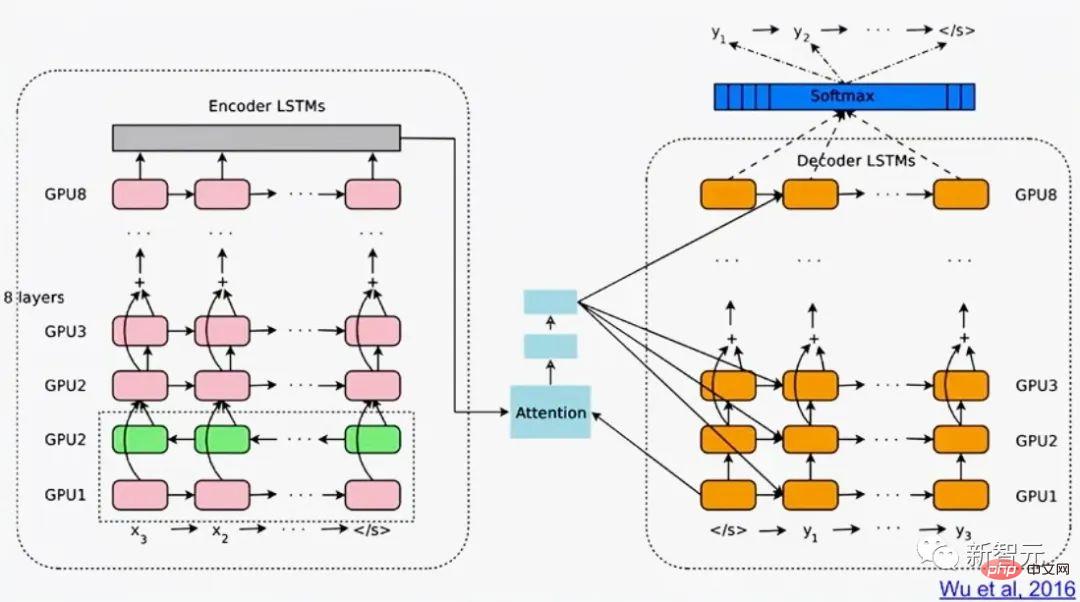

Google Translate en 2016 repose sur deux LSTM connectés (le livre blanc mentionne LSTM plus de 50 fois), un pour le texte entrant et un pour la traduction sortante.

La même année, plus d'un quart de la puissance de calcul utilisée pour l'inférence dans les centres de données de Google a été utilisé pour LSTM (et 5 % ont été utilisés pour une autre technologie d'apprentissage en profondeur populaire, à savoir CNN).

En 2017, LSTM générait également des traductions automatiques pour Facebook (plus de 30 milliards de traductions par semaine), Quicktype d'Apple sur environ 1 milliard d'iPhone, la voix Alexa d'Amazon, ainsi que la génération de légendes d'images et de réponses automatisées par e-mail de Google. apporter un soutien.

Bien sûr, le LSTM de Schmidhuber est également largement utilisé dans les soins de santé et le diagnostic médical : une simple recherche sur Google Scholar peut trouver d'innombrables articles médicaux avec « LSTM » dans le titre.

En mai 2015, l'équipe Schmidhuber a proposé Highway Network basé sur le principe LSTM, le premier FNN très profond avec des centaines de couches (les NN précédents n'avaient que des dizaines de couches au maximum). ResNet de Microsoft (qui a remporté le concours ImageNet 2015) en est une version.

Les performances des premiers Highway Net sur ImageNet étaient à peu près les mêmes que celles de ResNet. Des variantes de Highway Net sont également utilisées pour certaines tâches algorithmiques où les couches résiduelles pures ne fonctionnent pas bien.

Le principe LSTM/Highway Net est au cœur de l'apprentissage profond moderne

Le cœur de l'apprentissage profond est la profondeur NN.

Dans les années 1990, le LSTM a apporté une profondeur essentiellement infinie aux NN récurrents supervisés ; en 2000, le Highway Net inspiré du LSTM a apporté de la profondeur aux NN à réaction.

Désormais, LSTM est devenu le NN le plus cité au 20ème siècle, et ResNet, l'une des versions de Highway Net, est le NN le plus cité au 21ème siècle.

16 1980 à aujourd'hui : NNN pour des actions d'apprentissage sans professeur

De plus, NN est également lié à l'apprentissage par renforcement (RL).

Bien que certains problèmes puissent être résolus par des technologies non neuronales inventées dès les années 1980. Par exemple, la recherche arborescente de Monte Carlo (MC), la programmation dynamique (DP), l'évolution artificielle, l'élagage α-β, la théorie du contrôle et l'identification du système, la descente de gradient stochastique et les techniques de recherche générales. Mais les FNN et RNN profonds peuvent apporter de meilleurs résultats pour certains types de tâches RL.

De manière générale, un agent d'apprentissage par renforcement doit apprendre à interagir avec un environnement dynamique, initialement inconnu, partiellement observable sans l'aide d'un enseignant, maximisant ainsi le signal de récompense cumulatif attendu. Il peut y avoir des délais arbitraires, a priori inconnus, entre les actions et les conséquences perçues.

Lorsque l'environnement dispose d'une interface Markov telle que l'entrée vers l'agent RL peut transmettre toutes les informations nécessaires pour déterminer la prochaine meilleure action, basée sur la programmation dynamique (DP) / la différence temporelle (TD) / Monte Carlo RL avec La recherche arborescente (MC) peut être très efficace.

Pour les situations plus complexes sans interface Markov, l'agent doit considérer non seulement l'entrée actuelle, mais aussi l'historique des entrées précédentes. À cet égard, la combinaison des algorithmes RL et du LSTM est devenue une solution standard, en particulier le LSTM formé par gradient politique.

Par exemple, en 2018, un LSTM formé par PG au cœur du célèbre Dactyl d'OpenAI a appris à contrôler une main robotique adroite sans professeur.

Il en va de même pour les jeux vidéo.

En 2019, DeepMind (co-fondé par un étudiant du Schmidhuber Lab) a vaincu des joueurs professionnels dans le jeu "StarCraft". L'Alphastar utilisé avait un noyau LSTM profond formé par PG.

Dans le même temps, RL LSTM (représentant 84 % du nombre total de paramètres du modèle) est également le noyau du célèbre OpenAI Five, qui a vaincu les joueurs humains professionnels dans Dota 2.

L'avenir de RL consistera à apprendre/combiner/planifier avec des abstractions spatio-temporelles compactes de flux d'entrée complexes, ce qui concerne le raisonnement de bon sens et l'apprentissage de la pensée.

Schmidhuber a proposé dans un article publié en 1990-91 qu'un compresseur d'histoire neuronale auto-supervisé peut apprendre des concepts de représentation à plusieurs niveaux d'abstraction et à plusieurs échelles de temps et sur la base de sous-objectifs distinctifs de bout en bout ; NN Generator peut apprendre des plans d'action hiérarchiques grâce à la descente de gradient.

Au cours des années suivantes, 1997 et 2015-18, des méthodes plus sophistiquées d'apprentissage de la pensée abstraite ont été publiées.

Dix-sept ans. C'est un problème matériel, idiot !

Au cours des mille dernières années, sans l'amélioration continue et la mise à niveau accélérée du matériel informatique, les algorithmes d'apprentissage profond n'auraient pas été en mesure d'inaugurer des avancées majeures.

Notre premier appareil informatique à engrenages connu est le mécanisme d'Anticythère de la Grèce antique il y a plus de 2 000 ans. Il s'agit du plus ancien ordinateur scientifique complexe connu aujourd'hui et du premier ordinateur analogique au monde.

Machine d'Anticythère

La première machine programmable pratique au monde a été inventée par l'ancienne mécanicienne grecque Hélène au 1er siècle après JC.

Les machines du 17ème siècle sont devenues plus flexibles et pouvaient calculer des réponses en fonction des données d'entrée.

La première calculatrice mécanique pour l'arithmétique simple a été inventée et fabriquée par Wilhelm Schickard en 1623.

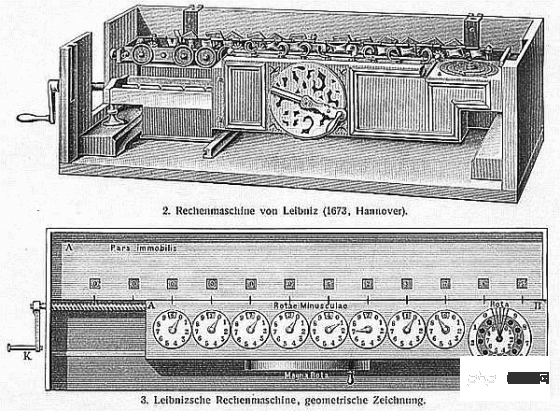

En 1673, Leibniz a conçu la première machine capable d'effectuer les quatre opérations arithmétiques et dotée de mémoire. Il a également décrit les principes d'un ordinateur binaire contrôlé par une carte perforée et a proposé la règle de chaîne, qui constitue une partie importante de l'apprentissage profond et de l'intelligence artificielle moderne.

Multiplicateur de Leibniz

Vers 1800, Joseph Marie Jacquard et d'autres construisirent le premier métier à tisser designable en France ——Machine Jacquard. Cette invention a joué un rôle déterminant dans le développement futur d’autres machines programmables, telles que les ordinateurs.

Jacquard Loom

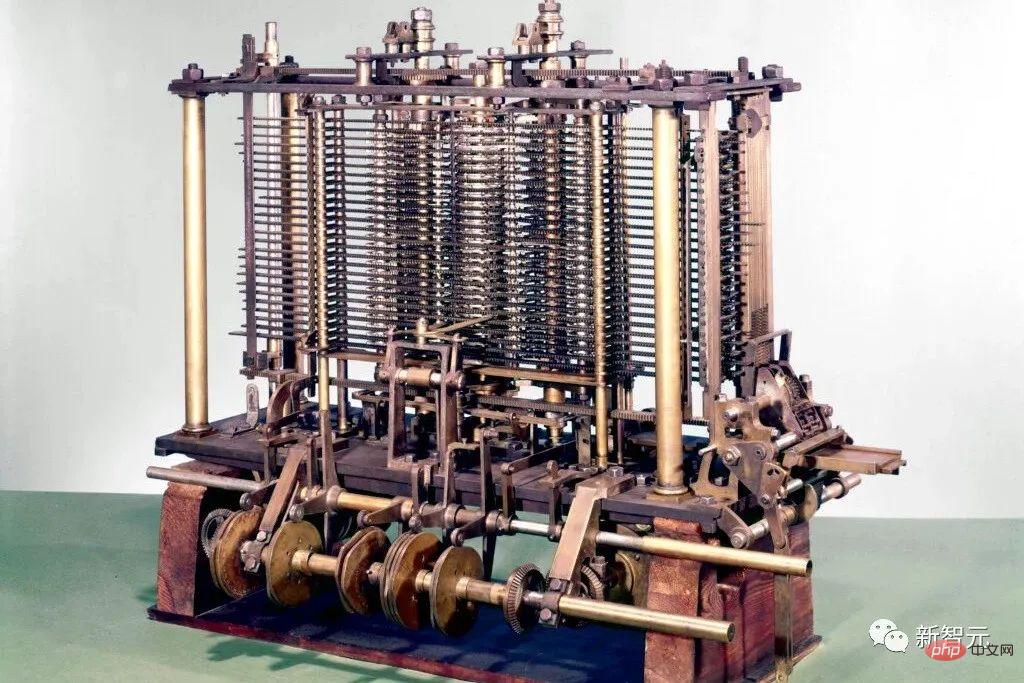

Ils ont inspiré Ada Lovelace et son mentor Charles Babbage à inventer une machine électronique moderne. Le prédécesseur de l'ordinateur : le moteur de différence de Babbage.

En 1843 suivant, Lovelace a publié le premier ensemble d'algorithmes informatiques au monde.

Le moteur de différence de Babbage

En 1914, l'Espagnol Leonardo Torres y Quevedo est devenu le premier pionnier de l'intelligence artificielle du 20e siècle lorsqu'il a créé le premier joueur de machine à terminal d'échecs.

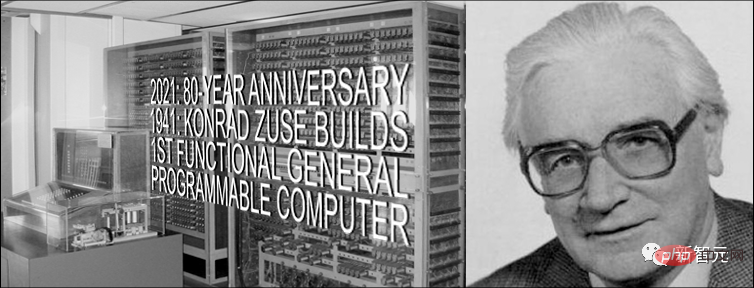

Entre 1935 et 1941, Konrad Zuse invente le premier ordinateur polyvalent programmable et opérationnel au monde : le Z3.

Conrad Zuse

Contrairement au moteur analytique de Babbage, Zuse a utilisé les principes de calcul binaire de Leibniz au lieu des calculs décimaux traditionnels. Cela simplifie grandement la charge sur le matériel.

En 1944, Howard Aiken a dirigé une équipe pour inventer le premier ordinateur numérique automatique à grande échelle au monde, Mark I (Mark I).

En 1948, Frederic Williams, Tom Kilburn et Geoff Tootill inventent le premier ordinateur à programme électronique stocké au monde : la Small Experimental Machine (SSEM), également connue sous le nom de « Manchester Baby ».

Réplique "Manchester Baby"

Depuis lors, les opérations informatiques sont devenues plus rapides grâce aux circuits intégrés (CI). En 1949, Werner Jacobi de Siemens a déposé une demande de brevet pour un circuit intégré semi-conducteur permettant l'utilisation de plusieurs transistors sur un substrat commun.

En 1958, Jack Kilby a fait la démonstration d'un circuit intégré avec des fils externes. En 1959, Robert Noyce propose le circuit intégré monolithique. Depuis les années 1970, les unités de traitement graphique (GPU) sont utilisées pour accélérer le calcul grâce au traitement parallèle. Aujourd'hui, le GPU d'un ordinateur contient des milliards de transistors.

Où sont les limites physiques ?

Selon la limite de Bremermann proposée par Hans Joachim Bremermann, un ordinateur d'une masse de 1 kilogramme et d'un volume de 1 litre peut être dans la 32ème direction jusqu'à 10 Effectuer jusqu'à 10 à la puissance 51 opérations par deuxième.

Hans Joachim Bremermann

Cependant, la masse du système solaire n'est que de 2x10^30 kilogrammes, cette tendance est vouée à s'arrêter d'ici quelques siècles, car la vitesse de la lumière va acquérir la masse supplémentaire sous la forme d’autres systèmes solaires est sévèrement limitée.

Par conséquent, les contraintes de la physique exigent que le futur matériel informatique efficace soit comme un cerveau, avec de nombreux processeurs placés de manière compacte dans un espace tridimensionnel pour minimiser le coût total de connexion, et son architecture de base est essentiellement une architecture profonde et peu connectée. RNN tridimensionnel.

Schmidhuber spécule que les méthodes d'apprentissage en profondeur telles que le RNN deviendront plus importantes.

18. Théorie de l'intelligence artificielle depuis 1931

Le cœur de l'intelligence artificielle moderne et de l'apprentissage profond est principalement basé sur les mathématiques des derniers siècles : calcul, algèbre linéaire et statistiques.

Au début des années 1930, Gödel fonde l'informatique théorique moderne. Il a introduit un langage de codage universel basé sur des nombres entiers qui permettait de formaliser les opérations de n'importe quel ordinateur numérique sous une forme axiomatique.

Dans le même temps, Gödel a également construit la célèbre déclaration formelle pour énumérer systématiquement tous les théorèmes possibles à partir d'un ensemble dénombrable d'axiomes, étant donné un testeur de théorème informatique. Ainsi, il a identifié les limites fondamentales de la preuve de théorèmes algorithmiques, du calcul et de tout type d’intelligence artificielle basée sur le calcul.

De plus, Gödel a identifié le problème ouvert le plus célèbre en informatique « P=NP ? » dans sa célèbre lettre à John von Neumann.

En 1935, Alonzo Church a dérivé un corollaire au résultat de Gödel en prouvant qu'il n'y a pas de solution générale au problème de prise de décision de Hilbert et Ackermann. Pour ce faire, il a utilisé un autre de ses langages de codage à usage général appelé Untyped Lambda Calculus, qui a constitué la base du langage de programmation très influent LISP.

En 1936, Alan Turing introduisit un autre modèle général : la machine de Turing, et obtint à nouveau les résultats ci-dessus. La même année, Emil Post publie un autre modèle informatique général indépendant.

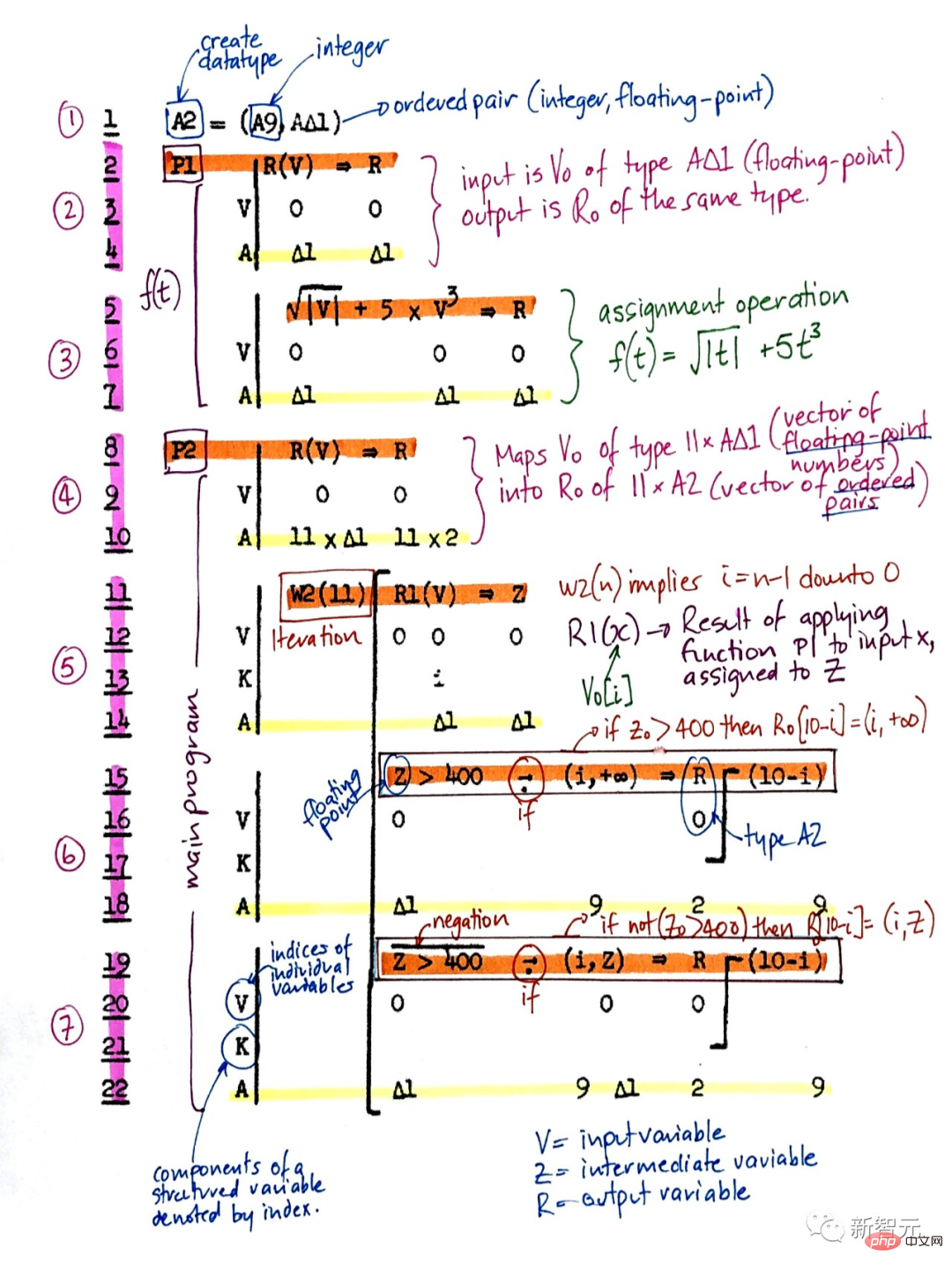

Konrad Zuse a non seulement créé le premier ordinateur polyvalent programmable utilisable au monde, mais a également conçu le premier langage de programmation de haut niveau - Plankalkül. Il l'appliqua aux échecs en 1945 et à la démonstration de théorèmes en 1948.

Plankalkül

Une grande partie des débuts de l'IA dans les années 1940 et 1970 concernait en réalité la preuve de théorèmes et la dérivation gödélienne à l'aide de systèmes experts et de programmation logique.

En 1964, Ray Solomonoff a combiné le raisonnement probabiliste bayésien (en fait laplacien) et l'informatique théorique pour arriver à une méthode d'apprentissage mathématiquement optimale (mais irréalisable sur le plan informatique), prédire les données futures à partir d'observations passées.

Avec Andrej Kolmogorov, il a fondé la théorie de la complexité de Korotkoff ou théorie algorithmique de l'information (AIT), qui formalise le concept du rasoir d'Occam à travers le concept du programme le plus court pour calculer des données, transcendant ainsi la théorie traditionnelle de l'information.

Complexité de Coriolis

L'optimalité plus générale des machines de Gödel auto-référentes ne se limite pas à l'optimalité asymptotique.

Pourtant, cette IA mathématiquement optimale n’est pas encore réalisable en pratique pour diverses raisons. Au lieu de cela, l’intelligence artificielle moderne et pratique est basée sur des technologies sous-optimales, limitées, mais pas extrêmement comprises, telles que la NN et l’apprentissage en profondeur.

Mais qui sait à quoi ressemblera l’histoire de l’intelligence artificielle dans 20 ans ?

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI