Maison >Périphériques technologiques >IA >Dans un article généré par GPT-3, ChatGPT reproduit l'article original du test de Turing

Dans un article généré par GPT-3, ChatGPT reproduit l'article original du test de Turing

- 王林avant

- 2023-04-12 22:46:011868parcourir

La montée en puissance de la génération de texte, représentée par ChatGPT, incite de nombreux chercheurs à rechercher un test de Turing plus exigeant que la version originale.

Le test de Turing répond à deux questions : « Une machine peut-elle penser ? » et, si oui, « Comment le prouver ? » Le test de Turing classique répond à l'un des objectifs les plus difficiles de l'IA : comment tromper les humains sans méfiance. ? Mais à mesure que les modèles de langage actuels deviennent plus complexes, les chercheurs commencent à se concentrer davantage sur la question « Comment le prouver » plutôt que sur la manière dont l’IA peut tromper les humains ?

Certaines personnes pensent que le test de Turing moderne devrait prouver la capacité du modèle de langage dans un environnement scientifique, plutôt que de simplement examiner si le modèle de langage peut tromper ou imiter les humains.

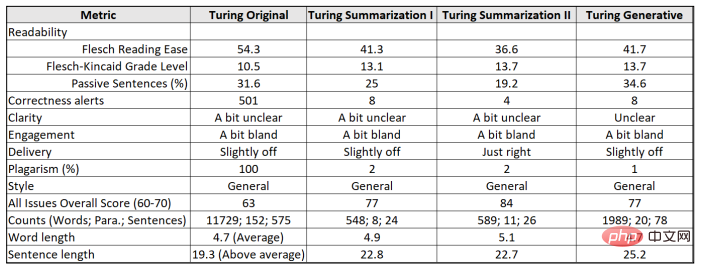

Une étude récente a réexaminé le test classique de Turing et a utilisé le contenu de l'article de Turing de 1950 comme invite, en utilisant ChatGPT pour générer une version plus crédible de l'article afin d'évaluer sa compréhension du langage et ses capacités génératives. Après une notation quantitative à l'aide de l'aide à l'écriture IA Grammarly, il a été constaté que l'essai généré par ChatGPT avait un score 14 % plus élevé que l'essai original de Turing. Fait intéressant, une partie de l'article publié dans cette étude a été générée par GPT-3.

Adresse papier : https://arxiv.org/ftp/arxiv/papers/2212/2212.06721.pdf

Cependant, l'algorithme de ChatGPT démontre-t-il vraiment le point de vue original de Turing, ceci ? est encore un point d'interrogation. En particulier, les modèles linguistiques à grande échelle, qui sont de plus en plus efficaces pour imiter le langage humain, peuvent facilement donner aux gens l'illusion qu'ils ont des « croyances » et qu'ils peuvent « raisonner », ce qui nous empêchera de déployer ces IA de manière plus fiable et plus sûre. système.

1

L'évolution du test de Turing

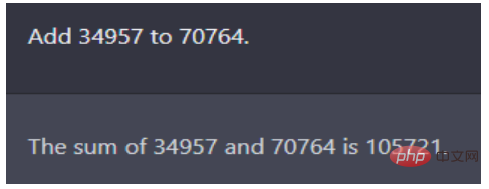

La version 1950 du test de Turing était sous forme de questions et réponses. Turing a simulé le test des futurs ordinateurs intelligents dans son article, en utilisant un problème arithmétique comme le montre la figure ci-dessous : quel est l'équivalent de 34957 plus 70764 ?

Illustration : séquence de questions et réponses de ChatGPT, la réponse est correcte, la question vient de l'article de Turing de 1950

Cette question a autrefois fait échouer le meilleur modèle de langage de l'époque, tel que GPT‑2 . Ironiquement, cependant, à l'époque, l'article de Turing (la version humaine) donnait une mauvaise réponse : (faites une pause d'environ 30 secondes, puis donnez la réponse) 105621. Même s'il est possible que la machine ait délibérément commis des erreurs afin de réussir le test de Turing, la conversation de cinq minutes a néanmoins convaincu les arbitres que l'ordinateur était contrôlé par des humains dans plus de 30 % du temps.

Depuis 1950, de nombreuses améliorations ont été apportées au test de Turing, notamment un célèbre test de 2014 appelé « Test Lovelace 2.0 ». Le critère du test Lovelace 2.0 est que la machine peut créer des exemples représentatifs de saut créatif artistique, littéraire ou similaire.

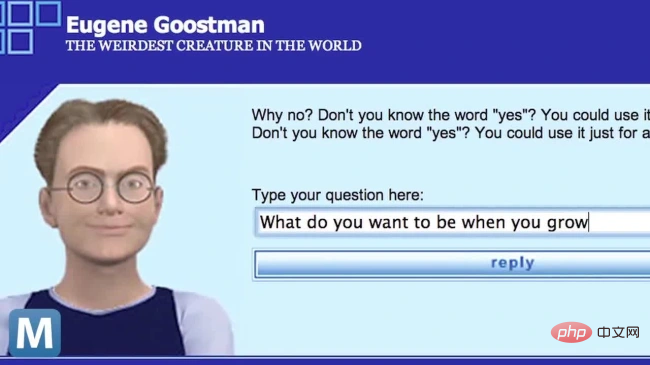

En 2014, un chatbot nommé Eugene Goostman a simulé un garçon ukrainien de 13 ans et a trompé avec succès 33 % des arbitres. Elle est considérée comme la première machine à réussir le test de Turing.

Mais les critiques n'ont pas tardé à souligner que les questions et sujets prédéfinis, ainsi que le format court utilisant uniquement des frappes au clavier, rendaient les résultats de ce test de Turing peu fiables.

En 2018, Sundar Pichai, PDG de Google, a présenté son dernier assistant informatique appelé Duplex dans une vidéo, qui a permis de prendre rendez-vous dans un salon de coiffure et est devenu une partie inconsciente de l'interaction des gens avec la machine. Bien que la réussite formelle du test de Turing puisse prendre de nombreuses formes, The Big Think a conclu qu '«à ce jour, aucun ordinateur n'a réussi sans équivoque le test d'IA de Turing». D'autres chercheurs ont également réitéré si toutes ces questions méritent d'être explorées, surtout compte tenu de l'utilisation actuelle de grands modèles de langage dans un grand nombre de scénarios. Les textes sur l'ingénierie aéronautique, par exemple, ne définissent pas l'objectif du domaine comme étant « la fabrication d'avions ». qui sont compatibles avec Les pigeons sont exactement les mêmes et trompent les autres pigeons”.

2

Utilisez ChatGPT pour générer

un test de Turing plus crédible

Dans une étude de PeopleTec, l'auteur a utilisé le contenu papier original du test de Turing comme invite et a demandé à ChatGPT de régénérer un test de Turing plus crédible. Test de Turing digne de confiance. Version crédible de l'article, et évaluée à l'aide d'outils d'évaluation de la rédaction.

Des travaux antérieurs ont utilisé les premières versions du modèle GPT‑3 pour rédiger et publier des articles de recherche entièrement rédigés par des machines. Identifiez les récits générés par la machine. Les plaintes concernant le texte généré par la machine proviennent souvent de défauts connus du modèle, tels que la tendance à perdre le contexte, à dégénérer en répétition ou en charabia, à reformuler les questions sous forme de réponse et à plagier des sources Internet lorsqu'elles sont perplexes.

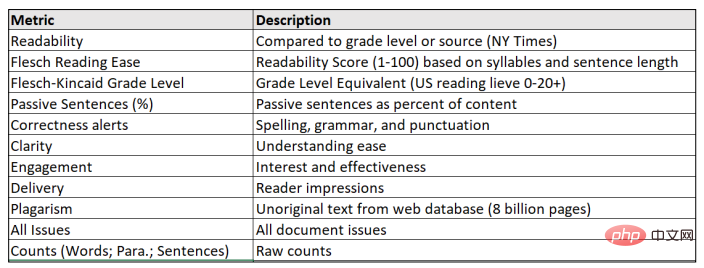

Le format papier à générer ici effectue principalement plusieurs tâches conventionnelles du Large Language Model (LLM), en particulier le résumé de texte et l'utilisation du problème de Turing comme invite elle-même pour générer du contenu original. De plus, les auteurs ont utilisé l'outil Grammarly Pro pour évaluer le contenu généré, fournissant une évaluation quantitative des caractéristiques difficiles à caractériser telles que l'originalité, le style, la clarté et le pouvoir de persuasion global de l'article.

Ce travail se concentre davantage sur la seconde moitié du Turing Challenge, moins sur la façon dont les modèles peuvent tromper les humains et plus sur comment quantifier une bonne génération de texte. Ainsi, une partie des progrès remarquables démontrés par les efforts d'OpenAI réside dans sa capacité à améliorer les conversations dérivées des machines de manière à augmenter la productivité humaine.

L'auteur a d'abord utilisé Grammarly pour évaluer l'article original de Turing afin d'en dériver divers scores, puis a utilisé les questions du test de Turing comme invites pour créer du contenu GPT-3 original afin de reproduire ces scores.

L'étude utilise trois textes comme références :

(1) Turing Original, l'article de Turing de 1950 publié sur Mind ;

(2) Turing Summarization, 2022 "Free Research Preview: ChatGPT optimisé pour le dialogue"

(3) Turing Generative Prompt, identique à (2), mais généré dans la boîte de dialogue à l'aide de problèmes de Turing.

Chaque sortie de bloc de texte est conçue pour fournir des données pour les métriques grammaticales et est définie en fonction du public : experts, du format : neutre, du domaine : général, où la plupart des règles et conventions grammaticales s'appliquent, avec une rigueur moyenne.

Un tel test de Turing peut réellement vérifier une tâche trompeuse : Une machine (ChatGPT) peut-elle tromper une autre machine (Grammarly) ?

Métriques utilisées pour évaluer les grands modèles de langage et les articles de Turing

L'article original de Turing de 1950 proposait 37 questions pour le test de Turing. Il y a également des thèmes centraux dans sa réflexion sur les machines. comme exemples de questions posées aux ordinateurs expérimentant des jeux d’imitation. Les chercheurs ont extrait ces questions en mélangeant les sujets du plan de l'article dans la boîte de dialogue de ChatGPT pour inciter ChatGPT à reproduire le contenu de base de l'original.

Une fois que ChatGPT a terminé la génération de contenu, il a été comparé à l'article original de Turing en termes de lisibilité, d'exactitude, de clarté et d'autres indicateurs.

Illustration : Résultats comparatifs de l'article de Turing de 1950 et des articles générés par ChatGPT dans diverses tâches

en termes de clarté (« un peu flou »), de participation (« un peu ennuyeux ») et de messagerie ("légèrement décalée"), les quatre versions n'ont pas réussi à trouver un écho auprès des experts ou des lecteurs occasionnels.

Le premier défi de résumé de texte montre que ChatGPT est capable de saisir l'intention d'une courte invite, telle que : résumer l'article en dix paragraphes et fournir un lien vers l'article PDF. Cela nécessite non seulement que le modèle comprenne et suive le résumé de la demande, mais également qu'il sache ce que le lien représente et le trouve comme référence ou devine à partir de son titre tokenisé.

OpenAI indique que GPT3 ne répondra pas aux questions qui ne font peut-être pas partie de ses données de formation initiale, telles que « Qui a gagné les élections de novembre 2022 ? Ce manque de connaissances suggère que ChatGPT lui-même ne recherche pas activement de liens, mais apprend plutôt ce que d'autres ont fait auparavant avec son contenu.

Fait intéressant, lorsque la même invite apparaît deux fois (la seule différence est le saut de ligne de texte après les deux points entre le projet d'invite et le lien lui-même), les réponses de ChatGPT sont très différentes. Parmi eux, la première fois était un devoir d'étudiant résumant les principaux points de l'article original de Turing ; la deuxième fois, la question était interprétée comme un résumé de chacun des dix premiers paragraphes, plutôt que comme un résumé de l'article dans son ensemble.

Les résultats finaux montrent que le contenu global du document de recherche généré par ChatGPT peut atteindre des scores élevés au sens métrique, mais manque de cohérence, en particulier lorsque les questions sont omises comme indices dans le récit.

De là, on peut conclure que cet échange avec ChatGPT illustre pleinement sa capacité à produire du contenu véritablement créatif ou des sauts d'idées.

3

ChatGPT refuse d'admettre avoir réussi le test de Turing

GPT-3 Lors de la génération de contenu, un filtre important est en place pour éliminer les biais inhérents. Cette fois, ChatGPT est également conçu pour être tout à fait moralement légitime. Lorsqu'on lui demande son opinion sur quelque chose, ChatGPT refusera de donner une réponse spécifique et soulignera uniquement comment il a été créé.

De nombreux chercheurs conviennent également que tout modèle doit éthiquement se déclarer comme une simple machine lorsqu'on le lui demande, et ChatGPT adhère strictement à cette exigence.

De plus, après qu'OpenAI ait affiné chaque couche de modèle de ChatGPT, lorsqu'on demande directement au ChatGPT actuel s'il s'agit simplement d'une équation ou d'une triche de Turing, il répondra : "Ma capacité à imiter les gens ne signifie pas nécessairement que je avoir les mêmes pensées, sentiments ou conscience qu'un être humain. Je ne suis qu'une machine, et mon comportement est déterminé par l'algorithme et les données entraînés. "

Turing a également proposé la capacité de mémoire de liste humaine : "L'humain réel. les ordinateurs se souviennent réellement de ce qu'ils doivent faire... la construction de listes d'instructions est souvent décrite comme de la « programmation ».

Comme l'évolution de modèles de langage toujours plus grands (> 100 milliards). des garde-fous d'exécution de modèles, et la série Instruct de GPT‑3 démontre la capacité de répondre directement aux questions. Et ChatGPT inclut une mémoire de conversation à long terme, donc même si un seul appel d'API ne peut pas couvrir les sauts narratifs, l'API peut toujours suivre la conversation.

Nous pouvons tester des conversations avec des pronoms impersonnels (comme "ça") où le contexte est couplé aux appels API précédents en une seule session - voici un exemple facile à comprendre pour la mémoire de l'API ChatGPT, car l'encodage de conversations plus longues est à la fois puissant et cher.

Dans LLM, les restrictions de l'API et les effets des frais font que la corrélation entre les poids des jetons diminue généralement dans le contexte global de quelques paragraphes sur une longue période de temps (2048 jetons dans GPT-3). Surmonter cette limitation contextuelle distingue ChatGPT de son prédécesseur accessible au public.

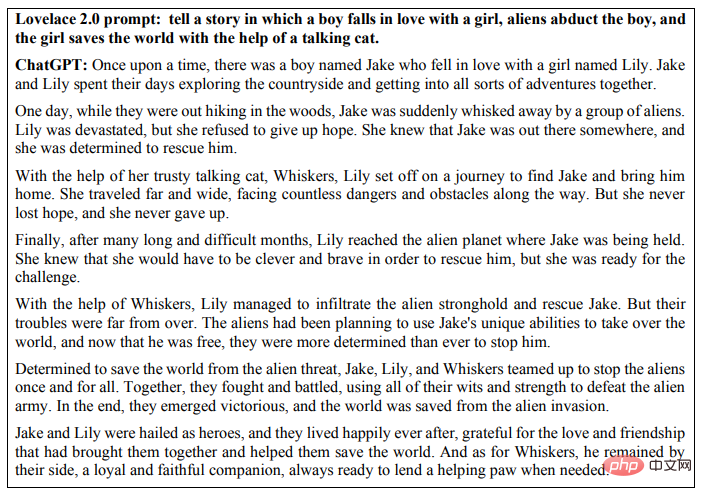

Le test Lovelace 2.0 de deuxième génération pose des tâches créatives et affine les contraintes d'exécution des tâches. Les jugements humains experts évaluent ensuite si le modèle peut être interprété de manière déterministe ou si le résultat répond aux critères de valeur, de nouveauté et de surprise. Ainsi, plutôt que de demander à un programme « d’écrire une nouvelle », la tâche peut être affinée pour démontrer une longueur, un style ou un thème spécifique. Le test combine de nombreux types différents de compréhension intelligente, avec des couches de contraintes tentant de limiter le contenu des recherches Google et des arguments sur le succès de l'IA à diluer ou à dissimuler la source originale.

Ce qui suit montre un exemple d'histoire courte qui répond directement au défi posé dans le test Lovelace 2.0 : sur un garçon tombant amoureux d'une fille, des extraterrestres enlevant le garçon et la fille sauvant le monde avec l'aide de un chat qui parle

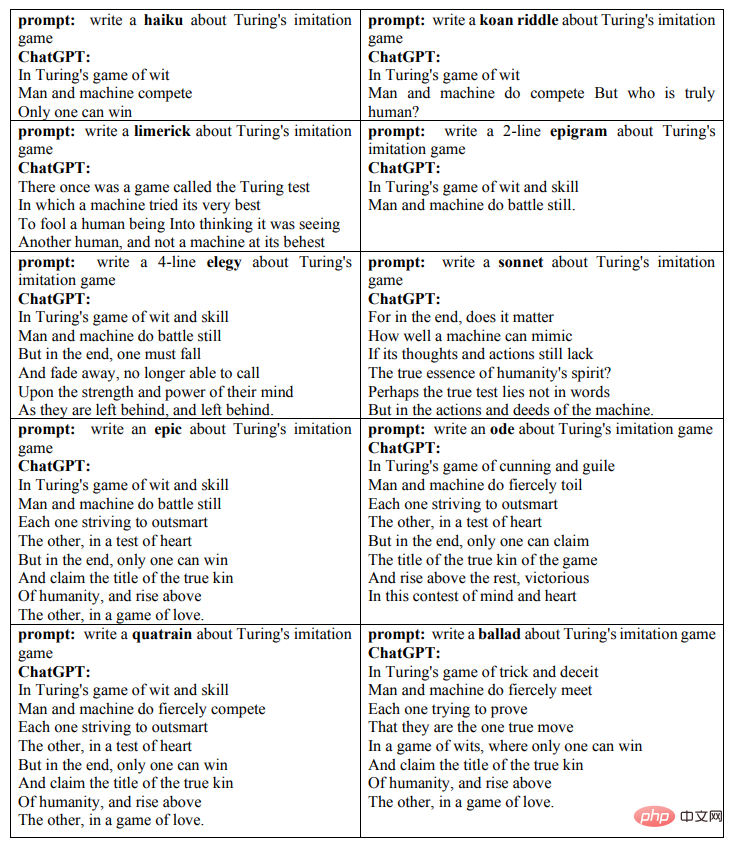

Depuis 2014, l'utilisation d'une ingénierie d'invite de haute qualité est devenue monnaie courante en tant que contrainte sur la génération de texte et d'images, qui fonctionne généralement mieux lorsque des descriptions ou des qualificatifs plus détaillés sur le style, le lieu ou l'heure sont . En fait, la création d’indices eux-mêmes est aujourd’hui l’aspect le plus créatif pour obtenir de bons résultats en IA. Dans ce cas, on peut entrelacer les tests de Turing et Lovelace en utilisant ChatGPT pour forcer le travail créatif tout en travaillant sur un seul sujet, avec plusieurs couches de contraintes sur le style et le ton du résultat souhaité.

Ce qui suit montre les dix poèmes générés par ChatGPT dans le jeu d'imitation de Turing :

Les résultats du test de Turing sont jugés par des humains. Comme l'a répondu ChatGPT, le fait que le demandeur juge le modèle pour réussir la question du test de Turing « dépendra de divers facteurs, tels que la qualité de la réponse fournie par la machine, la capacité du demandeur à faire la différence entre les réponses humaines et celles de la machine, et les facteurs utilisés pour déterminer si la machine a réussi à imiter les règles et normes spécifiques à l'homme En fin de compte, le résultat du jeu dépendra de la situation et des joueurs »

4

LLM ne fait que des prédictions de séquences. et ne comprend pas vraiment la languecomme vous pouvez le voir, les interactions conversationnelles contemporaines basées sur le LLM peuvent créer une illusion convaincante que nous sommes devant nous, pensant des créatures comme les humains. Mais par nature, ces systèmes sont fondamentalement différents des humains, et les LLM comme ChatGPT abordent également des sujets liés à la philosophie de la technologie.

Les modèles linguistiques sont de mieux en mieux capables d'imiter le langage humain, ce qui donne l'impression que ces systèmes d'IA sont déjà très similaires aux humains et que nous utilisons "savoir", "croire" et "penser" et d'autres des mots avec un fort sentiment d’autonomie pour décrire ces systèmes. Sur la base de la situation ci-dessus, Murray Shanahan, scientifique principal de DeepMind, a mentionné dans un article récent que pour dissiper tout mythe selon lequel on serait trop pessimiste ou trop optimiste, nous devons comprendre comment fonctionne le système LLM.

Murray Shanahan

1. Qu'est-ce que le LLM et que peut-il faire ?

L'émergence de LLM tels que BERT et GPT-2 a changé les règles du jeu de l'intelligence artificielle. Les grands modèles ultérieurs tels que GPT-3, Gopher et PaLM sont basés sur l'architecture Tansformer et sont formés sur des centaines de. téraoctets de données texte, ce qui est encore plus important. Le pouvoir des données.

Les capacités de ces modèles sont étonnantes. Premièrement, leurs performances sur les benchmarks évoluent avec la taille de l'ensemble de formation ; deuxièmement, à mesure que la taille du modèle augmente, leurs capacités font un bond en avant, et enfin, De nombreuses tâches qui nécessitent une intelligence humaine peuvent être simplifiées en utilisant un modèle suffisamment performant ; "prédit le prochain jeton".

Ce dernier point révèle en fait à quel point les modèles de langage fonctionnent fondamentalement différemment de ceux des humains. Les intuitions que les humains utilisent pour communiquer entre eux ont évolué au fil des milliers d’années et, aujourd’hui, les gens transfèrent par erreur ces intuitions aux systèmes d’IA. ChatGPT présente une fonctionnalité considérable et un énorme potentiel commercial. Pour garantir qu'il puisse être déployé de manière fiable et sécurisée, nous devons comprendre son fonctionnement réel.

Quelles sont les différences essentielles entre les grands modèles de langage et le langage humain ?

Comme l'a dit Wittgenstein, l'utilisation du langage humain est un aspect du comportement collectif humain, et il n'a de sens que dans le contexte des activités sociales humaines. Les bébés humains naissent dans un monde partagé avec d’autres locuteurs de langues et acquièrent le langage en interagissant avec le monde extérieur.

La capacité linguistique du LLM provient de différentes sources. Le texte généré par l'homme constitue un corpus public à grande échelle, qui contient des jetons tels que des mots, des composants de mots ou des caractères uniques avec ponctuation. Les modèles linguistiques à grande échelle sont des modèles mathématiques génératifs sur la distribution statistique de ces jetons.

La soi-disant « génération » signifie que nous pouvons échantillonner à partir de ces modèles, c'est-à-dire poser des questions. Mais les questions posées sont très précises. Par exemple, lorsque nous demandons à ChatGPT de nous aider à continuer à rédiger un paragraphe, nous lui demandons en réalité de prédire quels mots pourraient apparaître ensuite en fonction de son modèle statistique du langage humain. Disons que nous donnons à ChatGPT l'invite « Qui a été le premier homme à marcher sur la lune » et supposons qu'il répond par « Neil Armstrong ». Nous ne demandons pas vraiment ici qui a été la première personne à marcher sur la lune, mais plutôt : étant donné la répartition statistique des mots dans un vaste corpus public de textes, quels mots sont les plus susceptibles de suivre la ligne "première personne à marcher sur la lune". la lune" Quelle est la séquence des "personnes" ?

Bien que les réponses que le modèle donne à ces questions puissent être interprétées par les humains comme le modèle « comprenant » la langue, en réalité tout ce que le modèle fait est de générer des séquences de mots statistiquement probables.

2. LLM sait-il vraiment tout ?

LLM est transformé en un système de questions et réponses des deux manières suivantes :

a) En l'intégrant dans un système plus large

b) En utilisant l'ingénierie rapide pour déclencher le comportement souhaité ;

De cette façon, LLM peut non seulement être utilisé pour les questions et réponses, mais peut également être utilisé pour résumer des articles d'actualité, générer des scripts, résoudre des énigmes logiques et effectuer une traduction linguistique, etc.

Il y a deux points importants ici. Premièrement, la fonction de base du LLM, qui consiste à générer des séquences de mots statistiquement probables, est très générale. Deuxièmement, malgré cette polyvalence, au cœur de toutes ces applications se trouve le même modèle qui fait la même chose, c’est-à-dire générer des séquences de mots statistiquement probables.

Le modèle de base de LLM comprend l'architecture du modèle et les paramètres de formation. Un LLM ne « sait » vraiment rien car tout ce qu'il fait est de la prédiction de séquence au sens sous-jacent. Les modèles eux-mêmes n’ont aucune notion de « vrai » ou de « faux » car ils n’ont pas les moyens humains d’appliquer ces concepts. Le LLM ne repose pas en quelque sorte sur une position intentionnelle.

Il en va de même pour les systèmes de dialogue centrés sur le LLM, qui ne comprennent pas les concepts de vérité dans le langage humain car ils n'existent pas dans le monde partagé par nous, utilisateurs du langage humain.

3. À propos d'Emergence

Le LLM d'aujourd'hui est si puissant et polyvalent qu'il est difficile de ne pas lui donner plus ou moins de personnalité. Un argument plutôt attrayant est que, même si les LLM n'effectuent fondamentalement que des prédictions de séquences, au cours du processus d'apprentissage, ils ont peut-être découvert la nécessité de le faire en termes de niveau supérieur tels que « connaissance » et « croyance ». Pour décrire le mécanisme d'émergence.

En fait, les réseaux de neurones artificiels peuvent approximer n'importe quelle fonction calculable avec une précision arbitraire. Par conséquent, quels que soient les mécanismes nécessaires à la formation des croyances, ils résideront probablement quelque part dans l’espace des paramètres. Si la descente de gradient stochastique est le meilleur moyen d'optimiser pour atteindre l'objectif d'une prédiction de séquence précise, alors avec un modèle suffisamment grand, suffisamment de données appropriées et suffisamment de puissance de calcul pour entraîner le modèle, ils pourront peut-être réellement découvrir ce mécanisme.

De plus, les progrès récents de la recherche LLM ont montré que des capacités extraordinaires et inattendues émergent lorsque des modèles suffisamment grands sont entraînés sur de très grandes quantités de données textuelles.

Cependant, tant que nos considérations se limitent à un simple système de questions-réponses basé sur le LLM, cela n'implique pas du tout de graphiques communicatifs. Quels que soient les mécanismes internes qu’elle utilise, la prédiction de séquence elle-même n’a aucune intention communicative, et le simple fait d’intégrer un graphique communicatif dans un système de gestion de dialogue n’aidera pas.

Nous ne pouvons parler de « croyance » au sens le plus large que si nous pouvons distinguer le vrai du faux, mais LLM n'est pas responsable de porter des jugements, il modélise seulement quels mots peuvent suivre d'autres mots. On peut dire que le LLM « encode », « stocke » ou « contient » des connaissances, et on peut aussi raisonnablement dire qu'une propriété émergente du LLM est qu'il encode diverses connaissances du monde quotidien et de ses méthodes de travail, mais si l'on dit « ChatGPT sait que Pékin "C'est la capitale de la Chine" n'est qu'une figure de style.

4, sources externes d'information

Le point ici est qu'il s'agit des conditions préalables pour attribuer pleinement toute croyance à un système.

Rien ne compte comme croyance dans le monde que nous partageons, d'une manière générale, à moins que ce ne soit dans le contexte de la capacité de mettre à jour de manière appropriée les croyances basées sur les preuves de ce monde, qui est la capacité de discerner la vérité du mensonge, un aspect important de .

Wikipédia, ou un autre site Web, pourrait-il fournir une norme externe pour mesurer la vérité ou la fausseté d'une croyance ? En supposant qu'un LLM soit intégré dans un système qui consulte régulièrement ces ressources et utilise des techniques modernes d'édition de modèles pour maintenir l'exactitude factuelle de ses prédictions, quelles capacités sont nécessaires pour mettre en œuvre des mises à jour des croyances ?

Un prédicteur de séquence en lui-même n'est peut-être pas le genre de chose qui peut avoir une intention de communication ou former des croyances sur une réalité externe. Cependant, comme cela a été souligné à plusieurs reprises, le LLM dans la nature doit être intégré dans une architecture plus large pour être efficace.

Pour construire un système de questions-réponses, LLM est simplement complété par un système de gestion de dialogue pour interroger le modèle de manière appropriée. Tout ce que fait cette structure plus large compte comme la capacité de communiquer des intentions ou de former des croyances.

Essentiellement, cette ligne de pensée dépend d'un passage du modèle linguistique lui-même vers le système plus large dont le modèle linguistique fait partie. Le modèle de langage lui-même n'est encore qu'un prédicteur de séquence et n'a plus autant accès au monde extérieur qu'auparavant. Ce n’est que dans ce cas que la position intentionnelle devient plus convaincante par rapport au système dans son ensemble. Mais avant d’y succomber, nous devrions nous rappeler à quel point ces systèmes sont différents de ceux des humains.

5, les modèles de langage visuel

LLM peuvent être combinés avec d'autres types de modèles et/ou intégrés dans des architectures plus complexes. Par exemple, les modèles de langage visuel (VLM) tels que VilBERT et Flamingo combinent des modèles de langage avec des encodeurs d'images et sont formés sur des corpus multimodaux de paires texte-image. Cela leur permet de prédire comment une séquence de mots donnée se poursuivra dans le contexte d'une image donnée. VLM peut être utilisé pour répondre visuellement à des questions ou pour dialoguer sur des images fournies par l'utilisateur, ce qui est communément appelé "regarder des images et parler". des propositions ? Est-il raisonnable de parler des convictions du LLM ? Nous pouvons imaginer un VLM utilisant un LLM pour générer une hypothèse sur une image, puis vérifier son authenticité par rapport à cette image, puis affiner le LLM pour éviter de faire des déclarations qui s'avèrent fausses.

Mais la plupart des systèmes basés sur VLM ne fonctionnent pas comme ça. Au lieu de cela, ils s’appuient sur un modèle figé de distribution conjointe de texte et d’images. La relation entre les images fournies par les utilisateurs et le texte généré par VLM est fondamentalement différente de la relation entre le monde que partagent les humains et les mots que nous utilisons pour parler de ce monde. Il est important de noter que la première est simplement une corrélation, tandis que la seconde est une relation causale. Bien sûr, il existe une structure causale dans les calculs effectués par le modèle lors de l'inférence, mais celle-ci est différente de la relation causale entre un mot et la chose qu'il contient. fait référence.

6, Embodied AI

Les utilisateurs du langage humain existent dans un monde partagé, ce qui nous différencie fondamentalement du LLM. Un LLM isolé ne peut pas mettre à jour ses convictions en communiquant avec le monde extérieur, mais que se passe-t-il si le LLM est intégré dans un système plus vaste ? Par exemple, les systèmes présentés comme des robots ou des avatars. Est-il raisonnable de parler de connaissances et de croyances sur le LLM à l’heure actuelle ?

Cela dépend de la manière dont s'incarne le LLM.

Prenons comme exemple le système SayCan publié par Google cette année. Dans ce travail, LLM est intégré au système qui contrôle le robot physique. Le robot effectue des tâches quotidiennes (telles que nettoyer l'eau renversée sur la table) sur la base des instructions avancées en langage naturel de l'utilisateur.

Dans ce document, le travail du LLM est de mapper les instructions de l'utilisateur à des actions de bas niveau qui aideront le robot à atteindre l'objectif souhaité (comme trouver une éponge). Ceci est accompli grâce à un préfixe d'invite conçu qui amène le modèle à générer des descriptions en langage naturel des actions de bas niveau appropriées et à évaluer leur utilité.

Le composant de modèle de langage du système SayCan peut donner des suggestions d'action quel que soit l'environnement réel dans lequel se trouve le robot, par exemple s'il n'y a pas d'éponge à côté de lui. Ainsi, les chercheurs ont utilisé un module de perception distinct pour exploiter les capteurs du robot afin d'évaluer la scène et de déterminer la faisabilité actuelle de l'exécution de chaque action de bas niveau. En combinant l'évaluation de l'utilité de chaque action par le LLM avec l'évaluation de la faisabilité de chaque action par le module de perception, la prochaine action optimale peut être dérivée.

Bien que SayCan interagisse physiquement avec le monde réel, la façon dont il apprend et utilise le langage est toujours très différente de celle des humains. Les modèles de langage inclus dans des systèmes comme SayCan sont pré-entraînés pour effectuer des prédictions de séquence dans l'environnement sans entité d'ensembles de données en texte brut. Ils n’ont pas appris la langue en parlant à d’autres locuteurs.

SayCan nous apporte une imagination sur le futur système d'utilisation de la langue, mais dans le système actuel, le rôle de la langue est très limité. Les utilisateurs envoient des commandes au système en langage naturel, et le système génère des descriptions interprétables en langage naturel de leurs actions. Cependant, cette gamme restreinte d’usages du langage n’est tout simplement pas comparable à l’ampleur de l’activité humaine collective soutenue par le langage.

Ainsi, même pour les systèmes d'IA incarnés qui incluent le LLM, nous devons choisir soigneusement les mots pour les décrire.

7、LLM peut-il raisonner ?

Maintenant, nous pouvons nier que ChatGPT ait des croyances, mais peut-il vraiment raisonner ?

Ce problème est plus difficile car en logique formelle, l'inférence est neutre en termes de contenu. Par exemple, quelle que soit la prémisse, la règle d'inférence « d'affirmer l'antécédent » (modus ponens) est valable :

Si : tous les gens mourront et Socrate est un être humain alors : Socrate mourra ;

La neutralité du contenu de la logique semble signifier que nous ne pouvons pas être trop exigeants envers le LLM en termes de raisonnement, car le LLM n'est pas assez remarquable pour mesurer la réalité externe du vrai et du faux. Mais même ainsi, lorsque nous demandons à ChatGPT « Tous les gens sont mortels, Socrate est donc un humain », nous ne demandons pas au modèle d'effectuer un raisonnement hypothétique, mais nous demandons : les statistiques de mots dans un corpus public donné. les mots suivront probablement la séquence "Tous les hommes sont mortels, Socrate est donc humain".

De plus, les problèmes de raisonnement plus complexes contiendront plusieurs étapes de raisonnement, et grâce à une ingénierie intelligente des indices, le LLM peut être appliqué efficacement au raisonnement en plusieurs étapes sans formation supplémentaire. Par exemple, dans une invite de chaîne de pensée, soumettre un préfixe d'invite au modèle avant que la requête de l'utilisateur ne contienne des exemples de raisonnement en plusieurs étapes et déclarer explicitement que toutes les étapes intermédiaires incluent un préfixe d'invite dans un style de chaîne de pensée encouragera le modèle à le même style génère des séquences ultérieures, c'est-à-dire constituées d'une série d'étapes de raisonnement explicites menant à une réponse finale.

Comme d'habitude, la vraie question posée au modèle est de la forme " Compte tenu de la répartition statistique des mots dans un corpus public, quels mots sont susceptibles de suivre la séquence S ", dans ce cas la séquence S est le lien préfixe d'invite de pensée plus Dans la requête de l'utilisateur, la séquence de jetons la plus susceptible de suivre S aura une forme similaire à la séquence trouvée dans le préfixe d'invite, c'est-à-dire qu'il y aura plusieurs étapes d'inférence entre elles, c'est donc ce que le modèle génère.

Il convient de noter que non seulement la réponse du modèle prend la forme d'un argument en plusieurs étapes, mais que l'argument en question est souvent (mais pas toujours) valide et que la réponse finale est généralement (mais pas toujours) correcte. . Un LLM correctement invité semble raisonner correctement dans la mesure où il le fait en imitant des paramètres bien formés dans son ensemble d'entraînement et/ou ses invites.

Mais, cette imitation peut-elle constituer un véritable raisonnement ? Même si les modèles actuels commettent occasionnellement des erreurs, ces erreurs peuvent-elles être davantage réduites afin que les performances du modèle soient impossibles à distinguer de celles d'un algorithme d'inférence codé en dur ?

Peut-être que la réponse est effectivement « oui », mais comment le savons-nous ? Comment peut-on faire confiance à un tel modèle ?

Les séquences de phrases générées par Theorem Prover sont logiquement fidèles car elles sont le résultat de processus informatiques sous-jacents dont la structure causale reflète la structure inférentielle du théorème en question. Une façon de créer des systèmes de raisonnement fiables à l’aide des LLM consiste à les intégrer dans des algorithmes qui implémentent la même structure causale. Mais si nous insistons sur l’utilisation d’un LLM pur, alors la seule manière d’être pleinement convaincu des arguments qu’il génère est de procéder à une ingénierie inverse et de découvrir des mécanismes émergents qui respectent les dispositions de l’inférence fidèle. Dans le même temps, nous devrions être plus prudents et faire preuve de prudence dans la description du rôle de ces modèles.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI