Maison >Périphériques technologiques >IA >L'IA génère automatiquement des invites comparables à celles des internautes : les ingénieurs viennent d'être embauchés et seront à nouveau éliminés.

L'IA génère automatiquement des invites comparables à celles des internautes : les ingénieurs viennent d'être embauchés et seront à nouveau éliminés.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-12 22:40:011567parcourir

À ce stade, grâce à l'expansion de l'échelle des modèles et à l'émergence d'une architecture basée sur l'attention, les modèles de langage ont fait preuve d'une polyvalence sans précédent. Ces grands modèles de langage (LLM) ont démontré des capacités extraordinaires dans une variété de tâches différentes, y compris les réglages zéro et quelques coups.

Cependant, sur la base de l'universalité du modèle, une question de contrôle se pose : comment pouvons-nous faire en sorte que LLM fasse ce dont nous avons besoin ?

Afin de répondre à cette question et de guider le LLM vers le comportement souhaité, les chercheurs ont pris une série de mesures pour atteindre cet objectif, comme l'affinement du modèle, l'apprentissage par le contexte, différentes formes de génération d'invites. , etc. . Les méthodes basées sur des invites incluent des invites logicielles affinées et une ingénierie d'invites en langage naturel. De nombreux chercheurs ont montré un grand intérêt pour ce dernier car il fournit une interface interactive naturelle permettant aux humains d'interagir avec les machines.

Cependant, des invites simples ne produisent pas toujours les résultats souhaités. Par exemple, lors de la génération d'images de panda, l'ajout d'adjectifs tels que « mignon » ou d'expressions telles que « manger du bambou » n'a aucun effet sur le résultat. nous ne comprenons pas.

Par conséquent, les utilisateurs humains doivent essayer diverses invites pour guider le modèle afin de compléter le comportement souhaité. L'exécution des LLM peut être considérée comme un processus de boîte noire : bien qu'ils puissent exécuter un large éventail de programmes en langage naturel, ces programmes peuvent être traités d'une manière qui n'est pas intuitive pour les humains, très difficiles à comprendre et ne peuvent être utilisés que lors de l’exécution de tâches en aval. Mesurer la qualité de l’enseignement.

Nous ne pouvons nous empêcher de demander : Les grands modèles de langage peuvent-ils écrire eux-mêmes des invites ? La réponse est non seulement oui, mais cela peut aussi atteindre le niveau humain.

Afin de réduire la charge de travail manuelle liée à la création et à la vérification d'instructions efficaces, des chercheurs de l'Université de Toronto, de l'Université de Waterloo et d'autres institutions ont proposé un nouvel algorithme qui utilise LLM pour générer et sélectionner automatiquement des instructions : APE (Automatic Prompt Ingénieur). Ils décrivent ce problème comme une synthèse de programme en langage naturel et proposent de le traiter comme un problème d'optimisation de boîte noire où LLM peut être utilisé pour générer ainsi que rechercher des solutions candidates réalisables.

- Adresse papier : https://arxiv.org/pdf/2211.01910.pdf

- Page d'accueil papier : https://sites.google.com/view/automatic-prompt- ingénieur

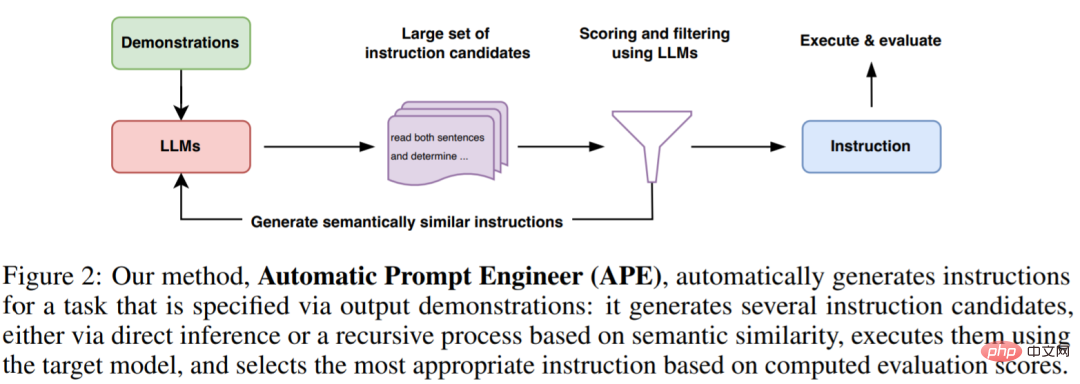

Les chercheurs sont partis des trois caractéristiques du LLM. Premièrement, un LLM est utilisé comme modèle d'inférence pour générer des instructions candidates basées sur un petit ensemble de démonstrations de la forme des paires entrée-sortie. Ensuite, un score est calculé pour chaque instruction du LLM pour guider le processus de recherche. Enfin, ils proposent une méthode de recherche itérative de Monte Carlo où LLM améliore les meilleures instructions candidates en proposant des variantes d'instructions sémantiquement similaires.

Intuitivement, l'algorithme proposé dans cet article nécessite que LLM génère un ensemble d'instructions candidates basées sur la démonstration, puis demande à l'algorithme d'évaluer quelles instructions sont les plus prometteuses, et l'algorithme est nommé APE.

Les contributions de cet article sont les suivantes :

- Le chercheur synthétise la génération d'instructions comme un programme en langage naturel, la formule comme un problème d'optimisation de boîte noire guidé par LLM, et propose une recherche itérative de Monte Carlo méthode pour approximer la solution ;

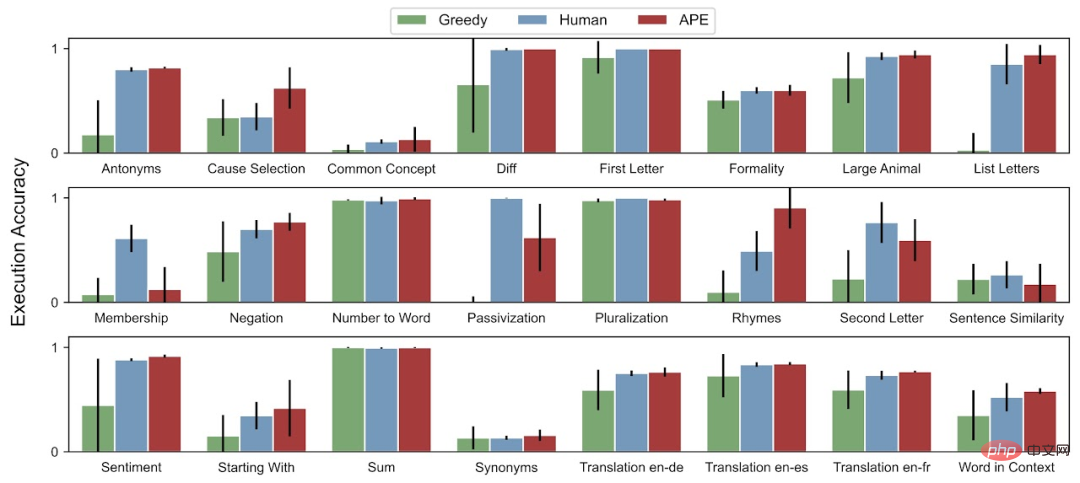

- La méthode APE permet d'obtenir des performances meilleures ou équivalentes que les instructions générées par des annotateurs humains sur la tâche 19/24.

Après avoir vu cette étude, les internautes n'ont pu s'empêcher de soupirer : ces ingénieurs rapides qui viennent d'être embauchés pourraient être éliminés par l'IA dans quelques mois. L’implication est que cette recherche supprimera le travail des ingénieurs humains.

"Cette étude fait de son mieux pour automatiser l'ingénierie rapide afin que les chercheurs engagés dans le ML puissent revenir aux vrais problèmes d'algorithme (deux émojis qui pleurent ci-joints)."

D'autres ont déploré : le LLM est en effet le pilier de l'AGI original.

Utilisation du LLM pour la synthèse de programmes en langage naturel

APE utilise le LLM dans les deux composants clés de la proposition et de la notation.

Comme le montrent la figure 2 et l'algorithme 1 ci-dessous, APE propose d'abord plusieurs invites de candidats, puis filtre/affine l'ensemble de candidats en fonction de la fonction de notation sélectionnée, et sélectionne enfin l'instruction avec le score le plus élevé.

L'image ci-dessous montre le processus d'exécution de l'APE. Il peut générer plusieurs invites candidates par inférence directe ou un processus récursif basé sur la similarité sémantique, évaluer leurs performances et proposer de nouvelles invites de manière itérative.

Distribution des propositions initiales

Étant donné que l'espace de recherche est infiniment grand, il est extrêmement difficile de trouver les instructions correctes, ce qui rend la synthèse de programmes en langage naturel historiquement difficile à gérer. Sur cette base, les chercheurs ont envisagé d'utiliser un LLM pré-formé pour proposer une solution candidate pour guider le processus de recherche.

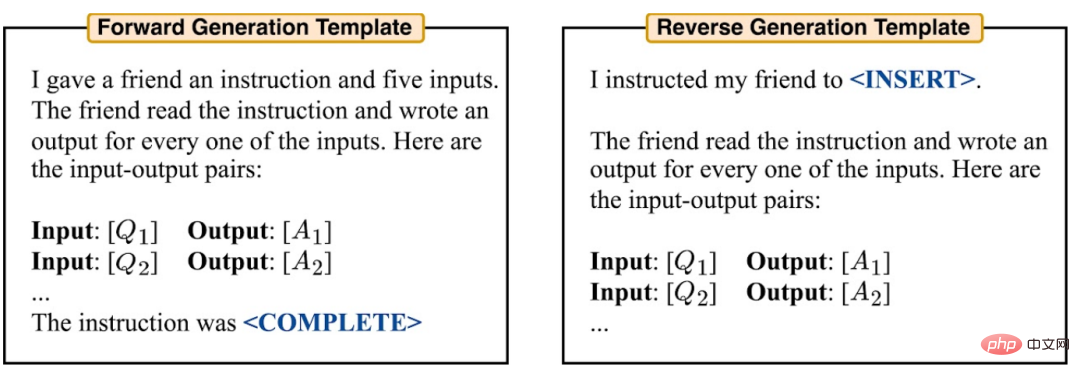

Ils envisagent deux méthodes pour générer des candidats de haute qualité. Tout d’abord, une méthode basée sur la génération de modèles directs est adoptée. En outre, ils ont également envisagé la génération de modèles inverses, en utilisant des LLM dotés de capacités de remplissage (par exemple, T5, GLM, InsertGPT) pour déduire les instructions manquantes.

Fonction de score

Pour convertir le problème en un problème d'optimisation de boîte noire, les chercheurs ont choisi une fonction de score pour mesurer avec précision l'alignement entre l'ensemble de données et les données générées par le modèle.

Dans l'expérience inductive, les chercheurs ont considéré deux fonctions de notation potentielles. Dans l’expérience TruthfulQA, les chercheurs se sont principalement concentrés sur les mesures d’automatisation proposées par Lin et al., similaires à la précision d’exécution.

Dans chaque cas, le chercheur utilise la formule suivante (1) pour évaluer la qualité des instructions générées et des attentes sur l'ensemble de données de test de maintien Dtest.

Expérience

Les chercheurs ont étudié comment l'APE guide LLM pour atteindre le comportement attendu. Ils procèdent selon trois perspectives : performance zéro-shot, performance d'apprentissage contextuel en quelques-shots et authenticité(vérité).

Les chercheurs ont évalué l'apprentissage contextuel à zéro et à quelques tirs sur 24 tâches d'induction d'instruction proposées par Honovich et al. Ces tâches couvrent de nombreux aspects de la compréhension du langage, depuis les structures de phrases simples jusqu'à la reconnaissance des similarités et des causalités. Pour comprendre comment les instructions générées par APE guident LLM pour générer différents styles de réponses, cet article applique APE à TruthfulQA, un ensemble de données.

Pour la précision des tests zéro tir, APE a atteint des performances de niveau humain sur 19 tâches sur 24.

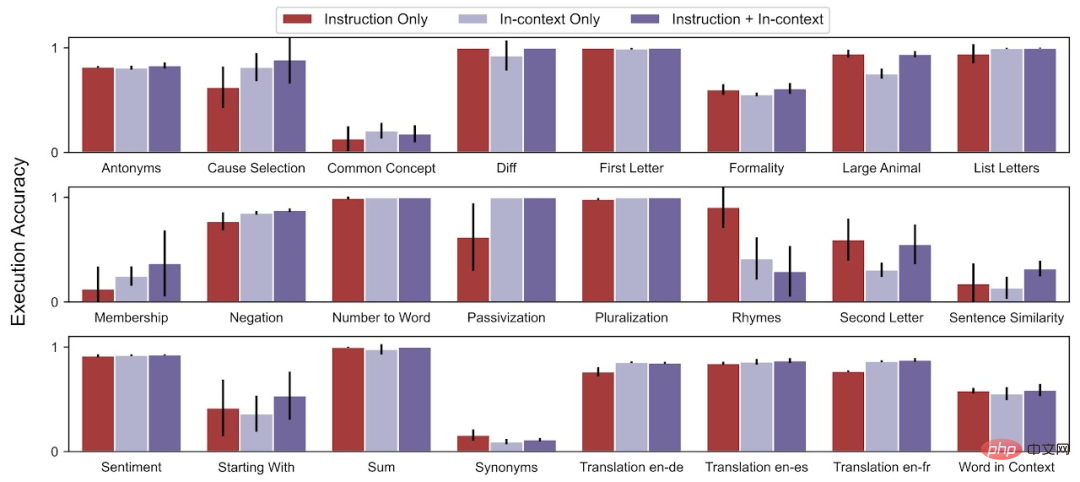

Pour la précision du test contextuel en quelques tirs, APE améliore les performances d'apprentissage contextuel en quelques tirs sur 21 des 24 tâches.

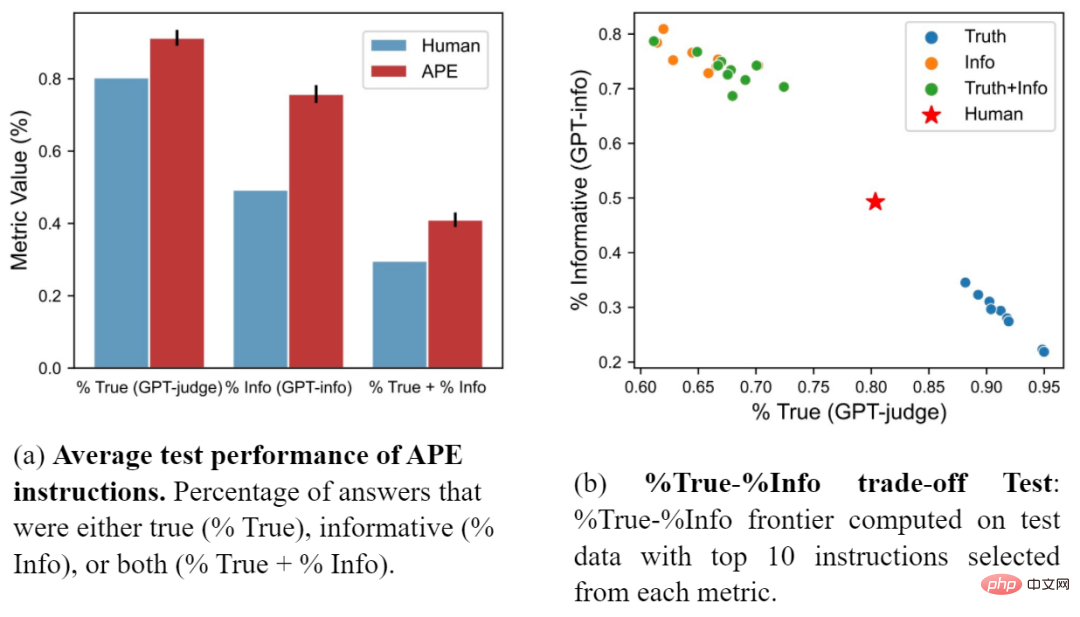

Les chercheurs ont également comparé l'invite APE avec l'invite artificielle proposée par Lin et al. La figure (a) montre que les instructions APE surpassent les invites humaines sur les trois métriques. La figure (b) montre le compromis entre véracité et contenu informatif.

Veuillez vous référer au document original pour plus de détails.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI