Maison >Périphériques technologiques >IA >L'infraction à la peinture AI est confirmée ! Les modèles de diffusion peuvent mémoriser vos photos et toutes les méthodes de protection de la vie privée existantes seront inefficaces

L'infraction à la peinture AI est confirmée ! Les modèles de diffusion peuvent mémoriser vos photos et toutes les méthodes de protection de la vie privée existantes seront inefficaces

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-12 22:16:011998parcourir

Cet article est réimprimé avec l'autorisation d'AI New Media Qubit (ID de compte public : QbitAI). Veuillez contacter la source pour la réimpression.

L'infraction à la peinture AI est confirmée !

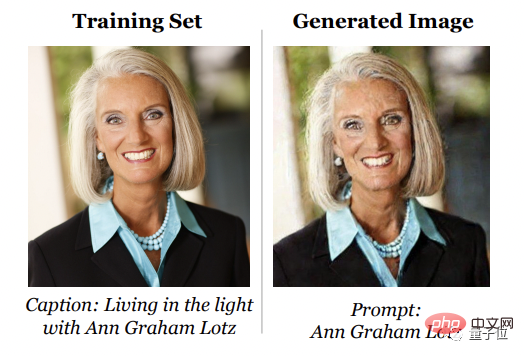

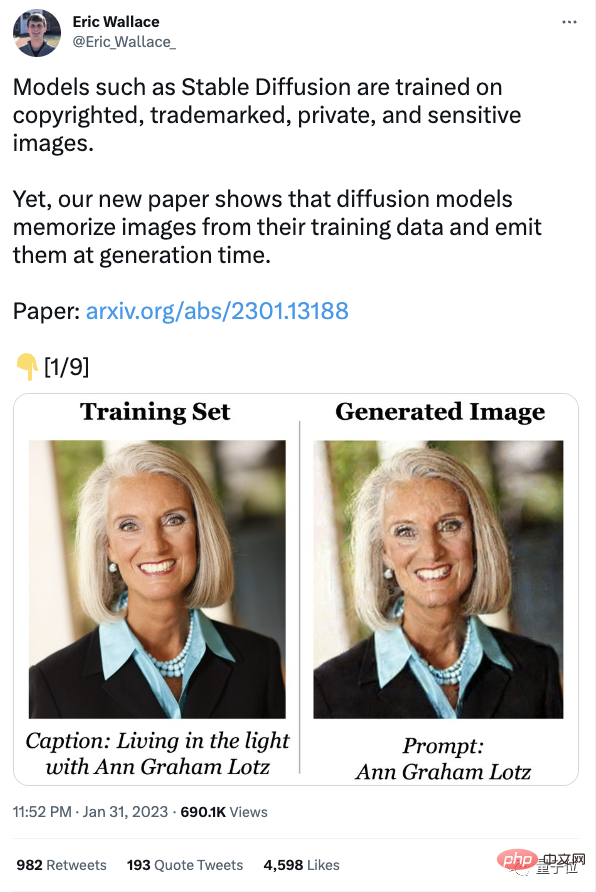

Les dernières recherches montrent que le modèle de diffusion gardera à l'espritles échantillons de l'ensemble d'entraînement et les "imitera" lors de leur génération.

En d'autres termes, dans les peintures IA générées par Stable Diffusion, derrière chaque coup il peut y avoir un incident d'infraction.

De plus, après recherche et comparaison, la capacité du modèle de diffusion à « plagier » à partir d'échantillons d'entraînement est deux fois supérieure à celle du GAN, et plus le modèle de diffusion est généré de manière efficace, plus sa capacité à mémoriser les échantillons d'entraînement est forte. Cette recherche provient d'une équipe composée de Google, DeepMind et UC Berkeley.

toutes les méthodes existantes de protection de la vie privée sont invalides.

Dès que la nouvelle est tombée, les internautes ont explosé et l'auteur des tweets liés au journal était sur le point d'être retweeté par plus d'un millier.

Modèle de diffusion Le principe est de supprimer le bruit puis de le restituer, donc ce que les chercheurs souhaitent étudier c'est en réalité : Est-ce qu'ils

se souviennent des images utilisées pour l'entraînement, et finalement « plagient » lors de la génération ?

Les images de l'ensemble de formation sont souvent obtenues sur Internet. Elles sont protégées par le droit d'auteur, sont déposées et certaines sont privées, comme les radiographies médicales privées. Afin de déterminer si le modèle de diffusion peutmémoriser et régénérerdes échantillons d'entraînement individuels, les chercheurs ont d'abord proposé une nouvelle définition de la « mémoire ».

D'une manière générale, la définition de la mémoire se concentre sur les modèles de langage textuel. Si le modèle peut être invité à récupérer une séquence mot par mot de l'ensemble d'entraînement, cela signifie que la séquence a été extraite et mémorisée. En revanche, l'équipe de recherchea défini la « mémoire » en fonction de la similarité des images.

Cependant, l'équipe admet aussi franchement que la définition de « mémoire » est conservatrice. Par exemple, l'image de gauche est une "photo d'Obama" générée à l'aide de Stable Diffusion. Cette photo n'est similaire à aucune image d'entraînement spécifique de droite, cette image ne peut donc pas être considérée comme générée de mémoire.

extraction de données en deux étapes (attaque d'extraction de données) .

L'opération spécifique consiste à utiliser des méthodes standard pour générer des images, puis à étiqueter les images qui dépassent les critères de notation du raisonnement humain. En appliquant cette approche à la diffusion stable et à l'image, l'équipe a extrait plus de 100 copies approximatives ou identiques d'images d'entraînement. Il existe à la fois des photos personnelles identifiables et des logos de marques. Après inspection, la plupart d'entre elles sont protégées par le droit d'auteur.

Ensuite, afin de mieux comprendre comment se produit la « mémoire », les chercheurs ont échantillonné 1 million de fois à partir du modèle et formé des centaines de modèles de diffusion sur CIFAR-10.

L'objectif est d'analyser quels comportements en matière de précision du modèle, d'hyperparamètres, d'amélioration et de déduplication ont un impact sur la confidentialité.

Je suis finalement arrivé à la conclusion suivante :

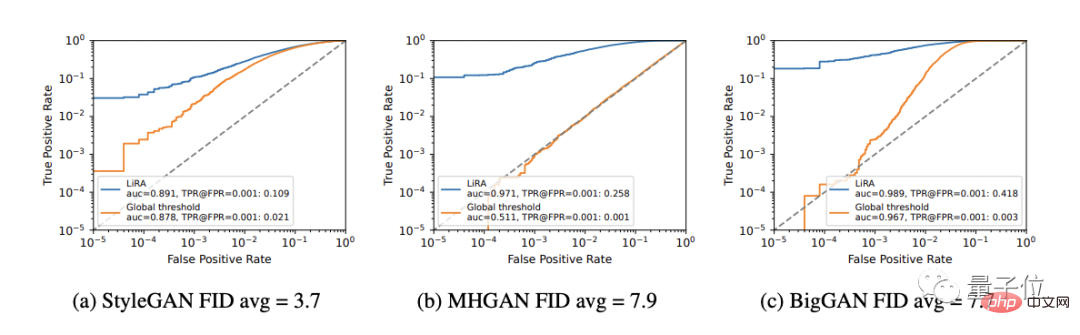

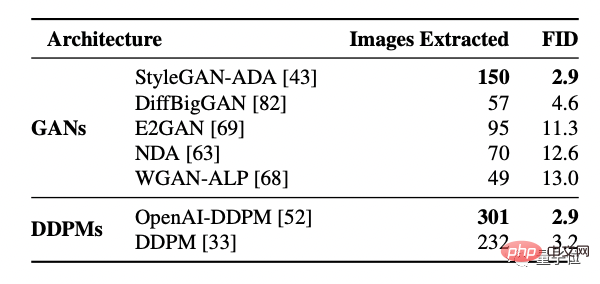

Tout d'abord, le modèle de diffusion a plus de mémoire que le GAN.

Mais les modèles de diffusion constituent également le groupe de pire confidentialité parmi les modèles d'images évalués, et ils divulguent plus de deux fois plus de données de formation que les GAN.

De plus, les modèles plus grands peuvent mémoriser plus de données.

Avec cette conclusion, les chercheurs ont également étudié le modèle de diffusion texte-image à 2 milliards de paramètres Imagen. Ils ont essayé d'extraire 500 images avec les scores les plus élevés en dehors de la distribution et les ont utilisées comme échantillons dans l'ensemble de données de formation. tout mémorisé.

En revanche, la même méthode a été appliquée à Stable Difusion et aucun comportement de mémoire n’a été identifié.

Par conséquent, Imagen a une confidentialité pire que Stable Difusion sur les images copiées et non copiées. Les chercheurs attribuent la raison au fait que le modèle utilisé par Imagen a une plus grande capacité que Stable Difusion, il mémorise donc plus d'images.

De plus, meilleurs modèles génératifs (valeurs FID inférieures) stockent plus de données.

En d’autres termes, au fil du temps, le même modèle divulgue davantage de confidentialité et enfreint davantage de droits d’auteur.

(Modèle GAN trié par FID, plus la valeur FID est faible, meilleur est l'effet)

En entraînant le modèle, l'équipe a découvert que une utilité croissante réduirait la confidentialité, de simples mesures défensives (telles que déduplication) )Pas suffisant pour résoudre complètement le problème de mémoire.

Par conséquent, les technologies améliorant la confidentialité ne fournissent pas un compromis acceptable entre confidentialité et utilité.

En fin de compte, l'équipe a formulé quatre recommandations à ces modèles de diffusion de formation :

- Il est recommandé de dédupliquer l'ensemble de données de formation et de minimiser le surentraînement ;

- Il est recommandé d'utiliser l'extraction de données ou d'autres techniques d'audit pour évaluer la confidentialité du modèle formé ; risques ;

- S'il existe une technologie de protection de la vie privée plus pratique, il est recommandé de l'utiliser autant que possible ;

- J'espère que les images générées par l'IA ne fourniront pas gratuitement aux utilisateurs des éléments liés à la vie privée.

Les titulaires des droits d'auteur n'ont jamais cessé de défendre leurs droits

Une fois la recherche publiée, elle pourrait avoir un impact sur les litiges en cours.

Fin janvier, le grand frère de la galerie, Getty Images(Getty Images), a assigné Stability AI devant la Haute Cour de Londres pour violation du droit d'auteur.

△Stability AI

Getty Images estime que Stability AI "a copié et traité illégalement des millions d'images protégées par le droit d'auteur" pour entraîner sa diffusion stable.

Une partie des données d'entraînement de Stable Difussion est open source. Après analyse et inspection des filigranes, il a été constaté que de nombreuses agences photo, dont Getty, avaient sans le savoir fourni une grande quantité de matériel pour l'ensemble de formation de Stable Difussion, représentant une grande proportion.

Mais du début à la fin, Stability AI n'a pas contacté l'agence photo.

De nombreuses sociétés d'IA pensent que cette pratique est protégée par des lois telles que la doctrine américaine sur l'utilisation équitable, mais la plupart des titulaires de droits d'auteur ne sont pas d'accord avec cette affirmation et estiment que ce comportement porte atteinte à leurs droits.

Bien que Stability AI ait précédemment publié une déclaration disant que dans la prochaine version, les titulaires de droits d'auteur pourront supprimer leurs propres œuvres protégées par le droit d'auteur dans la galerie de formation, mais à ce stade, il y a encore des gens qui ne sont pas convaincus.

Mi-janvier, trois artistes avaient porté plainte contre Stability AI et Midjourney.

Les experts juridiques ont également des opinions différentes afin de parvenir à une opinion unifiée, mais ils sont tous d'accord sur le fait que le tribunal doit se prononcer sur la question de la protection du droit d'auteur.

Le PDG de Getty Images, Craig Peters, a déclaré que la société avait envoyé un avis à Stability AI, disant "vous êtes sur le point d'être poursuivi en justice au Royaume-Uni" !

La société a également déclaré :

Nous ne nous soucions pas des pertes causées par la contrefaçon et nous n'avons pas l'intention d'arrêter le développement d'outils artistiques d'IA.

Poursuivre Stability AI en justice n'est pas dans l'intérêt de notre famille Getty.

Choisir de poursuivre en justice a un objectif plus profond à long terme, et j'espère que le tribunal établira de nouvelles lois pour réglementer le statu quo.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI