Maison >Périphériques technologiques >IA >Diffusion + détection de cible = génération d'images contrôlable ! L'équipe chinoise a proposé GLIGEN pour contrôler parfaitement la position spatiale des objets

Diffusion + détection de cible = génération d'images contrôlable ! L'équipe chinoise a proposé GLIGEN pour contrôler parfaitement la position spatiale des objets

- 王林avant

- 2023-04-12 21:25:05950parcourir

Avec l'open source de Stable Diffusion, l'utilisation du langage naturel pour la génération d'images est progressivement devenue populaire, et de nombreux problèmes de l'AIGC ont également été exposés, tels que l'IA ne peut pas dessiner les mains, ne peut pas comprendre les relations d'action et est difficile à contrôler. position des objets, etc.

La raison principale est que "l'interface de saisie" n'a qu'un langage naturel, et ne peut pas obtenir un contrôle précis de l'écran.

Récemment, des centres de recherche de l'Université du Wisconsin-Madison, de l'Université de Columbia et de Microsoft ont proposé une toute nouvelle méthode GLIGEN, qui étend les fonctionnalités du « modèle de diffusion de texte en image pré-entraîné » existant basé sur une entrée de mise à la terre.

Lien papier : https://arxiv.org/pdf/2301.07093.pdf

Page d'accueil du projet : https://gligen.github.io/

Lien d'expérience : https://huggingface.co/spaces/gligen/demo

Afin de conserver une grande quantité de connaissances conceptuelles du modèle pré-entraîné, les chercheurs n'ont pas choisi d'affiner le modèle , mais a fait passer l'entrée via le mécanisme de déclenchement. Différentes conditions de mise à la terre sont injectées dans de nouvelles couches pouvant être entraînées pour contrôler la génération d'images en monde ouvert.

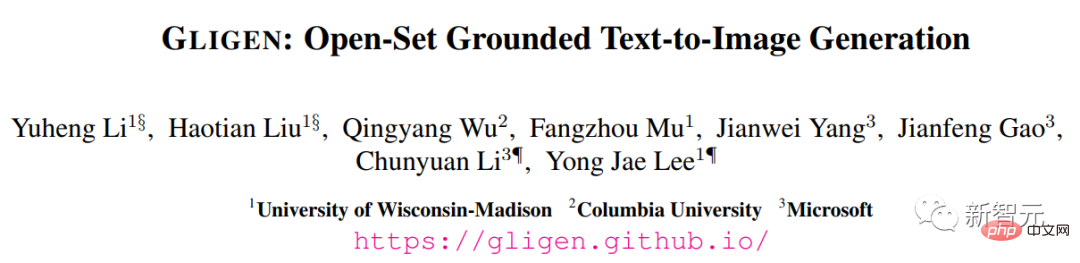

Actuellement, GLIGEN prend en charge quatre entrées.

(en haut à gauche) entité de texte + boîte (en haut à droite) entité d'image + boîte

(en bas à gauche) style d'image + texte + boîte (en bas à droite) entité de texte + clé point

Les résultats expérimentaux montrent également que les performances zéro tir de GLIGEN sur COCO et LVIS sont bien meilleures que la base de référence actuelle de mise en page supervisée en image.

Génération d'images contrôlables

Avant le modèle de diffusion, les réseaux contradictoires génératifs (GAN) ont toujours été le leader dans le domaine de la génération d'images, et leur espace latent et leur entrée conditionnelle ont été entièrement implémentés en termes de « fonctionnement contrôlable » et recherche « génération ».

Les modèles autorégressifs et de diffusion conditionnels de texte affichent une qualité d'image et une couverture conceptuelle étonnantes, grâce à leurs objectifs d'apprentissage plus stables et à leur formation à grande échelle sur les données appariées image-texte du réseau, et sortent rapidement du cercle et deviennent des outils d'aide. en conception et création artistique.

Cependant, les modèles de génération texte-image à grande échelle existants ne peuvent pas être conditionnés à d'autres modes de saisie « que le texte ». Ils n'ont pas la capacité de localiser avec précision des concepts ou d'utiliser des images de référence pour contrôler le processus de génération, ce qui limite l'expression de ceux-ci. information.

Par exemple, il est difficile de décrire l'emplacement précis d'un objet à l'aide de texte, mais des cadres de délimitation (bounding

boxes) ou des points clés (keypoints) peuvent être facilement réalisés.

Certains outils existants tels que l'inpainting, la génération layout2img, etc. peuvent utiliser des entrées modales autres que le texte, mais ces entrées sont rarement combinées pour une génération text2img contrôlable.

De plus, les modèles génératifs précédents sont généralement formés indépendamment sur des ensembles de données spécifiques à une tâche, tandis que dans le domaine de la reconnaissance d'images, le paradigme de longue date consiste à apprendre à partir de « données d'image à grande échelle » ou de « paires image-texte ». " Un modèle de base pré-entraîné commence à construire un modèle pour une tâche spécifique.

Les modèles de diffusion ont été formés sur des milliards de paires image-texte. Une question naturelle est : pouvons-nous nous appuyer sur les modèles de diffusion pré-entraînés existants et leur donner de nouvelles entrées conditionnelles ?

En raison de la grande quantité de connaissances conceptuelles possédées par le modèle pré-entraîné, il peut être possible d'obtenir de meilleures performances sur d'autres tâches de génération tout en gagnant plus de contrôlabilité que les modèles de génération texte-image existants.

GLIGEN

Sur la base des objectifs et des idées ci-dessus, le modèle GLIGEN proposé par les chercheurs conserve toujours le titre du texte en entrée, mais permet également d'autres modalités de saisie, telles que la boîte englobante du concept de mise à la terre, la référence de mise à la terre image et la clé du point de la pièce de mise à la terre.

Le problème clé ici est de conserver une grande quantité de connaissances conceptuelles originales dans le modèle pré-entraîné tout en apprenant à injecter de nouvelles informations de base.

Afin d'éviter l'oubli des connaissances, les chercheurs ont proposé de geler les poids du modèle d'origine et d'ajouter une nouvelle couche de transformateur fermée pouvant être entraînée pour absorber les nouvelles entrées de regroupement. Ce qui suit utilise des cadres de délimitation à titre d'exemple.

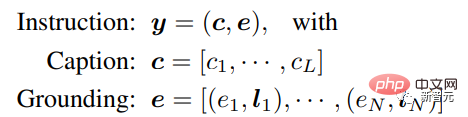

Saisie de commande

Chaque entité de texte de jointoiement est représentée comme une boîte englobante contenant les valeurs de coordonnées du coin supérieur gauche et du coin inférieur droit.

Il convient de noter que les travaux existants liés à layout2img nécessitent généralement un dictionnaire de concepts et ne peuvent gérer que des entités proches (telles que les catégories COCO) pendant la phase d'évaluation. Les informations de positionnement contenues dans l'ensemble de formation peuvent être généralisées à d'autres concepts.

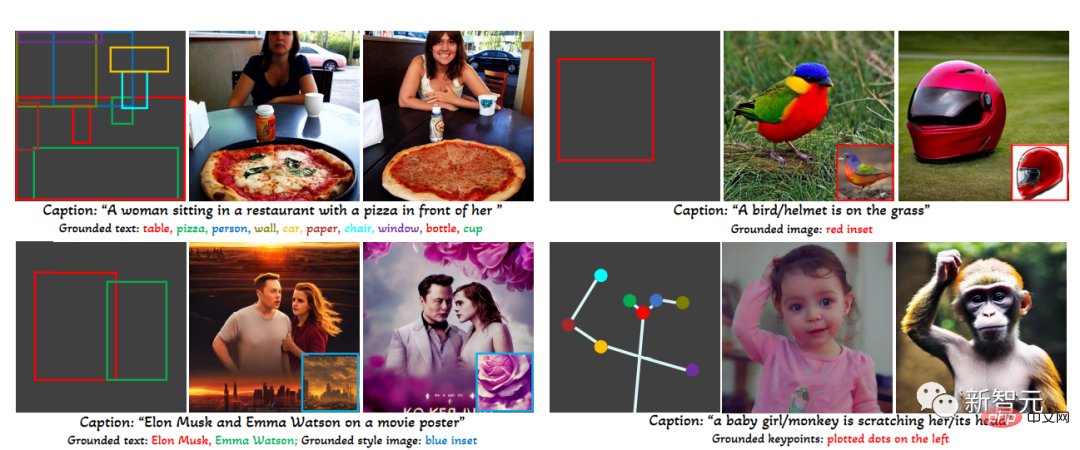

Données d'entraînement

Les données d'entraînement utilisées pour générer des images de base nécessitent le texte c et l'entité de base e comme conditions. En pratique, les contraintes sur les données peuvent être assouplies en envisageant des conditions plus flexibles. entrées Nécessite.

Il existe principalement trois types de données

1. Données de base

Chaque image est associée à un titre qui décrit l'entité nominale; titre et marquez le cadre de délimitation.

Étant donné que les entités nominales sont tirées directement des titres en langage naturel, elles peuvent couvrir un vocabulaire plus riche, ce qui est bénéfique à la génération fondamentale du vocabulaire du monde ouvert.

2. Données de détection Données de détection

L'entité nominale est une catégorie prédéfinie (telle que les 80 catégories d'objets dans COCO), choisissez d'utiliser le jeton de titre vide dans le classificateur. guide gratuit comme titre.

La quantité de données de détection (niveau en millions) est supérieure aux données de base (en milliers de niveaux), de sorte que les données globales d'entraînement peuvent être considérablement augmentées.

3. Données de détection et de légende

L'entité nominale est la même que l'entité nominale dans les données de détection, alors que l'image est décrite avec un titre de texte seul, il peut y avoir des entités nominales et des entités dans le titre Pas tout à fait cohérent.

Par exemple, le titre ne donne qu'une description générale du salon et ne mentionne pas les objets de la scène, tandis que l'annotation de détection fournit des détails plus fins au niveau de l'objet.

Mécanisme d'attention fermée

Les chercheurs visent à donner aux modèles existants de génération d'images et de langage à grande échelle de nouvelles capacités spatiales,

les modèles de diffusion à grande échelle ont des pré- formés sur du texte image à l'échelle du réseau pour obtenir les connaissances nécessaires pour synthétiser des images réalistes basées sur des instructions linguistiques diverses et complexes. Étant donné que la pré-formation est coûteuse, les performances sont également bonnes, tout en développant de nouvelles capacités. le modèle est pondéré afin que les nouveaux modules puissent être adaptés au fil du temps pour s'adapter à de nouvelles capacités.

Pendant le processus de formation, de nouvelles informations de base sont progressivement intégrées dans le modèle pré-entraîné à l'aide d'un mécanisme de déclenchement. Cette conception permet une flexibilité dans le processus d'échantillonnage pendant le processus de génération pour améliorer la qualité et la contrôlabilité.

L'expérience a également prouvé qu'en utilisant le modèle complet (toutes les couches) dans la première moitié de l'étape d'échantillonnage et en utilisant uniquement la couche d'origine (pas de couche de transformateur fermée) dans la seconde moitié, les résultats générés peuvent refléter plus précisément le Conditions de mise à la terre, tout en ayant une qualité d'image supérieure.

Partie expérimentale

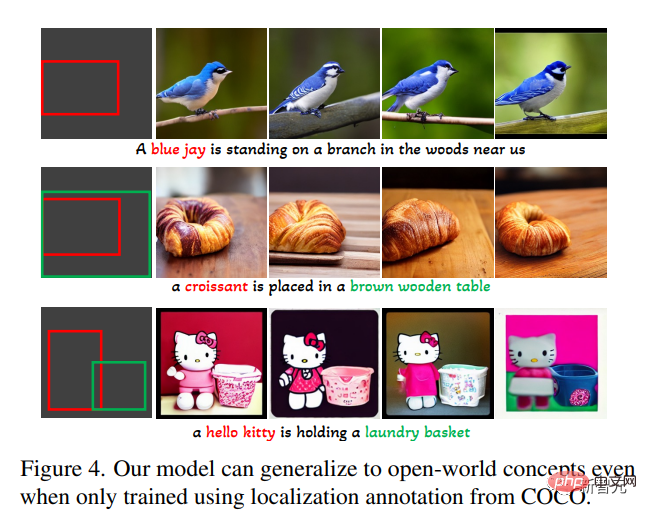

Dans la tâche de génération de texte en image ouverte, utilisez d'abord uniquement les annotations de base de COCO (COCO2014CD) pour la formation et évaluez si GLIGEN peut générer des entités de base autres que la catégorie COCO.

On peut voir que GLIGEN peut apprendre de nouveaux concepts tels que "corbeau bleu", "croissant", ou de nouveaux attributs d'objet tels que "table en bois marron", et cette information n'apparaît pas dans le catégorie de formation intermédiaire.

Les chercheurs pensent que cela est dû au fait que l'auto-attention fermée de GLIGEN a appris à repositionner les caractéristiques visuelles correspondant aux entités ancrées dans le titre pour la couche d'attention croisée suivante, et à cause du texte partagé dans l'espace des deux couches pour acquérir une capacité de généralisation. .

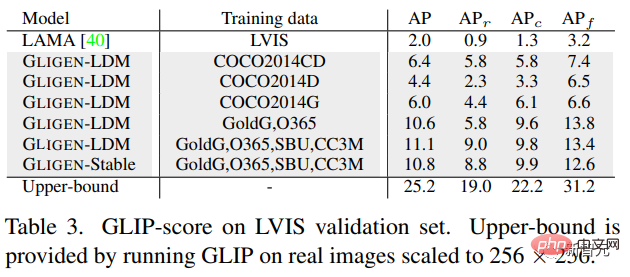

L'expérience a également évalué quantitativement les performances de génération zéro-shot de ce modèle sur LVIS, qui contient 1203 catégories d'objets à longue traîne. Utilisez GLIP pour prédire les cadres de délimitation à partir des images générées et calculer AP, nommé score GLIP ; en le comparant aux modèles de pointe conçus pour la tâche layout2img,

peut être trouvé, bien que le Le modèle GLIGEN est uniquement formé sur les annotations COCO, mais il fonctionne bien mieux que les lignes de base supervisées, probablement parce que les lignes de base formées à partir de zéro ont des difficultés à apprendre à partir d'annotations limitées, tandis que le modèle GLIGEN peut exploiter la vaste connaissance conceptuelle du modèle pré-entraîné.

En général, cet article :

1 propose une nouvelle méthode de génération text2img, qui donne au modèle de diffusion text2img existant une nouvelle contrôlabilité de base

2. ing pré -poids entraînés et apprentissage pour intégrer progressivement de nouvelles couches de positionnement, ce modèle réalise une génération de text2img et une entrée de boîte englobante en monde ouvert, c'est-à-dire qu'il intègre de nouveaux concepts de positionnement non observés lors de la formation

3. les performances sur la tâche layout2img sont nettement meilleures que l'état de l'art précédent, prouvant que de grands modèles génératifs pré-entraînés peuvent améliorer les performances des tâches en aval

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI