Maison >Périphériques technologiques >IA >Comment rendre l'IA dotée de capacités universelles ? Nouvelle étude : Endormez-le

Comment rendre l'IA dotée de capacités universelles ? Nouvelle étude : Endormez-le

- 王林avant

- 2023-04-12 21:19:041448parcourir

Les réseaux de neurones peuvent surpasser les humains dans de nombreuses tâches, mais si vous demandez à un système d'IA d'absorber de nouveaux souvenirs, il risque d'oublier instantanément ce qu'il a appris auparavant. Aujourd’hui, une nouvelle étude révèle une nouvelle façon pour les réseaux neuronaux de traverser les étapes du sommeil et d’aider à prévenir cette amnésie.

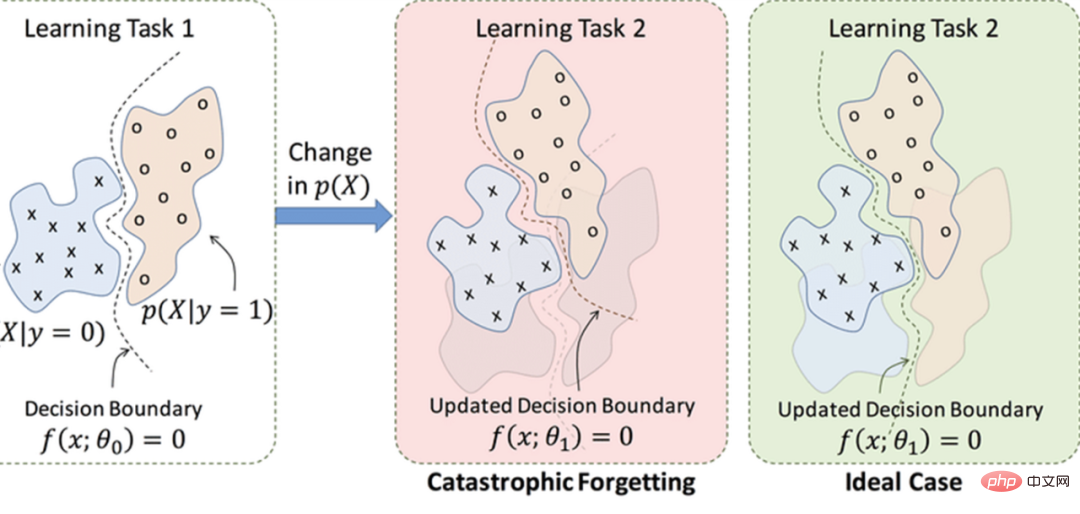

Un défi majeur auquel sont confrontés les réseaux de neurones artificiels est « l’oubli catastrophique ». Lorsqu’ils vont apprendre une nouvelle tâche, ils ont une fâcheuse tendance à oublier soudainement complètement ce qu’ils ont appris auparavant.

Essentiellement, la représentation des données par les réseaux de neurones est une « compression » de données orientée tâches des données originales, et les connaissances nouvellement acquises écraseront les données passées.

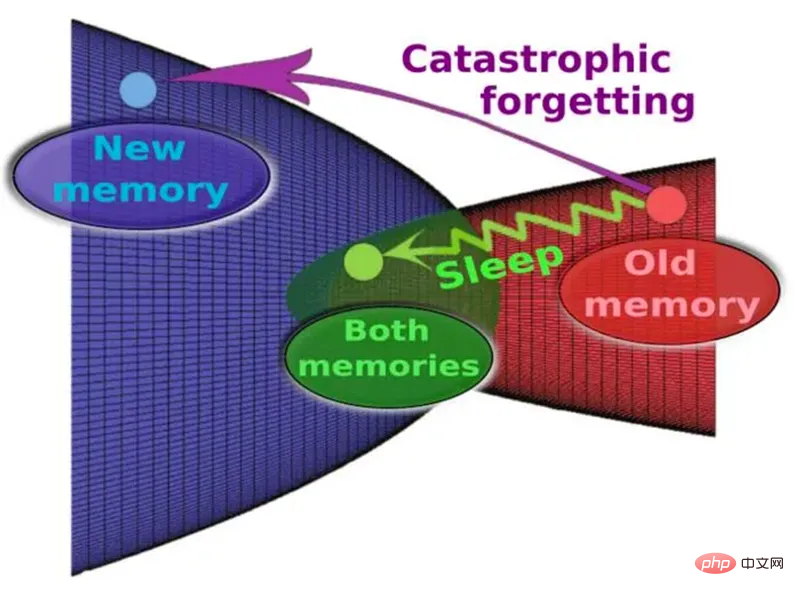

C'est l'un des plus gros défauts de la technologie actuelle par rapport aux réseaux de neurones humains : en revanche, le cerveau humain est capable d'apprendre de nouvelles tâches tout au long de sa vie sans affecter sa capacité à effectuer des tâches précédemment mémorisées. Nous ne savons pas exactement pourquoi, mais la recherche montre depuis longtemps que le cerveau humain apprend mieux lorsque les cycles d'apprentissage sont entrecoupés de sommeil. Le sommeil aide apparemment à intégrer les expériences récentes dans les banques de mémoire à long terme.

"La réorganisation des souvenirs pourrait en fait être l'une des principales raisons pour lesquelles les organismes doivent passer par des phases de sommeil", explique Erik Delanois, neuroscientifique informatique à l'Université de Californie à San Diego.

L'IA peut-elle aussi apprendre à dormir ? Certaines recherches antérieures ont tenté de lutter contre l’amnésie catastrophique en demandant à l’IA de simuler le sommeil. Par exemple, lorsqu'un réseau neuronal apprend une nouvelle tâche, une stratégie appelée formation entrelacée alimente simultanément les machines avec les anciennes données qu'elles ont apprises précédemment pour les aider à conserver leurs connaissances passées. On pensait auparavant que cette approche imitait la façon dont le cerveau fonctionne pendant le sommeil, en rejouant constamment d'anciens souvenirs.

Cependant, les scientifiques avaient émis l'hypothèse qu'un entraînement entrelacé nécessiterait d'alimenter un réseau neuronal avec toutes les données qu'il a initialement utilisées pour apprendre une ancienne compétence à chaque fois qu'il souhaite apprendre quelque chose de nouveau. Non seulement cela nécessite beaucoup de temps et de données, mais cela ne semble pas non plus être ce que font les cerveaux biologiques pendant le sommeil véritable : les organismes n'ont ni la capacité de conserver toutes les données nécessaires à l'apprentissage d'anciennes tâches, ni la capacité de conserver toutes les données nécessaires à l'apprentissage des anciennes tâches. il est temps de tout rejouer en dormant.

Dans une nouvelle étude, des chercheurs analysent les mécanismes à l'origine des oublis catastrophiques et l'efficacité du sommeil pour prévenir le problème. Les chercheurs n’ont pas utilisé de réseaux neuronaux traditionnels, mais ont utilisé un « réseau neuronal de pointe » plus proche du cerveau humain.

Dans un réseau neuronal artificiel, des composants appelés neurones reçoivent des données et travaillent ensemble pour résoudre un problème, comme la reconnaissance des visages. Le réseau neuronal modifie à plusieurs reprises ses synapses – les connexions entre ses neurones – et voit si les modèles de comportement qui en résultent conduisent mieux à des solutions. Au fil du temps (formation continue), le réseau découvre quels modèles sont les meilleurs pour calculer le résultat correct. Finalement, il adopte ces modes comme mode par défaut, censé imiter partiellement le processus d'apprentissage du cerveau humain.

Ce diagramme représente la mémoire dans l'espace synaptique abstrait et son évolution pendant et sans le sommeil.

Dans un réseau neuronal artificiel, la sortie d'un neurone change continuellement à mesure que l'entrée change. En revanche, dans un réseau neuronal à pointe (SNN), un neurone produit un signal de sortie seulement après un nombre donné de signaux d’entrée, un processus qui est une véritable reproduction du comportement de vrais neurones biologiques. Étant donné que les réseaux neuronaux à pointe émettent rarement des impulsions, ils transmettent moins de données que les réseaux neuronaux artificiels classiques et nécessitent en principe moins de puissance et de bande passante de communication.

Comme prévu, le réseau neuronal de pointe a une telle caractéristique : un oubli catastrophique se produit au cours du processus d'apprentissage initial, mais après les cycles d'apprentissage suivants, après un certain temps, le nombre de personnes impliquées dans l'apprentissage de la première tâche Collections. des neurones sont réactivés. C’est plus proche de ce que pensent actuellement les neuroscientifiques du processus du sommeil.

En termes simples : SNN permet aux traces de mémoire précédemment apprises d'être automatiquement réactivées pendant le sommeil du traitement hors ligne et de modifier les poids synaptiques sans interférence.

Cette étude utilise un SNN multicouche avec apprentissage par renforcement pour explorer si l'oubli catastrophique peut être évité en entrelaçant des périodes d'entraînement à de nouvelles tâches avec des périodes d'activité autonome semblable au sommeil. L’étude a notamment montré que l’oubli catastrophique peut être évité en interrompant périodiquement l’apprentissage par renforcement lors de nouvelles tâches, similaires aux phases de sommeil.

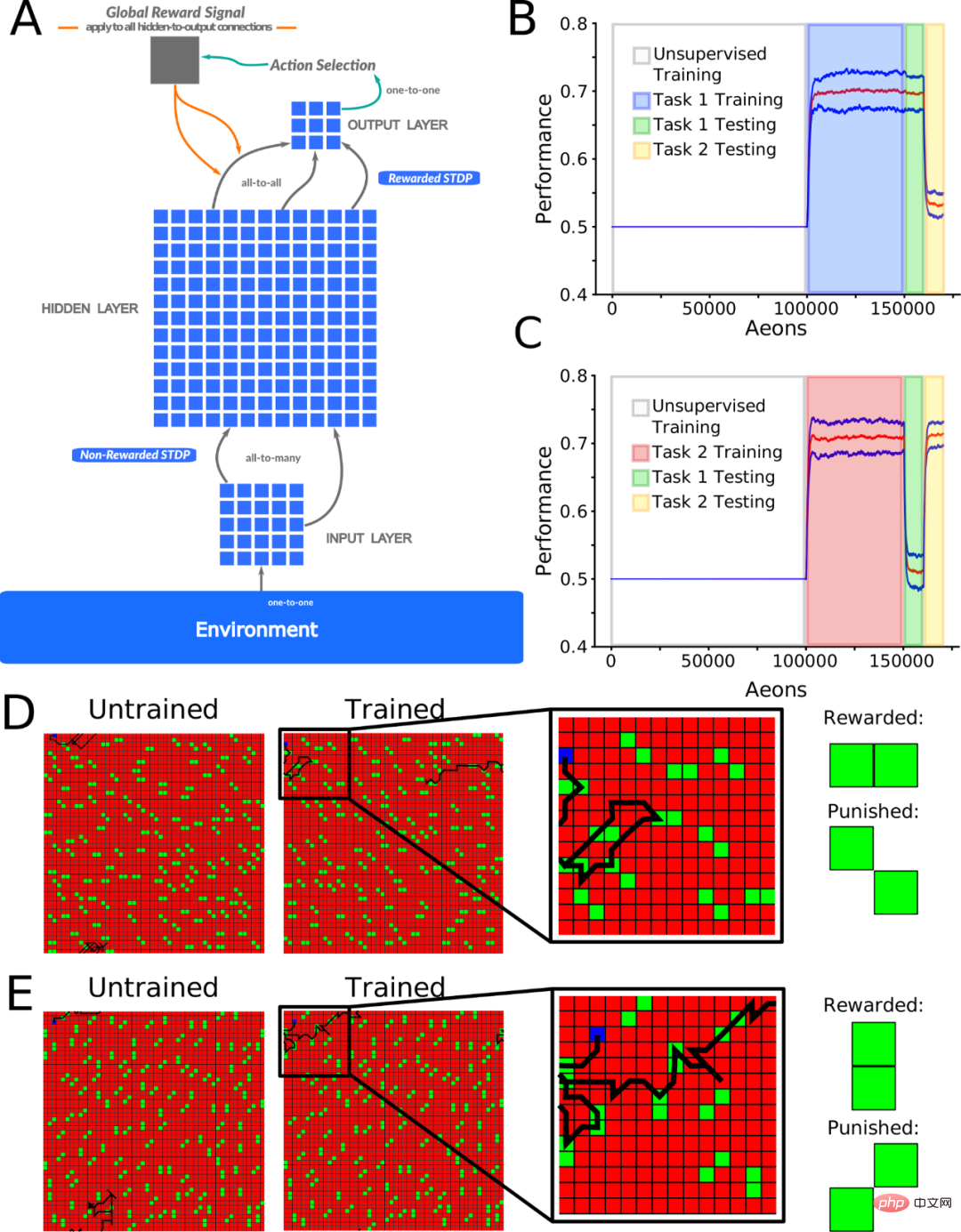

La figure 1A montre un réseau neuronal à action directe utilisé pour modéliser un signal de l'entrée à la sortie. Les neurones situés entre la couche d'entrée (I) et la couche cachée (H) subissent un apprentissage non supervisé (mis en œuvre à l'aide de STDP non récompensé), et les neurones entre la couche H et la couche de sortie (O) subissent un apprentissage par renforcement (mis en œuvre à l'aide de STDP récompensé). STDP).

L'apprentissage non supervisé permet aux neurones de la couche cachée d'apprendre différents modèles de particules à partir de différents emplacements spatiaux dans la couche d'entrée, tandis que le STDP de récompense permet aux neurones de la couche de sortie d'apprendre des décisions de mouvement en fonction du type de modèles de particules détectés par la couche d'entrée.

Les chercheurs ont formé le réseau de deux manières complémentaires. Dans l’une ou l’autre tâche, le réseau apprend à distinguer les modèles de particules de récompense et de punition, dans le but d’obtenir autant de récompense que possible. La tâche considère la discriminabilité des modèles (rapport entre la récompense dépensée et les particules de pénalité) comme mesure de performance avec une chance de 0,5. Tous les résultats rapportés sont basés sur au moins 10 expériences avec différentes initialisations de réseau aléatoires.

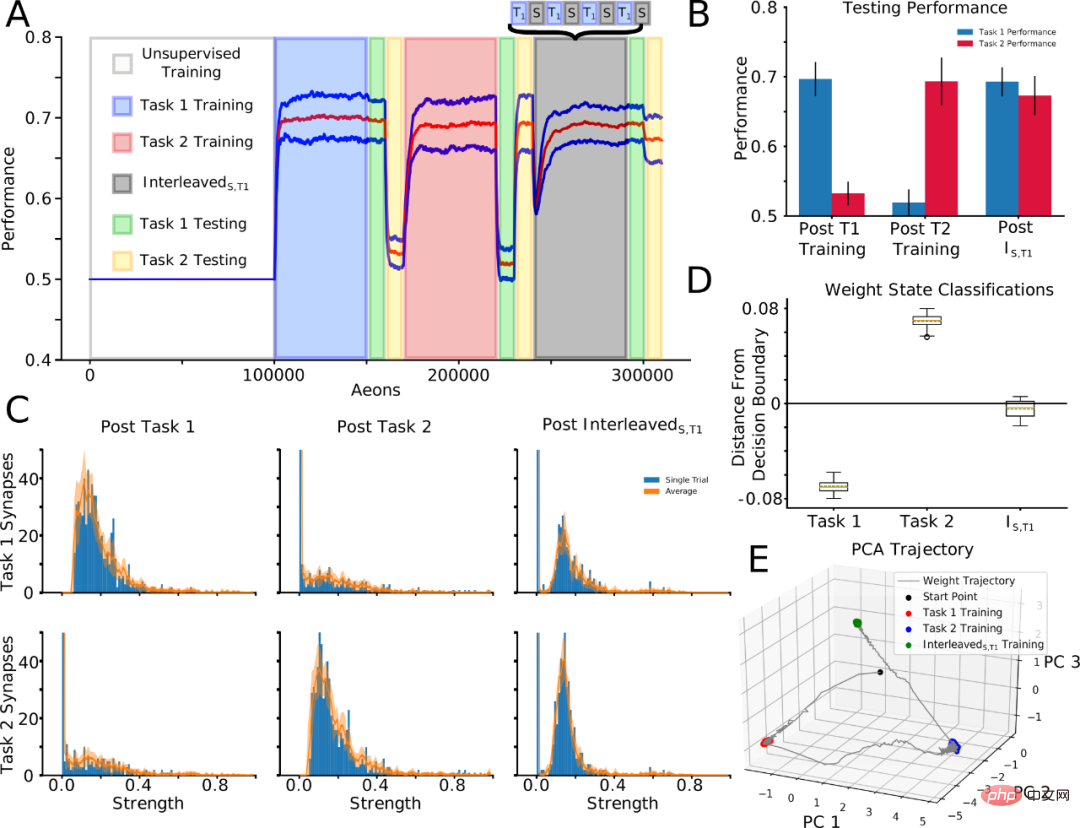

Pour révéler la dynamique du poids synaptique pendant l'entraînement et le sommeil, les chercheurs ont ensuite suivi les synapses « liées à une tâche », c'est-à-dire les synapses identifiées dans les 10 % supérieurs de la distribution après un entraînement sur une tâche spécifique. La tâche 1 a été entraînée en premier, puis la tâche 2, et les synapses pertinentes pour la tâche ont été identifiées après chaque entraînement à la tâche. Continuez ensuite à nouveau la tâche d'entraînement 1, mais entrelacez-la avec le temps de sommeil (entraînement entrelacé) : T1 → T2 → InterleavedS, T1. La formation séquentielle de la tâche 1 à la tâche 2 a entraîné l'oubli de la tâche 1, mais après InterleavedS, la tâche 1 a été réappris et la tâche 2 a également été conservée (figures 4A et 4B).

Il est important de noter que cette stratégie nous a permis de comparer les poids synaptiques après un entraînement InterleavedS, T1 avec des poids synaptiques identifiés comme pertinents pour la tâche après un entraînement distinct des tâches 1 et 2 (Figure 4C). La structure de distribution des synapses liées à la tâche 1 formées après l'entraînement de la tâche 1 (Fig. 4C ; en haut à gauche) a été perturbée après l'entraînement de la tâche 2 (en haut au milieu) mais partiellement restaurée après l'entraînement InterleavedS, T1 (en haut à droite). La structure de distribution des synapses liées à la tâche 2 après l'entraînement de la tâche 2 (en bas au centre) est absente après l'entraînement de la tâche 1 (en bas à gauche) et est partiellement préservée après l'entraînement InterleavedS, T1 (en bas à droite).

Il convient de noter que ce modèle qualitatif peut être clairement observé au sein d’un seul essai (Figure 4C ; barre bleue) et peut également se généraliser à travers les essais (Figure 4C ; ligne orange). Par conséquent, le sommeil peut préserver des synapses importantes tout en fusionnant de nouvelles synapses.

Figure 4. Des périodes entrelacées d'entraînement à une nouvelle tâche et de sommeil permettent l'intégration des informations synaptiques pertinentes pour la nouvelle tâche tout en préservant les anciennes informations sur la tâche.

"Fait intéressant, nous n'avons pas explicitement stocké les données liées aux premiers souvenirs afin de les rejouer artificiellement pendant le sommeil pour éviter tout oubli", a déclaré le co-auteur de l'étude, Informatique à l'Institut d'informatique de l'Académie tchèque des sciences. dit le neuroscientifique Pavel Sanda.

Nouvelle stratégie trouvée pour aider à prévenir les oublis catastrophiques. Le réseau neuronal de pointe a pu effectuer les deux tâches après avoir traversé des phases semblables à celles du sommeil, et les chercheurs pensent que leur stratégie a contribué à préserver les schémas synaptiques associés aux anciennes et aux nouvelles tâches.

"Notre travail démontre le caractère pratique du développement de solutions d'inspiration biologique", a déclaré Delanois.

Les chercheurs notent que leurs découvertes ne se limitent pas à l’augmentation des réseaux neuronaux. Sanda a déclaré que les travaux à venir montrent que les étapes semblables au sommeil pourraient aider à "surmonter l'oubli catastrophique dans les réseaux neuronaux artificiels standards".

L'étude a été publiée le 18 novembre dans la revue PLOS Computational Biology.

Article : "Le sommeil prévient les oublis catastrophiques dans les réseaux neuronaux en formant une représentation synaptique conjointe du poids"

Adresse de l'article : https://journals.plos.org/ploscompbiol /article ?id=10.1371/journal.pcbi.1010628

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI