Maison >Périphériques technologiques >IA >En apprenant ChatGPT, que se passera-t-il si le feedback humain est introduit dans la peinture IA ?

En apprenant ChatGPT, que se passera-t-il si le feedback humain est introduit dans la peinture IA ?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-12 21:04:011865parcourir

Récemment, les modèles génératifs profonds ont obtenu un succès remarquable dans la génération d'images de haute qualité à partir d'invites de texte, en partie grâce à la mise à l'échelle des modèles génératifs profonds vers des ensembles de données Web à grande échelle tels que LAION. Cependant, des défis importants subsistent, empêchant les modèles texte-image à grande échelle de générer des images parfaitement alignées avec les invites textuelles. Par exemple, les modèles texte-image actuels ne parviennent souvent pas à générer un texte visuel fiable et ont des difficultés à générer des images combinées.

De retour dans le domaine de la modélisation du langage, l'apprentissage à partir des commentaires humains est devenu une solution puissante pour « aligner le comportement du modèle sur les intentions humaines ». Ce type de méthode apprend d'abord une fonction de récompense conçue pour refléter ce qui intéresse les humains dans la tâche grâce à un retour humain sur la sortie du modèle, puis utilise la fonction de récompense apprise via un algorithme d'apprentissage par renforcement (tel que l'optimisation de politique proximale PPO) pour optimiser le langage. modèles. Ce cadre d'apprentissage par renforcement avec rétroaction humaine (RLHF) a combiné avec succès des modèles de langage à grande échelle (tels que GPT-3) avec une évaluation sophistiquée de la qualité humaine.

Récemment, inspirés par le succès du RLHF dans le domaine linguistique, des chercheurs de Google Research et de Berkeley, en Californie, ont proposé une méthode de réglage fin pour aligner le texte sur des modèles d'image en utilisant la rétroaction humaine.

Adresse papier : https://arxiv.org/pdf/2302.12192v1.pdf

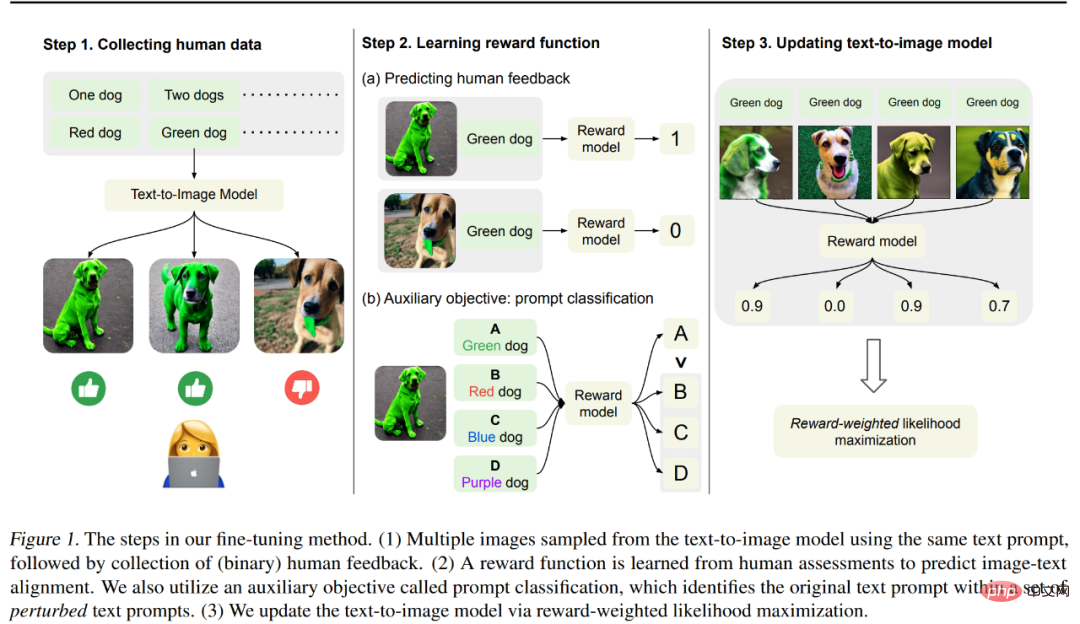

La méthode de cet article est présentée dans la figure 1 ci-dessous, qui est principalement divisée en 3 mesures.

Étape 1 : Générez d'abord différentes images à partir d'un ensemble d'invites de texte "conçues pour tester l'alignement du texte sur la sortie du modèle d'image". Plus précisément, examinez les invites du modèle pré-entraîné les plus sujettes aux erreurs : générer des objets avec une couleur, un nombre et un arrière-plan spécifiques, puis collecter des commentaires humains binaires utilisés pour évaluer la sortie du modèle.

Étape 2 : À l'aide d'un ensemble de données étiquetées par des humains, entraînez une fonction de récompense pour prédire les commentaires humains à partir d'invites d'images et de texte. Nous proposons une tâche auxiliaire pour identifier les invites textuelles originales parmi un ensemble d’invites textuelles perturbées afin d’utiliser plus efficacement les commentaires humains pour l’apprentissage par récompense. Cette technique améliore la généralisation de la fonction de récompense aux images et aux invites textuelles invisibles.

Étape 3 : Mettez à jour le modèle texte-image via une maximisation de la probabilité pondérée par les récompenses pour mieux l'aligner sur les commentaires humains. Contrairement aux travaux précédents qui utilisaient l’apprentissage par renforcement pour l’optimisation, les chercheurs ont utilisé l’apprentissage semi-supervisé pour mettre à jour le modèle afin de mesurer la qualité du résultat du modèle, qui est la fonction de récompense apprise.

Les chercheurs ont utilisé 27 000 paires image-texte avec des commentaires humains pour affiner le modèle de diffusion stable. Les résultats ont montré que le modèle affiné a permis d'obtenir des améliorations significatives dans la génération d'objets avec des couleurs, des quantités et des quantités spécifiques. et les arrière-plans. Amélioration jusqu'à 47 % de l'alignement image-texte avec une légère perte de fidélité de l'image.

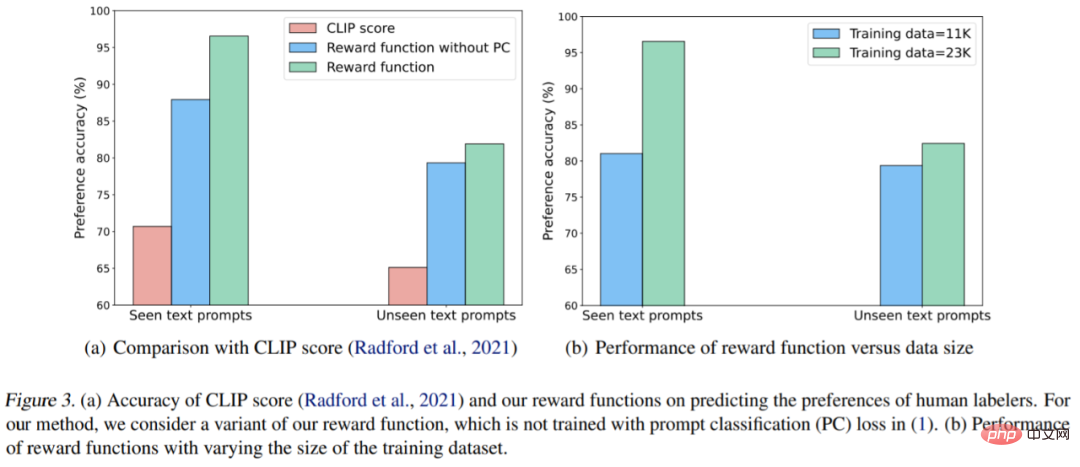

De plus, les résultats de génération combinée ont été améliorés pour mieux générer des objets invisibles grâce à une combinaison d'invites de couleur, de quantité et d'arrière-plan invisibles. Ils ont également observé que la fonction de récompense apprise correspondait mieux aux évaluations humaines de l’alignement que les scores CLIP sur les invites textuelles du test.

Cependant, Kimin Lee, le premier auteur de l'article, a également déclaré que les résultats de cet article n'ont pas résolu tous les modèles d'échec du modèle texte-image existant et qu'il reste encore de nombreux défis. Ils espèrent que ce travail mettra en évidence le potentiel de l’apprentissage à partir de la rétroaction humaine dans l’alignement des modèles de graphes Vincent.

Introduction à la méthode

Afin d'aligner l'image générée avec l'invite de texte, cette étude a effectué une série de réglages fins sur le modèle pré-entraîné, et le processus est illustré dans la figure 1 ci-dessus. Tout d'abord, les images correspondantes ont été générées à partir d'un ensemble d'invites textuelles, un processus conçu pour tester diverses performances du modèle graphique vincentien ; puis des évaluateurs humains ont fourni un retour binaire sur ces images générées. Ensuite, l'étude a formé un modèle de récompense pour prédire le retour humain ; des invites de texte et des images en entrée ; enfin, l'étude utilise la log-vraisemblance pondérée en fonction des récompenses pour affiner le modèle de graphique de Vincent afin d'améliorer l'alignement texte-image.

Collecte de données humaines

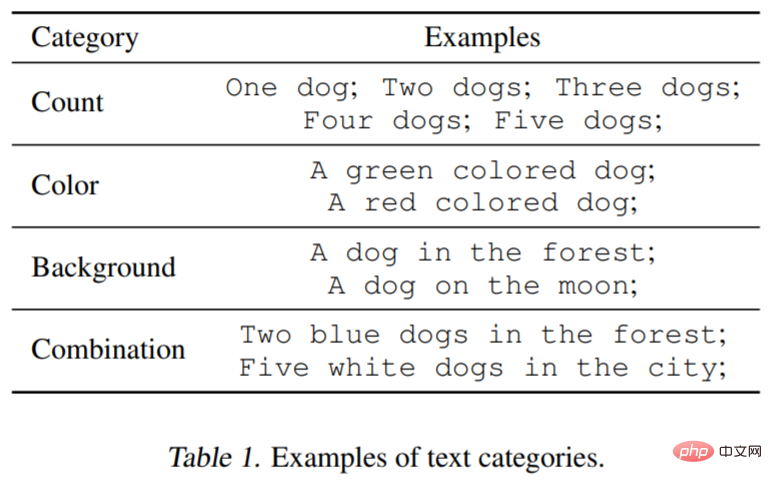

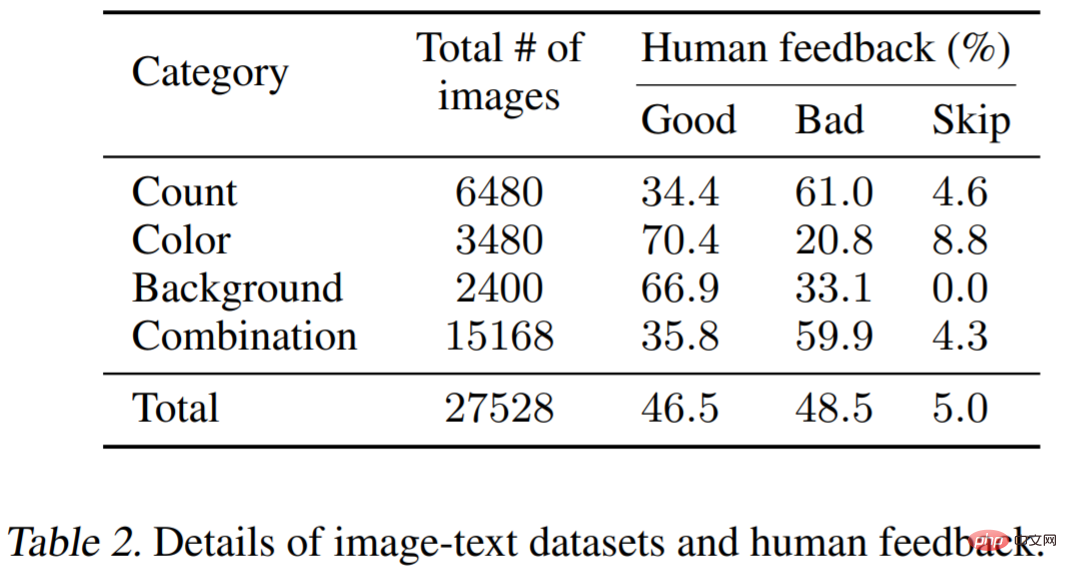

Pour tester la fonctionnalité du modèle de graphique vincentien, l'étude a considéré trois types d'invites textuelles : le nombre spécifié, la couleur et l'arrière-plan. Pour chaque catégorie, l'étude a généré des invites en associant chaque mot ou expression décrivant l'objet, comme le vert (couleur) avec un chien (quantité). De plus, l’étude a examiné des combinaisons de trois catégories (par exemple, deux chiens teints en vert dans une ville). Le tableau 1 ci-dessous illustre mieux la classification des ensembles de données. Chaque invite sera utilisée pour générer 60 images, et le modèle est principalement Stable Diffusion v1.5.

Commentaires humains

Vient ensuite les commentaires humains sur les images générées. Trois images générées par la même invite seront présentées aux étiqueteurs, et il leur sera demandé d'évaluer si chaque image générée est cohérente avec l'invite, et les critères d'évaluation seront bons ou mauvais. Cette tâche étant relativement simple, une rétroaction binaire suffira.

Reward Learning

Pour mieux évaluer l'alignement image-texte, cette étude utilise une fonction de récompense  pour le mesurer, qui peut mapper l'intégration CLIP de l'image x et de l'invite de texte z à la norme ampleur. Il est ensuite utilisé pour prédire le feedback humain k_y ∈ {0, 1} (1 = bon, 0 = mauvais).

pour le mesurer, qui peut mapper l'intégration CLIP de l'image x et de l'invite de texte z à la norme ampleur. Il est ensuite utilisé pour prédire le feedback humain k_y ∈ {0, 1} (1 = bon, 0 = mauvais).

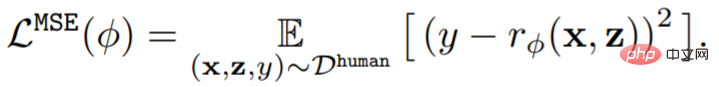

Formellement parlant, étant donné l'ensemble de données de rétroaction humaine D^human = {(x, z, y)}, la fonction de récompense  est entraînée en minimisant l'erreur quadratique moyenne (MSE) :

est entraînée en minimisant l'erreur quadratique moyenne (MSE) :

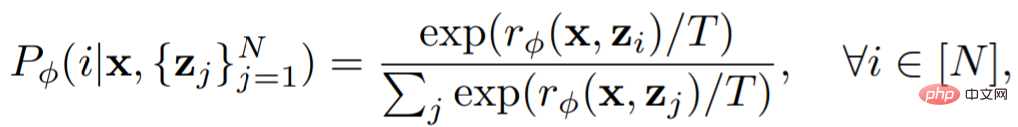

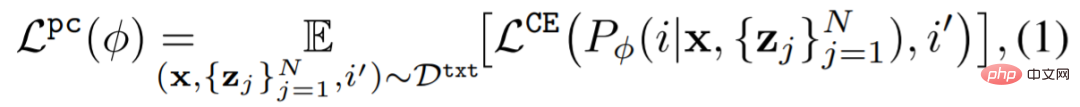

Des études précédentes ont montré que les méthodes d'augmentation des données peuvent améliorer considérablement l'efficacité des données et les performances d'apprentissage des modèles. Afin d'utiliser efficacement les ensembles de données de rétroaction, cette étude a conçu un schéma simple d'augmentation des données et récompense la perte auxiliaire d'apprentissage. Cette étude utilise des invites améliorées dans une tâche auxiliaire, c'est-à-dire que l'apprentissage des récompenses de classification est effectué sur les invites d'origine. Le classificateur Prompt utilise une fonction de récompense comme suit :

La perte auxiliaire est :

Enfin, le modèle graphique Vincent est mis à jour. Étant donné que la diversité de l'ensemble de données généré par le modèle est limitée, cela peut conduire à un surajustement. Pour atténuer cela, l'étude a également minimisé la perte avant l'entraînement comme suit :

Résultats expérimentaux

La partie expérimentale est conçue pour tester l'efficacité du feedback humain participant à la mise au point du modèle. Le modèle utilisé dans l'expérience est Stable Diffusion v1.5 ; les informations sur l'ensemble de données sont présentées dans le tableau 1 (voir ci-dessus) et le tableau 2. Le tableau 2 montre la distribution des commentaires fournis par plusieurs étiqueteurs humains.

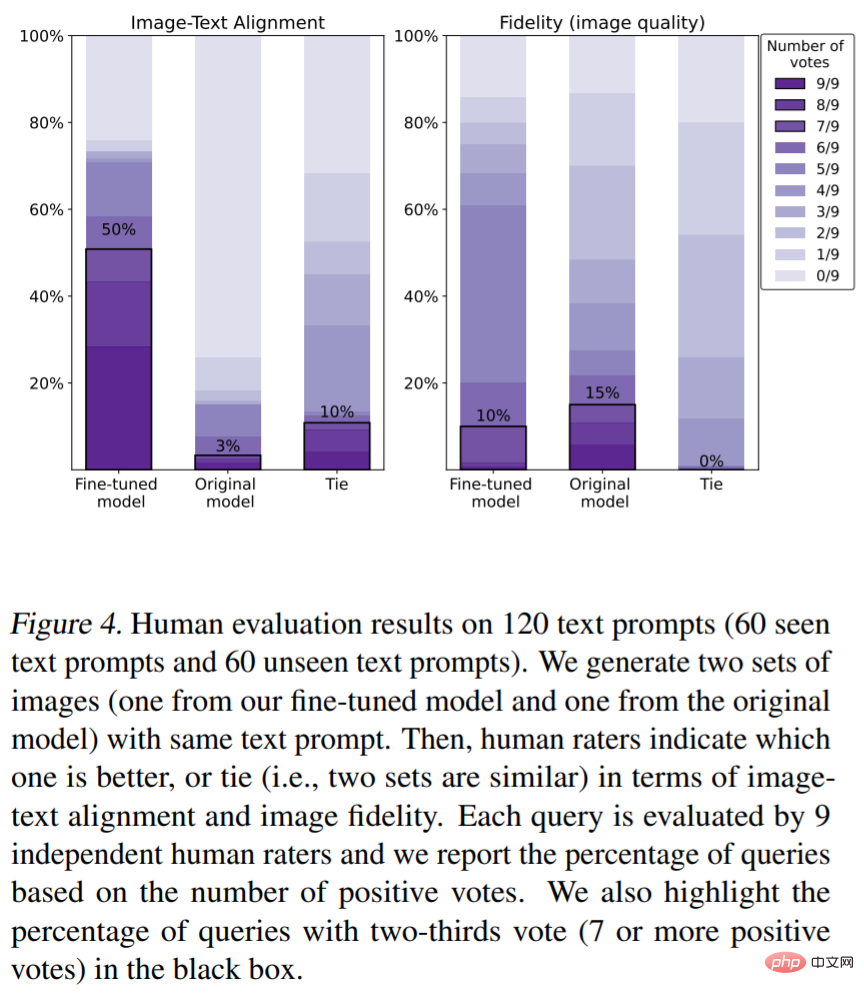

Évaluations humaines de l'alignement texte-image (les mesures d'évaluation sont la couleur, le nombre d'objets). Comme le montre la figure 4, notre méthode a considérablement amélioré l'alignement image-texte. Plus précisément, 50 % des échantillons générés par le modèle ont reçu au moins les deux tiers des votes favorables (le nombre de votes était de 7 votes favorables ou plus). . votes), cependant, le réglage fin réduit légèrement la fidélité de l'image (15 % contre 10 %).

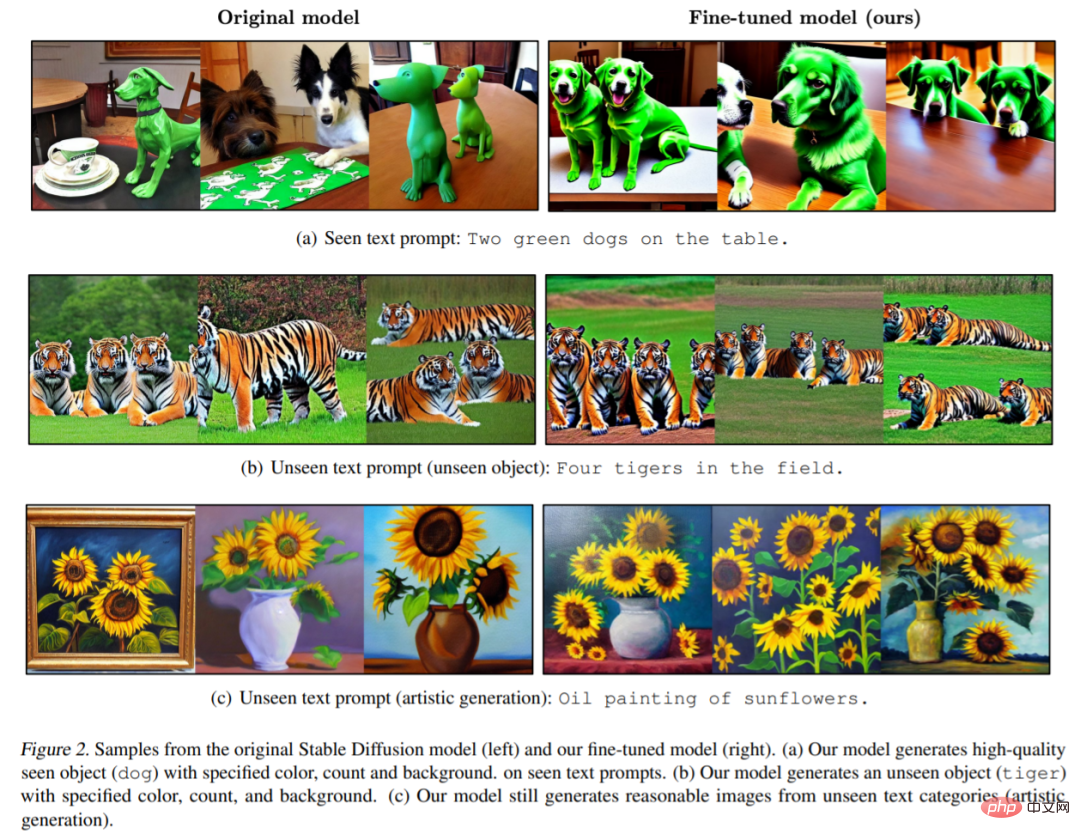

La figure 2 montre des exemples d'images du modèle original et du modèle correspondant affiné de ce document. On peut voir que le modèle d'origine a généré des images qui manquaient de détails (tels que la couleur, l'arrière-plan ou le nombre) (Figure 2 (a)) et que l'image générée par notre modèle est conforme à la couleur, au nombre et à l'arrière-plan spécifiés par l'invite. . Il convient de noter que le modèle présenté dans cet article peut également générer des images d'invite de texte invisibles de très haute qualité (Figure 2 (b)).

Récompensez les résultats d'apprentissage. La figure 3 (a) montre les scores du modèle dans les invites textuelles vues et invisibles. Avoir des récompenses (vert) est plus cohérent avec les intentions humaines typiques que les scores CLIP (rouge).

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI