Maison >Périphériques technologiques >IA >Quel est le potentiel des modèles à paramètres fixes ? Les Chinois de Hong Kong, le Shanghai AI Lab et d'autres ont proposé un cadre efficace de compréhension vidéo EVL

Quel est le potentiel des modèles à paramètres fixes ? Les Chinois de Hong Kong, le Shanghai AI Lab et d'autres ont proposé un cadre efficace de compréhension vidéo EVL

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-12 20:58:041144parcourir

Les modèles visuels de base ont connu un développement remarquable au cours des deux dernières années. D'une part, le pré-entraînement basé sur des données Internet à grande échelle a prédéfini un grand nombre de concepts sémantiques pour le modèle, ayant ainsi de bonnes performances de généralisation, mais d'autre part, afin d'utiliser pleinement la taille du modèle apportée ; par des ensembles de données à grande échelle La croissance rend les modèles associés confrontés à des problèmes d'inefficacité lors de la migration vers des tâches en aval, en particulier pour les modèles de compréhension vidéo qui doivent traiter plusieurs images.

- Lien papier : https://arxiv.org/abs/2208.03550

- Lien code : https://github.com/OpenGVLab/efficient-video-recognition

Sur la base des deux caractéristiques ci-dessus, des chercheurs de l'Université chinoise de Hong Kong, du Laboratoire d'intelligence artificielle de Shanghai et d'autres institutions ont proposé un cadre d'apprentissage par transfert de compréhension vidéo efficace EVL, qui économise les calculs d'entraînement et la mémoire en fixant le poids de la base de base modèle de consommation ; dans le même temps, en utilisant des fonctionnalités intermédiaires à plusieurs niveaux et à granularité fine, la flexibilité du réglage fin traditionnel de bout en bout est maintenue autant que possible.

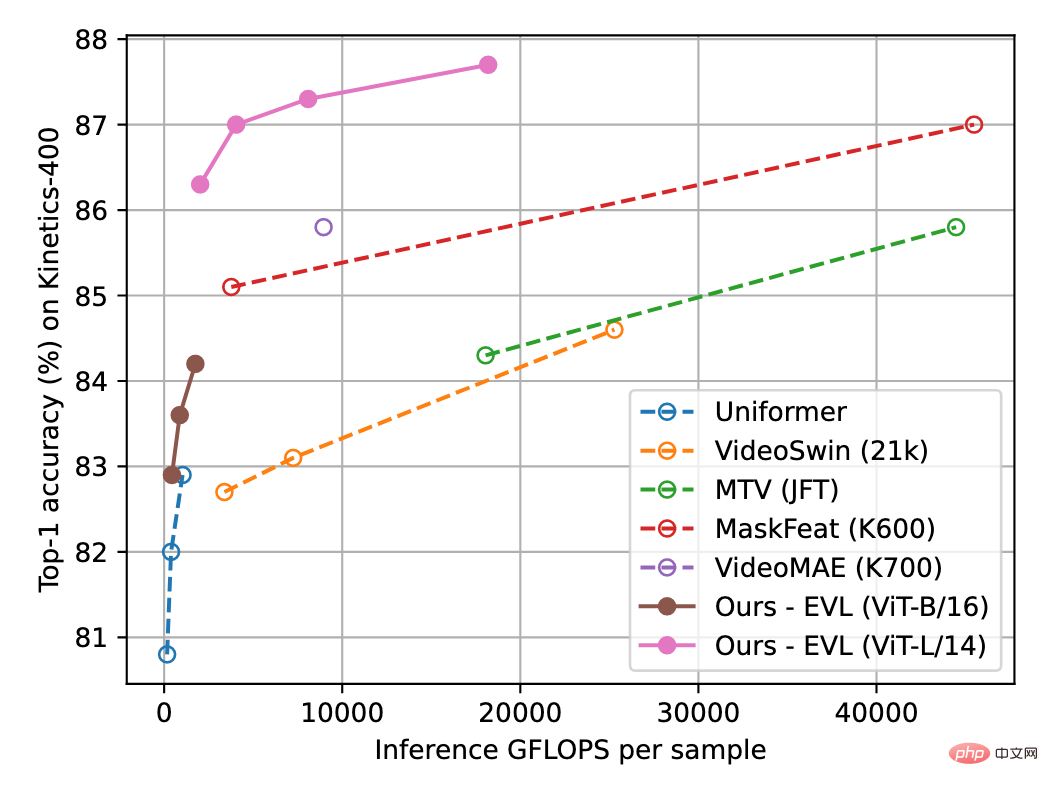

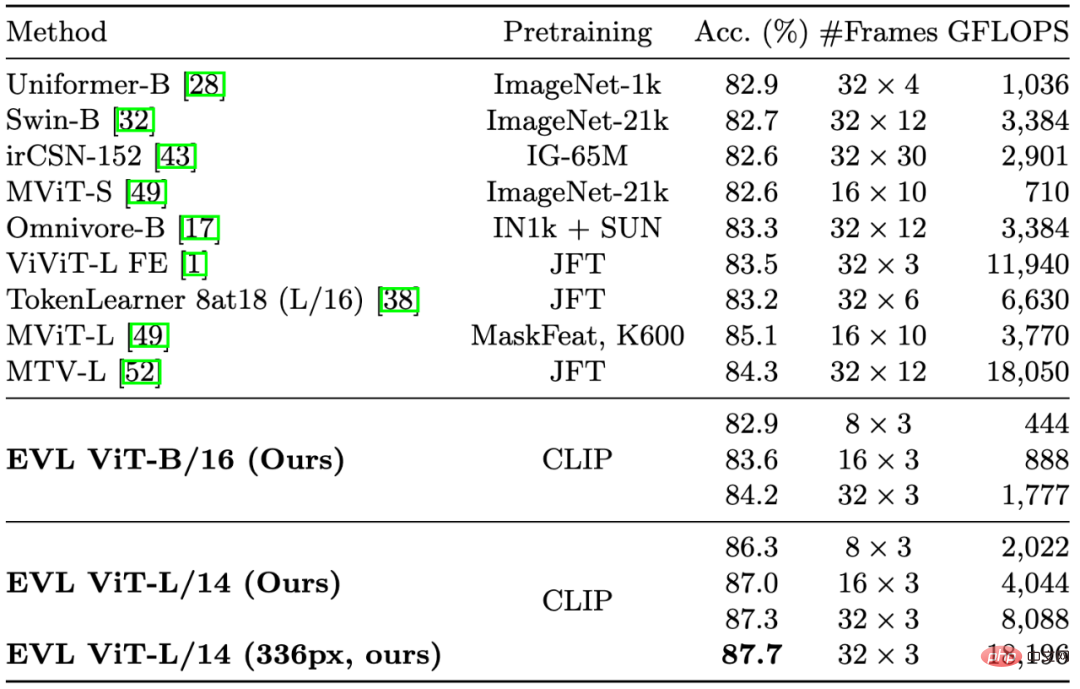

La figure 1 ci-dessous montre les résultats de la méthode EVL sur l'ensemble de données de compréhension vidéo Kinetics-400. Les expériences montrent que tout en réduisant les frais de formation, cette méthode explore pleinement le potentiel du modèle visuel de base dans les tâches de compréhension vidéo.

Figure 1 : Comparaison de la précision de reconnaissance de Kinetics-400 L'axe horizontal est la quantité de calcul d'inférence et l'axe vertical est la précision. Le diagramme schématique global de l'algorithme de la

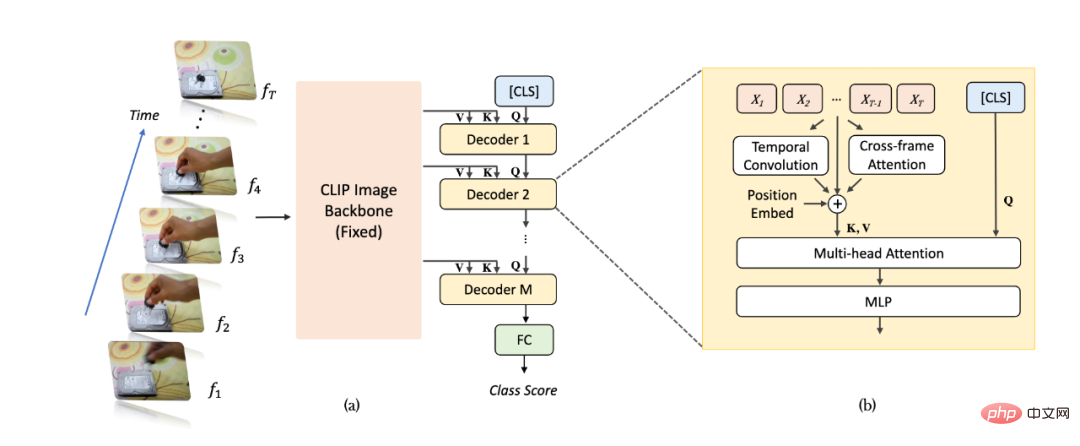

méthode

est présenté à la figure 2 (a). Pour un échantillon vidéo, nous prenons des images T et les entrons dans un réseau de reconnaissance d'image (en prenant CLIP comme exemple) et extrayons les fonctionnalités. Par rapport aux méthodes traditionnelles, nous extrayons des fonctionnalités multicouches non regroupées des dernières couches du réseau de reconnaissance d'images pour obtenir des informations d'image plus riches et plus fines, et les poids des paramètres du réseau de reconnaissance d'images sont toujours cohérents dans l'apprentissage vidéo. fixé. Par la suite, les cartes de caractéristiques multicouches sont entrées séquentiellement dans un décodeur Transformer pour l'agrégation d'informations au niveau vidéo. Les caractéristiques décodées multicouches [CLS] sont utilisées pour générer la prédiction de classification finale.

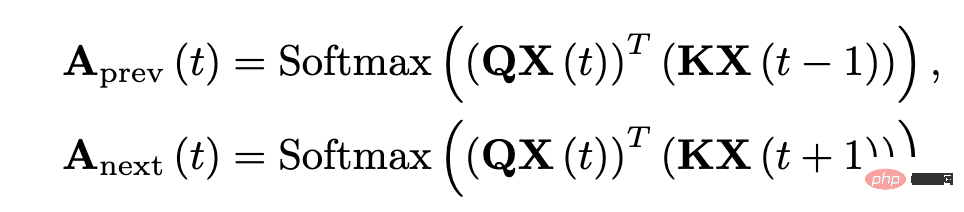

Comme le montre la figure 2 (b), en raison du désordre lorsque le décodeur Transformer regroupe les fonctionnalités, nous avons ajouté un module de modélisation d'informations de synchronisation supplémentaire dans le réseau pour mieux extraire les informations de synchronisation à grain fin liées à la position. Plus précisément, nous ajoutons trois types supplémentaires d'informations temporelles liées à la position : le premier est l'intégration de la position temporelle (Position Embeddings), le deuxième est la convolution séparable en profondeur de la dimension temporelle (Depthwise Convolution) et le troisième est l'attention entre les images adjacentes. forcer les informations. Pour les informations d'attention inter-trames, nous extrayons les caractéristiques de requête et clés de la couche correspondante du réseau de reconnaissance d'image et calculons la carte d'attention entre les trames adjacentes (différente du réseau de reconnaissance d'image, la carte d'attention est composée de la requête du même cadre et caractéristiques clés sont obtenus). La carte d'attention résultante peut refléter explicitement les changements de position des objets entre des images adjacentes. Après projection linéaire, la carte d'attention obtient un groupe de vecteurs qui reflète les caractéristiques de déplacement de l'objet et est intégrée aux caractéristiques de l'image sous la forme d'une addition élément par élément.

Figure 2 : Diagramme de structure de l'algorithme EVL. (a) Structure globale, (b) Module de modélisation d'informations séquentielles.

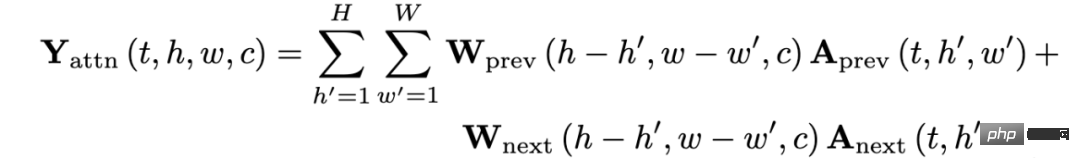

Figure 3 : Expression mathématique des caractéristiques d'attention inter-cadres.

Expérience

Dans la figure 1 et le tableau 1, nous avons cité quelques méthodes importantes dans la compréhension des vidéos précédentes. Bien qu'elle se concentre sur la réduction des frais de formation, notre méthode surpasse toujours les méthodes existantes en termes de précision (avec la même quantité de calcul).

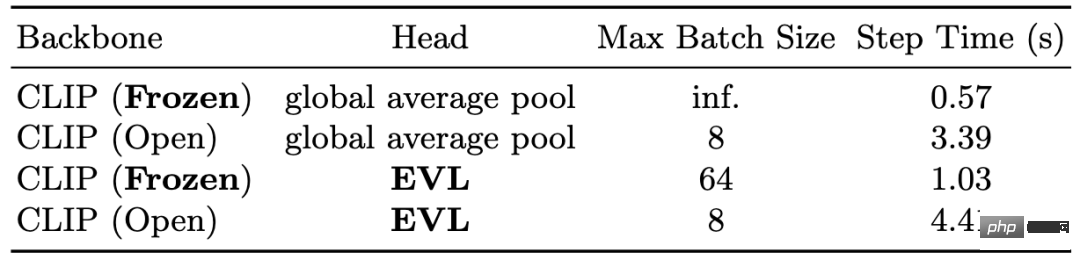

Dans le tableau 2, nous montrons la réduction des frais de formation apportée par le réseau fédérateur fixe. En termes de mémoire, sur le GPU V100 16 Go, le réseau fédérateur fixe peut permettre à une taille de lot d'une seule carte d'atteindre un maximum de 64, tandis que la formation de bout en bout ne peut atteindre que 8 en termes de temps, le fédérateur fixe ; Le réseau peut économiser 3 à 4 fois le temps de formation.

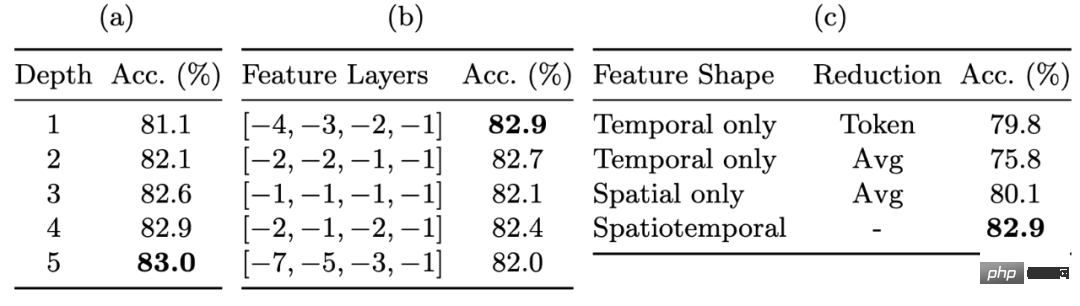

Dans le tableau 3, nous montrons l'amélioration des performances de reconnaissance grâce à des cartes de fonctionnalités à granularité fine. Les fonctionnalités multicouches non poolées nous permettent de conserver un degré considérable de flexibilité lors de la fixation des poids du réseau fédérateur. L'utilisation de fonctionnalités non poolées apporte l'amélioration la plus significative (environ 3 %), suivie par l'utilisation de décodeurs multicouches et de fonctionnalités de couche intermédiaire, qui apportent également chacune une amélioration des performances d'environ 1 %.

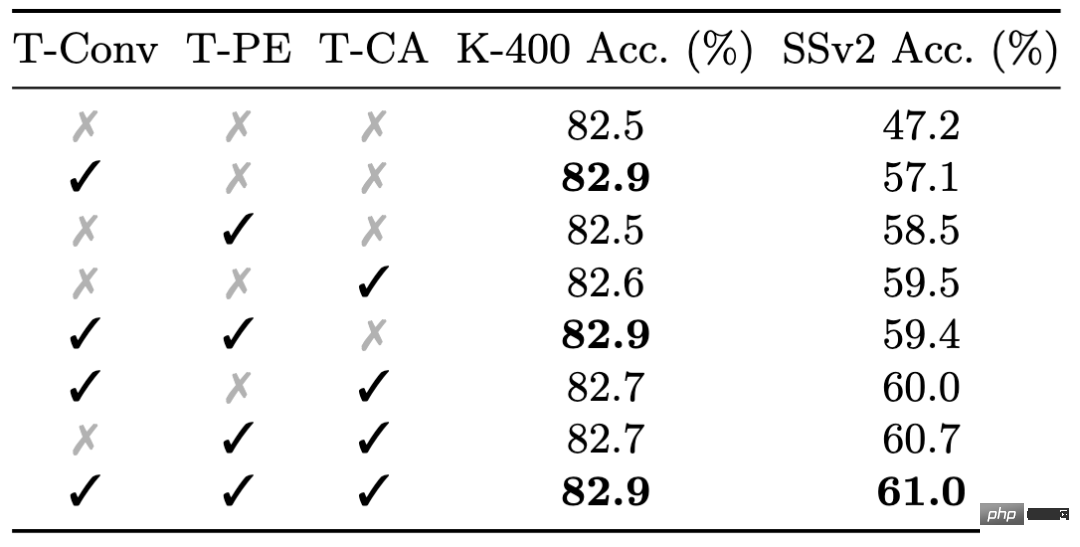

Enfin, nous montrons l'effet du module d'informations de synchronisation à granularité fine dans le tableau 4. Bien que les informations de synchronisation fines aient un impact limité sur les performances de Kinetics-400, elles sont très importantes pour les performances de Something-Something-v2 : les trois types de modules d'informations de synchronisation fines apportent un total d'environ 0,5 % et environ 14 % d’amélioration des performances.

Tableau 1 : Résultats de comparaison avec les méthodes existantes sur Kinetics-400

Tableau 2 : Réduction des frais généraux de formation causée par les poids fixes du réseau principal

Tableau 3 : L'impact des cartes de caractéristiques à granularité fine sur la précision

Tableau 4 : L'effet de la modélisation d'informations temporelles à granularité fine sur différents ensembles de données

Résumé

Cet article propose le cadre d'apprentissage de compréhension vidéo EVL, qui démontre pour la première fois le grand potentiel d'un réseau fédérateur d'images fixes dans les problèmes de compréhension vidéo, et rend également la compréhension vidéo haute performance plus conviviale pour les groupes de recherche disposant de ressources informatiques limitées. ressources. Nous pensons également qu'à mesure que la qualité et l'échelle des modèles visuels de base s'améliorent, notre méthode peut fournir une référence pour les recherches ultérieures sur les algorithmes légers d'apprentissage par transfert.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI