Maison >Périphériques technologiques >IA >Qui a publié la recherche la plus influente sur l'IA ? Google est loin devant, le taux de conversion des réussites d'OpenAI bat DeepMind

Qui a publié la recherche la plus influente sur l'IA ? Google est loin devant, le taux de conversion des réussites d'OpenAI bat DeepMind

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-12 20:55:011068parcourir

Qui publie la recherche sur l’IA la plus marquante ? À l’heure actuelle du « laisser fleurir cent fleurs », cette question présente un grand potentiel d’exploration.

Vous avez peut-être deviné certaines conclusions : de grandes institutions telles que Google, Microsoft, OpenAI et DeepMind n'ont qu'à moitié raison pour des conclusions comme celle-ci. Il existe également d'autres informations qui nous révèlent des conclusions qui étaient initialement inconnues.

Avec le développement rapide de l'innovation en IA, il est crucial d'obtenir une certaine « intelligence » le plus rapidement possible. Après tout, peu de gens ont le temps de tout lire, mais ce qui est certain, c’est que les articles compilés dans cet article ont le potentiel de changer l’orientation de la technologie de l’intelligence artificielle.

Le véritable test de l'influence de l'équipe R&D est bien sûr la manière dont la technologie est mise en œuvre dans les produits. OpenAI a publié ChatGPT fin novembre 2022, ce qui a choqué l'ensemble du secteur. Cela fait suite à leur article de mars 2022 « Utilisation ». Human Feedback" Une autre avancée après "Former des modèles de langage à suivre des instructions avec un feedback humain".

Il est rare qu'un produit soit lancé aussi rapidement. Par conséquent, afin d’obtenir plus d’informations, les statistiques de Zeta Alpha ont récemment adopté un indicateur académique classique : Citation Count.

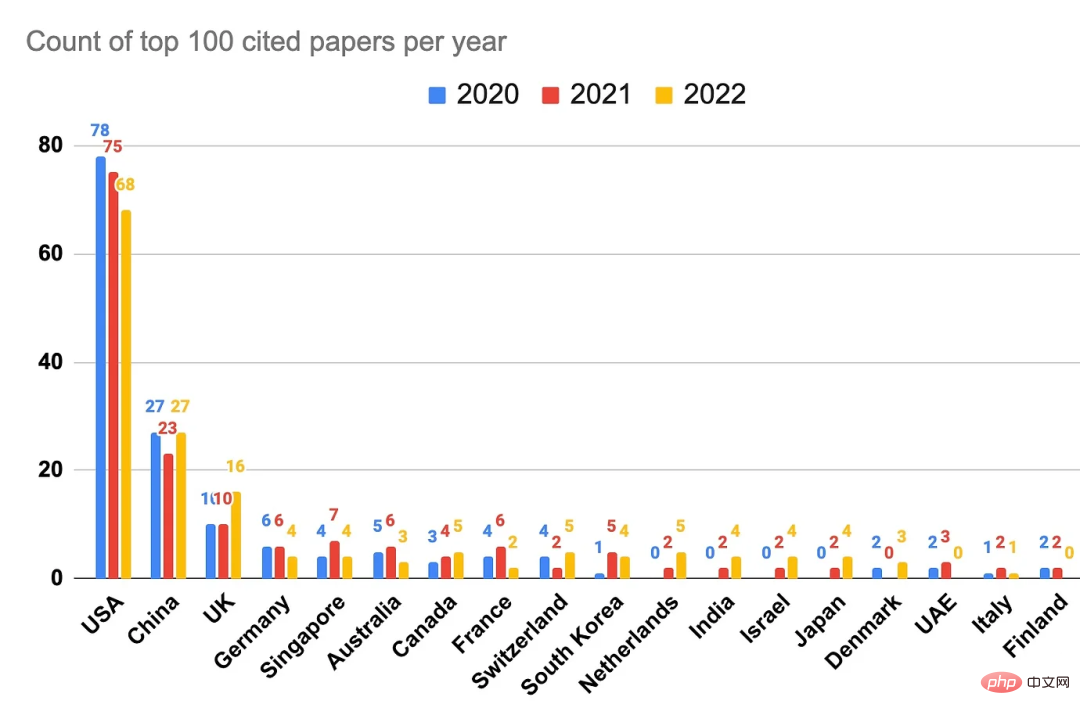

Une analyse détaillée des 100 articles les plus cités en 2022, 2021 et 2020 donne un aperçu des institutions et des pays qui publient actuellement les recherches les plus marquantes sur l'IA. Certaines conclusions préliminaires sont les suivantes : les États-Unis et Google dominent toujours, et DeepMind a également connu une excellente année, mais compte tenu des résultats, OpenAI est vraiment à l'avant-garde en termes d'impact produit et de recherche, et peut être adopté rapidement et largement.

Source : Zeta Alpha.

Comme le montre la figure ci-dessus, une autre conclusion importante est que la Chine se classe au deuxième rang en termes d'influence dans les citations de recherche, mais qu'il existe toujours un écart par rapport aux États-Unis, et qu'elle n'est pas aussi « à égalité » que décrit. dans de nombreux rapports, même au-delà.

À l'aide des données de la plateforme Zeta Alpha, puis combinées à une curation manuelle, cet article rassemble les articles les plus cités dans le domaine de l'intelligence artificielle en 2022, 2021 et 2020, et analyse les affiliations et les pays/régions des auteurs. . Cela permet de classer ces articles par impact R&D plutôt que par données de publication pures.

Pour créer l'analyse, nous avons d'abord collecté les articles les plus cités pour chaque année sur la plateforme Zeta Alpha, puis vérifié manuellement la première date de publication (généralement une préimpression arXiv) pour placer l'article dans la bonne année. Cette liste a ensuite été complétée par l'extraction d'articles sur l'IA très cités sur Semantic Scholar, qui a une couverture plus large et la possibilité de trier par nombre de citations. Cela découvre principalement des articles extérieurs à des éditeurs à fort impact tels que Nature, Elsevier, Springer et d'autres revues. Ensuite, le nombre de citations de chaque article sur Google Scholar a été utilisé comme mesure représentative, et les articles ont été triés selon ce nombre pour arriver dans le top 100 de l'année. Pour ces articles, nous avons utilisé GPT-3 pour extraire les auteurs, les affiliations et les pays et vérifié manuellement ces résultats (si le pays n'était pas évident dans la publication, le pays où se trouvait le siège de l'organisation a été utilisé). Si un article a des auteurs issus de plusieurs institutions, chaque institution est comptée une fois.

Après avoir lu ce classement, le patron Yann LeCun s'est dit très satisfait : « Chez Meta AI, nous privilégions la qualité plutôt que la quantité. C'est pourquoi parmi les 100 articles sur l'intelligence artificielle les plus cités en 2022, Meta AI a écrit ( ou co-écrit) 16 articles, se classant juste derrière les 22 articles de Google. Nos recherches ont un impact énorme sur la société (en plus, le classement de l'Université de New York est également très bon

Et alors). sont les principaux journaux dont nous venons de parler ?

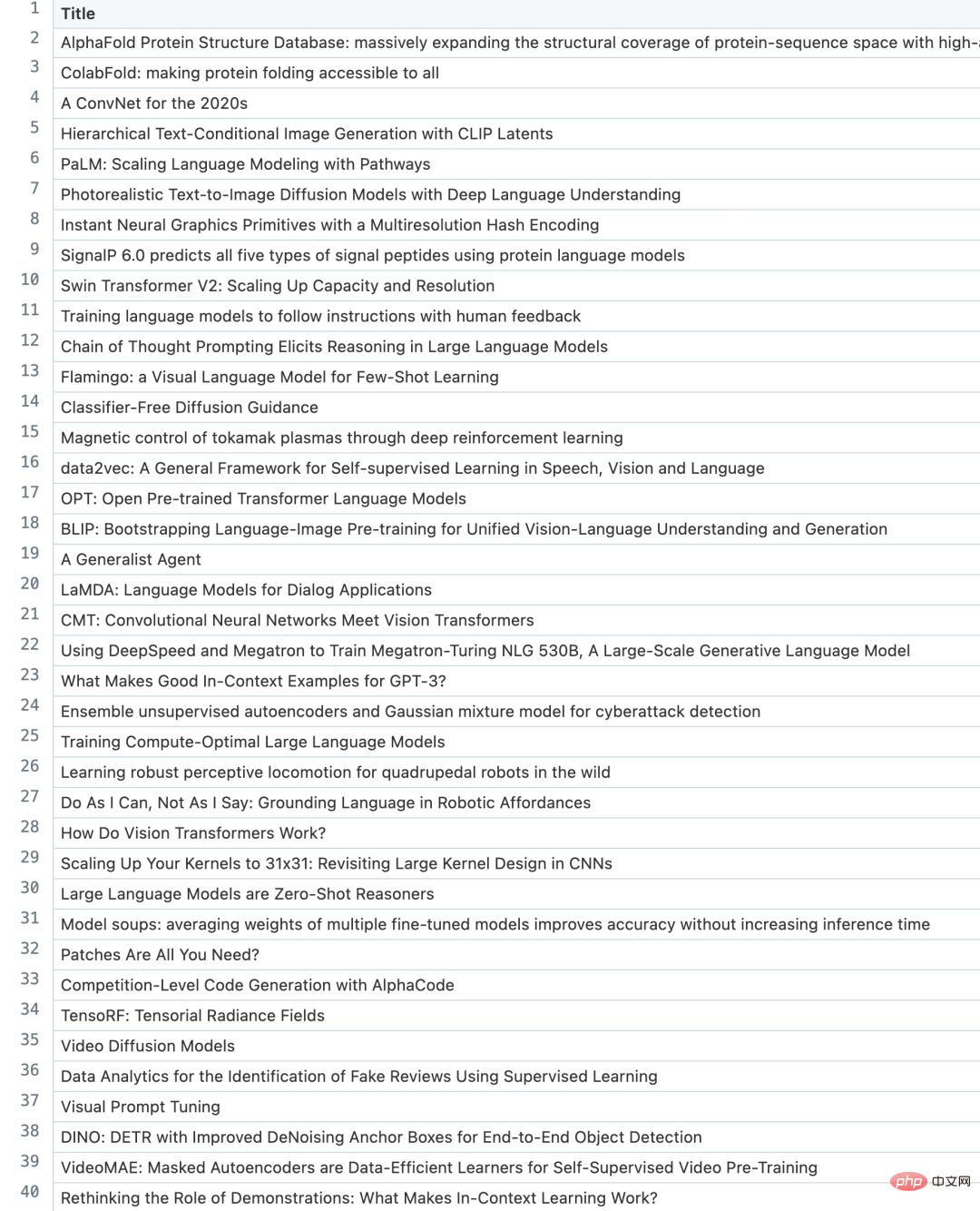

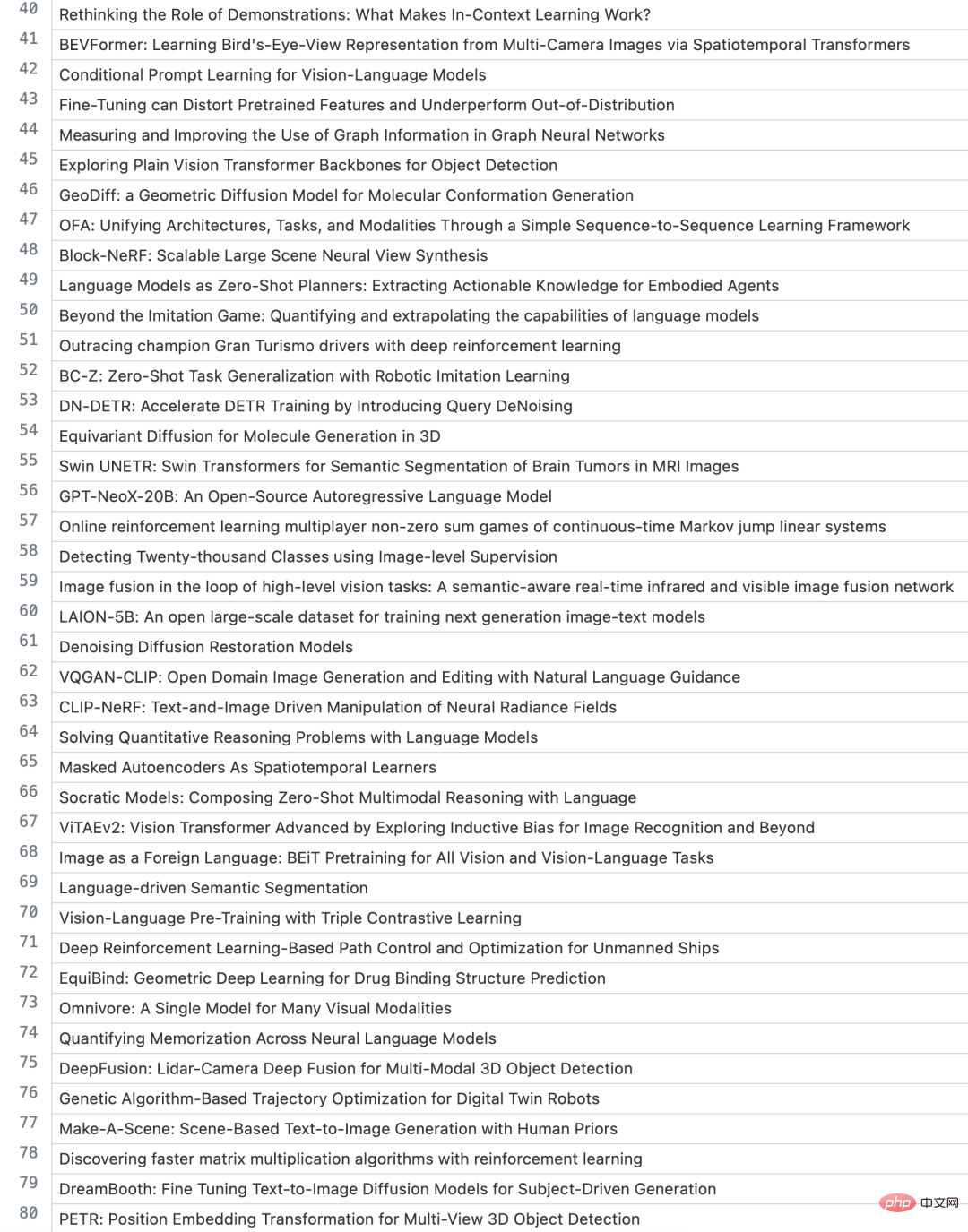

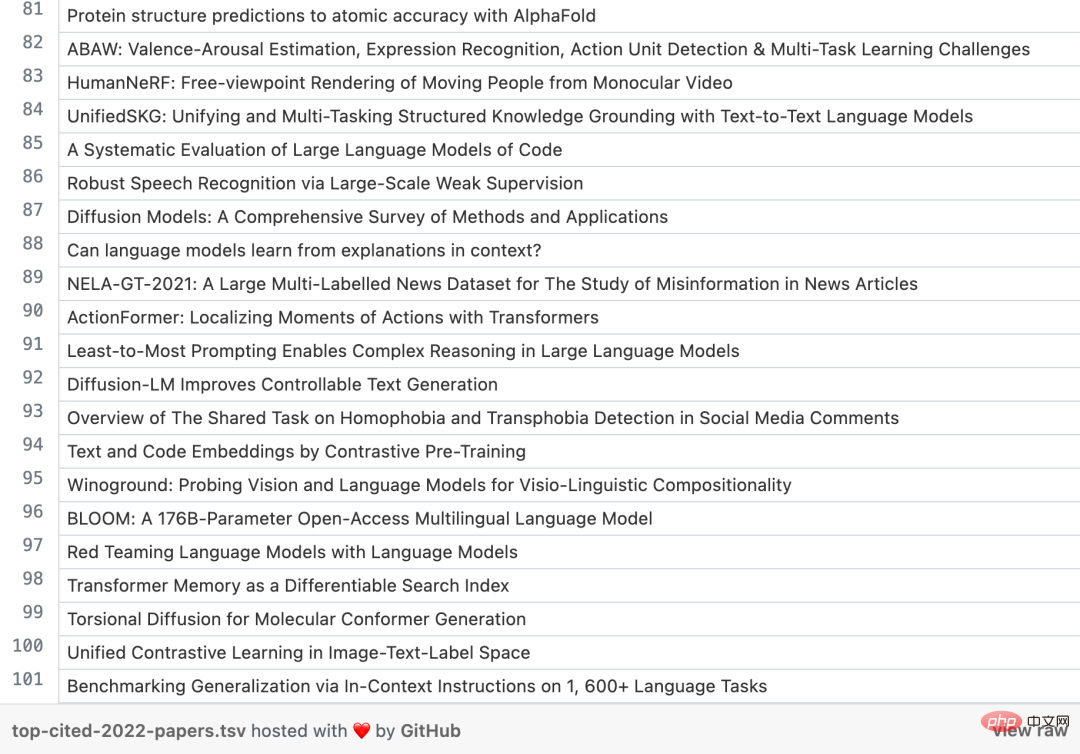

Avant de plonger dans les chiffres, jetons un coup d’œil aux meilleurs journaux des trois dernières années. Je suis sûr que vous en reconnaîtrez quelques-uns.

Articles chauds en 2022

1. Base de données sur la structure des protéines AlphaFold : étendre massivement la couverture structurelle de l'espace des séquences de protéines avec des modèles de haute précision

- Lien papier : https://academic.oup .com/nar/article/50/D1/D439/6430488

- Institution : DeepMind

- Nombre de citations : 1372

- Sujet : Utilisation d'AlphaFold pour augmenter la couverture de la base de données sur la structure des protéines.

2. ColabFold : rendre le repliement des protéines accessible à tous

- Lien papier : https://www.nature.com/articles/s41592-022-01488-1

- Nombre de citations : 1162

- Sujet : Un modèle de repliement de protéines open source et efficace.

3, Génération hiérarchique d'images conditionnelles de texte avec CLIP Latents

- Lien papier : https://arxiv.org/ abs/ 2204.06125

- Institution : OpenAI

- Nombre de citations : 718

- Sujet : DALL・E 2, génération d'images guidées complexes qui ont laissé les plus impressionnés

4、Un ConvNet pour les années 20 20

- Lien papier : https://arxiv.org/abs/2201.03545

- Institution : Meta, UC Berkeley

- Nombre de citations : 690

- Sujet : A modernisation réussie des CNN à une époque de boom pour Transformers in Computer Vision

5、PaLM : faire évoluer la modélisation du langage avec Pathways

- Lien papier : https://arxiv.org/abs/2204.02311

- Institution : Google

- Nombre de citations : 452

- Sujet : Le gigantesque modèle de langage étendu 540B de Google, une nouvelle infrastructure MLOps et ses performances

Articles chauds en 2021

1. Prédiction de la structure des « protéines hautement précises » avec AlphaFold》

- Lien papier : https://www.nature.com/articles/s41586-021-03819-2

- Institution : DeepMind

- Nombre de citations : 8965

- Sujet : AlphaFold, une percée dans la prédiction de la structure des protéines à l'aide du Deep Learning

2, "Swin Transformer : Transformateur de vision hiérarchique utilisant des fenêtres décalées"

- Lien papier: https: // arxiv .org / abs / 2103.14030

- Institution: Microsoft

- Numéro cité: 4810

- Thème: une variante robuste des transformateurs pour la vision

3, "Apprendre des modèles visuels transférables à partir de la supervision du langage naturel" Sujet : CLIP, paires image-texte à grande échelle pour apprendre des représentations conjointes image-texte de manière auto-supervisée

- 4、《Sur les dangers des perroquets stochastiques : les modèles linguistiques peuvent-ils être trop grands ?》

-

- Lien papier : https://dl.acm.org/doi/10.1145/3442188.3445922

- Institution : U. Washington, Black in AI, The Aether

- Nombre de citations : 1266

- Sujet :Célèbre document de position très critique à l'égard de la tendance des modèles de langage toujours plus nombreux, soulignant leurs limites et leurs dangers

5、《Propriétés émergentes des transformateurs de vision auto-supervisés》

- Lien vers l'article : https ://arxiv.org/pdf/2104.14294.pdf

- Institution : Meta

- Citations : 1219

- Sujet : DINO, montrant comment l'auto-supervision sur les images a conduit à l'émergence d'une sorte de segmentation de proto-objets dans Transformers

Articles chauds en 2020

1, "Une image vaut 16x16 mots : Transformers pour la reconnaissance d'images à grande échelle"

- Lien papier : https://arxiv " Les modèles linguistiques sont des apprenants peu nombreux " Sujet : Cet article n'a pas besoin d'explications supplémentaires à ce stade.

- Institution : Academia Sinica, Taiwan

- Nombre de citations : 8014

- Sujet : La détection d'objets robuste et rapide se vend comme des petits pains.

4. "Explorer les limites de l'apprentissage par transfert avec un transformateur de texte en texte unifié》

- Lien papier : https://arxiv.org/abs/1910.10683

- Institution : Google

- Nombre de citations : 5906

- Sujet : Une étude rigoureuse de l'apprentissage par transfert avec Transformers, aboutissant au fameux T5

5、《Bootstrap your own latent : Une nouvelle approche de l'apprentissage auto-supervisé 》

- Lien article : https:// arxiv.org/abs/2006.07733 Institution : DeepMind, Imperial College

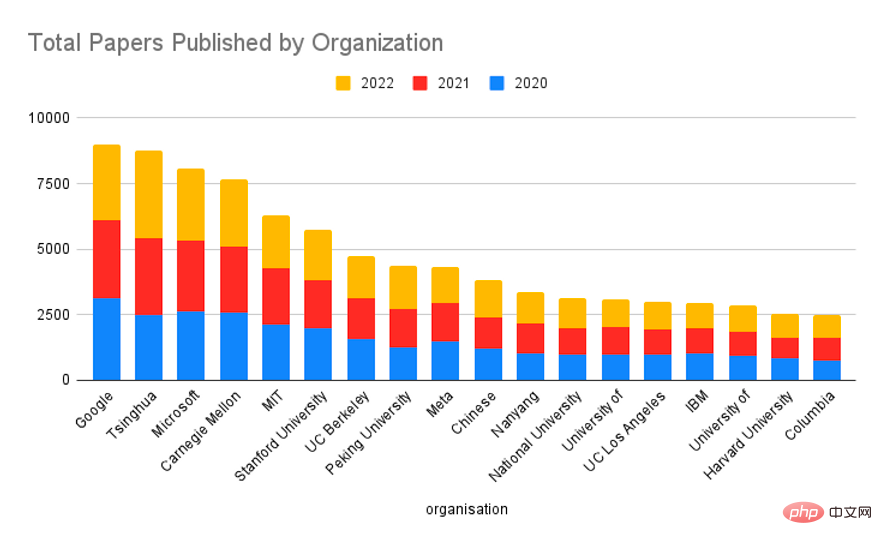

- Jetons un coup d'œil à la façon dont certaines des principales institutions se classent en termes de nombre d'articles dans le top 100 :

- Google a été l'acteur le plus fort, suivi de Meta, Microsoft, California Berkeley, DeepMind et Stanford

- . Bien que l'industrie soit désormais la force dominante dans la recherche en IA, un seul établissement universitaire n'aura pas un impact aussi important, mais la queue de ces établissements est beaucoup plus longue, donc lorsque nous regroupons par type d'organisation, un équilibre est atteint.

En termes de volume total de recherche, Google s'est classé premier au cours des trois dernières années, l'Université Tsinghua, l'Université Carnegie Mellon, le MIT, l'Université Stanford et d'autres universités se sont classées en tête, tandis que Microsoft s'est classée troisième. Dans l’ensemble, les établissements universitaires produisent plus de recherches que les entreprises technologiques du secteur, et les deux géants technologiques Google et Microsoft ont également publié un grand nombre d’études au cours des trois dernières années.

En fait, la force de recherche scientifique de Google a toujours été très forte. En 2017, Google a publié l'article « Attention Is All You Need », marquant l'avènement du transformateur. À ce jour, les transformateurs constituent toujours la base architecturale de la plupart des modèles NLP et CV, y compris ChatGPT.

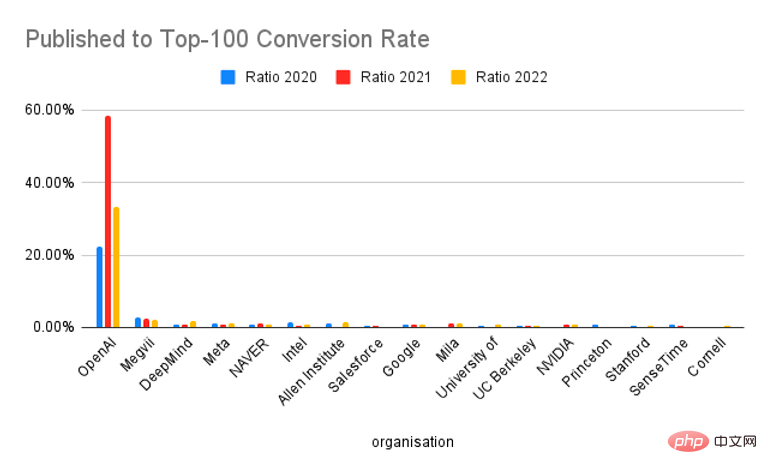

Le mois dernier, à l'occasion de la sortie de Bard, le PDG de Google, Sundar Pichai, a également déclaré dans une lettre ouverte : « Google AI et DeepMind promeuvent le développement de technologies de pointe. Notre projet de recherche Transformer et notre domaine 2017 Le document, ainsi que nos progrès importants dans les modèles de diffusion, sont à la base de nombreuses applications actuelles d'IA générative. Bien sûr, en tant que société à l'origine du nouveau top ChatGPT, le taux de conversion des résultats de recherche d'OpenAI au cours des trois dernières années (Conversion). Rate) a un avantage absolu. Ces dernières années, la plupart des résultats de recherche d’OpenAI ont attiré une grande attention, notamment dans le domaine des modèles linguistiques à grande échelle.

En 2020, OpenAI a publié GPT-3, un modèle de langage à grande échelle avec 175 milliards de paramètres, qui a dans une certaine mesure bouleversé les règles du jeu dans le domaine des modèles de langage car il a résolu de nombreux problèmes de modèles de langage à grande échelle. GPT-3 a déclenché un engouement pour les modèles linguistiques à grande échelle. Depuis plusieurs années, l'échelle des paramètres des modèles de langage a été continuellement brisée et les gens ont exploré davantage le potentiel des modèles de langage à grande échelle.

En 2020, OpenAI a publié GPT-3, un modèle de langage à grande échelle avec 175 milliards de paramètres, qui a dans une certaine mesure bouleversé les règles du jeu dans le domaine des modèles de langage car il a résolu de nombreux problèmes de modèles de langage à grande échelle. GPT-3 a déclenché un engouement pour les modèles linguistiques à grande échelle. Depuis plusieurs années, l'échelle des paramètres des modèles de langage a été continuellement brisée et les gens ont exploré davantage le potentiel des modèles de langage à grande échelle. Fin 2022, ChatGPT est sorti, qui a attiré une grande attention sur la génération de texte et les systèmes de dialogue IA. En particulier, ChatGPT a montré de très grandes capacités en matière de génération de contenu basé sur les connaissances et de génération de code. Après que Google et Microsoft ont successivement annoncé l'intégration de fonctions de type ChatGPT dans le moteur de recherche de nouvelle génération, ChatGPT est censé mener une nouvelle révolution dans l'AIGC et les outils intelligents.

Enfin, jetons un œil aux 100 articles les plus cités en 2022

Ajouté recommandations ici spéciales Nombre de mentions, qui est parfois considéré un premier indicateur d’impact. Mais jusqu’à présent, la corrélation semble faible. Des travaux supplémentaires sont nécessaires.

Ajouté recommandations ici spéciales Nombre de mentions, qui est parfois considéré un premier indicateur d’impact. Mais jusqu’à présent, la corrélation semble faible. Des travaux supplémentaires sont nécessaires.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI

En 2020, OpenAI a publié GPT-3, un modèle de langage à grande échelle avec 175 milliards de paramètres, qui a dans une certaine mesure bouleversé les règles du jeu dans le domaine des modèles de langage car il a résolu de nombreux problèmes de modèles de langage à grande échelle. GPT-3 a déclenché un engouement pour les modèles linguistiques à grande échelle. Depuis plusieurs années, l'échelle des paramètres des modèles de langage a été continuellement brisée et les gens ont exploré davantage le potentiel des modèles de langage à grande échelle.

En 2020, OpenAI a publié GPT-3, un modèle de langage à grande échelle avec 175 milliards de paramètres, qui a dans une certaine mesure bouleversé les règles du jeu dans le domaine des modèles de langage car il a résolu de nombreux problèmes de modèles de langage à grande échelle. GPT-3 a déclenché un engouement pour les modèles linguistiques à grande échelle. Depuis plusieurs années, l'échelle des paramètres des modèles de langage a été continuellement brisée et les gens ont exploré davantage le potentiel des modèles de langage à grande échelle.

Ajouté recommandations ici spéciales Nombre de mentions, qui est parfois considéré un premier indicateur d’impact. Mais jusqu’à présent, la corrélation semble faible. Des travaux supplémentaires sont nécessaires.

Ajouté recommandations ici spéciales Nombre de mentions, qui est parfois considéré un premier indicateur d’impact. Mais jusqu’à présent, la corrélation semble faible. Des travaux supplémentaires sont nécessaires.