Maison >Périphériques technologiques >IA >Un article traitant des trois éléments fondamentaux de la conduite autonome

Un article traitant des trois éléments fondamentaux de la conduite autonome

- 王林avant

- 2023-04-12 20:19:061357parcourir

Capteurs : différents positionnements et fonctions, avantages complémentaires

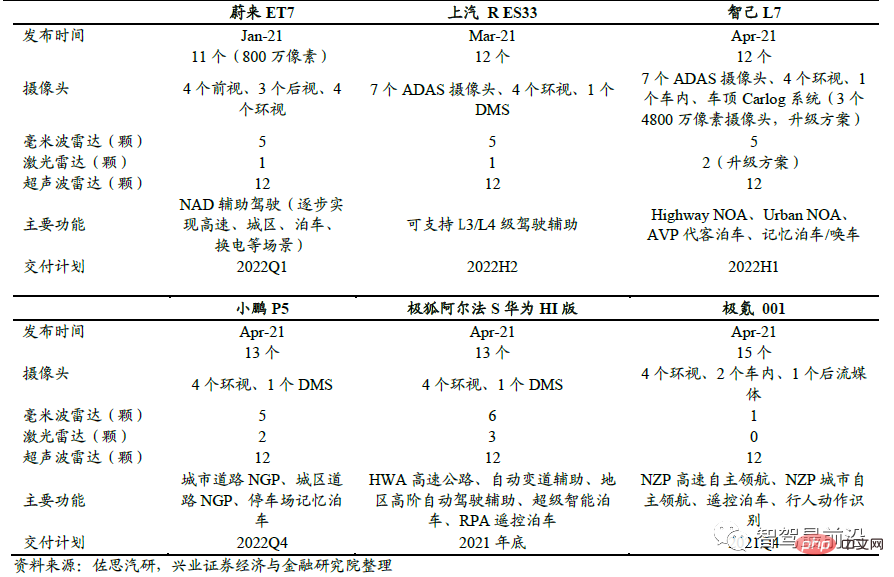

Les véhicules autonomes sont souvent équipés de divers capteurs, notamment des caméras, un radar à ondes millimétriques et un lidar. Ces capteurs ont chacun des fonctions et des positionnements différents, et se complètent mutuellement, devenant ainsi les yeux des véhicules autonomes. Les nouvelles voitures après 2021 seront équipées d'un grand nombre de capteurs afin de réserver du matériel redondant pour mettre en œuvre des fonctions de conduite plus autonomes via OTA.

Configuration du capteur et fonctions de base des modèles nouvellement lancés en Chine de janvier à mai 2021

Fonction de la caméra : principalement utilisée pour les lignes de voie, les panneaux de signalisation, les feux de circulation, comme ainsi que les véhicules et les piétons. La détection présente les caractéristiques d'informations de détection complètes et d'un prix bas, mais elle sera affectée par la pluie, la neige, les conditions météorologiques et la lumière. Les caméras modernes sont composées d'objectifs, de modules d'objectif, de filtres, de pièces CMOS/CCD, ISP et de transmission de données. La lumière est focalisée sur le capteur après avoir traversé la lentille optique et le filtre. Le signal optique est converti en signal électrique via un circuit intégré CMOS ou CCD, puis converti en une image numérique standard au format RAW, RVB ou YUV par le capteur. processeur d'image (ISP). Le signal est transmis à l'ordinateur via l'interface de transmission de données. Les caméras peuvent fournir une multitude d’informations. Cependant, la caméra s'appuie sur des sources de lumière naturelle. La plage dynamique actuelle du capteur visuel n'est pas particulièrement large. Lorsque la lumière est insuffisante ou que la lumière change radicalement, l'image visuelle peut être temporairement perdue et la fonction sera sévèrement limitée. conditions de pluie et de pollution. Dans l’industrie, la vision par ordinateur est généralement utilisée pour pallier diverses lacunes des caméras.

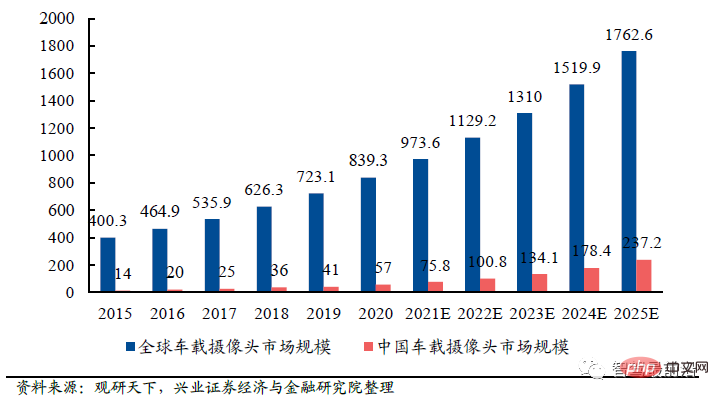

Les caméras automobiles sont un marché à forte croissance. L'utilisation de caméras embarquées augmente avec la mise à niveau continue des fonctions de conduite autonome. Par exemple, 1 à 3 caméras sont généralement nécessaires pour la vue vers l'avant et 4 à 8 caméras pour la vue panoramique. On s'attend à ce que le marché mondial des caméras automobiles atteigne 176,26 milliards de yuans d'ici 2025, dont 23,72 milliards de yuans pour le marché chinois.

Taille du marché mondial et chinois des caméras automobiles de 2015 à 2025 (milliards de yuans)

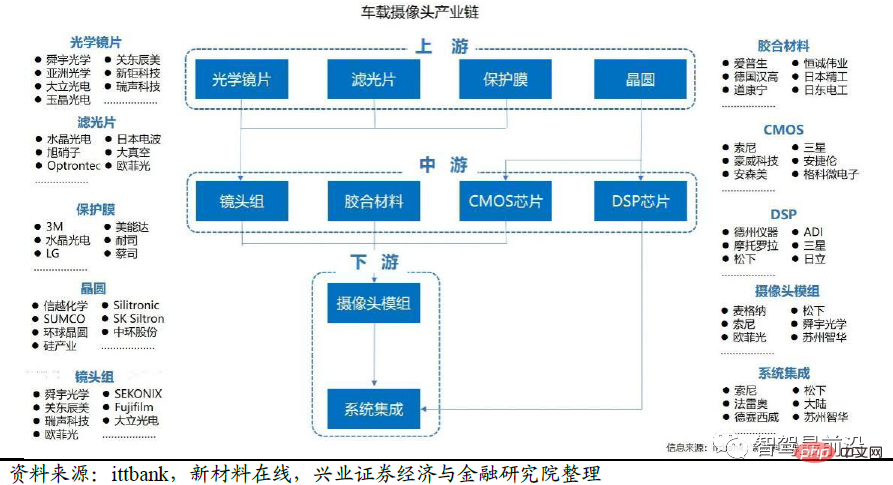

La chaîne industrielle de l'industrie des caméras automobiles comprend des fournisseurs d'ensembles d'objectifs en amont, des fournisseurs de matériaux de colle, des fournisseurs de capteurs d'images , les fournisseurs de puces des FAI, ainsi que les fournisseurs de modules intermédiaires et les intégrateurs de systèmes, les entreprises d'électronique grand public en aval, la conduite autonome de niveau 1, etc. En termes de valeur, le capteur d'image (CMOS Image Sensor) représente 50 % du coût total, suivi par l'emballage des modules, qui représente 25 %, et les lentilles optiques, qui représentent 14 %.

Chaîne de l'industrie de l'appareil photo

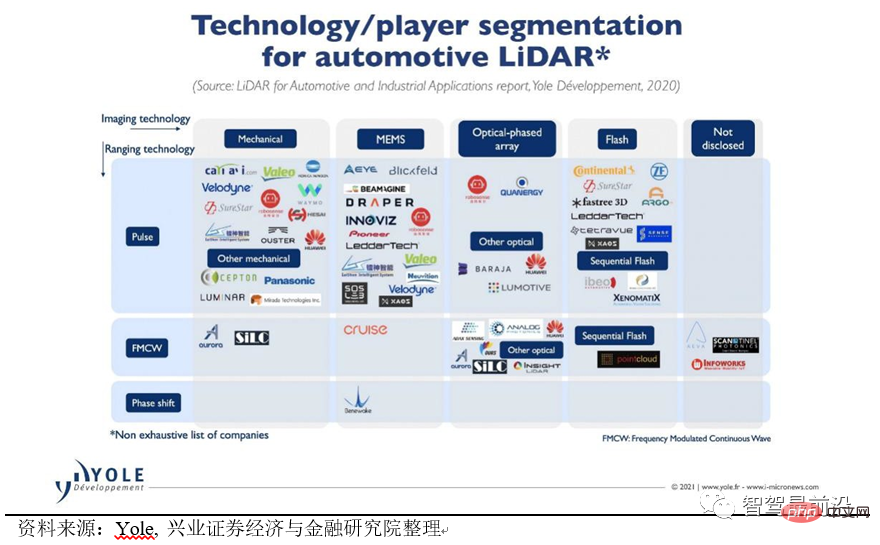

Le rôle du lidar (Lidar) : principalement utilisé pour détecter la distance et la vitesse des objets environnants. À l'extrémité émettrice du lidar, un faisceau laser à haute énergie est généré par un semi-conducteur laser. Une fois que le laser entre en collision avec les cibles environnantes, il est réfléchi. L'extrémité réceptrice du lidar capture et effectue des calculs pour obtenir la distance et. vitesse de la cible. Le Lidar a une précision de détection supérieure à celle des ondes millimétriques et des caméras, et peut détecter de longues distances, atteignant souvent plus de 200 mètres. Le LiDAR est divisé en miroir mécanique rotatif, MEMS et LiDAR à semi-conducteurs selon son principe de balayage. Selon le principe de télémétrie, il peut être divisé en télémétrie à temps de vol (ToF) et onde continue modulée en fréquence (FMCW). L'industrie est actuellement au stade exploratoire de l'application du lidar, et il n'y a pas encore d'orientation claire, et on ne sait pas quelle voie technique deviendra la principale à l'avenir.

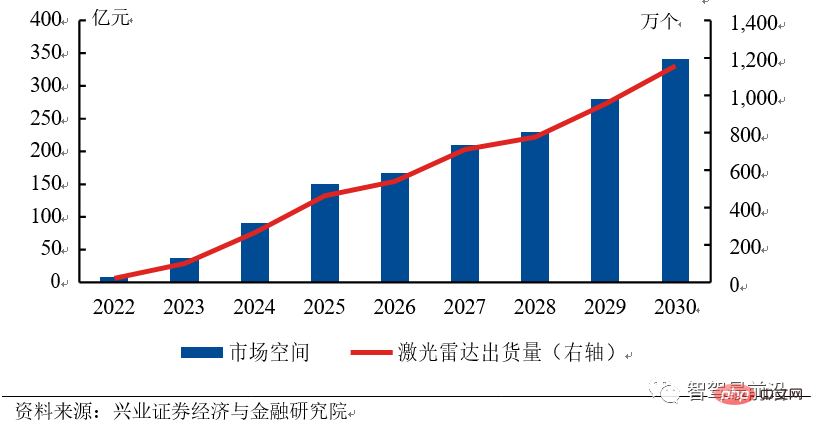

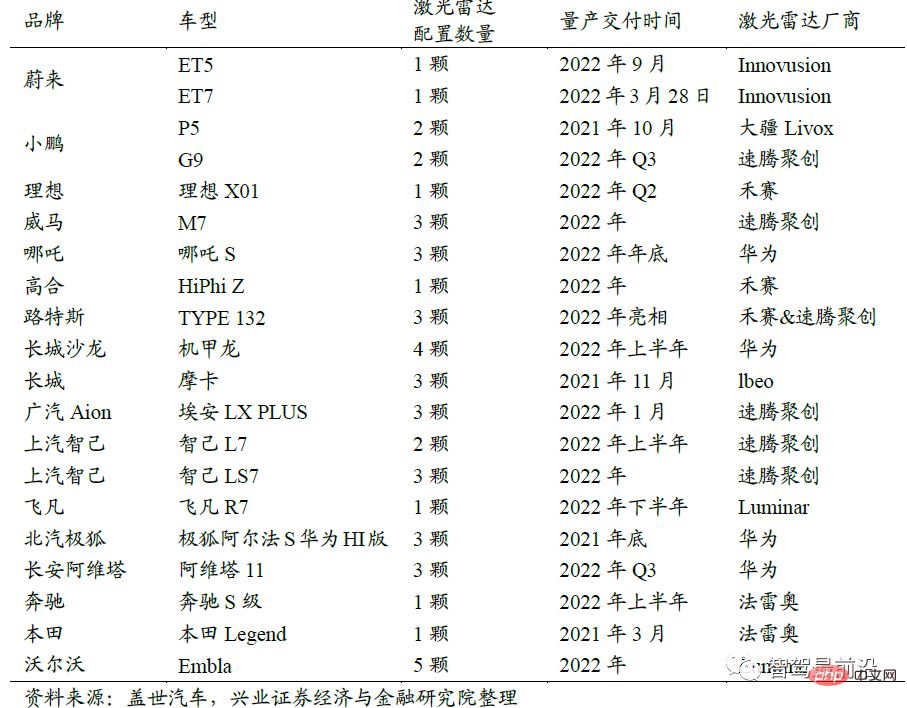

Le marché des radars laser est vaste et les entreprises chinoises seront en tête des États-Unis. Le marché du lidar a de larges perspectives. Nous prévoyons que d'ici 2025, le marché chinois du lidar atteindra près de 15 milliards de yuans et que le marché mondial avoisinera les 30 milliards de yuans ; de yuans, et le marché mondial sera proche de 65 milliards de yuans. Le taux de croissance annuel du marché a atteint 48,3 %. Tesla, la plus grande entreprise de conduite autonome aux États-Unis, adopte une solution de vision pure. D'autres constructeurs automobiles n'ont pas de plans spécifiques pour installer le lidar sur les voitures. La Chine est donc devenue le plus grand marché potentiel pour le lidar automobile. En 2022, un grand nombre de constructeurs automobiles nationaux lanceront des produits équipés de lidar, et on s'attend à ce que les livraisons de produits lidar automobiles atteignent 200 000 unités en 2022. Les entreprises chinoises ont une plus grande probabilité de gagner car elles sont plus proches du marché, ont un degré élevé de coopération avec les équipementiers chinois et peuvent plus facilement obtenir des commandes sur le marché, ce qui leur permet de réduire leurs coûts plus rapidement, formant ainsi un cercle vertueux. Le vaste marché chinois aidera les entreprises chinoises de lidar à combler le fossé technologique avec les entreprises étrangères.

Perspectives du marché chinois du Lidar de 2022 à 2030

Liste des modèles Lidar

E Chaque étape actuelle Chaque voie technique présente ses propres avantages et inconvénients. Le nôtre On estime qu'à l'avenir, la technologie FMCW coexistera avec la technologie TOF, les émetteurs laser 1550 nm seront meilleurs que 905 nm et le marché pourrait sauter l'état semi-solide et passer directement à l'étape tout solide.

La technologie FMCW coexiste avec la technologie TOF : la technologie TOF est relativement mature et présente les avantages d'une vitesse de réponse rapide et d'une précision de détection élevée, mais elle ne peut pas mesurer directement la vitesse grâce au principe Doppler et a une sensibilité élevée ( supérieur à ToF plus de 10 fois), forte capacité anti-interférence, détection longue distance et faible consommation d'énergie. À l’avenir, les produits haut de gamme pourraient utiliser FMCW et les produits bas de gamme utiliser TOF.

1550 nm est meilleur que 905 nm : 905 nm est un laser proche infrarouge qui est facilement absorbé par la rétine humaine et provoque des dommages rétiniens, de sorte que la solution 905 nm ne peut être maintenue qu'à faible puissance. Le principe du laser 1550 nm est celui du spectre visible. Dans les mêmes conditions de puissance, le laser provoque moins de dommages à l'œil humain et a une plage de détection plus longue. Cependant, l'inconvénient est qu'il nécessite du InGaAs comme générateur et ne peut pas utiliser de détecteurs à base de silicium.

Sautez l'état semi-solide et passez directement à l'état solide : les solutions semi-solides existantes, type miroir rotatif, type angulaire et MEMS, ont toutes un petit nombre de composants mécaniques, ont un service court vie dans l'environnement du véhicule et sont difficiles à passer la certification réglementaire des véhicules. La solution VCSEL+SPAD pour le lidar à semi-conducteurs adopte une technologie au niveau de la puce, a une structure simple et peut facilement respecter les réglementations sur les véhicules. Elle est actuellement devenue la solution technique la plus courante pour le lidar à semi-conducteurs pur. Le lidar derrière l'iPhone12 pro utilise la solution VCSEL + SPAD.

La feuille de route technique de Lidar et les sociétés représentatives

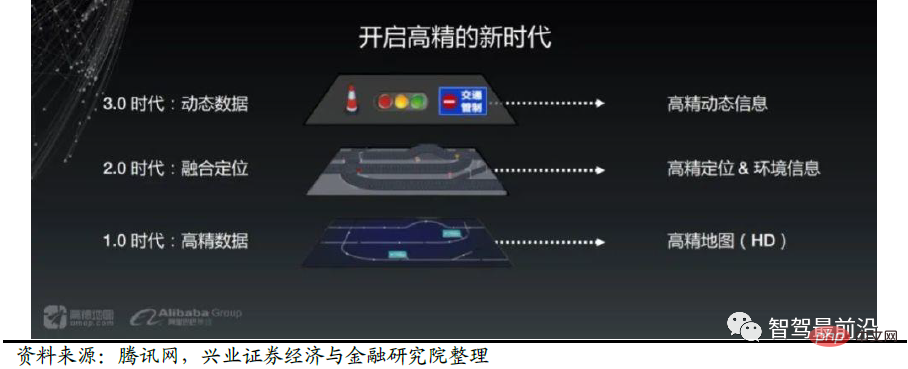

Les cartes HD peuvent être renversées. La bataille pour les itinéraires se poursuit dans le domaine des cartes avancées. Tesla a proposé une carte de haute précision qui ne nécessite pas de cartographie avancée. Sur la base des données collectées par les caméras, la technologie de l'intelligence artificielle est utilisée pour construire un espace tridimensionnel de l'environnement. Il adopte une réflexion participative et est composé de chaque véhicule qui fournit des informations routières et est unifié et agrégé dans le cloud. Nous devons donc être attentifs à la subversion des cartes de haute précision provoquée par l’innovation technologique.

Certains praticiens pensent que les cartes de haute précision sont indispensables pour une conduite intelligente, du point de vue du champ de vision, les cartes de haute précision ne sont pas bloquées et ne présentent pas de défauts de distance et de vision dans des conditions météorologiques particulières, de haute précision. les cartes peuvent toujours jouer un rôle. Effet : du point de vue des erreurs, les cartes de haute précision peuvent éliminer efficacement certaines erreurs de capteurs et peuvent compléter et corriger efficacement les systèmes de capteurs existants dans certaines conditions routières. En outre, les cartes de haute précision peuvent également créer une base de données sur l'expérience de conduite, analyser les zones dangereuses grâce à l'exploration de données spatio-temporelles multidimensionnelles et fournir aux conducteurs de nouveaux ensembles de données sur l'expérience de conduite.

Lidar + technologie de vision, véhicule de collecte + modèle de crowdsourcing sont les solutions principales pour les cartes de haute précision à l'avenir.

Les cartes HD doivent équilibrer précision et vitesse. Une précision de collecte trop faible et une fréquence de mise à jour trop faible ne peuvent pas répondre aux besoins de la conduite autonome en matière de cartes de haute précision. Afin de résoudre ce problème, les sociétés de cartes de haute précision ont adopté de nouvelles méthodes, telles que le modèle de crowdsourcing. Chaque voiture autonome sert de dispositif de collecte de cartes de haute précision pour fournir des informations dynamiques de haute précision, qui sont agrégées et collectées. distribué à d'autres voitures pour utilisation. Dans le cadre de ce modèle, les principales sociétés de cartes de haute précision peuvent collecter des cartes de haute précision plus précises et plus rapides grâce au grand nombre de modèles de voitures pouvant participer au crowdsourcing, maintenant ainsi une situation où les forts sont toujours forts.

Solution de fusion AMAP

Plateforme informatique : les exigences en matière de puces augmentent constamment et la technologie des semi-conducteurs est le fossé

La plate-forme informatique est également appelée domaine de conduite autonome contrôleur. À mesure que le taux de pénétration de la conduite autonome au-dessus de L3 augmente, les besoins en puissance de calcul augmentent également. Bien que les réglementations et algorithmes actuels de L3 n'aient pas encore été introduits, les constructeurs automobiles ont adopté des solutions de redondance de la puissance de calcul pour réserver de l'espace pour les itérations logicielles ultérieures.

La plateforme informatique aura deux caractéristiques de développement à l'avenir : l'hétérogénéité et l'élasticité distribuée.

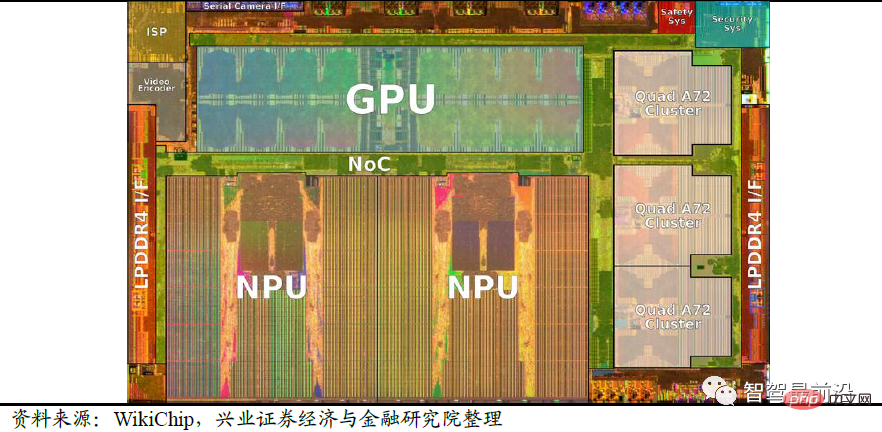

Hétérogène : pour les véhicules autonomes haut de gamme, la plate-forme informatique doit être compatible avec plusieurs types de capteurs de données et offrir une sécurité et des performances élevées. La puce unique existante ne peut pas répondre à de nombreuses exigences en matière d'interface et de puissance de calcul, et une solution matérielle à puce hétérogène est nécessaire. L'hétérogénéité peut se refléter dans une seule carte intégrant plusieurs puces d'architecture, telles que le MCU (microcontrôleur) intégré Audi zFAS, le FPGA (matrice de portes programmable), le CPU (unité centrale de traitement), etc. ; elle peut également se refléter dans une puce unique puissante ; (SoC, système sur puce) intègre plusieurs unités architecturales en même temps, telles que le GPU (processeur graphique) intégré NVIDIA Xavier et le CPU, deux unités hétérogènes.

Flexibilité de distribution : L'architecture électronique automobile actuelle est constituée de nombreuses puces monofonctions progressivement intégrées dans des contrôleurs de domaine. La conduite autonome haut de gamme nécessite des plates-formes informatiques intelligentes embarquées pour disposer d'une redondance du système et d'une expansion fluide. D'une part, en tenant compte de l'architecture hétérogène et de la redondance du système, plusieurs cartes sont utilisées pour réaliser le découplage et la sauvegarde du système, d'autre part, une extension distribuée multi-cartes est utilisée pour répondre aux exigences de puissance de calcul et d'interface du haut de gamme ; conduite autonome. Sous la gestion et l'adaptation unifiées du même système d'exploitation de conduite autonome, le système global implémente de manière collaborative les fonctions de conduite autonome et adapte différentes puces en changeant les pilotes matériels, les services de communication, etc. À mesure que le niveau de conduite autonome augmente, la demande du système en puissance de calcul, en interfaces, etc. augmentera de jour en jour. En plus d'augmenter la puissance de calcul d'une seule puce, les composants matériels peuvent également être empilés à plusieurs reprises pour obtenir un ajustement flexible et une expansion fluide des composants matériels, améliorant ainsi la puissance de calcul de l'ensemble du système, augmentant les interfaces et améliorant les fonctions.

L'architecture matérielle distribuée hétérogène se compose principalement de trois parties : l'unité d'IA, l'unité de calcul et l'unité de contrôle.

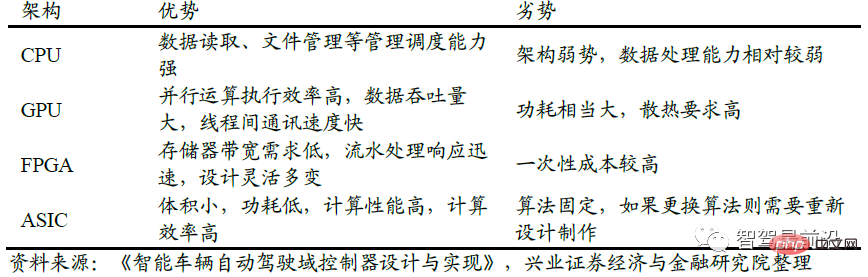

Unité IA : adopte une puce AI à architecture informatique parallèle et utilise un processeur multicœur pour configurer la puce AI et les processeurs nécessaires. Actuellement, les puces d'IA sont principalement utilisées pour la fusion et le traitement efficaces de données multi-capteurs, et produisent des informations clés pour l'exécution de la couche d'exécution. L'unité d'IA est la partie la plus exigeante de l'architecture hétérogène et doit surmonter les goulots d'étranglement en matière de coût, de consommation d'énergie et de performances pour répondre aux exigences d'industrialisation. Les puces IA peuvent choisir GPU, FPGA, ASIC (circuit intégré spécifique à une application), etc.

Comparaison des différents types de puces

Unité de calcul : L'unité de calcul est composée de plusieurs processeurs. Il présente les caractéristiques d'une fréquence monocœur élevée et d'une forte puissance de calcul, et répond aux exigences de sécurité fonctionnelle correspondantes. Loading Hypervisor, le système de gestion du noyau Linux, gère les ressources logicielles, effectue la planification des tâches et est utilisé pour exécuter la plupart des algorithmes de base liés à la conduite autonome et intégrer des données multidimensionnelles pour réaliser la planification des itinéraires et le contrôle de la prise de décision.

Unité de contrôle : principalement basée sur le contrôleur de véhicule traditionnel (MCU). L'unité de commande charge le logiciel de base de la plate-forme ClassicAUTOSAR et le MCU est connecté à l'ECU via l'interface de communication pour obtenir un contrôle horizontal et longitudinal de la dynamique du véhicule et répondre aux exigences de sécurité fonctionnelle ASIL-D.

Prenons l'exemple de la puce Tesla FSD. La puce FSD utilise une architecture CPU+GPU+ASIC. Contient 3 clusters Cortex-A72 quadricœurs pour un total de 12 processeurs fonctionnant à 2,2 GHz ; un GPU Mali G71 MP12 fonctionnant à 1 GHz, 2 unités de traitement neuronal (NPU) et divers autres accélérateurs matériels. Il existe une division claire du travail entre les trois types de capteurs : le processeur central Cortex-A72 est utilisé pour le traitement informatique général, le GPU central Mali est utilisé pour le post-traitement léger et le NPU est utilisé pour les calculs de réseau neuronal. La puissance de calcul du GPU atteint 600GFLOPS et celle du NPU atteint 73,73Tops.

Architecture de la puce Tesla FSD

La technologie de base du contrôleur de domaine de conduite autonome est la puce, suivie du logiciel et du système d'exploitation. Le fossé à court terme concerne les clients et la livraison. capacités.

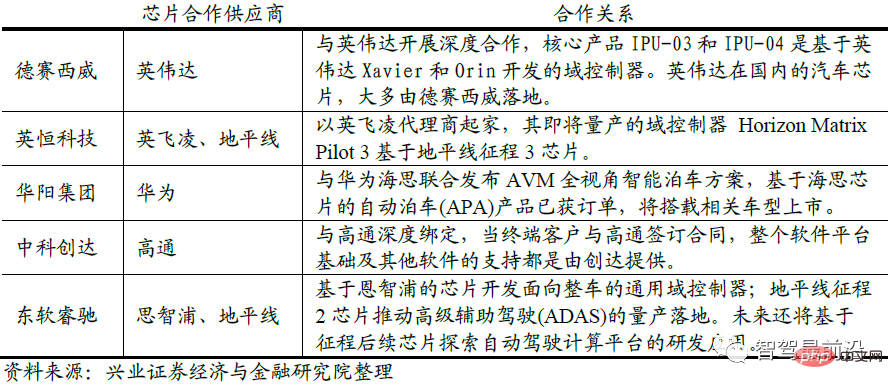

La puce détermine la puissance de calcul de la plate-forme informatique de conduite autonome. Elle est difficile à concevoir et à fabriquer et peut facilement devenir un lien bloqué. Le marché haut de gamme est dominé par les géants internationaux des semi-conducteurs NVIDIA, Mobileye, Texas Instruments, NXP, etc. Sur les marchés L2 et inférieurs, les entreprises nationales représentées par Horizon gagnent progressivement en reconnaissance auprès des clients. Les fabricants chinois de contrôleurs de domaine coopèrent généralement en profondeur avec un fabricant de puces pour acheter des puces et les livrer à l'OEM avec leurs propres capacités de fabrication de matériel et d'intégration de logiciels. La coopération avec les fabricants de puces est généralement exclusive. Du point de vue de la coopération en matière de puces, Desay SV présente les avantages les plus évidents en s'associant à Nvidia et Thunderstar à Qualcomm. Huayang Group, une autre société nationale de contrôleurs de domaine de conduite autonome, s'est associée à Huawei HiSilicon et Neusoft Reach pour établir des relations de coopération avec NXP et Horizon.

La relation de coopération entre les sociétés nationales de contrôleurs de domaine et les sociétés de puces

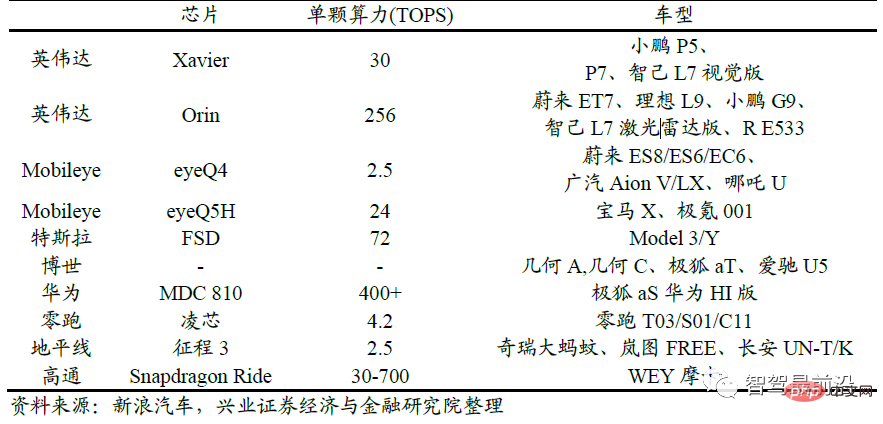

La compétitivité des contrôleurs de domaine est déterminée par les sociétés coopératives de puces en amont, et les OEM en aval achètent souvent des puces. ensemble de solutions proposées par l'entreprise. Par exemple, les modèles haut de gamme de Weilai, Ideal et Xpeng achètent des puces NVIDIA Orin et des logiciels de conduite autonome NVIDIA ; Jikrypton et BMW achètent des solutions auprès de la société de puces Mobileye et Great Wall achètent la solution L2 d'Horizon. Nous devons continuer à prêter attention à la coopération entre les sociétés de puces et de contrôleurs de domaine.

Coopération entre les produits des fabricants de puces et les constructeurs automobiles

3 Données et algorithmes : les données aident à itérer les algorithmes, et la qualité des algorithmes est au cœur de la compétitivité des entreprises de conduite autonome

. Les données des utilisateurs sont extrêmement importantes pour transformer les systèmes de conduite autonome. Dans le processus de conduite autonome, il existe un scénario rare et peu probable. Ce type de scénario est appelé cas de coin. Si le système de détection rencontre un coin, cela entraînera de graves risques pour la sécurité. Par exemple, ce qui s'est passé ces dernières années, c'est que le pilote automatique de Tesla n'a pas reconnu un gros camion blanc qui traversait et l'a heurté sur le côté, provoquant la mort du propriétaire. En avril 2022, Xiaopeng s'est écrasé et s'est renversé en tournant ; conduite autonome. Véhicules au milieu de la route.

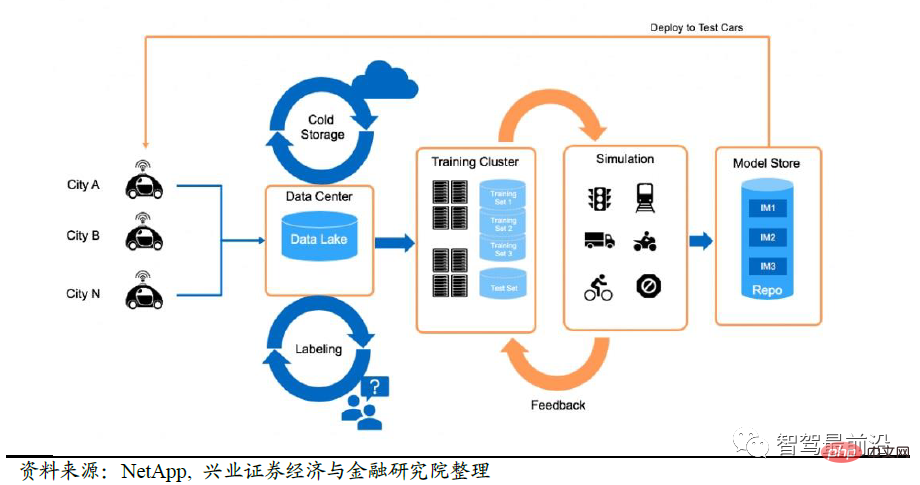

Il n'y a qu'une seule solution à ce genre de problème, qui est que les constructeurs automobiles prennent l'initiative de collecter des données réelles, et en même temps simulent davantage d'environnements similaires sur la plate-forme informatique de conduite autonome, afin que le système puisse apprenez à mieux le gérer la prochaine fois. Un exemple typique est le mode Shadow de Tesla : identifier les cas potentiels en les comparant au comportement du conducteur humain. Ces scènes sont ensuite annotées et ajoutées à l’ensemble de formation.

En conséquence, les constructeurs automobiles doivent établir un processus de traitement des données afin que les données réelles collectées puissent être utilisées pour l'itération du modèle et que le modèle itéré puisse être installé sur de vrais véhicules de production. Dans le même temps, afin de permettre à la machine d'apprendre les cas de coin à grande échelle, après l'obtention d'un cas de coin, une simulation à grande échelle sera effectuée sur les problèmes rencontrés dans ce cas de coin afin d'en dériver davantage de cas de coin pour l'apprentissage du système. Nvidia DriveSim, une plateforme de simulation développée par NVIDIA utilisant la technologie Metaverse, est l'un des systèmes de simulation. Les entreprises leaders en matière de données construisent des fossés de données.

Les procédures courantes de traitement des données sont :

1) Déterminez si le véhicule autonome rencontre un cas de coin et téléchargez-le

2) Annotez les données téléchargées

3) Utilisez un logiciel de simulation pour simuler et créer des données d'entraînement supplémentaires

4) Mettre à jour de manière itérative le modèle de réseau neuronal avec des données

5) Déployer le modèle sur des véhicules réels via OTA

Processus de traitement des données

Derrière les données, la boucle fermée repose sur une énorme puissance de calcul Selon D'après le discours de NVIDIA au CES 2022, les entreprises qui investissent dans des systèmes de conduite assistée L2 n'ont besoin que de 1 à 2 000 GPU, tandis que les entreprises développant des systèmes de conduite autonomes complets L4 ont besoin de 25 000 GPU pour construire des centres de données.

1. Tesla dispose actuellement de 3 grands centres de calcul avec un total de 11 544 GPU : le centre de calcul de marquage automatique dispose de 1 752 GPU A100, et les deux autres centres de calcul utilisés pour la formation disposent respectivement de 4 032 et 5 760 GPU A100 en 2021 ; Le système de superordinateur DOJO auto-développé et publié par AI DAY dispose de 3 000 puces D1 et d'une puissance de calcul allant jusqu'à 1,1EFLOPS.

2. Le projet Shanghai Supercomputing Center en construction par SenseTime prévoit 20 000+A100 GPU Une fois terminé, la puissance de calcul maximale atteindra 3,65EFLPOS (BF16/CFP8).

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI