Maison >Périphériques technologiques >IA >Le modèle LLaMA a été divulgué, et la version Meta de ChatGPT a été forcée d'être « open source » ! GitHub gagne 8 000 étoiles et un grand nombre de critiques sont publiées

Le modèle LLaMA a été divulgué, et la version Meta de ChatGPT a été forcée d'être « open source » ! GitHub gagne 8 000 étoiles et un grand nombre de critiques sont publiées

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-12 17:49:031491parcourir

La bataille pour ChatGPT devient de plus en plus intense.

Il y a quelques semaines, Meta a publié son propre modèle de langage à grande échelle LLaMA, avec des paramètres allant de 7 milliards à 65 milliards.

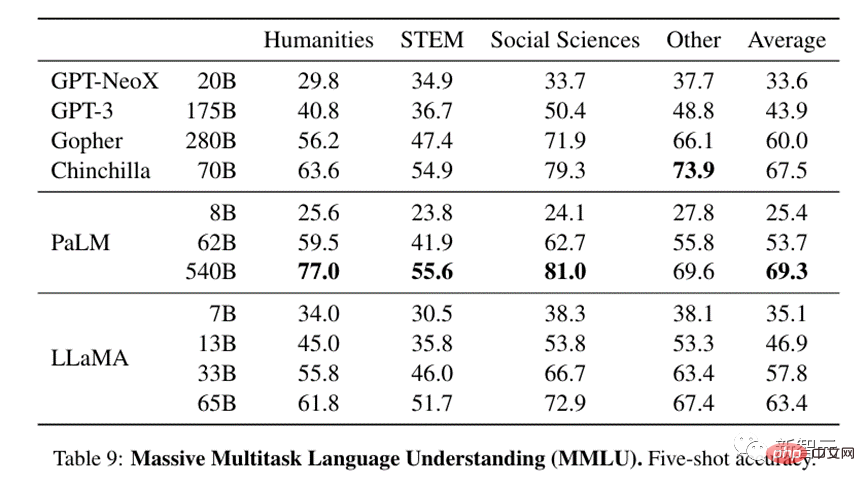

Dans le journal, LLaMA (13 milliards) avec seulement 1/10 de paramètres a dépassé GPT-3 sur la plupart des benchmarks.

Pour LLaMA avec 65 milliards de paramètres, il est comparable au Chinchilla de DeepMind (70 milliards de paramètres) et au PaLM de Google (540 milliards de paramètres).

Bien que Meta affirme que LLaMA est open source, les chercheurs doivent encore l'appliquer et l'examiner.

Cependant, ce à quoi je ne m'attendais pas, c'est que quelques jours seulement après sa sortie, les fichiers modèles de LLaMA aient été divulgués à l'avance.

Alors, la question est : est-ce intentionnel ou accidentel

LLaMA était « open source » ?

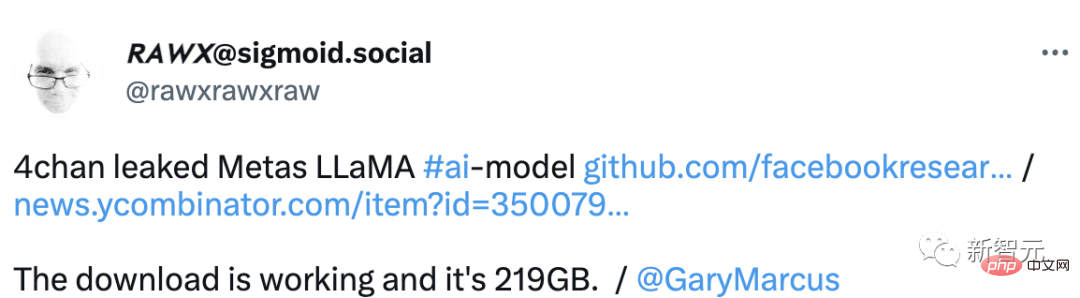

Récemment, la bibliothèque de produits finis de LLaMA a été divulguée sur le forum étranger 4chan.

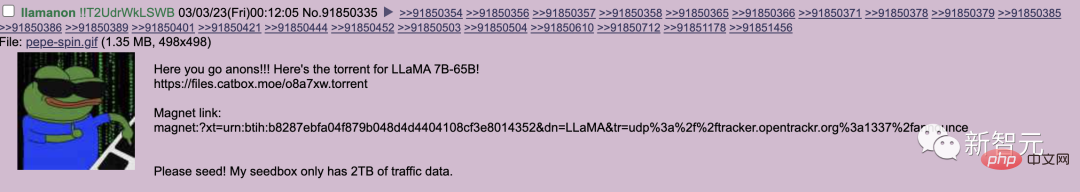

Jeudi dernier, l'utilisateur llamanon a posté sur le forum technique 4chan pour publier les modèles 7B et 65B LLaMA via torrent.

Ce lien de départ est actuellement fusionné dans la page GitHub de LLaMA.

Il a également soumis une deuxième pull request au projet qui a fourni un lien de départ vers un autre ensemble de poids pour le modèle.

Actuellement, le projet a reçu 8 000 étoiles sur GitHub.

Cependant, l'une des plus grandes erreurs commises par les fuyards est d'inclure leur code d'identification unique dans le modèle divulgué.

Ce code est spécialement conçu pour traquer les fuites, mettant ainsi en danger les informations personnelles de l'utilisateur Llamanon.

Comme le dit le proverbe, l'open source de LLaMA n'est pas très décent, mais les internautes l'aident à être décent.

De plus, les utilisateurs de 4chan ont créé une ressource pratique pour ceux qui cherchent à déployer le modèle sur leurs propres postes de travail.

et fournit un guide d'un didacticiel de distribution sur la façon d'obtenir un modèle et d'y ajouter des poids modifiés pour une inférence plus efficace.

De plus, cette ressource propose même un moyen d'intégrer LLaMA dans la plateforme d'écriture en ligne KoboldAI.

Que Meta ait fait cela intentionnellement ou accidentellement, l'a divulgué. Les internautes ont exprimé leurs opinions les uns après les autres.

Un internaute a fait une analyse claire : "Peut-être que cela a été divulgué intentionnellement par Meta pour lutter contre OpenAI."

Certains clients pensent qu'il s'agit d'un meilleur modèle et il touche directement au cœur de leur plan commercial consistant à vendre l'accès pour 250 000 $ par an. Un mois d'accès à leur service permet d'acheter une machine capable d'exécuter ce modèle divulgué. Meta sape un concurrent potentiel parvenu pour maintenir la stabilité du grand cartel technologique actuel. C’est peut-être un peu une théorie du complot, mais nous vivons à l’ère de la grande technologie et des grandes conspirations.

Lundi, Meta a déclaré qu'elle continuerait à fournir ses outils d'intelligence artificielle aux chercheurs accrédités, même si LLaMA a été divulguée à des utilisateurs non autorisés.

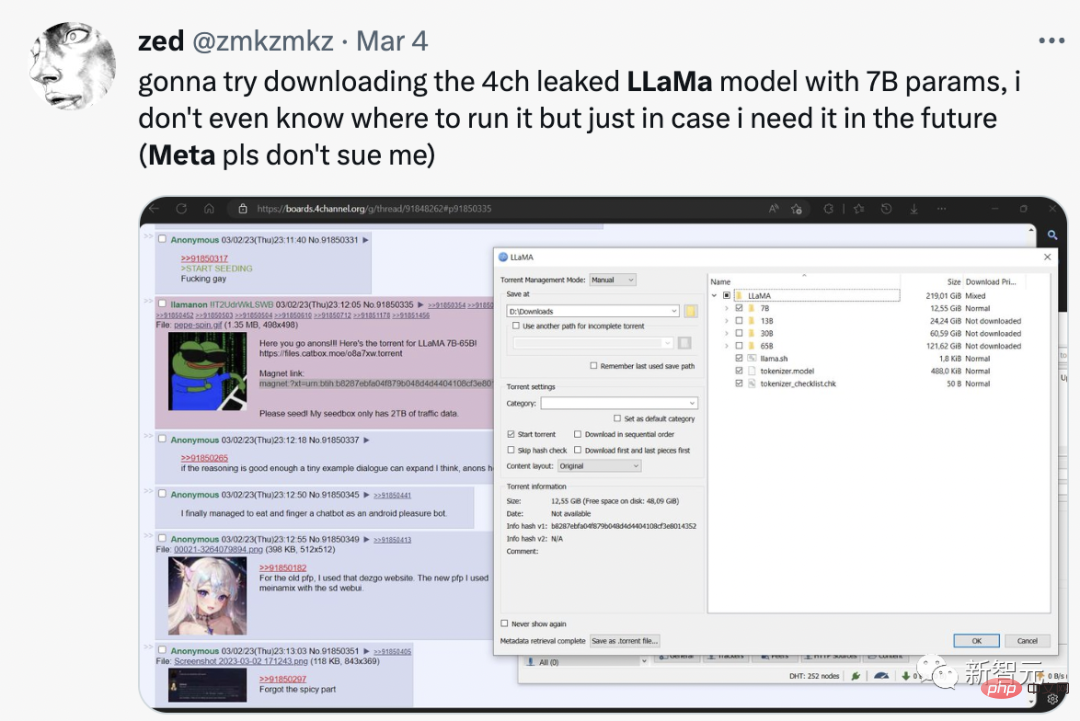

Certains internautes ont directement déclaré avoir téléchargé LLaMA avec 7 milliards de paramètres. Bien qu'ils ne sachent pas comment l'exécuter, ils peuvent l'obtenir au cas où ils en auraient besoin à l'avenir.

La fuite et l'open source de LLaMA est un grand événement :

Stable Diffusion est open source. Huit mois plus tard, nous pouvons désormais lire dans les pensées des autres et décoder tout ce qu’ils voient.

Avec l'ouverture des LLM on va avoir des trucs vraiment fous.

Évaluation préliminaire du modèle

Peu de temps après la sortie de LLaMA, les internautes ont découvert que ce modèle avec les paramètres les plus petits nécessite également près de 30 Go de GPU pour fonctionner.

Cependant, grâce à l'optimisation en virgule flottante via les bibliothèques Bits et Bytes, ils ont pu faire fonctionner le modèle sur un seul NVIDIA RTX 3060.

De plus, un chercheur sur GitHub a même pu déduire quelques mots par seconde en exécutant la version 7B de LLM sur un processeur Ryzen 7900X.

Alors c'est quoi exactement le modèle LLaMA ? Des étrangers l'ont examiné.

LLaMA a bien performé dans de nombreux tests.

En termes de compréhension du langage multitâche à grande échelle, même le modèle 13B, relativement petit, est à égalité avec GPT-3, qui est 13 fois plus grand.

La version 33B est de loin supérieure au GPT-3, et la version 65B peut rivaliser avec le modèle LLM existant le plus puissant, le paramètre PaLM 540B de Google.

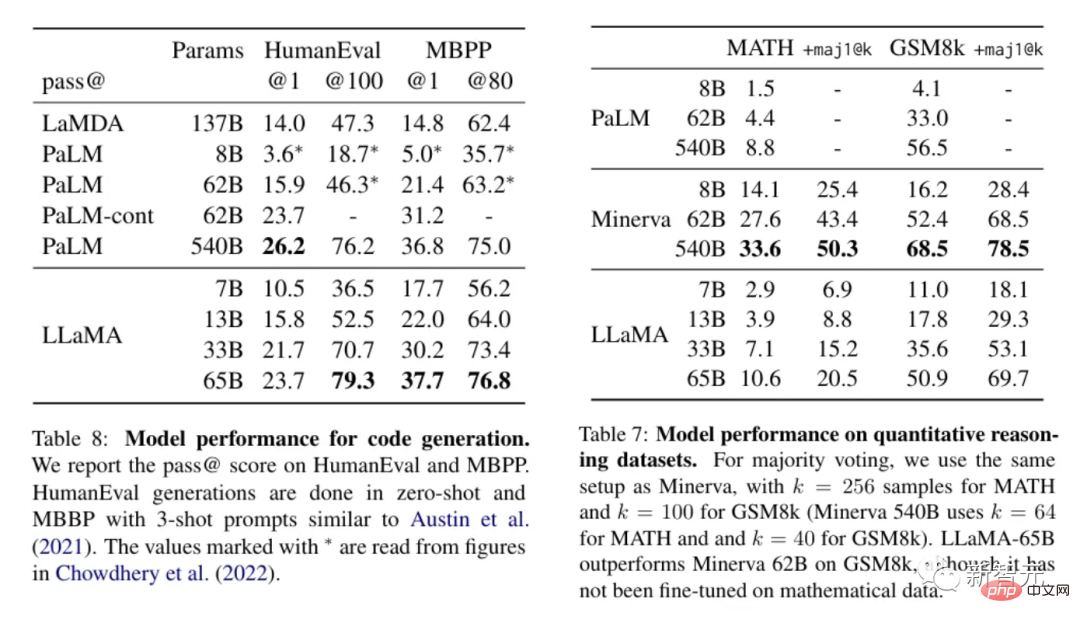

Pour les textes qui nécessitent l'application de logique ou de calculs pour le traitement, LLaMA fonctionne bien et est comparable à PaLM en termes de raisonnement quantitatif, et possède même de meilleures capacités de génération de code que ce dernier.

Au vu de ces résultats, LLaMA semble être l'un des modèles les plus avancés actuellement disponibles, et de plus, il est suffisamment petit pour ne pas nécessiter beaucoup de ressources pour fonctionner. Cela rend LLaMA très tentant pour les gens de vouloir jouer avec et voir ce qu'il peut faire.

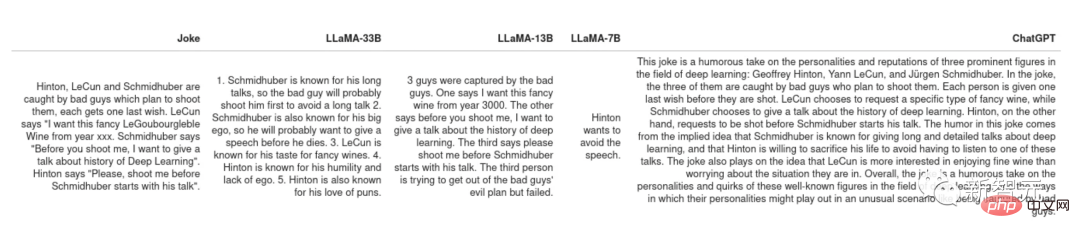

Explaining Jokes

L'article original de PaLM montre un cas d'utilisation très intéressant : étant donné une blague, laissez le modèle expliquer pourquoi elle est drôle. Cette tâche nécessite une combinaison d’expérimentation et de logique, ce que tous les modèles précédents de PaLM n’étaient pas en mesure de réaliser.

Laissez LLaMA et ChatGPT expliquer certaines blagues. Certains modèles de langage de blague peuvent comprendre, comme le discours long et ennuyeux de Schimidhuber.

Mais dans l'ensemble, LLaMA et ChatGPT n'ont aucun sens de l'humour.

Cependant, les deux ont des stratégies différentes pour gérer les blagues qu'ils ne comprennent pas. ChatGPT générera un « mur de texte » dans l'espoir qu'au moins certaines des phrases soient des réponses correctes. comme un élève qui ne connaît pas la réponse, j'espère que le professeur pourra trouver la réponse à ses bêtises.

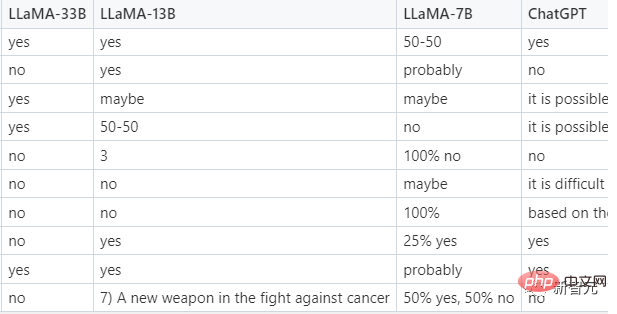

Classification Zero-shot

Il s'agit d'une fonction très pratique qui permet aux gens d'utiliser LLM au lieu d'évaluateurs pour générer des ensembles de formation, puis de former des modèles utilisables plus petits sur ces ensembles de formation.

Une tâche plus difficile consiste à classer les publicités cliquées. Étant donné que même les humains ne peuvent pas s'entendre sur ce que sont les publicités cliquées, quelques exemples sont fournis au modèle dans l'invite, il s'agit donc en fait d'un échantillon moindre et non nul. classement des échantillons. Voici les conseils de LLaMA.

Dans le test, seul LLaMA-33B a réussi à suivre le format requis pour donner des réponses, et ses prédictions étaient raisonnables et ont joué en deuxième position et pouvaient donner des réponses plus raisonnables, mais ne répondaient souvent pas dans le format prescrit. , les modèles plus petits 7B et 13B sont moins adaptés à cette tâche.

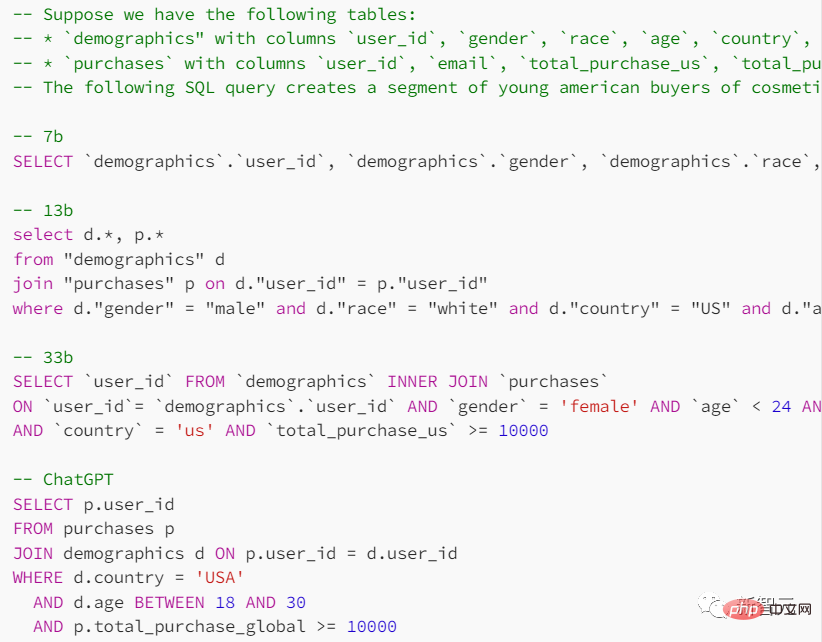

Génération de code

Bien que le LLM français soit performant en sciences humaines, il n'est pas bon dans les matières STEM, alors comment LLaMA se comporte-t-il dans cet aspect ?

Dans l'invite, indiquez la forme de la table de recherche et l'objectif que vous espérez atteindre, et demandez au modèle de fournir des instructions de requête SQL.

ChatGPT est plus performant dans cette tâche, mais les résultats donnés par le modèle de langage sont généralement peu fiables.

Dans divers tests par rapport à ChatGPT, LLaMA n'a pas gagné autant que prévu. Bien sûr, si l’écart est uniquement causé par le RLHF (apprentissage par renforcement avec rétroaction humaine), alors l’avenir des petits modèles pourrait être meilleur.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI