Maison >Périphériques technologiques >IA >Protection de la vie privée : l'IA anonymise les données cliniques des soins de santé

Protection de la vie privée : l'IA anonymise les données cliniques des soins de santé

- 王林avant

- 2023-04-12 15:19:081161parcourir

Face à la soudaine épidémie de COVID-19, nous avons été témoins de violations de données record. Un récent rapport d'IBM révèle que le coût des violations de données augmente également de façon spectaculaire.

La santé est sans aucun doute l'un des secteurs les plus touchés par les violations de données, avec une perte moyenne de 9,2 millions de dollars par incident de violation de données. Le type d’informations le plus souvent exposé lors de telles violations sont les données sensibles des clients.

Les entreprises pharmaceutiques et de soins de santé sont tenues de s'organiser et de fonctionner conformément à des directives strictes tout en protégeant les données des patients. Toute violation peut donc coûter cher. Par exemple, les entreprises sont tenues de collecter, traiter et stocker des informations personnelles identifiables (PII) tout au long de la phase de découverte de médicaments, et lorsque les essais sont terminés et les demandes cliniques soumises, il faut veiller à protéger la vie privée des patients dans les résultats publiés.

Le règlement n° 0070 de l'Agence européenne des médicaments (EMA) et le règlement sur la « diffusion publique des informations cliniques » émis par Santé Canada proposent tous deux des suggestions spécifiques sur l'anonymisation des données, dans l'espoir de minimiser le risque d'utilisation des résultats pour restaurer les informations sur l'identité des patients. .

En plus de prôner la confidentialité des données, ces réglementations exigent également le partage des données des essais pour garantir que la communauté puisse y travailler. Mais cela place sans aucun doute les entreprises face à un dilemme.

Alors, comment les sociétés pharmaceutiques parviennent-elles à trouver un équilibre entre confidentialité et transparence des données, tout en publiant les résultats de la recherche de manière opportune, rentable et efficace ? Les faits ont prouvé que la technologie de l'IA peut prendre en charge plus de 97 % de la charge de travail du processus de soumission, réduisant ainsi considérablement la charge opérationnelle des entreprises.

Pourquoi est-il si difficile d'anonymiser les résultats de la recherche clinique (RSE) ?

Dans le processus de mise en œuvre de l'anonymisation des soumissions cliniques, les entreprises sont principalement confrontées à trois défis principaux :

Les données non structurées sont difficiles à traiter : Une grande partie des données des essais cliniques sont des données non structurées. Les résultats de recherche contiennent une grande quantité de données textuelles, d’images numérisées et de tableaux, ce qui rend le traitement inefficace. Les rapports de recherche comptent souvent des milliers de pages et y identifier des informations sensibles équivaut à chercher une aiguille dans une botte de foin. De plus, il n’existe pas de solutions de formation technique standardisées permettant d’automatiser ce type de traitement.

Les processus manuels sont lourds et sujets aux erreurs : Aujourd'hui, les sociétés pharmaceutiques doivent employer des centaines d'employés pour anonymiser les soumissions d'études cliniques. L'ensemble de l'équipe doit passer par plus de 25 étapes complexes, et le traitement d'un document de synthèse typique peut prendre jusqu'à 45 jours. Et lors de la révision manuelle de milliers de pages de documents, ce processus fastidieux entraîne souvent des erreurs.

Interprétation ouverte des directives réglementaires : Bien qu'il existe de nombreuses suggestions détaillées dans la réglementation, les détails sont encore incomplets. Par exemple, le règlement de Santé Canada sur la « diffusion publique des informations cliniques » exige que le risque de récupération des informations d'identité soit inférieur à 9 %, mais il ne détaille pas la méthode de calcul du risque spécifique.

Ci-dessous, nous imaginerons des solutions spécifiques pouvant répondre à de tels besoins d'anonymisation du point de vue de la résolution de problèmes.

Utilisez l'analyse augmentée pour identifier les informations sensibles dans le langage humain

Les trois éléments suivants aident à créer des solutions d'anonymisation basées sur la technologie :

Modèles linguistiques d'IA pour le traitement du langage naturel (NLP)

Aujourd'hui, l'IA peut déjà créer comme un artiste et diagnostiquer comme un médecin. La technologie d’apprentissage profond a favorisé de nombreuses avancées dans le domaine de l’IA, et les modèles linguistiques d’IA en sont l’un des piliers. En tant que branche d'algorithmes conçue pour traiter le langage humain, les modèles de langage d'IA sont particulièrement efficaces pour détecter des entités nommées, telles que les noms de patients, les numéros de sécurité sociale et les codes postaux.

Sans le savoir, ces puissants modèles d'IA ont pénétré tous les recoins du domaine public et ont été formés à grande échelle à l'aide de documents publics. En plus du célèbre Wikipédia, la base de données MIMIC-III v1.4 contenant les données de désensibilisation de 40 000 patients est également devenue une ressource précieuse pour la formation de modèles d’IA. Bien entendu, afin d’améliorer les performances du modèle, les experts du domaine doivent également procéder à un recyclage ultérieur du modèle sur la base des rapports d’essais cliniques internes.

Améliorer la précision grâce à la conception de boucles homme-machine

La norme de seuil de risque de 9 % proposée par Santé Canada peut être grossièrement convertie en une exigence de précision du modèle d'environ 95 % (généralement mesurée par rappel ou précision). Les algorithmes d'IA sont capables d'examiner de grandes quantités de données et d'exécuter plusieurs cycles de formation pour améliorer leur précision. Cependant, les améliorations technologiques ne suffisent pas à elles seules à les préparer à une application clinique ; ces modèles nécessitent également des conseils et un soutien humains.

Pour répondre à la subjectivité des données des essais cliniques et améliorer les résultats, les solutions d'analyse sont conçues pour fonctionner aux côtés des humains : c'est ce qu'on appelle l'intelligence augmentée. Autrement dit, les humains sont considérés comme faisant partie de la boucle homme-machine. Ils sont non seulement responsables de l’étiquetage des données et de la formation des modèles, mais fournissent également un retour d’information régulier une fois la solution efficace. De cette façon, la précision et les performances de sortie du modèle seront améliorées.

Résoudre les problèmes dans une approche collaborative

Supposons qu'une étude implique un total de 1 000 patients, dont 980 viennent de la zone continentale des États-Unis et les 20 autres d'Amérique du Sud. Alors, les données de ces 20 patients doivent-elles être éditées (masquées) ou anonymisées ? Est-il nécessaire de sélectionner des échantillons de patients dans le même pays ou continent ? De quelles manières un attaquant pourrait-il combiner ces informations anonymisées avec l'âge, le code postal et d'autres données pour finalement restaurer l'identité du patient ?

Malheureusement, il n’existe pas de réponses standards à ces questions. Pour interpréter plus clairement les directives de soumission clinique, les fabricants de produits pharmaceutiques, les organismes de recherche clinique (CRO), les fournisseurs de solutions technologiques et les chercheurs universitaires doivent unir leurs forces et collaborer.

Méthode d'anonymisation basée sur l'IA

Avec les idées de base ci-dessus, l'étape suivante consiste à les rassembler en un processus de solution complet. Les différentes technologies de l'ensemble de la solution d'anonymisation doivent être basées sur les méthodes réelles que nous utilisons déjà dans notre travail.

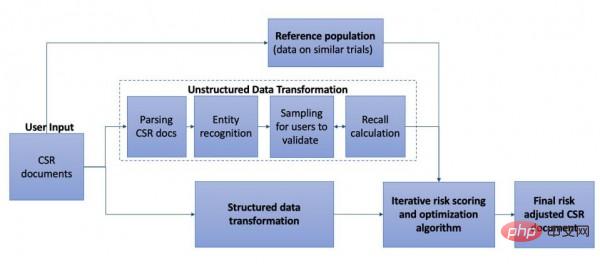

Les rapports d'études cliniques contiennent une variété de données structurées (entités numériques et identitaires, telles que des informations démographiques et des entrées d'adresse), ainsi que divers éléments de données non structurés dont nous avons discuté précédemment. Cela doit être géré correctement pour empêcher les pirates malveillants de les restaurer vers des entités nommées sensibles. Les données structurées sont relativement faciles à traiter, mais les algorithmes d’IA doivent encore surmonter la difficulté des données non structurées.

Ainsi, les données non structurées (généralement dans un format tel que des images numérisées ou des PDF) sont d'abord converties en une forme lisible à l'aide de technologies telles que la reconnaissance optique de caractères (OCR) ou la vision par ordinateur. Ensuite, des algorithmes d’IA sont appliqués aux documents pour détecter les informations personnellement identifiables. Pour améliorer les performances de l'algorithme, les utilisateurs peuvent partager des commentaires sur les résultats des échantillons pour aider le système à comprendre comment gérer ces analyses de moindre confiance.

Méthode d'anonymisation basée sur l'IA

Une fois l'anonymisation terminée, les risques correspondants de restauration d'identité doivent également être évalués. Ce travail nécessite généralement une référence au contexte de la population et une combinaison avec les données d'autres essais similaires. L’évaluation des risques se concentre sur l’identification de trois scénarios de risque majeurs – procureurs, journalistes et spécialistes du marketing – à travers un ensemble d’éléments. Ces trois groupes tenteront de restaurer les informations des patients en fonction de leurs propres besoins.

Avant que le niveau de risque n'atteigne 9 % des recommandations prescrites, le processus d'anonymisation continuera à introduire davantage de règles métier et d'améliorations d'algorithmes, en essayant d'améliorer l'efficacité dans un cycle répétitif. Ensuite, en s'intégrant à d'autres applications technologiques et en établissant un processus d'opérations d'apprentissage automatique (ML Ops), l'ensemble de la solution d'anonymisation peut être intégrée au flux de travail réel.

Un défi plus difficile que les algorithmes : la qualité des données

Pour les sociétés pharmaceutiques, de telles solutions d'anonymisation peuvent raccourcir le cycle de soumission jusqu'à 97 %. Plus important encore, ce flux de travail semi-automatisé améliore l’efficacité tout en garantissant l’implication humaine. Mais quels sont les plus grands défis dans la création de solutions d’anonymisation basées sur l’IA ?

En fait, comme la plupart des pratiques de science des données, le plus grand obstacle à ce travail n'est pas l'algorithme d'IA utilisé pour identifier les entités nommées, mais la manière de convertir les rapports de recherche en données de haute qualité pouvant être traitées par l'IA. Pour les documents ayant des formats, styles et structures différents, le pipeline d’ingestion de contenu correspondant est souvent perdu.

Par conséquent, les solutions d'anonymisation de l'IA doivent être continuellement affinées pour s'adapter aux nouveaux formats d'encodage de documents ou pour détecter avec précision les positions de début et de fin dans les numérisations d'images/tableaux. De toute évidence, cet aspect du travail est le domaine le plus long et le plus énergivore de l’anonymisation de l’IA.

Nouveaux défis de l'anonymisation dans la recherche clinique

Avec les progrès rapides de la technologie, l'anonymisation de la recherche clinique continuera-t-elle à être moins difficile et plus efficace ? Même si les solutions basées sur l’IA sont effectivement impressionnantes, de nouveaux défis nécessiteront une attention particulière.

Premièrement, les données des consommateurs collectées via les réseaux sociaux, l’utilisation des appareils et le suivi en ligne augmentent considérablement le risque de restauration d’identité. Les attaquants peuvent combiner ces informations publiques avec des données de recherche clinique pour identifier avec précision les patients. Ce qui est encore plus inquiétant, c’est que les pirates malveillants sont très actifs dans l’application des résultats de l’IA et pourraient même devancer les sociétés pharmaceutiques.

Enfin, les réglementations continuent d'évoluer pour s'adapter aux pratiques spécifiques aux pays. Peut-être que bientôt certains pays annonceront des réglementations spécifiques sur l’anonymisation des soumissions cliniques, ce qui augmentera certainement la complexité et le coût pour les entreprises de maintenir leur conformité. Mais comme le dit le proverbe, l’avenir est radieux mais le chemin est tortueux. Le développement mature de la technologie de l’IA apporte au moins l’espoir à l’ensemble du secteur de surmonter les problèmes.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI