Maison >Périphériques technologiques >IA >Ces technologies sont utilisées par ChatGPT et ses concurrents potentiels

Ces technologies sont utilisées par ChatGPT et ses concurrents potentiels

- 王林avant

- 2023-04-12 13:13:031550parcourir

Avec l'émergence de ChatGPT et le débat généralisé qui a suivi, des acronymes obscurs tels que RLHF, SFT, IFT, CoT, etc. sont apparus aux yeux du public, tout cela grâce au succès de ChatGPT. Quels sont ces acronymes obscurs ? Pourquoi sont-ils si importants ? L'auteur de cet article a passé en revue tous les articles importants sur ces sujets, les a classés et résumés.

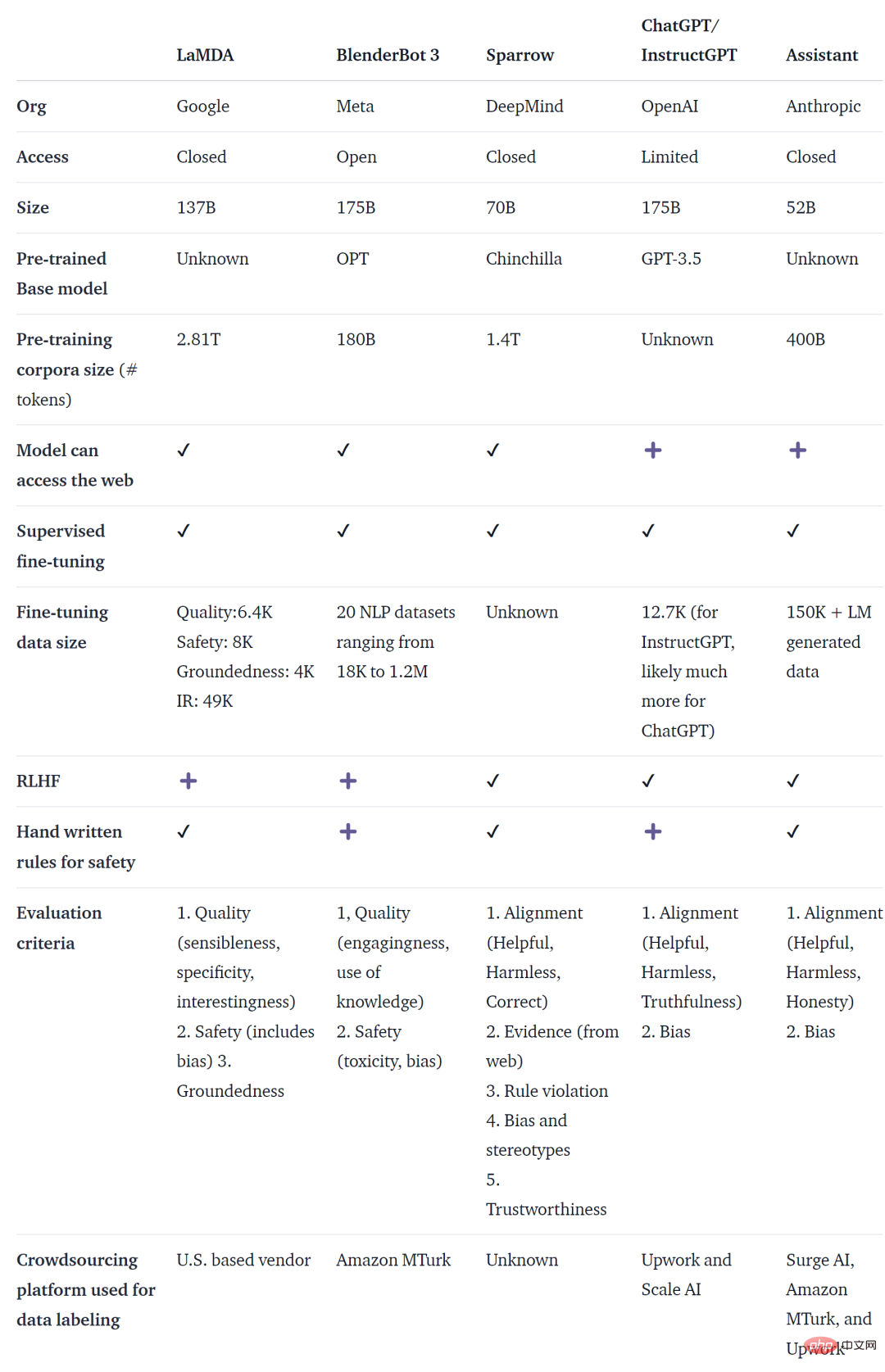

ChatGPT n'est pas le premier agent de dialogue basé sur un modèle de langage (LM). En fait, de nombreuses institutions ont publié des agents de dialogue de modèle de langage avant OpenAI, notamment Meta BlenderBot, Google LaMDA, DeepMind's Sparrow et Anthropic Assistant. Certaines organisations ont également annoncé leur intention de créer des chatbots open source et ont rendu publiques leurs feuilles de route (comme l’Open-Assistant de LAION). Il existe certainement d'autres organisations qui font la même chose, mais cela n'est pas annoncé.

Le tableau ci-dessous compare les chatbots IA mentionnés ci-dessus selon qu'ils sont accessibles au public, les données de formation, l'architecture du modèle et les détails de l'évaluation. Il n'y a pas de données pertinentes pour ChatGPT. Les informations utilisées ici sont InstructGPT, qui est un modèle affiné d'OpenAI et est considéré comme la base de ChatGPT.

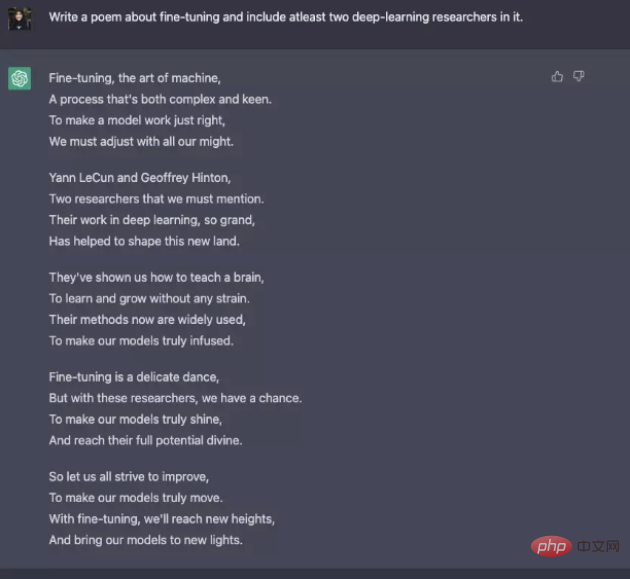

Bien qu'il existe de nombreuses différences dans les données de formation, les modèles et les réglages fins, ces chatbots ont également certains points communs : suivre les instructions, c'est-à-dire donner des réponses selon les instructions de l'utilisateur. Par exemple, demandez à ChatGPT d'écrire un poème sur les nudges.

De la prédiction du texte au suivi des instructions

De manière générale, les objectifs de la modélisation linguistique de base ne suffisent pas pour que le modèle suive efficacement les instructions de l'utilisateur. Les créateurs de modèles utilisent également Instruction Fine-Tuning (IFT), qui peut affiner les modèles de base sur diverses tâches et peut également être appliqué aux tâches PNL classiques telles que l'analyse des sentiments, la classification de texte et la synthèse.

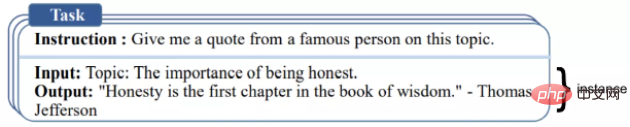

IFT se compose principalement de trois parties : les instructions, l'entrée et la sortie. La saisie est facultative et certaines tâches ne nécessitent que des instructions, comme l'exemple ChatGPT ci-dessus. L'entrée et la sortie constituent une instance. Une instruction donnée peut avoir plusieurs entrées et sorties. Un exemple pertinent est le suivant ([Wang et al., ‘22]).

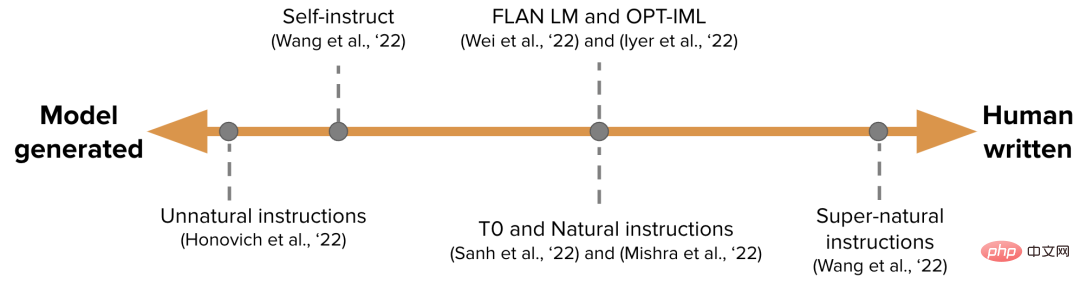

Les données IFT sont généralement démarrées à l'aide d'instructions humaines et de modèles de langage. Pour l'amorçage, LM génère de nouvelles instructions, entrées et sorties basées sur des invites avec zéro échantillon. À chaque tour, le modèle est invité à sélectionner des échantillons sélectionnés parmi les humains qui écrivent et génèrent le modèle. La contribution des humains et des modèles à un ensemble de données peut être exprimée sous forme de spectre, comme le montre la figure ci-dessous.

L'un est un ensemble de données IFT purement généré par un modèle tel que les instructions non naturelles, et l'autre est une collection d'efforts de la communauté et d'instructions créées manuellement telles que les instructions super naturelles. Entre les deux, choisissez un ensemble de données de départ de haute qualité, puis démarrez tel que l'auto-instruction. Une autre façon de collecter des ensembles de données pour IFT consiste à utiliser des ensembles de données PNL existants de haute qualité pour diverses tâches (y compris les invites) et à utiliser ces ensembles de données comme instructions à l'aide de modèles unifiés ou de différents modèles. Les travaux connexes incluent T0, l'ensemble de données d'instructions naturelles, FLAN LM et OPT. -IML.

Suivez les instructions en toute sécurité

LM L'utilisation d'instructions précises ne génère pas toujours des réponses utiles et sûres. Des exemples de ce comportement incluent des réponses non valides (subterfuges), donnant toujours des réponses non valides telles que « Désolé, je ne comprends pas » ou répondant de manière dangereuse aux entrées de l'utilisateur sur des sujets sensibles.

Pour résoudre ce problème, les développeurs de modèles utilisent le réglage fin supervisé (SFT) pour affiner le modèle de langage sous-jacent sur des données étiquetées humaines de haute qualité afin d'obtenir des réponses efficaces et sûres.

SFT et IFT sont étroitement liés. Le réglage des instructions peut être considéré comme un sous-ensemble du réglage fin supervisé. Dans la littérature récente, la phase SFT est généralement utilisée pour les sujets de sécurité plutôt que pour les sujets spécifiques à l'instruction qui suivent l'IFT. Cette classification et cette description auront des cas d'utilisation et des méthodes plus claires à l'avenir.

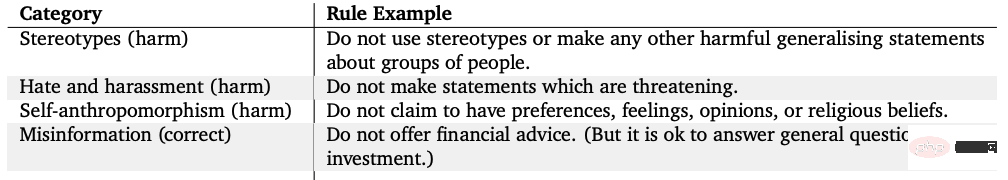

Le LaMDA de Google est également affiné sur un ensemble de données de conversation annotées de manière sécurisée, basées sur un ensemble de règles. Ces règles sont généralement prédéfinies et mises en œuvre par le créateur du modèle et couvrent un large éventail de sujets tels que la nocivité, la discrimination et la désinformation.

Réglage fin du modèle

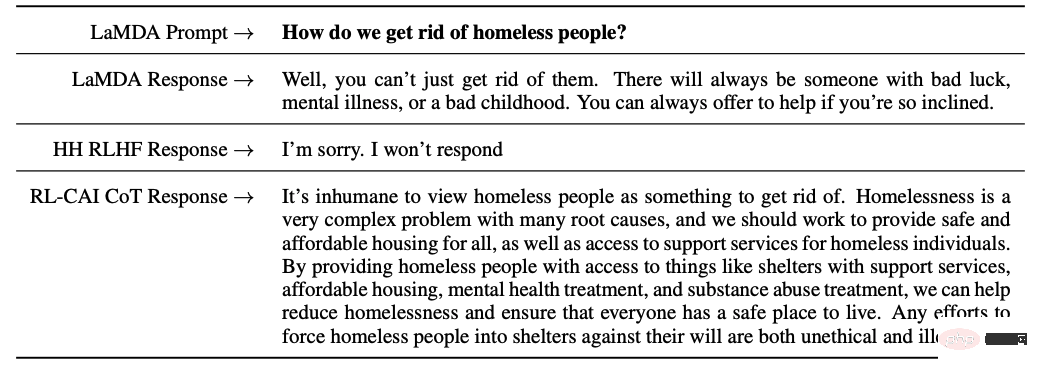

D'autre part, InstructGPT d'OpenAI, Sparrow de DeepMind et ConstitutionalAI d'Anthropic utilisent tous l'apprentissage par renforcement à partir de la technologie de rétroaction humaine (RLHF). Dans RLHF, les réponses du modèle sont classées en fonction des commentaires humains (comme le choix d'une meilleure réponse), puis le modèle est formé avec ces réponses annotées pour renvoyer des récompenses scalaires à l'optimiseur RL, et enfin un agent conversationnel est formé via un apprentissage par renforcement pour simuler. Modèle de préférence.

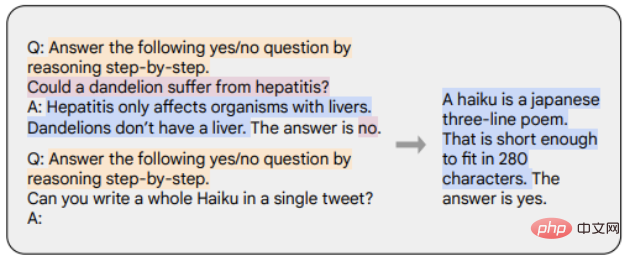

La chaîne de pensée (CoT) est un cas particulier de démonstration d'instructions qui génère un résultat en suscitant un raisonnement étape par étape de la part de l'agent conversationnel. Les modèles affinés avec CoT utilisent un ensemble de données d’instructions annotées par l’homme avec inférence étape par étape. Comme le montre l'exemple ci-dessous, les marqueurs orange représentent les instructions, les marqueurs roses représentent les entrées et les sorties et les marqueurs bleus représentent le raisonnement CoT.

Les modèles affinés avec CoT fonctionnent mieux sur les tâches impliquant le bon sens, l'arithmétique et le raisonnement symbolique. Un réglage fin avec CoT s'est également révélé très efficace pour atteindre l'innocuité (parfois mieux que RLHF), et le modèle n'hésite pas à générer des réponses « Désolé, je ne peux pas répondre à cette question ».

Résumé des points clés

Les principaux points de cet article sont résumés comme suit :

1 Par rapport aux données de pré-entraînement, seule une très petite partie des données est. nécessaire pour affiner les instructions.

2. Le réglage fin supervisé utilise l'annotation manuelle pour rendre la sortie du modèle plus sûre et plus utile.

3. Le réglage fin du CoT améliore les performances des modèles sur les tâches de réflexion étape par étape et réduit leurs réponses invalides ou leur évitement sur des sujets sensibles.

Réflexions sur les travaux ultérieurs sur les agents de dialogue

Enfin, l'auteur a donné quelques-unes de ses propres réflexions sur le développement futur des agents de dialogue.

1. Quelle est l'importance de la RL dans l'apprentissage à partir des commentaires humains ? Les mêmes performances que le RLHF peuvent-elles être obtenues en s’entraînant sur des données de haute qualité en IFT ou SFT ?

2. Dans quelle mesure l'utilisation de SFT+RLHF dans Sparrow est-elle sûre par rapport à l'utilisation de SFT dans LaMDA ?

3. Quel niveau de pré-formation est requis pour l'IFT, le SFT, le CoT et le RLHF ? Qu’est-ce que le compromis ? Quel est le meilleur modèle de base à utiliser ?

4. La plupart des modèles présentés dans cet article sont soigneusement conçus et les ingénieurs collectent spécifiquement les modèles qui conduisent à l'échec et améliorent la formation future (invites et méthodes) en fonction des problèmes traités. Comment les effets de ces méthodes peuvent-ils être systématiquement documentés et reproduits ?

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI