Maison >Périphériques technologiques >IA >Meta publie le premier modèle de langage de masque « non paramétrique » NPM : battant GPT-3 avec 500 fois plus de paramètres

Meta publie le premier modèle de langage de masque « non paramétrique » NPM : battant GPT-3 avec 500 fois plus de paramètres

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-12 10:13:061128parcourir

Bien que les performances puissantes des grands modèles de langage dans le domaine de la PNL soient étonnantes, les coûts négatifs qu'elles entraînent sont également graves, comme la formation trop coûteuse et difficile à mettre à jour. , et il est difficile de gérer les connaissances à longue traîne.

Et les modèles de langage utilisent généralement une couche softmax contenant un vocabulaire limité dans la couche de prédiction, qui ne produit fondamentalement pas de mots ou d'expressions rares, ce qui limite considérablement la capacité d'expression du modèle.

Afin de résoudre le problème de la longue traîne du modèle, des chercheurs de l'Université de Washington, de Meta AI et de l'Allen Institute for Artificial Intelligence ont récemment proposé conjointement le premier « Modèle de langage masqué non paramétrique » (NPM). La sortie softmax est remplacée. par une distribution non paramétrique pour chaque phrase du corpus de référence.

Lien papier : https://arxiv.org/abs/2212.01349

Lien code : https://github.com/facebookresearch/NPM

Le NPM peut utiliser un objectif contrastif et une approximation intra-lot Une formation efficace dans récupérer le corpus complet.

Les chercheurs ont mené une évaluation zéro sur 9 tâches fermées et 7 tâches ouvertes, y compris des tâches de transformation spatio-temporelle et de traduction au niveau des mots qui mettent l'accent sur la nécessité de prédire de nouveaux faits ou des phrases rares.

Les résultats montrent que, que les méthodes de récupération et de génération soient utilisées ou non, le NPM est nettement meilleur que les modèles paramétriques plus grands. Par exemple, GPT-3 avec des paramètres 500 fois plus élevés et OPT 13B avec 37 fois plus de performances sont bien meilleurs, et NPM. a de meilleures performances en Il est particulièrement efficace pour gérer des modèles rares (significations de mots ou faits) et prédire des mots rares ou à peine vus (tels que les écritures non latines).

Le premier modèle de langage non paramétrique

Bien que ce problème puisse être atténué en combinant certains travaux existants liés à la récupération et à la génération, la partie de prédiction finale de ces modèles nécessite toujours une couche softmax pour prédire les jetons, ne résout pas fondamentalement le problème. problème de longue traîne.

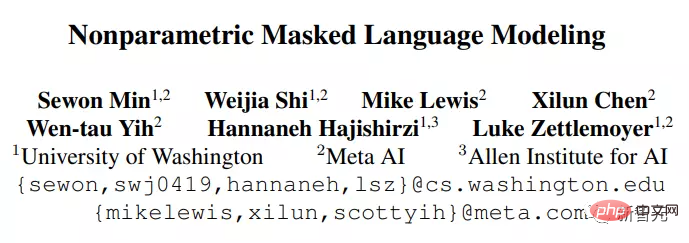

NPM se compose d'un encodeur et d'un corpus de référence. L'encodeur mappe le texte dans un vecteur de taille fixe, puis NPM en récupère une phrase et remplit [MASK].

Comme vous pouvez le voir, NPM choisit la distribution non paramétrique obtenue sur les phrases au lieu d'utiliser un vocabulaire de sortie fixe softmax comme sortie.

Mais la formation de modèles non paramétriques pose également deux problèmes clés :

1. La récupération du corpus complet pendant le processus de formation prend beaucoup de temps et demande beaucoup de travail. Les chercheurs utilisent des approximations intra-lots de la récupération complète du corpus ;

2. Apprendre à prédire des phrases de longueur arbitraire sans décodeur est difficile, et les chercheurs résolvent ce problème en étendant les objectifs de masquage de portée et de comparaison au niveau des phrases.

En résumé, NPM supprime complètement le softmax du vocabulaire de sortie et obtient un espace de sortie illimité efficace en prédisant n'importe quel nombre de n-grammes.

Le modèle résultant peut prédire des mots « extrêmement rares » ou même « complètement invisibles » (tels que les mots coréens) et peut prendre en charge efficacement des vocabulaires illimités, ce que les modèles existants ne peuvent pas faire.

Méthode NPM

L'idée clé de NPM est d'utiliser un encodeur pour mapper toutes les phrases du corpus dans un espace vectoriel dense. Au moment de l'inférence, lorsque vous recevez une requête avec [MASK], utilisez l'encodeur pour trouver la phrase la plus proche du corpus et remplissez [MASK].

Le modèle d'encodeur pur (encodeur uniquement) est un modèle de représentation très compétitif, mais les modèles existants d'encodage uniquement ne peuvent pas faire de prédictions avec un nombre inconnu de jetons, ce qui limite leur utilisation sans réglage fin.

NPM résout ce problème en récupérant une phrase à remplir [MASK] avec n'importe quel nombre de jetons.

Inférence

L'encodeur mappe chaque phrase distincte du corpus de référence C dans un espace vectoriel dense.

Au moment du test, l'encodeur mappe la requête masquée dans le même espace vectoriel et remplit [MASK] avec des phrases extraites de C.

Ici, C ne doit pas nécessairement être le même que le corpus de formation et peut être remplacé ou étendu au moment du test sans recycler l'encodeur.

En pratique, il y a un grand nombre de phrases dans le corpus, et les indexer toutes coûte cher.

Par exemple, si nous considérons une phrase avec au plus l jetons (l≈20), nous devons indexer le nombre l×|C| de vecteurs, ce qui peut prendre du temps.

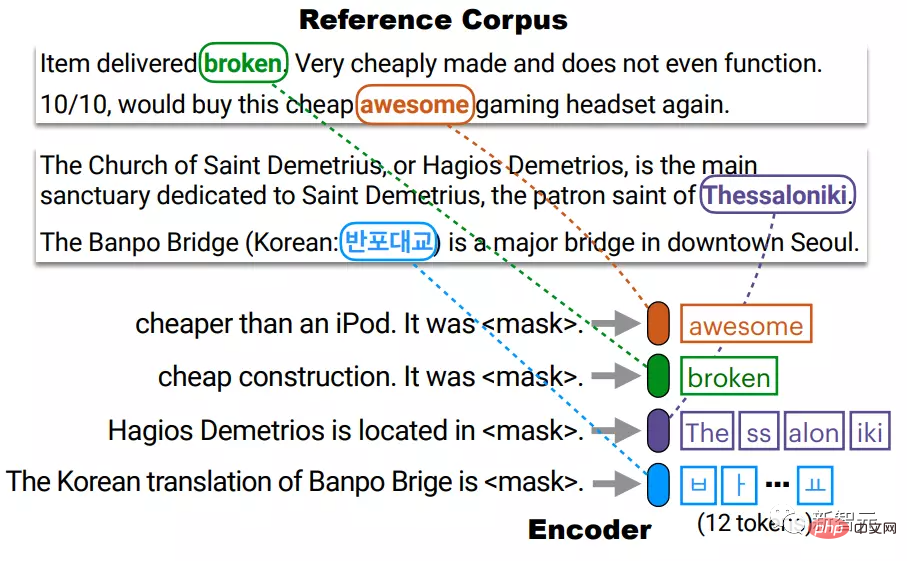

Les chercheurs ont indexé chaque jeton différent en C, réduisant ainsi la taille de l'index de l × |C| à |C|, puis au moment du test, ont effectué k recherches de voisins les plus proches au début et à la fin. approximant la distribution non paramétrique de toutes les phrases.

Par exemple, la phrase Thessalonique composée de 4 jetons BPE est représentée par la connexion de c1 et c4, qui correspondent respectivement au début (The) et à la fin (iki) de la phrase.

Représentez ensuite une requête avec deux vecteurs q_start et q_end dans le même espace vectoriel, et utilisez chaque vecteur pour récupérer le début et la fin d'une phrase plausible avant de faire l'agrégation.

La prémisse de cela est que la représentation du début et de la fin est assez bonne, c'est-à-dire que le point de départ de q est suffisamment proche de c1, et le point final de q est suffisamment proche de c4, et cela a été assurée pendant le processus de formation.

Formation

NPM est formé sur des données texte non étiquetées pour garantir que l'encodeur mappe le texte dans un espace vectoriel dense et agréable.

Il y a deux problèmes principaux dans la formation du NPM : 1) La récupération complète du corpus rendra la formation très longue. 2) Remplir [MASK] avec des phrases de longueur arbitraire au lieu de jetons ;

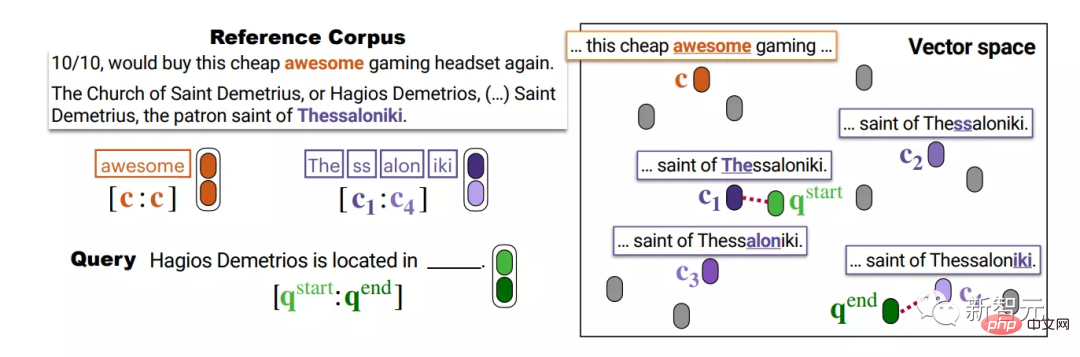

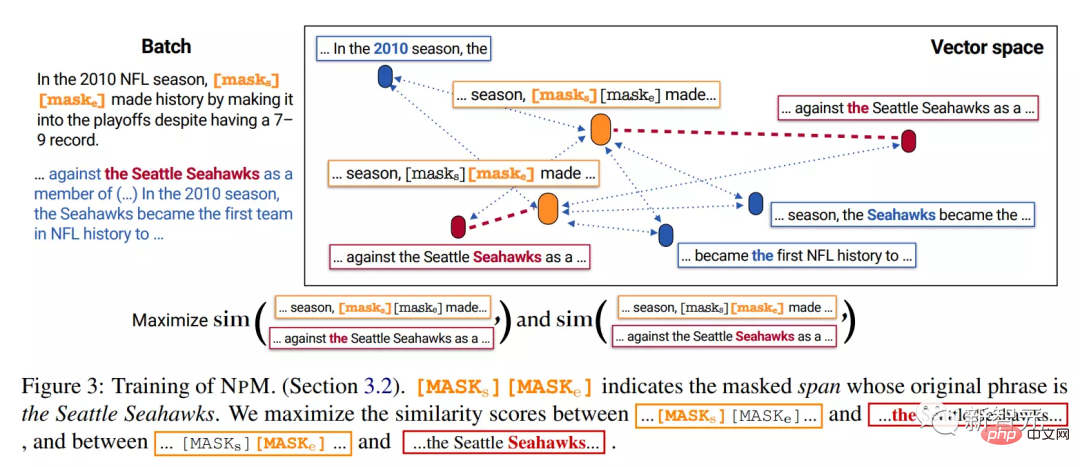

1. Masquage Masquage

Le masquage Span consiste à masquer des jetons continus dont les longueurs sont échantillonnées à partir d'une distribution géométrique.

Les chercheurs ont développé ceci :

1) Si certains fragments coapparaissent dans d'autres séquences du lot, ils sont ensuite masqués pour garantir les positifs du lot lors de l'entraînement).

Par exemple, le clip masqué 2010, les Seattle Seahawks et to the all coapparaissent dans une autre séquence.

Mais pour le « jeu » du bigramme, ils ne peuvent pas être masqués ensemble. Bien qu'ils apparaissent également dans deux séquences, ils ne se produisent pas ensemble.

2) Au lieu de remplacer chaque jeton du fragment par [MASK], remplacez le fragment entier par deux jetons spéciaux [MASKs][MASKe].

Par exemple, dans l'exemple ci-dessus, quelle que soit la longueur du segment masqué, il est remplacé par [MASKs][MASKe], afin que les vecteurs de début et de fin de chaque segment puissent être obtenus, ce qui rend le raisonnement plus pratique.

2. Objectif de formation

En supposant que le fragment masqué soit les Seahawks de Seattle, lors des tests, le modèle doit récupérer la phrase les Seahawks de Seattle à partir d'autres séquences du corpus de référence.

Dans la phase d'inférence, le modèle obtient des vecteurs de [MASKs] et [MASKe] et les utilise pour récupérer respectivement le début et la fin de la phrase du corpus.

Par conséquent, l'objectif d'entraînement devrait encourager le vecteur de [MASQUES] à se rapprocher du vecteur des Seahawks de Seattle et à s'éloigner des autres jetons, et ne devrait pas être le vecteur dans aucune phrase, comme devenir le premier.

Nous faisons cela en entraînant le modèle pour rapprocher le corpus complet des autres séquences du lot. Plus précisément, nous entraînons le modèle pour récupérer les points de début et de fin du segment des Seahawks de Seattle à partir d'autres séquences du même lot.

Il convient de noter que cette stratégie de masque garantit que chaque travée masquée possède un segment co-occurrent dans un lot.

Partie expérimentale

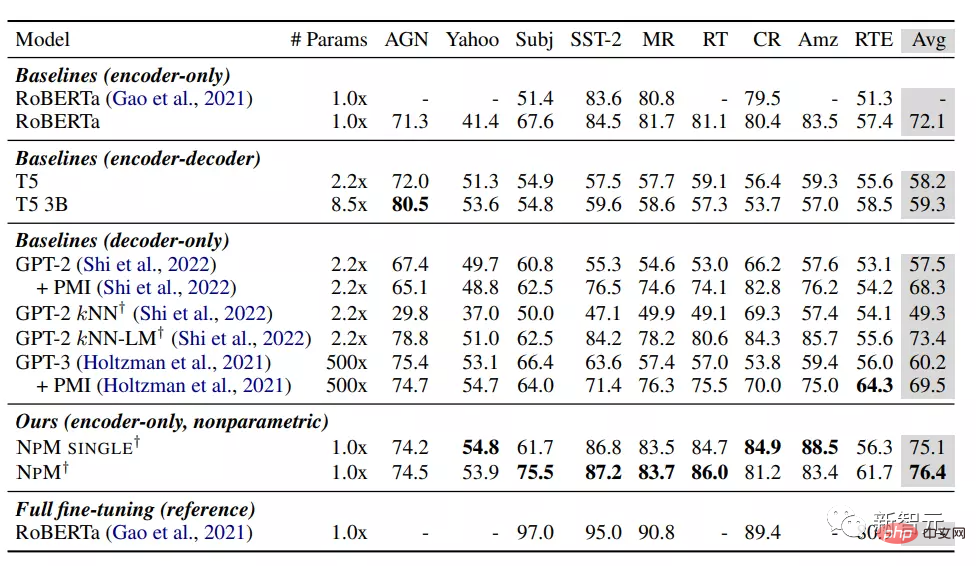

À en juger par les résultats, le NPM fonctionne mieux que les autres modèles de base sous le réglage zéro tir.

Parmi les modèles paramétriques, RoBERTa a obtenu les meilleures performances, surpassant de manière inattendue les modèles incluant GPT-3, probablement parce que la bidirectionnalité du modèle d'encodeur pur a joué un rôle crucial, ce qui suggère également que les modèles de langage causal pourraient ne pas être appropriés. choix pour le classement. La méthode

kNN-LM ajoute des composants non paramétriques au modèle paramétrique et ses performances sont meilleures que toutes les autres lignes de base. Néanmoins, s'appuyer uniquement sur la récupération (kNN) fonctionne mal dans GPT-2, ce qui indique les limites de l'utilisation de kNN uniquement au moment de l'inférence.

NPM SINGLE et NPM ont tous deux largement surperformé toutes les références, obtenant des performances constamment supérieures sur tous les ensembles de données. Cela montre que les modèles non paramétriques sont très compétitifs même pour des tâches qui ne nécessitent pas explicitement de connaissances externes.

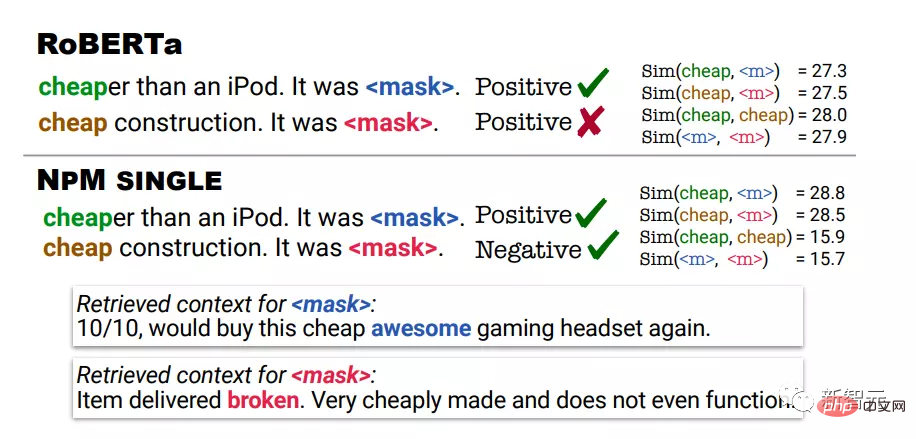

L'analyse qualitative utilise les résultats de prédiction de RoBERTa et NPM dans les tâches d'analyse des sentiments. Dans le premier exemple, bon marché signifie pas cher, et dans le deuxième exemple, bon marché signifie mauvaise qualité.

Les prédictions de RoBERTa étaient positives pour les deux exemples, tandis que NPM a fait la prédiction correcte en récupérant les contextes où cheap a été utilisé dans le même contexte que l'entrée.

On peut également constater que la représentation produite par NPM peut apporter une meilleure désambiguïsation du sens des mots. Par exemple, RoBERTa attribue un score de similarité élevé entre bon marché et bon marché.

D'un autre côté, NPM attribue avec succès un faible score de similarité entre bon marché et bon marché, ce qui montre également que cette formation non paramétrique avec des objectifs contrastés est efficace et peut mieux améliorer l'apprentissage des représentations, tandis qu'une telle inférence kNN Un algorithme sans formation est complètement impossible .

Référence : https://arxiv.org/abs/2212.01349

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI