Maison >Périphériques technologiques >IA >La « version améliorée » du grand modèle OPT-IML de Meta de 100 milliards de paramètres est ici, et le modèle complet et le code sont publiés !

La « version améliorée » du grand modèle OPT-IML de Meta de 100 milliards de paramètres est ici, et le modèle complet et le code sont publiés !

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-11 22:31:091670parcourir

En mai de cette année, MetaAI a officiellement annoncé la sortie du modèle ultra-large OPT-175B basé sur 175 milliards de paramètres, qui est également ouvert gratuitement à toutes les communautés.

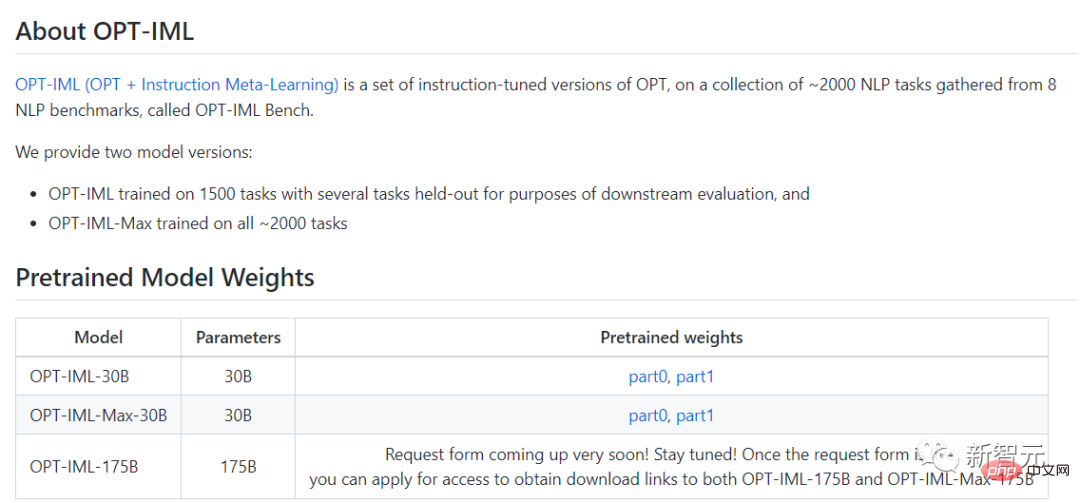

Le 22 décembre, une version mise à jour du modèle, OPT-IML (Open Pre-trained Transformer), a été officiellement lancée. Meta a déclaré qu'il était "affiné pour 2 000 tâches de langage et contenait 175 milliards de paramètres". sera également utilisé gratuitement à des fins de recherche non commerciale.

Quelles sont les performances de cet OPT-IML mis à jour ? Jetons un coup d'œil aux deux photos.

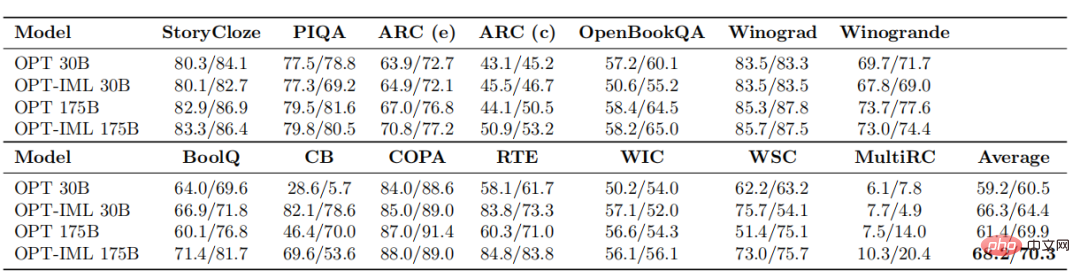

Cette fois, OPT-IML a créé deux tailles de modèle, 30B et 175B.

Par rapport à l'ancien modèle OPT, OPT-IML surpasse l'OPT en moyenne dans 14 tâches d'évaluation PNL standard.

Les deux tailles de modèle sont respectivement 7 %~ meilleures pour la tâche d'apprentissage sans tir et 4 %~ et 0,4 %~ meilleures pour la tâche d'apprentissage à 32 tirs.

Dans cette étude, les chercheurs décrivent comment l'augmentation de la taille du modèle et du benchmark affecte l'impact des décisions de réglage des instructions sur la performance des tâches en aval.

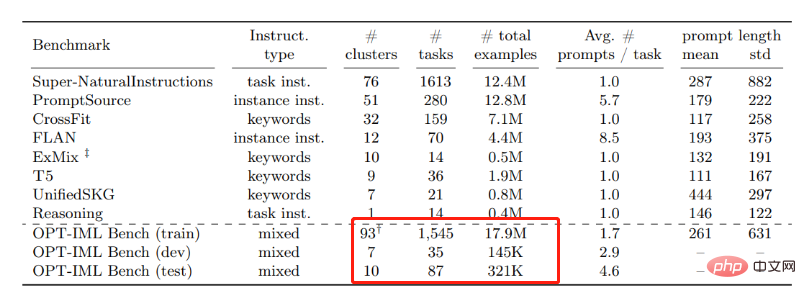

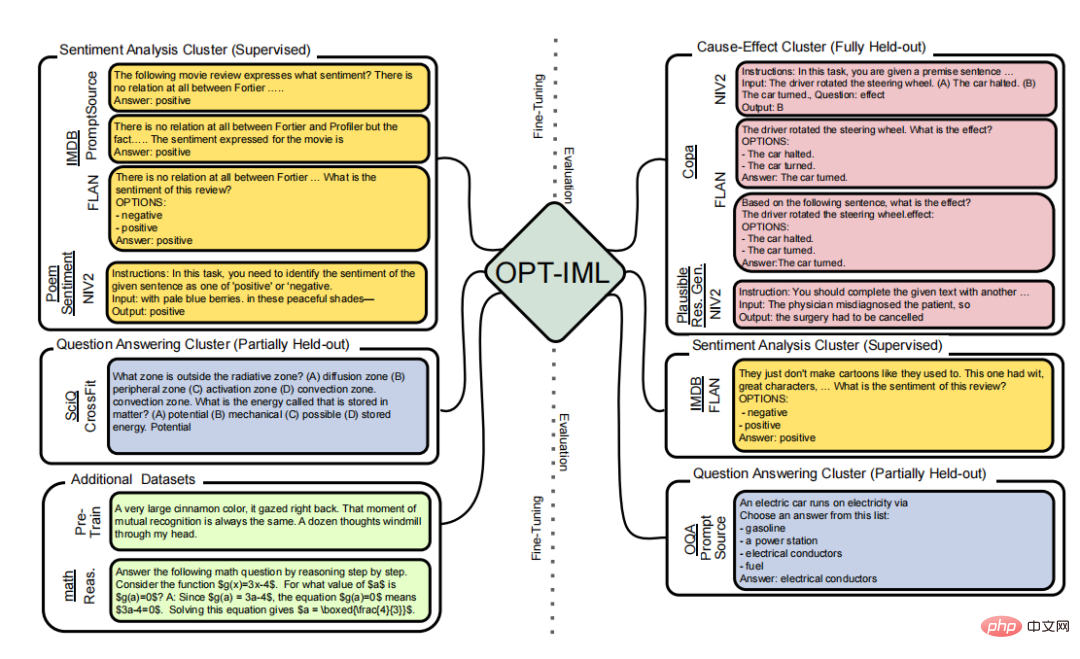

Pour cela, ils ont développé OPT-IML Bench, un benchmark de méta-apprentissage pédagogique (IML) assez volumineux contenant 2000 tâches PNL réparties en catégories de tâches basées sur huit benchmarks existants.

Pour former les OPT-IML 30B et 175B, les chercheurs ont d'abord fourni un aperçu des décisions de réglage des instructions appliquées à l'OPT-30B du point de vue de ce cadre.

Sur quatre benchmarks d'évaluation (PromptSource, FLAN, Super-NaturalInstructions et UnifiedSKG) avec différentes cibles et formats d'entrée, OPT-IML démontre les trois compétences de généralisation à deux échelles.

Non seulement il surpasse considérablement OPT dans tous les benchmarks, mais il surpasse également les modèles existants optimisés pour ce benchmark spécifique d'une manière très compétitive.

De plus, OPT-IML est open source et le lien Github est également publié ci-dessous~

Lien Github : https://github.com/facebookresearch/metaseq/tree/main /projects/ OPT-IML

Ensuite, découvrons OPT-IML à travers le document.

Lien papier : https://github.com/facebookresearch/metaseq/blob/main/projects/OPT-IML/optimal_paper_v1.pdf

Méthodes de recherche

Instructions pour les grands modèles de langage Le réglage fin est devenu une méthode efficace pour améliorer ses capacités de généralisation à tir nul et à quelques tirs. Dans cette étude, les chercheurs de Meta ont apporté trois ajouts importants à l’affinement de l’enseignement.

Tout d'abord, ils ont compilé un benchmark de réglage fin des instructions à grande échelle contenant 2 000 tâches PNL provenant de huit collections d'ensembles de données, classées par type de tâche.

Les chercheurs construisent de manière sélective des divisions d'évaluation sur ce benchmark pour tester trois types différents de capacités de généralisation de modèles :

Comprend les tâches des catégories entièrement suspendues, les tâches suspendues des types vus et les instances suspendues des tâches vues).

Le réglage fin des instructions

Le réglage fin des modèles pour les rendre cohérents avec les instructions de conformité est l'une des directions de recherche actuelles en apprentissage automatique.

Il existe deux méthodes pour affiner les commandes. L’un se concentre sur le réglage fin des modèles pour une variété de tâches à l’aide d’instructions et de commentaires annotés par l’homme ; l’autre se concentre sur l’ajout d’instructions via des annotations ou automatiquement à des références et des ensembles de données accessibles au public.

Dans cette étude, les membres de Meta AI se sont concentrés sur la deuxième technique et ont compilé un certain nombre d'ensembles de données accessibles au public contenant des méthodes pour améliorer l'OPT.

Au cours de la recherche, les membres de Meta ont proposé une méthode de mise à l'échelle similaire utilisant 1836 tâches issues de quatre benchmarks. Enfin, tout en ajustant l'ensemble du test pour repousser les limites de performances de références externes difficiles telles que MMLU et Big-Bench Hard (BBH), les chercheurs décrivent les poids de diverses stratégies de réglage des instructions qui peuvent avoir un impact sur les performances en aval.

Apprentissage multitâche

L'apprentissage multitâche est une expression du réglage fin basé sur l'instruction (MTL).

MTL est un paradigme populaire qui peut améliorer les performances de généralisation d'une tâche lorsqu'il est combiné avec des fonctions similaires partageant des paramètres ou des représentations comparables.

Ces dernières années, MTL a été appliqué à de nombreux scénarios de PNL, se concentrant principalement sur l'amélioration des performances des tâches de formation ou de nouveaux domaines en exploitant les signaux des activités pertinentes.

En revanche, le réglage fin basé sur les instructions nous aide à améliorer les performances de généralisation sur des problèmes jamais vus auparavant. Pour ce faire, il demande de combiner toutes les tâches en un concept et de les entraîner ensemble en attribuant les poids du modèle à toutes les tâches.

Qu'est-ce que l'OPT ?

Les modèles linguistiques à grande échelle, les systèmes de traitement du langage naturel avec plus de 100 milliards de paramètres, ont transformé la recherche en PNL et en IA au cours des dernières années.

Formés sur un large éventail de textes divers, ces modèles ont démontré de nouvelles capacités surprenantes pour générer du texte créatif, résoudre des problèmes mathématiques de base, répondre à des questions de compréhension écrite, et bien plus encore.

Bien que dans certains cas, le public puisse interagir avec ces modèles via des API payantes, l'accès complet à la recherche est encore limité à une poignée de laboratoires disposant de ressources suffisantes.

Cet accès restreint limite la capacité des chercheurs à comprendre comment et pourquoi ces grands modèles de langage fonctionnent, ce qui entrave les progrès vers l'amélioration de leur robustesse et l'atténuation des problèmes connus tels que les biais.

Dans le cadre de son engagement en faveur de la science ouverte, Meta AI a publié Open Pretrained Transformer (OPT-175B) en mai de cette année, un modèle avec 175 milliards de paramètres formés sur des ensembles de données publics. En partageant ce modèle, Meta AI espère impliquer le monde. communauté plus large dans la compréhension des techniques fondamentales autour des grands modèles.

En termes simples, Meta ouvre au public l'accès aux modèles de langage à grande échelle utilisés dans la recherche sur l'intelligence artificielle, réalisant ainsi la démocratisation de l'intelligence artificielle dans la recherche sur des modèles à grande échelle.

Comparaison avec l'ancienne version

Selon la version IML désormais publiée par Meta, elle a été affinée et fonctionne mieux sur les tâches en langage naturel que l'ancienne version d'OPT.

Les tâches linguistiques typiques comprennent la réponse aux questions, la synthèse de texte et la traduction.

Pour la mise au point, les chercheurs ont utilisé environ 2 000 tâches en langage naturel. Les tâches sont réparties en huit benchmarks NLP (OPT-IML Bench), également fournis par les chercheurs.

En moyenne, en prenant les modèles 30B et 175B comme exemples, OPT-IML améliore la précision d'apprentissage zéro-shot d'environ 6 à 7 % par rapport à OPT. En 32 époques, le modèle avec 30 milliards de paramètres a montré une amélioration significative de la précision, et le modèle avec 175 milliards de paramètres a montré une légère amélioration.

Après comparaison, l'équipe Meta a constaté que les performances de l'OPT-IML sont meilleures que celles de l'OPT sur tous les benchmarks et sont plus compétitives que les autres modèles basés sur le réglage fin des instructions en termes de tir zéro et de quelques tirs. précision d’apprentissage.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI