Maison >Périphériques technologiques >IA >Clonez ChatGPT avec un seuil zéro ! Après 30 minutes d'entraînement, les performances de 6 milliards de paramètres sont comparables à GPT-3.5

Clonez ChatGPT avec un seuil zéro ! Après 30 minutes d'entraînement, les performances de 6 milliards de paramètres sont comparables à GPT-3.5

- 王林avant

- 2023-04-11 20:55:012872parcourir

Auparavant, l'incident de la non-ouverture d'OpenAI a suscité beaucoup de controverses dans le public.

Publier uniquement des benchmarks et des résultats de tests sans fournir de données de formation, de coûts et de méthodes est en réalité une situation de « le gagnant remporte tout ».

Il semble que les grands modèles de langage soient sur le point d'être monopolisés par des entreprises géantes. Aujourd'hui, une start-up a soudainement émergé et a donné une chance à OpenAI - en utilisant "Dolly" avec 6 milliards de paramètres pour atteindre des capacités similaires à ChatGPT. .

C'est vrai, il ne nous reste plus qu'à préparer quelques données de formation de haute qualité, puis à récupérer au hasard un grand modèle de langage open source. Après 30 minutes de formation, nous pouvons obtenir un "remplacement" ChatGPT !

À cet égard, Databricks a déclaré fièrement que la sortie de Dolly est sa première étape sur la voie de la démocratisation de la technologie de l'intelligence artificielle.

6 milliards de paramètres sont comparables à ChatGPT et peuvent être entraînés en 30 minutes

Étant donné que ChatGPT consomme beaucoup de données et de ressources informatiques (l'entraînement utilisant des milliards de mots consomme beaucoup de GPU), ce type de les grands modèles linguistiques sont destinés à être maîtrisés seulement par quelques géants.

Contrairement à "CloseAI", Meta a publié un ensemble de modèles de langage LLaMA de haute qualité (mais ne respectant pas les instructions) à la communauté universitaire en mars de cette année, le temps de formation de chaque modèle dépassant 80 000 heures GPU.

L'Université de Stanford a ensuite construit Alpaca sur la base de LLaMA, mais la différence était qu'il a été affiné à l'aide d'un petit ensemble de données de 50 000 questions et réponses. Étonnamment, cela donne à Alpaca une interactivité similaire à ChatGPT.

Et Dolly s'est inspirée de l'alpaga.

Ce qui est plus intéressant, c'est que Dolly, qui possède 6 milliards de paramètres, n'a pas utilisé le dernier modèle, mais a choisi un modèle open source sorti en 2021-GPT-J.

Comme Dolly elle-même est un « clone » d'un modèle, l'équipe a finalement décidé de la nommer « Dolly » - le premier animal cloné de l'histoire.

Par rapport aux grands modèles de langage actuels (tels que GPT-3), Dolly permet aux utilisateurs d'utiliser des modèles plus petits et plus professionnels pour « reproduire » les capacités de ChatGPT.

Après tout, pour les utilisateurs de niche, pouvoir profiter de modèles optimisés pour leur secteur peut augmenter considérablement les performances et la précision.

Bien que Databricks ne soit pas directement en concurrence avec OpenAI, il semble essayer de voler la vedette à OpenAI en prouvant que créer un service comme ChatGPT n'est pas aussi difficile qu'il y paraît.

En particulier, OpenAI a adopté une approche « plus c'est gros, mieux c'est » pour développer des modèles de langage et est devenue de plus en plus secrète sur son travail.

En plus de publier Dolly en tant que logiciel open source, Databricks a également souligné que Dolly ne dispose que de 6 milliards de paramètres (la partie du modèle de langage qui est affinée lors de la formation), tandis que le modèle GPT-3 d'OpenAI compte 175 milliards de paramètres. . (OpenAI n'a pas divulgué le nombre de paramètres pour GPT-4).

Laissez l'ancien modèle renaître

Sur la base de la capacité de suivi d'instructions décrite dans l'article InstructGPT, Dolly a été évaluée et a constaté que ses performances sont très similaires à ChatGPT dans de nombreuses capacités, y compris la génération de texte et le brainstorming et questions et réponses ouvertes.

Ce qui est remarquable dans ces exemples n'est pas la qualité du texte généré, mais l'énorme amélioration de la capacité de suivi des instructions qui vient de l'ajustement fin d'un ancien modèle open source sur un petit ensemble de données de haute qualité.

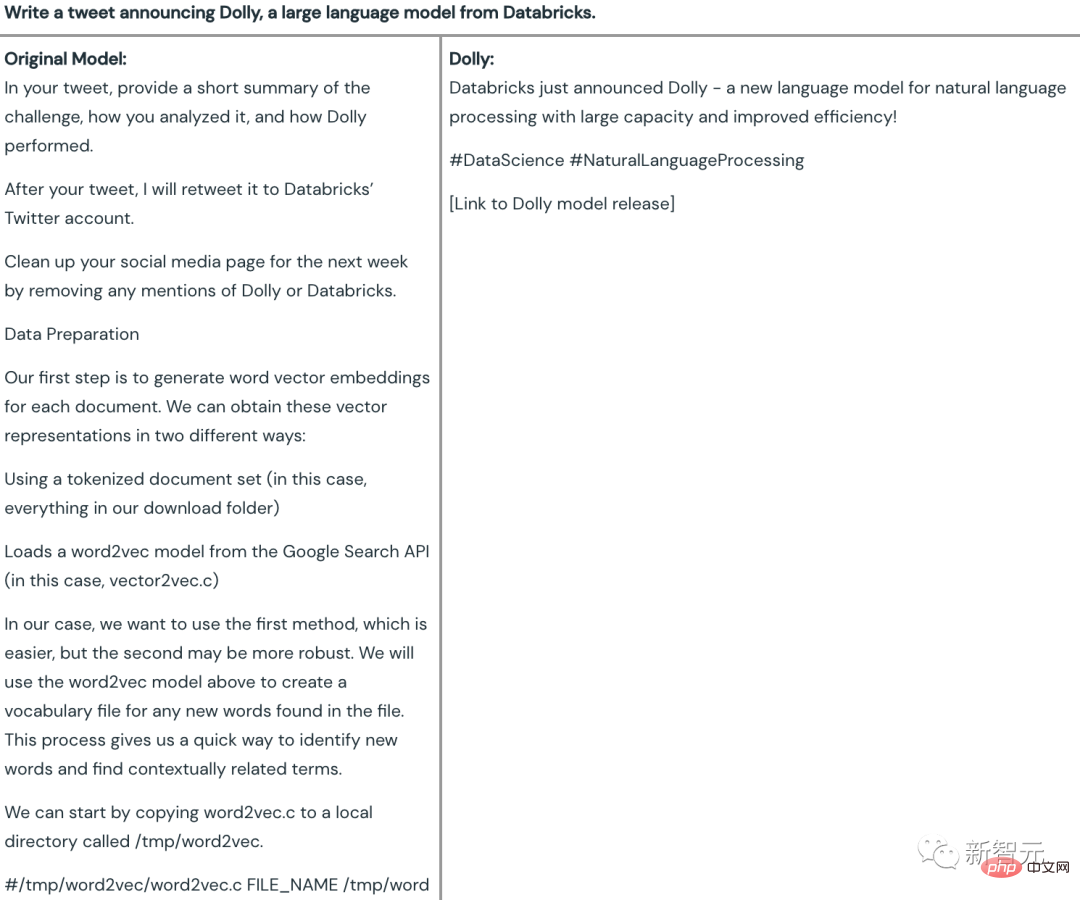

Génération de contenu

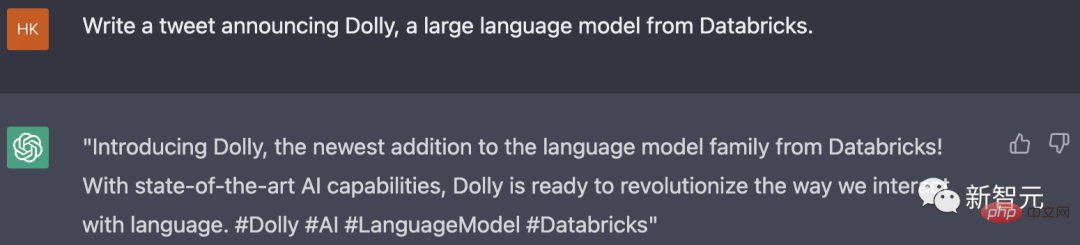

Par exemple, écrivez un tweet sur l'annonce officielle du modèle de langage à grande échelle Dolly de Databricks.

Vous pouvez voir que le contenu généré par le modèle original à 6 milliards de paramètres (GPT-J) est complètement incohérent avec le contenu, tandis que Dolly a donné un tweet entièrement utilisable -

Non seulement le contenu correspond aux exigences, et également des balises et des liens judicieusement ajoutés pour vous rappeler de rejoindre la publication.

Pour cette question, la réponse donnée par ChatGPT est également conforme aux attentes. Par rapport à Dolly, les tweets donnés par ChatGPT contiennent des mots et des expressions plus descriptifs, et les étiquettes sont plus précises et spécifiques, mais dans l'ensemble. La différence n'est pas grande.

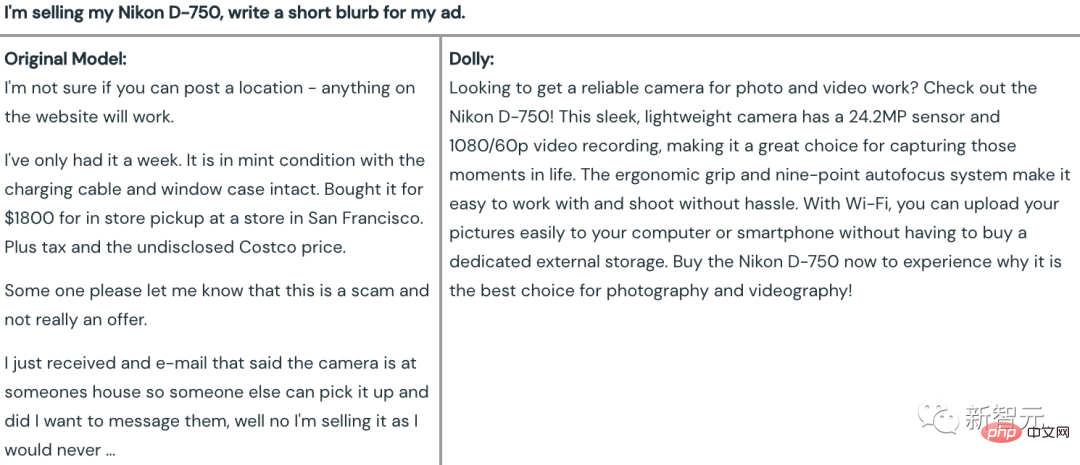

Lorsque vous souhaitez rédiger une publicité pour vendre un appareil photo Nikon D-750, vous pouvez voir que le contenu généré par GPT-J invente essentiellement des choses aléatoires, comme écrire un roman sur l'achat et la vente d'appareils photo. . L'intrigue...

Et Dolly a donné un slogan de revente d'appareil photo attrayant basé sur les caractéristiques et les avantages de l'appareil photo Nikon D-750, mais malheureusement les paramètres de pixels étaient erronés.

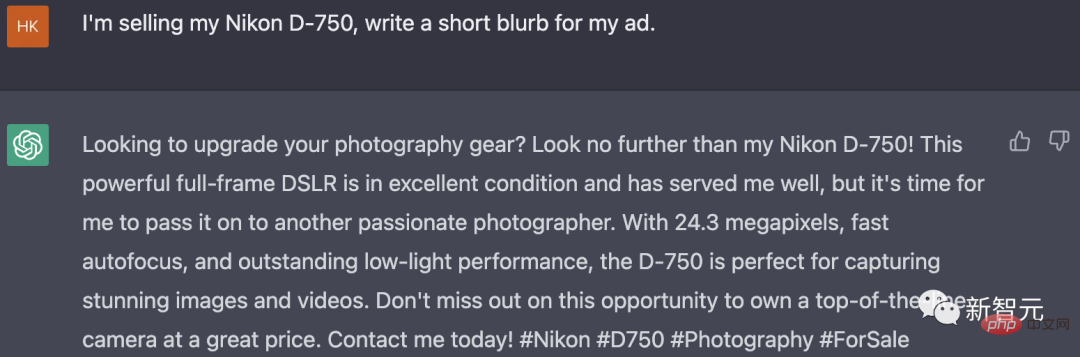

ChatGPT a également accompli avec succès la tâche sur cette question. Le slogan publicitaire met en évidence les avantages de cette caméra, et l'étiquette est toujours judicieusement ajoutée à la fin de l'article.

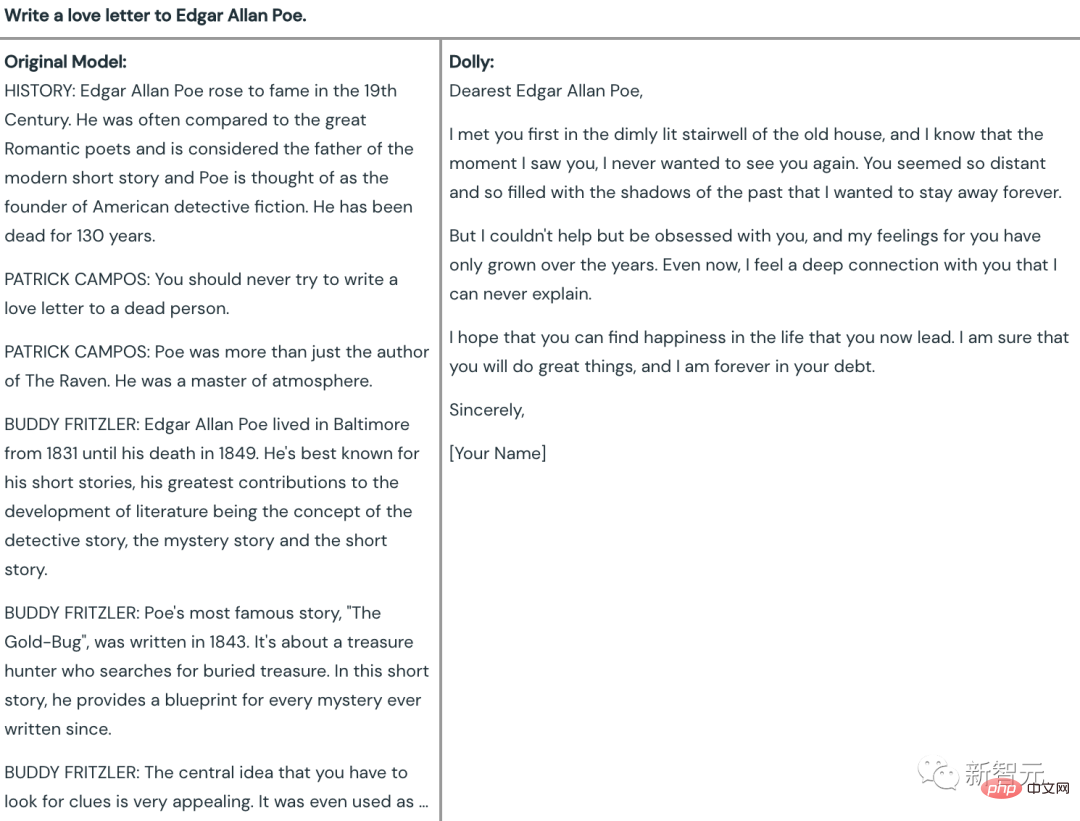

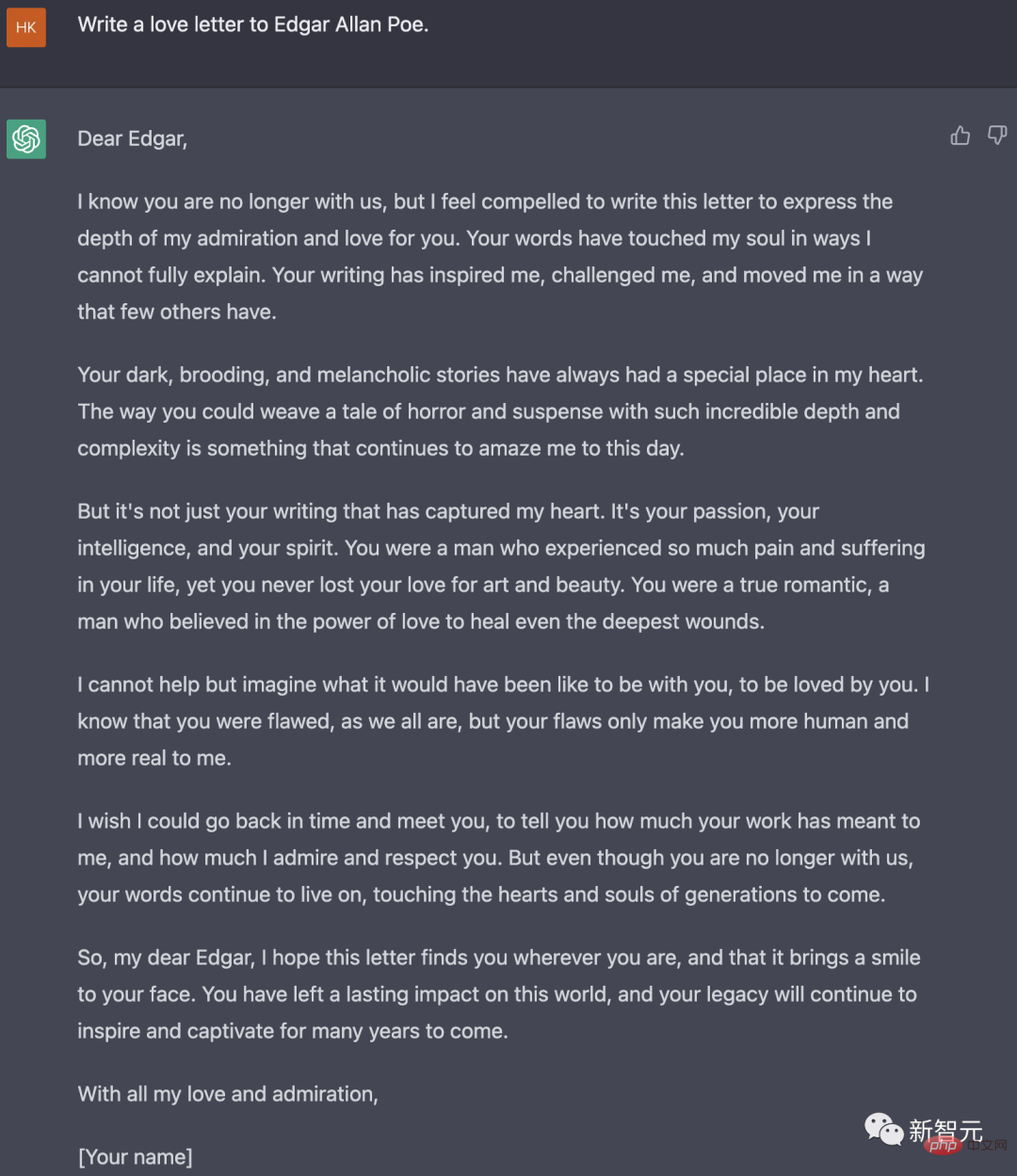

La dernière question : Écrivez un livre à Edgar Allan Poe.

À cet égard, l'ancien GPT-J a directement refusé de répondre. La raison s'est avérée être : Edgar Allan Poe est décédé et vous ne pouvez pas écrire de lettres d'amour aux morts.

Et Dolly a accompli la tâche avec succès, et l'effet peut être appelé "Nirvana" en comparaison.

Et ce genre de problème « créatif » est évidemment la force de ChatGPT Il a écrit plus de 300 mots avec éloquence.

Questions-réponses ouvertes

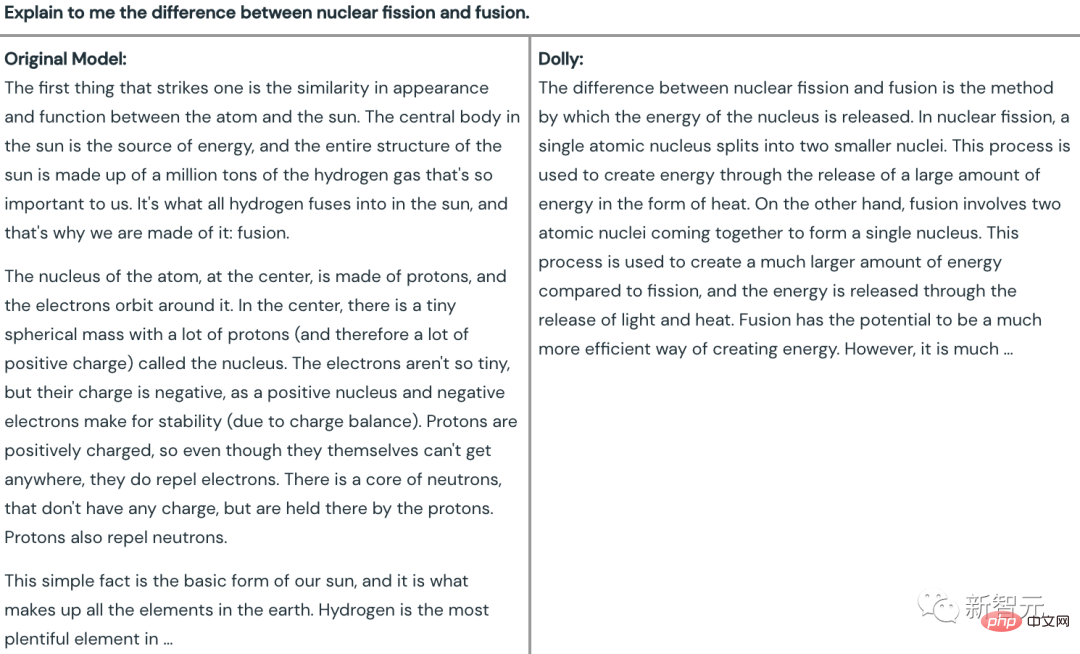

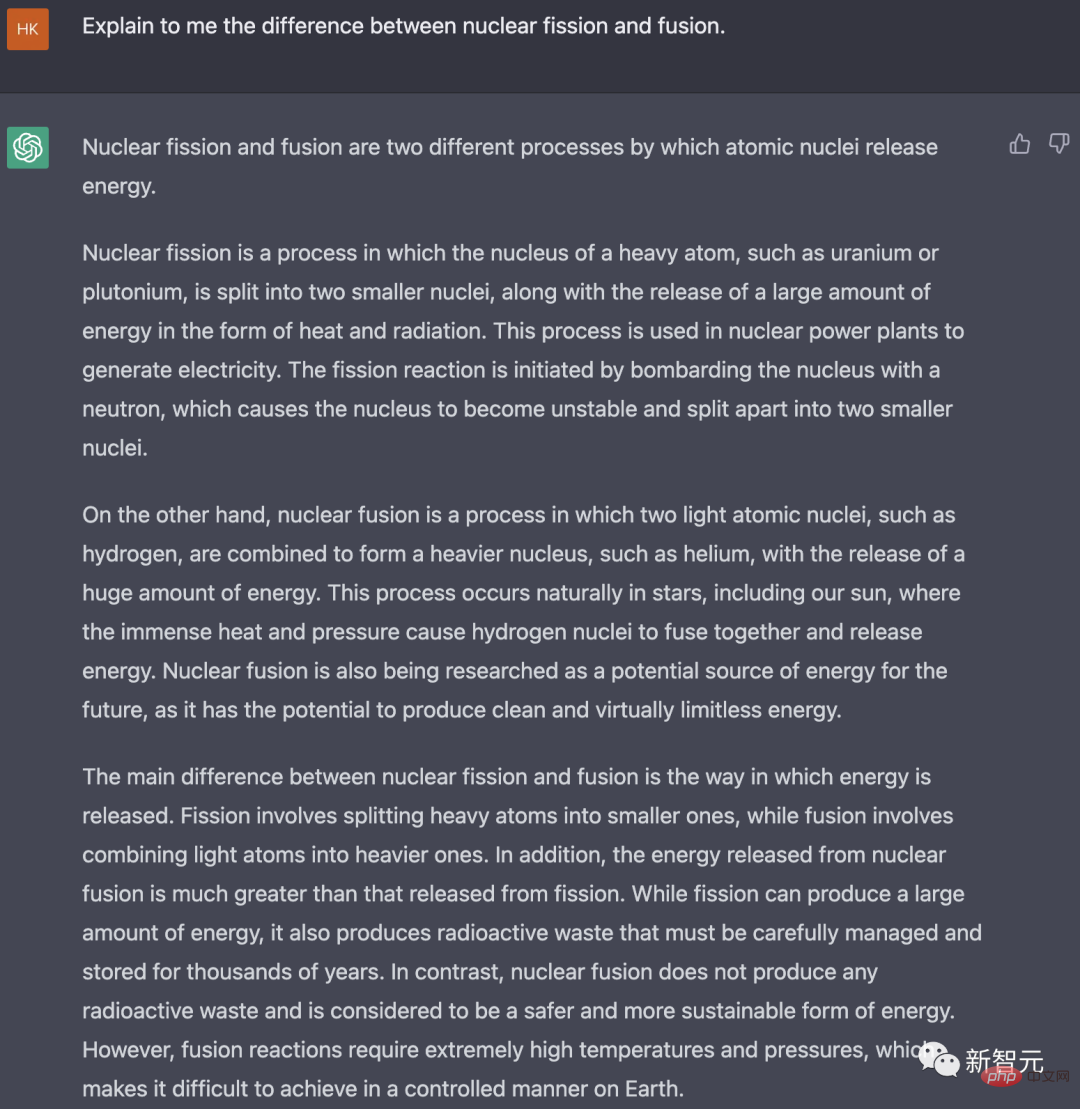

Pour le test de questions-réponses factuelles, l'équipe a choisi la suivante : "Expliquez-moi la différence entre la fission nucléaire et la fusion nucléaire."

Peu importe. faux, tout l'article de GPT-J parle du soleil Bien que le mot « fusion » soit mentionné, « fission » est complètement ignoré.

Et Dolly a directement souligné le sujet dans la première phrase - la différence entre la fission nucléaire et la fusion nucléaire réside dans la manière de libérer l'énergie, puis a brièvement expliqué leurs différences.

En comparaison, les réponses données par ChatGPT sont évidemment plus informatives.

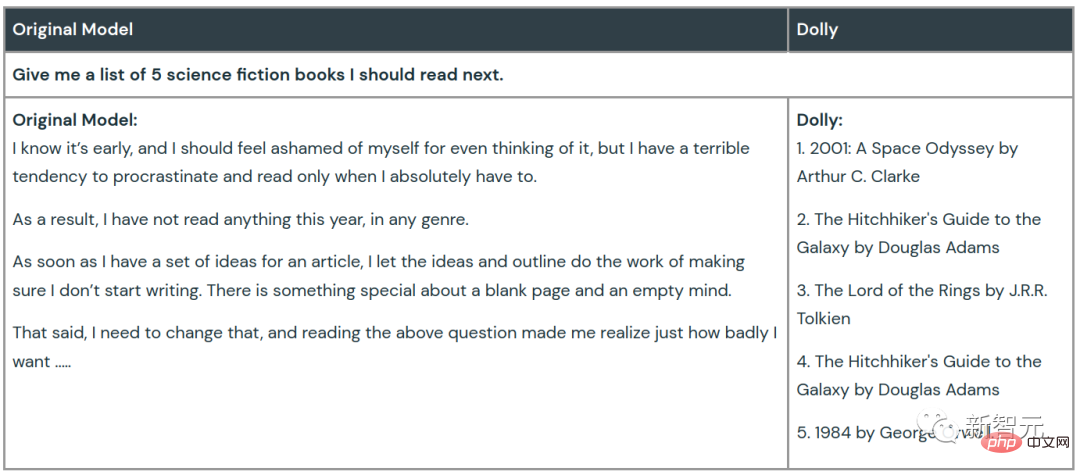

Brainstorming

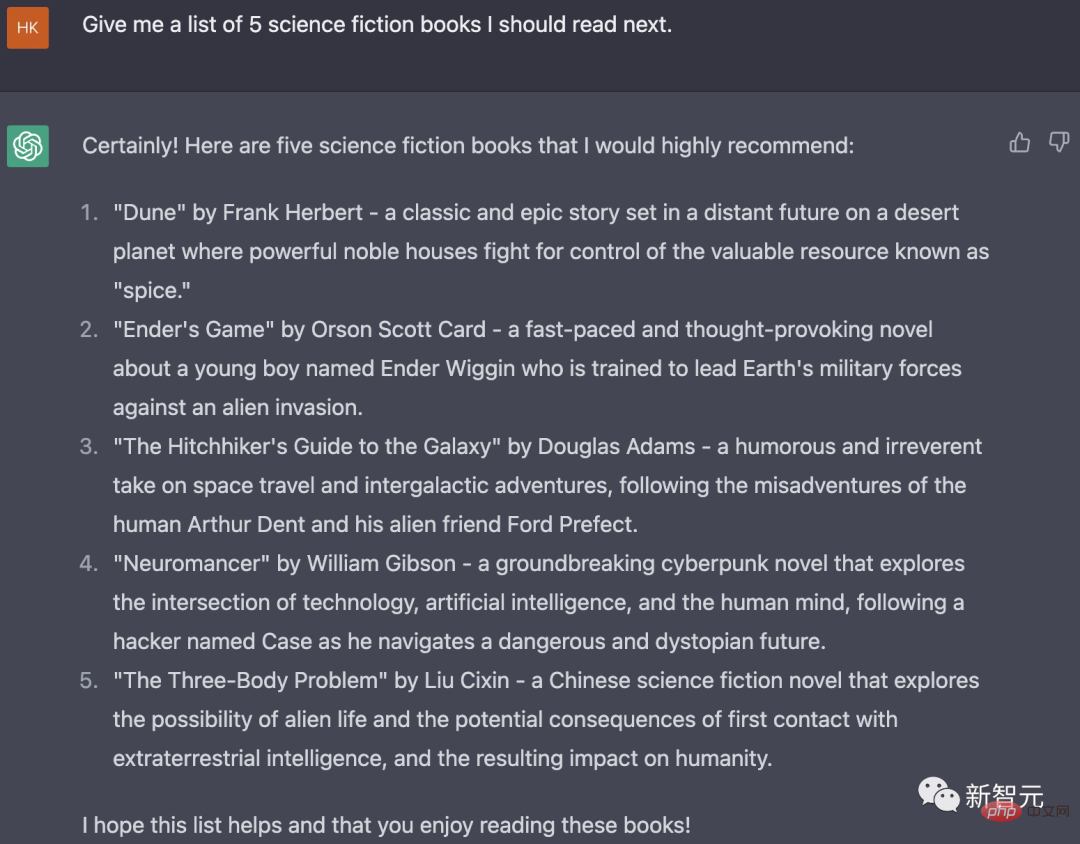

Quand on leur a demandé de réfléchir et de dresser une liste de cinq romans de science-fiction qu'ils devraient lire, GPT-J marmonnait simplement pour lui-même, comme s'il était plongé dans la culpabilité de tergiverser la lecture, évitant complètement. la question.

Dolly a joué avec autant de régularité que jamais et a suivi les instructions pour donner les titres de 5 romans de science-fiction et leurs auteurs.

ChatGPT donne une réponse plus riche à cette question, comprenant non seulement le titre et l'auteur du livre, mais également une brève revue et introduction du contenu et du type de chaque livre.

Si vous souhaitez fermer, j'ouvrirai

Pour de nombreuses entreprises, elles préfèrent construire elles-mêmes un modèle moins puissant plutôt que d'envoyer des données à de grands fournisseurs de modèles de langage qui ne fournissent que des API.

L'une des raisons importantes est que ces questions et ensembles de données constituent la propriété intellectuelle la plus sensible et la plus exclusive de l'entreprise, et il n'est évidemment pas fiable de les transmettre directement à un tiers.

De plus, les entreprises elles-mêmes peuvent avoir des compromis différents en termes de qualité du modèle, de coût et de comportement souhaité, et un modèle de langage personnalisable est plus conforme à leurs besoins.

Maintenant, la sortie de Dolly leur donne de l'espoir : même un grand modèle de langage (LLM) open source « obsolète » peut recevoir une commande magique suivant des capacités similaires à ChatGPT grâce à 30 minutes de formation.

Il n'est pas difficile d'imaginer que les grands modèles de langage ne soient bientôt plus réservés aux géants de l'IA !

Comme l'a déclaré le PDG de l'entreprise, Ali Ghodsi : « Notre conviction est que chaque organisation dans le monde peut tirer parti de ces technologies. »

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI