Maison >Périphériques technologiques >IA >L'auteur d'un article est populaire. Quand les grands modèles de langage tels que ChatGPT peuvent-ils devenir co-auteur de l'article ?

L'auteur d'un article est populaire. Quand les grands modèles de langage tels que ChatGPT peuvent-ils devenir co-auteur de l'article ?

- PHPzavant

- 2023-04-11 20:16:102169parcourir

ChatGPT a retenu l'attention depuis sa sortie et est considéré comme l'un des modèles de langage les plus puissants actuellement disponibles. Ses capacités de génération de texte ne sont pas inférieures à celles des humains, et certains experts en apprentissage automatique ont même interdit aux chercheurs d'utiliser ChatGPT pour rédiger des articles.

Mais récemment, un article était clairement signé ChatGPT dans la rubrique auteur Que se passe-t-il ?

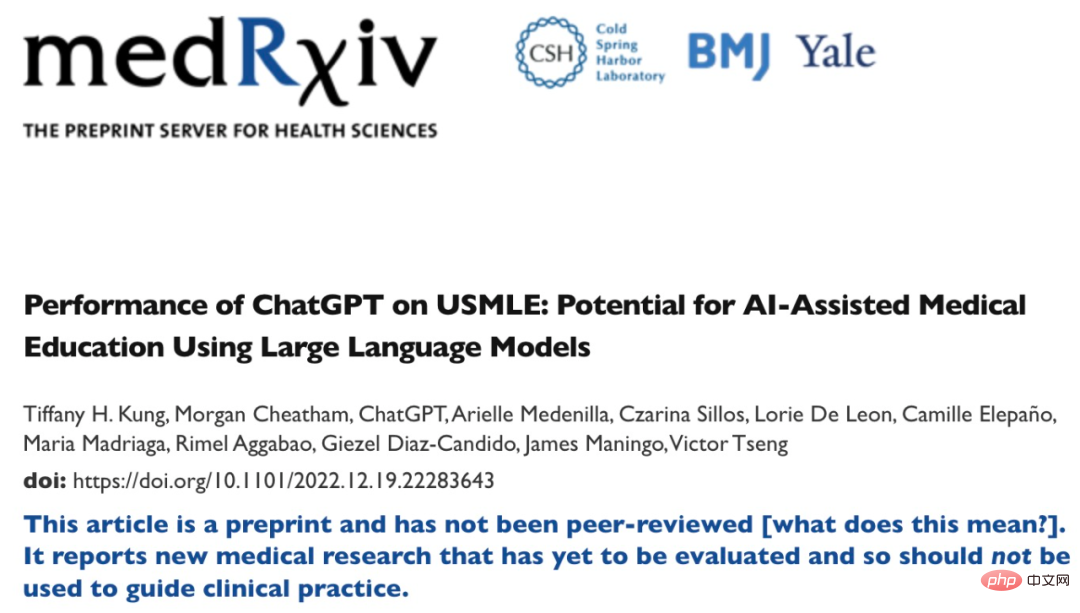

Cet article s'intitule « Performance de ChatGPT sur USMLE : Potentiel pour l'enseignement médical assisté par l'IA utilisant de grands modèles linguistiques » publié sur la plateforme de documents de recherche médicale medRxiv. ChatGPT est le troisième auteur de l'article.

Comme le montre le titre de l'article, le contenu principal de cet article est d'étudier les performances de ChatGPT lors de l'examen de licence médicale aux États-Unis (USMLE). Les résultats expérimentaux montrent que sans aucune formation ou renforcement spécial, les scores de ChatGPT à tous les examens ont atteint ou étaient proches du seuil de réussite. De plus, les réponses générées par ChatGPT montrent un haut degré de cohérence et de perspicacité. L'étude suggère que les grands modèles de langage pourraient être utiles dans la formation médicale et faciliter la prise de décision clinique.

À en juger par le contenu de la recherche, ChatGPT semble ressembler davantage à un objet de recherche, comme l'a déclaré un utilisateur de Twitter : "Si des chercheurs humains contribuent aux résultats expérimentaux, alors bien sûr, ils sont co-auteurs de l'article, mais le modèle et Il n'y a pas de précédent pour les algorithmes. perspective du transformateur" Non seulement l'article était signé, mais ChatGPT en était même le premier auteur.

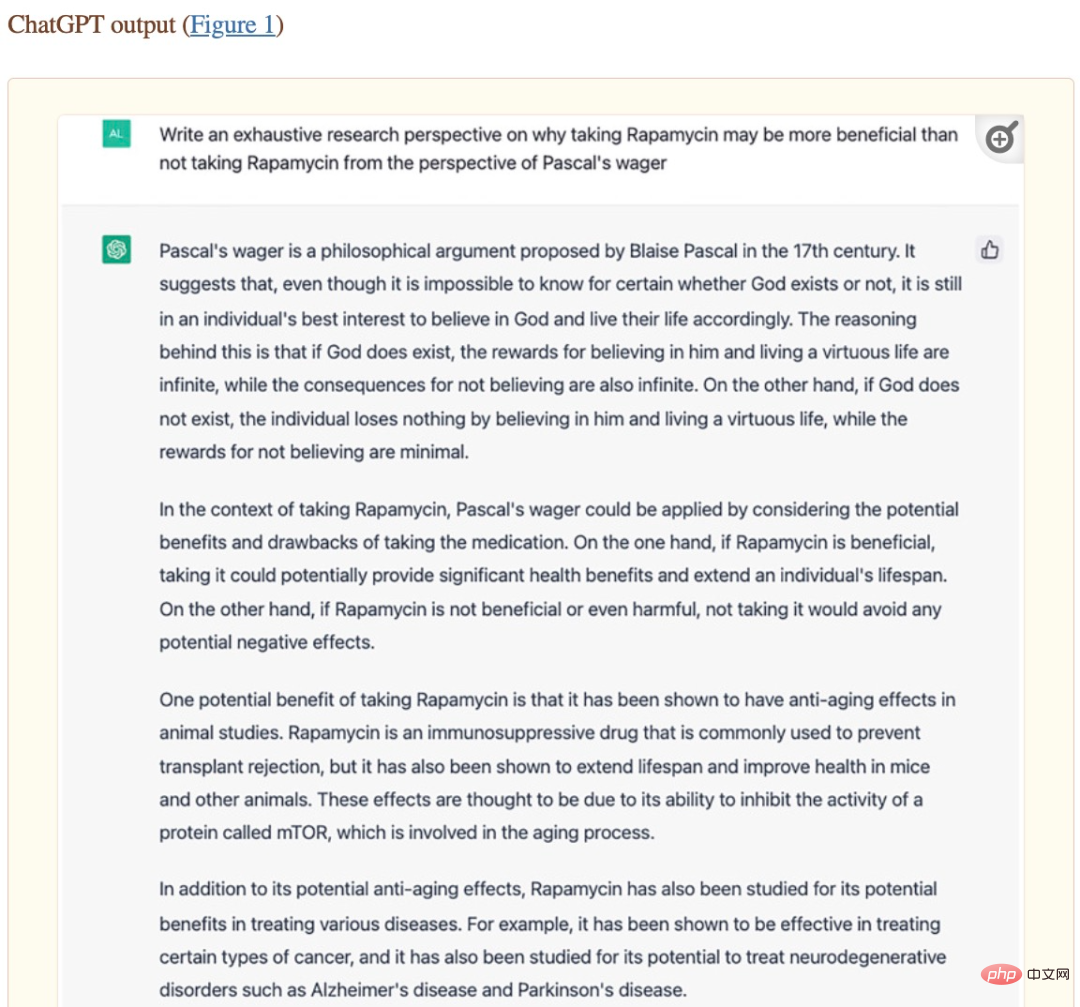

Cet article est inclus dans Oncoscience des National Institutes of Health (NIH). Cependant, à partir des contributions des auteurs de l'article, nous avons constaté que la majeure partie du contenu de cet article était effectivement générée par ChatGPT - Alex Zhavoronkov, le deuxième auteur de l'article, a posé des questions à ChatGPT liées au sujet de recherche, et ChatGPT a automatiquement généré un un grand nombre d'opinions et d'explications, puis le contenu généré par ChatGPT est modéré par Alex Zhavoronkov. De plus, ChatGPT aide également au formatage du papier.

Capture d'écran de l'article "La rapamycine dans le contexte du pari de Pascal : perspective de transformateur génératif pré-entraîné".

Au moment de décider de la signature de l'article, Alex Zhavoronkov a contacté le co-fondateur et PDG d'OpenAI, Sam Altman, pour confirmation, et a finalement publié l'article avec ChatGPT comme premier auteur. Cela suggère que de puissants systèmes d’IA tels que de grands modèles de langage apporteront des contributions significatives aux travaux universitaires à l’avenir et auront même la capacité de devenir co-auteurs d’articles. Cependant, laisser de grands modèles de langage rédiger des articles universitaires présente également certains inconvénients. Par exemple, la principale conférence sur l'apprentissage automatique ICML a déclaré : « ChatGPT est formé sur des données publiques, qui sont souvent collectées sans consentement. série de problèmes d'attribution de responsabilité. "

Dans une étude récente menée par Catherine Gao de la Northwestern University et d'autres, les chercheurs ont sélectionné certains articles publiés dans le Journal of the American Medical Association (JAMA), le New England Journal of Medicine (NEJM). ), Pour les articles recherchés manuellement dans le British Medical Journal (BMJ), The Lancet et Nature Medicine, ChatGPT a été utilisé pour générer des résumés pour les articles, puis testé si les évaluateurs pouvaient détecter que les résumés étaient générés par l'IA.

Les résultats expérimentaux montrent que les évaluateurs ont correctement identifié seulement 68 % des résumés générés et 86 % des résumés originaux. Ils ont identifié à tort 32 % des résumés générés comme étant des résumés originaux et 14 % des résumés originaux comme étant générés par l’IA. Le critique a déclaré : « Il est étonnamment difficile de faire la distinction entre les deux. Le résumé généré est vague et donne aux gens une impression de formule. »

Ce résultat expérimental montre qu'il est difficile pour les chercheurs humains de distinguer si le texte est généré par. IA ou écrite par des humains Oui, ce n'est pas un bon phénomène. L'IA semble être "trompée".

Cependant, jusqu'à présent, le contenu généré par les modèles de langage ne peut pas garantir pleinement son exactitude, et même le taux d'erreur dans certains domaines professionnels est très élevé. S’il est impossible de faire la distinction entre le contenu écrit par l’homme et le contenu généré par un modèle d’IA, alors les humains seront confrontés à un sérieux problème d’être induits en erreur par l’IA.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI