Maison >Périphériques technologiques >IA >Jeu terminé? La bataille entre une IA forte et une IA faible

Jeu terminé? La bataille entre une IA forte et une IA faible

- 王林avant

- 2023-04-11 20:07:171507parcourir

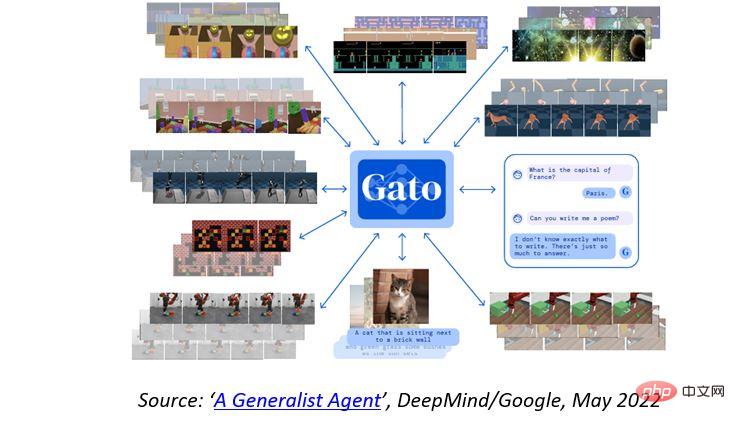

Depuis que DeepMind, filiale d'intelligence artificielle (IA) de Google, a publié il y a quelques semaines un article décrivant un agent « généraliste » qu'ils appellent Gato (un agent qui peut effectuer différentes tâches en utilisant le même modèle entraîné), affirmant que l'intelligence artificielle générale (AGI) peut être réalisé à grande échelle, ce qui a déclenché un débat féroce dans l’industrie de l’intelligence artificielle. Même si cela peut paraître un peu académique, la réalité est que si l’intelligence artificielle générale est à nos portes, notre société – y compris nos lois, nos réglementations et nos modèles économiques – ne sera pas prête.

En effet, grâce au même modèle entraîné, l'agent généraliste Gato est capable de jouer à Atari, d'ajouter des légendes aux images, de discuter ou d'empiler des blocs avec un véritable bras robotique. Il peut également décider d'afficher du texte, de connecter le couple, d'appuyer sur des boutons ou d'autres marqueurs en fonction de son contexte. Il semble donc s'agir d'un modèle d'IA plus général que les populaires GPT-3, DALL-E 2, PaLM ou Flamingo, qui deviennent très efficaces dans des tâches spécifiques très précises, telles que l'écriture en langage naturel, la compréhension du langage ou la création d'une image basée sur une image. sur le descriptif.

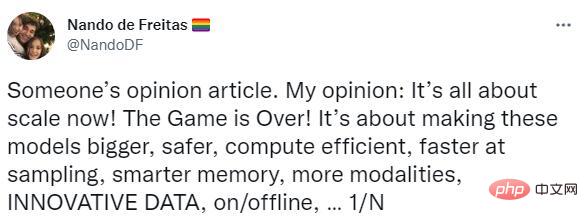

Cela a amené Nando de Freitas, scientifique de DeepMind et professeur à l'Université d'Oxford, à affirmer que "tout est désormais une question d'échelle ! Game over !" et a estimé que l'intelligence générale artificielle (AGI) pouvait être réalisée à grande échelle (c'est-à-dire des modèles plus grands, plus grands). ensembles de données de formation et une plus grande puissance de calcul). Cependant, « de quel jeu » parle de Freitas ? De quoi parle réellement ce débat ?

Le débat sur l'intelligence artificielle : IA forte contre IA faible

Avant d'aborder les détails de ce débat et son impact sur la société au sens large, il convient de prendre du recul et de comprendre le contexte.

Le sens du terme « Intelligence Artificielle » a changé au fil des années, mais d'un point de vue général et de haut niveau, il peut être défini comme le domaine d'étude des agents intelligents, qui désigne tout agent qui perçoit son environnement et un système qui prend des mesures pour maximiser les chances d’atteindre ses objectifs. Cette définition laisse délibérément de côté la question de savoir si les agents ou les machines peuvent réellement « penser », une question qui fait depuis longtemps l’objet de débats houleux. En 1950, le mathématicien britannique Alan Turing affirmait dans son célèbre article « The Imitation Game » qu'au lieu de se demander si une machine peut penser, il vaut mieux se concentrer sur « si une machine est susceptible de présenter un comportement intelligent ».

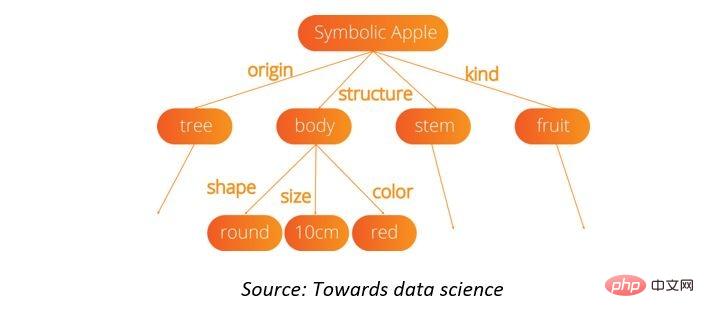

Cette distinction conduit conceptuellement à deux branches principales de l'intelligence artificielle : l'intelligence artificielle forte et l'intelligence artificielle faible. L’IA forte, également connue sous le nom d’intelligence artificielle générale (AGI), est une forme théorique d’intelligence artificielle dans laquelle les machines nécessitent la même intelligence que les humains. En tant que tel, il sera conscient de lui-même et aura la capacité de résoudre des problèmes, d’apprendre et de planifier l’avenir. Il s’agit de la définition la plus ambitieuse de l’intelligence artificielle, le « Saint Graal de l’intelligence artificielle » – mais pour l’instant, cela reste une pure théorie. Les approches pour parvenir à une IA forte s’articulent souvent autour de l’IA symbolique, dans laquelle les machines forment des représentations symboliques internes du « monde » physique et abstrait afin que des règles ou un raisonnement puissent être appliqués pour apprendre davantage et prendre des décisions.

Bien que les recherches dans ce domaine se poursuivent, elles n'ont jusqu'à présent eu qu'un succès limité dans la résolution de problèmes réels, car les représentations internes ou symboliques du monde deviennent rapidement ingérables à mesure qu'elles évoluent.

L'IA faible, également connue sous le nom d'« IA étroite », est une approche moins ambitieuse de l'IA qui se concentre sur l'exécution de tâches spécifiques, telles que répondre à des questions basées sur la saisie de l'utilisateur, reconnaître des visages ou jouer aux échecs, tout en s'appuyant sur l'intervention humaine pour définir les paramètres de son algorithme d’apprentissage et fournir des données de formation pertinentes pour garantir l’exactitude.

Cependant, des progrès significatifs ont été réalisés dans le domaine de l’intelligence artificielle faible, des exemples bien connus incluent les algorithmes de reconnaissance faciale, les modèles de langage naturel (comme le GPT-n d’OpenAI), les assistants virtuels (comme Siri ou Alexa), le programme d’échecs de Google/DeepMind. AlphaZero, et dans une certaine mesure les voitures sans conducteur.

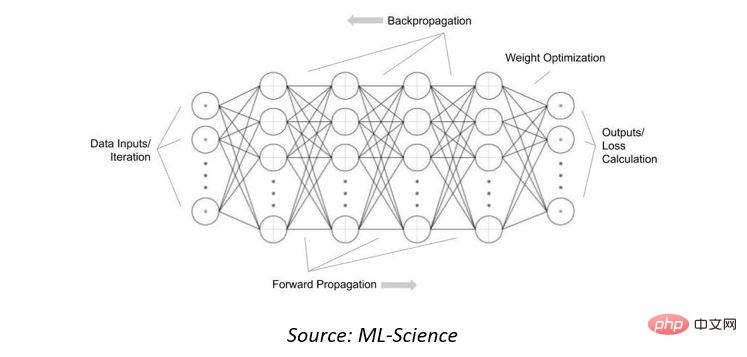

Les méthodes permettant d'atteindre une intelligence artificielle faible tournent souvent autour de l'utilisation de réseaux de neurones artificiels, des systèmes inspirés des réseaux de neurones biologiques qui composent le cerveau des animaux. Ce sont des ensembles de nœuds ou de neurones interconnectés, combinés à une fonction d'activation qui détermine la sortie en fonction des données présentées dans une « couche d'entrée » et des poids dans les interconnexions. Afin d'ajuster les pondérations dans les interconnexions afin que la « sortie » soit utile ou correcte, le réseau peut être « entraîné » en l'exposant à de nombreux exemples de données et en « rétropropagant » la perte de sortie.

On peut dire qu'il existe une troisième branche appelée « intelligence artificielle neuro-symbolique », qui combine les réseaux de neurones et l'intelligence artificielle basée sur des règles. Bien que conceptuellement prometteur et solide dans la mesure où il semble plus proche du fonctionnement de notre cerveau biologique, il en est encore à ses tout premiers stades.

Est-ce vraiment une question d’échelle ?

La clé du débat actuel est de savoir si, avec des modèles d’IA et d’apprentissage automatique d’une échelle suffisante, l’intelligence artificielle générale (AGI) peut réellement être réalisée, éliminant ainsi complètement l’intelligence artificielle symbolique. S’agit-il désormais simplement d’une mise à l’échelle et d’une optimisation du matériel, ou devons-nous découvrir et développer davantage d’algorithmes et de modèles d’IA ?

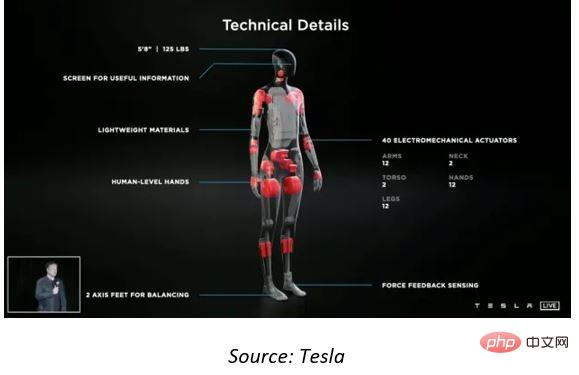

Tesla semble également accepter le point de vue de Google/DeepMind. Lors de l'événement de la Journée de l'intelligence artificielle (IA) 2021, Tesla a annoncé le lancement de Tesla Bot, également connu sous le nom d'Optimus, un robot humanoïde universel qui sera développé par Tesla et contrôlé par le même système d'IA développé pour les systèmes avancés d'aide à la conduite utilisés dans son voitures. Il est intéressant de noter que le PDG de l'entreprise, Elon Musk, a déclaré qu'il espérait que le robot serait en production d'ici 2023, affirmant qu'Optimus Prime serait éventuellement capable de faire « tout ce qu'un humain ne voudrait pas faire », ce qui signifie qu'il s'attend à ce qu'AGI soit alors possible.

Cependant, d'autres groupes de recherche sur l'IA, notamment Yann LeCun, scientifique en chef de l'IA chez Meta et professeur à l'Université de New York, qui préfère le terme moins ambitieux d'intelligence artificielle au niveau humain (HLAI), affirment qu'il reste encore de nombreuses questions. Les problèmes qui doivent être résolus, et qui ne peuvent être résolus par la seule puissance de calcul, peuvent nécessiter de nouveaux modèles, voire des paradigmes logiciels.

Dans ces problèmes, la machine a la capacité de comprendre comment le monde fonctionne grâce à une observation semblable à celle d'un bébé, de prédire comment il affectera le monde à travers ses actions, de gérer l'imprévisibilité inhérente du monde et de prédire l'impact de une série d’actions. Cela permet le raisonnement et la planification, ainsi que la représentation et la prédiction dans l’espace abstrait. En fin de compte, le débat est de savoir si cela peut être réalisé par un apprentissage basé sur les gradients avec uniquement nos réseaux de neurones artificiels existants, ou si des avancées supplémentaires sont nécessaires.

Bien que les modèles d'apprentissage profond soient effectivement capables de produire des « fonctionnalités clés » à partir de données sans nécessiter d'intervention humaine, il est facile de croire qu'ils seront capables d'exploiter davantage de données et de puissance de calcul pour exploiter et résoudre les problèmes restants. question, mais c’est peut-être trop beau pour être vrai. Pour utiliser une analogie simple, concevoir et construire des voitures plus rapides et plus puissantes ne les fera pas voler, car nous devons d’abord bien comprendre l’aérodynamique pour résoudre le problème du vol.

Les progrès réalisés grâce à l'utilisation des modèles d'IA d'apprentissage profond sont impressionnants, mais il convient de se demander si la vision optimiste des praticiens faibles de l'IA est simplement une affaire de marteau de Maslow ou de la « loi des outils », c'est-à-dire « si vous êtes le seul outil que vous avoir est un marteau et vous avez tendance à voir chaque problème comme un clou.

Game over ou travailler ensemble ?

La recherche fondamentale comme Google/DeepMind, Meta ou Tesla met souvent le secteur privé mal à l'aise car malgré leurs budgets importants, ces organisations sont souvent plus orientées vers la concurrence et la rapidité de mise sur le marché que vers la collaboration universitaire et la réflexion à long terme.

La résolution de l’intelligence artificielle générale peut nécessiter deux approches, plutôt qu’une compétition entre partisans forts et faibles de l’IA. Il n’est pas exagéré de faire une analogie avec le cerveau humain, qui possède des capacités d’apprentissage à la fois conscientes et inconscientes. Notre cervelet représente environ 10 % du volume du cerveau mais contient plus de 50 % du nombre total de neurones et est responsable de la coordination et des mouvements liés aux capacités motrices, en particulier des mains et des pieds, ainsi que du maintien de la posture et de l'équilibre. Cela se fait rapidement et inconsciemment, et nous ne pouvons pas vraiment expliquer comment nous le faisons. Cependant, notre cerveau conscient, bien que beaucoup plus lent, est capable de traiter des concepts abstraits, de planifier et de prédire. De plus, il est possible d’acquérir consciemment des connaissances et, grâce à l’entraînement et à la répétition, de parvenir à l’automatisation – un domaine dans lequel les athlètes professionnels excellent.

On ne peut s’empêcher de se demander, si la nature a fait évoluer le cerveau humain de manière si hybride sur des centaines de milliers d’années, pourquoi le système d’intelligence artificielle moyen s’appuie sur un seul modèle ou algorithme.

Impact sur la société et les investisseurs

Indépendamment de la technologie d'IA sous-jacente spécifique qui mènera à terme à l'intelligence artificielle générale, cet événement aura un impact énorme sur notre société - tout comme la roue, la machine à vapeur, l'électricité ou l'ordinateur. On peut soutenir que si les entreprises parviennent à remplacer complètement les humains par des robots, notre modèle économique capitaliste devra changer, sinon des troubles sociaux finiront par s’ensuivre.

Cela dit, il est probable que le débat en cours ressemble un peu à celui des relations publiques d’entreprise, et la réalité est que l’intelligence artificielle générale est plus lointaine qu’on ne le pense actuellement, nous avons donc le temps d’aborder son impact potentiel. Toutefois, à court terme, il est clair que la poursuite de l’intelligence artificielle générale continuera de stimuler les investissements dans des domaines technologiques spécifiques, tels que les logiciels et les semi-conducteurs.

Le succès de cas d'utilisation spécifiques dans le cadre d'une IA faible a conduit à une pression croissante sur nos capacités matérielles existantes. Par exemple, le modèle populaire Generative Pre-Trained Transformer 3 (GPT-3) OpenAI lancé en 2020, qui peut déjà écrire de la prose brute avec une fluidité semblable à celle d'un humain, comporte 175 milliards de paramètres et prend plusieurs mois pour s'entraîner.

On peut dire que certains des produits semi-conducteurs existants – notamment les processeurs, les GPU et les FPGA – sont capables de calculer plus ou moins efficacement des algorithmes d’apprentissage en profondeur. Cependant, à mesure que la taille des modèles augmente, leurs performances deviennent insatisfaisantes et il devient nécessaire de concevoir des conceptions personnalisées optimisées pour les charges de travail d'IA. Les principaux fournisseurs de cloud tels qu'Amazon, Alibaba, Baidu et Google ont emprunté cette voie, ainsi que Tesla et diverses startups de semi-conducteurs telles que Cambrian, Cerebras, Esperanto, Graphcore, Groq, Mythic et Sambanova.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI