Maison >Périphériques technologiques >IA >ChatGPT peut choisir lui-même les modèles ! Le nouvel article de l'Institut de recherche Microsoft en Asie et de l'Université du Zhejiang, le projet HuggingGPT, est open source

ChatGPT peut choisir lui-même les modèles ! Le nouvel article de l'Institut de recherche Microsoft en Asie et de l'Université du Zhejiang, le projet HuggingGPT, est open source

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-11 08:41:021062parcourir

L'engouement pour l'IA déclenché par ChatGPT a également "brûlé" le cercle financier.

Récemment, des chercheurs de Bloomberg ont également développé un GPT dans le domaine financier - Bloomberg GPT, avec 50 milliards de paramètres.

L'émergence de GPT-4 a donné à de nombreuses personnes un avant-goût des puissantes capacités des grands modèles de langage.

Cependant, OpenAI n'est pas ouvert. De nombreuses personnes dans l'industrie ont commencé à cloner GPT, et de nombreux modèles de remplacement de ChatGPT sont construits sur des modèles open source, en particulier le modèle open source Meta LLMa.

Par exemple, Stanford’s Alpaca, UC Berkeley ont fait équipe avec CMU, Stanford et autres Vicuna, Dolly de la startup Databricks, etc.

Divers modèles de langage à grande échelle de type ChatGPT, conçus pour différentes tâches et applications, sont en compétition entre des centaines d'écoles de pensée dans l'ensemble du domaine.

La question est alors de savoir comment les chercheurs choisissent-ils un modèle approprié, voire plusieurs modèles, pour accomplir une tâche complexe ?

Récemment, l'équipe de recherche de Microsoft Research Asia et de l'Université du Zhejiang a publié HuggingGPT, un système de collaboration à grande échelle.

Adresse papier : https://arxiv.org/pdf/2303.17580.pdf

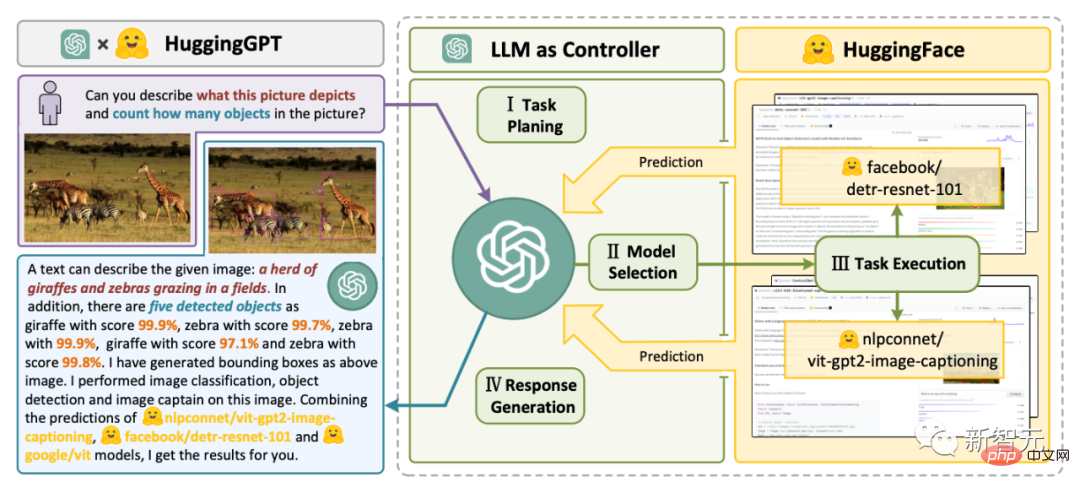

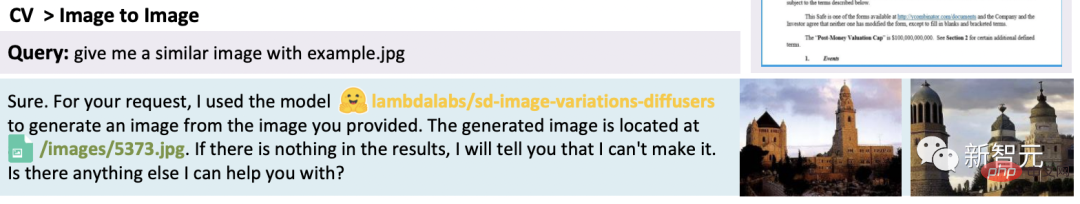

HuggingGPT utilise ChatGPT comme contrôleur pour connecter divers modèles d'IA dans la communauté HuggingFace afin de compléter le complexe multimodal tâches.

Cela signifie que vous aurez une sorte de super magie. Grâce à HuggingGPT, vous pourrez disposer de capacités multimodales, notamment des images, des vidéos et des voix.

HuggingGPT bridge

Les chercheurs ont souligné que la résolution des problèmes actuels des grands modèles de langage (LLM) pourrait être la première et cruciale étape vers l'AGI.

Étant donné que la technologie actuelle des grands modèles de langage présente encore certaines lacunes, il existe des défis urgents sur la voie de la construction de systèmes AGI.

- Limités par les formes d'entrée et de sortie de génération de texte, les LLM actuels n'ont pas la capacité de traiter des informations complexes (telles que la vision et la parole)

- Dans des scénarios d'application pratiques, certaines tâches complexes sont généralement composé de plusieurs Il se compose de sous-tâches, nécessitant ainsi la planification et la collaboration de plusieurs modèles, ce qui dépasse également les capacités des modèles de langage

- Pour certaines tâches difficiles, les LLM fonctionnent bien en mode zéro ou ; réglages pour quelques prises de vues Excellents résultats, mais ils restent plus faibles que ceux de certains experts (comme les modèles affinés).

Pour gérer des tâches d'IA complexes, les LLM doivent être capables de se coordonner avec des modèles externes pour exploiter leurs capacités. Par conséquent, le point clé est de savoir comment choisir le middleware approprié pour relier les modèles LLM et IA.

Les chercheurs ont découvert que chaque modèle d'IA peut être exprimé sous forme de langage en résumant ses fonctions de modèle.

Ainsi, un concept est introduit, "Le langage, ce sont les LLM, à savoir ChatGPT, une interface universelle pour connecter des modèles d'intelligence artificielle."

En incorporant des descriptions de modèles d'IA dans les invites, ChatGPT peut être considéré comme le cerveau de la gestion des modèles d'IA. Par conséquent, cette méthode permet à ChatGPT d'appeler des modèles externes pour résoudre des tâches pratiques.

Pour parler simplement, HuggingGPT est un système de collaboration, pas un grand modèle.

Sa fonction est de connecter ChatGPT et HuggingFace pour traiter les entrées dans différentes modalités et résoudre de nombreuses tâches complexes d'intelligence artificielle.

Ainsi, chaque modèle d'IA de la communauté HuggingFace a une description de modèle correspondante dans la bibliothèque HuggingGPT et est intégrée dans l'invite pour établir une connexion avec ChatGPT.

HuggingGPT utilise ensuite ChatGPT comme cerveau pour déterminer la réponse à la question.

Jusqu'à présent, HuggingGPT a intégré des centaines de modèles sur HuggingFace autour de ChatGPT, couvrant 24 modèles comprenant la classification de texte, la détection de cible, la segmentation sémantique, la génération d'images, les questions et réponses, la synthèse vocale, la synthèse textuelle, etc. Tâche.

Les résultats expérimentaux prouvent que HuggingGPT a la capacité de gérer des informations multimodales et des tâches complexes d'intelligence artificielle.

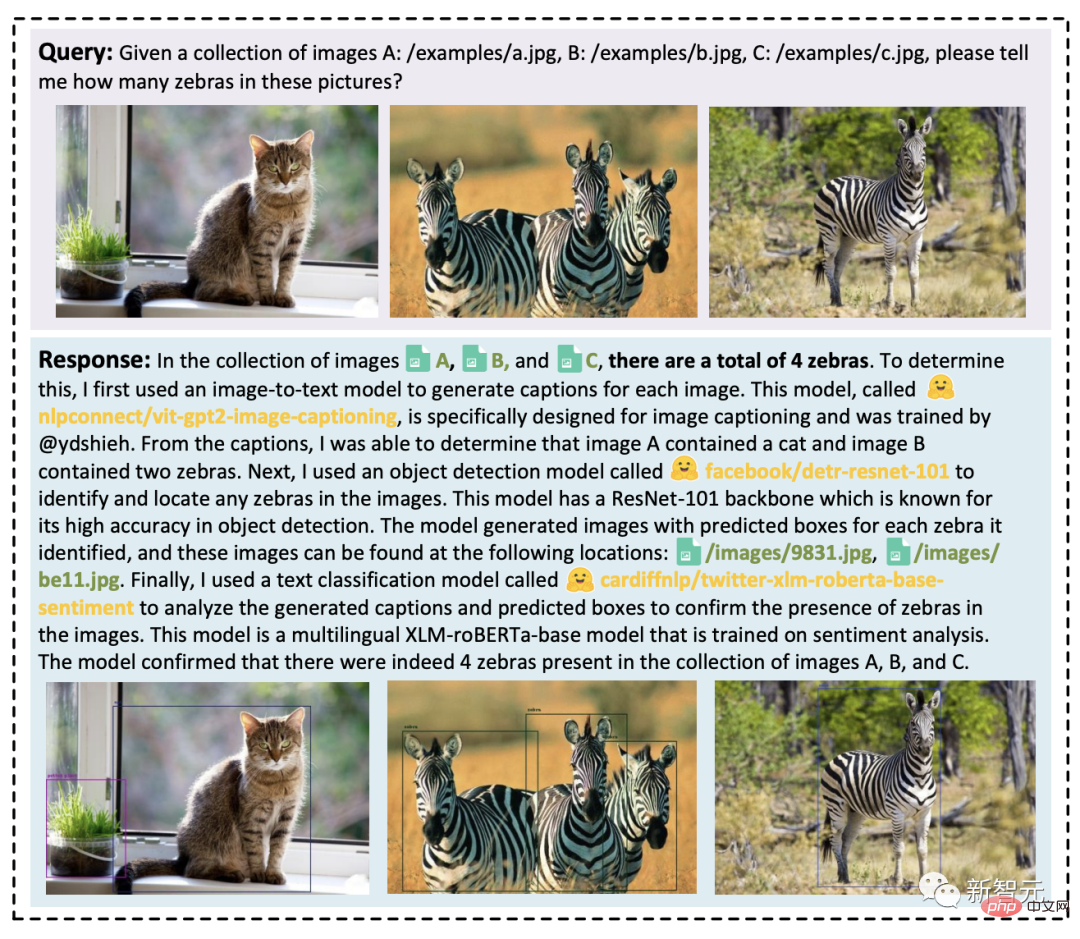

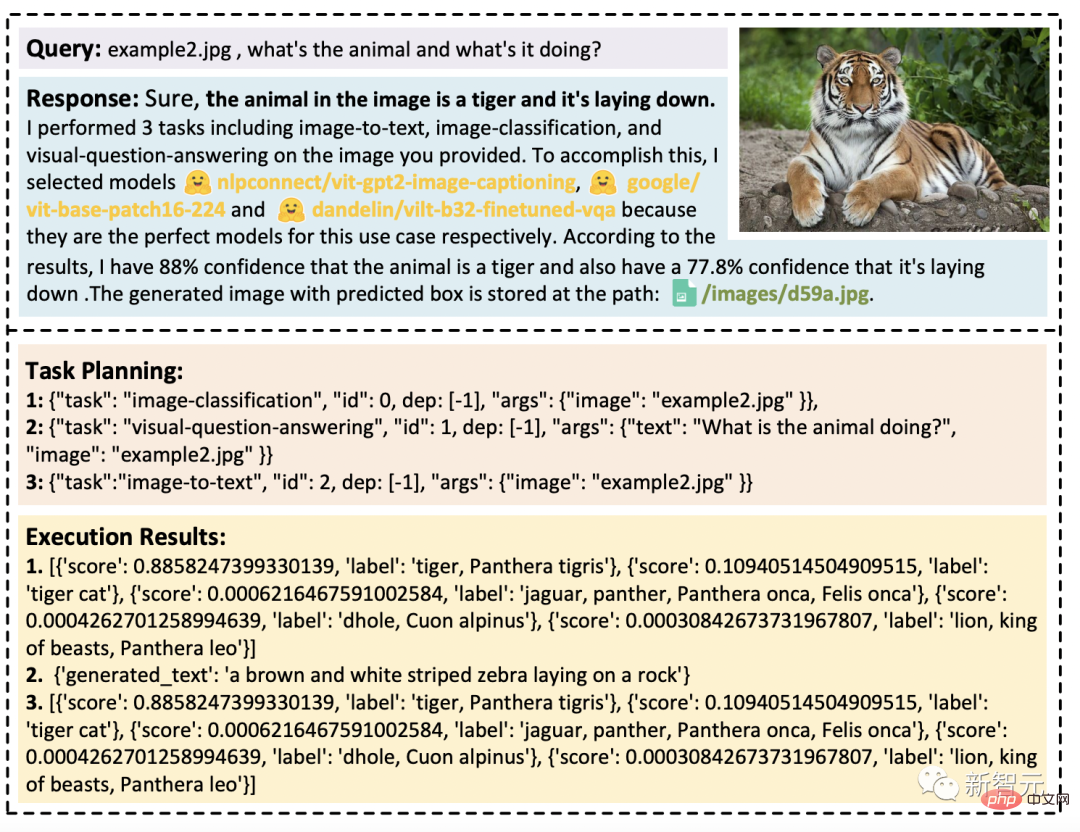

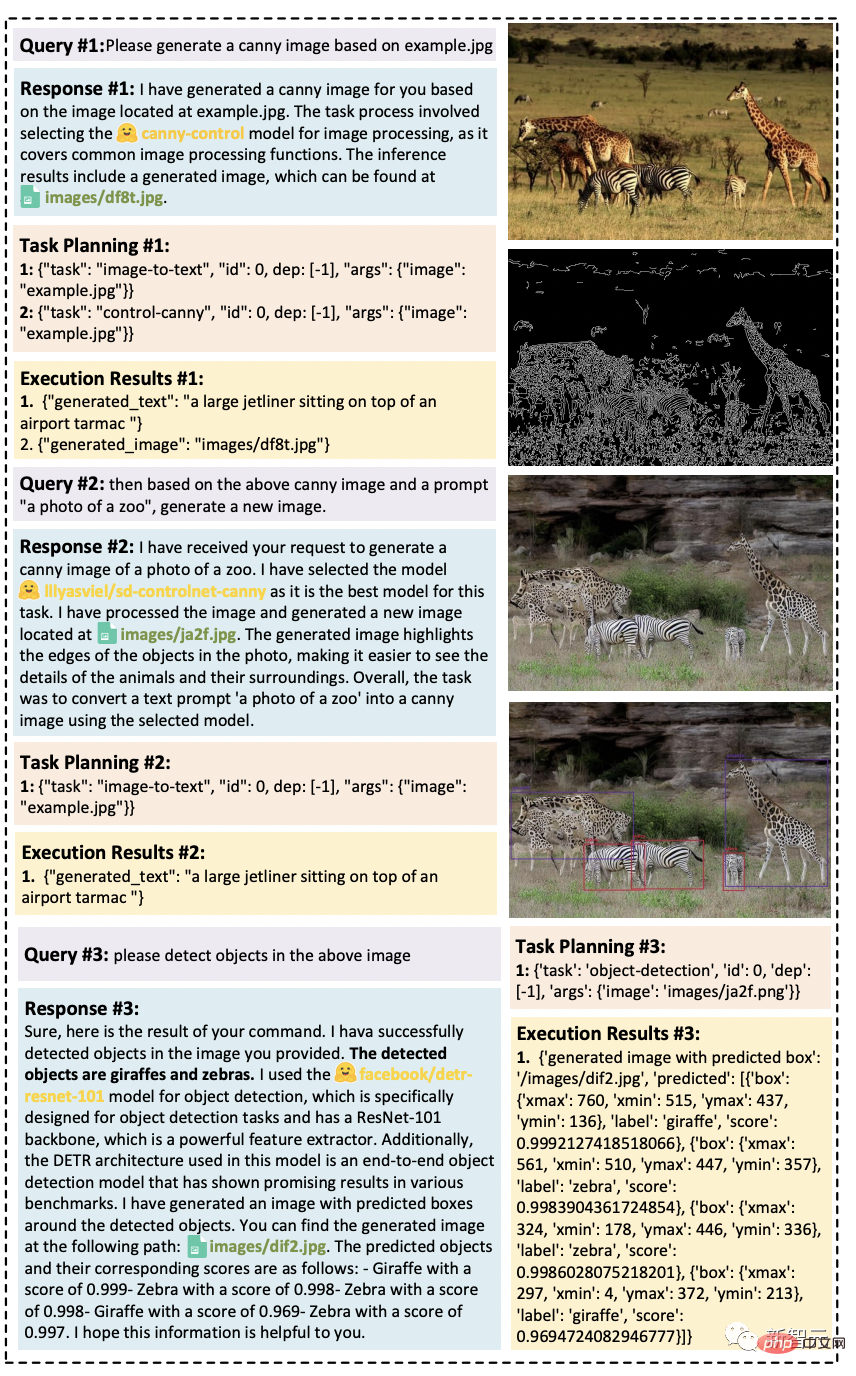

four du flux de travail en passant tâches en plusieurs étapes et planifie la séquence de tâches et les dépendances en fonction de ses connaissances

- Sélection du modèle : LLM attribue les tâches analysées à des modèles experts en fonction de la description du modèle dans HuggingFace

- Exécution des tâches : Expert Le modèle exécute les tâches assignées sur le point de terminaison d'inférence et enregistre les informations d'exécution et les résultats d'inférence dans LLM

- Génération de réponse : LLM résume les journaux du processus d'exécution et les résultats d'inférence et renvoie le résumé à l'utilisateur

Capacités multimodales, avecParamètres expérimentaux

Dans l'expérience, les chercheurs ont utilisé deux variantes du modèle GPT, gpt-3.5-turbo et text-davinci-003, comme grand- des modèles de langages à l'échelle (LLM), qui sont accessibles au public via l'API OpenAI.

Afin de rendre la sortie de LLM plus stable, nous définissons la température de décodage sur 0.

En même temps, afin d'ajuster la sortie de LLM pour qu'elle corresponde au format attendu, nous définissons logit_bias à 0,1 sur la contrainte de format.

Les chercheurs fournissent des invites détaillées conçues pour les phases de planification de mission, de sélection de modèle et de génération de réaction dans le tableau suivant, où {{variable}} indique que l'invite doit être remplie avec le texte correspondant avant d'être saisie. dans la valeur du domaine LLM.

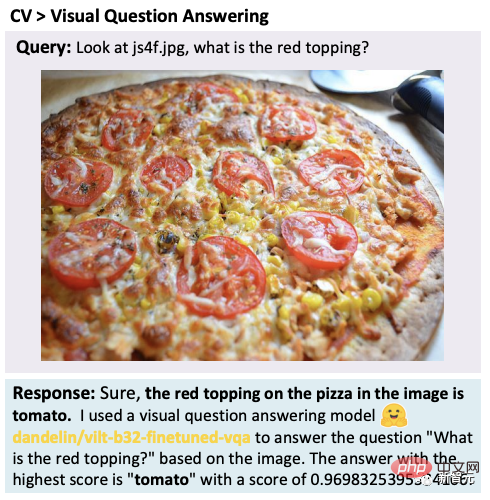

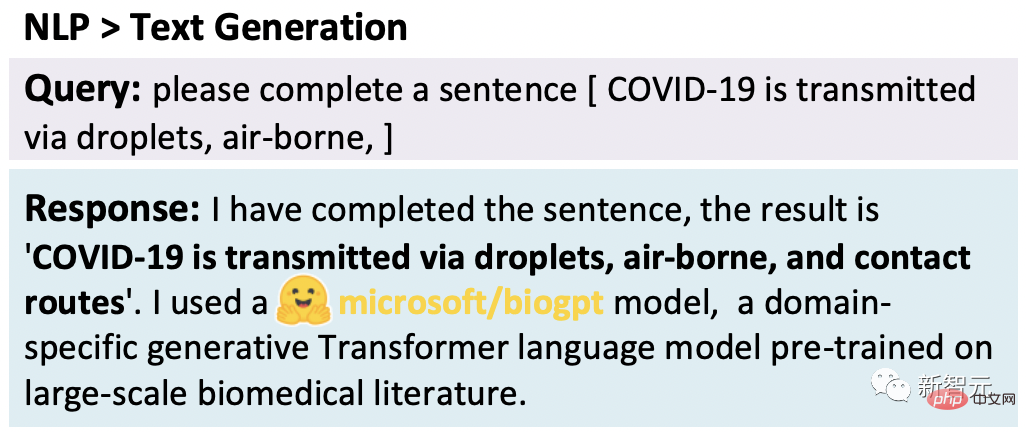

Les chercheurs ont testé HuggingGPT sur un large éventail de tâches multimodales.

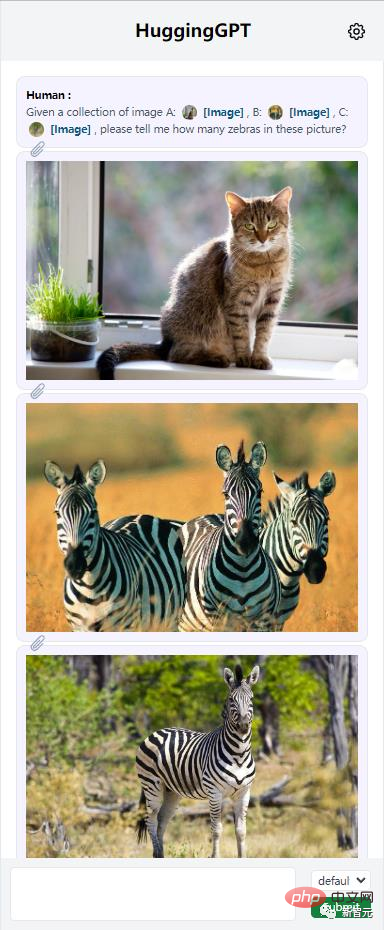

Avec la coopération de ChatGP et de modèles experts, HuggingGPT peut résoudre des tâches dans plusieurs modes tels que le langage, l'image, l'audio et la vidéo, y compris la détection, la génération, la classification et la réponse aux questions. Bien que ces tâches semblent simples, maîtriser les capacités de base de HuggingGPT est une condition préalable pour résoudre des tâches complexes. Par exemple, tâche visuelle de questions et réponses : Génération de texte : Vincent photo : HuggingGPT peut intégrer plusieurs Faire des inférences simples basées sur le contenu d'entrée. On peut constater que même s'il existe plusieurs ressources de tâches, HuggingGPT peut décomposer la tâche principale en plusieurs tâches de base et enfin intégrer les résultats d'inférence de plusieurs modèles pour obtenir la bonne réponse. De plus, les chercheurs ont évalué l'efficacité de HuggingGPT dans des situations de tâches complexes au moyen de tests. a démontré la capacité de HuggingGPT à gérer plusieurs tâches complexes. Lors du traitement de plusieurs demandes, elles peuvent contenir plusieurs tâches ou besoins implicites et d'autres informations. À l'heure actuelle, il ne suffit pas de s'appuyer sur un modèle expert pour résoudre le problème. HuggingGPT peut organiser la collaboration de plusieurs modèles grâce à la planification des tâches. Une demande utilisateur peut explicitement contenir plusieurs tâches : La figure suivante montre la capacité de HuggingGPT à gérer des tâches complexes dans un scénario de conversation à plusieurs tours. Les utilisateurs divisent une demande complexe en plusieurs étapes et atteignent l'objectif final grâce à plusieurs séries de demandes. Il a été constaté que HuggingGPT peut suivre l'état de la situation des demandes des utilisateurs grâce à la gestion de la situation de dialogue au cours de la phase de planification des tâches, et peut bien résoudre les ressources demandées et la planification des tâches mentionnées par les utilisateurs. Actuellement, ce projet est open source sur GitHub, mais le code n'a pas été entièrement publié. Fait intéressant, les chercheurs ont nommé ce projet Jarvis dans "Iron Man", et l'IA invincible est là. JARVIS : Un système connectant les LLM et les communautés ML D'ailleurs, HuggingGPT nécessite l'utilisation de l'API OpenAI. JARVIS / HuggingGPT, comme le Toolformer proposé par Meta précédemment, fait office de connecteur. Même, y compris les plugins ChatGPT. Un internaute a déclaré : « Je soupçonne fortement que la première intelligence générale artificielle (AGI) apparaîtra plus tôt que prévu. Elle s'appuiera sur une intelligence artificielle « colle » qui peut combiner intelligemment une série d'intelligence artificielle étroite et de pratiques. Les outils sont collés ensemble. J'ai eu accès au module complémentaire, qui m'a transformé du jour au lendemain d'un noob en mathématiques à un génie des mathématiques. Bien sûr, ce n’est qu’un petit pas, mais c’est un signe des tendances de développement futures. Je prédis que dans l'année prochaine, nous verrons un assistant IA connecté à des dizaines de grands modèles de langage (LLM) et d'outils similaires, et à l'utilisateur final uniquement. Ils doivent donner des instructions à leurs assistants pour accomplir des tâches à leur place. Ce moment de science-fiction arrive. Certains internautes ont dit que c'était la future méthode de recherche. GPT Devant beaucoup d'outils, vous savez les utiliser.

"Jarvis" est open source

Internaute : L'avenir de la recherche

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI