Maison >Périphériques technologiques >IA >Après avoir joué plus de 300 fois en quatre minutes, Google a appris à son robot à jouer au tennis de table

Après avoir joué plus de 300 fois en quatre minutes, Google a appris à son robot à jouer au tennis de table

- 王林avant

- 2023-04-10 09:11:031754parcourir

Laissez un passionné de tennis de table jouer contre un robot. À en juger par la tendance de développement des robots, il est vraiment difficile de dire qui gagnera et qui perdra.

Le robot a une maniabilité adroite, un mouvement de jambe flexible et une excellente capacité de préhension... et a été largement utilisé dans diverses tâches difficiles. Mais comment les robots accomplissent-ils les tâches qui impliquent une interaction étroite avec les humains ? Prenons l'exemple du tennis de table. Cela nécessite un haut degré de coopération de la part des deux parties et la balle se déplace très rapidement, ce qui pose un défi majeur à l'algorithme.

Au tennis de table, la première priorité est la vitesse et la précision, ce qui impose des exigences élevées aux algorithmes d'apprentissage. En même temps, ce sport présente deux caractéristiques majeures : une collaboration très structurée (avec un environnement fixe et prévisible) et multi-agents (les robots peuvent se battre avec des humains ou d'autres robots), ce qui en fait un lieu idéal pour étudier l'interaction homme-machine et apprentissage par renforcement. Une plateforme expérimentale idéale pour résoudre des problèmes.

L'équipe de recherche en robotique de Google a construit une telle plateforme pour étudier les problèmes rencontrés par les robots qui apprennent dans des environnements multi-personnes, dynamiques et interactifs. Google a également écrit un blog spécial à cet effet pour présenter les deux projets qu'ils étudient, Iterative-Sim2Real (i-S2R) et GoalsEye. i-S2R a permis au robot de jouer plus de 300 matchs avec des joueurs humains, tandis que GoalsEye a permis au robot d'apprendre des stratégies utiles (stratégies conditionnelles aux buts) auprès des amateurs.

La stratégie i-S2R permet aux robots de lutter contre les humains Bien que la posture de maintien du robot n'ait pas l'air très professionnelle, il ne manquera pas une balle :

Tu viens et je pars, c'est plutôt bien Like. cela donne l'impression qu'une balle de haute qualité est jouée.

La stratégie GoalsEye peut renvoyer le ballon à la position désignée sur la table, tout comme le frapper partout où vous pointez :

i-S2R : Utiliser le simulateur pour coopérer avec des humains pour jouer à des jeux

Dans ce projet, les robots sont conçus pour apprendre à coopérer avec les humains, c'est-à-dire à s'entraîner avec les humains le plus longtemps possible. Étant donné que s’entraîner directement contre des joueurs humains est fastidieux et prend du temps, Google a adopté une approche basée sur la simulation. Cependant, cela se heurte à un nouveau problème : il est difficile pour les méthodes basées sur la simulation de simuler avec précision le comportement humain, les tâches d'interaction en boucle fermée, etc.

Dans i-S2R, Google a proposé un modèle capable d'apprendre le comportement humain dans les tâches d'interaction homme-machine et l'a instancié sur la plateforme robotique de tennis de table. Google a construit un système capable de réaliser jusqu'à 340 lancers au bâton avec des joueurs humains amateurs (illustré ci-dessous).

L'homme et le robot se battent pendant 4 minutes, jusqu'à 340 fois d'avant en arrière

Modèle d'apprentissage du comportement humain

Laisser le robot apprendre avec précision le comportement humain est également confronté aux problèmes suivants : S'il y a pas assez au début Une bonne stratégie de robots ne peut être réalisée sans collecter des données de haute qualité sur la façon dont les humains interagissent avec les robots. Mais sans modèle de comportement humain, la stratégie du robot ne peut pas être obtenue dès le début. Ce problème est un peu compliqué, comme celui de savoir qui est arrivé en premier, la poule ou l'œuf. Une approche consiste à former les politiques relatives aux robots directement dans le monde réel, mais cela est souvent lent, coûteux et pose des problèmes de sécurité qui sont encore exacerbés lorsque des humains sont impliqués.

Comme le montre la figure ci-dessous, i-S2R utilise un modèle de comportement humain simple comme point de départ approximatif et alterne entre formation par simulation et déploiement dans le monde réel. À chaque itération, des modèles et des stratégies de comportement humain sont adaptés.

Méthode i-S2R

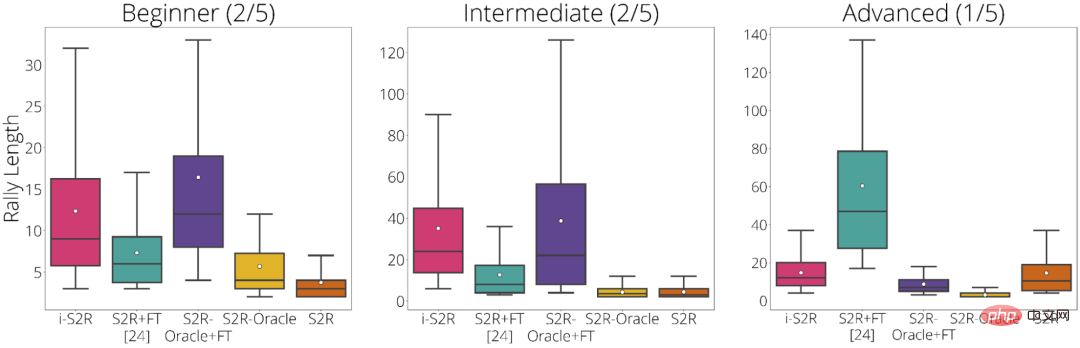

Google décompose les résultats de l'expérimentation en fonction du type de joueur : Débutant (40 % des joueurs), Intermédiaire (40 % des joueurs) et Avancé (20 % des joueurs) . D'après les résultats expérimentaux, i-S2R fonctionne nettement mieux que S2R+FT (sim-to-real plus fine-tuning) pour les joueurs débutants et intermédiaires (80 % des joueurs).

Résultats i-S2R par type de joueur

GoalsEye : frapper exactement où vous voulez

Dans GoalsEye, Google a également démontré une méthode qui combine des techniques de clonage comportemental utilisées pour apprendre un ciblage précis stratégies.

Ici, Google se concentre sur la précision du tennis de table. Ils espèrent que le robot pourra renvoyer la balle avec précision dans n'importe quelle position désignée sur la table, comme le montre l'image ci-dessous. Pour obtenir les effets suivants, ils ont également utilisé le LFP (Learning from Play) et le GCSL (Goal-Conditioned Supervised Learning).

La stratégie GoalsEye cible un cercle d'un diamètre de 20 cm (à gauche). Un joueur humain peut viser la même cible (à droite)

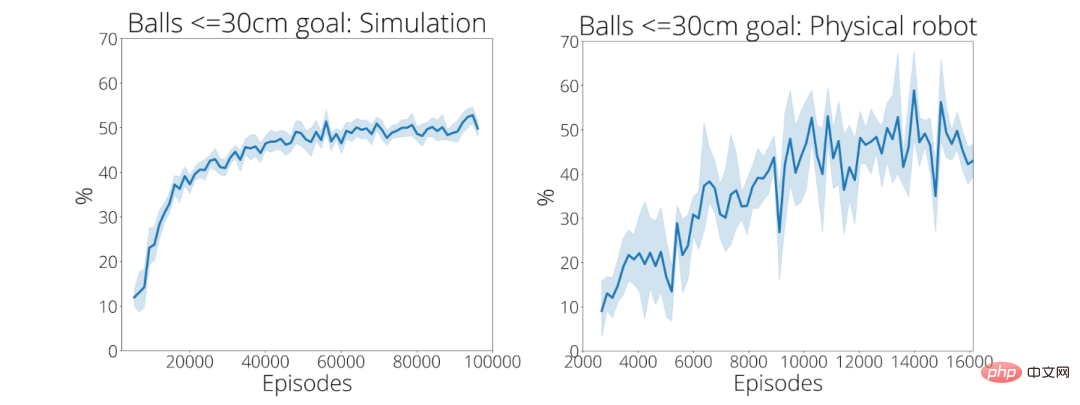

Dans ses 2 480 premières démos, la stratégie d'entraînement de Google a atteint avec précision une cible circulaire d'un rayon de 30 cm seulement 9 % du temps. Après environ 13 500 démonstrations, la précision du ballon atteignant sa cible est passée à 43 pour cent (en bas à droite).

Pour plus d'informations sur ces deux projets, veuillez vous référer au lien suivant :

- Page d'accueil d'Iterative-Sim2Real : https://sites.google.com/view/is2r

- Page d'accueil de GoalsEye : https://sites.google.com/view/goals-eye

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI