Maison >Périphériques technologiques >IA >Pourquoi un chat ? Explainable AI comprend le mécanisme de reconnaissance de CNN à un niveau sémantique

Pourquoi un chat ? Explainable AI comprend le mécanisme de reconnaissance de CNN à un niveau sémantique

- 王林avant

- 2023-04-09 23:11:011502parcourir

Ces dernières années, CNN a été privilégié par les chercheurs dans divers domaines tels que la vision par ordinateur et le traitement du langage naturel en raison de ses excellentes performances. Cependant, CNN est un modèle de « boîte noire », c'est-à-dire que le contenu d'apprentissage et le processus de prise de décision du modèle sont difficiles à extraire et à exprimer d'une manière que les humains peuvent comprendre, ce qui limite sa crédibilité de prédiction et son application pratique. Par conséquent, l'interprétabilité de CNN a reçu de plus en plus d'attention. Les chercheurs ont essayé d'utiliser la visualisation des fonctionnalités, le diagnostic du réseau et l'ajustement de l'architecture du réseau pour aider à expliquer le mécanisme d'apprentissage de CNN, rendant ainsi cette « boîte noire » transparente. les humains à comprendre, détecter et améliorer leurs processus de prise de décision.

Récemment, Des équipes de recherche de l'Université de Pékin, de l'Institut de technologie de l'Est, de l'Université des sciences et technologies du Sud, du Laboratoire de Pengcheng et d'autres institutions ont proposé un cadre de recherche pour l'IA sémantique explicable (S-XAI), explique le mécanisme d'apprentissage de CNN à partir du niveau sémantique, et prend le problème de classification des chats et des chiens comme exemple pour révéler de manière vivante comment le modèle apprend le concept de chat au sens de catégorie, c'est-à-dire « qu'est-ce qu'un chat ?

Cette recherche se concentre sur les caractéristiques communes apprises par CNN à partir d'échantillons de la même catégorie et extrait des concepts sémantiques compréhensibles par l'homme, fournissant une explication au niveau sémantique de CNN. Sur cette base, la recherche a d'abord proposé le concept de « probabilité sémantique » pour caractériser la probabilité d'occurrence d'éléments sémantiques dans l'échantillon. Les expériences montrent que S-XAI peut extraire avec succès des caractéristiques communes et des concepts sémantiques abstraits surréalistes mais identifiables dans des tâches binaires et multi-classifications, et a de larges perspectives d'application dans l'évaluation de la crédibilité et la recherche d'échantillons sémantiques.

L'étude s'intitulait « Interprétation sémantique pour les réseaux de neurones convolutifs : qu'est-ce qui fait d'un chat un chat ? » et a été publiée dans « Advanced Science » le 10 octobre 2022.

Lien papier : https://onlinelibrary.wiley.com/doi/10.1002/advs.202204723

Lien code : https://github.com/woshixuhao/semantic-explainable -AI

Effet de modèle

Différent des recherches précédentes sur la visualisation d'échantillons uniques, S-XAI peut extraire et visualiser les caractéristiques communes d'échantillons de groupe, obtenant ainsi interprétabilité globale . Sur la base de l'espace sémantique plus abstrait et des probabilités sémantiques calculées, S-XAI peut générer automatiquement des explications sémantiques compréhensibles par l'homme pour la logique de décision du CNN et évaluer la crédibilité de la décision à un niveau sémantique.

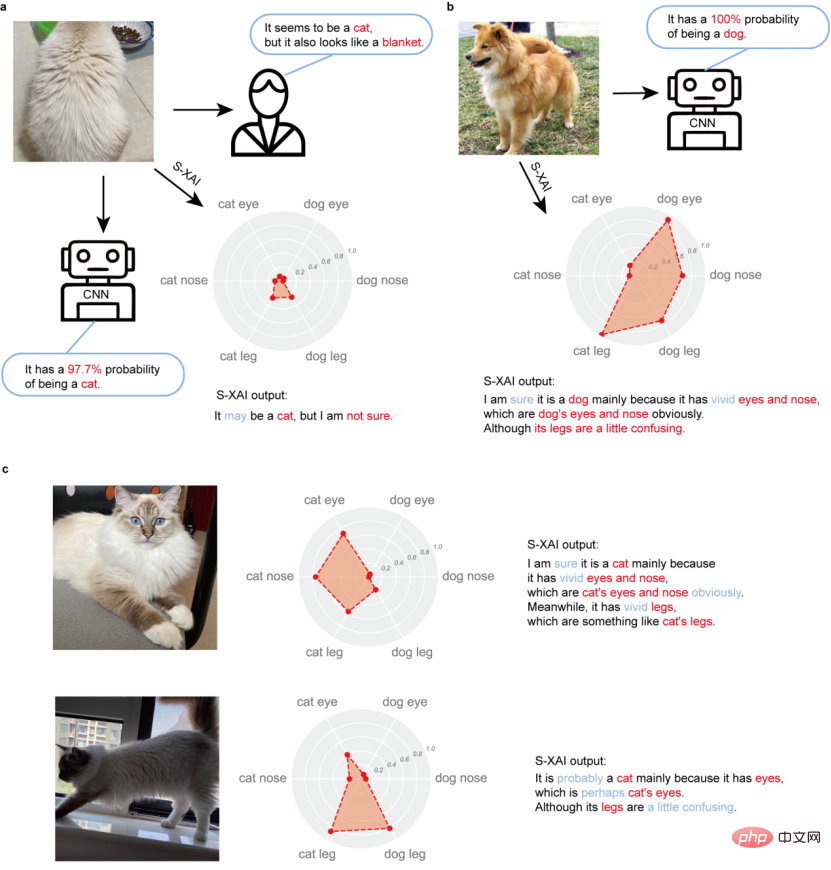

Comme le montre la figure 1, dans le problème à deux catégories des chats et des chiens, S-XAI génère automatiquement des graphiques radar de probabilité sémantique correspondants et des phrases d'explication pour les images du même chat sous trois angles. Bien que les réseaux de neurones aient tous identifié ces images comme étant des chats avec une probabilité de plus de 90 %, S-XAI a fourni davantage d'informations d'interprétation à partir de la probabilité sémantique, reflétant les différences entre ces images. Par exemple, pour l'image frontale, l'explication de S-XAI est "Je suis convaincu que c'est un chat, principalement parce qu'il a des yeux et un nez vifs, qui sont évidemment des yeux et un nez de chat. En même temps, il a des pattes réalistes, ce qui ressemble un peu à des pattes de chat. » Cette explication montre un haut degré de crédibilité. Pour l'image vue de côté, l'explication de S-XAI est "C'est probablement un chat, principalement parce qu'il a des yeux, peut-être des yeux de chat, mais ses pattes sont un peu déroutantes. Pour l'image vue de dos, aucun." les probabilités sémantiques sont évidentes, et l'interprétation de S-XAI est "C'est peut-être un chat, mais je n'en suis pas sûr." Pendant ce temps, pour une photo d'un chien, l'interprétation de S-XAI est : "Je suis sûr que c'est un chat". ." Un chien, principalement à cause de ses yeux et de son nez vifs, qui sont évidemment ceux d'un chien, même si ses pattes prêtent un peu à confusion.

En fait, si le haut du corps de ce chien est couvert, je regarde juste." au niveau des pattes, il serait difficile, même pour les humains, de dire s'il s'agit d'un chat ou d'un chien. On peut voir que l'explication sémantique fournie par S-XAI est plus précise et cohérente avec la cognition humaine, permettant aux humains de mieux comprendre la logique de reconnaissance de catégorie des réseaux de neurones au niveau sémantique.

Figure 1. Graphique radar de probabilité sémantique et phrases d'explication générées automatiquement par S-XAI

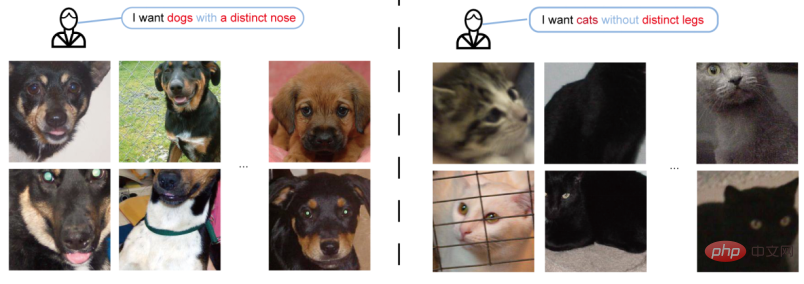

Dans le même temps, S-XAI a également de larges perspectives d'application dans la recherche d'échantillons sémantiques. Comme le montre la figure 2, lorsque les utilisateurs ont besoin de filtrer des images présentant certaines caractéristiques sémantiques à partir d'un grand nombre d'images, S-XAI fournit un moyen rapide et précis de filtrer par probabilité sémantique. Étant donné que le calcul des probabilités sémantiques implique uniquement l’opération directe (c’est-à-dire la prédiction) du réseau neuronal, le processus est très rapide.

Figure 2. Exemple de recherche d'échantillons sémantiques

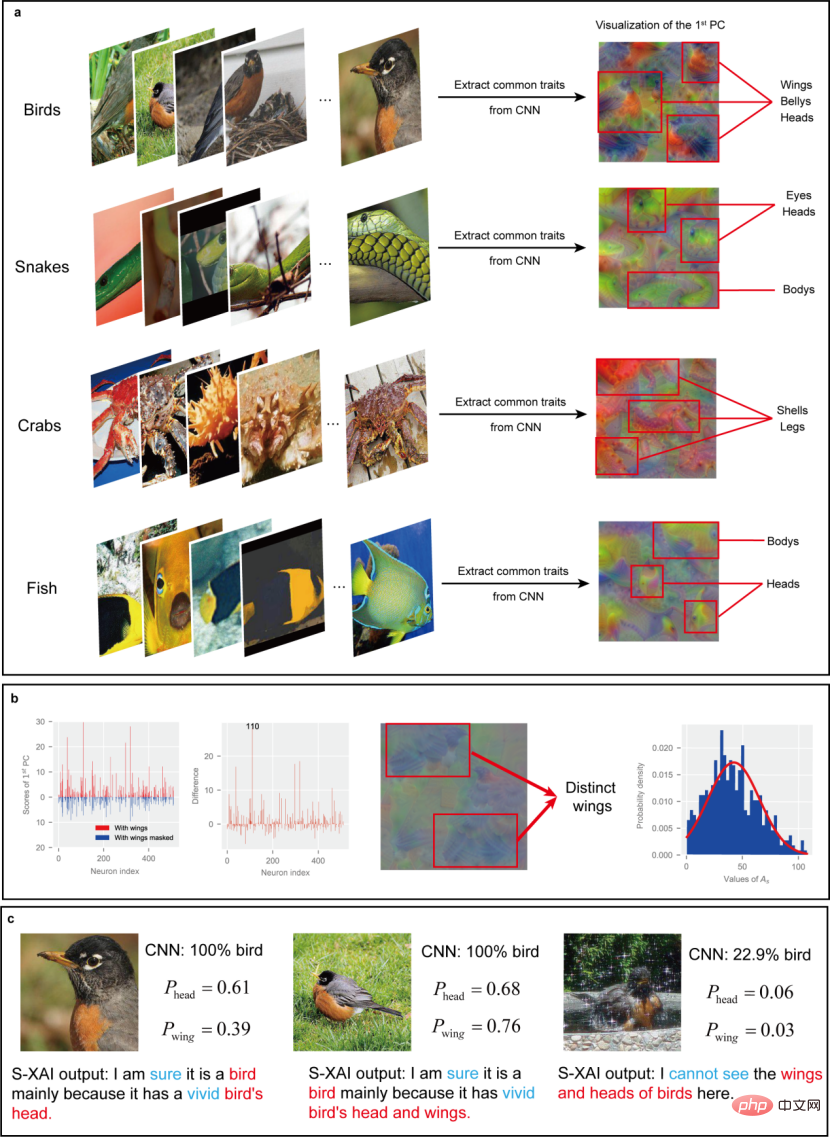

Dans l'étude, les chercheurs ont également prouvé que S-XAI a une bonne évolutivité dans les tâches multi-classifications. Comme le montre la figure 3, en prenant comme exemple l'ensemble de données Mini-ImageNet (contenant 100 catégories d'animaux), S-XAI peut toujours extraire des images clairement identifiables à partir de différentes catégories de données (telles que les oiseaux, les serpents, les crabes, les poissons, etc. ) Caractéristiques communes et espace sémantique, et générer les explications sémantiques correspondantes.

Figure 3. Performances de S-XAI dans des tâches multi-classifications.

Principes et méthodes

Actuellement, les idées courantes pour améliorer l'interprétabilité des modèles sont principalement divisées en deux catégories : la visualisation et l'intervention sur le modèle. Les méthodes de visualisation visualisent les cartes de fonctionnalités, les filtres ou les cartes thermiques à l'intérieur du CNN pour comprendre les fonctionnalités auxquelles le réseau prête attention lorsqu'il est confronté à un échantillon donné. La limite de cette méthode est qu’elle ne peut extraire que des caractéristiques individuelles d’un seul échantillon pour obtenir une interprétabilité locale, et ne peut pas aider les gens à comprendre la logique décisionnelle globale du modèle face au même type de données. La méthode d'intervention sur modèle intègre certains modèles existants hautement interprétables (tels que des modèles d'arbres, etc.) dans l'architecture du réseau neuronal pour améliorer l'interprétabilité du modèle. Bien que ce type de méthode présente l’avantage d’une interprétabilité globale, elle nécessite souvent un recyclage du modèle, ce qui entraîne des coûts d’interprétation élevés, peu propices à la généralisation et à l’application.

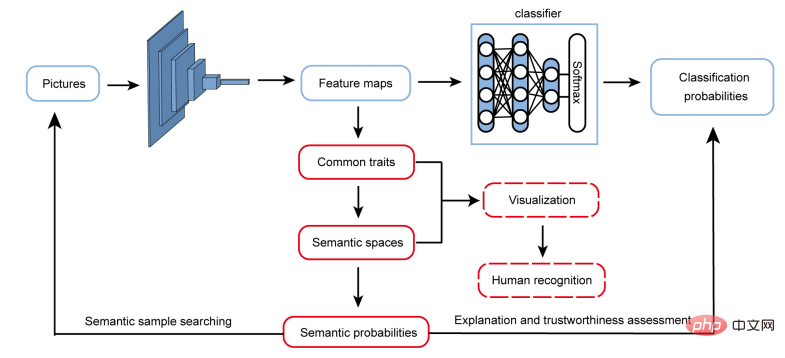

Inspirés par les modèles cognitifs humains, dans S-XAI, les chercheurs ont adopté une nouvelle stratégie d'explication pour expliquer le mécanisme d'apprentissage des catégories de CNN à partir du niveau sémantique (Figure 4). Dans la nature, les objets du même type ont souvent certaines caractéristiques communes similaires, qui constituent une base importante pour la cognition des catégories. Par exemple, bien que les chats aient des formes différentes, ils partagent tous certaines caractéristiques communes (telles que les moustaches, le nez et les yeux), ce qui permet aux humains de les identifier rapidement comme des chats. Lors d’expériences, les chercheurs ont découvert que le mécanisme d’apprentissage des catégories de CNN est similaire à celui des humains. Figure 4. Cadre de recherche sur l'intelligence artificielle interprétable sémantique la même catégorie est extraite de CNN. Différente de l'analyse traditionnelle en composantes principales, la compression d'échantillons au centre des lignes réduit la dimensionnalité des cartes de caractéristiques obtenues dans le CNN à partir d'un grand nombre d'échantillons dans l'espace échantillon, extrayant ainsi un petit nombre de composantes principales en tant que caractéristiques communes apprises par le CNN. Afin de rendre plus claires les caractéristiques communes extraites, l'échantillon a trouvé la combinaison optimale de superpixels grâce à la segmentation des superpixels et à un algorithme génétique pour réduire les interférences. Les caractéristiques communes extraites sont affichées visuellement (Figure 5).

Figure 5. Chemin d'extraction des caractéristiques communes

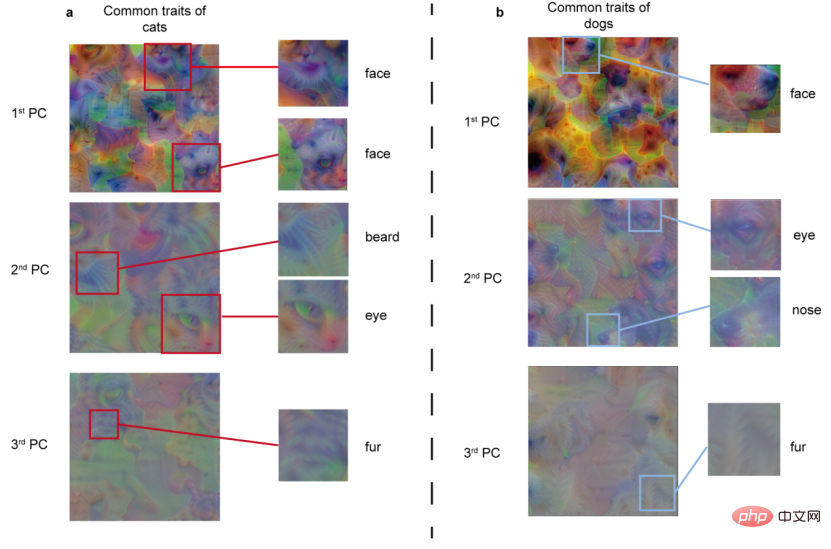

En prenant comme exemple le problème de classification binaire des chats et des chiens sur l'architecture de réseau VGG-19, les différents composants principaux extraits des données de catégorie des chats et des chiens sont présentés dans la figure 6. Il ressort clairement de la figure que les différentes composantes principales présentent des caractéristiques identifiables à différents niveaux. Il est évident que la première composante principale montre des traits complets du visage, la deuxième composante principale montre des concepts sémantiques dispersés, tels que la barbe, les yeux et le nez, etc., et la troisième composante principale montre principalement les caractéristiques de la fourrure. Il convient de mentionner que les caractéristiques présentées par ces composants principaux sont surnaturelles, c'est-à-dire qu'elles n'appartiennent à aucun échantillon, mais reflètent les caractéristiques communes de tous les échantillons d'une même catégorie.

Figure 6. Résultats de visualisation des différents composants principaux extraits des données de catégorie des chats et des chiens

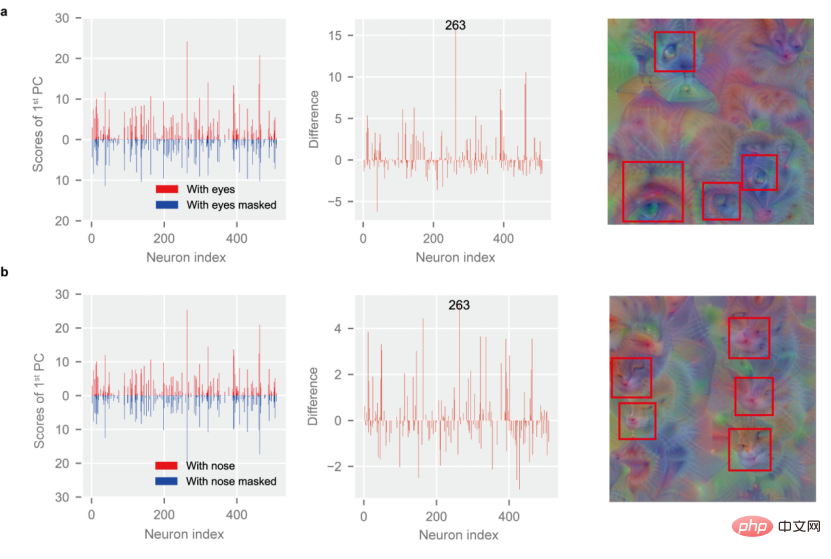

Sur la base des caractéristiques communes extraites, les chercheurs ont analysé les informations sémantiques dans les échantillons. Le traitement des masques est utilisé pour comparer les changements dans les composantes principales et séparer davantage les concepts sémantiques mixtes, extrayant ainsi les vecteurs sémantiques correspondant à chaque concept sémantique et abstrayant l'espace sémantique. Ici, les chercheurs ont utilisé des concepts sémantiques compris par l'homme, tels que les yeux et le nez, et ont visualisé l'espace sémantique abstrait. Après avoir réussi à extraire l'espace sémantique, les chercheurs ont défini le concept de « probabilité sémantique » pour caractériser la probabilité d'apparition d'éléments sémantiques dans l'échantillon, fournissant ainsi une méthode d'analyse quantitative pour l'explication du niveau sémantique de CNN.

Comme le montre la figure 7, des concepts sémantiques clairement identifiables (yeux brillants, petit nez) apparaissent dans l'espace sémantique, ce qui montre que l'espace sémantique est extrait avec succès du CNN, montrant que le CNN extrait des informations sémantiques des données de catégorie savant. Dans le même temps, les chercheurs ont découvert qu'il existe certaines différences entre la compréhension de la sémantique par CNN et celle des humains. La « sémantique » qu'il apprend n'est pas nécessairement la « sémantique » convenue par les humains. Il se peut même que la sémantique des réseaux neuronaux le soit davantage. efficace. Par exemple, les chercheurs ont découvert que pour les chats, CNN traite souvent le nez et les moustaches du chat comme une sémantique globale, ce qui peut être plus efficace. Dans le même temps, CNN a découvert certains liens entre la sémantique. Par exemple, les yeux et le nez d’un chat apparaissent souvent en même temps. Cet aspect mérite des recherches plus approfondies.

Figure 7. Vecteurs sémantiques extraits de CNN et espace sémantique visualisé (en haut : espace œil de chat ; en bas : espace nez de chat)

Résumé et perspectives

En résumé, l'artificiel explicable sémantique L'intelligence (S-XAI) proposée dans l'étude fournit une explication du mécanisme de reconnaissance de catégorie de CNN à partir du niveau sémantique en extrayant les caractéristiques communes et l'espace sémantique. Ce cadre de recherche peut obtenir certaines capacités d'explication globale sans modifier l'architecture CNN. Puisqu'il n'implique pas de recyclage du réseau, S-XAI présente l'avantage d'une vitesse de réponse plus rapide et a des applications considérables dans l'évaluation de la crédibilité et le potentiel de recherche d'échantillons sémantiques.

Essentiellement, S-XAI est similaire à la découverte de connaissances. La découverte des connaissances vise à trouver des termes fonctionnels qui reflètent les lois physiques communes des réseaux de neurones, tandis que S-XAI vise à trouver des espaces sémantiques qui reflètent les caractéristiques communes des échantillons de CNN. L'idée principale des deux est de trouver des points communs et de les représenter. quant à la possibilité de rendre l'humain compréhensible.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI