Maison >Périphériques technologiques >IA >Marcus a publié un article critiquant LeCun : L'apprentissage profond à lui seul ne peut pas atteindre une intelligence semblable à celle de l'humain.

Marcus a publié un article critiquant LeCun : L'apprentissage profond à lui seul ne peut pas atteindre une intelligence semblable à celle de l'humain.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-09 23:01:141147parcourir

En mars de cette année, Gary Marcus a fait sensation dans la communauté universitaire en intelligence artificielle après avoir proposé l'idée selon laquelle "l'apprentissage profond s'est heurté à un mur".

À cette époque, même les trois géants du deep learning ne pouvaient pas rester assis. Tout d'abord, Geoffrey Hinton a réfuté ce point de vue dans un podcast.

En juin, Yann LeCun a écrit un article en réponse à cela, et a souligné qu'il ne faut pas traiter les difficultés passagères comme se heurter à un mur.

Maintenant, Marcus a publié un article intitulé « L'apprentissage profond seul ne nous amène pas à une IA de type humain » dans le magazine américain NOEMA.

De même, il n'a toujours pas changé d'avis : l'apprentissage profond ne peut à lui seul atteindre une intelligence semblable à celle de l'humain.

et a proposé que la recherche actuelle sur l'intelligence artificielle se concentre principalement sur l'apprentissage profond, et qu'il est temps de la reconsidérer.

Au cours des 70 dernières années, le débat le plus fondamental dans le domaine de l'intelligence artificielle est de savoir si les systèmes d'intelligence artificielle doivent être construits sur des "opérations symboliques" ou sur des systèmes de "réseaux neuronaux" de type cerveau.

En fait, il existe ici une troisième possibilité : le modèle hybride - combinant l'apprentissage profond des réseaux de neurones avec les puissantes capacités d'abstraction des opérations symboliques.

Le récent article de LeCun "What AI Can Tell Us About Intelligence" publié dans le magazine NOEMA a également abordé cette question, mais Marcus a souligné que son article semblait clair, mais qu'il avait des défauts évidents, à savoir la logique du passé et le futur.

L'article commence par le rejet du modèle hybride, mais l'article se termine en reconnaissant l'existence de modèles hybrides et en le mentionnant comme une voie possible à suivre.

Modèle hybride de réseau neuronal et d'opérations symboliques

Marcus a souligné que le point principal de LeCun et Browning est que "si un modèle apprend des opérations symboliques, il n'est pas hybride".

Mais le problème de l'apprentissage automatique est un problème de développement (comment le système est-il né ?)

Et la façon dont le système fonctionne une fois développé est un problème de calcul (par exemple, utilise-t-il un mécanisme ou pas ? Deux mécanismes ?), c'est-à-dire : « Tout système qui utilise à la fois des symboles et des réseaux de neurones est un modèle hybride. »

Peut-être que ce qu'ils veulent vraiment dire, c'est que l'intelligence artificielle est probablement un hybride appris plutôt qu'un hybride né. Mais un apprentissage hybride reste un hybride.

Et le point de vue de Marcus est le suivant : « Les opérations symboliques elles-mêmes sont innées, ou il y a une autre chose qui est innée, qui contribue indirectement à l'émergence des opérations symboliques. »

Nos recherches devraient donc porter sur la manière de découvrir ce médium qui favorise indirectement les opérations symboliques.

L'hypothèse est que tant que nous pouvons déterminer quel support permet au système d'atteindre le point où il peut apprendre des abstractions symboliques, nous pouvons construire des systèmes qui tirent parti de toutes les connaissances du monde.

Ensuite, Marcus a cité des classiques et passé au peigne fin l'histoire des débats sur la manipulation symbolique et les réseaux de neurones dans le domaine de l'intelligence artificielle.

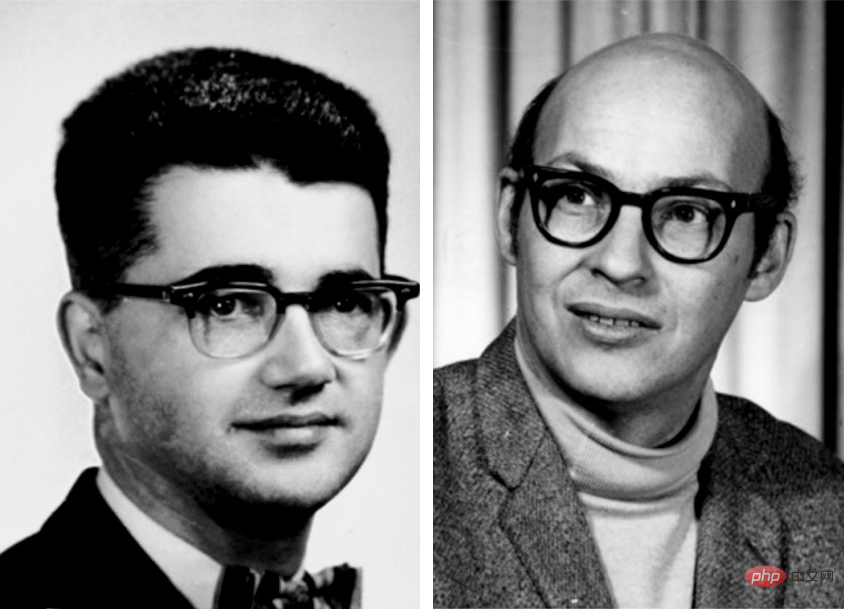

Les premiers pionniers de l'intelligence artificielle tels que Marvin Minsky et John McCarthy pensaient que la manipulation symbolique était la seule voie raisonnable pour avancer.

Et le pionnier des réseaux neuronaux, Frank Rosenblatt, estime que l'IA pourrait être plus performante sur la base d'une structure dans laquelle les nœuds neuronaux sont superposés et traitent les entrées numériques.

En fait, ces deux possibilités ne s'excluent pas mutuellement.

Le réseau neuronal utilisé par l'IA n'est pas un véritable réseau de neurones biologiques. Au contraire, il s'agit d'un modèle numérique simplifié qui présente certaines caractéristiques du cerveau humain, mais avec très peu de complexité.

En principe, ces symboles abstraits peuvent être connectés de nombreuses manières différentes, dont certaines peuvent directement mettre en œuvre des opérations logiques et symboliques.

Warren S. McCulloch et Walter Pitts ont publié Un calcul logique des idées inmanentes dans l'activité nerveuse en 1943, reconnaissant explicitement cette possibilité.

D'autres, dont Frank Rosenblatt dans les années 1950 et David Rumelhart et Jay McClelland dans les années 1980, ont proposé les réseaux de neurones comme alternative à la manipulation symbolique. Geoffrey Hinton soutient également généralement cette position.

Puis Marcus a cité les lauréats du prix Turing tels que LeCun, Hinton et Yoshua Bengio l'un après l'autre.

Je veux dire, peu importe ce que je dis, d’autres grands l’ont dit !

En 2015, LeCun, Bengio et Hinton ont écrit un article de style manifeste sur l'apprentissage profond dans la nature.

Cet article se termine par une attaque contre les symboles, affirmant qu '"un nouveau paradigme est nécessaire pour remplacer les opérations d'expression symbolique basées sur des règles par des opérations sur de grands vecteurs".

En fait, Hinton était tellement convaincu que les symboles étaient une impasse que la même année, il a donné une conférence à l'Université de Stanford intitulée "Ether Symbols" - comparant les symboles à l'une des plus grandes erreurs de l'histoire. des sciences.

Un argument similaire a été avancé dans les années 1980 par deux de ses anciens collaborateurs, Rumelhart et McClelland, qui affirmaient dans un livre célèbre de 1986 que les symboles ne sont pas « l'essence du calcul humain ».

Marcus a déclaré que lorsqu'il a écrit un article défendant la manipulation symbolique en 2018, LeCun a rejeté son argument en faveur de l'IA hybride sans explication, le rejetant sur Twitter comme étant "un point de vue essentiellement erroné".

Puis il a déclaré que deux experts célèbres dans le domaine de l'apprentissage profond avaient également exprimé leur soutien à l'IA hybride.

Andrew Ng a exprimé son soutien à un tel système en mars. Sepp Hochreiter, co-créateur des LSTM, l'une des principales architectures d'apprentissage profond pour les séquences d'apprentissage, a fait la même chose, déclarant publiquement en avril que l'approche d'IA à grande échelle la plus prometteuse est l'IA neurosymbolique.

Dans le nouveau point de vue de LeCun et Browning, la manipulation symbolique est en fait cruciale, comme le proposent Marcus et Steven Pinker depuis 1988.

Marcus a donc accusé Lecun : "J'ai proposé votre point de vue il y a des décennies, et vos recherches remontent à des décennies."

Et ce n'est pas seulement moi, d'autres grands le pensent aussi.

Le reste de l'article de LeCun et Browning peut être grossièrement divisé en trois parties :

1. Caractérisation erronée de ma position 2. Efforts pour restreindre la portée des modèles hybrides 3. La manipulation symbolique peut être apprise une raison innée.

Ensuite, Marcus a réfuté le point dans l'article de LeCun :

LeCun et Browning ont déclaré : "Marcus a dit que si vous n'avez pas d'opérations symboliques au début, vous ne l'aurez jamais."

Et en fait, j'ai explicitement admis dans mon livre de 2001 "Pensée algébrique" que nous ne sommes pas sûrs que les opérations symboliques soient innées.

Ils ont critiqué ma déclaration selon laquelle "l'apprentissage profond ne peut pas faire de progrès supplémentaires", mais mon point réel n'est pas que DL ne fera aucun progrès sur aucun problème, mais que l'apprentissage profond lui-même est très important pour la composition, le raisonnement, etc. Mauvais outil pour certains travaux.

De même, ils m'ont calomnié en disant que le raisonnement symbolique est soit présent, soit non (1 ou 0) dans le système.

C'est tout simplement absurde.

Il est vrai que DALL-E n'utilise pas de symboles pour le raisonnement, mais cela ne signifie pas que tout système incluant un raisonnement symbolique doit être présent ou non.

Au moins dès le système MYCIN dans les années 1970, il existait un système purement symbolique pour divers raisonnements quantitatifs.

La manipulation de symboles est innée

Les capacités de manipulation symbolique peuvent-elles être apprises plutôt que construites dès le début ?

La réponse est oui.

Marcus a déclaré que bien que les expériences précédentes ne puissent garantir que la capacité de manipuler des symboles est innée, elles sont presque impossibles à distinguer de ce point de vue. Ils posent un défi à toute théorie de l’apprentissage qui s’appuie sur de grandes quantités d’expérience.

et avance les 2 arguments principaux suivants:

1. apprendre les opérations symboliques.

Un système doté de points de départ intégrés sera plus efficace pour comprendre le monde qu'une page vierge.

En fait, même le travail le plus célèbre de LeCun - Sur les réseaux de neurones convolutifs - en est un bon exemple : des contraintes intégrées sur la façon dont les réseaux de neurones apprennent, améliorant ainsi considérablement l'efficacité. Lorsque les opérations symboliques sont bien intégrées, des gains encore plus importants peuvent être obtenus.

2. Les nourrissons humains démontrent certaines capacités de manipulation symbolique

Dans une série d'expériences d'apprentissage de règles souvent citées, les nourrissons ont généralisé des modèles abstraits à ceux pour lesquels ils avaient été formés, au-delà d'exemples spécifiques. Des recherches ultérieures sur la capacité de raisonnement logique implicite des nourrissons humains ont également prouvé ce point.

De plus, des recherches montrent que les abeilles, par exemple, peuvent généraliser la fonction d'azimut solaire à des conditions d'éclairage qu'elles n'ont jamais vues auparavant.

Pour LeCun, l’apprentissage des symboles équivaut à quelque chose acquis au cours des années suivantes, car les jeunes ont besoin de compétences plus précises et professionnelles.

Ce qui est déroutant, c'est que, après s'être opposé à la nature innée des opérations symboliques, LeCun n'a pas fourni de preuves solides pour prouver que les opérations symboliques s'apprennent.

Si un chevreau peut descendre une colline en rampant peu de temps après sa naissance, pourquoi un réseau neuronal naissant ne peut-il pas intégrer une petite manipulation symbolique prête à l'emploi ?

Dans le même temps, LeCun et Browning n'ont pas précisé comment, faute du mécanisme intrinsèque de manipulation symbolique, comment résoudre les problèmes spécifiques bien connus de compréhension et de raisonnement du langage ? Ils donnent juste une faible généralisation : puisque l'apprentissage profond a surmonté le problème de 1 à N, nous devons être sûrs qu'il peut surmonter le problème N+1. Les gens devraient se demander si l'apprentissage profond a atteint ses limites. Compte tenu des améliorations progressives continues des missions observées récemment dans DALL-E 2, Gato et PaLM, il semble sage de ne pas confondre les difficultés momentanées avec des « murs ». L’échec inévitable du deep learning a déjà été prédit, mais cela ne vaut pas la peine de parier. L'optimisme est une chose, mais la réalité doit être vue clairement. L'apprentissage profond est en principe confronté à des défis spécifiques, principalement en termes de compositionnalité, de systématisation et de compréhension du langage, qui tournent tous autour de la généralisation et du « transfert distribué ». Maintenant, tout le monde se rend compte que la migration de distribution est le talon d'Achille des réseaux de neurones actuels. Bien sûr, l’apprentissage profond a progressé, mais peu de progrès ont été réalisés sur ces problèmes fondamentaux. Pour Marcus, la situation dans laquelle les opérations symboliques peuvent être innées est à peu près la même que par le passé : 1. Le système actuel, 20 ans après l’émergence de la « pensée algébrique » , même face à des ensembles de données massifs et à une formation, les opérations symboliques (telles que la multiplication) ne peuvent pas être extraites de manière fiable. 2. L'exemple des nourrissons humains montre qu'avant de recevoir une éducation formelle, ils ont la capacité de généraliser des aspects complexes du langage naturel et du raisonnement. 3. Un peu de signification symbolique intérieure peut grandement améliorer l'efficacité de l'apprentissage. Une partie de la puissance d’AlphaFold 2 provient de représentations innées soigneusement construites de la biologie moléculaire. En bref, le monde peut être grossièrement divisé en trois bacs : L'un est un système avec un équipement de manipulation de symboles entièrement installé en usine. La seconde est que le système doté d'un dispositif d'apprentissage inné manque d'opérations symboliques, mais avec les bonnes données et le bon environnement de formation, il a suffisamment de capacité pour les obtenir. Le troisième est un système qui ne peut pas obtenir un mécanisme complet de manipulation de symboles même avec une formation suffisante. Les systèmes d'apprentissage profond actuels semblent appartenir à la troisième catégorie : pas de mécanismes de manipulation symbolique au début, et pas de mécanismes de manipulation symbolique fiables dans le processus. Actuellement, comprendre les origines des opérations symboliques est notre priorité absolue. Même les plus ardents partisans des réseaux de neurones reconnaissent désormais l’importance des opérations symboliques dans la réalisation de l’IA. Et c'est exactement ce sur quoi la communauté neurosémiotique s'est concentrée : comment faire fonctionner en harmonie l'apprentissage basé sur les données et la représentation symbolique au sein d'une intelligence unique et plus puissante ?

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI