Maison >Périphériques technologiques >IA >Le SOTA d'apprentissage multitâche à grande échelle de Jeff Dean a été critiqué et sa reproduction coûterait 60 000 $ US.

Le SOTA d'apprentissage multitâche à grande échelle de Jeff Dean a été critiqué et sa reproduction coûterait 60 000 $ US.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-09 10:31:08999parcourir

En octobre 2021, Jeff Dean a personnellement écrit un article présentant une nouvelle architecture d'apprentissage automatique : Pathways.

L'objectif est très simple : permettre à une IA de couvrir des dizaines de milliers de tâches, de comprendre différents types de données et d'y parvenir avec une efficacité extrêmement élevée en même temps :

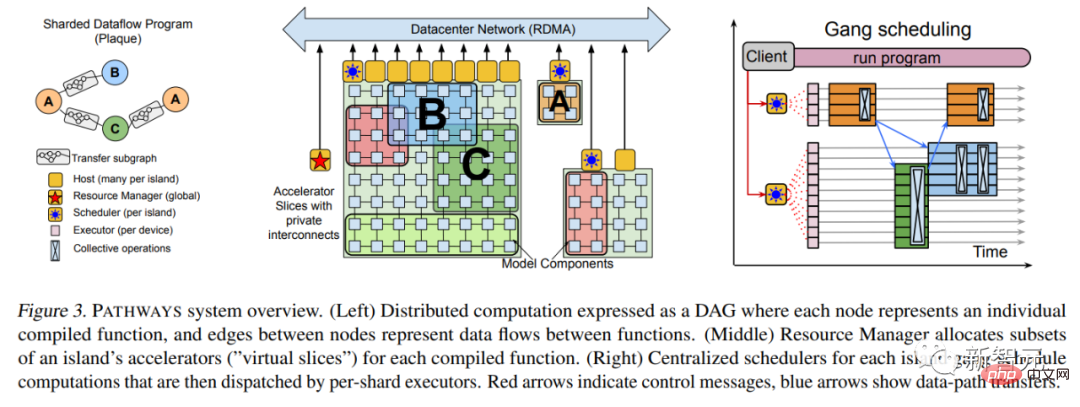

En mars 2022 , plus de six mois plus tard, en mars, Jeff Dean a finalement publié le document Pathways.

Lien papier : https://arxiv.org/abs/2203.12533

De nombreux détails techniques y sont ajoutés, tels que l'architecture système la plus élémentaire, etc.

En avril 2022, Google a utilisé le modèle de langage PaLM de Pathways pour émerger, brisant les SOTA de plusieurs tâches de traitement du langage naturel les unes après les autres. Ce modèle de langage Transformer avec 540 milliards de paramètres a prouvé une fois de plus que « de gros efforts peuvent produire des miracles ». ".

En plus d'utiliser le puissant système Pathways, l'article introduit que la formation de PaLM utilise 6144 TPU v4, en utilisant un ensemble de données de haute qualité de 780 milliards de jetons et une certaine proportion de corpus multilingue non anglais.

Adresse papier : https://arxiv.org/abs/2204.02311

Récemment, un nouveau travail de Jeff Dean a suscité des spéculations sur Pathways.

Une autre pièce du puzzle Pathways a-t-elle été assemblée ?

Il n'y a que deux auteurs de cet article : le célèbre Jeff Dean et l'ingénieur italien Andrea Gesmundo.

Ce qui est intéressant, c'est que non seulement Gesmundo est très discret, mais que Jeff Dean, qui vient de faire exploser son propre Imagen il y a deux jours, ne l'a pas du tout mentionné sur Twitter.

Après l'avoir lu, certains internautes ont émis l'hypothèse qu'il pourrait s'agir d'un composant des Pathways de l'architecture d'IA de nouvelle génération.

Adresse papier : https://arxiv.org/abs/2205.12755

L'idée de cet article est la suivante :

En incorporant dynamiquement de nouvelles tâches dans un grand système en cours d'exécution, Des données multiples clairsemées peuvent être exploitées. Des fragments de modèle d'apprentissage automatique de tâches pour améliorer la qualité des nouvelles tâches et partager automatiquement des fragments de modèle entre des tâches associées.

Cette approche peut améliorer la qualité de chaque tâche et améliorer l'efficacité du modèle en termes de temps de convergence, de nombre d'instances de formation, de consommation d'énergie, etc. Le cadre de problèmes d’apprentissage automatique proposé dans cet article peut être considéré comme une généralisation et une synthèse des formalisations standard multitâches et d’apprentissage continu.

Dans ce cadre, quelle que soit l'ampleur de l'ensemble des tâches, elles peuvent être résolues conjointement.

Et, au fil du temps, l'ensemble des tâches peut être élargi en ajoutant un flux continu de nouvelles tâches. La distinction entre les tâches de pré-formation et les tâches en aval disparaît également.

Car, à mesure que de nouvelles tâches sont ajoutées, le système cherchera comment combiner les connaissances et représentations existantes avec de nouvelles capacités de modèle pour atteindre un niveau de qualité élevé pour chaque nouvelle tâche. Les connaissances et les représentations acquises lors de la résolution d'une nouvelle tâche peuvent également être utilisées dans des tâches futures ou pour continuer l'apprentissage sur des tâches existantes.

Cette méthode est appelée « Mutation Multi-Task Network » ou µ2Net. (μ=Mutation)

Deux types de modèles de mutation pour des expériences d'apprentissage continu à grande échelle

En termes simples, il s'agit de générer un réseau multitâche à grande échelle pour résoudre conjointement plusieurs tâches. Non seulement la qualité et l’efficacité de chaque tâche sont améliorées, mais le modèle peut également être étendu en ajoutant dynamiquement de nouvelles tâches.

Plus les connaissances intégrées dans le système sont accumulées grâce à l'apprentissage des tâches précédentes, plus la qualité des solutions aux tâches suivantes est élevée.

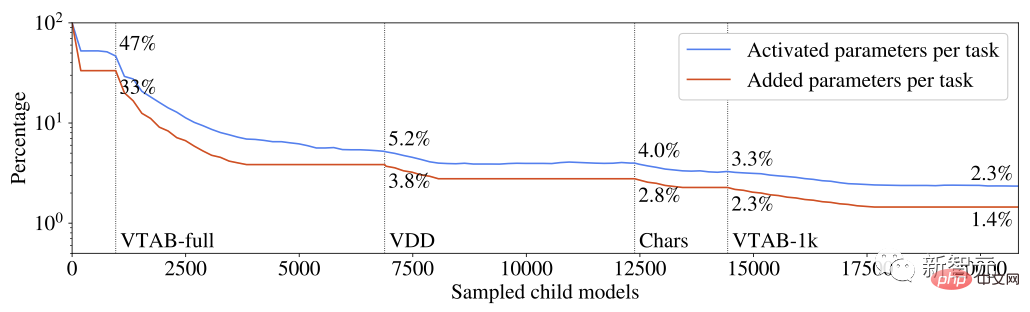

De plus, en termes de réduction des paramètres nouvellement ajoutés à chaque tâche, l'efficacité de la résolution de nouvelles tâches peut être continuellement améliorée. Le modèle multitâche généré est peu activé et le modèle intègre un mécanisme de routage basé sur les tâches. À mesure que le modèle se développe, l'augmentation du coût de calcul de chaque tâche est garantie d'être limitée.

Le pourcentage de paramètres activés et augmentés par chaque tâche par rapport au nombre total de paramètres du système multitâche

Les connaissances apprises de chaque tâche sont divisées en parties qui peuvent être réutilisées par plusieurs tâches. Des expériences ont montré que cette technique de segmentation évite les problèmes courants des modèles multitâches et d'apprentissage continu, tels que l'oubli catastrophique, l'interférence de gradient et le transfert négatif.

L'exploration de l'espace de la route des tâches et l'identification du sous-ensemble de connaissances préalables le plus pertinent pour chaque tâche sont guidées par un algorithme évolutif conçu pour ajuster dynamiquement l'équilibre exploration/exploitation sans travail manuel Ajuster les méta-paramètres. La même logique évolutive est utilisée pour ajuster dynamiquement les composants du modèle multitâche hyperparamétrique.

Puisqu'on l'appelle "réseau de mutation", comment expliquez-vous cette mutation ?

Les réseaux de neurones profonds sont souvent définis par l'architecture et les hyperparamètres. L'architecture de cet article est composée d'une série de couches de réseaux neuronaux. Chaque couche mappe un vecteur d'entrée sur un vecteur de sortie de dimension variable, et les détails de l'instanciation du réseau, tels que la configuration de l'optimiseur ou le prétraitement des données, sont déterminés par des hyperparamètres.

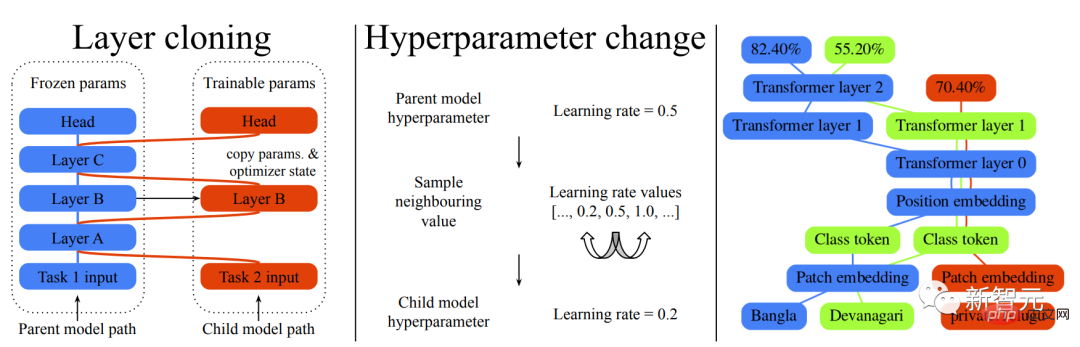

Ainsi, les mutations mentionnées ici sont également divisées en deux catégories, les mutations de clonage de couches et les mutations d'hyperparamètres.

La mutation clone de couche crée une copie de n'importe quelle couche de modèle parent qui peut être entraînée par le modèle enfant. Si une couche du modèle parent n'est pas sélectionnée pour le clonage, l'état actuel est gelé et partagé avec le modèle enfant pour garantir l'invariance du modèle préexistant.

La mutation hyperparamètre est utilisée pour modifier la configuration héritée par la couche enfant de la couche parent. La nouvelle valeur de chaque hyperparamètre peut être extraite d'un ensemble de valeurs valides. Pour les hyperparamètres numériques, l'ensemble des valeurs valides est trié sous forme de liste et l'échantillonnage est limité aux valeurs adjacentes pour appliquer une contrainte de changement incrémentiel.

Jetons un coup d'œil à l'effet réel :

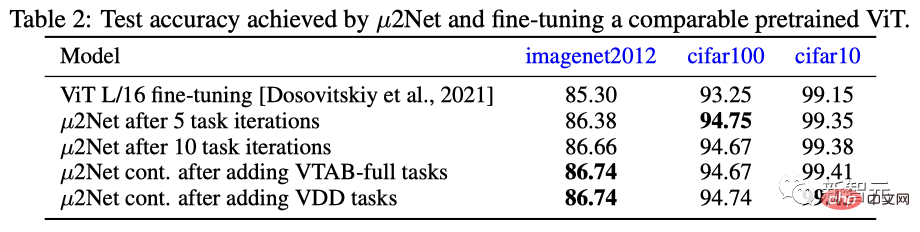

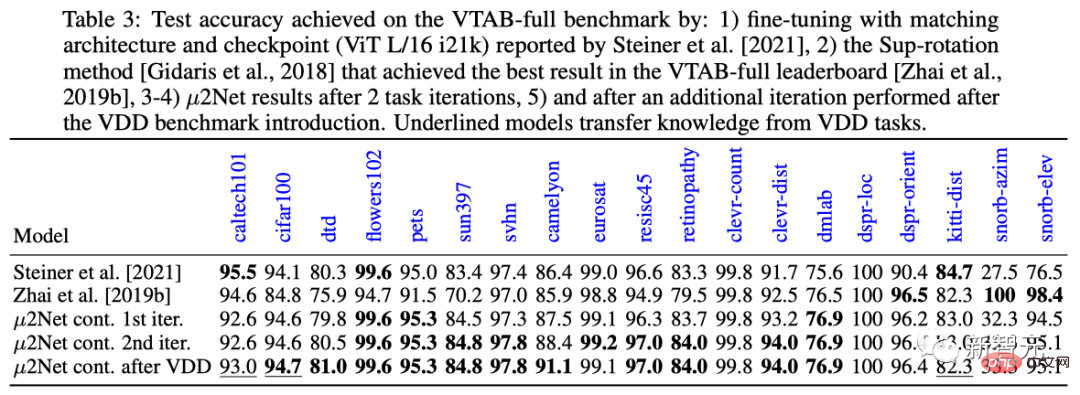

Sur les trois ensembles de données d'ImageNet 2012, cifar100 et cifar10, les performances de µ2Net après 5 itérations de tâches et 10 itérations de tâches ont dépassé les performances les plus générales et les plus performantes actuelles. Bon modèle affiné pré-entraîné ViT.

En termes d'expansion des tâches, après l'ajout des tâches d'apprentissage continu VTAB-full et VDD, les performances de µ2Net ont été encore améliorées. Les performances des tâches d'apprentissage continu VDD sur l'ensemble de données cifar10 ont atteint le meilleur résultat de 99,43 %.

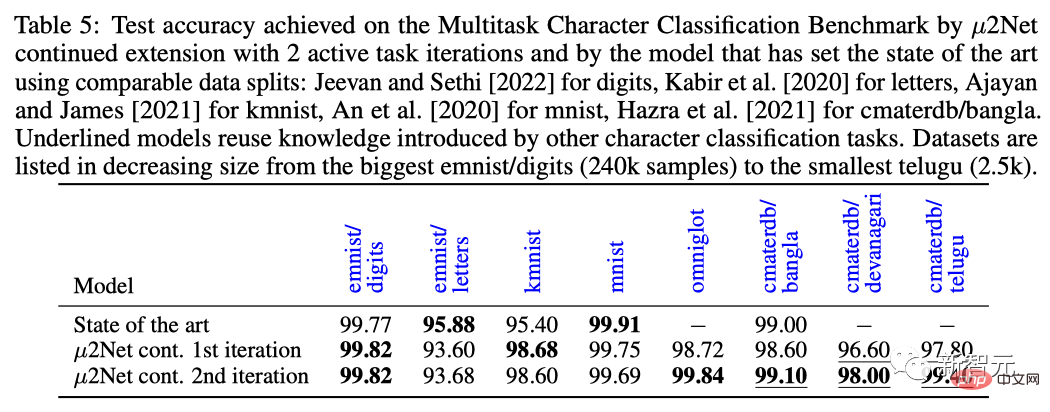

Sur la tâche de référence de classification de caractères multitâches, après deux itérations de tâches, µ2Net a actualisé le niveau SOTA sur la plupart des ensembles de données, avec des tailles d'ensemble de données allant de 2,5 000 à 240 000 tailles d'échantillon.

En termes simples, dans cette architecture, plus le modèle apprend de tâches, plus le système apprend de connaissances et plus il est facile de résoudre de nouvelles tâches.

Par exemple, une architecture ViT-L (307 millions de paramètres) peut évoluer vers un système multitâche avec 130,87 milliards de paramètres et résoudre 69 tâches.

De plus, à mesure que le système se développe, la rareté des activations de paramètres maintient constants l'effort de calcul et l'utilisation de la mémoire de chaque tâche. Les expériences montrent que le nombre moyen de paramètres ajoutés pour chaque tâche est réduit de 38 %, alors que le système multitâche n'active que 2,3 % du total des paramètres pour chaque tâche.

Bien sûr, à ce stade, il ne s'agit que d'une architecture et d'une expérimentation préliminaire.

Internaute : Le journal est très bon, mais...

Bien que le journal soit génial, certaines personnes ne semblent pas l'acheter.

Certains internautes qui adorent exposer les nouveaux vêtements de l'empereur postés sur Reddit, disant qu'ils ne croient plus en l'amour... Oh non, c'est un article sur l'IA produit par un "laboratoire/institution de recherche de premier plan".

L'internaute portant la carte d'identité "M. Acurite" a déclaré qu'il croyait naturellement aux données et aux résultats des opérations de modèle contenus dans ces documents.

Mais prenons cet article de l'enseignant Jeff Dean comme exemple. L'article de 18 pages parle d'un algorithme de convolution évolutive et d'apprentissage multitâche particulièrement complexe. Il est puissant, accrocheur et très apprécié.

Cependant, deux points doivent être soulignés :

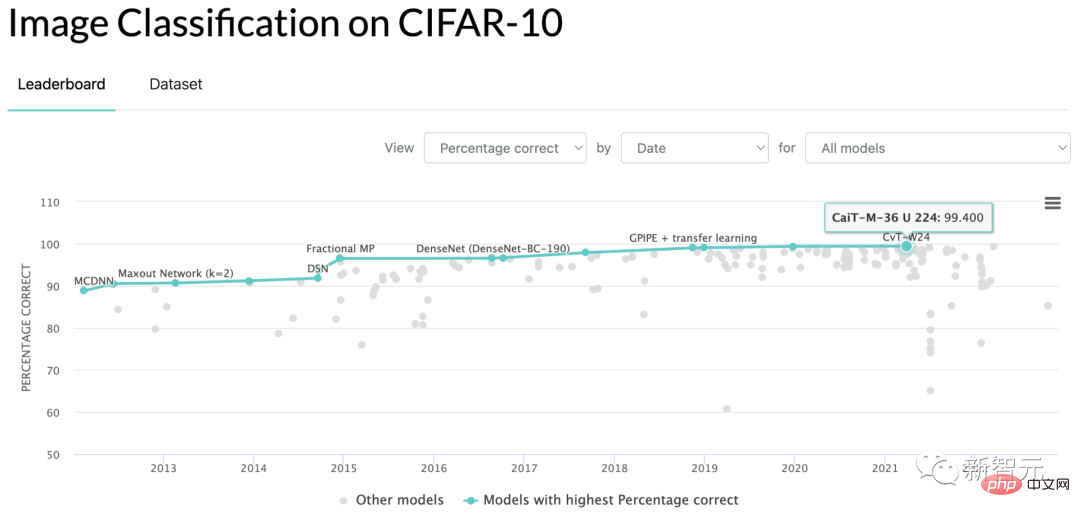

Premièrement, les résultats du score courant proposés par Jeff Dean dans l'article pour prouver qu'ils sont meilleurs que les produits concurrents sont la précision de référence CIFAR-10 de 99,43, ce qui est mieux que de dépasser les 99,40 actuels de la SOTA...

Je ne peux pas dire que c'est une arnaque, mais c'est vraiment difficile à décrire avec des mots.

Deuxièmement, à la fin de l'article, il y a un tableau de consommation de temps pour utiliser l'algorithme d'exécution TPU pour obtenir les résultats finaux, totalisant 17 810 heures.

Supposons que quelqu'un ne travaille pas chez Google et souhaite reproduire les résultats de l'article et loue un TPU au prix du marché de 3,22 USD de l'heure pour le faire fonctionner à nouveau, le coût sera de 57 348 USD.

Qu'est-ce que cela signifie ? Faut-il fixer un seuil de compétence même pour les quotidiens ?

Bien sûr, cette approche est désormais une tendance dans l'industrie, y compris, mais sans s'y limiter, chez les grands acteurs tels que Google et OpenAI. Tout le monde apporte dans le modèle quelques idées pour améliorer le statu quo, ainsi que de nombreuses données et références prétraitées.

Ensuite, tant que le résultat courant est numériquement supérieur à celui de l'adversaire, même de deux décimales après un point de pourcentage, le chercheur peut ajouter en toute confiance une nouvelle ligne de titre de thèse au CV !

En quoi cela va-t-il réellement promouvoir les milieux académiques et industriels ? Les étudiants diplômés ordinaires ne peuvent pas se permettre de dépenser de l'argent pour vérifier vos conclusions, et les entreprises ordinaires ne peuvent pas utiliser des critères aussi ennuyeux dans leurs projets.

La même phrase, qu'est-ce que ça veut dire ?

Est-ce la zone de confort acceptable dans le monde de l'IA ? Un petit groupe de grandes entreprises, et parfois de grandes écoles, montrent chaque jour que j'ai de l'argent et que je peux faire ce que je veux, mais vous n'avez pas d'argent et devez être à la traîne ?

Si nous continuons ainsi, autant ouvrir une autre revue informatique et simplement collecter des articles dont les résultats peuvent être reproduits sur une carte graphique autonome grand public en huit heures.

Dans le fil de discussion, des étudiants diplômés ayant des travaux de thèse ont exprimé leurs plaintes.

Un internaute dont l'identifiant est "Support Vector Machine" a déclaré qu'il est praticien dans un petit laboratoire. En raison de cet élan, il a presque complètement perdu la motivation de continuer à s'engager dans l'apprentissage profond.

Parce qu'avec le budget de mon propre laboratoire, je ne peux pas rivaliser avec ces géants, et je ne peux pas produire de résultats de référence qui montrent des performances concrètes.

Même si vous avez une nouvelle idée théorique, il est difficile de rédiger un article qui puisse passer l'examen. En effet, les examinateurs actuels de l'article ont développé un « biais de belle image » en raison de la capacité des grands fabricants. Les images utilisées pour les tests dans l'article ne sont pas belles et tout est en vain.

Ce n’est pas que les constructeurs géants soient inutiles, des projets comme GPT et DALL-E sont vraiment révolutionnaires. Mais si ma propre machine ne peut pas fonctionner, pourquoi devrais-je être excité ?

Un autre internaute doctorant s'est présenté et a commenté le message pour soutenir "Support Vector Machine".

J'ai soumis un article sur le modèle de flux il y a deux ans en tant que doctorant. Il portait principalement sur la découverte de l'espace potentiel des données pouvant être échantillonnées, et il n'avait aucun impact sur la qualité de la génération d'images du modèle.

En conséquence, le commentaire critique donné par le correcteur du papier était : "L'image générée n'est pas aussi belle que celle générée par GAN."

Un autre étudiant diplômé portant le nom d'identification "Uday" a également déclaré que le critique qui a noté l'article qu'il a soumis pour la conférence en 2021 était : "Les données ne sont pas assez sophistiquées

Il semble que le la main-d’œuvre est insuffisante. C’est vraiment une tendance mondiale selon laquelle la psychologie de l’Orient et de l’Occident est la même et que le taoïsme chinois et étranger ne sont pas séparés.

Dans seulement 30 ans depuis Hedong et 30 ans depuis Hexi, peut-être que la mise en œuvre à la base d'algorithmes et de capitalisation universelle apportera le deuxième miracle des startups de garage battant IBM.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI