Maison >Périphériques technologiques >IA >Basée sur le transfert d'éléments multimodaux, la méthode de segmentation d'objets vidéo de référence de l'Université de technologie Meitu & Dalian ne nécessite qu'une seule étape

Basée sur le transfert d'éléments multimodaux, la méthode de segmentation d'objets vidéo de référence de l'Université de technologie Meitu & Dalian ne nécessite qu'une seule étape

- 王林avant

- 2023-04-08 21:21:071132parcourir

Introduction

Referring VOS (RVOS) est une tâche nouvellement émergente, qui vise à segmenter les objets référencés par le texte à partir d'une séquence vidéo basée sur le texte de référence. Comparé à la segmentation d'objets vidéo semi-supervisée, RVOS s'appuie uniquement sur des descriptions de langage abstrait au lieu de masques de référence au niveau des pixels, offrant une option plus pratique pour l'interaction homme-machine et a donc reçu une large attention. L'objectif principal de cette recherche est de résoudre les problèmes rencontrés dans les RVOS existants. tâches Deux défis majeurs :

; Comment abandonner la stratégie en deux étapes des méthodes existantes (c'est-à-dire obtenir d'abord un résultat approximatif image par image au niveau de l'image, puis utiliser le résultat comme référence et obtenir la prédiction finale grâce à un raffinement structurel avec des informations temporelles améliorées ), unifiant l'ensemble de la tâche RVOS dans un cadre en une seule étape.

À cet égard, cette recherche propose un cadre RVOS de bout en bout pour la

- migration d'éléments intermodaux - YOFO Ses principales contributions et innovations sont :

Propose un module d'exploration de fonctionnalités multi-échelles multimodales (Multi-Scale Cross -Modal Feature Mining), qui peut intégrer pleinement des fonctionnalités utiles ; en langage et en images. Stratégie de mise en œuvre

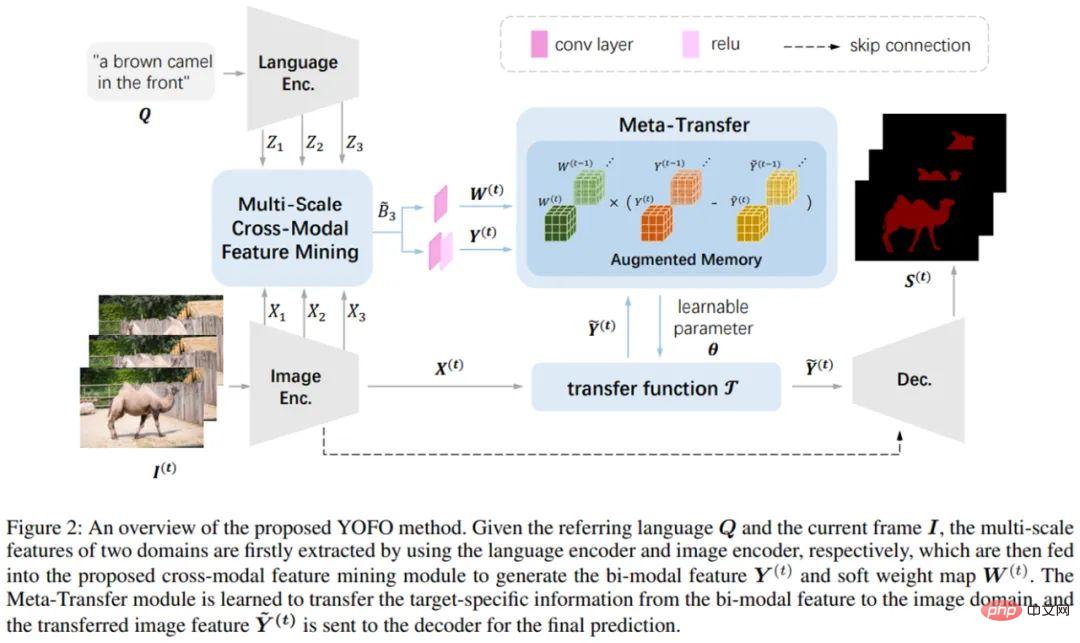

- Le processus principal du framework YOFO est le suivant : les images et les textes d'entrée sont d'abord extraits respectivement par l'encodeur d'image et l'encodeur de langue, puis fusionnés dans la fonctionnalité multi-échelle multimodale module minier. Les caractéristiques bimodales fusionnées sont simplifiées dans le module de méta-transfert qui contient la bibliothèque de mémoire pour éliminer les informations redondantes dans les caractéristiques du langage. En même temps, les informations temporelles peuvent être préservées pour améliorer la corrélation temporelle, et finalement les résultats de segmentation sont obtenus grâce à une méthode de segmentation. décodeur.

- Figure 1 : Processus principal du framework YOFO.

Module d'exploration de fonctionnalités multimodales multi-échelles

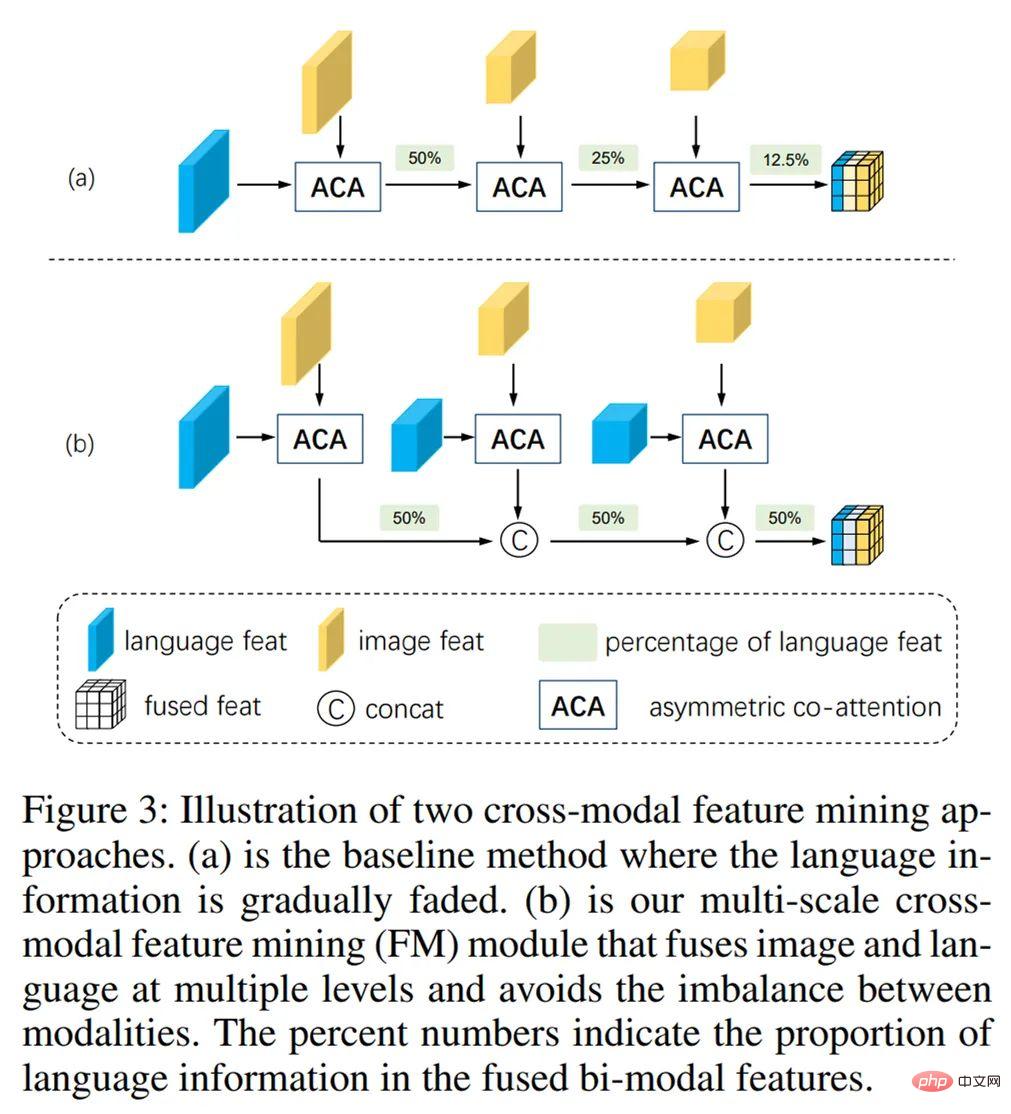

: Ce module peut maintenir la relation entre les informations d'échelle véhiculées par les caractéristiques de l'image et les caractéristiques du langage en fusionnant progressivement deux caractéristiques modales d'échelles différentes. La cohérence, et plus important encore, garantit que les informations linguistiques ne seront pas diluées et submergées par des informations d'images multi-échelles pendant le processus de fusion.

: Ce module peut maintenir la relation entre les informations d'échelle véhiculées par les caractéristiques de l'image et les caractéristiques du langage en fusionnant progressivement deux caractéristiques modales d'échelles différentes. La cohérence, et plus important encore, garantit que les informations linguistiques ne seront pas diluées et submergées par des informations d'images multi-échelles pendant le processus de fusion.

Figure 2 : Module d'exploration de fonctionnalités multimodales et multi-échelles.

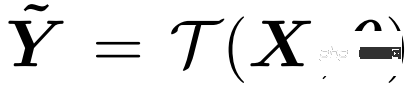

Module de méta-migration : Une stratégie d'apprentissage à apprendre est adoptée, et le processus peut être simplement décrit comme la fonction de cartographie suivante. Où la fonction de migration est une convolution, alors est son paramètre de noyau de convolution :

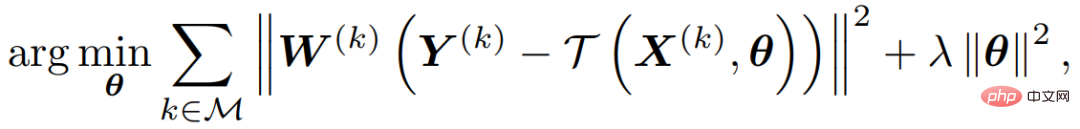

Le processus d'optimisation peut être exprimé comme la fonction objectif suivante :

Parmi elles, M représente la banque de mémoire qui peut stocker des informations historiques, et W représente le poids des différentes positions, ce qui peut donner différentes positions pour différentes caractéristiques. Le degré d'attention, Y, représente les caractéristiques bimodales de chaque image vidéo stockée dans la banque de mémoire. Ce processus d'optimisation maximise la capacité de la fonction de méta-transfert à reconstruire les fonctionnalités bimodales et permet également à l'ensemble du framework d'être formé de bout en bout.

Formation et tests : La fonction de perte utilisée dans la formation est la perte lovasz, et l'ensemble de formation est constitué de deux ensembles de données vidéo Ref-DAVIS2017 et Ref-Youtube-VOS, et est réalisé via l'ensemble de données statiques Ref -La transformation affine aléatoire COCO simule les données vidéo comme formation auxiliaire. Le processus de méta-migration est effectué pendant la formation et la prédiction, et l'ensemble du réseau fonctionne à une vitesse de 10 FPS sur 1080ti.

Résultats expérimentaux

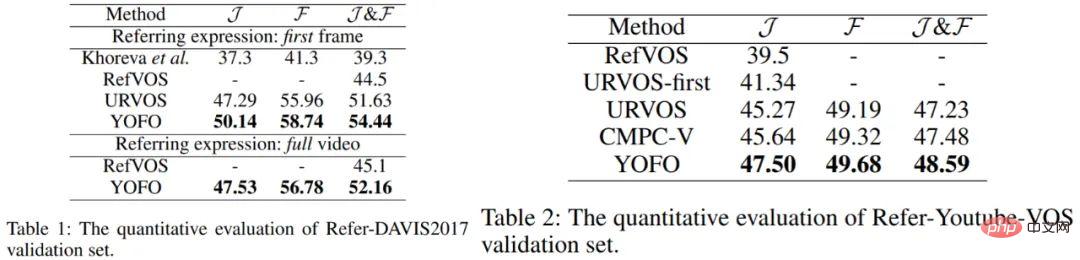

La méthode utilisée dans la recherche a obtenu d'excellents résultats sur deux ensembles de données RVOS grand public (Ref-DAVIS2017 et Ref-Youtube-VOS). Les indicateurs quantitatifs et certains rendus de visualisation sont les suivants :

.

Figure 3 : Indicateurs quantitatifs sur deux ensembles de données principales.

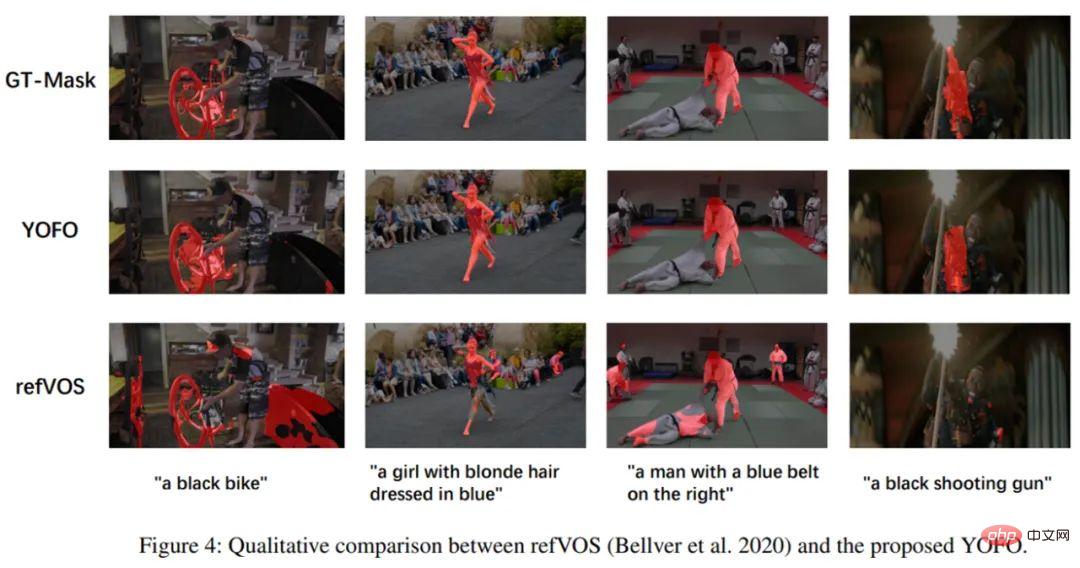

Figure 4 : Visualisation sur l'ensemble de données VOS.

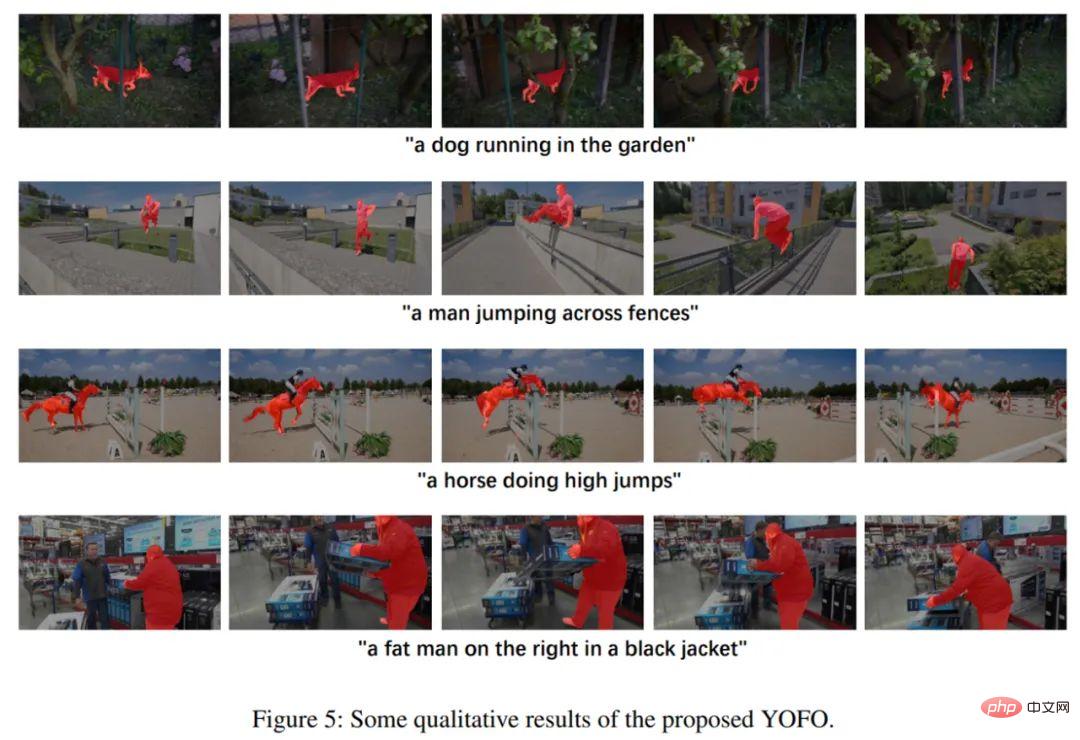

Figure 5 : Autres effets de visualisation de YOFO.

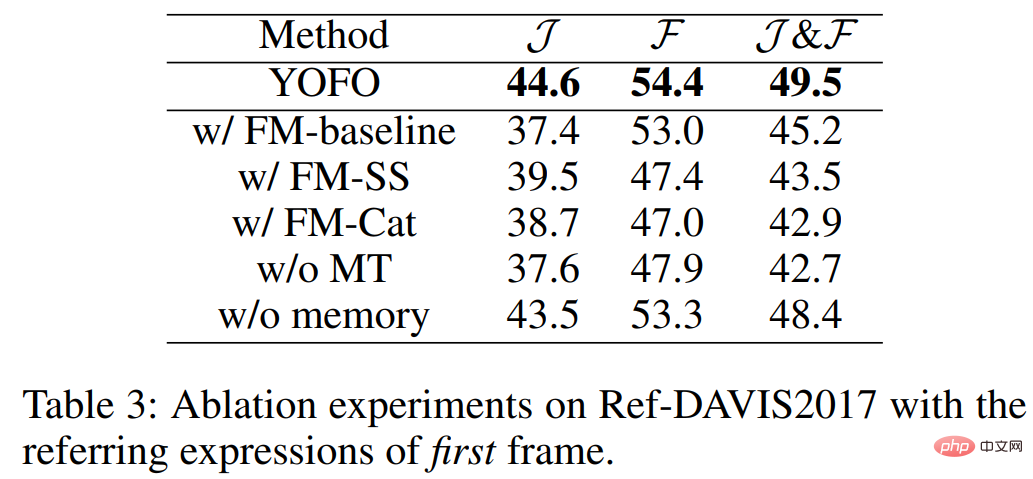

L'étude a également mené une série d'expériences d'ablation pour illustrer l'efficacité du module d'exploration de fonctionnalités (FM) et du module de méta-transfert (MT).

Figure 6 : Efficacité du module d'exploration de fonctionnalités (FM) et du module de méta-transfert (MT).

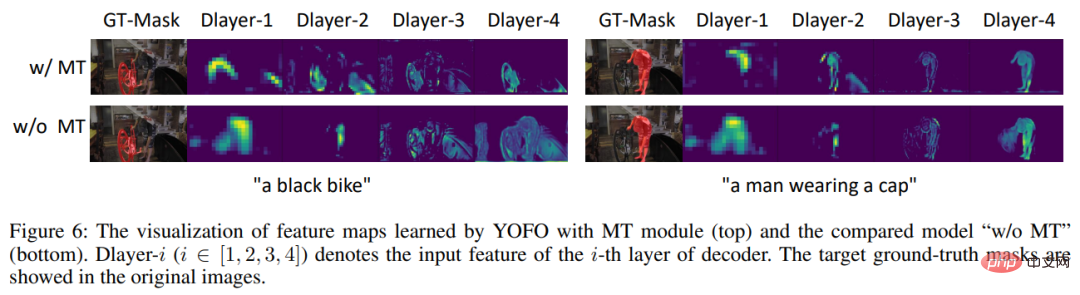

De plus, l'étude a visualisé les caractéristiques de sortie du décodeur utilisant le module MT et n'utilisant pas le module MT. On voit clairement que le module MT peut capturer correctement le contenu décrit par le langage et effectuer des bruits d'interférence. .filtrer.

Figure 7 : Comparaison des fonctionnalités de sortie du décodeur avant et après l'utilisation du module MT. À propos de l'équipe de recherche

Cet article a été proposé conjointement par des chercheurs du Meitu Imaging Research Institute (MT Lab) et l'équipe Lu Huchuan de l'Université de technologie de Dalian. Le Meitu Imaging Research Institute (MT Lab) est l'équipe de Meitu dédiée à la recherche d'algorithmes, au développement technique et à la production dans les domaines de la vision par ordinateur, de l'apprentissage automatique, de la réalité augmentée, du cloud computing et d'autres domaines. Elle constitue la base des produits existants et futurs de Meitu. Il fournit un support d'algorithme de base et favorise le développement de produits Meitu grâce à une technologie de pointe. Il est connu sous le nom de « Centre technologique Meitu ». Il a participé aux principales conférences internationales de vision par ordinateur telles que CVPR, ICCV et ECCV, et en a remporté davantage. plus de dix championnats et finalistes.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI