Maison >Périphériques technologiques >IA >Parlons de reconnaissance d'image : réseau de neurones récurrents

Parlons de reconnaissance d'image : réseau de neurones récurrents

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-08 15:11:031683parcourir

Cet article est réimprimé du compte public WeChat « Vivre à l'ère de l'information ». L'auteur vit à l'ère de l'information. Pour réimprimer cet article, veuillez contacter le compte public Vivre à l’ère de l’information.

Le réseau neuronal récurrent (RNN) est principalement utilisé pour résoudre des problèmes de données de séquence. La raison pour laquelle il s’agit d’un réseau neuronal récurrent est que la sortie actuelle d’une séquence est également liée à la sortie précédente. Le réseau RNN mémorise les informations des moments précédents et les applique au calcul de sortie actuel. Contrairement au réseau neuronal convolutif, les neurones des couches cachées du réseau neuronal récurrent sont connectés les uns aux autres. déterminé par l'entrée La sortie de la couche est composée de la sortie des neurones cachés à l'instant précédent. Bien que le réseau RNN ait obtenu des résultats remarquables, il présente certains défauts et limites, tels que : difficulté de formation, faible précision, faible efficacité, longue durée, etc. Par conséquent, certains modèles de réseau améliorés basés sur RNN ont été progressivement développés, tels que comme : Mémoire Long Court Terme (LSTM), RNN bidirectionnel, LSTM bidirectionnel, GRU, etc. Ces modèles RNN améliorés ont montré des résultats exceptionnels dans le domaine de la reconnaissance d’images et sont largement utilisés. En prenant le réseau LSTM comme exemple, nous présenterons sa structure principale de réseau.

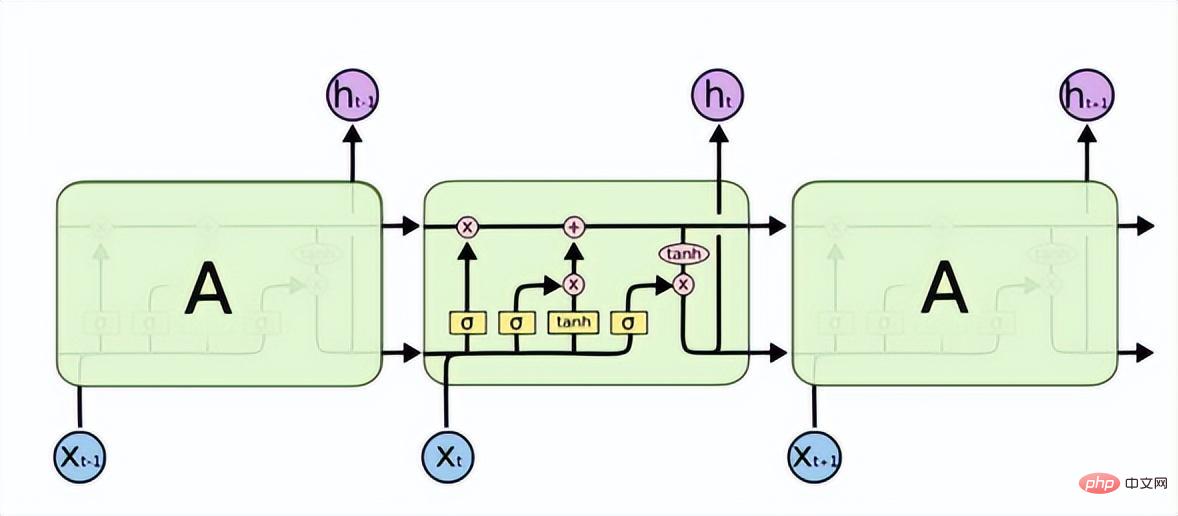

La mémoire à long terme (LSTM) résout les problèmes de disparition ou d'explosion de gradient dans RNN et peut apprendre les problèmes de dépendance à long terme. Sa structure est la suivante.

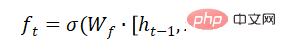

LSTM dispose de trois portes pour transmettre sélectivement les informations : la porte d'oubli, la porte d'entrée et la porte de sortie. La porte d'oubli détermine quelles informations peuvent passer par cette cellule. Il est mis en œuvre à travers une couche neuronale sigmoïde. Son entrée est et la sortie est un vecteur avec une valeur comprise entre (0, 1), représentant la proportion de chaque partie de l'information autorisée à passer. 0 signifie « ne laisser passer aucune information », 1 signifie « laisser passer toutes les informations ».

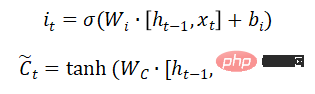

La porte d'entrée détermine la quantité de nouvelles informations ajoutées à l'état de la cellule. Une couche tanh génère un vecteur, qui est le contenu alternatif pour la mise à jour.

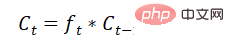

Mettre à jour l'état de la cellule :

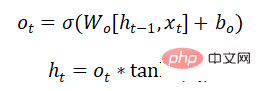

Quelle partie des informations de la décision de la porte de sortie est émise :

Le modèle de réseau GRU résout également le problème de la disparition du gradient ou gradient dans RNN Les problèmes tels que les explosions peuvent apprendre des dépendances à long terme. C'est une déformation du LSTM. La structure est plus simple que le LSTM, a moins de paramètres et le temps de formation est également plus court que le LSTM. Il est également largement utilisé dans la reconnaissance vocale, la description d’images, le traitement du langage naturel et d’autres scénarios.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI