Maison >Périphériques technologiques >IA >Les pirates informatiques utilisent la technologie révolutionnaire de l'IA pour postuler à des emplois. Les problèmes de sécurité de l'intelligence artificielle ne peuvent être ignorés.

Les pirates informatiques utilisent la technologie révolutionnaire de l'IA pour postuler à des emplois. Les problèmes de sécurité de l'intelligence artificielle ne peuvent être ignorés.

- PHPzavant

- 2023-04-08 14:51:141268parcourir

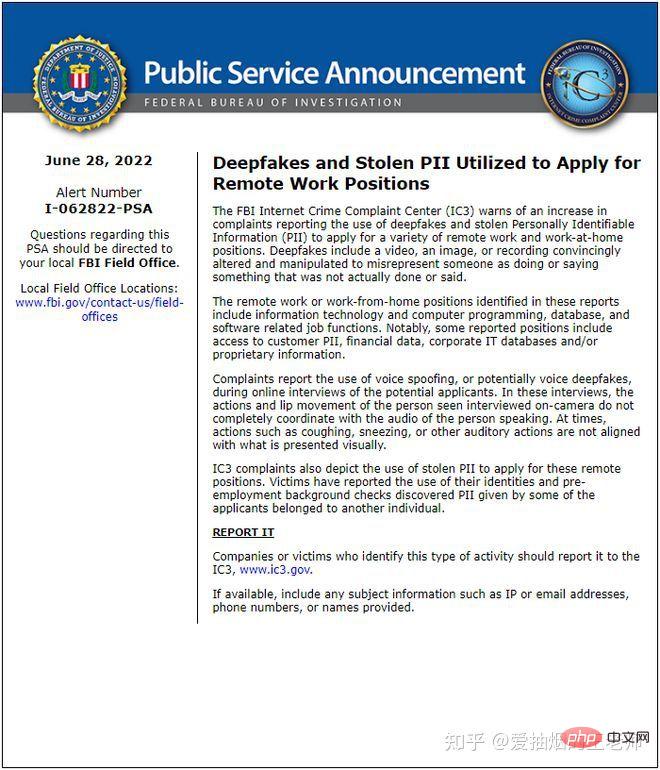

Après l'épidémie aux États-Unis, de nombreuses entreprises ont adopté le modèle « Work From Home » (WFH). Le Crime Complaint Center du FBI a déclaré avoir récemment reçu des plaintes de nombreux employeurs selon lesquelles, au cours du processus de recrutement, des candidats avaient volé l'identité d'autrui et utilisé la technologie Deepfake pour participer à des entretiens à distance.

Ces postes concernent les technologies de l'information, les programmes informatiques, les bases de données et les domaines liés aux logiciels. Certains demandeurs d'emploi tentent d'utiliser l'expérience et l'expertise des autres pour obtenir un emploi et utilisent la technologie Deepfake pour simuler des vidéos.

Ils ont constaté que lors d’entretiens en ligne avec des demandeurs d’emploi, les mouvements du demandeur d’emploi ou l’ouverture et la fermeture de ses lèvres n’étaient pas cohérents avec sa voix. Par exemple, lorsque des éternuements ou des toux se produisaient, les images n’étaient pas synchronisées.

Lorsqu'ils ont vérifié les antécédents de ces demandeurs d'emploi, ils ont découvert que certains demandeurs d'emploi utilisaient en fait l'identité d'autres personnes pour trouver un emploi. Si vous recherchez simplement un emploi, cela reste un petit problème, mais s'il s'agit d'un pirate informatique, une fois le contrat signé avec succès, il pourra entrer avec succès dans l'entreprise et accéder aux données confidentielles.

Êtes-vous également curieux, ce logiciel est-il si simple à utiliser ?

La réponse est qu’elle est effectivement très avancée.

Deepfake utilise la puissante capacité de génération d'images du Generative Adversarial Network (GAN), qui peut combiner et superposer n'importe quelle image et vidéo existante sur l'image et la vidéo source. Il peut enregistrer les détails du visage d'une personne. Après des années de développement, la technologie Deepfake peut désormais changer de visage en temps réel sans aucun sentiment de violation.

Cependant, en ce qui concerne les vidéos, il est difficile pour les Deepfakes d'animer les expressions faciales avec une grande confiance. Les personnes présentes dans la vidéo ne clignent jamais des yeux, ou clignent des yeux trop fréquemment ou de manière anormale. De plus, les images audio et factices ne correspondront pas assez naturellement.

Donc, si ce genre de vidéo dure 10 secondes, cela rendra les gens méfiants. L'intégralité de l'entretien prendra plus de temps et il sera plus facile d'exposer les défauts.

Le progrès et le changement dans la science et la technologie sont une arme à double tranchant.

Bien que la technologie de l'intelligence artificielle nous offre d'énormes commodités, elle peut également entraîner une série de problèmes tels que la sécurité, l'éthique et la confidentialité.

L'essence du développement de l'intelligence artificielle est d'utiliser des algorithmes, de la puissance de calcul et des données pour résoudre des problèmes déterministes dans des informations complètes et des environnements structurés. À l'ère du support des données, l'intelligence artificielle est confrontée à de nombreux risques de sécurité

Tout d'abord, elle peut être confrontée à des attaques d'empoisonnement.

C'est-à-dire que les pirates injectent des données malveillantes pour réduire la fiabilité et la précision du système d'IA, conduisant ainsi à des erreurs de prise de décision en matière d'intelligence artificielle. L'ajout de fausses données, d'échantillons malveillants, etc. aux données d'entraînement détruira l'intégrité des données, ce qui entraînera des écarts dans la prise de décision du modèle d'algorithme entraîné.

Si ce type d'opération est utilisé dans le domaine de la conduite autonome, il est probable que le véhicule enfreigne le code de la route et même provoque un accident de la route.

Deuxièmement, il y aura le problème des fuites de données.

Les attaques inversées peuvent entraîner des fuites de données au sein du modèle d'algorithme. De nos jours, divers appareils intelligents tels que les bracelets intelligents, les systèmes d'identification biométrique de haut-parleurs intelligents et les systèmes médicaux intelligents sont largement utilisés, et les informations personnelles sont collectées dans toutes les directions. Y compris les visages, les empreintes digitales, les empreintes vocales, les iris, les battements de cœur, les gènes, etc., ces informations sont uniques et immuables, et une fois divulguées ou mal utilisées, elles auront de graves conséquences.

Par exemple, il a été révélé qu'un grand nombre de photos de visage collectées par un grand nombre de magasins nationaux sans le consentement de l'utilisateur ont été divulguées. Ces photos de visage ont été plus ou moins divulguées sur des produits noirs, et il y aura fraude ou. fraude. Risques pour la sécurité financière.

Encore une fois, vous serez confronté à des risques de réseau.

L'intelligence artificielle introduira inévitablement des connexions réseau, et la technologie de l'intelligence artificielle elle-même peut également améliorer le niveau d'intelligence des attaques réseau, puis mener des attaques intelligentes de vol de données et d'extorsion de données ou générer automatiquement une grande quantité de fausses informations sur les menaces pour attaquer l'analyse. système.

Les principales méthodes d'attaque comprennent : les attaques de contournement, les attaques par inférence, les attaques par porte dérobée, les attaques d'extraction de modèle, les attaques par inférence d'attribution, les attaques de chevaux de Troie, les attaques d'inversion de modèle, les attaques anti-filigrane et les attaques de reprogrammation.

Nous devons clairement comprendre que la sécurité des données à l’ère de l’intelligence artificielle est également confrontée à de nombreux nouveaux défis. La protection de la sécurité des données et de la sécurité des algorithmes est devenue une priorité absolue pour les entreprises.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI