Maison >Périphériques technologiques >IA >Pourquoi les modèles arborescents surpassent-ils toujours l'apprentissage profond sur les données tabulaires ?

Pourquoi les modèles arborescents surpassent-ils toujours l'apprentissage profond sur les données tabulaires ?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-08 14:41:031658parcourir

Le deep learning a fait d'énormes progrès dans des domaines tels que les images, le langage et même l'audio. Cependant, l’apprentissage profond fonctionne médiocrement lorsqu’il s’agit de traiter des données tabulaires. Étant donné que les données tabulaires présentent des caractéristiques telles que des caractéristiques inégales, une petite taille d’échantillon et de grandes valeurs extrêmes, il est difficile de trouver les invariants correspondants.

Les modèles basés sur des arbres ne sont pas différenciables et ne peuvent pas être entraînés conjointement avec des modules d'apprentissage profond, la création d'architectures d'apprentissage profond spécifiques aux tables est donc un domaine de recherche très actif. De nombreuses études ont prétendu être capables de battre ou de rivaliser avec les modèles basés sur les arbres, mais leurs études ont suscité beaucoup de scepticisme.

Le fait que l'apprentissage sur des données tabulaires manque de repères établis donne aux chercheurs une grande liberté dans l'évaluation de leurs méthodes. De plus, la plupart des ensembles de données tabulaires disponibles en ligne sont petits par rapport aux références d’autres sous-domaines d’apprentissage automatique, ce qui rend l’évaluation plus difficile.

Pour atténuer ces inquiétudes, des chercheurs de l'Institut national de l'information et de l'automatisation, de la Sorbonne Université et d'autres institutions proposent un benchmark de données tabulaires qui peut évaluer les derniers modèles d'apprentissage profond et montrer que les modèles arborescents sont plus efficaces à Still SOTA de taille moyenne sur des ensembles de données tabulaires.

Pour cette conclusion, l'article donne des preuves concluantes. Sur les données tabulaires, il est plus facile d'obtenir de bonnes prédictions en utilisant des méthodes arborescentes que l'apprentissage en profondeur (même les architectures modernes) ont également découvert la raison.

Adresse papier : https://hal.archives-ouvertes.fr/hal-03723551/documentIl est à noter que l'un des auteurs de l'article est Gaël Varoquaux, qui est un Auteur de Scikit-learn. L'un des leaders du programme. Le projet est désormais devenu l’une des bibliothèques d’apprentissage automatique les plus populaires sur GitHub. L'article « Scikit-learn : Machine learning en Python » de Gaël Varoquaux compte 58 949 citations.

La contribution de cet article peut être résumée comme suit :

Cette étude crée un nouveau benchmark pour les données tabulaires (sélection de 45 ensembles de données ouverts) et partage ces ensembles de données via OpenML, ce qui les rend faciles à utiliser. .

Cette étude compare les modèles d'apprentissage profond et les modèles arborescents sous divers paramètres sur des données tabulaires et considère le coût de sélection des hyperparamètres. L’étude partage également les résultats bruts de recherches aléatoires, qui permettront aux chercheurs de tester de nouveaux algorithmes à moindre coût pour un budget d’optimisation d’hyperparamètres fixe.

Sur les données tabulaires, les modèles arborescents sont toujours meilleurs que les méthodes d'apprentissage profond

Le nouveau benchmark fait référence à 45 ensembles de données tabulaires, et le benchmark de sélection est le suivant :

- Colonnes hétérogènes, les colonnes doivent correspondent à différentes propriétés, excluant ainsi les ensembles de données d'image ou de signal.

- Faible dimensionnalité, le rapport d/n de l'ensemble de données est inférieur à 1/10.

- Ensembles de données invalides, supprimez les ensembles de données avec peu d'informations disponibles.

- Données I.I.D. (Indépendamment et I.D.), supprimant les ensembles de données de type flux ou les séries chronologiques.

- Données du monde réel, supprimez les ensembles de données artificiels mais conservez certains ensembles de données simulés.

- L'ensemble de données ne peut pas être trop petit, supprimez les ensembles de données avec trop peu de fonctionnalités (

- Supprimez les ensembles de données trop simples.

- Supprimez les ensembles de données pour des jeux comme le poker et les échecs, car ces ensembles de données sont de nature déterministe.

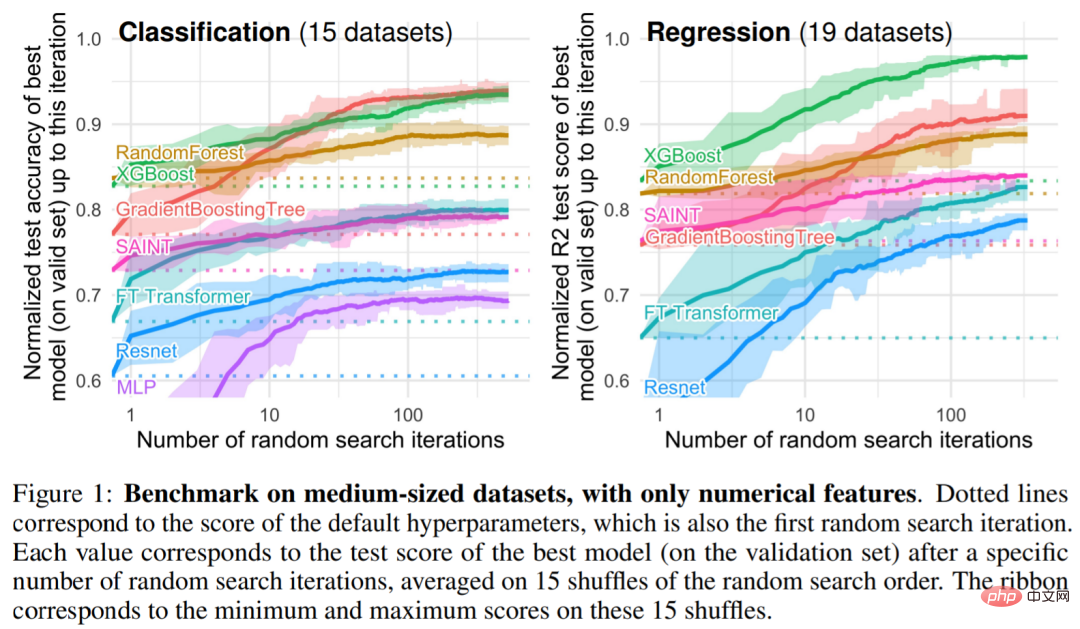

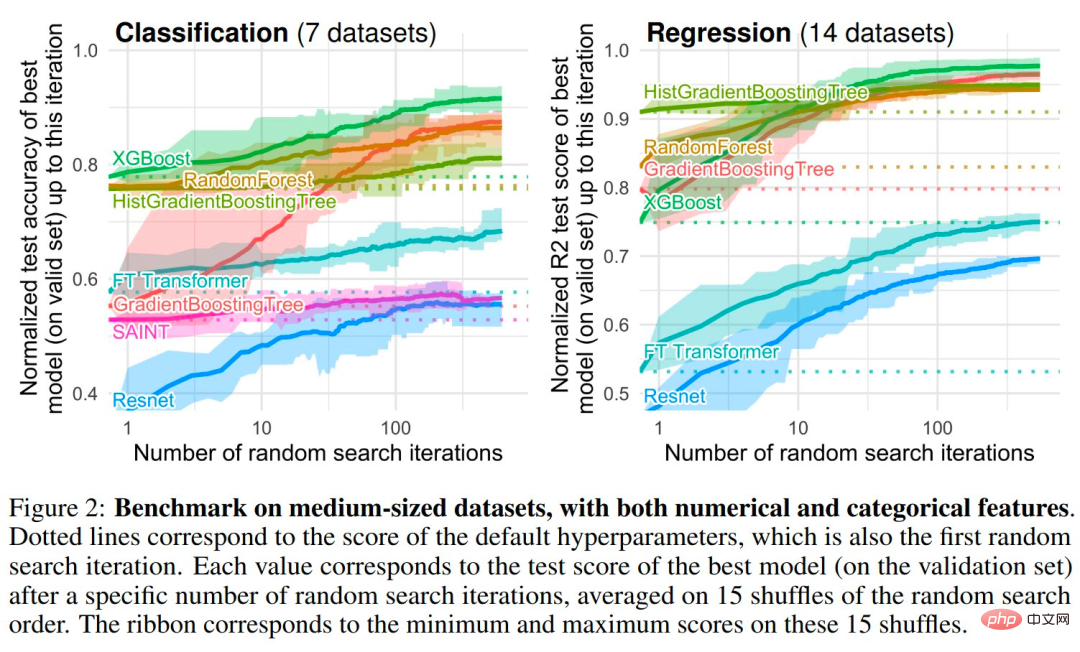

Parmi les modèles basés sur des arbres, les chercheurs ont choisi 3 modèles SOTA : RandomForest de Scikit Learn, GradientBoostingTrees (GBTs) et XGBoost. L'étude a réalisé les benchmarks suivants sur des modèles profonds : MLP, Resnet, FT Transformer, SAINT. Les figures 1 et 2 donnent les résultats de référence pour différents types d'ensembles de données

Enquête empirique : pourquoi les modèles arborescents surpassent toujours l'apprentissage profond sur les données tabulaires

Biais inductif. Les modèles arborescents battent les réseaux de neurones sur une variété de choix d'hyperparamètres. En fait, les meilleures méthodes de traitement de données tabulaires ont deux propriétés communes : ce sont les méthodes d’ensemble, le bagging (forêts aléatoires) ou le boosting (XGBoost, GBT), et les apprenants faibles utilisés dans ces méthodes sont les arbres de décision.

Constatation 1 : Les réseaux de neurones (NN) ont tendance à trop lisser les solutions

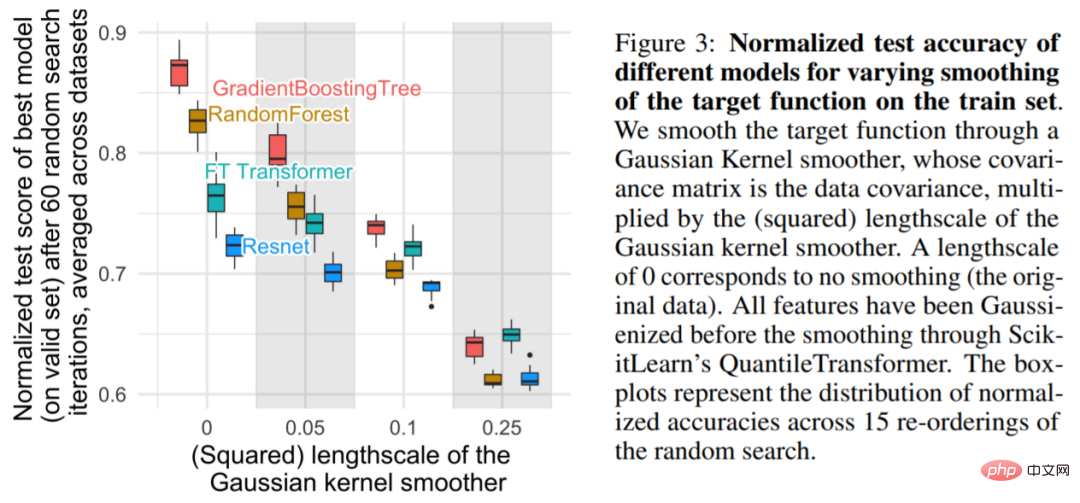

Comme le montre la figure 3, pour des échelles plus petites, la fonction objectif sur l'ensemble d'entraînement fluide diminuera considérablement en fonction de la précision du modèle arborescent, mais n’affectera guère le NN. Ces résultats indiquent que la fonction objectif dans l'ensemble de données n'est pas fluide et que NN a du mal à s'adapter à ces fonctions irrégulières par rapport aux modèles arborescents. Ceci est cohérent avec les conclusions de Rahaman et al., qui ont constaté que les NN sont biaisés vers les fonctions basse fréquence. Les modèles basés sur des arbres de décision apprennent des fonctions constantes par morceaux sans de tels biais.

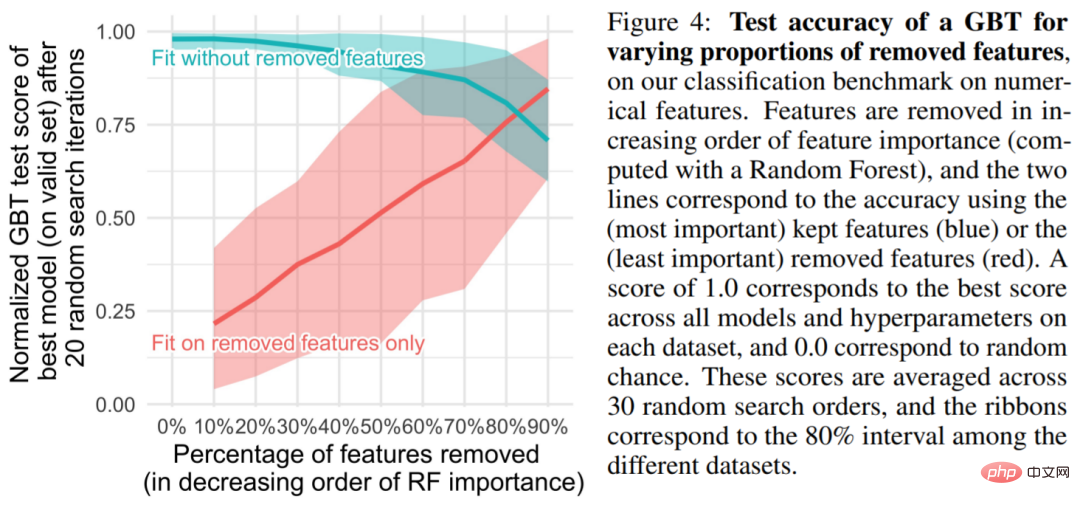

Constatation 2 : Les caractéristiques non informatives peuvent affecter davantage les NN

Les ensembles de données tabulaires contiennent de nombreuses caractéristiques non informatives. Pour chaque ensemble de données, cette étude est basée sur les caractéristiques. L'importance. de choisiront de supprimer une certaine proportion de fonctionnalités (généralement classées par forêt aléatoire). Comme le montre la figure 4, la suppression de plus de la moitié des caractéristiques a peu d’impact sur la précision de la classification du GBT.

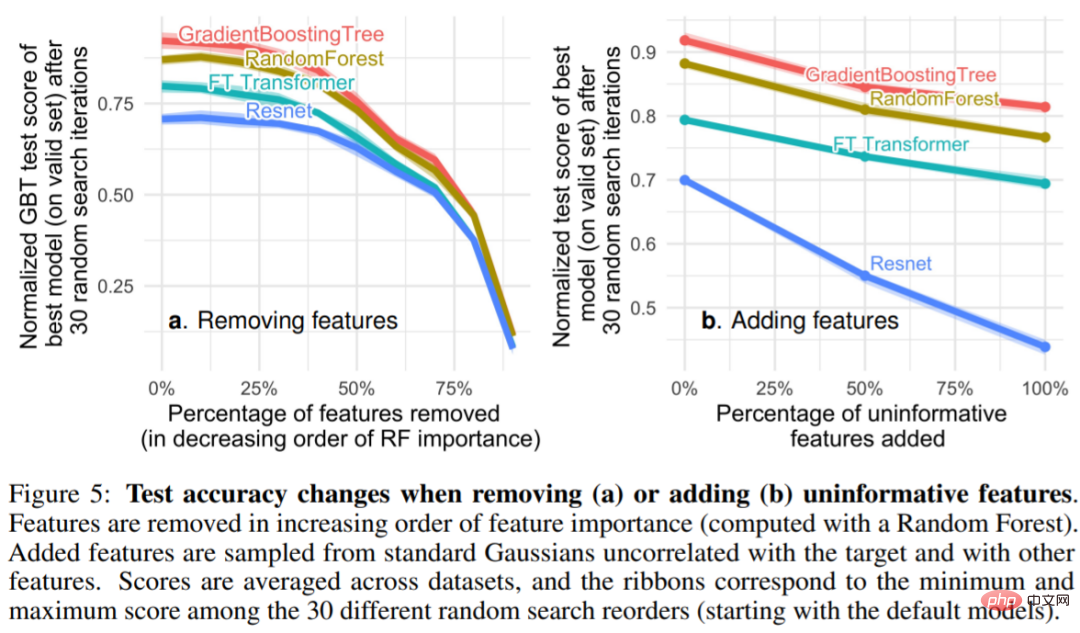

Figure 5 On peut voir que la suppression des fonctionnalités non informatives (5a) réduit l'écart de performances entre MLP (Resnet) et d'autres modèles (Transformateurs FT et modèles arborescents), tout en ajoutant des fonctionnalités non informatives (5a). fonctionnalités informatives Les fonctionnalités élargissent l'écart, indiquant que MLP est moins robuste aux fonctionnalités non informatives. Dans la figure 5a, lorsque le chercheur supprime une plus grande proportion de fonctionnalités, les informations utiles sont également supprimées en conséquence. La figure 5b montre que la diminution de la précision causée par la suppression de ces fonctionnalités peut être compensée par la suppression des fonctionnalités non informatives, ce qui est plus utile au MLP par rapport aux autres modèles (en même temps, cette étude supprime également les fonctionnalités redondantes et n'affecte pas le modèle). performance).

Constatation 3 : Grâce à la rotation, les données sont non invariantes

Pourquoi le MLP est-il plus sensible aux caractéristiques non informatives que d'autres modèles ? Une réponse est que les MLP sont invariants par rotation : le processus d'apprentissage d'un MLP sur l'ensemble de formation et de son évaluation sur l'ensemble de test est invariant lorsque des rotations sont appliquées aux fonctionnalités de l'ensemble de formation et de test. En fait, tout processus d'apprentissage invariant par rotation a une complexité d'échantillon dans le pire des cas qui augmente linéairement au moins en nombre de caractéristiques non pertinentes. Intuitivement, afin de supprimer les fonctionnalités inutiles, l'algorithme invariant en rotation doit d'abord trouver l'orientation d'origine de la fonctionnalité, puis sélectionner la fonctionnalité la moins informative.

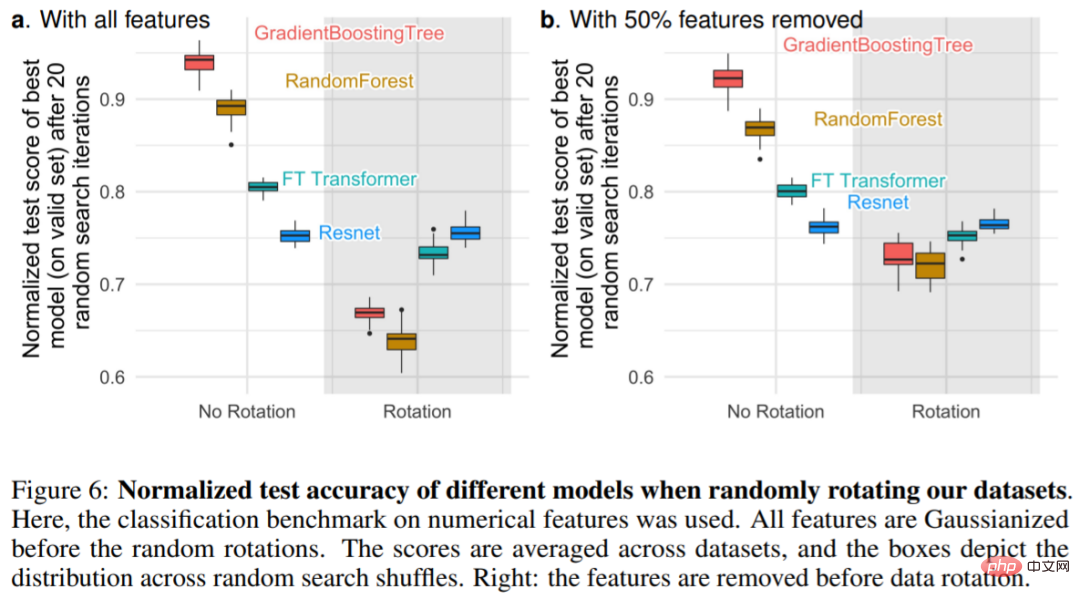

La figure 6a montre le changement dans la précision du test lorsque l'ensemble de données subit une rotation aléatoire, confirmant que seuls les Resnets sont invariants par rotation. Notamment, la rotation aléatoire inverse l'ordre de performance : le résultat est des NN supérieurs aux modèles arborescents et des Resnets supérieurs aux transformateurs FT, ce qui indique que l'invariance de rotation n'est pas souhaitable. En fait, les données tabulaires ont souvent des significations individuelles, comme l'âge, le poids, etc. Comme le montre la figure 6b : la suppression de la moitié la moins importante des fonctionnalités de chaque ensemble de données (avant la rotation) réduit les performances de tous les modèles à l'exception des Resnets, mais par rapport à l'utilisation de toutes les fonctionnalités sans supprimer les fonctionnalités, la baisse est plus faible.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI