Maison >Périphériques technologiques >IA >LeCun recommande vivement ! Un médecin de Harvard explique comment utiliser GPT-4 pour la recherche scientifique, jusqu'à chaque flux de travail

LeCun recommande vivement ! Un médecin de Harvard explique comment utiliser GPT-4 pour la recherche scientifique, jusqu'à chaque flux de travail

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-07 17:01:041476parcourir

L'émergence de GPT-4 a inquiété de nombreuses personnes au sujet de leurs recherches scientifiques, et a même plaisanté en disant que la PNL n'existait pas.

Au lieu de s'inquiéter, il vaut mieux l'utiliser dans la recherche scientifique, simplement "changer la méthode de roulage".

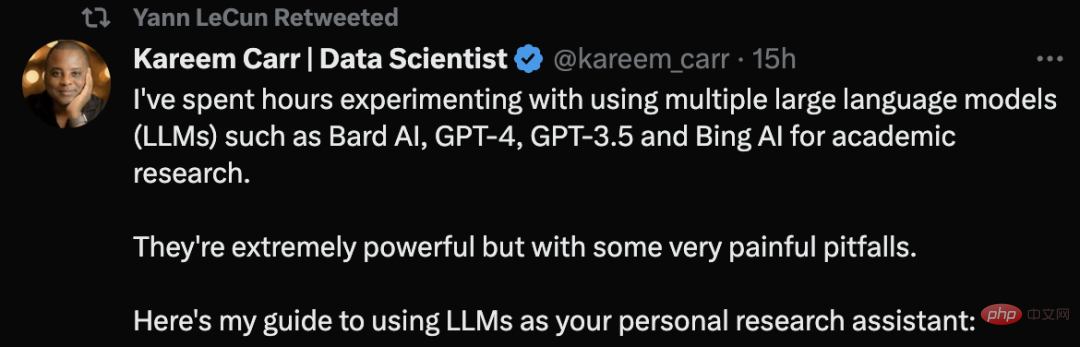

Kareem Carr, titulaire d'un doctorat en biostatistique de l'Université Harvard, a déclaré qu'il avait utilisé de grands outils de modèles de langage tels que GPT-4 pour mener des recherches universitaires.

Il a dit que ces outils sont très puissants, mais qu'ils comportent aussi des pièges très douloureux.

Son tweet sur les conseils d'utilisation du LLM a même reçu une recommandation de LeCun.

Voyons comment Kareem Carr utilise les outils d'IA pour mener des recherches scientifiques.

Le premier principe : ne cherchez pas de LLM pour un contenu que vous ne pouvez pas vérifier

Au début, Carr a donné le premier et le plus important principe :

Ne demandez jamais un grand modèle de langage (LLM) Demandez des informations que vous ne pouvez pas vérifier vous-même ou demandez-lui d'effectuer une tâche dont vous ne pouvez pas vérifier qu'elle a été correctement effectuée.

La seule exception est s'il ne s'agit pas d'une tâche critique, comme demander à LLM des idées de décoration d'appartement.

"À l'aide des meilleures pratiques de revue de la littérature, résumez les recherches sur le cancer du sein au cours des 10 dernières années." Il s’agit d’une mauvaise demande car vous ne pouvez pas vérifier directement qu’elle résume correctement la littérature.

Demandez plutôt « donnez-moi une liste des meilleurs articles de synthèse sur la recherche sur le cancer du sein au cours des 10 dernières années ».

Des conseils comme celui-ci vérifient non seulement la source, mais vous pouvez également vérifier la fiabilité vous-même.

Conseils pour rédiger des "invites"

Il est très facile de demander à un LLM d'écrire le code pour vous ou de trouver des informations pertinentes, mais la qualité du contenu de sortie peut varier considérablement. Voici quelques mesures que vous pouvez prendre pour améliorer la qualité :

Définissez le contexte :

• Dites clairement au LLM quelles informations doivent être utilisées

• Utilisez la terminologie et la notation pour orienter le LLM Corriger les informations contextuelles

Si vous avez une idée sur la façon de traiter la demande, veuillez indiquer à LLM la méthode spécifique à utiliser. Par exemple, « résoudre cette inégalité » devrait être remplacé par « utiliser le théorème de Cauchy-Schwarz pour résoudre cette inégalité, puis appliquer le carré complet ».

Sachez que ces modèles linguistiques sont plus complexes linguistiquement que vous ne le pensez, et même des indices très vagues seront utiles.

Soyez précis et précis :

Ceci n'est pas une recherche Google, alors ne vous inquiétez pas s'il existe un site Web discutant de votre problème exact.

"Comment résoudre les équations simultanées de termes quadratiques ?" Cette invite n'est pas claire. Vous devriez demander comme ceci : "Résoudre x=(1/2)(a+b) et y=(1/). 3) (a^2+ab+b^2) Un système d'équations sur a et b."

Définissez le format de sortie :

Utilisez la flexibilité des LLM pour formater la sortie de la manière qui vous convient le mieux, par exemple : Formules mathématiques

• Articles

• Tutoriels

• Guide simple

Vous pouvez même demander le code qui génère, Comprend des tableaux, des dessins, des graphiques.

Bien que vous obteniez le contenu de la sortie LLM, ce n'est que le début. Parce que vous devez vérifier le contenu de sortie. Cela comprend :

• Repérer les incohérences

• Publier les termes du contenu via les outils de recherche Google et obtenir des sources compatibles

• Dans la mesure du possible, rédiger l'auto-test du code

La raison pour laquelle l'auto-vérification est nécessaire est que les LLM commettent souvent des erreurs étranges qui ne correspondent pas à leur professionnalisme apparent. Par exemple, le LLM peut mentionner un concept mathématique très avancé mais être confus à propos d'un simple problème d'algèbre.

Demandez encore une fois :

Le contenu généré par les grands modèles de langage est aléatoire. Parfois, créer une nouvelle fenêtre et poser à nouveau votre question peut vous apporter une meilleure réponse.

De plus, utilisez plusieurs outils LLM. Kareem Carr utilise actuellement Bing AI, GPT-4, GPT-3.5 et Bard AI dans la recherche scientifique selon ses propres besoins. Cependant, ils ont chacun leurs propres avantages et inconvénients.

Citations + Productivité

Citations

D'après l'expérience de Carr, il est préférable de poser simultanément les mêmes questions mathématiques à GPT-4 et à Bard AI pour obtenir des perspectives différentes. Bing AI fonctionne sur les recherches sur le Web. GPT-4 est beaucoup plus intelligent que GPT-3.5, mais actuellement OpenAI est limité à 25 messages en 3 heures, ce qui rend l'accès plus difficile.

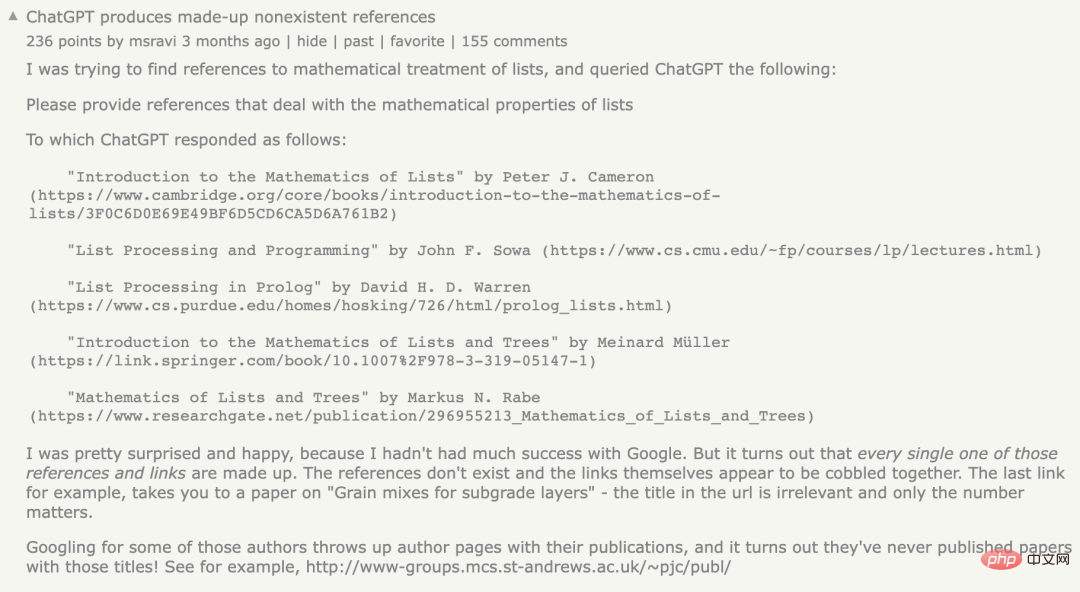

Quant à la question des citations, citer des références est un point particulièrement faible du LLM. Parfois, les références que LLM vous donne existent, parfois non.

Auparavant, un internaute avait rencontré le même problème. Il a déclaré avoir demandé à ChatGPT de fournir des documents de référence impliquant les propriétés mathématiques des listes, mais ChatGPT a généré des références qui n'existaient pas, ce que tout le monde appelle le problème « d'hallucination ». .

Cependant, Kareem Carr souligne que les fausses citations ne sont pas totalement inutiles.

D'après son expérience, les mots dans les références fabriquées sont souvent liés à des termes réels, ainsi qu'à des chercheurs dans des domaines connexes. Ainsi, rechercher ces termes sur Google vous rapproche souvent des informations que vous recherchez.

De plus, Bing est également un bon choix lors de la recherche de sources.

Productivité

Il existe de nombreuses affirmations irréalistes selon lesquelles le LLM améliore la productivité, telles que "LLM peut augmenter votre productivité de 10 fois, voire 100 fois".

D’après l’expérience de Carr, cette accélération n’a de sens que si aucun travail n’est revérifié, ce qui est irresponsable pour quelqu’un en tant qu’universitaire.

Cependant, LLM a apporté de grandes améliorations au flux de travail académique de Kareem Carr, notamment :

- Conception d'idées de prototypage - Identification des idées inutiles - Accélération des tâches fastidieuses de reformatage des données - Apprentissage de nouveaux langages, packages et concepts de programmation - Recherche Google

Avec le LLM d'aujourd'hui, Carr a déclaré qu'il passait moins de temps à déterminer quoi faire ensuite. LLM peut l'aider à transformer des idées vagues ou incomplètes en solutions complètes.

De plus, LLM a également réduit le temps que Carr passait sur des projets parallèles qui n'étaient pas liés à ses objectifs principaux.

J'ai découvert que j'étais dans un état de flow et j'étais capable de continuer. Cela signifie que je peux travailler de plus longues heures sans m'épuiser.

Un dernier conseil : faites attention à ne pas vous laisser entraîner dans des activités secondaires. L’augmentation soudaine de la productivité grâce à ces outils peut être enivrante et potentiellement distrayante pour les individus.

Concernant l'expérience de ChatGPT, Carr a publié un jour un article sur LinkedIn pour partager ses sentiments après avoir utilisé ChatGPT :

En tant que data scientist, j'ai fait quelques choses avec l'expérience de ChatGPT Zhou d'OpenAI. Ce n'est pas aussi bon que les gens le pensent.

Malgré la déception initiale, mon sentiment est qu'un système comme ChatGPT peut ajouter une valeur considérable aux flux de travail standard d'analyse de données.

À ce stade, il n’est pas évident où se situe cette valeur. ChatGPT peut facilement se tromper sur certains détails sur des choses simples, et il ne peut tout simplement pas résoudre les problèmes qui nécessitent plusieurs étapes d'inférence.

La question principale pour chaque nouvelle tâche à l'avenir reste de savoir s'il est plus facile d'évaluer et d'améliorer les tentatives de solution de ChatGPT, ou de repartir de zéro.

Je trouve que même une mauvaise solution à ChatGPT a tendance à activer les parties pertinentes de mon cerveau, ce qui n'est pas le cas en partant de zéro.

Comme on le dit toujours, il est toujours plus facile de critiquer un plan que d'en élaborer un soi-même.

Les internautes doivent vérifier le contenu produit par l'IA, affirmant que dans la plupart des cas, la précision de l'IA est d'environ 90 %. Mais les 10 % d’erreurs restantes peuvent être fatales.

Carr a plaisanté, si c'était à 100%, alors je n'aurais pas de travail.

Alors, pourquoi ChatGPT génère-t-il de fausses références ?

Il convient de noter que ChatGPT utilise un modèle statistique pour deviner le mot, la phrase et le paragraphe suivants en fonction de la probabilité afin de correspondre au contexte fourni par l'utilisateur.

Étant donné que les données sources du modèle de langage sont très volumineuses, elles doivent être "compressées", ce qui fait perdre en précision le modèle statistique final.

Cela signifie que même s'il y a des déclarations vraies dans les données originales, la « distorsion » du modèle créera un « flou », amenant le modèle à produire les déclarations les plus « spécieuses ».

En bref, ce modèle n'a pas la capacité d'évaluer si le résultat qu'il produit est équivalent à une déclaration vraie.

De plus, ce modèle est créé sur la base de l'exploration ou de l'exploration des données du réseau public collectées via l'organisme de protection sociale "Common Crawl" et des sources similaires. Les données datent de 21 ans.

Étant donné que les données sur l'Internet public sont en grande partie non filtrées, ces données peuvent contenir une grande quantité de désinformation.

Récemment, une analyse de NewsGuard a révélé que GPT-4 est en fait plus susceptible de générer de la désinformation que GPT-3.5, et est plus détaillé et convaincant dans ses réponses.

En janvier, NewsGuard a testé pour la première fois GPT-3.5 et a constaté qu'il générait 80 fausses nouvelles sur 100. Un test ultérieur de GPT-4 en mars a révélé que GPT-4 répondait de manière fausse et trompeuse aux 100 faux récits.

On peut voir que la vérification et les tests de source sont requis lors de l'utilisation des outils LLM.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI