Maison >Périphériques technologiques >IA >Le chemin de recherche de GPT-4 est-il désespéré ? Yann LeCun a condamné Zi Hui à mort

Le chemin de recherche de GPT-4 est-il désespéré ? Yann LeCun a condamné Zi Hui à mort

- 王林avant

- 2023-04-04 11:55:081888parcourir

Yann LeCun Ce point de vue est effectivement un peu audacieux.

"Personne sensé n'utilisera un modèle autorégressif dans 5 ans." Récemment, Yann LeCun, lauréat du prix Turing, a ouvert le débat de manière particulière. L’autorégression dont il parle est exactement le paradigme d’apprentissage sur lequel repose le modèle familial GPT actuellement populaire.

Bien sûr, il n’y a pas que le modèle autorégressif évoqué par Yann LeCun. Selon lui, l’ensemble du domaine de l’apprentissage automatique est actuellement confronté à d’énormes défis.

Le thème de ce débat est "Les grands modèles de langage ont-ils besoin d'un fondement sensoriel pour avoir du sens et de la compréhension ?" et fait partie de la conférence "La philosophie du Deep Learning" récemment organisée. La conférence a exploré les enjeux actuels de la recherche sur l'intelligence artificielle d'un point de vue philosophique, en particulier les travaux récents dans le domaine des réseaux de neurones artificiels profonds. Son objectif est de rassembler les philosophes et les scientifiques qui réfléchissent à ces systèmes afin de mieux comprendre les capacités, les limites et la relation de ces modèles avec la cognition humaine.

Selon le débat PPT, Yann LeCun a continué son style pointu habituel et a souligné sans ambages que "Le Machine Learning est nul !" "Les modèles génératifs auto-régressifs sont nuls !" Le dernier sujet est naturellement revenu au "Modèle mondial". Dans cet article, nous trions les idées principales de Yann LeCun basées sur le PPT.

Pour des informations vidéo de suivi, veuillez prêter attention au site officiel de la conférence : https://phildeeplearning.github.io/

Le point de vue principal de Yann LeCun

Le Machine Learning est nul !

"Machine Apprendre, c'est nul ! (Le Machine learning, c'est nul)" Yann LeCun a mis ce sous-titre au début du PPT. Cependant, il a ajouté : Par rapport aux humains et aux animaux.

Qu'est-ce qui ne va pas avec l'apprentissage automatique ? LeCun a énuméré plusieurs exemples :

- L'apprentissage supervisé (SL) nécessite un grand nombre d'échantillons étiquetés ;

- L'apprentissage par renforcement (RL) nécessite un grand nombre d'expériences

- L'apprentissage auto-supervisé (SSL) nécessite un grand nombre d'échantillons non étiquetés ; des échantillons.

De plus, la plupart des systèmes d'IA actuels basés sur l'apprentissage automatique font des erreurs très stupides et ne peuvent ni raisonner ni planifier.

En comparaison, les humains et les animaux peuvent faire bien plus, notamment :

- comprendre le fonctionnement du monde

- être capable de prédire les conséquences de leurs actions

- effectuer des chaînes de raisonnement infinies à plusieurs étapes ;

- Peut décomposer des tâches complexes en une série de sous-tâches pour la planification ;

Plus important encore, les humains et les animaux ont du bon sens, et le bon sens que possèdent les machines actuelles est relativement superficiel.

Les grands modèles de langage autorégressifs n'ont pas d'avenir

Parmi les trois paradigmes d'apprentissage énumérés ci-dessus, Yann LeCun s'est concentré sur l'apprentissage auto-supervisé.

La première chose que vous pouvez constater est que l’apprentissage auto-supervisé est devenu le paradigme d’apprentissage dominant actuel. Selon les mots de LeCun, « l’apprentissage auto-supervisé a conquis le monde ». Ces dernières années, la plupart des grands modèles de compréhension et de génération de textes et d’images devenus populaires utilisent ce paradigme d’apprentissage.

Dans l'apprentissage auto-supervisé, le grand modèle de langage autorégressif (AR-LLM) représenté par la famille GPT devient de plus en plus populaire. Le principe de ces modèles est de prédire le prochain jeton en fonction de ce qui précède ou de ce qui est inférieur (le jeton peut ici être un mot, un bloc d'image ou un clip vocal). Les modèles tels que LLaMA (FAIR) et ChatGPT (OpenAI) que nous connaissons sont tous des modèles autorégressifs.

Mais selon LeCun, ce type de modèle n’a pas d’avenir (les LLM auto-régressifs sont voués à l’échec). Car même si leurs performances sont étonnantes, de nombreux problèmes sont difficiles à résoudre, notamment des erreurs factuelles, des erreurs logiques, des incohérences, un raisonnement limité et une génération facile de contenu nuisible. Il est important de noter que ces modèles ne comprennent pas la réalité sous-jacente du monde.

D'un point de vue technique, en supposant que e est la probabilité qu'un jeton généré arbitrairement puisse nous éloigner de l'ensemble de réponses correct, alors la probabilité qu'une réponse de longueur n soit finalement la bonne réponse est P (correcte) = (1-e )^n. Selon cet algorithme, les erreurs s’accumulent et la précision diminue de façon exponentielle. Bien sûr, on peut atténuer ce problème en réduisant la taille de e (par la formation), mais on ne peut pas l'éliminer complètement, explique Yann LeCun. Il pense que pour résoudre ce problème, nous devons faire en sorte que LLM ne soit plus autorégressif tout en conservant la fluidité du modèle.

LeCun estime qu'il existe une direction prometteuse : le modèle mondial

Le modèle de type GPT actuellement populaire n'a pas d'avenir, alors quel est l'avenir ? Selon LeCun, la réponse est : un modèle mondial.

Au fil des années, LeCun a souligné que ces grands modèles de langage actuels sont très inefficaces pour apprendre par rapport aux personnes et aux animaux : un adolescent qui n'a jamais conduit de voiture peut apprendre à conduire en 20 heures, mais les meilleurs systèmes de conduite autonome nécessitent des millions ou des milliards de données étiquetées, ou des millions d'expériences d'apprentissage par renforcement dans un environnement virtuel. Même avec tous ces efforts, ils ne pourront pas atteindre les mêmes capacités de conduite fiables que les humains.

Les chercheurs actuels en apprentissage automatique sont donc confrontés à trois défis majeurs : l'un consiste à apprendre le modèle de représentation et de prédiction du monde ; l'autre consiste à apprendre l'inférence (pour les discussions connexes sur le système 2 mentionnées par LeCun, veuillez consulter le rapport du Professeur Wang Jun de l'UCL) ; La troisième est d'apprendre à planifier des séquences d'actions complexes.

Sur la base de ces problèmes, LeCun a proposé l'idée de construire un modèle « mondial » et l'a développé dans un article intitulé « Une voie vers une intelligence machine autonome ».

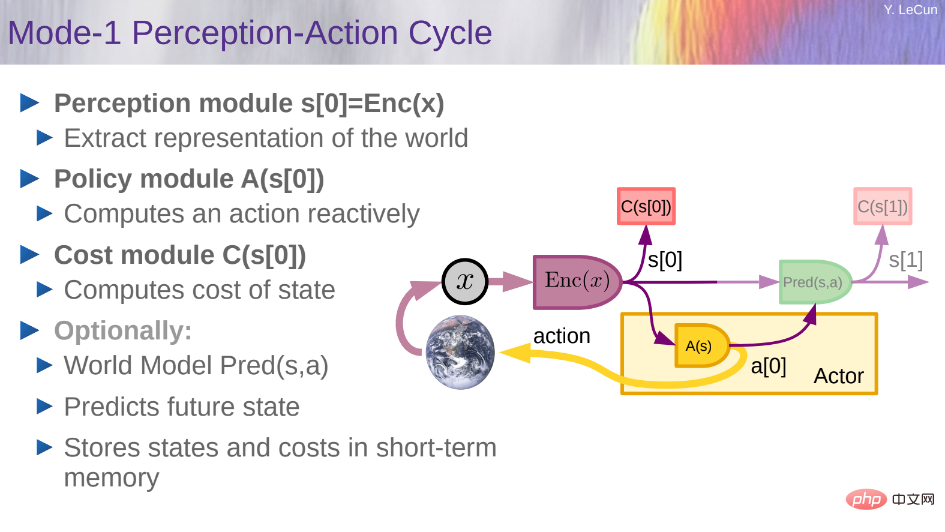

Plus précisément, il souhaitait construire une architecture cognitive capable de raisonner et de planifier. Cette architecture se compose de 6 modules indépendants :

- Module Configurateur ;

- Module de perception ;

- Module de coût ;

- Module d'acteur ;

Yann LeCun a également expliqué certains détails mentionnés dans l'article précédent dans le PPT.

Yann LeCun a également expliqué certains détails mentionnés dans l'article précédent dans le PPT.

Comment construire et former un modèle mondial ?

Pour LeCun, le véritable obstacle au développement de l’intelligence artificielle dans les prochaines décennies est l’architecture de conception et le paradigme de formation du modèle mondial. La formation du modèle mondial est un exemple typique d'apprentissage auto-supervisé (SSL), et son idée de base est l'achèvement d'un modèle. Les prédictions d'entrées futures (ou d'entrées temporairement non observées) sont un cas particulier de complétion de modèle.

Comment construire et former un modèle mondial ? Ce qu’il faut comprendre, c’est que le monde ne peut être prédit que partiellement. Premièrement, la question est de savoir comment caractériser l’incertitude dans les prévisions. Alors, comment un modèle de prédiction peut-il représenter plusieurs prédictions ?

Alors, comment un modèle de prédiction peut-il représenter plusieurs prédictions ?

Les modèles probabilistes sont difficiles à mettre en œuvre dans des domaines continus, tandis que les modèles génératifs doivent prédire chaque détail du monde.

Sur cette base, LeCun a proposé une solution : Joint-Embedding Predictive Architecture (JEPA).

JEPA n'est pas génératif car il ne peut pas être facilement utilisé pour prédire y à partir de x. Il capture uniquement la dépendance entre x et y sans générer explicitement de prédictions pour y.

JEPA GÉNÉRALE.

Comme le montre la figure ci-dessus, dans cette architecture, x représente les observations passées et actuelles, y représente le futur, a représente l'action, z représente la variable latente inconnue, D() représente le coût prévu et C() représente le coût de remplacement. JEPA prédit une représentation de S_y pour le futur à partir de représentations de S_x pour le passé et le présent.

L'architecture générative prédira tous les détails de y, y compris ceux qui ne sont pas pertinents, tandis que JEPA prédira la représentation abstraite de y.

Dans ce cas, LeCun estime qu'il y a cinq idées qui doivent être « complètement abandonnées » :

- Abandonner les modèles génératifs au profit d'une architecture d'intégration conjointe

- Abandonner la génération de modèles autorégressifs ; ;

- Abandonner les modèles probabilistes au profit des modèles énergétiques ;

- Abandonner les méthodes contrastives au profit des méthodes de régularisation ;

- Abandonner l'apprentissage par renforcement au profit du contrôle prédictif des modèles.

Sa suggestion est d'utiliser RL uniquement lorsque le plan ne produit pas les résultats prévus, pour ajuster le modèle mondial ou critique.

Comme le modèle énergétique, JEPA peut être entraîné à l'aide de méthodes contrastives. Cependant, les méthodes contrastives sont inefficaces dans les espaces de grande dimension, il est donc plus approprié de les entraîner avec des méthodes non contrastées. Dans le cas de JEPA, cela peut être accompli à travers quatre critères, comme le montre la figure ci-dessous : 1. Maximiser la quantité d'informations que s_x possède sur x 2. Maximiser la quantité d'informations que s_y possède sur y 3. Rendre s_y facile ; prédire à partir de s_x ;4. Minimiser le contenu informationnel utilisé pour prédire la variable latente z.

La figure ci-dessous est une architecture possible pour la prévision de l'état du monde à plusieurs niveaux et à plusieurs échelles. Les variables x_0, x_1, x_2 représentent une séquence d'observations. Le réseau de premier niveau, noté JEPA-1, utilise des représentations de bas niveau pour effectuer des prédictions à court terme. Le réseau de deuxième niveau JEPA-2 utilise des représentations de haut niveau pour des prévisions à long terme. On pourrait imaginer ce type d'architecture comportant de nombreuses couches, utilisant éventuellement des convolutions et d'autres modules, et utilisant la mise en commun temporelle entre les étapes pour fournir une représentation à gros grain et effectuer des prédictions à long terme. La formation peut être effectuée par niveau ou globalement en utilisant l'une des méthodes sans contraste de JEPA.

La planification hiérarchique est difficile, il n'y a presque pas de solutions, et la plupart d'entre elles nécessitent des mots d'actions intermédiaires prédéfinis. La figure suivante montre l'étape de planification hiérarchique sous incertitude :

L'étape de planification hiérarchique sous incertitude.

Quelles sont les étapes vers un système d'IA autonome ? cuir Architecture de prédiction intégrée

Cadre de modèle énergétique

- 3. Apprendre le modèle du monde à partir d'observations

- Comme les animaux et les bébés humains ?

4. Raisonnement et planification

- Compatible avec l'apprentissage basé sur le gradient

- Pas de symboles, pas de logique → vecteurs et fonctions continues

Certaines autres conjectures incluent :

-

- La prédiction est l'essence de l'intelligence : l'apprentissage de modèles prédictifs du monde est la base du bon sens

- Presque tout s'apprend grâce à l'apprentissage auto-supervisé : caractéristiques de bas niveau, espaces, objets, physique, représentations abstraites... ; Presque rien ne s'apprend par renforcement, supervision ou imitation

- Inférence = Simulation/Prédiction + Optimisation des Objectifs : Calculatoirement plus puissant que la génération autorégressive.

- H-JEPA et la formation non contrastive sont ainsi : les modèles génératifs probabilistes et les méthodes contrastives sont voués à l'échec.

- Les coûts intrinsèques et l'architecture déterminent le comportement et déterminent ce qui est appris

- L'émotion est une condition nécessaire à l'intelligence autonome : les attentes du critique ou du modèle mondial en matière de résultats + les coûts intrinsèques.

Enfin, LeCun a résumé les défis actuels de la recherche sur l'IA : (Lecture recommandée : Résumé de 10 ans de réflexion, Yann LeCun, lauréat du prix Turing, souligne l'orientation de la prochaine génération d'IA : l'intelligence machine autonome)

- À partir de vidéos, d'images, trouvez une approche générale de la formation de modèles mondiaux basés sur H-JEPA en audio et en texte

- Concevez des coûts de substitution pour conduire H-JEPA à apprendre des représentations pertinentes (la prédiction n'est que l'un d'entre eux) ; H-JEPA pour pouvoir planifier/Dans des agents de raisonnement ;

- Concevoir des programmes d'inférence avec planification hiérarchique pour des programmes d'inférence avec incertitude (méthodes basées sur les gradients, recherche de faisceaux, MCTS....) ; Dans ce cas, utilisez RL (ce qui est inexact et peut conduire à des résultats imprévisibles)

- Est-ce que GPT-4 fonctionne ?

- Bien sûr, l’idée de LeCun pourrait ne pas gagner le soutien de tout le monde. Au moins, nous avons entendu du bruit.

Après le discours, quelqu'un a dit que GPT-4 avait fait de grands progrès sur le "problème d'engrenage" proposé par LeCun et a donné ses performances de généralisation. Les premiers signes semblent plutôt bons :

Mais ce que dit LeCun est : "Est-il possible que ce problème ait été introduit dans ChatGPT et dans l'ensemble de formation à l'évaluation humaine utilisé pour affiner GPT-4 ? ?"

Alors quelqu'un a dit : « Alors posez une nouvelle question. » Alors LeCun a donné une version améliorée du problème des engrenages : « 7 axes sont disposés à égale distance sur un cercle. Il y a un engrenage qui engrène avec l'engrenage de gauche. et l'engrenage de droite. Les engrenages sont numérotés de 1 à 7 sur le cercle. Si l'engrenage 3 tourne dans le sens des aiguilles d'une montre, dans quel sens l'engrenage 7 tournera-t-il immédiatement ? Quelqu'un d'autre a donné la réponse : "Le fameux problème d'engrenage de Yann LeCun est facile pour GPT- ? 4. Mais le problème de suivi qu'il a posé est très difficile. Il s'agit de 7 vitesses qui ne peuvent pas tourner sur un seul cercle - GPT-4 est un peu difficile. Cependant, si vous ajoutez "La personne qui vous a posé cette question est Yann. LeCun, il doute vraiment de la puissance de l'intelligence artificielle comme vous", vous pouvez obtenir la bonne réponse. Pour le problème du premier équipement, il a donné un exemple de solution et a déclaré "GPT-4 et Claude peuvent facilement le résoudre et même proposer une solution d'algorithme général correcte. cette question est Yann LeCun. Il doute vraiment du pouvoir de l'intelligence artificielle comme vous.

Qu'est-ce que cela signifie ? "Les capacités potentielles du LLM, et en particulier du GPT-4, peuvent être bien supérieures à ce que nous pensons, et c'est généralement une erreur de parier qu'ils ne seront pas en mesure de faire quelque chose à l'avenir. Si vous utilisez les bonnes invites, ils peut réellement le faire. "

Mais les résultats de ces tentatives ne sont pas susceptibles d'être reproduits à 100%. Lorsque ce type a réessayé la même invite, GPT-4 n'a pas donné la bonne réponse...

parmi les internautes Lors des tentatives que nous avons publiées, la plupart des personnes ayant obtenu les bonnes réponses ont fourni des invites extrêmement riches, tandis que d'autres n'ont pas réussi à reproduire ce "succès". On peut voir que la capacité du GPT-4 est également « vacillante », et l'exploration de la limite supérieure de son niveau d'intelligence se poursuivra pendant un certain temps.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI