Maison >Périphériques technologiques >IA >Guide d'utilisation du plug-in ChatGPT pour débloquer une nouvelle expérience Internet

Guide d'utilisation du plug-in ChatGPT pour débloquer une nouvelle expérience Internet

- PHPzavant

- 2023-04-01 22:07:373723parcourir

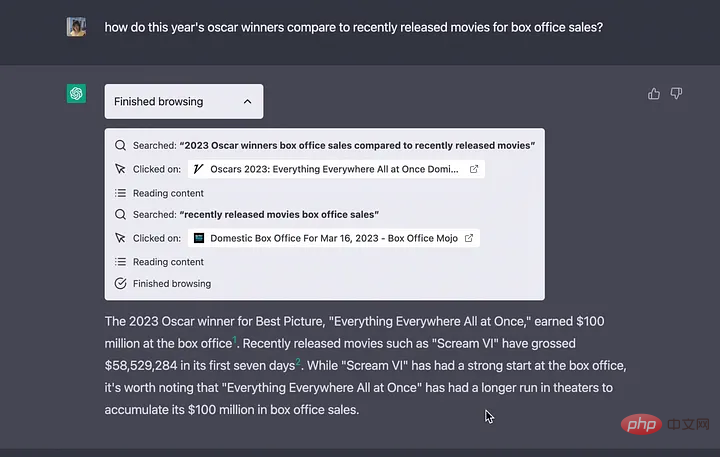

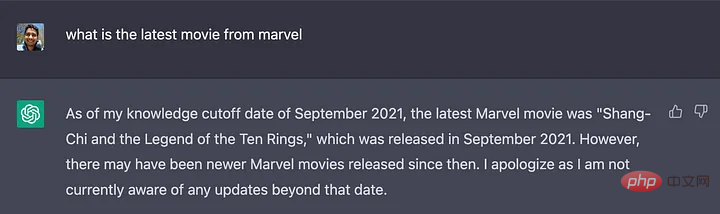

La base de connaissances de ChatGPT a été formée avec des données datant de septembre 2021, mais en utilisant ces plugins, ChatGPT est désormais capable de rechercher sur le Web les dernières réponses, supprimant ainsi les limites de s'appuyer uniquement sur sa base de connaissances.

Récemment, OpenAI a publié une nouvelle fonctionnalité de ChatGPT : le système de plug-in. ChatGPT peut désormais être étendu avec des fonctionnalités et effectuer de nouvelles tâches, telles que :

- Récupérer des informations en temps réel : par exemple, les résultats sportifs, les cours des actions, les dernières actualités, etc.

- Récupérer les informations de la base de connaissances : par exemple, des documents d'entreprise, des notes personnelles, etc.

- Effectuer des actions au nom de l'utilisateur : par exemple, réserver un vol, commander de la nourriture, etc. La base de connaissances de

La base de connaissances de ChatGPT a été formée avec des données à partir de septembre 2021, mais en utilisant ces plugins, ChatGPT est désormais capable de rechercher sur le Web les dernières réponses, supprimant ainsi les limites de s'appuyer uniquement sur sa base de connaissances.

Créer des plugins personnalisés

OpenAI permet également à tout développeur de créer ses propres plugins. Bien que les développeurs doivent actuellement s'inscrire sur une liste d'attente (https://openai.com/waitlist/plugins), les fichiers pour créer des plugins sont déjà disponibles.

Plus d'informations sur le processus de plug-in peuvent être trouvées sur cette page (https://platform.openai.com/docs/plugins/introduction).

Un exemple de code peut être trouvé sur cette page (https://platform.openai.com/docs/plugins/examples).

La documentation montre uniquement comment fonctionne l'intégration entre l'API tierce et ChatGPT. L'article suivant explorera le fonctionnement interne de cette intégration :

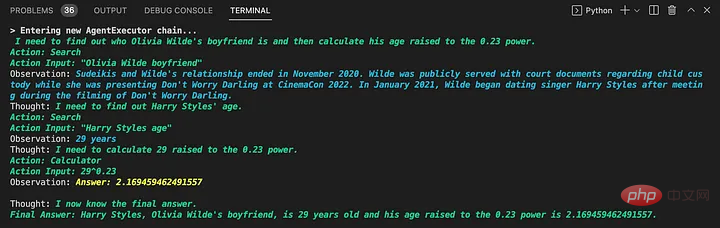

LangChain est un outil développé par Harrison Chase (hwchase17) en 2022 pour aider les développeurs à intégrer des applications tierces dans des modèles de langage étendus (LLM). Empruntez l'exemple ci-dessous pour expliquer son mode de fonctionnement :"Comment les grands modèles de langage effectuent-ils des opérations sans formation pertinente ?" réponse, résumé et plus encore

import os

import os

os.environ["OPENAI_API_KEY"] = "

from langchain.agents import load_tools

from langchain.agents import initialize_agentfrom langchain.llms import OpenAI

# Tout d'abord, chargez le modèle de langage à utiliser pour contrôler l'agent

llm = OpenAI(temperature=0)

# Continuer Venez et chargez quelques outils à utiliser. Veuillez noter que l'outil llm-math utilise LLM, vous devez donc le passer dans

tools = load_tools(["serpapi", "llm-math"], llm=llm)

# Enfin, utilisez les outils, le modèle de langage et que vous souhaitez utiliser le type d'agent pour initialiser l'agent

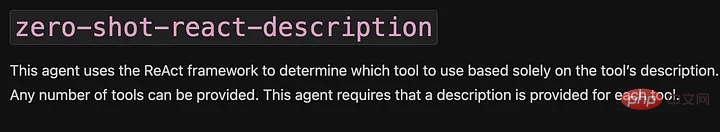

agent = initialize_agent(tools, llm, agent="zero-shot-react-description", verbose=True)

# Maintenant, testons

agent.run("Qui est Le petit ami d'Olivia Wilde ? Quel est son âge actuel à la puissance 0,23 ?")

Trois parties principales peuvent être vues à partir de cet exemple :

LLM : LLM est un composant essentiel de LangChain, qui aide l'agent à comprendre le langage naturel. Dans cet exemple, le modèle par défaut d’OpenAI est utilisé. Selon le code source (https://github.com/hwchase17/langchain/blob/master/langchain/llms/openai.py#L133), le modèle par défaut est text-davinci-003.

Agent : L'agent utilise LLM pour décider quelles actions entreprendre et dans quel ordre. Une action peut consister à utiliser un outil et à observer son résultat, ou à renvoyer une réponse à l'utilisateur.

La description 0-shot-react est utilisée ici. Dans sa documentation, on peut lire que « cet agent utilise le framework ReAct et décide quel outil utiliser en fonction entièrement de la description de l'outil ». Ces informations seront utilisées ultérieurement.

- Outils : fonctions que les agents peuvent utiliser pour interagir avec le monde. Dans cet exemple, deux outils sont utilisés :

- serpapi : un wrapper autour de l'API https://serpapi.com/. Il est utilisé pour naviguer sur le Web.

- llm-math : permet à l'agent de répondre à des questions liées aux mathématiques dans des invites, telles que "Quel est son âge actuel élevé à la puissance 0,23 ?".

Lorsque le script est exécuté, l'agent fait plusieurs choses comme rechercher qui est le petit ami d'Olivia Wilde, extraire son nom, demander l'âge de Harry Style, effectuer une recherche et calculer 29 ^ 0,23 à l'aide de l'outil llm-math, soit 2,16.

Le plus gros avantage de LangChain est qu'il ne s'appuie pas sur un seul fournisseur, comme décrit dans la documentation (https://python.langchain.com/en/latest/modules/llms/integrations.html).

Pourquoi LangChain peut-il fournir des fonctions puissantes pour le système de plug-in ChatGPT ?

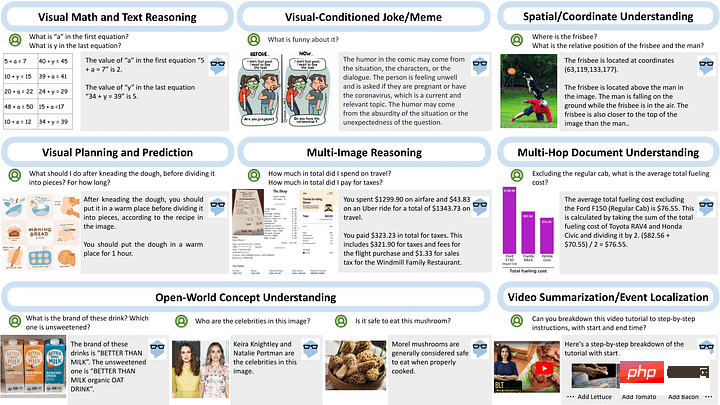

Le 21 mars, Microsoft, le partenaire le plus important d'OpenAI, a publié MM-REACT, révélant le raisonnement et les actions multimodaux de ChatGPT (https://github.com/microsoft/MM-REACT).

En examinant les capacités de ce « paradigme système », vous pouvez voir que chaque exemple implique une interaction entre un modèle de langage et une application externe.

En regardant l'exemple de code fourni (https://github.com/microsoft/MM-REACT/blob/main/sample.py), nous pouvons voir que l'implémentation de l'interaction modèle+outils utilise Fabriqué par LangChain. Le fichier README.md (https://github.com/microsoft/MM-REACT/blob/main/README.md) indique également que « le code de MM-REACT est basé sur langchain ».

En combinant ces preuves, ainsi que le fait que la documentation du plugin ChatGPT mentionne que « les descriptions des plugins, les demandes d'API et les réponses de l'API sont toutes insérées dans les conversations avec ChatGPT. » On peut supposer que le système de plugins ajoute différents plugins en tant qu'outils proxy. dans Dans ce cas, il s'agit de ChatGPT.

Il est également possible qu'OpenAI ait transformé ChatGPT en un proxy de type zero-shot-react-description pour prendre en charge ces plug-ins (le type que nous avons vu dans l'exemple précédent). La description de l’API étant insérée dans la conversation, elle correspond aux attentes de l’agent, comme on peut le voir dans l’extrait de documentation ci-dessous.

LangChain

Conclusion

Bien que le système de plug-in ne soit pas encore ouvert aux utilisateurs, vous pouvez utiliser les documents publiés et MM-REACT pour découvrir les puissantes fonctions du système de plug-in ChatGPT.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI