Maison >Périphériques technologiques >IA >GPT-4 est si puissant qu'OpenAI refuse de s'ouvrir ! Scientifique en chef : L'open source n'est pas intelligent, nous avions tort avant

GPT-4 est si puissant qu'OpenAI refuse de s'ouvrir ! Scientifique en chef : L'open source n'est pas intelligent, nous avions tort avant

- PHPzavant

- 2023-03-31 22:40:021380parcourir

Le co-fondateur d'OpenAI, Greg Brockman, et le scientifique en chef Ilya Sutskever évaluent les performances de GPT-4 et expliquent les problèmes de sécurité et les controverses open source.

Il ne fait aucun doute qu'une fois GPT-4 sorti, il a fait exploser l'ensemble de l'industrie et du monde universitaire.

Grâce à son raisonnement puissant et à ses capacités multimodales, il a déclenché de nombreuses discussions animées.

Cependant, GPT-4 n'est pas un modèle ouvert.

Bien qu'OpenAI ait partagé un grand nombre de benchmarks et de résultats de tests de GPT-4, il n'a fondamentalement pas fourni les données utilisées pour la formation, le coût ou la méthode utilisée pour créer le modèle.

Bien sûr, OpenAI n'annoncera certainement pas un tel "secret exclusif".

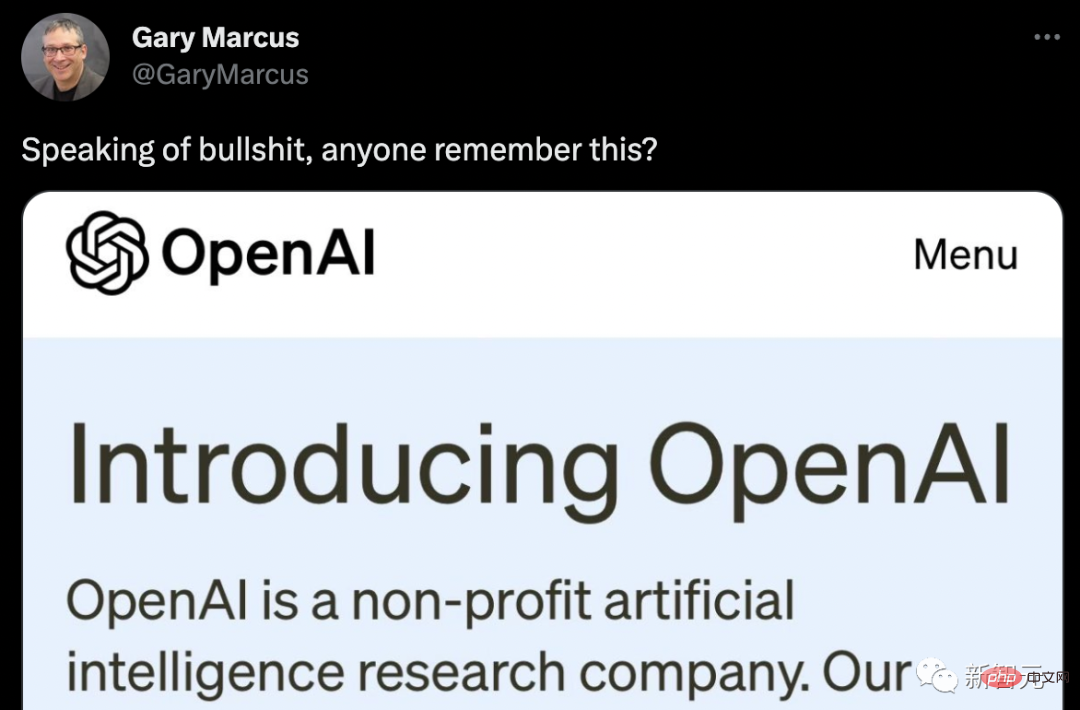

Marcus a directement retiré l'intention initiale d'OpenAI et a publié une vague de ridicule.

Les internautes ont amélioré une version.

Personne n'est parfait, tout comme GPT-4

Lorsque Greg Brockman, président et co-fondateur d'OpenAI, a comparé GPT-4 et GPT-3, il a dit un mot : différent.

"C'est juste différent, le modèle présente encore beaucoup de problèmes et de bugs... mais vous pouvez vraiment le voir améliorer les compétences dans des domaines comme le calcul ou le droit. Dans certains domaines, il est passé de très mauvaises performances à suffisamment évolué pour rivaliser avec les humains. maintenant. "

Les résultats du test GPT-4 sont très bons : à l'examen AP Calculus BC, GPT-4 a marqué 4 points, tandis que GPT-3 a marqué 1 point. Lors de l'examen simulé du barreau, le GPT-4 a réussi avec un score d'environ 10 % des meilleurs candidats ; le score du GPT-3.5 se situait dans les 10 % inférieurs.

En termes de capacités contextuelles, c'est-à-dire de texte pouvant être mémorisé avant de générer le texte, GPT-4 peut mémoriser environ 50 pages de contenu, soit 8 fois celle de GPT-3.

En termes d'invites, GPT-3 et GPT-3.5 ne peuvent accepter que des invites de texte : "Écrivez un article sur les girafes", tandis que GPT-4 multimodal peut accepter des invites d'image et de texte : donnez une image d'une girafe. pose la question « Combien y a-t-il de girafes ici ? » Ces GPT-4 peuvent répondre correctement, et sa capacité à lire les mèmes est également très forte !

Nous avions tort avant, l'open source n'est pas judicieux

Et dès que le ridiculement puissant GPT-4 est sorti, il a suscité l'intérêt d'un grand nombre de chercheurs et d'experts. Mais ce qui est décevant, c'est que le GPT-4 publié par OpenAI n'est pas un « modèle Open AI ».

Bien qu'OpenAI ait partagé un grand nombre de benchmarks, de résultats de tests et de démonstrations intéressantes de GPT-4, il ne propose fondamentalement pas de formation. Données sur le système, les coûts énergétiques ou informations sur le matériel spécifique ou les méthodes utilisées pour le créer.

Lorsque le modèle LLaMa de Meta a déjà été divulgué, cela a déclenché une vague de discussions sur l'open source. Cependant, cette fois, la réaction initiale de chacun au modèle fermé GPT-4 a été majoritairement négative.

La communauté de l’intelligence artificielle estime généralement que cela sape non seulement l’esprit fondateur d’OpenAI en tant qu’institution de recherche, mais rend également difficile pour d’autres de développer des garanties pour faire face aux menaces.

Ben Schmidt, vice-président de la conception de l'information chez Nomic AI, a déclaré que comme il est impossible de voir sur quelles données GPT-4 a été formé, il est difficile pour tout le monde de savoir où le système peut être utilisé en toute sécurité et de proposer des solutions de réparation.

« Pour que les gens sachent où ce modèle ne fonctionne pas, OpenAI doit mieux comprendre ce que fait GPT-4 et les hypothèses qu'il fait. Je ne vais pas faire confiance à quelqu'un dans un climat enneigé quand il neige. Des voitures autonomes formées, car il est très probable que des failles et des problèmes n'apparaîtront que lorsqu'elles seront réellement utilisées. " À cet égard, le scientifique en chef et co-fondateur d'OpenAI, Ilya Sutskever, a expliqué : OpenAI ne partage pas davantage sur GPT. Il y a il ne fait aucun doute que l'information -4 est due à la peur de la concurrence et aux préoccupations de sécurité.

"La concurrence extérieure est féroce et le développement de GPT-4 n'est pas facile. Presque tous les employés d'OpenAI travaillent ensemble depuis longtemps pour produire cette chose. Du point de vue de la concurrence, de très nombreuses entreprises souhaitent En faisant la même chose, GPT-4 est comme un fruit mûr."

Comme nous le savons tous, OpenAI était une organisation à but non lucratif lors de sa création en 2015. Ses fondateurs comprennent Sutskever, l'actuel PDG Sam Altman, le président Greg Brockman et Musk, qui a maintenant quitté OpenAI.

Sutskever et d'autres ont déclaré que l'objectif de l'organisation est de créer de la valeur pour tous, pas seulement pour les actionnaires, et ont déclaré qu'ils « coopéreraient librement » avec toutes les parties prenantes sur le terrain.

Cependant, afin d'obtenir des milliards de dollars d'investissement (principalement de la part de Microsoft), OpenAI s'est vu attribuer une couche d'attributs commerciaux.

Cependant, lorsqu'on lui a demandé pourquoi OpenAI avait changé son approche du partage de ses recherches, Sutskever a simplement répondu :

"Nous avions tort. À un moment donné, l'IA/AGI deviendra extrêmement puissante, et à ce moment-là, l'open source n'aura plus de sens. On peut s'attendre à ce que d'ici quelques années, tout le monde comprenne pleinement que l'IA open source n'est pas judicieuse. Parce que ce modèle est très puissant, si quelqu'un le voulait, il serait assez facile de faire beaucoup de dégâts, donc à mesure que les capacités du modèle deviennent de plus en plus élevées, il est logique de ne pas vouloir les révéler. "

William Falcon, PDG de Lightning AI et créateur de l'outil open source PyTorch Lightning, a expliqué d'un point de vue commercial : "En tant qu'entreprise, vous avez parfaitement le droit de le faire

Risques de sécurité

En même temps, Brockman croit également à l'adoption." de GPT-4 devrait progresser lentement à mesure qu’OpenAI évalue les risques et les avantages.

"Nous devons résoudre certains problèmes politiques, tels que la reconnaissance faciale et la manière de traiter les images de personnes. Nous devons déterminer où se trouve la zone de danger, où se trouve la ligne rouge, puis clarifier progressivement ces points

." Et le cliché, Le risque que GPT-4 soit utilisé pour faire de mauvaises choses.

Adversa AI, une startup israélienne de cybersécurité, a publié un article de blog montrant comment contourner les filtres de contenu d'OpenAI et permettre à GPT-4 de générer des e-mails de phishing, des descriptions sexuelles d'homosexuels et d'autres textes hautement répréhensibles.

Par conséquent, beaucoup de gens espèrent que GPT-4 apportera des améliorations significatives en matière de modération.

En réponse à cela, Brockman a souligné qu'ils avaient passé beaucoup de temps à essayer de comprendre les capacités du GPT-4 et que le modèle avait suivi six mois de formation en sécurité. Lors de tests internes, GPT-4 était 82 % moins susceptible que GPT-3.5 de répondre à du contenu non autorisé par la politique d'utilisation d'OpenAI, et était 40 % plus susceptible de produire des réponses « factuelles ».

Cependant, Brockman ne nie pas que GPT-4 présente des lacunes à cet égard. Mais il a souligné le nouvel outil du modèle axé sur l'atténuation, une capacité au niveau de l'API appelée « informations système ».

Les messages système sont essentiellement des instructions qui donnent le ton et établissent les limites des interactions GPT-4. De cette façon, l'utilisation des informations système comme garde-corps peut empêcher GPT-4 de s'écarter de la direction.

Par exemple, le personnage d'un message système pourrait ressembler à ceci : "Vous êtes un tuteur qui répond toujours aux questions de manière socratique. Vous ne donnez jamais de réponses aux étudiants, mais essayez toujours de poser les bonnes questions et de les aider à apprendre à réfléchir." pour vous-même. "

New Road

En fait, dans une certaine mesure, Sutskever est également d'accord avec les critiques : "Si davantage de personnes sont prêtes à étudier ces modèles, nous en saurons plus, ce qui sera une bonne chose. «

OpenAI donne donc accès à ses systèmes à certaines institutions universitaires et de recherche pour ces raisons.

Et Brockman a également mentionné Evals, le nouveau framework logiciel open source d'OpenAI pour évaluer les performances de ses modèles d'intelligence artificielle.

Evals utilise le crowdsourcing pour les tests de modèles, permettant aux utilisateurs de développer et d'exécuter des benchmarks pour évaluer des modèles tels que GPT-4, tout en vérifiant leurs performances. C'est également l'un des signes de l'engagement d'OpenAI envers des modèles « solides ».

「Grâce aux évaluations, nous pouvons voir les cas d'utilisation qui intéressent les utilisateurs et être en mesure de les tester de manière systématique. Une partie de la raison pour laquelle nous sommes open source est que nous passons de la publication d'un nouveau modèle tous les trois mois à. améliorer continuellement de nouveaux modèles. Lorsque nous créons une nouvelle version de modèle, nous pouvons au moins savoir quels sont les changements grâce à l'open source "

En fait, la discussion sur le partage de la recherche a été assez animée. D’un côté, les géants de la technologie comme Google et Microsoft s’empressent d’ajouter des capacités d’IA à leurs produits, mettant souvent de côté les préoccupations éthiques antérieures, d’un autre côté, Microsoft a récemment licencié une équipe chargée de garantir que les produits d’IA sont conformes à l’éthique. Les progrès rapides de la technologie ont suscité des inquiétudes concernant l'intelligence artificielle.

Jess Whittlestone, responsable de la politique britannique en matière d'IA, a déclaré que l'équilibre entre ces différentes pressions pose de sérieux problèmes de gouvernance, ce qui signifie que nous pourrions avoir besoin de l'implication de régulateurs tiers.

"L'intention d'OpenAI de ne pas partager plus de détails sur GPT-4 est bonne, mais cela pourrait également conduire à la centralisation du pouvoir dans le monde de l'intelligence artificielle. Ces décisions ne devraient pas être prises par des entreprises individuelles." Idéal La situation est que nous devons codifier les pratiques ici, puis demander à des tiers indépendants d'examiner les risques associés à certains modèles.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI