Maison >Périphériques technologiques >IA >Lorsque GPT-4 apprend à lire des images et du texte, une révolution de la productivité est imparable

Lorsque GPT-4 apprend à lire des images et du texte, une révolution de la productivité est imparable

- 青灯夜游avant

- 2023-03-31 22:38:411835parcourir

De nombreux chercheurs du monde universitaire et de l'industrie ont mené des discussions approfondies sur « la technologie intelligente de traitement d'images et de texte et la technologie d'application multi-scénarios ».

« C'est trop compliqué ! »

Après avoir expérimenté GPT-4 et Microsoft Microsoft 365 Copilot After les bombardements continus, je crois que beaucoup de gens ont ce sentiment.

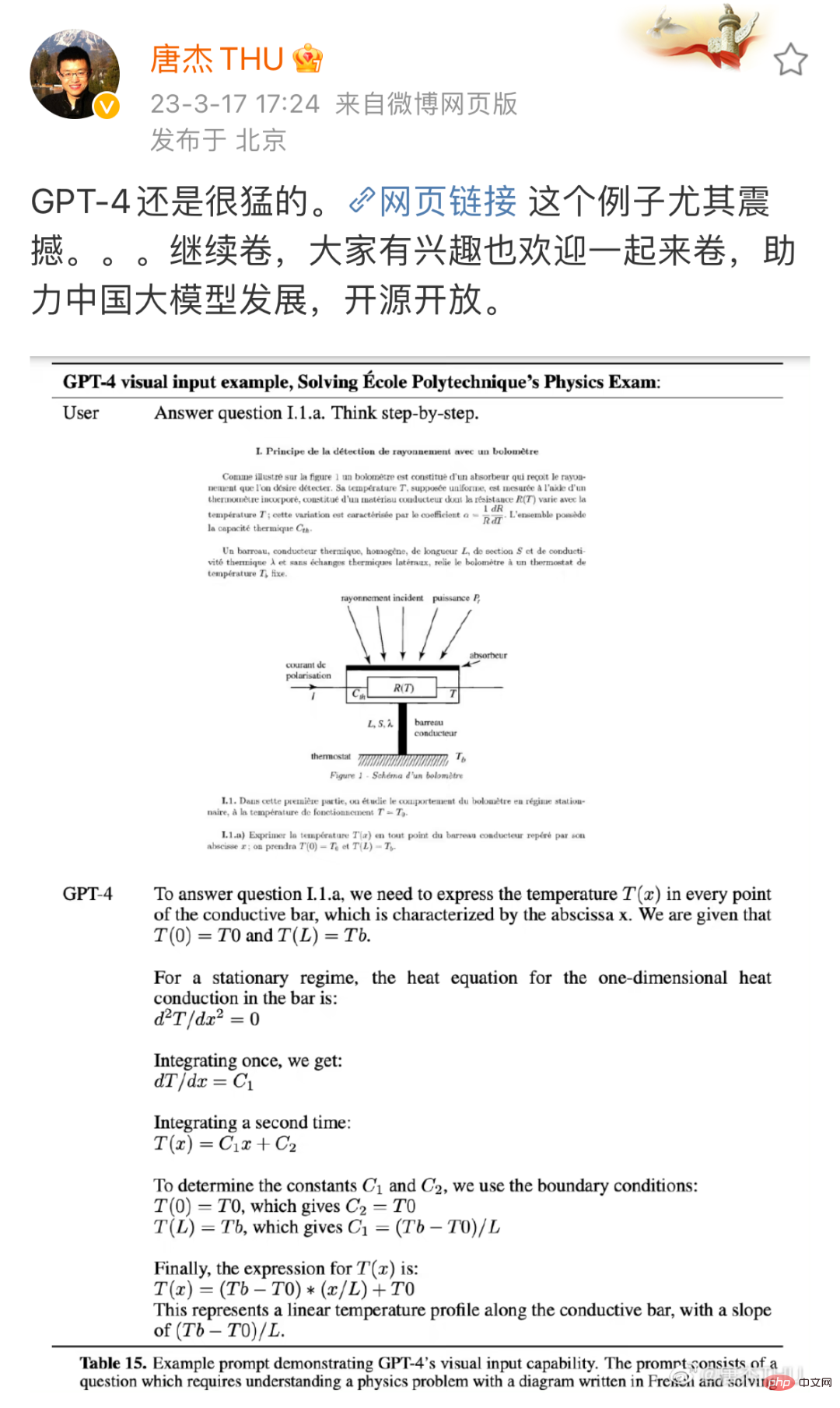

Par rapport à GPT-3.5, GPT-4 a réalisé des améliorations significatives dans de nombreux aspects. Par exemple, dans l'examen simulé du barreau, il est passé des 10 % inférieurs d'origine à 10 % positifs. Bien entendu, les gens ordinaires n’ont peut-être aucune idée de ces examens professionnels. Mais si je vous montre une image, vous comprendrez à quel point son amélioration est terrifiante :

Source : Tang Jie, professeur du département d'informatique de l'université Tsinghua, Weibo. Lien : https://m.weibo.cn/detail/4880331053992765

Il s'agit d'une question de physique GPT-4 est nécessaire pour résoudre le problème étape par étape en fonction des images et des textes. Il s'agit de GPT-3.5 (ici. fait référence au ChatGPT avant la mise à niveau) Les modèles dépendants) n'ont pas de fonctionnalités. D'une part, GPT-3.5 est uniquement formé pour comprendre le texte et ne peut pas comprendre l'image de la question. D'un autre côté, la capacité de résolution de problèmes de GPT-3.5 est également très faible et peut être déconcertée par un poulet et un lapin dans la même cage. Mais cette fois, les deux problèmes semblent avoir été résolus à merveille.

Juste au moment où tout le monde pensait que c'était un gros problème, Microsoft a publié un autre blockbuster : GPT-4. Ces fonctionnalités ont été intégrées dans une nouvelle application appelée Microsoft 365 Copilot. Grâce à ses puissantes capacités de traitement d'images et de texte, Microsoft 365 Copilot peut non seulement vous aider à rédiger divers documents, mais également à convertir facilement des documents en PPT et à résumer automatiquement les données Excel en graphiques...

Des débuts technologiques au lancement du produit, OpenAI et Microsoft n'ont donné au public que deux jours pour répondre. Du jour au lendemain, une nouvelle révolution de la productivité est arrivée.

Parce que les changements se produisent si rapidement, le monde universitaire et l'industrie sont plus ou moins dans un état de confusion et de « FOMO (peur de manquer quelque chose) ». Actuellement, tout le monde veut connaître une réponse : que pouvons-nous faire dans cette vague ? Quelles sont les opportunités disponibles ? À partir de la démo publiée par Microsoft, nous pouvons trouver une percée claire : Traitement intelligent d'images et de texte.

Dans des scénarios réels, de nombreux emplois dans divers secteurs sont liés au traitement graphique et de texte, comme l'organisation de données non structurées dans des graphiques, la rédaction de rapports basés sur des graphiques, l'extraction d'informations utiles à partir d'informations graphiques massives, etc. Pour cette raison, l’impact de cette révolution pourrait être bien plus profond que ce que beaucoup de gens imaginent. Un récent article à succès d'OpenAI et de la Wharton School prédit cet impact : environ 80 % de la main-d'œuvre américaine pourrait voir au moins 10 % de ses tâches affectées par l'introduction du GPT, et environ 19 % des travailleurs sont susceptibles de voir au moins 50% des tâches concernées. Il est prévisible qu'une grande partie du travail implique une intelligence graphique et textuelle.

À un tel point d’entrée, quels efforts de recherche ou d’ingénierie méritent d’être explorés ? Lors du récent événement CSIG Enterprise Tour organisé par la Société chinoise de l'image et du graphisme (CSIG) et organisé conjointement par Hehe Information et le comité professionnel d'analyse et de reconnaissance d'images de documents du CSIG, de nombreux chercheurs du monde universitaire et de l'industrie se sont concentrés sur « Traitement intelligent des images et text" Technologie et technologie d'application multi-scénarios " a mené une discussion approfondie, qui pourrait inspirer les chercheurs et les praticiens préoccupés par le domaine du traitement intelligent d'images et de textes.

Le traitement des graphiques et du texte commence par la vision sous-jacente

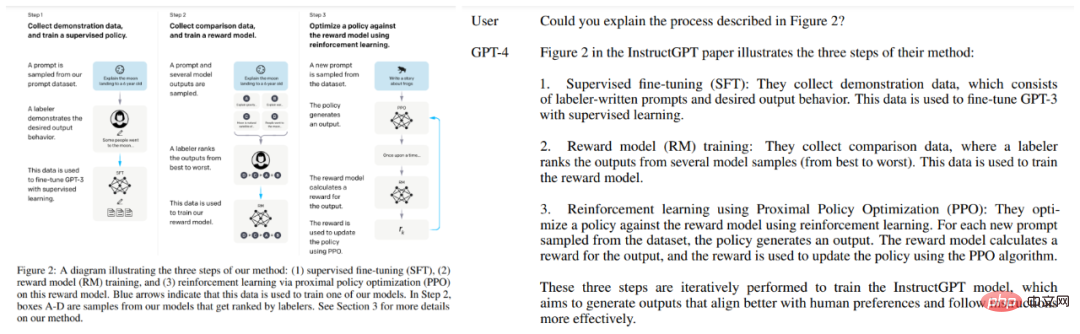

Comme mentionné précédemment, les capacités graphiques et de traitement de texte de GPT-4 sont très choquantes. En plus de la question physique ci-dessus, le rapport technique d'OpenAI a également cité d'autres exemples, comme laisser GPT-4 lire l'image papier :

Cependant, il y a peut-être encore beaucoup de travail de base à faire pour qu'un tel La technologie doit être largement mise en œuvre, la vision sous-jacente en fait partie.

Les caractéristiques de la vision sous-jacente sont très évidentes : l'entrée est une image, et la sortie est aussi une image. Le prétraitement, le filtrage, la restauration et l'amélioration des images entrent tous dans cette catégorie.

« Les théories et méthodes de la vision sous-jacente sont largement utilisées dans de nombreux domaines, tels que la téléphonie mobile, l'analyse d'images médicales, la surveillance de la sécurité, etc. Les entreprises et institutions qui valorisent la qualité des images et des contenus vidéo doivent prêter attention à la recherche sur la direction de la vision sous-jacente. Si la vision sous-jacente n'est pas bien réalisée, de nombreux systèmes de vision de haut niveau (tels que la détection, la reconnaissance et la compréhension) ne peuvent pas être véritablement mis en œuvre. " Guo Fengjun, directeur de la R&D sur les algorithmes d'image de Hehe. Information, déclarée lors de l'événement CSIG Enterprise Tour.

Comment comprendre cette phrase ? Nous pouvons regarder quelques exemples :

Contrairement à la situation idéale présentée dans les démos OpenAI et Microsoft, les graphiques et le texte du monde réel existent toujours sous des formes difficiles, telles que des déformations, des ombres et des motifs de moiré, ce qui augmentera la difficulté de reconnaissance et de compréhension ultérieures. L’objectif de l’équipe de Guo Fengjun est de résoudre ces problèmes dans un premier temps.

À cette fin, ils ont divisé cette tâche en plusieurs modules, dont l'extraction de la région d'intérêt (RoI), la correction de la déformation, la restauration de l'image (telle que la suppression des ombres, le moiré), l'amélioration de la qualité (telle que la netteté améliorée, la clarté) et l'attente.

Ces technologies peuvent être combinées pour créer des applications très intéressantes. Après des années d'exploration, ces modules ont obtenu d'assez bons résultats et la technologie associée a été appliquée au produit de reconnaissance de texte intelligent « Scanner » de l'entreprise.

Des mots aux tableaux, en passant par les chapitres, lisez les images et les textes étape par étape

Une fois l'image traitée, l'étape suivante consiste à identifier le contenu de l'image et du texte. Il s'agit également d'un travail très détaillé, et peut même être réalisé en unités de « mots ».

Dans de nombreux scénarios du monde réel, les caractères n'apparaissent pas nécessairement sous une forme imprimée standardisée, ce qui pose des problèmes de reconnaissance des caractères.

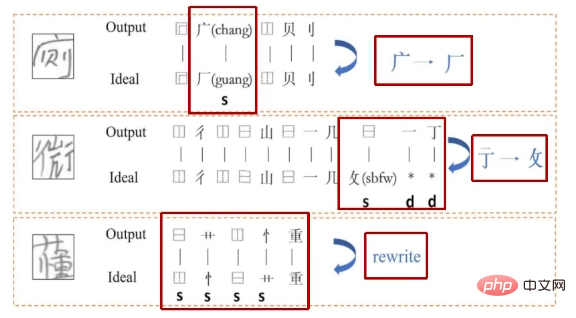

Prenons l'exemple de la scène éducative. Supposons que vous soyez un enseignant et que vous souhaitiez absolument que l'IA vous aide directement à corriger les devoirs de tous les élèves, tout en résumant la maîtrise de chaque partie des connaissances par les élèves. Il est également préférable de poser des questions erronées, des fautes de frappe et des corrections. suggestions. Du Jun, professeur agrégé au Laboratoire national d'ingénierie pour le traitement de l'information vocale et linguistique de l'Université des sciences et technologies de Chine, travaille dans ce domaine.

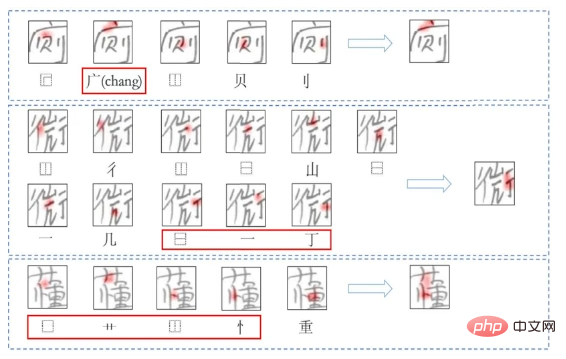

Plus précisément, ils ont créé un système de reconnaissance, de génération et d'évaluation des caractères chinois basé sur les radicaux, car par rapport à la modélisation de caractères entiers, il existe beaucoup moins de combinaisons de radicaux. Parmi eux, la reconnaissance et la génération sont optimisées conjointement, ce qui s'apparente un peu au processus de renforcement mutuel de l'alphabétisation et de l'écriture lorsque les élèves apprennent. Dans le passé, la plupart des travaux d'évaluation se concentraient sur le niveau grammatical, mais l'équipe de Du Jun a conçu une méthode capable de trouver les fautes de frappe directement à partir de l'image et d'expliquer les erreurs en détail. Cette méthode sera très utile dans des scénarios tels que le marquage intelligent.

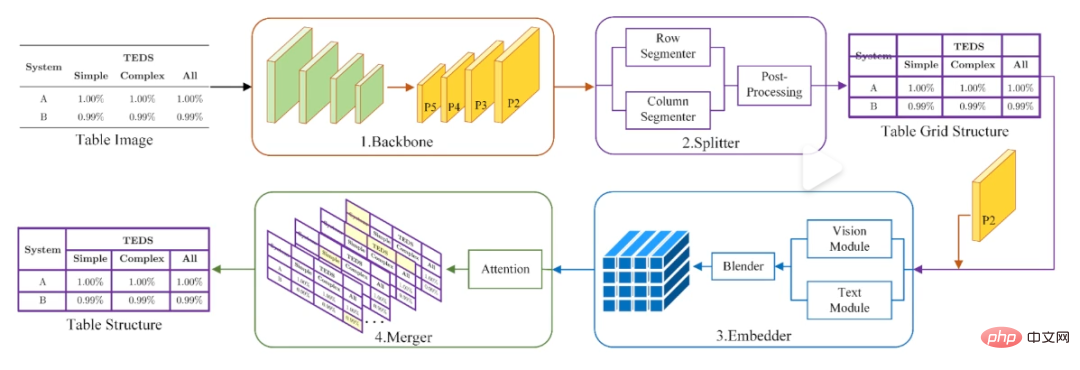

En plus du texte, l'identification et le traitement des tableaux sont en fait une grande difficulté, car il faut non seulement identifier le contenu à l'intérieur, mais aussi clarifier la relation structurelle entre ces contenus, et certains tableaux peuvent même ne pas avoir filaires. À cette fin, l'équipe de Du Jun a conçu une méthode « diviser d'abord, puis fusionner », c'est-à-dire diviser d'abord l'image du tableau en une série de grilles de base, puis apporter d'autres corrections par fusion.

Méthode de reconnaissance de formulaire « d'abord diviser, puis fusionner » de l'équipe de Du Jun.

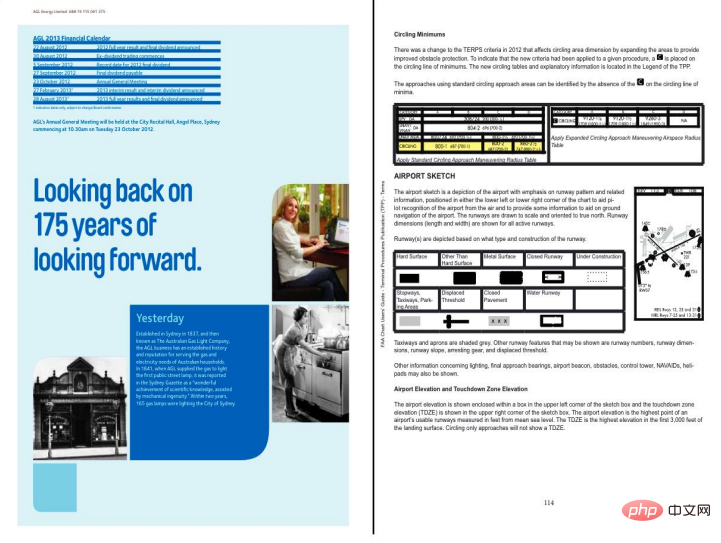

Bien sûr, tout ce travail jouera à terme un rôle dans la structuration et la compréhension des documents au niveau des chapitres. Dans les environnements réels, la plupart des documents auxquels les modèles sont confrontés comportent plus d'une page (comme un papier). Dans cette direction, les travaux de l'équipe de Du Jun se concentrent sur la classification des éléments de documents inter-pages et la restauration de la structure des documents inter-pages. Cependant, ces méthodes présentent encore des limites dans les scénarios multi-mises en page.

Grand modèle, multimodalité, modèle mondial... Où est l'avenir ?

En ce qui concerne le traitement et la compréhension des images et du texte au niveau des chapitres, nous ne sommes en fait pas loin de GPT-4. "Après la sortie du GPT-4 multimodal, nous avons également réfléchi à la possibilité de faire quelque chose dans ces aspects", a déclaré Du Jun lors de l'événement. Je crois que de nombreux chercheurs ou praticiens dans le domaine du traitement d’images et de textes ont cette idée.

L'objectif de la série de modèles GPT a toujours été de s'efforcer d'améliorer la polyvalence et, à terme, d'atteindre l'intelligence artificielle générale (AGI). Les puissantes capacités de compréhension d’images et de textes démontrées cette fois par GPT-4 constituent une partie importante de cette capacité générale. Pour créer un modèle doté de capacités similaires, OpenAI a donné quelques références, mais a également laissé de nombreux mystères et problèmes non résolus.

Tout d’abord, le succès de GPT-4 montre que l’approche grand modèle + multi-modalité est réalisable. Cependant, quels problèmes devraient être étudiés dans les grands modèles et comment résoudre les besoins exagérés en puissance de calcul des modèles multimodaux sont autant de défis auxquels sont confrontés les chercheurs.

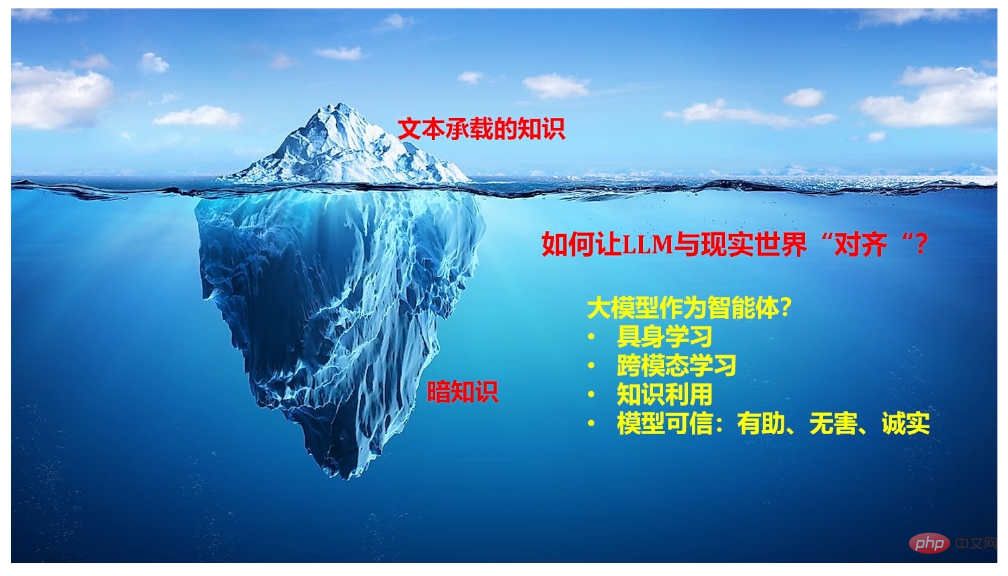

Pour la première question, Qiu Xipeng, professeur à l'École d'informatique de l'Université de Fudan a donné quelques orientations dignes de référence. Selon certaines informations précédemment divulguées par OpenAI, nous savons que ChatGPT est indissociable de plusieurs technologies clés, notamment l'apprentissage en contexte, la chaîne de pensée et l'apprentissage à partir d'instructions. Qiu Xipeng a souligné dans son partage qu'il reste encore de nombreuses questions à discuter dans ces directions, telles que l'origine de ces capacités, comment continuer à s'améliorer et comment les utiliser pour transformer les paradigmes d'apprentissage existants. En outre, il a également partagé les capacités à prendre en compte lors de la création de modèles de langage conversationnel à grande échelle et les orientations de recherche qui peuvent être envisagées pour aligner ces modèles sur le monde réel.

Concernant la deuxième question, le Professeur distingué Ji Rongrong de Nanqiang de l'Université de Xiamen a apporté une idée importante. Il estime qu’il existe un lien naturel entre le langage et la vision, et que l’apprentissage conjoint entre les deux constitue la tendance générale. Mais face à cette vague, le pouvoir de toute université ou laboratoire est insignifiant. Alors maintenant, depuis l’Université de Xiamen où il travaille, il tente de persuader les chercheurs d’intégrer la puissance de calcul et de former un réseau pour construire de grands modèles multimodaux. En fait, lors d'un événement il y a quelque temps, l'académicien E Weinan, qui se concentre sur l'IA pour la science, a également exprimé des points de vue similaires, espérant que tous les horizons « osent mettre en commun leurs ressources dans des directions d'innovation originales ».

Pour autant, le chemin emprunté par GPT-4 mènera-t-il définitivement à l’intelligence artificielle générale ? Certains chercheurs sont sceptiques à ce sujet, et Yann LeCun, lauréat du prix Turing, en fait partie. Il estime que ces grands modèles actuels ont des besoins énormes en données et en puissance de calcul, mais que leur efficacité d'apprentissage est très faible (comme les voitures autonomes). Par conséquent, il a créé une théorie appelée « modèle mondial » (un modèle interne du fonctionnement du monde), estimant que l'apprentissage d'un modèle mondial (qui peut être compris comme l'exécution d'une simulation pour le monde réel) peut être la clé pour atteindre l'AGI. Lors de l'événement, le Professeur Yang Xiaokang de l'Université Jiao Tong de Shanghai a partagé son travail dans cette direction. Plus précisément, son équipe s'est concentrée sur le modèle mondial de l'intuition visuelle (car l'intuition visuelle contient une grande quantité d'informations), en essayant de modéliser la vision, l'intuition et la perception du temps et de l'espace. Enfin, il a également souligné l’importance de l’intersection des disciplines mathématiques, physiques, cognitives de l’information et informatique pour ce type de recherche.

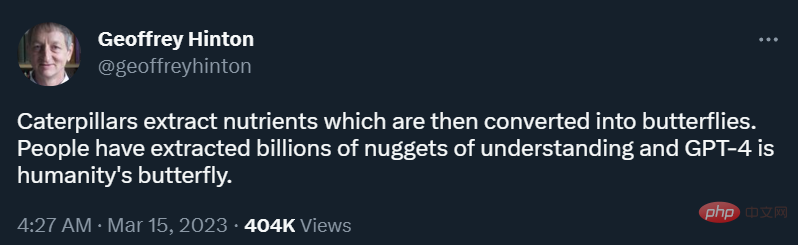

"Une chenille extrait les nutriments de la nourriture puis se transforme en papillon. Les gens ont extrait des milliards d'indices pour comprendre. GPT-4 est le papillon humain." Le lendemain de la sortie de GPT-4, le père Geoffrey Hinton, apprenant en profondeur, a tweeté. ce.

Actuellement, personne ne peut prédire quelle ampleur d'ouragan ce papillon va déclencher. Mais il est certain que ce n’est pas encore un papillon parfait et que l’ensemble du puzzle du monde AGI n’est pas encore terminé. Chaque chercheur et praticien a encore des opportunités.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI