Maison >Périphériques technologiques >IA >L'apprentissage par renforcement fait à nouveau la couverture de Nature, et le nouveau paradigme de vérification de la sécurité de la conduite autonome réduit considérablement le kilométrage des tests

L'apprentissage par renforcement fait à nouveau la couverture de Nature, et le nouveau paradigme de vérification de la sécurité de la conduite autonome réduit considérablement le kilométrage des tests

- PHPzavant

- 2023-03-31 22:38:371879parcourir

Présentation de l'apprentissage par renforcement dense et utilisation de l'IA pour vérifier l'IA.

Les progrès rapides de la technologie des véhicules autonomes (VA) nous placent à l’aube d’une révolution des transports d’une ampleur jamais vue depuis l’avènement de l’automobile il y a un siècle. La technologie de conduite autonome a le potentiel d’améliorer considérablement la sécurité routière, la mobilité et la durabilité et a donc attiré l’attention de l’industrie, des agences gouvernementales, des organisations professionnelles et des établissements universitaires.

Le développement des voitures autonomes a parcouru un long chemin au cours des 20 dernières années, notamment avec l'avènement du deep learning. En 2015, les entreprises commençaient à annoncer qu’elles produiraient en masse des AV d’ici 2020. Mais jusqu’à présent, aucun AV de niveau 4 n’est disponible sur le marché.

Il y a de nombreuses raisons à ce phénomène, mais la chose la plus importante est que les performances de sécurité des voitures autonomes sont encore nettement inférieures à celles des conducteurs humains. Pour le conducteur moyen aux États-Unis, la probabilité d'une collision dans l'environnement naturel de conduite (END) est d'environ 1,9 × 10^−6 par mile. À titre de comparaison, le taux de désengagement des véhicules autonomes de pointe est d’environ 2,0 × 10^−5/mile, selon les rapports de désengagement 2021 de la Californie.

Remarque : le taux de désengagement est un indicateur important pour évaluer la fiabilité de la conduite autonome. Il décrit le nombre de fois que le système demande à un conducteur de prendre le relais tous les 1 000 miles de fonctionnement. Plus le taux de désengagement du système est faible, meilleure est la fiabilité. Lorsque le taux de désengagement est égal à 0, cela signifie que le système de conduite autonome a atteint dans une certaine mesure le niveau sans conducteur.

Bien que l'on puisse reprocher au taux de désengagement d'être biaisé, il a été largement utilisé pour évaluer les performances de sécurité des véhicules autonomes.

L’un des principaux goulots d’étranglement dans l’amélioration des performances de sécurité des véhicules autonomes est la faible efficacité de la vérification de la sécurité. Il est actuellement courant de tester les essais non destructifs des véhicules autonomes en combinant simulation logicielle, piste d'essai fermée et essais sur route. En conséquence, les développeurs audiovisuels doivent engager des coûts et du temps considérables pour l'évaluation, ce qui entrave la progression du déploiement audiovisuel.

Vérifier les performances de la sécurité AV dans un environnement NDE est très complexe. Par exemple, les environnements de conduite sont complexes dans l’espace et dans le temps, de sorte que les variables requises pour définir de tels environnements sont de grande dimension. À mesure que la dimensionnalité des variables augmente de façon exponentielle, la complexité informatique augmente également. Dans ce cas, les modèles d’apprentissage profond sont difficiles à apprendre, même avec de grandes quantités de données.

Dans cet article, des chercheurs de l'Université du Michigan, d'Ann Arbor, de l'Université Tsinghua et d'autres institutions proposent une méthode dense d'apprentissage par renforcement profond (D2RL) pour résoudre ce défi.

Cette étude fait la couverture de Nature.

- Adresse papier : https://www.nature.com/articles/s41586-023-05732-2

- Adresse du projet : https://github.com/michigan-traffic-lab/Dense-Deep -Apprentissage par renforcement

Une maîtrise a été décernée après la rédaction de la thèse. Il est actuellement professeur assistant tenure track au département d'automatisation de l'université Tsinghua. Institut de recherche sur les transports (UMTRI). Il a obtenu sa licence et son doctorat au Département d'automatisation de l'Université Tsinghua en 2014 et 2019, sous la direction du professeur Zhang Yi. De 2017 à 2019, il a été doctorant invité en génie civil et environnemental à l’Université du Michigan, sous la direction du professeur Henry X. Liu (auteur correspondant de cet article).

Introduction à la recherche

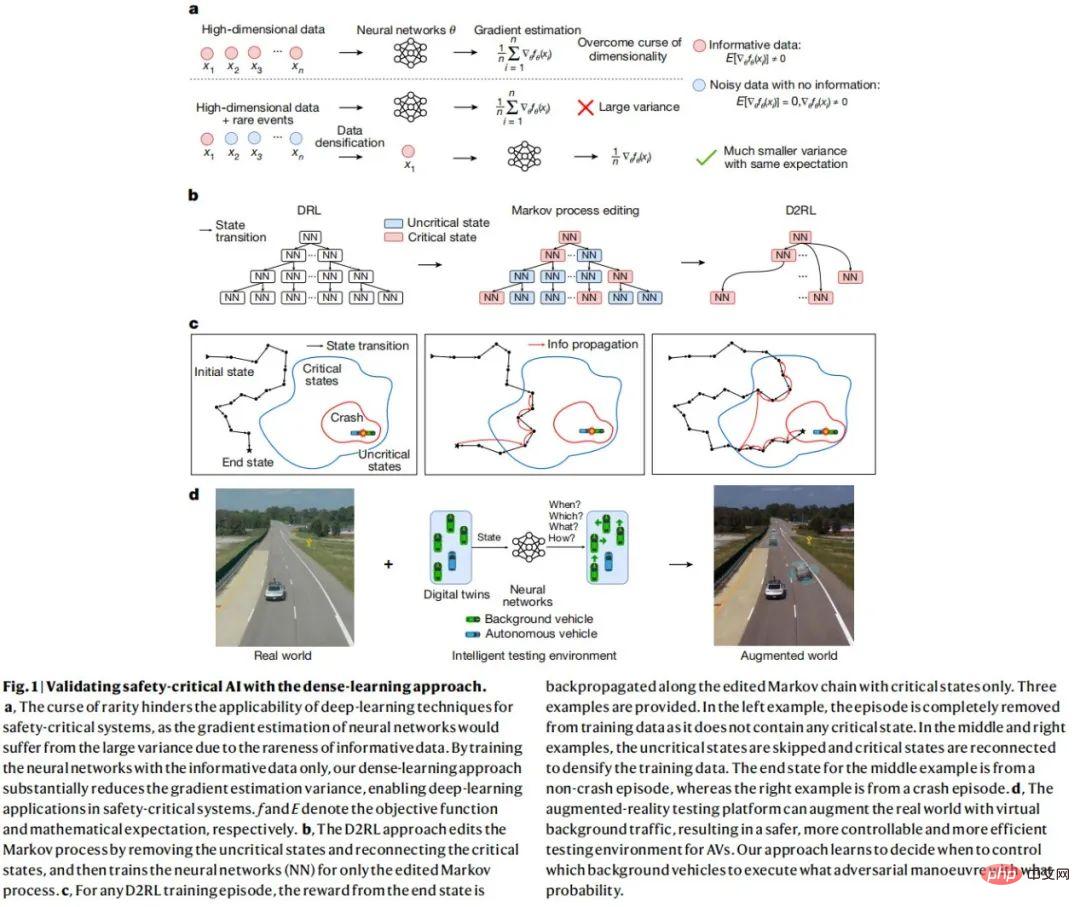

L'idée de base de la méthode D2RL est d'identifier et de supprimer les données non critiques pour la sécurité, et d'utiliser les données critiques pour la sécurité pour entraîner le réseau neuronal. Étant donné que seule une petite partie des données est critique pour la sécurité, les données restantes seront fortement densifiées en informations.

Par rapport à la méthode DRL, la méthode D2RL peut réduire considérablement la variance de l'estimation du gradient politique de plusieurs ordres de grandeur sans perdre son impartialité. Cette réduction significative de la variance peut permettre aux réseaux de neurones d'apprendre et d'accomplir des tâches difficiles à résoudre pour les méthodes DRL.

Pour les tests AV, cette recherche utilise la méthode D2RL pour entraîner des véhicules d'arrière-plan (BV) via des réseaux de neurones afin d'apprendre quand effectuer quelles opérations contradictoires, dans le but d'améliorer l'efficacité des tests. D2RL peut réduire le kilométrage de test requis pour les AV de plusieurs ordres de grandeur dans un environnement de test contradictoire basé sur l'IA tout en garantissant des tests impartiaux.

La méthode D2RL peut être appliquée à des environnements de conduite complexes, comprenant plusieurs autoroutes, intersections et ronds-points, ce qui n'est pas possible avec les méthodes précédentes basées sur des scénarios. De plus, la méthode proposée dans cette étude peut créer des environnements de test intelligents qui utilisent l’IA pour vérifier l’IA. Il s’agit d’un changement de paradigme qui ouvre la porte à des tests et à une formation accélérés d’autres systèmes critiques pour la sécurité.

Pour prouver que la méthode de test basée sur l'IA est efficace, cette étude a formé BV à l'aide d'un ensemble de données de conduite réelle à grande échelle et a mené des expériences de simulation et des expériences sur le terrain sur des pistes d'essai physiques. Les résultats expérimentaux sont présentés dans la figure 1 ci-dessous.

Apprentissage dense par renforcement profond

Pour tirer parti de la technologie de l'IA, cette étude formule le problème des tests AV comme un processus de décision de Markov (MDP), dans lequel le fonctionnement du BV est décidé en fonction des informations sur l'état actuel. L'étude vise à former une politique (agent DRL) modélisée par un réseau neuronal qui contrôle les actions des BV interagissant avec les AV pour maximiser l'efficacité de l'évaluation et garantir l'impartialité. Cependant, comme mentionné ci-dessus, en raison des limites de dimensionnalité et de la complexité informatique, il est difficile, voire impossible, d’apprendre des politiques efficaces si la méthode DRL est directement appliquée.

Étant donné que la plupart des états ne sont pas critiques et ne peuvent pas fournir d'informations sur les événements critiques pour la sécurité, D2RL se concentre sur la suppression des données de ces états non critiques. Pour les problèmes de tests antivirus, un certain nombre de mesures de sécurité peuvent être exploitées pour identifier les états critiques avec une efficience et une efficacité variables. La métrique de criticité utilisée dans cette étude est une approximation externe du taux de collision AV dans un laps de temps spécifique de l'état actuel (par exemple, 1 seconde). L'étude a ensuite modifié le processus de Markov, en supprimant les données pour les états non critiques, et a utilisé les données restantes pour l'estimation du gradient politique et le Bootstrap pour la formation DRL.

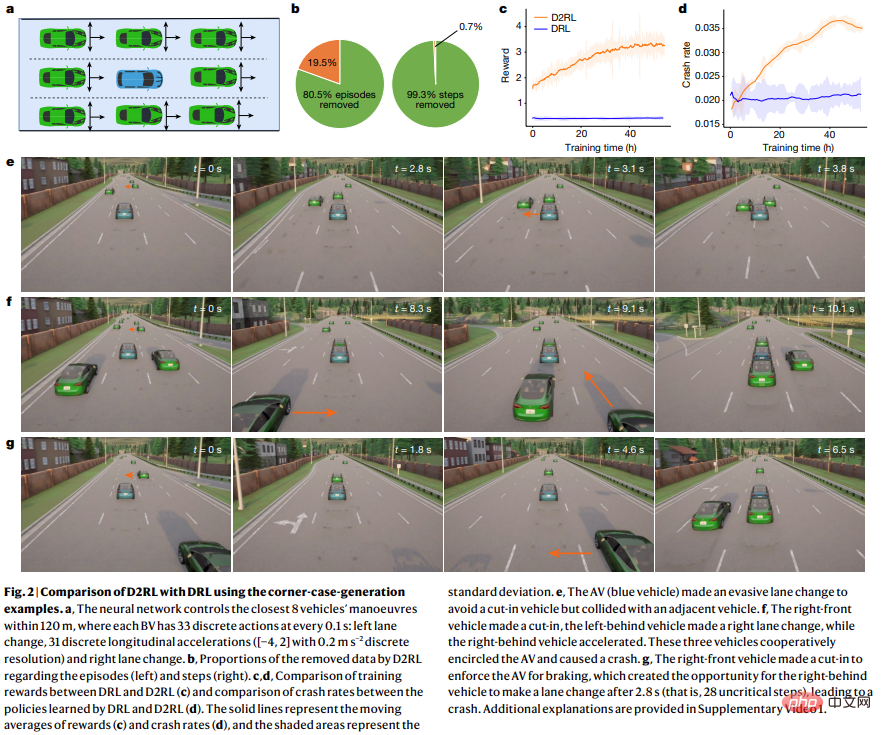

Comme le montre la figure 2 ci-dessous, par rapport au DRL, l'avantage du D2RL est qu'il peut maximiser la récompense pendant le processus d'entraînement.

Test de simulation AV

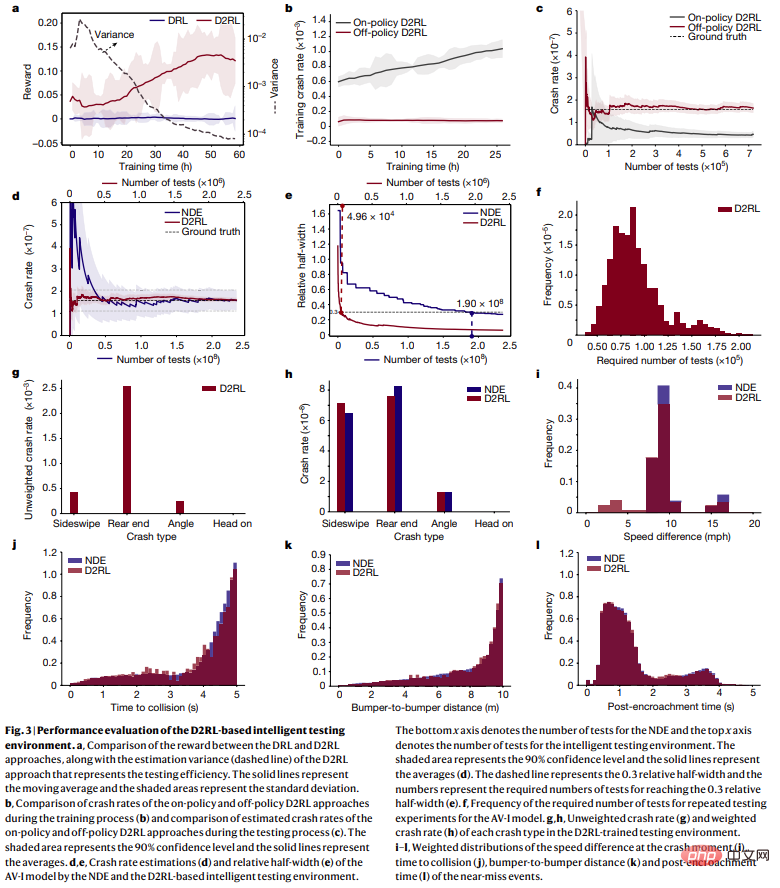

Pour évaluer la précision, l'efficacité, l'évolutivité et la généralité de la méthode D2RL, cette étude a mené des tests de simulation. Pour chaque ensemble de tests, l'étude a simulé une distance fixe de déplacement, puis a enregistré et analysé les résultats des tests, comme le montre la figure 3 ci-dessous.

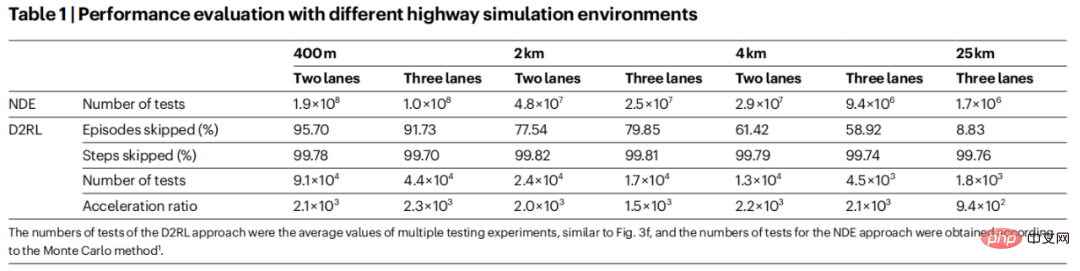

Pour étudier plus en détail l'évolutivité et la généralisation du D2RL, cette étude a mené des modèles AV-I avec différents numéros de voie (2 voies et 3 voies) et distances de conduite (400 mètres, 2 kilomètres, 4 kilomètres et 25 km) . Cet article examine les trajets de 25 kilomètres, car le navetteur moyen aux États-Unis parcourt environ 25 kilomètres pour un aller simple. Les résultats sont présentés dans le tableau 1 :

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI