Maison >développement back-end >Tutoriel Python >Spark peut-il exécuter Python ?

Spark peut-il exécuter Python ?

- 藏色散人original

- 2019-08-06 11:53:503432parcourir

Spark peut-il exécuter Python ?

spark peut exécuter des programmes Python. Les algorithmes écrits en Python ou des bibliothèques d'extensions telles que sklearn peuvent être exécutés sur Spark. Il est également possible d'utiliser directement la mllib de Spark, disponible pour la plupart des algorithmes.

Spark est un moteur à usage général qui peut être utilisé pour effectuer diverses opérations, notamment des requêtes SQL, le traitement de texte, l'apprentissage automatique, etc.

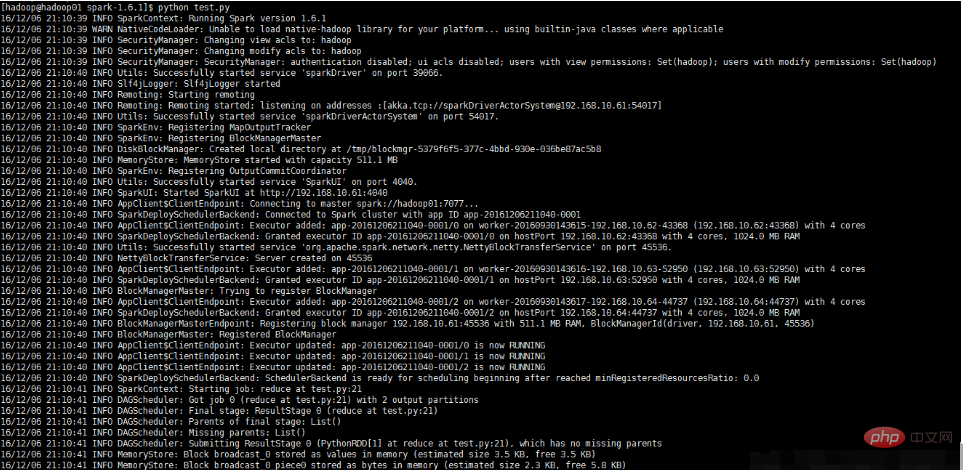

Cette expérience a été exécutée sous Linux avec un environnement Spark. La version Spark est 1.6.1, ce qui équivaut à l'exécuter localement dans Spark. Le fichier Spark est placé dans /opt/moodles/spark-1.6. 1/ (Vous le verrez dans le code)

Écrivez un programme de test python

#test.py文件

# -*- coding:utf-8 -*-

import os

import sys

#配置环境变量并导入pyspark

os.environ['SPARK_HOME'] = r'/opt/moudles/spark-1.6.1'

sys.path.append("/opt/moudles/spark-1.6.1/python")

sys.path.append("/opt/moudles/spark-1.6.1/python/lib/py4j-0.9-src.zip")

from pyspark import SparkContext, SparkConf

appName ="spark_1" #应用程序名称

master= "spark://hadoop01:7077"#hadoop01为主节点hostname,请换成自己的主节点主机名称

conf = SparkConf().setAppName(appName).setMaster(master)

sc = SparkContext(conf=conf)

data = [1, 2, 3, 4, 5]

distData = sc.parallelize(data)

res = distData.reduce(lambda a, b: a + b)

print("===========================================")

print (res)

print("===========================================")Exécutez le programme python

Exécutez la commande suivante

python test.py

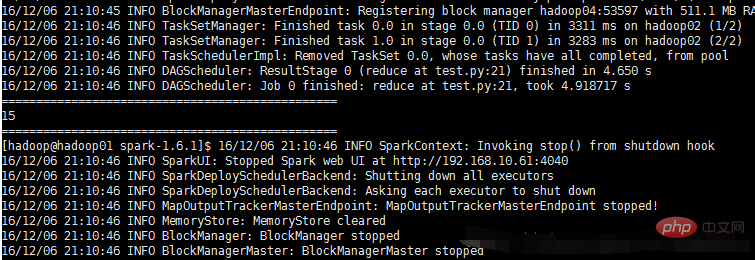

L'exécution et les résultats sont tels que présentés dans la figure ci-dessous Affichage :

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Comment configurer opencv en python

- Comment dessiner un lapin en utilisant Python - une introduction détaillée à l'utilisation de la fonction de dessin de cercles circle() dans la bibliothèque des tortues

- Le résumé le plus complet de l'utilisation des pandas Python

- Comprendre soi-même en Python en un seul article