Maison >Périphériques technologiques >IA >Tutoriel de modèle à réglage fin Solar-10.7b

Tutoriel de modèle à réglage fin Solar-10.7b

- 尊渡假赌尊渡假赌尊渡假赌original

- 2025-03-08 09:21:09969parcourir

Solar-10.7b: une plongée profonde dans un modèle de langage grand très efficace

Le projet SOLAR-10.7B marque un développement important dans le développement du modèle de langue grande (LLM). Cet article explore son approche de mise à l'échelle innovante, ses références de performance, son utilisation pratique et ses applications potentielles, tout en reconnaissant ses limites.

Comprendre Solar-10.7b

développé par Upstage AI en Corée du Sud, Solar-10.7b est un modèle de paramètres de 10,7 milliards de 10 ans construit sur l'architecture lama-2. Remarquablement, il surpasse les autres LLM avec un nombre de paramètres significativement plus élevé, y compris le mixtral 8x7b. Pour une compréhension complète de Llama-2, reportez-vous à notre guide sur le réglage fin de ce modèle.

La variante Solar-10.7b-Instruct, une version affinée, excelle sur les instructions complexes suivantes. Cela met en évidence la puissance du réglage fin pour adapter les LLM pour des tâches spécifiques. L'innovation principale derrière Solar-10.7b est sa méthode de dépassement de mise à l'échelle (DUS), détaillée ci-dessous.

profondeur à l'échelle: une nouvelle technique de mise à l'échelle

DUS permet d'augmenter la profondeur du modèle sans augmentation proportionnelle des ressources de calcul. Cela améliore à la fois l'efficacité et les performances. La méthode repose sur trois composantes clés: les poids Mistral 7B, le cadre LLAMA 2 et la pré-formation continue.

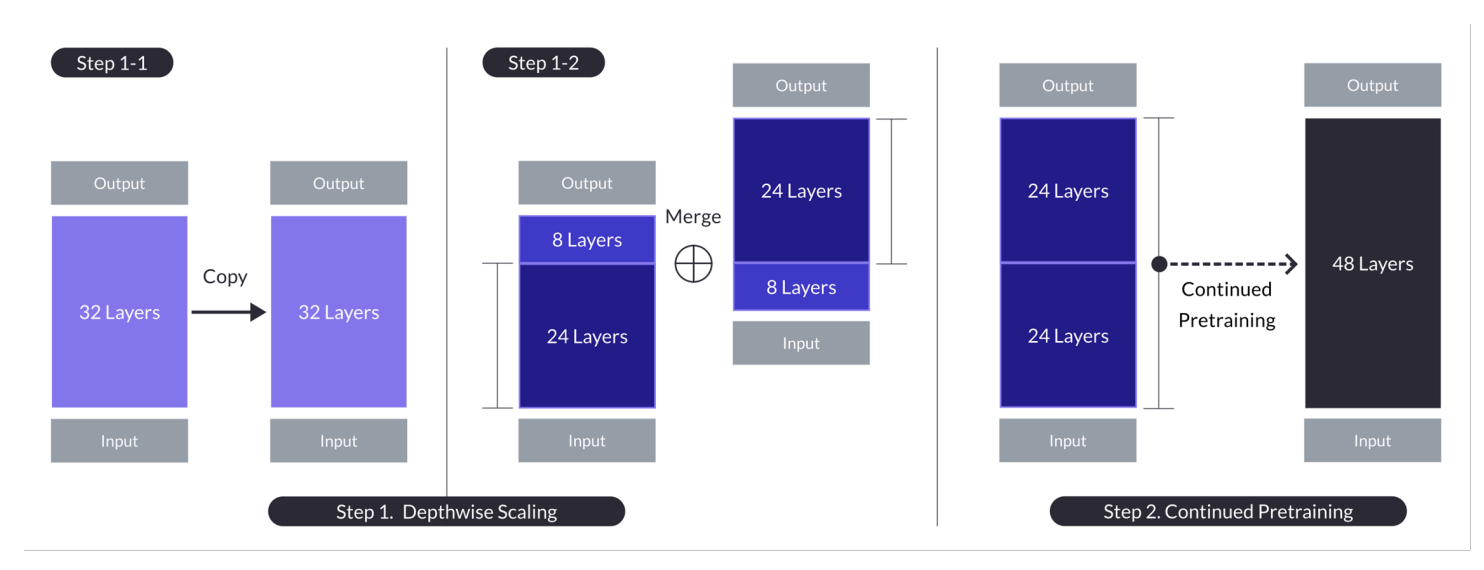

Illustration de mise à l'échelle de profondeur pour n = 32, S = 48 et M = 8. Un processus à deux étages combine la mise à l'échelle du sens de la profondeur et la pré-formation continue. (Source)

Le processus implique:

- Modèle de base: Un modèle de 32 couches Llama 2 initialisé avec des poids Mistral 7b.

- Échelle dans le sens de la profondeur: Le modèle de base est mis à l'échelle en le duplication, en supprimant les couches des deux copies et en les concaténant pour atteindre le nombre de couches souhaité (par exemple, 48 couches d'une base de 32 couches).

- Pré-formation continue: ATTENTIE PRÉSENTAIRE D'ATTENTIE D'ATTRESSE TOUTES PERFORMANCES COLUSE PAR LE PROCESSUS DE MALAGNE.

Cette approche en plusieurs étapes permet à Solar-10.7b de correspondre ou de dépasser les capacités de modèles beaucoup plus grands, ce qui en fait une option rentable et puissante.

SOLAR-10.7B-INSTRUCT: Instruction améliorée suivant

L'instruct Solar-10.7B est spécifiquement réglé pour une interprétation de l'enseignement complexe. Ceci est réalisé grâce à des réglages fins à l'aide de ensembles de données open source et de jeux de données MATH Synthétisés pour améliorer le raisonnement mathématique. La fondation du modèle dans l'architecture lama-2 fournit un équilibre entre la vitesse et la précision.

Applications du modèle affiné

Le modèle SOLAR-10.7B à réglage fin propose des applications diverses:

- Éducation personnalisée: Créer des systèmes de tutorat intelligents qui s'adaptent aux styles d'apprentissage individuels.

- Support client: Power Advanced Chatbots capable de gérer les requêtes complexes.

- Création de contenu automatisée: Générez diverses formes de contenu écrit et résumez de longs documents.

un guide pratique de l'utilisation de Solar-10.7B-Istruct

Cette section fournit un guide étape par étape pour utiliser le modèle SOLAR-10.7B-INSTRUCT V1.0 GGUF.

1. Installation:

pip -q install transformers==4.35.2 pip -q install accelerate

2. Importer des bibliothèques:

import torch from transformers import AutoModelForCausalLM, AutoTokenizer

3. Configuration du GPU: Assurez-vous qu'un GPU est activé (par exemple, en utilisant les paramètres d'exécution de Google Colab). Vérifiez avec !nvidia-smi.

4. Définition du modèle:

model_ID = "Upstage/SOLAR-10.7B-Instruct-v1.0" tokenizer = AutoTokenizer.from_pretrained(model_ID) model = AutoModelForCausalLM.from_pretrained(model_ID, device_map="auto", torch_dtype=torch.float16)

5. Inférence et génération de résultats du modèle:

user_request = "What is the square root of 24?"

conversation = [{'role': 'user', 'content': user_request}]

prompt = tokenizer.apply_chat_template(conversation, tokenize=False, add_generation_prompt=True)

inputs = tokenizer(prompt, return_tensors="pt").to(model.device)

outputs = model.generate(**inputs, use_cache=True, max_length=4096)

output_text = tokenizer.decode(outputs[0])

print(output_text)

limitations

Bien que puissant, Solar-10.7b a des limites:

- Optimisation de l'hyperparamètre: Une exploration d'hyperparamètre plus étendue est nécessaire pour Dus.

- Demandes de calcul: nécessite des ressources de calcul importantes.

- biais: Les biais potentiels dans les données de formation peuvent affecter les performances.

- Impact environnemental: Consommation élevée d'énergie pendant la formation et l'inférence.

Conclusion

SOLAR-10.7B représente un pas en avant significatif dans la mise à l'échelle LLM efficace. Sa méthode DUS innovante, associée à ses performances solides et à ses applications diverses, la positionne comme un outil précieux. Cependant, ses limites doivent être prises en compte. Pour une exploration plus approfondie de LLM Fineding, consultez nos tutoriels sur Flan-T5 et GPT-3.5.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI