Génération auto-réflexive-récupération (auto-rag): améliorer les LLM avec une récupération adaptative et une autocritique

Les modèles de langues grands (LLM) sont transformateurs, mais leur dépendance à l'égard des connaissances paramétriques conduit souvent à des inexactitudes factuelles. La génération (RAG) (RAG) de la récupération vise à y remédier en incorporant des connaissances externes, mais les méthodes traditionnelles de chiffon souffrent de limitations. Cet article explore Self-Rag, une nouvelle approche qui améliore considérablement la qualité et la factualité LLM.

Adommagent les lacunes du chiffon standard

Le chiffon standard récupère un nombre fixe de passages, quelle que soit sa pertinence. Cela conduit à plusieurs problèmes:

- Informations non pertinentes: La récupération des documents inutiles dilue la qualité de sortie.

- Manque d'adaptabilité: L'incapacité à ajuster la récupération en fonction des exigences des tâches entraîne des performances incohérentes.

- Sorties incohérentes: Le texte généré peut ne pas s'aligner sur les informations récupérées en raison d'un manque de formation explicite sur l'intégration des connaissances.

- Absence d'auto-évaluation: Aucun mécanisme pour évaluer la qualité ou la pertinence des passages récupérés ou la sortie générée.

- Attribution de source limitée: Citation ou indication insuffisante de la prise en charge de la source pour le texte généré.

Présentation de l'auto-rag: récupération adaptative et auto-réflexion

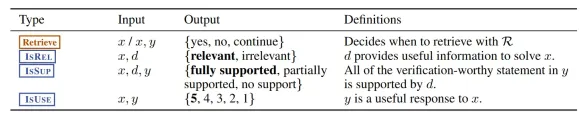

L'auto-RAG améliore les LLM en intégrant la récupération adaptative et l'auto-réflexion. Contrairement à RAG standard, il récupère dynamiquement les passages uniquement lorsque cela est nécessaire, en utilisant un «jeton de récupération». Surtout, il utilise des jetons de réflexion spéciaux - ISREL (pertinence), ISSUP (soutien) et ISUse (utilitaire) - pour évaluer son propre processus de génération.

Les caractéristiques clés de l'auto-Rag incluent:

- Retrie à la demande: Récupération efficace uniquement en cas de besoin.

- Tokens de réflexion: Auto-évaluation en utilisant des jetons Isrel, ISSUp et ISUSE.

- autocritique: Évaluation de la pertinence et de la qualité de sortie du passage récupéré.

- Formation de bout en bout: Formation simultanée de la génération de sortie et de la prédiction des jetons de réflexion.

- Décodage personnalisable: Ajustement flexible de la fréquence de récupération et de l'adaptation à différentes tâches.

Le flux de travail auto-rag

- Traitement des entrées et décision de récupération: Le modèle détermine si des connaissances externes sont requises.

- Récupération des passages pertinents: Si nécessaire, les passages pertinents sont récupérés à l'aide d'un modèle Retriever (par exemple, Contriever-MS Marco).

- Traitement parallèle et génération de segments: Le modèle du générateur traite chaque passage récupéré, créant plusieurs candidats de continuation avec des jetons de critique associés.

- autocritique et évaluation: Les jetons de réflexion évaluent la pertinence (isrel), le support (ISSUP) et l'utilité (ISUSE) de chaque segment généré.

- Sélection du meilleur segment et sortie: Une recherche de faisceau au niveau du segment sélectionne la meilleure séquence de sortie basée sur un score pondéré incorporant des probabilités de jeton de critique.

- Processus de formation: Un processus de formation en deux étapes consiste à former un modèle de critique hors ligne pour générer des jetons de réflexion, suivis par la formation du modèle de générateur en utilisant des données augmentées avec ces jetons.

Avantages de l'auto-rag

Self-Rag offre plusieurs avantages clés:

- Amélioration de la précision factuelle: La récupération à la demande et l'autocritique conduisent à une précision factuelle plus élevée.

- Pertinence améliorée: La récupération adaptative garantit que seules les informations pertinentes sont utilisées.

- meilleure citation et vérifiabilité: Les citations et évaluations détaillées améliorent la transparence et la fiabilité.

- Comportement personnalisable: Les jetons de réflexion permettent des ajustements spécifiques à la tâche.

- Inférence efficace: La formation du modèle de critique hors ligne réduit les frais généraux d'inférence.

Implémentation avec Langchain et Langgraph

L'article détaille une implémentation pratique à l'aide de Langchain et Langgraph, couvrant la configuration de la dépendance, la définition du modèle de données, le traitement des documents, la configuration de l'évaluateur, la configuration de la chaîne de chiffon, les fonctions de flux de travail, la construction du flux de travail et les tests. Le code montre comment construire un système d'auto-rag capable de gérer diverses requêtes et d'évaluer la pertinence et la précision de ses réponses.

Limites de l'auto-rag

Malgré ses avantages, l'auto-rag a des limites:

- non entièrement pris en charge Sorties: Les sorties peuvent ne pas toujours être entièrement appuyées par les preuves citées.

- potentiel d'erreurs factuelles: Bien que améliorées, des erreurs factuelles peuvent encore se produire.

- Complotions de taille de modèle: Les modèles plus petits peuvent parfois surpasser ceux plus grands en précision factuelle.

- Complotions de personnalisation: Ajuster les poids de jeton de réflexion peut avoir un impact sur d'autres aspects de la sortie (par exemple, la fluidité).

Conclusion

L'auto-RAG représente une progression significative dans la technologie LLM. En combinant la récupération adaptative avec l'auto-réflexion, il traite des limites clés du chiffon standard, ce qui entraîne des sorties plus précises, pertinentes et vérifiables. La nature personnalisable du cadre permet d'adapter son comportement à diverses applications, ce qui en fait un outil puissant pour diverses tâches nécessitant une précision factuelle élevée. La mise en œuvre de Langchain et Langgraph fournie offre un guide pratique pour construire et déployer des systèmes d'auto-ragravage.

Questions fréquemment posées (FAQ) (La section FAQ du texte d'origine est conservée ici.)

Q1. Qu'est-ce que l'auto-Rag? A. Auto-Rag (génération auto-réflexive-récupération-auvue) est un cadre qui améliore les performances de la LLM en combinant la récupération à la demande avec l'auto-réflexion pour améliorer la précision et la pertinence factuelles.

Q2. En quoi l'auto-RAG diffère-t-il du chiffon standard? A. Contrairement à un chiffon standard, l'auto-RAG récupère les passages uniquement en cas de besoin, utilise des jetons de réflexion pour critiquer ses sorties et adapte son comportement en fonction des exigences de la tâche.

Q3. Que sont les jetons de réflexion? A. Les jetons de réflexion (Isrel, ISSUP, ISUSE) évaluent la pertinence de récupération, la prise en charge du texte généré et de l'utilité globale, permettant l'auto-évaluation et de meilleures sorties.

Q4. Quels sont les principaux avantages de l'auto-rag? A. L'auto-RAG améliore la précision, réduit les erreurs factuelles, offre de meilleures citations et permet une personnalisation spécifique à la tâche pendant l'inférence.

Q5. L'auto-RAG peut-il éliminer complètement les inexactitudes factuelles? A. Non, tandis que l'auto-Rag réduit considérablement les inexactitudes, il est toujours sujet à des erreurs factuelles occasionnelles comme n'importe quel llm.

(Remarque: l'image reste dans son format et son emplacement d'origine.)

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Les thérapeutes de l'IA sont là: 14 outils révolutionnaires de santé mentale que vous devez savoirApr 30, 2025 am 11:17 AM

Les thérapeutes de l'IA sont là: 14 outils révolutionnaires de santé mentale que vous devez savoirApr 30, 2025 am 11:17 AMBien qu'il ne puisse pas fournir la connexion humaine et l'intuition d'un thérapeute formé, la recherche a montré que de nombreuses personnes sont à l'aise de partager leurs inquiétudes et leurs préoccupations avec des robots d'IA relativement sans visage et anonymes. Que ce soit toujours un bon I

Appeler l'IA dans l'allée de l'épicerieApr 30, 2025 am 11:16 AM

Appeler l'IA dans l'allée de l'épicerieApr 30, 2025 am 11:16 AML'intelligence artificielle (IA), une technologie des décennies en cours, révolutionne l'industrie de la vente au détail alimentaire. Des gains d'efficacité à grande échelle et des réductions de coûts aux processus rationalisés à travers diverses fonctions commerciales, l'impact de l'IA est indéniable

Obtenir des pourparlers d'encouragement de l'IA génératrice pour soulever votre espritApr 30, 2025 am 11:15 AM

Obtenir des pourparlers d'encouragement de l'IA génératrice pour soulever votre espritApr 30, 2025 am 11:15 AMParlons-en. Cette analyse d'une percée d'IA innovante fait partie de ma couverture de colonne Forbes en cours sur les dernières personnes en IA, notamment l'identification et l'explication de diverses complexités d'IA percutantes (voir le lien ici). De plus, pour ma comp

Pourquoi l'hyper-personnalisation alimentée par IA est un must pour toutes les entreprisesApr 30, 2025 am 11:14 AM

Pourquoi l'hyper-personnalisation alimentée par IA est un must pour toutes les entreprisesApr 30, 2025 am 11:14 AMLe maintien d'une image professionnelle nécessite des mises à jour occasionnelles de garde-robe. Bien que les achats en ligne soient pratiques, il n'a pas la certitude des essais en personne. Ma solution? Personnalisation alimentée par AI. J'imagine un assistant d'assistant de conservation des vêtements sélectionnés

Oubliez Duolingo: la nouvelle fonctionnalité d'IA de Google Translate enseigne les languesApr 30, 2025 am 11:13 AM

Oubliez Duolingo: la nouvelle fonctionnalité d'IA de Google Translate enseigne les languesApr 30, 2025 am 11:13 AMGoogle Translate ajoute une fonction d'apprentissage des langues Selon Android Authority, l'application Expert Assembedebug a constaté que la dernière version de l'application Google Translate contient un nouveau mode de test "Practice" conçu pour aider les utilisateurs à améliorer leurs compétences linguistiques grâce à des activités personnalisées. Cette fonctionnalité est actuellement invisible pour les utilisateurs, mais Assembedebug est en mesure de l'activer partiellement et de visualiser certains de ses nouveaux éléments d'interface utilisateur. Lorsqu'il est activé, la fonction ajoute une nouvelle icône de capuchon de graduation en bas de l'écran marqué d'un badge "bêta" indiquant que la fonction "Practice" sera publiée initialement sous forme expérimentale. L'invite contextuelle connexe montre "Pratiquez les activités adaptées à vous!", Ce qui signifie que Google générera des

Ils fabriquent TCP / IP pour l'IA, et ça s'appelle NandaApr 30, 2025 am 11:12 AM

Ils fabriquent TCP / IP pour l'IA, et ça s'appelle NandaApr 30, 2025 am 11:12 AMLes chercheurs du MIT développent Nanda, un protocole Web révolutionnaire conçu pour les agents de l'IA. Abréviation des agents en réseau et de l'IA décentralisée, Nanda s'appuie sur le protocole de contexte du modèle d'Anthropic (MCP) en ajoutant des capacités Internet, permettant à l'IA Agen

L'invite: Deepfake Detection est une entreprise en plein essorApr 30, 2025 am 11:11 AM

L'invite: Deepfake Detection est une entreprise en plein essorApr 30, 2025 am 11:11 AMLa dernière aventure de Meta: une application AI pour rivaliser avec un chatpt rival Meta, la société mère de Facebook, Instagram, WhatsApp et Threads, lance une nouvelle application alimentée par AI. Cette application autonome, Meta AI, vise à rivaliser directement avec le chatppt d'Openai. Levier

Les deux prochaines années dans la cybersécurité de l'IA pour les chefs d'entrepriseApr 30, 2025 am 11:10 AM

Les deux prochaines années dans la cybersécurité de l'IA pour les chefs d'entrepriseApr 30, 2025 am 11:10 AMNaviguer dans la marée montante des cyberattaques d'IA Récemment, Jason Clinton, CISO pour anthropique, a souligné les risques émergents liés aux identités non humaines - à mesure que la communication de la machine à la machine prolifère, sauvegarde ces "identités"

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

SublimeText3 version anglaise

Recommandé : version Win, prend en charge les invites de code !

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Listes Sec

SecLists est le compagnon ultime du testeur de sécurité. Il s'agit d'une collection de différents types de listes fréquemment utilisées lors des évaluations de sécurité, le tout en un seul endroit. SecLists contribue à rendre les tests de sécurité plus efficaces et productifs en fournissant facilement toutes les listes dont un testeur de sécurité pourrait avoir besoin. Les types de listes incluent les noms d'utilisateur, les mots de passe, les URL, les charges utiles floues, les modèles de données sensibles, les shells Web, etc. Le testeur peut simplement extraire ce référentiel sur une nouvelle machine de test et il aura accès à tous les types de listes dont il a besoin.

Adaptateur de serveur SAP NetWeaver pour Eclipse

Intégrez Eclipse au serveur d'applications SAP NetWeaver.