La rubrique AIxiv est une rubrique où ce site publie du contenu académique et technique. Au cours des dernières années, la rubrique AIxiv de ce site a reçu plus de 2 000 rapports, couvrant les meilleurs laboratoires des principales universités et entreprises du monde entier, favorisant efficacement les échanges et la diffusion académiques. Si vous souhaitez partager un excellent travail, n'hésitez pas à contribuer ou à nous contacter pour un rapport. Courriel de soumission : liyazhou@jiqizhixin.com ; zhaoyunfeng@jiqizhixin.com

Les co-auteurs de cet article sont le Dr Li Jing, Sun Zhijie et le Dr Lin Dachao. Les principaux membres sont du GTS AI Computing Lab. Les principaux domaines de recherche et de mise en œuvre comprennent la formation et la promotion LLM, l’assurance de la formation en IA et le calcul graphique.

Le MoE a brillé dans le domaine des grands modèles linguistiques au cours des deux dernières années en raison de son faible coût et de sa grande efficacité dans le processus de formation et de promotion. En tant qu'âme du MoE, il existe d'innombrables recherches et discussions sur la manière dont les experts peuvent maximiser leur potentiel d'apprentissage. Auparavant, l'équipe de recherche du Huawei GTS AI Computing Lab avait proposé LocMoE, comprenant une nouvelle structure de réseau de routage, une perte locale pour aider à réduire les frais généraux de communication, etc., qui ont attiré une large attention. La conception ci-dessus de LocMoE atténue efficacement les goulots d'étranglement de certaines structures classiques du MoE dans la formation, telles que : les algorithmes de routage experts peuvent ne pas être en mesure de distinguer efficacement les jetons, et l'efficacité de la synchronisation des communications est limitée par la différence de bande passante de transmission au sein et entre les nœuds, etc. De plus, LocMoE prouve et résout la limite inférieure de la capacité experte capable de traiter avec succès les jetons discriminants. Cette limite inférieure est dérivée de la distribution de probabilité des jetons discriminants existant dans des lots de jetons dans un scénario dans lequel les jetons sont distribués passivement aux experts. Ensuite, si les experts ont également la possibilité de sélectionner les jetons optimaux, la probabilité que des jetons discriminants soient traités sera considérablement augmentée et la limite inférieure de la capacité des experts sera encore plus comprimée. Sur la base des idées ci-dessus, l'équipe a en outre proposé une architecture MoE basée sur un routage actif à faible surcharge, en la nommant LocMoE+. LocMoE+ hérite des avantages des experts à haute discrimination et de la communication locale de LocMoE, transforme davantage la stratégie de routage, définit l'indice d'affinité entre les jetons et les experts, et commence avec cet index pour compléter plus efficacement la distribution des jetons, améliorant ainsi l'efficacité de la formation. L'idée principale du document est combiner Routage passif traditionnel avec des experts Le routage actif améliore la probabilité de traiter des jetons discriminants sous une certaine capacité, réduisant ainsi le bruit d'échantillonnage et améliorant l'efficacité de la formation. Cet article part de la relation entre un jeton et ses experts assignés, et quantifie et définit l'affinité entre les experts et les jetons dans un schéma à faible surcharge de calcul. En conséquence, cet article met en œuvre une stratégie globale de routage adaptatif et réorganise et sélectionne les jetons dans la dimension experte en fonction des scores d'affinité. Dans le même temps, il est prouvé que la limite inférieure de la capacité des experts diminue progressivement à mesure que la répartition des fonctionnalités des jetons se stabilise, et que les frais généraux de formation peuvent être réduits.

Cet article est le premier à combiner deux mécanismes de routage. Basé sur la découverte que les jetons ont tendance à être acheminés vers des experts avec des angles plus petits dans la stratégie de routage d'apprentissage, il brise l'obstacle de la surcharge excessive des solutions de routage actif existantes affectant. l'efficacité de la formation. Et rester cohérent avec la nature du routage passif.

Il convient de mentionner que l'auteur a choisi un environnement matériel complètement différent (modèle de serveur, modèle de carte NPU, schéma de mise en réseau de cluster), un cadre de formation et un modèle de base de LocMoE pour prouver la haute efficacité de cette série de travaux. et facilité de portabilité. Mécanisme adaptatif de répartition des itinéraires bidirectionnels routeur, mettez directement tout le jeton les fonctionnalités sont attribuées ;

(2) routeur logiciel, qui attribue une combinaison pondérée de fonctionnalités de jeton. Cet article continue de considérer (1) en raison de son coût de calcul inférieur. Pour le scénario du routeur dur, il peut être divisé en 1) Routeur de choix de jetons (TCR), qui permet à chaque jeton de sélectionner les experts les plus importants ; 2) Routeur de choix expert (ECR), qui permet à chaque expert de sélectionner le top -C approprié ; jeton. En raison des limitations de capacité, le nombre de jetons reçus par chaque expert a une limite supérieure C, donc dans le scénario 1), les jetons reçus par chaque expert seront tronqués :

Des travaux antérieurs ont souligné que la formation du MoE est divisée en deux étapes : Phase 1. La formation au routage garantit que le routage peut raisonnablement attribuer des jetons, c'est-à-dire que les jetons dans différents domaines ou avec de grandes différences peuvent être distingués et attribués à différents experts. Grâce au routage des jetons Le rôle de chaque expert est de recevoir des jetons dans le même domaine ou avec des propriétés similaires. Chaque expert peut acquérir des connaissances dans des domaines et propriétés connexes après avoir suivi certaines formations. En résumé, la clé du « succès » de chaque étape de la formation du MoE réside dans l’exactitude et la rationalité de la distribution des jetons. Contributions de cet article (1) Grâce à la déduction de la fonction d'activation softmax, la similarité cosinus entre les experts et les jetons peut mesurer plus précisément l'affinité :

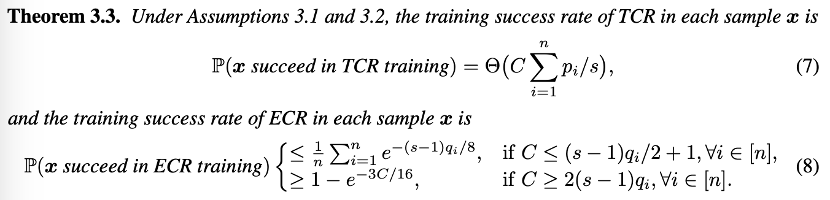

(2) Du point de vue de modélisation théorique, le taux de réussite de la formation unique du TCR et de l'ECR est analysé dans deux scénarios courants : Sur la base de la théorie, l'auteur a souligné que

- Au début de la formation du modèle, lorsque le la capacité du jeton de routage est insuffisante. Chaque fois que TCR est formé, il a une probabilité de réussite de la formation plus élevée que l'ECR et nécessite une plus grande capacité d'experts pour garantir que le jeton approprié est sélectionné.

- Dans la phase ultérieure de la formation du modèle, lorsque le routeur a une certaine capacité à allouer correctement les jetons, chaque fois qu'ECR est formé, il a une probabilité de réussite plus élevée que TCR. À ce stade, seule une capacité plus petite est. nécessaire pour sélectionner le jeton approprié.

Cette théorie est également très intuitive. Lorsque le routeur n'a pas de capacité de répartition, il est préférable de laisser le jeton sélectionner les experts au hasard. Lorsque le routeur a une certaine capacité de répartition, c'est-à-dire lorsque l'expert peut sélectionner le. jeton approprié, il est plus approprié d’utiliser ECR . Par conséquent, l’auteur recommande la transition du TCR vers l’ECR et propose une stratégie de commutation de routage adaptative au niveau mondial. Dans le même temps, sur la base de l’estimation de la demande de capacité d’expert, une capacité d’expert plus petite est utilisée dans les étapes ultérieures de la formation. Les expériences de cet article ont été menées sur le cluster auto-construit de NPU Ascend 910B3, grâce au système informatique haute performance (HCCS) exclusif de Huawei. la communication de données entre appareils est réalisée dans des scénarios multi-cartes, et la bibliothèque de communication collective Huawei (HCCL) conçue spécifiquement pour les processeurs Ascend permet une formation distribuée hautes performances sur des liaisons à haut débit telles que HCCS. L'expérience utilise le framework PyTorch pour Ascend compatible avec Ascend NPU et la bibliothèque d'accélération AscendSpeed et le framework de formation ModelLink spécialement personnalisé pour les appareils Ascend, en se concentrant sur la stratégie parallèle LLM et l'optimisation du masquage des communications. Efficacité de la formationLes résultats expérimentaux montrent que sans affecter la convergence ou l'efficacité de la formation du modèle, le nombre de jetons que chaque expert doit traiter peut être réduit de plus de 60 % par rapport à la ligne de base. Combinée à l'optimisation de la communication, l'efficacité de la formation est améliorée en moyenne de 5,4 % à 46,6 % pour des tailles de cluster de 32 cartes, 64 cartes et 256 cartes.

Utilisation de la mémoire vidéoLocMoE+ présente également un certain gain dans l'utilisation de la mémoire vidéo, en particulier dans les scénarios où la taille du cluster est petite et le calcul est intensif. En utilisant l'outil Ascend Insight pour analyser les échantillons de surveillance de la mémoire, on peut constater que l'utilisation de la mémoire LocMoE+ a chuté de 4,57 % à 16,27 % par rapport à la ligne de base, et de 2,86 % à 10,5 % par rapport à LocMoE. À mesure que la taille du cluster augmente, l’écart d’utilisation de la mémoire diminue.

Évaluation de l'efficacitéLes ensembles d'évaluation open source C-Eval et TeleQnA, ainsi que l'ensemble d'évaluation du domaine TIC construit indépendamment GDAD, ont été utilisés pour évaluer les capacités de LocMoE+ en matière de connaissances générales et de connaissances du domaine. Parmi eux, GDAD couvre un total de 47 sous-éléments, dont 18 060 échantillons, pour examiner les performances du modèle dans les trois principaux systèmes d'évaluation des tâches du domaine, des examens de certification des compétences du domaine et des capacités générales. Après suffisamment de SFT, LocMoE+ s'est amélioré en moyenne d'environ 20,1 % par rapport à la référence dans 16 sous-capacités des capacités de tâches de domaine, et s'est amélioré d'environ 3,5 % par rapport à LocMoE. Les examens de certification des compétences dans le domaine ont augmenté respectivement de 16 % et 4,8 %. Parmi les 18 sous-capacités des capacités générales, LocMoE+ s'est amélioré d'environ 13,9 % et 4,8 % respectivement. Dans l'ensemble, LocMoE+ affiche des améliorations de performances de 9,7 % à 14,1 % respectivement sur GDAD, C-Eval et TeleQnA.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Déclaration:Le contenu de cet article est volontairement contribué par les internautes et les droits d'auteur appartiennent à l'auteur original. Ce site n'assume aucune responsabilité légale correspondante. Si vous trouvez un contenu suspecté de plagiat ou de contrefaçon, veuillez contacter admin@php.cn