Maison >Périphériques technologiques >IA >L'équipe de Jia Jiaya s'est associée à l'Université Cambridge Tsinghua et à d'autres pour promouvoir un nouveau paradigme d'évaluation permettant de détecter « des scores élevés et une faible énergie » dans de grands modèles en une seconde

L'équipe de Jia Jiaya s'est associée à l'Université Cambridge Tsinghua et à d'autres pour promouvoir un nouveau paradigme d'évaluation permettant de détecter « des scores élevés et une faible énergie » dans de grands modèles en une seconde

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBoriginal

- 2024-07-19 13:55:25556parcourir

MR-Ben a soigneusement évalué de nombreux modèles open source et fermés de première ligne nationaux et étrangers, tels que GPT4-Turbo, Cluade3.5-Sonnet, Mistral-Large, Zhipu-GLM4, Moonshot-v1, Yi-Large, Qwen2. -70B , Deepseek-V2, etc., et effectué une analyse détaillée.

Quels grands modèles apparemment beaux seront « supprimés » et quel modèle a la surface la plus solide ? À l’heure actuelle, tout le code et les données de ce travail sont open source, jetons-y un œil !

Page du projet : https://randolph-zeng.github.io/Mr-Ben.github.io/

Page Arxiv : https://arxiv.org/abs/2406.13975

Repo Github : https://github.com /dvlab-research/Mr-Ben

MR-Ben brise le « score élevé et la faible énergie » des grands modèles en quelques secondes

Après que le domaine de l'intelligence artificielle soit entré dans le moment GPT, le monde universitaire et l'industrie ont travaillé ensemble et de nouveaux modèles ont été publiés chaque mois ou même chaque semaine.

Les grands modèles émergent à l'infini. Quelles normes sont utilisées pour mesurer les capacités spécifiques des grands modèles ? L'orientation dominante actuelle consiste à utiliser des tests humains standardisés - des questions à choix multiples et des questions à remplir pour mener des évaluations de grands modèles. L'utilisation de cette méthode de test présente de nombreux avantages, qui peuvent être divisés en termes simples selon les points suivants :

• Les tests standardisés sont faciles à quantifier et à évaluer. Les normes sont claires, et ce qui est bien est bien et ce qui est mal est mal. .

• Les indicateurs sont intuitifs et il est facile de comparer et de comprendre les scores obtenus à l'examen d'entrée à l'université national ou à l'examen d'entrée à l'université américain SAT.

• Les résultats quantitatifs sont naturellement d'actualité (par exemple, la capacité du GPT4 à réussir facilement l'examen de certification du barreau américain est extrêmement accrocheuse).

Mais si vous approfondissez la méthode de formation des grands modèles, vous constaterez que cette méthode de chaîne de réflexion étape par étape pour générer la réponse finale n'est pas « fiable ».

La question apparaît précisément dans le processus de réponse étape par étape !

Le modèle de pré-formation a déjà vu des milliards d'éléments de mots lors de la pré-formation. Il est difficile de dire si le modèle évalué a déjà vu les données correspondantes et peut répondre correctement aux questions en « mémorisant les questions ». Dans la réponse étape par étape, nous ne savons pas si le modèle sélectionne la bonne option sur la base d’une compréhension et d’un raisonnement corrects, car la méthode d’évaluation repose principalement sur la vérification de la réponse finale.

Bien que la communauté universitaire continue de mettre à niveau et de transformer les ensembles de données tels que GSM8K et MMLU, par exemple en introduisant une version multilingue de l'ensemble de données MGSM sur GSM8K et en introduisant des questions plus difficiles basées sur MMLU, il n'y a toujours aucun moyen de s'en débarrasser. du problème de la sélection ou du remplissage des blancs.

De plus, ces ensembles de données ont tous été confrontés à de sérieux problèmes de saturation. Les valeurs des grands modèles de langage sur ces indicateurs ont atteint des sommets et ils ont progressivement perdu leur distinction.

À cette fin, l'équipe de Jiajiaya s'est associée à de nombreuses universités renommées telles que le MIT, Tsinghua et Cambridge, et a coopéré avec des sociétés d'annotation nationales pour annoter un ensemble de données d'évaluation MR-Ben pour le processus de raisonnement de problèmes complexes.

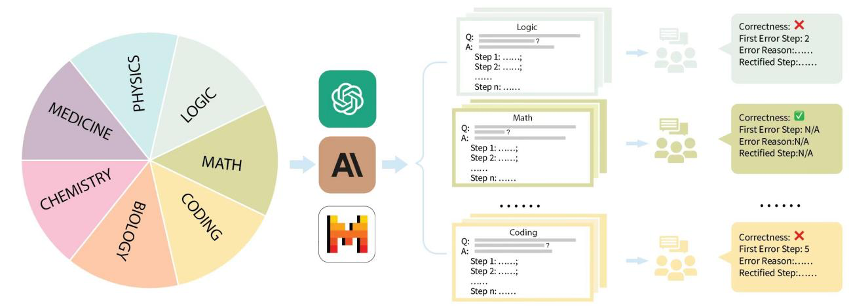

MR-Ben a effectué une transformation de paradigme de « notation » basée sur les questions des ensembles de données de pré-entraînement et de test de grands modèles tels que GSM8K, MMLU, LogiQA, MHPP et d'autres grands modèles. Les nouveaux ensembles de données générés sont plus nombreux. difficile, plus différencié et plus réaliste. Cela reflète la capacité de raisonnement du modèle !

Le travail de l'équipe de Jiajiaya a également apporté cette fois des améliorations ciblées pour résoudre les problèmes d'évaluation existants :

N'avez-vous pas peur que les fuites de données conduisent à une mémorisation de questions à grande échelle, entraînant des scores gonflés ? Il n'est pas nécessaire de retrouver les questions ou de déformer les questions pour tester la robustesse du modèle. MR-Ben change directement le modèle de l'identité de l'étudiant qui répond au mode « notation » du processus de réponse, permettant ainsi le grand. modèle pour être l'enseignant à tester Dans quelle mesure maîtrise-t-il les points de connaissance !

Ne craignez-vous pas que le modèle n'ait pas conscience du processus de résolution de problèmes, qu'il puisse avoir des « illusions » ou des malentendus et qu'il se trompe de réponse ? MR-Ben recrute directement un groupe d'annotateurs de master et de doctorat de haut niveau pour annoter soigneusement le processus de résolution de problèmes d'un grand nombre de questions. Indiquez en détail si le processus de résolution de problèmes est correct, l'emplacement de l'erreur et la raison de l'erreur, et comparez les résultats de notation du grand modèle et les résultats de notation des experts humains pour tester les connaissances du modèle. points.

Plus précisément, l'équipe Jiajiaya a organisé les principaux ensembles de données d'évaluation du marché tels que GSM8K, MMLU, LogiQA, MHPP et d'autres ensembles de données, et les a divisés en plusieurs catégories telles que les mathématiques, la physique, la chimie, la biologie, le code, la logique, la médecine. , etc., et distinguent également différents niveaux de difficulté. Pour chaque catégorie et chaque question collectée, l'équipe a soigneusement collecté le processus de résolution de problème étape par étape correspondant, et a été formée et annotée par des annotateurs professionnels de maîtrise et de doctorat.

Als nächstes kombinieren wir die spezifischen Beispiele aus MR-Bens Arbeit, um zu sehen, warum die schrittweise Methode zur Generierung endgültiger Antworten und zugehöriger Bewertungen unzuverlässig ist.

Als bewertetes „Bewertungs“-Modell hat GPT4-Turbo die im zweiten Schritt versteckten Berechnungsfehler nicht gefunden:

E.1 Mathematik

Fachgebiet: Oberstufenmathematik

Frage: Welche kleinste ganze Zahl wird durch 4 geteilt? Rest 1, Rest 2 bei Division durch 3, Rest 2 bei Division durch 5?

Optionen: [A] 67 [B] 43 [C] 57 [D] 37

Antwort: D

Stichprobenmodell: Claude2

Modelllösungsschritte:

- Schritt 1: Aktivieren Sie Option A (67), wenn Wenn 67 durch 4 geteilt wird, ist der Rest 3 und nicht 1. 67 ist also nicht die richtige Antwort.

- Schritt 2: Aktivieren Sie Option B (43). Wenn 43 durch 4 geteilt wird, ist der Rest 1. Wenn 43 durch 3 geteilt wird, ist der Rest 3 und nicht 2. 43 ist also nicht die richtige Antwort.

- Schritt 3: Aktivieren Sie Option C (57). Wenn 57 durch 4 geteilt wird, ist der Rest 1. Wenn 57 durch 3 geteilt wird, ist der Rest 0 und nicht 2. 57 ist also nicht die richtige Antwort.

- Schritt 4: Aktivieren Sie Option D (37). Wenn 37 durch 4 geteilt wird, ist der Rest 1. Wenn 37 durch 3 geteilt wird, ist der Rest 1. Wenn 37 durch 5 geteilt wird, ist der Rest 2.

-

Schritt 5: Option D (37) erfüllt alle Bedingungen und ist die richtige Antwort.

Antwort: Option D

Menschliche Annotation

Korrektheit der Modellantwort: Falsch

Erster falscher Schritt: Schritt 2

Fehlergrund der Modellantwort:

In Schritt 2 hat das Modell fälschlicherweise berechnet, dass der Rest von 43 dividiert durch 4 stattdessen 1 ist von 3. Das Modell geht davon aus, dass bei Division von 43 durch 4 der Rest 1 ist, der Rest jedoch 3 sein sollte. Hier liegt ein Rechenfehler vor.Der erste richtige Schritt nach der Korrektur: Schritt 2

Wenn 43 durch 4 geteilt wird, ist der Rest 1. Wenn 43 durch 3 geteilt wird, ist der Rest 1. Wenn 43 durch 5 geteilt wird, ist der Rest 3 und nicht 2. Daher ist 43 nicht die richtige Antwort.

Bewertungsmodell: gpt-4-turbo

Modellantwort:

-Schritt 1: Überprüfen Sie den Rest von 67 dividiert durch 4 und 3 und stellen Sie fest, dass er die Bedingung erfüllt, dass er durch 4 geteilt wird und 3 bleibt eine korrekte Verifizierung.

-Schritt 2: Überprüfen Sie die Reste der Division von 43 durch 4, 3 und 5 und stellen Sie fest, dass die Reste von 1, 3 und 5 den Erwartungen korrekt entsprechen, mit der Ausnahme, dass der Rest von 5 die Bedingungen nicht erfüllt.

-Schritt 3: Schritt Berechnen Sie den Rest der Division von 57 durch 4 und 3, der Rest ist 1 bzw. 0. Wenn 57 durch 3 dividiert wird, erfüllt der Rest nicht die Kriterien.

-Schritt 4: Überprüfen und verifizieren Sie die Reste der Division von 37 durch 4, 3 und 5. Es wird festgestellt, dass alle erwarteten Reste korrekt sind und 37 alle Bedingungen in der Frage erfüllt.Ist der Lösungsprozess korrekt? Richtig

Der erste Fehlerschritt: Nicht zutreffend

Der Grund für den ersten Fehlerschritt: Nicht zutreffend

Das ist ersichtlich, wenn die Frage gestellt und der Lösungsprozess festgelegt wird , die Bewertung Die Methode des Sprachmodells wird dahingehend umgewandelt, dass das Modell den Antwortprozess „markieren“ kann, beurteilen kann, ob er richtig oder falsch ist, und den Ort und die Ursache des Fehlers angeben kann. Die Genauigkeit des Lösungsprozesses und die potenziellen Fehlerorte können durch Vergleich mit den Annotationsergebnissen berechnet werden. Die Bewertung der Modellfehlerschritte und -gründe kann an GPT4 übergeben werden, um durch Vergleich der vom Annotator gegebenen Erklärung der Fehlergründe und der Erklärung der Fehlergründe des Modells festzustellen, ob das Modell korrekt ist.

Von der Bewertungsmethode erfordert die von MR-Ben vorgeschlagene Methode, dass das Modell eine detaillierte Analyse der Prämissen, Annahmen und Logik jedes Schritts im Problemlösungsprozess durchführt und eine Vorschau des Argumentationsprozesses durchführt, um festzustellen, ob die Der aktuelle Schritt kann in die richtige Richtung führen. fenye1. Diese „Bewertungs“-Bewertungsmethode ist weitaus schwieriger als die Bewertungsmethode, bei der nur Fragen beantwortet werden, kann jedoch das Problem falsch hoher Punktzahlen, die durch das Auswendiglernen von Fragen durch das Modell verursacht werden, wirksam vermeiden. Für einen Schüler, der sich nur Fragen merken kann, ist es schwierig, ein qualifizierter Korrekturlehrer zu werden.

- Zweitens hat MR-Ben durch den Einsatz manueller und präziser Annotationsprozesssteuerung eine große Anzahl hochwertiger Annotationen erreicht, und das clevere Prozessdesign ermöglicht eine intuitive Quantifizierung der Bewertungsmethode.

- Das Jiajiaya-Team hat außerdem die zehn repräsentativsten Sprachmodelle und verschiedene Versionen getestet. Es ist ersichtlich, dass GPT4-Turbo unter den großen Closed-Source-Sprachmodellen die beste Leistung aufweist (obwohl bei der „Bewertung“ keine Berechnungsfehler festgestellt wurden). In den meisten Fächern gibt es Demos (k = 1) und keine Demos. (k=0) sind anderen Modellen voraus.

**Bewertungsergebnisse einiger großer Open-Source-Sprachmodelle im MR-Ben-Datensatz

Es ist ersichtlich, dass die Auswirkungen einiger der stärksten großen Open-Source-Sprachmodelle einige kommerzielle Modelle und sogar die stärksten Closed-Source-Modelle eingeholt haben Modelle befinden sich in MR-Ben. Die Leistung des Ben-Datensatzes ist immer noch nicht gesättigt und der Unterschied zwischen verschiedenen Modellen ist groß.

Darüber hinaus gibt es in MR-Bens Originalarbeit weitere interessante Analysen und Erkenntnisse, wie zum Beispiel:

Die von Qwen und Deepseek veröffentlichten Open-Source-Modelle stehen dem PK-Closed-Source-Modell auch im globalen Maßstab nicht nach.

Die Preisstrategien und die tatsächliche Leistung verschiedener Closed-Source-Modelle sind faszinierend. Freunde, denen die Argumentationsfähigkeit in Nutzungsszenarien am Herzen liegt, können anhand des Preises und der Funktionen ihr Lieblingsmodell finden.

In ressourcenarmen Szenarien haben auch kleine Modelle viele Highlights. In der MR-Ben-Bewertung stach Phi-3-mini unter den kleinen Modellen hervor, sogar höher oder gleich groß wie große Modelle mit zig Milliarden Parametern die Fähigkeit zur Feinabstimmung der Datenbedeutung.

MR-Ben-Szenen enthalten komplexe logische Analysen und schrittweise Schlussfolgerungen. Ein zu langer Kontext im Few-Shot-Modus führt zu Verwirrung im Modell und zu Leistungseinbußen.

MR-Ben hat viele Generation-Reflexions-Regeneration-Ablationsexperimente ausgewertet, um die Unterschiede zwischen verschiedenen Aufforderungsstrategien zu überprüfen, und festgestellt, dass es keine Auswirkung auf Low-Level-Modelle hat und die Auswirkung auf High-Level-Modelle wie GPT4-Turbo nicht offensichtlich. Im Gegenteil, bei Modellen mittlerer Ebene ist der Effekt leicht verbessert, da immer die falschen korrigiert werden und die richtigen korrigiert werden.

Nach einer groben Einteilung der von MR-Ben bewerteten Themen in wissensbasierte, logische, rechnerische und algorithmische Typen haben verschiedene Modelle ihre eigenen Vor- und Nachteile in verschiedenen Argumentationstypen.

Das Jiajiaya-Team hat eine Ein-Klick-Bewertungsmethode auf Github hochgeladen. Alle Partner, die sich Gedanken über komplexe Argumente machen, sind herzlich eingeladen, ihre eigenen Modelle zu bewerten und einzureichen. Das Team wird die entsprechende Bestenliste zeitnah aktualisieren.

Übrigens kostet die Ein-Klick-Auswertung mit dem offiziellen Skript nur etwa 12 Millionen Token. Der Prozess ist sehr reibungslos, also probieren Sie es aus!

Referenz

Training von Prüfern zur Lösung mathematischer Wortprobleme (https://arxiv.org/abs/2110.14168)

Messung des massiven Multitask-Sprachverständnisses (https://arxiv.org/abs/2009.03300)

LogiQA: Eine Herausforderung Datensatz für maschinelles Leseverständnis mit logischem Denken (https://arxiv.org/abs/2007.08124) Sparks of Artificial General Intelligence: Frühe Experimente mit GPT-4(https://arxiv.org/abs/2303.12712)

Qwen Technical Report(https://arxiv.org/abs/2309.16609)

DeepSeek-V2: Ein starkes, Ökonomisches und effizientes Mixture-of-Experts-Sprachmodell (https://arxiv.org/abs/2405.04434)

Lehrbücher sind alles, was Sie brauchen (https://arxiv.org/abs/2306.11644)

Große Sprachmodelle können sich nicht selbst Bisher die richtige Argumentation(https://arxiv.org/abs/2310.01798)

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI