Maison >Périphériques technologiques >IA >Tous les prix CVPR 2024 annoncés ! Près de 10 000 personnes ont assisté à la conférence hors ligne et un chercheur chinois de Google a remporté le prix du meilleur article.

Tous les prix CVPR 2024 annoncés ! Près de 10 000 personnes ont assisté à la conférence hors ligne et un chercheur chinois de Google a remporté le prix du meilleur article.

- 王林original

- 2024-06-20 17:43:032666parcourir

Tôt le matin du 20 juin, heure de Pékin, CVPR 2024, la plus grande conférence internationale sur la vision par ordinateur qui s'est tenue à Seattle, a officiellement annoncé le meilleur article et d'autres récompenses.

Au total, 10 articles ont remporté des prix cette année, dont 2 meilleurs articles, 2 meilleurs articles étudiants, en plus de 2 nominations pour les meilleurs articles et 4 nominations pour les meilleurs articles étudiants.

La principale conférence dans le domaine de la vision par ordinateur (CV) est la CVPR, qui attire chaque année un grand nombre d'instituts de recherche et d'universités. Selon les statistiques, un total de 11 532 articles ont été soumis cette année, dont 2 719 ont été acceptés, avec un taux d'acceptation de 23,6 %.

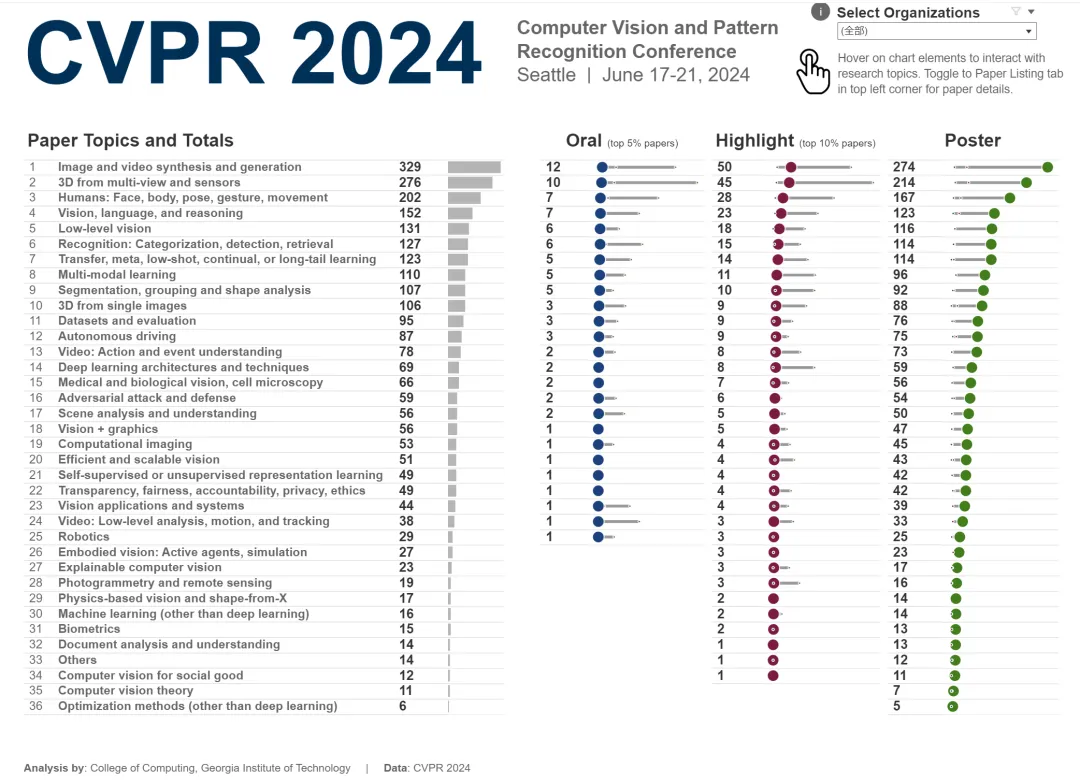

Selon l'analyse statistique des données CVPR 2024 du Georgia Institute of Technology, en termes de sujets de recherche, le plus grand nombre d'articles est le thème de la synthèse et de la génération d'images et de vidéos, avec un total de 329 articles.

Le nombre total de participants cette année est plus élevé que les années précédentes, et de plus en plus de personnes choisissent de participer hors ligne.

Meilleur article

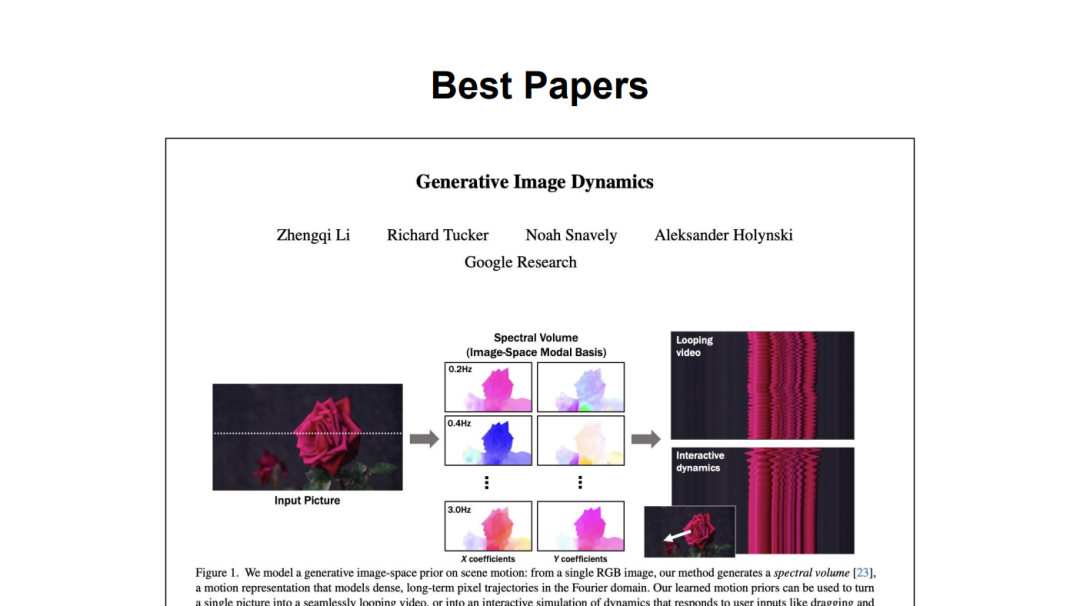

Article 1 : Dynamique des images génératives

Auteurs : Zhengqi Li, Richard Tucker, Noah Snavely, Aleksander Holynski

-

Institution : Google Research

Adresse papier : https://arxiv.org/pdf/2309.07906

Zhengqi Li est chercheur scientifique chez Google DeepMind. Auparavant, il a obtenu son doctorat en informatique à l'Université Cornell, où il a étudié auprès du professeur Noah Snavely. Ses recherches ont reçu plusieurs prix, dont la Google PhD Fellowship 2020, la Adobe Research Fellowship 2020, les CVPR 2019 et CVPR 2023 Best Paper Honors et le ICCV 2023 Best Student Paper Award.

Résumé : Cette étude propose une méthode préalable dans l'espace image pour modéliser le mouvement d'une scène. L'a priori est appris à partir d'une collection de trajectoires de mouvement extraites de séquences vidéo réelles, illustrant la dynamique d'oscillation naturelle d'objets tels que des arbres, des vêtements, etc. se balançant dans le vent. L’étude modélise le mouvement dense à long terme dans le domaine de Fourier sous la forme d’un volume spectral, que l’équipe a trouvé bien adapté à la prédiction avec des modèles de diffusion.

À partir d'une seule image, le modèle formé dans cette étude utilise un processus d'échantillonnage par diffusion coordonné en fréquence pour prédire le volume spectral, qui peut également être converti en une texture de mouvement qui s'étend sur l'intégralité de la vidéo.运动 Cette étude peut réduire (en haut) ou zoomer (en bas) le mouvement d'animation en ajustant l'amplitude de la texture de mouvement.

Article 2 : Commentaires humains riches pour la génération de texte en image

- Institution : Université of California, San Diego Branch campus, Google Research, University of Southern California, University of Cambridge, Brandeis University

- Adresse papier : https://arxiv.org/pdf/2312.10240

-

De l'auteur Dans la colonne du journal, on peut voir que de nombreux Chinois ont participé à cette recherche. Parmi eux, Youwei Liang est doctorant au Département de génie électrique et informatique de l'Université de Californie à San Diego. un étudiant de premier cycle en informatique et informatique à l'Université agricole de Chine du Sud ; Junfeng vient de Google. Il a précédemment obtenu une maîtrise de l'Université Tsinghua.

Résumé : Récemment, les modèles génératifs texte-image (T2I) ont fait des progrès significatifs, capables de générer des images haute résolution à partir de descriptions textuelles. Cependant, de nombreuses images générées souffrent encore d’artefacts, d’incohérences factuelles et d’une mauvaise esthétique.

Inspirée par l'utilisation réussie de l'apprentissage par renforcement avec feedback humain (RLHF) pour les grands modèles de langage, cette recherche enrichit le signal de feedback en :

marquage des zones d'image non fiables ou mal alignées avec du texte

paires Annoter les situations où ; les mots de l'invite de texte sont déformés ou manquants sur l'image.

Cette étude a créé l'ensemble de données d'images générées par 18K RichHF-18K, collecté de riches commentaires humains sur RichHF-18K et formé un transformateur multimodal pour prédire automatiquement les commentaires. L'étude démontre que les commentaires humains prédits peuvent être utilisés pour améliorer la génération d'images, par exemple en sélectionnant des données d'entraînement de haute qualité pour affiner et améliorer les modèles génératifs, ou en créant des masques pour réparer les zones d'image problématiques.

Meilleur article finaliste

Article 1 : EventPS : Stéréo photométrique en temps réel à l'aide d'une caméra d'événement

Auteurs : Bohan Yu, Jieji Ren, Jin Han, Feishi Wang, Jinxiu Liang , Boxin Shi

Institutions : Université de Pékin, Université Jiao Tong de Shanghai, etc.

Adresse papier : https://openaccess.thecvf.com/content/CVPR2024/papers/Yu_EventPS_Real-Time_Photometric_Stereo_Using_an_Event_Camera_CVPR_2024_paper. pdf

Article 2 : pixelSplat : Splats gaussiens 3D à partir de paires d'images pour une reconstruction 3D généralisable et évolutive

Auteurs : David Charatan, Sizhe Lester Li, Andrea Tagliasacchi, Vincent Sitzmann

-

Institution : MIT , Simon Fraser Université de Toronto

- Meilleur article d'étudiant

Article 1 : BioCLIP : Un modèle de fondation de vision pour l'arbre de vie

Auteurs : Samuel Stevens , Jiaman Wu , Matthew J Thompson , Elizabeth G Campolongo , Chan Hee Song , David Edward Carlyn , Li Dong , Wasila M Dahdul , Charles Stewart , Tanya Berger -Wolf, Wei-Lun Chao, Yu Su

- Institution : Ohio State University, Microsoft Research, Université de Californie, Irvine, Rensselaer Polytechnic Institute

- Adresse papier : https://arxiv.org/pdf/2311.18803

-

Abstrait

: Les images du monde naturel collectées par des caméras allant des drones aux téléphones portables personnels deviennent de plus en plus une riche source d'informations biologiques. On assiste à une explosion de méthodes et d’outils informatiques, en particulier la vision par ordinateur, pour extraire des informations biologiquement pertinentes à partir d’images scientifiques et de conservation. Cependant, la plupart d’entre elles sont des méthodes personnalisées conçues pour des tâches spécifiques et ne sont pas facilement adaptées ou étendues à de nouveaux problèmes, contextes et ensembles de données. Les chercheurs ont besoin de toute urgence d’un modèle visuel des problèmes biologiques généraux des organismes sur des images. - Pour atteindre cet objectif, la recherche a organisé et publié TREEOFLIFE-10M, l'ensemble de données d'images biologiques le plus vaste et le plus diversifié prêt pour le ML. Sur cette base, les chercheurs ont développé le modèle de base BIOCLIP, qui est principalement utilisé pour construire l'arbre de vie (arbre de vie), en utilisant les attributs uniques de la biologie capturés par TREEOFLIFE-10M, c'est-à-dire la richesse et la diversité des images de des plantes, des animaux et des champignons, ainsi qu'une richesse de connaissances biologiques structurées. Diagramme arborescent de 108 portes dans TREEOFLIFE-10M.

L'évaluation intrinsèque montre que BIOCLIP a appris une représentation hiérarchique cohérente avec l'Arbre de Vie, révélant sa forte généralité.

Article 2 : Mip-Splatting : Éclaboussures gaussiennes 3D sans alias

Auteurs de l'article : Zehao Yu, Anpei Chen, Binbin Huang, Torsten Sattler, Andreas Geiger

Institutions : Université de Tübingen, Centre d'intelligence artificielle de Tübingen, Université des sciences et technologies de Shanghai, Breitning, Université technique tchèque de Prague

Adresse papier : https://arxiv.org/abs/2311.16493

Résumé : Récemment, les techniques d'éclaboussures gaussiennes 3D ont démontré des résultats impressionnants dans la synthèse de nouvelles vues, atteignant des niveaux de fidélité et d'efficacité élevés. Cependant, lors de la modification du taux d'échantillonnage (par exemple en modifiant la distance focale ou la distance de la caméra), de forts artefacts peuvent apparaître.

Les éclaboussures gaussiennes 3D fonctionnent en représentant un objet 3D comme une fonction gaussienne 3D projetée sur le plan de l'image, suivie d'une dilatation 2D dans l'espace de l'écran, comme le montre la figure (a). Le biais de retrait inhérent à cette méthode amène la fonction gaussienne 3D dégénérée à dépasser la limite d'échantillonnage, comme le montre la fonction δ sur la figure (b), alors qu'elle rend un rendu similaire à la 2D en raison de l'opération de dilatation. Cependant, lors de la modification du taux d'échantillonnage (soit via la distance focale, soit via la distance de la caméra), de forts effets de dilatation (c) et des artefacts haute fréquence (d) sont observés.

L'équipe de recherche a découvert que la raison de ce phénomène peut être attribuée au manque de contraintes de fréquence 3D et à l'utilisation d'un filtre de dilatation 2D. Pour résoudre ce problème, ils ont introduit un filtre de lissage 3D qui contraint la taille des primitives gaussiennes 3D en fonction de la fréquence d'échantillonnage maximale induite par la vue d'entrée, éliminant ainsi les artefacts haute fréquence lors d'un zoom avant.

De plus, l'équipe d'auteurs a remplacé le filtre de dilatation 2D par un filtre Mip 2D, qui simule le filtre boîte 2D et atténue efficacement les problèmes d'alias et d'expansion. Les chercheurs ont vérifié l’efficacité de cette méthode sur la base d’évaluations, notamment de scénarios tels que la formation sur des images à une seule échelle et des tests à plusieurs échelles.

Finaliste du meilleur article d'étudiant

Article : SpiderMatch : correspondance de formes 3D avec optimalité globale et cohérence géométrique

Auteur : Paul Roetzer, Florian Bernard

-

Institution : Université de Bonn

Lien : https://openaccess.thecvf.com/content/CVPR2024/papers/Roetzer_SpiderMatch_3D_Shape_Matching_with_Global_Optimality_and_Geometric_Consistency_CVPR_2024_paper.pdf

Pa par : Traitement d'images GNN : Briser la rigidité en super-résolution

Auteur : Yuchuan Tian, Hanting Chen, Chao Xu, Yunhe Wang

Institution : Université de Pékin, Laboratoire Huawei Noah's Ark

Lien : https://openaccess.thecvf.com/content/CVPR2024/papers/Tian_Image_Processing_GNN_Breaking_Rigidity_in_Super-Resolution_CVPR_2024 _papier. pdf

Papier : Les objets en tant que volumes : Une vue géométrique stochastique des solides opaques

Auteurs : Bailey Miller, Hanyu Chen, Alice Lai, Ioannis Gkioulekas

-

Institution : Carnegie Mellon University

Lien : https://arxiv.org/pdf/2312.15406v2

Article : Comparaison des mécanismes de prise de décision par les transformateurs et les CNN via des méthodes d'explication

Auteur : Mingqi , Saeed Khorram et Li Fuxin _paper .pdf

Autres Prix

Prix Longuet-Higgins

Le prix Longuet-Higgins est le "Computer Vision Fundamental Contribution Award" décerné par le comité technique de l'IEEE Computer Society Pattern Analysis and Machine Intelligence (PAMI) lors du CVPR annuel, en reconnaissance des contributions à la vision par ordinateur il y a dix ans. Les articles du CVPR ont eu un impact significatif sur la recherche en vision par ordinateur. Le prix porte le nom du chimiste théoricien et scientifique cognitif H. Christopher Longuet-Higgins.L'article primé de cette année est "Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation".

Auteurs : Ross Girshick, Jeff Donahue, Trevor Darrell et Jitendra Malik

Institution : UC Berkeley

-

Lien papier : https://arxiv.org/abs/1311.2524

Prix du jeune chercheur

Les Prix du jeune chercheur visent à récompenser les jeunes scientifiques et à les encourager à continuer à réaliser des travaux révolutionnaires. Le critère de sélection est que le récipiendaire ait moins de 7 ans d'expérience en doctorat.

Les gagnants de cette année sont Angjoo Kanazawa (UC Berkeley) et Carl Vondrick (Columbia University).

Aussi, Katie Bouman (Caltech) a reçu une mention honorable pour le Prix du jeune chercheur.

Prix commémoratif Thomas Huang

Lors du CVPR 2020, à la mémoire du professeur Thomas S. Huang (Huang Xutao), le comité des prix PAMITC a approuvé la création du prix commémoratif Thomas S. Huang en reconnaissance de la recherche sur le CV , éducation et service Des chercheurs reconnus comme des modèles. Le prix sera décerné à partir de 2021. Les titulaires doivent être titulaires de leur doctorat depuis au moins 7 ans, de préférence en milieu de carrière (pas plus de 25 ans).

Le gagnant de cette année est Andrea Vedaldi, professeur à l’Université d’Oxford.

Pour plus d'informations, veuillez vous référer à : https://media.eventhosts.cc/Conferences/CVPR2024/OpeningRemarkSlides.pdf

Lien de référence :

https://public.tableau .com /views/CVPR2024/CVPRtrends?%3AshowVizHome=no&continueFlag=6a947f6367e90acd982f7ee49a495fe2

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Résumé des connaissances de base de PHP (nécessaire aux débutants pour débuter)

- Explication détaillée du didacticiel d'introduction ABP de la série ABP du cadre de développement de modèles ASP.NET

- Introduction au développement personnel des mini-programmes WeChat populaires en 2018 (avec code)

- Quels livres dois-je lire pour démarrer avec Java ?

- Tutoriel de base de PHP : du débutant au maître