Maison >Périphériques technologiques >IA >L'IA multimodale est l'avenir de la médecine. Google lance trois nouveaux modèles et Med-Gemini accueille une mise à niveau majeure.

L'IA multimodale est l'avenir de la médecine. Google lance trois nouveaux modèles et Med-Gemini accueille une mise à niveau majeure.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBoriginal

- 2024-05-30 10:13:191323parcourir

Edit | Feuilles de chou

De nombreuses tâches cliniques nécessitent la compréhension de données professionnelles, comme les images médicales, la génomique, etc. Ce type d'informations sur les connaissances professionnelles n'existe généralement pas dans la formation de grands modèles multimodaux généraux...

Dans la description de l'article précédent, Med-Gemini a dépassé la mise en œuvre du modèle de la série GPT-4 sur diverses tâches d'imagerie médicale. SOTA!

Ici, Google DeepMind a rédigé un deuxième article sur Med-Gemini.

Sur la base du modèle multimodal de Gemini, l'équipe a développé plusieurs modèles pour la série Med-Gemini. Ces modèles héritent des fonctionnalités de base de Gemini et sont optimisés pour un usage médical avec un réglage fin des données de radiologie 2D et 3D, d'histopathologie, d'ophtalmologie, de dermatologie et de génomique.

L'étude, intitulée « Advancing Multimodal Medical Capabilities of Gemini », a été publiée sur la plateforme de prépublication arXiv le 6 mai 2024.

Les sources de données médicales comprennent des données médicales provenant de différentes sources telles que les biobanques, les dossiers de santé électroniques, l'imagerie médicale, les appareils portables, les biocapteurs et le séquençage du génome. Ces données stimulent le développement de solutions d’IA multimodales pour mieux saisir la complexité de la santé et des maladies des populations.

L'IA en médecine s'est principalement concentrée sur des tâches étroites avec des types d'entrée et de sortie uniques, mais les progrès récents de l'IA générative sont prometteurs pour résoudre les défis multimodaux et multitâches dans les contextes médicaux.

L'IA générative multimodale, représentée par des modèles puissants tels que Gemini, a un grand potentiel pour révolutionner les soins de santé. Bien que la médecine soit une source de données permettant une itération rapide de ces nouveaux modèles, les modèles généraux fonctionnent souvent mal lorsqu’ils sont appliqués au domaine médical en raison de leurs données hautement spécialisées.

Basé sur les fonctions de base de Gemini, DeepMind a lancé trois nouveaux modèles de la série Med-Gemini, Med-Gemini-2D, Med-Gemini-3D et Med-Gemini-Polygenic.

Plus de 7 millions d'échantillons de données provenant de 3,7 millions d'images et de cas médicaux ont été utilisés pour entraîner le modèle. Divers ensembles de données de réponses visuelles aux questions et de sous-titres d’images sont utilisés, y compris certains ensembles de données privés provenant d’hôpitaux.

Pour traiter les données 3D (CT), l'encodeur vidéo Gemini est utilisé, où la dimension temporelle est traitée comme la dimension de profondeur. Pour traiter les données génomiques, les scores de risque pour divers traits ont été codés sous forme de pixels RVB dans l'image.

Med-Gemini-2D

Med-Gemini-2D établit une nouvelle norme en matière de génération de rapports de radiographie thoracique (CXR) basés sur l'IA, basés sur une évaluation d'experts, dépassant deux données indépendantes précédentes. Le meilleur résultats de l'ensemble, avec des avantages absolus de 1 % et 12 %, dont les rapports de cas normaux d'AI étaient de 57 % et 96 % et les rapports de cas anormaux de 43 % et 65 %. Par rapport au rapport original du radiologue, la qualité est " comparable" " ou même " meilleur ".

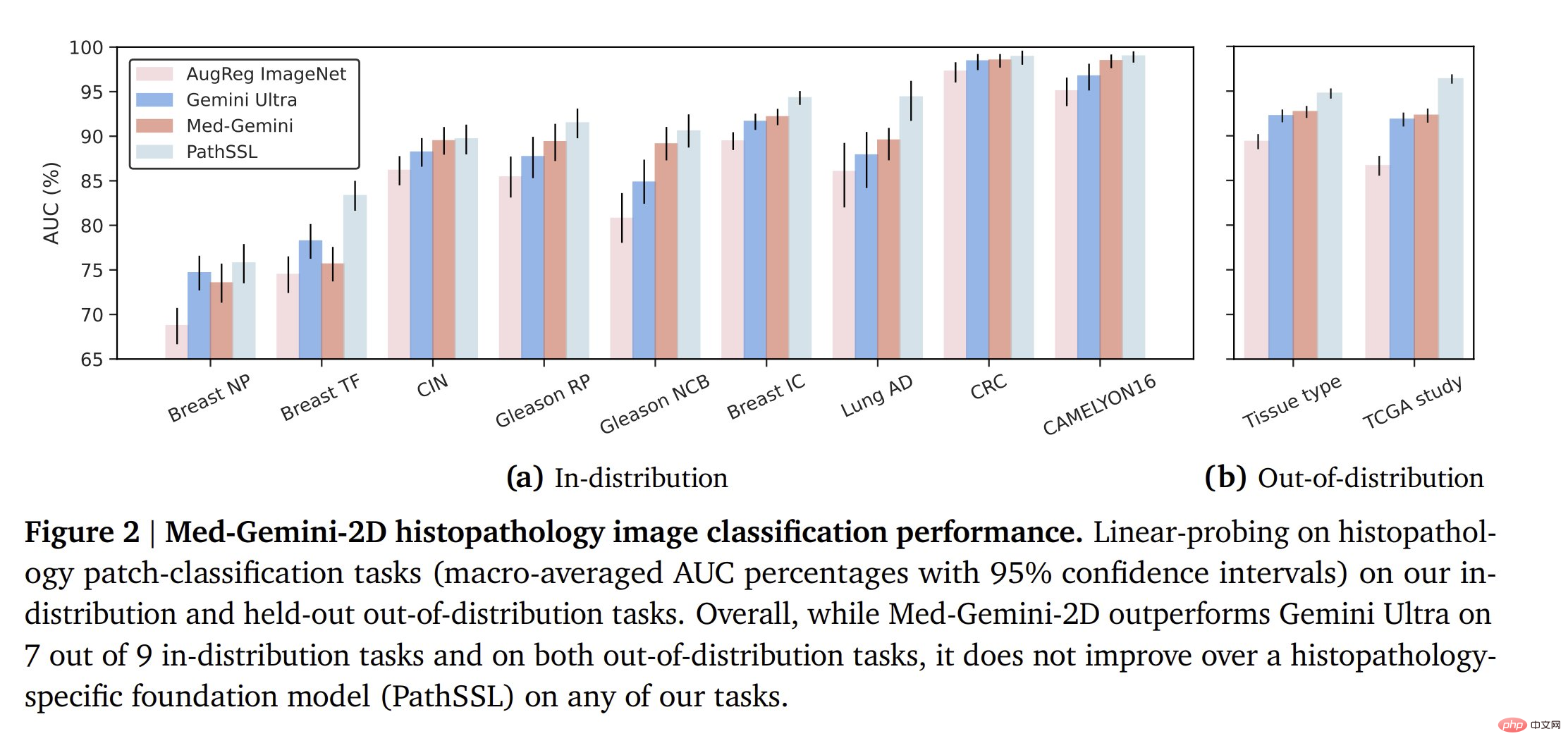

Graphique : performances de Med-Gemini-2D dans la tâche de classification des radiographies pulmonaires. (Source : article)

Med-Gemini-2D surpasse le modèle général Gemini 1.0 Ultra plus grand dans la tâche de classification distribuée des radiographies thoraciques (vu sur des exemples du même ensemble de données pendant la formation). Pour les tâches en dehors de la distribution, les performances varient.

Sur les tâches de classification histopathologique, Med-Gemini a largement surpassé Gemini Ultra, mais n'a pas réussi à surpasser le modèle de base spécifique à la pathologie.

Une tendance similaire est observée pour la classification des lésions cutanées (modèle spécifique au domaine > Med-Gemini > Gemini Ultra), bien que Med-Gemini soit très proche du modèle spécifique au domaine.

Pour la classification en ophtalmologie, une situation similaire se retrouve. Notez que les modèles spécifiques à un domaine sont formés sur environ 200 fois plus de données, donc Med-Gemini fonctionne plutôt bien en comparaison.

L'équipe a également évalué le modèle Med-Gemini-2D en réponse à des questions visuelles médicales (VQA). Ici, leur modèle est très puissant sur de nombreuses tâches VQA, battant souvent les modèles SOTA. Med-Gemini-2D a obtenu de bons résultats en matière de classification CXR et de radiologie VQA, dépassant SOTA ou référence sur 17 tâches sur 20.

Au-delà d'une simple interprétation étroite des images médicales, les auteurs évaluent également les performances de Med-Gemini-2D sur la génération de rapports de radiologie thoracique et observent ses résultats sur la base de l'évaluation d'experts en radiologie SOTA !

Med-Gemini-3D

Med-Gemini-3D n'est pas seulement destiné aux images 2D, mais également à la génération automatisée de rapports CT de bout en bout. Selon l'évaluation des experts, 53 % de ces rapports d'IA ont été jugés cliniquement acceptables, et bien que des recherches supplémentaires soient nécessaires pour garantir la qualité des rapports des radiologues experts, il s'agit du premier modèle génératif capable d'accomplir cette tâche.

Med-Gemini-Polygenic

Enfin, la prédiction des résultats de santé de Med-Gemini-Polygenic a été évaluée sur la base de scores de risque polygénique pour divers traits. Le modèle surpasse généralement les références existantes.

Illustration : Prédictions des résultats en matière de santé à l'aide de Med-Gemini-Polygenic par rapport à deux lignes de base de résultats mal distribués et hors distribution. (Source : Paper)

Voici quelques exemples de conversations multimodales prises en charge par Med-Gemini !

Dans la classification d'images en histopathologie, ophtalmologie et dermatologie, Med-Gemini-2D a dépassé la ligne de base dans 18 tâches sur 20 et s'est approché des performances du modèle spécifique à une tâche.

Conclusion

Dans l'ensemble, ces travaux ont fait des progrès utiles sur un modèle général d'intelligence artificielle médicale multimodale, mais il reste évidemment encore beaucoup à faire. De nombreux modèles spécifiques à un domaine surpassent Med-Gemini, mais Med-Gemini est capable de bien fonctionner avec moins de données et des méthodes plus générales. Il est intéressant de noter que Med-Gemini semble mieux performer dans les tâches qui reposent davantage sur la compréhension du langage, telles que la génération de rapports VQA ou de radiologie.

Les chercheurs envisagent un avenir dans lequel toutes ces fonctions individuelles seront intégrées dans des systèmes complets pour effectuer une gamme de tâches cliniques multidisciplinaires complexes. L’IA travaille aux côtés des humains pour maximiser l’efficacité clinique et améliorer les résultats pour les patients.

Lien papier : https://arxiv.org/abs/2405.03162

Contenu associé : https://twitter.com/iScienceLuvr/status/1789216212704018469

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- La précision de GPT-3 dans la résolution de problèmes mathématiques est passée à 92,5 % ! Microsoft propose MathPrompter pour créer des modèles de langage « scientifiques » sans réglage fin

- Les membres de la CCPPC du district de Xuhui ont organisé des activités d'inspection intensives et prêté attention au développement de l'industrie de l'intelligence artificielle.

- Comment utiliser correctement la version mobile de Google Chrome

- Comment activer l'accès à la caméra dans Google Chrome

- Google Chrome ouvre une nouvelle page Web sans écraser la page Web d'origine