1. Introduction

Our experience of the world is multimodal – we see objects, hear sounds, feel textures, smell To smell, to taste. Modality refers to the way a certain condition occurs or is experienced, and when a research question contains multiple modalities, it is characterized as multimodal. For AI to make progress in understanding the world around us, it needs to be able to interpret these multimodal signals simultaneously.

For example, images are often associated with tags and text explanations, and text contains images to more clearly express the central idea of the article. Different modalities have very different statistical properties. These data are called multimodal big data and contain rich multimodal and cross-modal information, posing huge challenges to traditional data fusion methods.

In this review, we will introduce some groundbreaking deep learning models to fuse these multi-modal big data. As multimodal big data is increasingly explored, there are still some challenges that need to be addressed. Therefore, this article provides a review of deep learning for multimodal data fusion, aiming to provide readers (regardless of their original community) with the basic principles of multimodal deep learning fusion methods and inspire new multimodal approaches to deep learning. Dynamic data fusion technology.

The problem with this approach is that it will give equal importance to all sub-networks/modes, which is very unlikely in real-world situations of. A weighted combination of sub-networks is needed here so that each input modality can have a learning contribution (Theta) to the output prediction.

In this section, we will introduce Representative deep learning architecture for multimodal data fusion deep learning models. Specifically, the definition of deep architecture, feedforward computation and backpropagation computation, as well as typical variations are given. Representative models are summarized.

Table 1: Summary of representative deep learning models.

Restricted Boltzmann Machine (RBM) is Basic blocks of deep belief networks (Zhang, Ding, Zhang, & Xue, 2018; Bengio, 2009). RBM is a special variant of the Boltzmann machine (see Figure 1), which consists of a visible layer and a hidden layer; there is a full connection between the visible layer and the hidden layer, but there is no connection between units in the same layer. RBM is also a generative model that uses an energy function to capture the probability distribution between visible and hidden units. By using the derivative of the energy function, the probability distribution of units between visible and hidden units can be calculated. RBM can capture the probability distribution between individual elements and hidden units. There are no connections between cells in RBM, except that there are no connections between cells within the same layer, and all cells are connected through full connections. RBM also uses the energy function to calculate the probability distribution between visible and hidden units. Using the probability function of RBM, the probability distribution between units can be captured.

Recently, some advanced RBMs have been proposed to improve performance. For example, to avoid network overfitting, Chen, Zhang, Yeung, and Chen (2017) designed a sparse Boltzmann machine that learns the network structure based on hierarchical latent trees. Ning, Pittman, and Shen (2018) introduced the fast contrastive divergence algorithm into RBM, where boundary-based filtering and delta product are used to reduce redundant dot product calculations in the calculation. To protect the internal structure of multidimensional data, Ju et al. (2019) proposed tensor RBM to learn high-level distributions hidden in multidimensional data, where tensor decomposition is used to avoid the curse of dimensionality.

DBM是一種典型的深度架構,由多個RBM堆疊而成(Hinton&Salakhutdinov,2006)。它是一種基於預訓練和微調訓練策略,可利用能量來捕捉可見物體與對應標籤之間的關節分佈的生成模型。在預訓練中,每個隱藏層都被貪婪地建模為在無監督策略中訓練的 RBM。之後,透過監督策略中訓練標籤的判別資訊進一步訓練每個隱藏層。 DBN 已被用於解決許多領域的問題,例如資料降維、表示學習和語義雜湊。具代表性的 DBM 如圖 1 所示。 圖1: #堆疊式自動編碼器(SAE)是編碼器-解碼器架構的典型深度學習模型(Michael,Olivier和Mario,2018;翁,盧,譚,和周,2016)。它可以透過以無監督-監督方式將原始輸入轉換為中間表示來捕獲輸入的簡潔特徵。 SAE已廣泛應用於許多領域,包括降維(Wang,Yao,&Zhao,2016),圖像識別(Jia,Shao,Li,Zhao,&Fu,2018)和文本分類(Chen&Zaki,2017)。圖 2 展示了代表性的 SAE。 圖2: ##DBN 和SAE 是完全連接的神經網路。在這兩個網路中,隱藏層中的每個神經元都連接到前一層的每個神經元,這種拓撲結構會產生大量連接。為了訓練這些連接的權重,全連接的神經網路需要大量的訓練物件來避免過度擬合和欠擬合,這是計算密集型的。此外,全連接拓撲不考慮神經元之間所包含的特徵的位置資訊。因此,完全連接的深度神經網路(DBN、SAE及其變體)無法處理高維度數據,尤其是大圖像和大音訊數據。 卷積神經網路是一種特殊的深度網絡,它考慮了資料的局部拓撲結構(Li, Xia, Du, Lin, & Samat, 2017;Sze,Chen, Yang和Emer,2017)。卷積神經網路包括全連接網路和包含卷積層和池化層的約束網路。約束網路使用卷積和池化運算來實現局部感受野和參數約簡。與 DBN 和 SAE 一樣,卷積神經網路也透過隨機梯度下降演算法進行訓練。它在醫學影像辨識(Maggiori,Tarabalka,Charpiat和Alliez,2017)和語義分析(胡,Lu,Li,&Chen,2014)方面取得了很大進展。具代表性的 CNN 如圖 3 所示。 圖3: #遞歸神經網路是一種處理串列資料的神經運算架構(Martens & Sutskever,2011;Sutskever,Martens和Hinton,2011)。與深度前向架構(即DBN,SAE和CNN)不同,它不僅將輸入模式對應到輸出結果,而且還透過利用隱藏單元之間的連接將隱藏狀態傳輸到輸出(Graves&Schmidhuber,2008)。透過使用這些隱藏的連接,RNN 對時間依賴性進行建模,從而在時間維度上共享物件之間的參數。它已被應用於各個領域,如語音分析(Mulder,Bethard和Moens,2015),圖像標題(Xu等人,2015)和語言翻譯(Graves&Jaitly,2014),取得了出色的性能。與深度前向架構類似,其運算也包括前向傳遞和反向傳播階段。在前向傳遞計算中,RNN 同時取得輸入和隱藏狀態。在反向傳播計算中,它使用時間反向傳播演算法來反向傳播時間步長的損耗。圖 4 顯示了具有代表性的 RNN。 圖4:

###都#########在本節中,我們從模型任務、模型框架和評估資料集的角度回顧了最具代表性的多模態資料融合深度學習模型。根據所使用的深度學習架構,它們分為四類。表2總結了具有代表性的多模態深度學習模型。 ############ 表2:############代表性多模態深度學習模型摘要.###### Srivastava 和Salakhutdinov (2012) 提出了一種基於深度玻爾茲曼學習模型的多模態生成模型,透過擬合多模態資料在各種模態(如圖像、文字和音訊)上的聯合分佈來學習多模態表示。 所提出的多模態DBN的每個模組均以無監督逐層方式初始化,並以基於MCMC的近似方法進行模型訓練。 為了評估學習到的多模態表示,執行了大量的任務,例如產生缺失模態任務、推論共同表示任務和判別任務。實驗驗證了學習到的多模態表示是否滿足所需的屬性。 #為了在早期有效診斷阿茲海默症,Suk、Lee、Shen和阿茲海默病神經影像學計劃(2014)提出了一種多模態玻爾茲曼模型,該模型可以融合多模態資料中的互補知識。具體來說,為了解決淺層特徵學習方法造成的局限性,DBN用於透過將特定領域的表示轉移到分層抽象表示來學習每個模態的深度表示。然後,在串聯向量上建立單層 RBM,該向量是來自每個模態的分層抽象表示的線性組合。它用於透過構建不同多模態特徵的聯合分佈來學習多模態表示。最後,根據三種典型診斷對ADNI資料集對所提出的模型進行了廣泛的評估,實現了最先進的診斷準確性。 為了精確估計人類姿勢,Ouyang, Chu, and Wang (2014)設計了一個多源深度學習模型,該模型透過提取高階空間中身體模式的聯合分佈,從混合類型、外觀得分和變形模態中學習多模態表示。在人類-姿態多源深度模型中,從影像結構模型中提取了三種廣泛使用的模態,這些模型基於條件隨機場理論組合了身體的各個部位。為了獲得多模態數據,透過線性支援向量機對圖形結構模型進行訓練。之後,這三個特徵中的每一個都被輸入到一個兩層受限玻爾茲曼模型中,以從特定於特徵的表示中捕獲高階姿態空間的抽象表示。透過無監督初始化,每個特定模態的受限玻爾茲曼模型都會捕捉全域空間的固有表示。然後,使用RBM進一步學習基於高級混合類型、外觀得分和變形表示的串聯向量的人體姿態表示。為了訓練所提出的多源深度學習模型,設計了一個同時考慮身體位置和人體偵測的任務特定目標函數。所提出的模型在LSP、PARSE和UIUC上進行了驗證,並產生了高達8.6%的改進。 最近,人們提出了一些新的基於DBN的多模態特徵學習模型。例如,Amer、Shields、Siddiquie 和 Tamrakar ( 2018) 提出了一種用於序列事件檢測的混合方法,其中採用條件 RBM 來提取具有附加判別標籤資訊的模態和跨模態特徵。 Al-Waisy、Qahwaji、Ipson 和 Al-Fahdawi ( 2018) 引進了一種辨識人臉的多模態方法。在這種方法中,使用基於DBN的模型對Curvelet變換捕獲的局部手工特徵的多模態分佈進行建模,可以合併局部特徵和深度特徵的優勢(Al-Waisy等人,2018)。 #這些基於DBN的多模態模型使用機率圖網路將特定於模態的表示轉換為共享空間中的語意特徵。然後,根據共享空間的特徵對模態上的聯合分佈進行建模。這些基於DBN的多模態模型在無監督、半監督和監督學習策略中更加靈活和穩健。它們非常適合捕獲輸入資料的資訊特徵。然而,他們忽略了多模態資料的空間和時間拓撲。 #Ngiam et al . (2011) 提出的多模態深度學習是基於堆疊自編碼器(SAE) 的多模態資料融合最具代表性的深度學習模型。這種深度學習模型旨在解決兩個資料融合問題:跨模態和共享模態表徵學習。前者旨在利用其他模態的知識來捕捉更好的單模態表示,而後者則在中級學習模態之間的複雜相關性。為了實現這些目標,設計了三種學習情境—多模態、跨模態和共享模態學習,如表 3 和圖 6 所示。 圖 6: 表3: 多模態學習的設定。 在多模態學習場景中,音訊頻譜圖和視訊幀以線性方式連接成向量。將串聯向量饋入稀疏受限玻爾茲曼機 (SRBM),以學習音訊和視訊之間的相關性。該模型只能學習多個模態的陰影聯合表示,因為相關性隱含在原始層級的高維表示中,而單層 SRBM 無法對它們進行建模。受此啟發,中級表示的串聯向量被輸入到 SRBM 中,以模擬多個模態的相關性,從而顯示出更好的性能。 在跨模態學習場景中,提出了一種深度堆疊多模態自編碼器來明確學習模態之間的相關性。具體來說,音訊和視訊都作為特徵學習中的輸入呈現,在監督訓練和測試中,只有其中一個被輸入到模型中。該模型以多模態學習的方式初始化,能夠很好地模擬跨模態關係。 在共享模態表示中,在去噪自編碼器的激勵下,引入了特定於模態的深度堆疊多模態自編碼器,以探索模態之間的聯合表示,尤其是在缺少一個模態時。透過將其中一個模態替換為零而擴大的訓練資料集被輸入到特徵學習的模型中。 最後,在CUAVE和AVLetters資料集上進行了詳細的實驗,以評估多模態深度學習在特定任務特徵學習中的表現。 #為了從一系列影像(特別是影片)產生視覺和語意上有效的人體骨骼, Hong,Yu,Wan,Tao和Wang(2015)提出了一種多模態深度自動編碼器來捕捉影像和姿勢之間的融合關係。特別是,所提出的多模態深度自編碼器透過三階段策略進行訓練,以建立二維影像和三維姿態之間的非線性映射。在特徵融合階段,利用多視圖超圖低秩表示,基於流形學習,從一系列影像特徵(如定向梯度直方圖和形狀上下文)建構內部二維表示。在第二階段,訓練單層自動編碼器來學習抽象表示,此抽象表示用於透過重建二維影像間特徵來恢復三維姿態。同時,以類似的方式訓練單層自動編碼器,以學習三維姿勢的抽象表示。在獲得每個單一模態的抽象表示後,使用神經網路透過最小化兩個模態互表示之間的平方歐幾里德距離來學習二維影像和三維姿態之間的多模態相關性。所提出的多模態深度自編碼器的學習由初始化和微調階段組成。在初始化中,從對應的自編碼器和神經網路複製多模態深度自編碼器每個子部分的參數。然後,透過隨機梯度下降演算法對整個模型的參數進行進一步微調,從對應的二維影像中建構出三維姿態。 基於SAE的多模態模型採用編碼器-解碼器架構,透過無監督方式透過重構方法提取內在的模態特徵和跨模態特徵。由於它們基於SAE,這是一個完全連接的模型,因此需要訓練許多參數。此外,他們忽略了多模態資料中的空間和時間拓撲。 #為了模擬影像和句子之間的語意映射分佈,馬,Lu,Shang和Li(2015)提出了一個多模態卷積神經網路。為了充分捕捉語意相關性,在端到端架構中設計了三級融合策略-詞級、階段級和句子級。此架構由影像子網路、匹配子網路和多模態子網路組成。圖像子網是一個具有代表性的深度卷積神經網絡,例如Alexnet和Inception,它有效地將圖像輸入編碼為簡潔的表示。匹配子網對將圖像內容與語義空間中句子的單字片段相關聯的聯合表示進行建模。 為了將視覺辨識系統擴展到無限數量的離散類別,Frome等人(2013)透過利用文字資料中的語意資訊提出了一種多模態卷積神經網路。此網路由語言子模型和視覺子模型組成。語言子模型基於skip-gram模型,該模型可以將文字訊息傳輸到語義空間的密集表示中。視覺子模型是一個具有代表性的捲積神經網絡,例如 Alexnet,它在 1000 類 ImageNet 資料集上進行預先訓練以捕獲視覺特徵。為了對圖像和文字之間的語義關係進行建模,語言和視覺子模型透過線性投影層進行組合。每個子模型都由每個模態的參數初始化。之後,為了訓練這種視覺語義多模態模型,提出了一種新的損失函數,透過結合點積相似度和鉸鏈秩損失,可以為正確的圖像和標籤對提供高相似性分數。該模型可以在 ImageNet 資料集上產生最先進的效能,避免語義上不合理的結果。 #基於CNN的多模態模型可以透過局部字段和池化操作來學習模態之間的局部多模態特徵。它們明確地對多模態資料的空間拓撲進行建模。而且它們不是參數數量大大減少的完全連接模型。 #為了產生圖像的標題,毛等人(2014)提出了一種多模態遞歸神經架構。這種多模態遞歸神經網路可以彌合影像和句子之間的機率相關性。它解決了以前工作無法產生新圖像標題的局限性,因為以前的工作根據學習的圖像-文字映射在句子資料庫中檢索相應的標題。與先前的工作不同,多模態遞歸神經模型(MRNN)根據給定的單字和圖像學習語義空間上的聯合分佈。當影像出現時,它會根據捕獲的聯合分佈逐字產生句子。具體來說,多模態遞歸神經網路由語言子網路、視覺子網路和多模態子網路組成,如圖 7 所示。語言子網由兩層詞嵌入部分和單層循環神經部分組成,前者捕獲有效的特定任務表示,後者對句子的時間依賴性進行建模。視覺子網本質上是一個深度卷積神經網絡,如Alexnet、Resnet或Inception,它將高維圖像編碼為緊湊的表示。最後,多模態子網是一個隱藏網絡,它對學習語言和視覺表示的聯合語義分佈進行建模。 圖7: #為了解決目前視覺辨識系統無法一目了然地產生影像豐富描述的局限性,透過橋接視覺和文字資料之間的模態間關係,提出了一種多模態對齊模型(Karpathy&Li,2017)。為了實現這一點,提出了一個雙重方案。首先,設計了一個可視化語意嵌入模型來產生多模態訓練資料集。然後,在此資料集上訓練多模態 RNN,以產生影像的豐富描述。 在視覺語義嵌入模型中,區域卷積神經網路用於獲取豐富的圖像表示,這些圖像表示包含與句子相對應的內容的足夠資訊。然後使用雙向 RNN 將每個句子編碼為具有圖像表示的相同維度的密集向量。此外,還給出了一個多模態評分函數來衡量圖像和句子之間的語義相似性。最後,利用馬可夫隨機場方法產生多模態資料集。 在多模態RNN中,提出了一個基於文字內容和圖像輸入的更有效的擴展模型。此多模態模型由對影像輸入編碼的捲積神經網路和對影像特徵和句子進行編碼的 RNN 組成。該模型還透過隨機梯度下降演算法進行訓練。這兩種多模態模型都在 Flickr 和 Mscoco 資料集上進行了廣泛的評估,並實現了最先進的性能。 #基於RNN的多模態模型能夠藉助隱藏單元計算中的明確狀態傳遞來分析隱藏在多模態資料中的時間依賴性。他們使用時間反向傳播演算法來訓練參數。由於在隱藏狀態傳輸中進行運算,因此很難在高效能設備上並行化。 我們將模型總結為基於DBN、SAE、CNN和RNN的四組多模態資料深度學習模型。這些開創性的模式已經取得了一些進展。然而,這些模型仍處於初步階段,因此仍存在挑戰。 首先,多模態資料融合深度學習模式中存在大量的自由權重,特別是對目標任務影響不大的冗餘參數。為了訓練這些捕捉資料特徵結構的參數,將大量資料輸入到基於反向傳播演算法的多模態資料融合深度學習模型中,該演算法計算密集且耗時。因此,如何結合現有的壓縮策略設計新的多模態深度學習壓縮方法也是一個潛在的研究方向。 其次,多模態資料不僅包含跨模態訊息,而且包含豐富的跨模態資訊。因此,深度學習和語義融合策略的結合可能是解決探索多模態資料所帶來的挑戰的一種方式。 第三,從動態環境中收集多模態數據,顯示數據是不確定的。因此,隨著動態多模態資料的爆炸性增長,必須解決用於資料融合的線上和增量多模態深度度學習模型的設計問題。

#2.2 堆疊式自動編碼器(SAE)

#2.3 捲積神經網路(CNN)

2.4 循環神經網路(RNN)

#3.多模態資料融合的深度學習

3.1 以網路為基礎的深度信念多模態資料融合

3.1.1 範例1

3.1.2 例2

3.1.3 範例3

3.1.4 小結

3.2 基於堆疊自編碼器的多模態資料融合

3.2.1 範例4

#多模態、跨模態和共享模態學習的架構。

#多模態、跨模態和共享模態學習的架構。

3.2.2 範例5

3.2.3 小結

3.3 基於卷積神經網路的多模態資料融合

3.3.1 範例6

3.3.2 範例7

3.3.3 小結

3.4 基於遞迴神經網路的多模態資料融合

3.4.1 範例8

#3.4.2 範例9

3.4.3 小結

4.總結與展望

The above is the detailed content of Too complete! A review of multimodal deep learning!. For more information, please follow other related articles on the PHP Chinese website!

How to Run LLM Locally Using LM Studio? - Analytics VidhyaApr 19, 2025 am 11:38 AM

How to Run LLM Locally Using LM Studio? - Analytics VidhyaApr 19, 2025 am 11:38 AMRunning large language models at home with ease: LM Studio User Guide In recent years, advances in software and hardware have made it possible to run large language models (LLMs) on personal computers. LM Studio is an excellent tool to make this process easy and convenient. This article will dive into how to run LLM locally using LM Studio, covering key steps, potential challenges, and the benefits of having LLM locally. Whether you are a tech enthusiast or are curious about the latest AI technologies, this guide will provide valuable insights and practical tips. Let's get started! Overview Understand the basic requirements for running LLM locally. Set up LM Studi on your computer

Guy Peri Helps Flavor McCormick's Future Through Data TransformationApr 19, 2025 am 11:35 AM

Guy Peri Helps Flavor McCormick's Future Through Data TransformationApr 19, 2025 am 11:35 AMGuy Peri is McCormick’s Chief Information and Digital Officer. Though only seven months into his role, Peri is rapidly advancing a comprehensive transformation of the company’s digital capabilities. His career-long focus on data and analytics informs

What is the Chain of Emotion in Prompt Engineering? - Analytics VidhyaApr 19, 2025 am 11:33 AM

What is the Chain of Emotion in Prompt Engineering? - Analytics VidhyaApr 19, 2025 am 11:33 AMIntroduction Artificial intelligence (AI) is evolving to understand not just words, but also emotions, responding with a human touch. This sophisticated interaction is crucial in the rapidly advancing field of AI and natural language processing. Th

12 Best AI Tools for Data Science Workflow - Analytics VidhyaApr 19, 2025 am 11:31 AM

12 Best AI Tools for Data Science Workflow - Analytics VidhyaApr 19, 2025 am 11:31 AMIntroduction In today's data-centric world, leveraging advanced AI technologies is crucial for businesses seeking a competitive edge and enhanced efficiency. A range of powerful tools empowers data scientists, analysts, and developers to build, depl

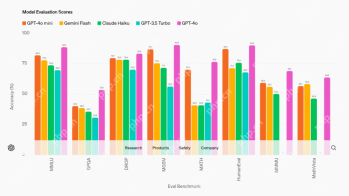

AV Byte: OpenAI's GPT-4o Mini and Other AI InnovationsApr 19, 2025 am 11:30 AM

AV Byte: OpenAI's GPT-4o Mini and Other AI InnovationsApr 19, 2025 am 11:30 AMThis week's AI landscape exploded with groundbreaking releases from industry giants like OpenAI, Mistral AI, NVIDIA, DeepSeek, and Hugging Face. These new models promise increased power, affordability, and accessibility, fueled by advancements in tr

Perplexity's Android App Is Infested With Security Flaws, Report FindsApr 19, 2025 am 11:24 AM

Perplexity's Android App Is Infested With Security Flaws, Report FindsApr 19, 2025 am 11:24 AMBut the company’s Android app, which offers not only search capabilities but also acts as an AI assistant, is riddled with a host of security issues that could expose its users to data theft, account takeovers and impersonation attacks from malicious

Everyone's Getting Better At Using AI: Thoughts On Vibe CodingApr 19, 2025 am 11:17 AM

Everyone's Getting Better At Using AI: Thoughts On Vibe CodingApr 19, 2025 am 11:17 AMYou can look at what’s happening in conferences and at trade shows. You can ask engineers what they’re doing, or consult with a CEO. Everywhere you look, things are changing at breakneck speed. Engineers, and Non-Engineers What’s the difference be

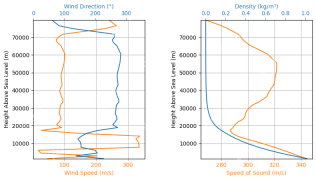

Rocket Launch Simulation and Analysis using RocketPy - Analytics VidhyaApr 19, 2025 am 11:12 AM

Rocket Launch Simulation and Analysis using RocketPy - Analytics VidhyaApr 19, 2025 am 11:12 AMSimulate Rocket Launches with RocketPy: A Comprehensive Guide This article guides you through simulating high-power rocket launches using RocketPy, a powerful Python library. We'll cover everything from defining rocket components to analyzing simula

Hot AI Tools

Undresser.AI Undress

AI-powered app for creating realistic nude photos

AI Clothes Remover

Online AI tool for removing clothes from photos.

Undress AI Tool

Undress images for free

Clothoff.io

AI clothes remover

Video Face Swap

Swap faces in any video effortlessly with our completely free AI face swap tool!

Hot Article

Hot Tools

SublimeText3 Chinese version

Chinese version, very easy to use

VSCode Windows 64-bit Download

A free and powerful IDE editor launched by Microsoft

Safe Exam Browser

Safe Exam Browser is a secure browser environment for taking online exams securely. This software turns any computer into a secure workstation. It controls access to any utility and prevents students from using unauthorized resources.

MinGW - Minimalist GNU for Windows

This project is in the process of being migrated to osdn.net/projects/mingw, you can continue to follow us there. MinGW: A native Windows port of the GNU Compiler Collection (GCC), freely distributable import libraries and header files for building native Windows applications; includes extensions to the MSVC runtime to support C99 functionality. All MinGW software can run on 64-bit Windows platforms.

SublimeText3 Mac version

God-level code editing software (SublimeText3)