Heim >Technologie-Peripheriegeräte >KI >GPT-4 erzielte in jeder Kategorie nur 7,1 Punkte, was drei große Mängel bei den Codefunktionen großer Modelle aufzeigt. Der neueste Benchmark-Test ist da

GPT-4 erzielte in jeder Kategorie nur 7,1 Punkte, was drei große Mängel bei den Codefunktionen großer Modelle aufzeigt. Der neueste Benchmark-Test ist da

- PHPznach vorne

- 2024-04-01 12:41:01854Durchsuche

Der erste KI-Softwareentwickler Devin wurde offiziell vorgestellt und begeisterte sofort die gesamte Technologie-Community.

Obwohl Devin Programmieraufgaben nicht einfach lösen kann, kann er den gesamten Zyklus der Softwareentwicklung selbstständig abschließen – von der Projektplanung bis zur Bereitstellung. Er versucht sein Bestes, um zu graben, beschränkt sich aber nicht nur auf das Erstellen von Websites, das selbstständige Finden und Beheben von Fehlern, das Training und die Feinabstimmung von KI-Modellen usw.

Diese Art von „unglaublich starker“ Softwareentwicklungsfähigkeit hat viele Programmierer zum Verzweifeln gebracht und gerufen: „Kommt wirklich das Ende der Programmierer?“

In allen Testergebnissen hat Devin die Leistung auf dem Besonders auffällig ist der SWE-Bench Benchmark.

SWE-Bench ist ein Test zur Bewertung der Fähigkeiten der KI-Softwareentwicklung, wobei der Schwerpunkt auf der Fähigkeit großer Modelle liegt, tatsächliche GitHub-Probleme zu lösen.

Devin führte die Liste mit einer unabhängigen Problemlösungsrate von 13,86 % an und übertraf damit den GPT-4-Wert von nur 1,74 % sofort und ließ viele große KI-Modelle weit hinter sich.

Diese starke Leistung lässt die Menschen sich fragen: „Welche Rolle wird KI in der zukünftigen Softwareentwicklung spielen?“

Das Shanghai Artificial Intelligence Laboratory hat sich mit Forschern von ByteDance SE Lab und SWE zusammengetan – das Bench-Team hat einen neuen Test-Benchmark vorgeschlagen DevBench, zeigt zum ersten Mal, inwieweit große Modelle von PRD ausgehen können, das Design, die Entwicklung und das Testen eines kompletten Projekts abschließen.

DevBench ist das erste Unternehmen, das die Leistung großer Modelle in allen Phasen vom Produktanforderungsdokument (PRD) bis zur vollständigen Projektentwicklung bewertet, einschließlich Softwaredesign, Aufbau von Abhängigkeitsumgebungen, Codegenerierung auf Codebasisebene, Integrationstests und Unit-Tests .

Experimente haben gezeigt, dass DevBench die Mängel großer Sprachmodelle wie GPT, CodeLlama und DeepSeek-Coder in verschiedenen Phasen der Softwareentwicklung aufdecken kann, wie z. B. unzureichende objektorientierte Programmierfunktionen, Unfähigkeit, ein komplexeres Build-Skript (Build-Skript) zu schreiben, und Funktionsaufrufparameter stimmen nicht überein und andere Probleme.

Große Sprachmodelle sind noch weit davon entfernt, die Entwicklung eines kleinen und mittleren Softwareprojekts selbstständig abschließen zu können.

Derzeit wurden DevBench-Artikel auf der Preprint-Plattform arXiv veröffentlicht, und der relevante Code und die Daten sind Open Source auf GitHub. (Link am Ende des Artikels)

Was sind die Aufgaben von DevBench?

△ Das Bild zeigt einen Überblick über das DevBench-Framework

△ Das Bild zeigt einen Überblick über das DevBench-Framework

Traditionelle Programmier-Benchmarks konzentrieren sich oft auf einen einzelnen Aspekt der Codegenerierung und können die Komplexität realer Programmieraufgaben nicht vollständig abbilden.

Das Aufkommen von DevBench überwindet diese Einschränkung. Es simuliert verschiedene Phasen der Softwareentwicklung durch eine Reihe sorgfältig konzipierter Aufgaben und bietet so eine Plattform für eine umfassende Bewertung der LLM-Funktionen.

DevBench basiert auf fünf Schlüsselaufgaben, die sich jeweils auf eine Schlüsselphase des Softwareentwicklungslebenszyklus konzentrieren, und der modulare Aufbau ermöglicht das unabhängige Testen und Bewerten jeder Aufgabe.

Software-Design: Verwenden Sie das Produktanforderungsdokument PRD, um UML-Diagramme und Architekturentwürfe zu erstellen, um Klassen, Attribute, Beziehungen und das strukturelle Layout der Software anzuzeigen. Diese Aufgabe bezieht sich auf MT-Bench und übernimmt die LLM-as-a-Judge-Bewertungsmethode. Die Bewertung basiert hauptsächlich auf zwei Hauptindikatoren: allgemeinen Prinzipien des Softwaredesigns (wie hohe Kohäsion und geringe Kopplung usw.) und Treue (Treue) .

Umgebungseinstellungen: Generieren Sie die Abhängigkeitsdateien, die zum Initialisieren der Entwicklungsumgebung erforderlich sind, basierend auf dem bereitgestellten Anforderungsdokument. Während des Evaluierungsprozesses wird die Abhängigkeitsdatei in einer bestimmten grundlegenden Isolationsumgebung (Docker-Container) durch Benchmark-Anweisungen erstellt. Anschließend bewertet die Aufgabe in der von diesem Modell erstellten Abhängigkeitsumgebung die Erfolgsquote der Ausführung des Benchmark-Codes, indem sie den Benchmark-Beispielverwendungscode (Beispielverwendung) im Code-Warehouse ausführt.

Code-Implementierung: Basierend auf dem Anforderungsdokument und dem Architekturdesign muss das Modell die Codedateigenerierung der gesamten Codebasis abschließen. DevBench entwickelte ein automatisiertes Test-Framework und passte es an die jeweils verwendete Programmiersprache an. Dabei wurden Pythons PyTest, C++s GTest, Javas JUnit und JavaScripts Jest integriert. Diese Aufgabe bewertet die Erfolgsquote der modellgenerierten Codebasis bei der Ausführung von Benchmark-Integrationstests und Unit-Tests in einer Benchmark-Umgebung.

Integrationstests: Das Modell generiert Integrationstestcode basierend auf Anforderungen, um die externen Schnittstellenfunktionen der Codebasis zu überprüfen. Diese Aufgabe führt die generierten Integrationstests für den Basisimplementierungscode aus und meldet die Testerfolgsquote.

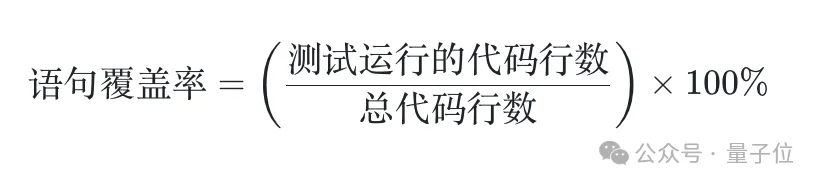

Unit-Tests: Das Modell generiert Unit-Testcode basierend auf den Anforderungen. Auch diese Aufgabe führt die generierten Komponententests für den Basisimplementierungscode aus. Zusätzlich zum Erfolgsquotenindikator führt diese Aufgabe auch Bewertungsindikatoren für die Aussageabdeckung ein, um die Vollständigkeit des Tests quantitativ zu bewerten.

Welche Daten enthält DevBench?

DevBench-Datenvorbereitungsprozess umfasst drei Phasen: Lagervorbereitung, Codebereinigung und Dokumentenvorbereitung.

- In der Vorbereitungsphase wählen Forscher hochwertige Repositories von GitHub aus und stellen so sicher, dass deren Komplexität beherrschbar ist.

- In der Code-Bereinigungsphase überprüfen Annotatoren die Funktionalität des Codes, verfeinern ihn und ergänzen und führen Tests durch, um die Qualität sicherzustellen.

- Die Dokumentationsvorbereitungsphase umfasst die Erstellung von Anforderungsdokumenten, UML-Diagrammen und Architekturentwürfen für das Lager.

Am Ende enthält der DevBench-Datensatz 4 Programmiersprachen, mehrere Felder und insgesamt 22 Codebasen. Die Komplexität dieser Code-Repositories und die Vielfalt der verwendeten Programmierparadigmen stellen erhebliche Herausforderungen für Sprachmodelle dar.

Ein paar interessante Beispiele:

TextCNN

Kann das große Modell vollständig ein TextCNN-Modell für die binäre Textklassifizierung schreiben? Eine Grundvoraussetzung ist die Fähigkeit, den Datensatz von HF selbst abzurufen und das Training durchzuführen. Das Modell muss außerdem Hyperparameter anpassen, Protokolle aufzeichnen und Prüfpunkte gemäß den Anforderungen des Dokuments speichern und gleichzeitig die Reproduzierbarkeit des Experiments sicherstellen.

(https://github.com/open-compass/DevBench/tree/main/benchmark_data/python/TextCNN)

Registrierung & Anmeldung

Front-End-Projekte stützen sich oft auf mehr Komponentenbibliotheken und Front -End-Frameworks: Kann das Modell problemlos Front-End-Projekte bewältigen, bei denen es zu Versionskonflikten kommen kann?

(https://github.com/open-compass/DevBench/tree/main/benchmark_data/javascript/login-registration)

People Management

Wie beherrscht das Modell die Erstellung und Verwaltung von SQLite? Datenbanken? Probe? Kann das Modell zusätzlich zu den grundlegenden Vorgängen zum Hinzufügen, Löschen, Ändern und Abfragen die Verwaltung und den Betrieb von Campus-Personalinformationen und relationalen Datenbanken in benutzerfreundlichen Befehlszeilentools kapseln?

(https://github.com/open-compass/DevBench/tree/main/benchmark_data/cpp/people_management)

Actor Relationship Game

Vermutungsüberprüfung von „Six Degrees of Separation Theory“ in der Film- und Fernsehindustrie? Das Modell muss Daten von der TMDB-API abrufen und durch ihre Zusammenarbeit in Filmen ein Netzwerk von Verbindungen zwischen beliebten Schauspielern aufbauen.

(https://github.com/open-compass/DevBench/tree/main/benchmark_data/java/Actor_relationship_game)

ArXiv-Digest

Das ArXiv-Papierabruf-Gadget wurde ebenfalls problemlos gemeistert? Die API von ArXiv unterstützt nicht die Funktion „Papiere in den letzten N Tagen filtern“, kann aber „nach Veröffentlichungszeitpunkt sortieren“ verwendet werden.

(https://github.com/open-compass/DevBench/tree/main/benchmark_data/python/ArXiv_digest)

Experimentelle Ergebnisse

Das Forschungsteam nutzte DevBench, um derzeit beliebte LLMs, einschließlich GPT-4, zu analysieren - Turbo ist vollständig getestet. Die Ergebnisse zeigen, dass diese Modelle zwar bei einfachen Programmieraufgaben gut funktionieren, bei komplexen, realen Softwareentwicklungsherausforderungen jedoch immer noch auf erhebliche Schwierigkeiten stoßen. Insbesondere beim Umgang mit komplexen Codestrukturen und Logik muss die Leistung des Modells verbessert werden.

DevBench deckt nicht nur die Grenzen bestehender LLMs in der Softwareentwicklung auf, sondern liefert auch wertvolle Erkenntnisse für zukünftige Modellverbesserungen. Durch diesen Benchmark-Test können Forscher die Stärken und Schwächen von LLMs besser verstehen, diese dadurch gezielt optimieren und die Weiterentwicklung von KI im Bereich Software Engineering vorantreiben.

Darüber hinaus bedeutet die Offenheit und Erweiterbarkeit des DevBench-Frameworks, dass es sich weiterhin an verschiedene Programmiersprachen und Entwicklungsszenarien anpassen kann. DevBench befindet sich noch im Entwicklungsprozess und Freunde aus der Community sind herzlich willkommen, sich an der gemeinsamen Entwicklung zu beteiligen.

Devin ist führend auf der SWE-Bench. Kann seine hervorragende Leistung auf andere Bewertungsszenarien ausgeweitet werden? Da sich die Fähigkeiten zur Entwicklung von KI-Software weiter entwickeln, wird dieser Kampf zwischen Programmierern und KI mit Spannung erwartet.

Es gibt auch das Bewertungssystem für große Modelle von OpenCompass.

DevBench hat sich jetzt dem Bewertungssystem für große Modelle von OpenCompass angeschlossen. OpenCompass ist ein One-Stop-Shop für verschiedene Modelle wie große Sprachmodelle und multimodale große Modelle, die von entwickelt und eingeführt wurden die Evaluierungsplattform des Shanghai Artificial Intelligence Laboratory.

OpenCompass zeichnet sich durch Reproduzierbarkeit, umfassende Fähigkeitsdimensionen, umfassende Modellunterstützung, verteilte effiziente Bewertung, diversifizierte Bewertungsparadigmen und flexible Erweiterung aus. Basierend auf einem hochwertigen, mehrstufigen Kompetenzsystem und einer Toolkette hat OpenCompass eine Reihe von Methoden zur Kompetenzbewertung innoviert und unterstützt verschiedene hochwertige zweisprachige Bewertungsmaßstäbe in Chinesisch und Englisch, die Sprache und Verständnis, gesunden Menschenverstand und logisches Denken abdecken. Mathematische Berechnung und Anwendung usw. Mehrere Aspekte wie Programmiersprachen-Codierungsfunktionen, Agenten, Erstellung und Dialog können eine umfassende Diagnose der wahren Fähigkeiten großer Modelle ermöglichen. DevBench hat die Evaluierungsfunktionen von OpenCompass im Bereich Agenten erweitert.

DevBench-Papier: https://arxiv.org/abs/2403.08604GitHub: https://github.com/open-compass/devBench/

OpenCompass https://github.com/open- Kompass/offener Kompass

Das obige ist der detaillierte Inhalt vonGPT-4 erzielte in jeder Kategorie nur 7,1 Punkte, was drei große Mängel bei den Codefunktionen großer Modelle aufzeigt. Der neueste Benchmark-Test ist da. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!