Heim >Technologie-Peripheriegeräte >KI >Das Modell wird sich nach der Fusion weiterentwickeln und SOTA direkt gewinnen! Die neuen unternehmerischen Errungenschaften des Transformer-Autors sind beliebt

Das Modell wird sich nach der Fusion weiterentwickeln und SOTA direkt gewinnen! Die neuen unternehmerischen Errungenschaften des Transformer-Autors sind beliebt

- 王林nach vorne

- 2024-03-26 11:30:14765Durchsuche

Verwenden Sie die vorgefertigten Modelle auf Huggingface, um „zu sparen“ –

Kann man sie direkt kombinieren, um neue leistungsstarke Modelle zu erstellen? !

Sakana.ai, ein großes japanisches Modellunternehmen, hat eine große Fantasie (es ist das Unternehmen, das von einem der „Transformer Eight“ gegründet wurde) und hat sich eine so clevere Möglichkeit ausgedacht, Modelle weiterzuentwickeln und zusammenzuführen.

Diese Methode kann nicht nur automatisch ein neues Basismodell generieren, sondern auch Leistung ist keineswegs schlecht:

Sie nutzen ein großes Modell japanischer Mathematik mit 7 Milliarden Parametern und erreichen den neuesten Stand der Technik. the-art-Ergebnisse in relevanten Benchmarks Die Ergebnisse übertrafen frühere Modelle wie Llama-2 mit 70 Milliarden Parametern.

Das Wichtigste ist, dass für die Entwicklung eines solchen Modells kein Gradiententraining erforderlich ist, sodass die erforderlichen Rechenressourcen erheblich reduziert werden.

NVIDIA-Wissenschaftler Jim Fan lobte es, nachdem er es gelesen hatte:

Dies ist einer der einfallsreichsten Artikel, die ich in letzter Zeit gelesen habe.

Evolution zusammenführen und automatisch neue Basismodelle generieren

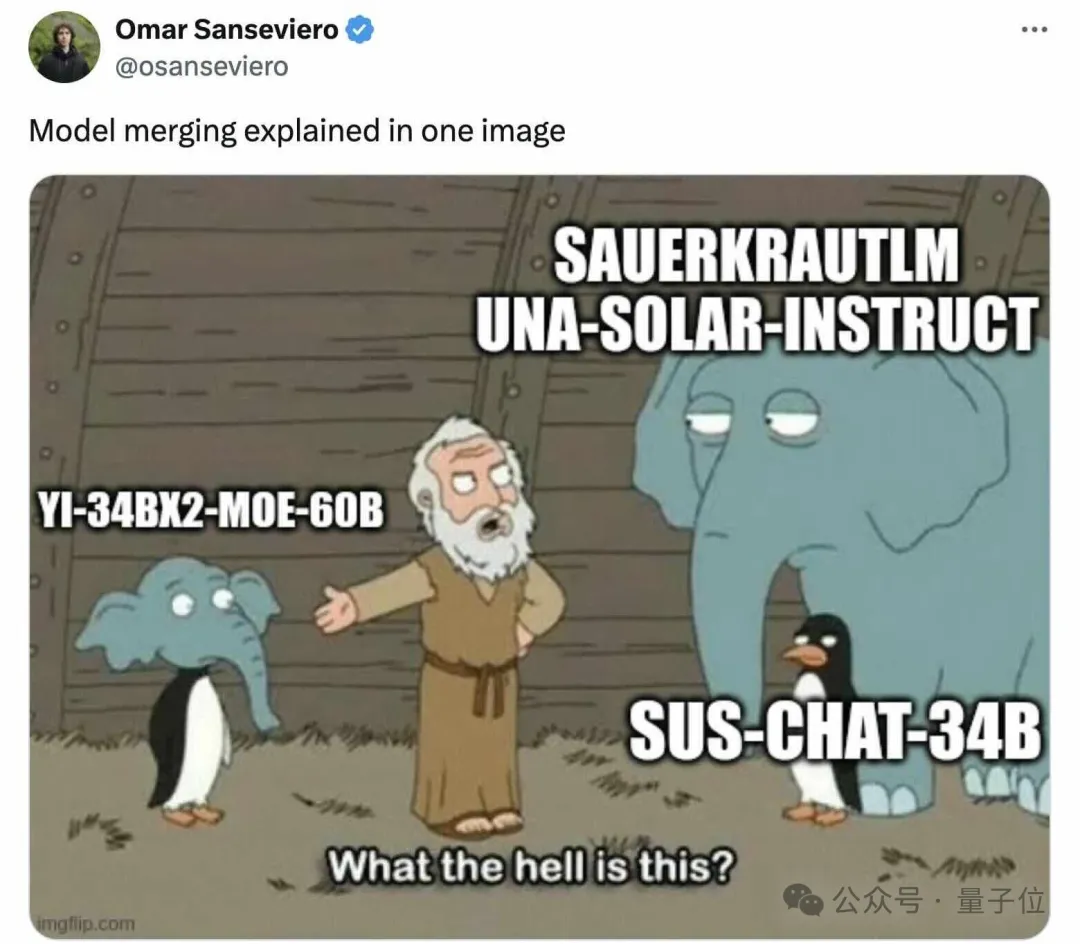

Die meisten der leistungsstärksten Modelle aus den Open-Source-Ranglisten für große Modelle sind nicht mehr „Original“-Modelle wie LLaMA oder Mistral, sondern einige fein abgestimmte oder zusammengeführte Modelle Danach können wir sehen:

Ein neuer Trend ist entstanden.

Sakana.ai stellt vor, dass das Open-Source-Basismodell leicht in Hunderte von verschiedenen Richtungen erweitert und verfeinert werden kann und dann neue Modelle generiert werden kann, die in neuen Bereichen gute Leistungen erbringen.

Unter diesen ist die Modellzusammenführung vielversprechend.

Allerdings kann es sich um eine Art „schwarze Magie“ handeln, die stark auf Intuition und Fachwissen angewiesen ist.

Deshalb brauchen wir einen systematischeren Ansatz.

Inspiriert von der natürlichen Selektion in der Natur konzentriert sich Sakana.ai auf evolutionäre Algorithmen, stellt das Konzept der „Evolutionary Model Merge“ vor und schlägt eine allgemeine Methode vor, mit der die beste Modellkombination ermittelt werden kann.

Diese Methode kombiniert zwei verschiedene Ideen:

(1) Zusammenführen von Modellen im Datenflussraum (Ebenen) und (2) Zusammenführen von Modellen im Parameterraum (Gewichte) .

Konkret besteht die erste Methode des Datenflussraums darin, durch Evolution die beste Kombination verschiedener Modellschichten zu ermitteln, um ein neues Modell zu bilden.

In der Vergangenheit hat sich die Community auf ihre Intuition verlassen, um zu bestimmen, wie und welche Schichten eines Modells mit Schichten eines anderen Modells kombiniert werden können.

Aber tatsächlich hat Sakana.ai eingeführt, dass dieses Problem einen Suchraum mit einer großen Anzahl von Kombinationen hat, der sich am besten für die Suche nach Optimierungsalgorithmen wie evolutionären Algorithmen eignet.

Das Operationsbeispiel lautet wie folgt:

Bei der zweiten Parameterraummethode werden mehrere Modellgewichte gemischt, um ein neues Modell zu bilden.

Es gibt tatsächlich unzählige Möglichkeiten, diese Methode umzusetzen, und im Prinzip kann jede Mischschicht unterschiedliche Mischungsverhältnisse verwenden, sogar noch mehr.

Und hier können wir mithilfe evolutionärer Methoden effektiv weitere neuartige Hybridstrategien finden.

Das Folgende ist ein Beispiel für das Mischen der Gewichte zweier verschiedener Modelle, um ein neues Modell zu erhalten:

Die Kombination der beiden oben genannten Methoden sieht so aus:

Der Autor stellte vor, dass sie hoffen um das Ziel zu erreichen, die Gewichte zweier verschiedener Modelle, wie Mathematik und nicht-englische Sprachen, Vision und nicht-englische Sprachen, zu kombinieren, um bisher noch nicht erforschte Kombinationen zu bilden.

Das Ergebnis ist wirklich überraschend.

Das neue Modell gewinnt leicht SOTA

Mit der oben genannten evolutionären Zusammenführungsmethode erhielt das Team drei Grundmodelle:

- Großes Sprachmodell EvoLLM-JP

Es besteht aus dem japanischen Großmodell Shisa-Gamma und großes Mathematikmodell Das Modell ist eine Fusion von WizardMath/Abel, das sich gut zur Lösung japanischer Mathematikprobleme eignet und sich über 100–150 Generationen weiterentwickelt hat.

- Visuelles Sprachmodell EvoVLM-JP

Das japanische Großmodell Shisa Gamma 7B v1+LLaVa-1.6-Mistral-7B ist ein VLM mit japanischen Sprachfunktionen.

- Bildgenerierungsmodell EvoSDXL-JP

Unterstützt das japanische SDXL-Diffusionsmodell.

Die ersten beiden wurden auf Hugging Face und GitHub veröffentlicht, und das letzte wird bald veröffentlicht.

Schauen Sie es sich konkret an.

1. EvoLLM-JP

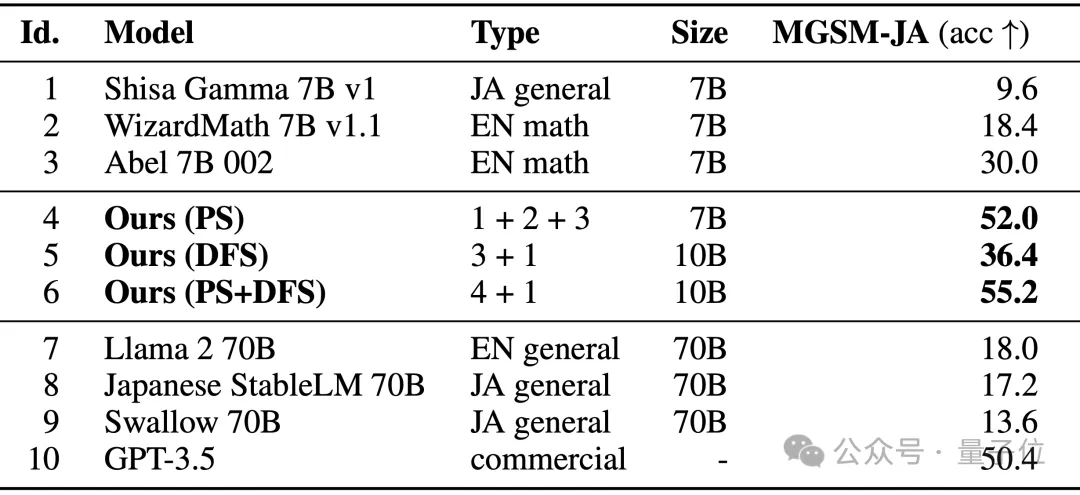

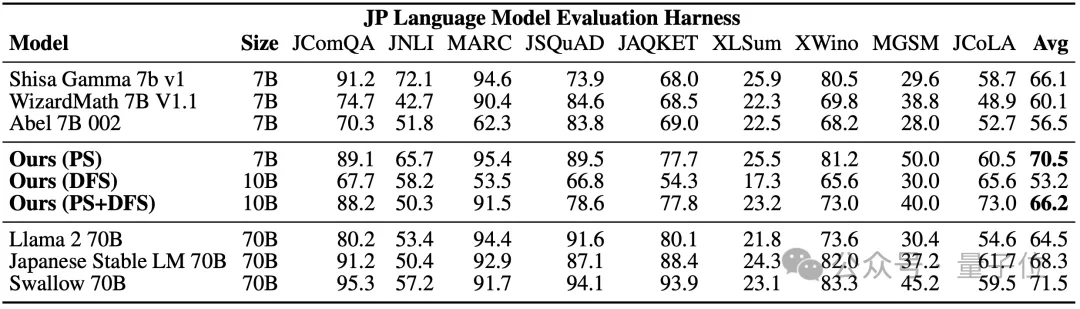

Es erzielte die folgenden Ergebnisse auf dem japanischen Evaluierungssatz von MGSM, einer mehrsprachigen Version des GSM8K-Datensatzes:

Wie Sie sehen können, EvoLLM-JP löst Mathematik auf Japanisch. Die Leistung des Problems übertrifft ihre Originalmodelle sowie Hochleistungsmodelle wie Llama-2 und GPT-3.5.

Unter diesen ist Modell 4 nur im Parameterraum optimiert, und Modell 6 ist das Ergebnis einer weiteren Optimierung im Datenflussraum unter Verwendung von Modell 4.

Beim japanischen LM-Evaluation-Harness-Benchmark, der sowohl Datenfähigkeiten als auch allgemeine japanische Sprachkenntnisse bewertet, erreichte EvoLLM-JP bei 9 Aufgaben die höchste durchschnittliche Punktzahl von 70,5 – mit nur 7 Milliarden Parametern besiegte es 70 Milliarden Llama-2 und andere Modelle.

Das Team gab an, dass EvoLLM-JP gut genug ist, um als allgemeines japanisches Großmodell verwendet zu werden und einige interessante Beispiele zu lösen:

z. B. mathematische Probleme, die spezifische Kenntnisse der japanischen Kultur erfordern, oder das Erzählen japanischer Witze im Kansai-Dialekt.

2, EvoVLM-JP

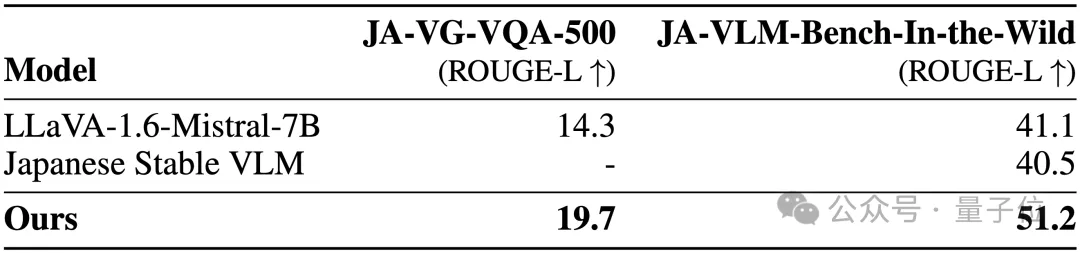

Bei den folgenden zwei Benchmark-Datensätzen für Bildfragen und -antworten gilt: Je höher die Punktzahl, desto genauer ist die Beschreibung der Modellantwort auf Japanisch.

Damit ist es nicht nur besser als das englische VLM LLaVa-1.6-Mistral-7B, auf dem es basiert, sondern auch besser als das bestehende japanische VLM.

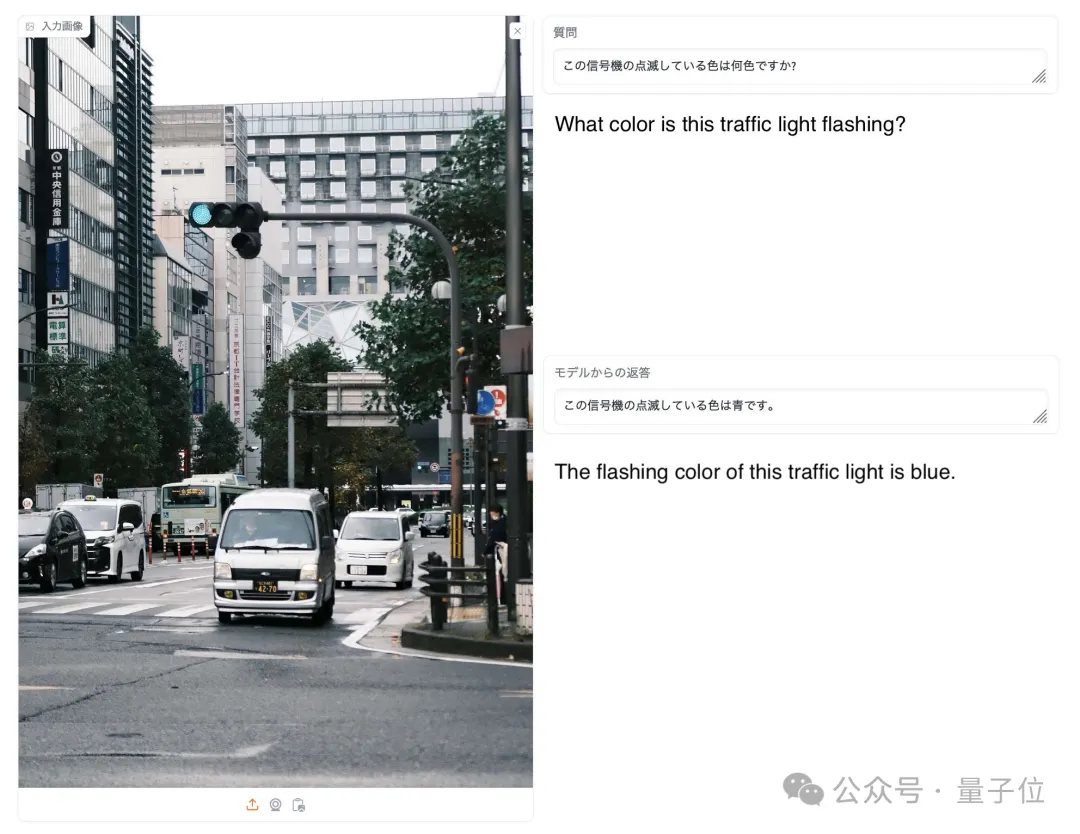

Wie im Bild unten gezeigt, antwortete auf die Frage, welche Farbe das Signallicht im Bild hat, nur EvoVLM-JP richtig: blau.

3, EvoSDXL-JP

Dieses SDXL-Modell, das Japanisch unterstützt, erfordert nur 4 Diffusionsmodelle, um Inferenz durchzuführen, und die Generierungsgeschwindigkeit ist recht hoch.

Die konkreten Laufergebnisse wurden noch nicht veröffentlicht, aber das Team verriet, dass sie „ziemlich vielversprechend“ seien.

Sie können sich an einigen Beispielen erfreuen:

Zu den Aufforderungswörtern gehören: Miso ラーメン, Ukiyoe höchster Qualität, Katsushika Hokusai, Edo-Zeit.

Für die oben genannten drei neuen Modelle wies das Team darauf hin:

Grundsätzlich können wir die Gradienten-basierte Backpropagation verwenden, um die Leistung dieser Modelle weiter zu verbessern.

Aber wir verwenden nicht, denn der Zweck besteht nun darin, zu zeigen, dass wir auch ohne Backpropagation immer noch ein Basismodell erhalten können, das weit genug fortgeschritten ist, um das aktuelle „teure Paradigma“ in Frage zu stellen.

Netizens mochten dies nacheinander.

Jim Fan fügte außerdem hinzu:

Im Bereich der Basismodelle derzeit konzentriert sich die Community fast ausschließlich darauf, das Modell lernen zu lassen, und schenkt der Suche nicht viel Aufmerksamkeit , aber letzteres ist Training (das ist der in diesem Artikel vorgeschlagene evolutionäre Algorithmus) und die Argumentationsphase haben tatsächlich großes Potenzial.

△Gefällt Musk

Also, wie Internetnutzer sagten:

Befinden wir uns jetzt in der kambrischen Explosionsära des Modells?

Papieradresse: https://arxiv.org/abs/2403.13187

Das obige ist der detaillierte Inhalt vonDas Modell wird sich nach der Fusion weiterentwickeln und SOTA direkt gewinnen! Die neuen unternehmerischen Errungenschaften des Transformer-Autors sind beliebt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Was sind die Gründe und Lösungen für einen Datenbankverbindungsfehler?

- So verwenden Sie die Vlookup-Funktion von Excel, um mehrere Datenspalten gleichzeitig abzugleichen

- Googles führender KI-Experte schließt sich OpenAI an und warnt Google davor, ChatGPT-Daten zum Trainieren von Bard zu verwenden

- Musk kündigt an, dass er Microsoft wegen der Verwendung von Twitter-Daten zum Trainieren künstlicher Intelligenz verklagen wird

- So verwenden Sie PyTorch für das Training neuronaler Netzwerke