Heim >Technologie-Peripheriegeräte >KI >Die Tsinghua NLP Group hat InfLLM veröffentlicht: Keine zusätzliche Schulung erforderlich, „1024K ultralanger Kontext' 100 % Rückruf!

Die Tsinghua NLP Group hat InfLLM veröffentlicht: Keine zusätzliche Schulung erforderlich, „1024K ultralanger Kontext' 100 % Rückruf!

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2024-03-11 14:40:04811Durchsuche

Große Modelle können sich nur einen begrenzten Kontext merken und verstehen, was zu einer großen Einschränkung ihrer praktischen Anwendungen geworden ist. Konversations-KI-Systeme können sich beispielsweise häufig nicht dauerhaft an die Gespräche des Vortages erinnern, was dazu führt, dass Agenten, die mit großen Modellen erstellt wurden, inkonsistentes Verhalten und Gedächtnis aufweisen.

Damit große Modelle längere Kontexte besser verarbeiten können, haben Forscher eine neue Methode namens InfLLM vorgeschlagen. Diese von Forschern der Tsinghua-Universität, des MIT und der Renmin-Universität gemeinsam vorgeschlagene Methode ermöglicht es großen Sprachmodellen (LLMs), extrem lange Texte ohne zusätzliche Schulung zu verarbeiten. InfLLM nutzt eine geringe Menge an Rechenressourcen und Grafikspeicher-Overhead, um eine effiziente Verarbeitung sehr langer Texte zu erreichen.

Papieradresse: https://arxiv.org/abs/2402.04617

Code-Repository: https://github.com/thunlp/InfLLM

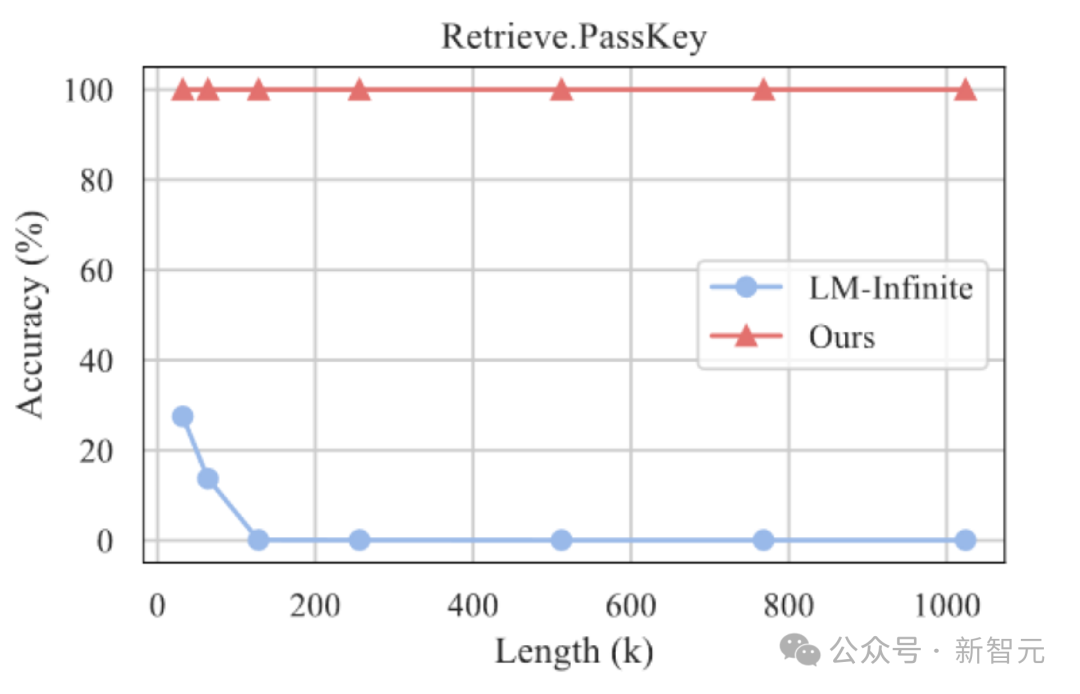

Experimentelle Ergebnisse zeigen, dass InfLLM sein kann effektiv Es erweitert das Kontextverarbeitungsfenster von Mistral und LLaMA erheblich und erreicht 100 % Rückruf bei der Suche nach der Nadel im Heuhaufen mit 1024.000 Kontexten.

Forschungshintergrund

Groß angelegte vorab trainierte Sprachmodelle (LLMs) haben in den letzten Jahren bei vielen Aufgaben bahnbrechende Fortschritte gemacht und sind zum Basismodell für viele Anwendungen geworden.

Diese praktischen Anwendungen stellen auch größere Herausforderungen an die Fähigkeit von LLMs, lange Sequenzen zu verarbeiten. Beispielsweise muss ein LLM-gesteuerter Agent die von der externen Umgebung empfangenen Informationen kontinuierlich verarbeiten, was eine stärkere Speicherkapazität erfordert. Gleichzeitig muss sich die Konversations-KI den Inhalt von Gesprächen mit Benutzern besser merken, um personalisiertere Antworten zu generieren.

Aktuelle groß angelegte Modelle werden jedoch normalerweise nur auf Sequenzen mit Tausenden von Tokens vorab trainiert, was bei der Anwendung auf sehr lange Texte zu zwei großen Herausforderungen führt:

1 Länge: Die direkte Anwendung von LLMs auf Texte mit längerer Länge erfordert häufig, dass LLMs die Positionskodierung über den Trainingsbereich hinaus verarbeiten, was zu Out-of-Distribution-Problemen und einem Versagen bei der Verallgemeinerung führt.

Ein zu langer Kontext führt dazu, dass die Aufmerksamkeit des Modells übermäßig auf irrelevante Informationen abgelenkt wird, wodurch es unmöglich wird, langfristige semantische Abhängigkeiten im Kontext effektiv zu modellieren. Einführung in die Methode InfLLM zielt darauf ab, die intrinsische Fähigkeit von LLMs zu stimulieren, semantische Abhängigkeiten über große Entfernungen in extrem langen Kontexten mit begrenztem Rechenaufwand zu erfassen und so ein effizientes Verständnis langer Texte zu ermöglichen.

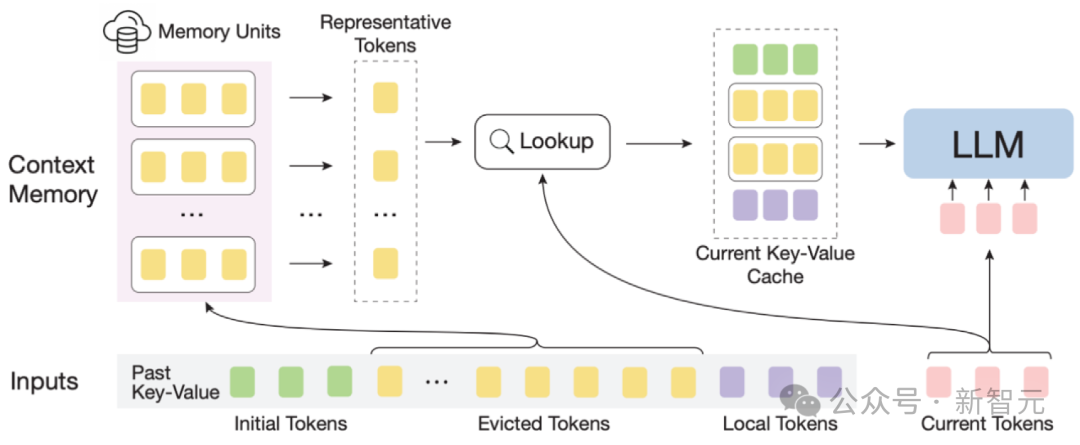

Gesamtrahmen: Angesichts der spärlichen Aufmerksamkeit für lange Texte erfordert die Verarbeitung jedes Tokens normalerweise nur einen kleinen Teil seines Kontexts.

So können LLMs eine begrenzte Fenstergröße verwenden, um die gesamte lange Sequenz zu verstehen und die Einführung von Rauschen zu vermeiden.

Der massive Kontext in extrem langen Sequenzen bringt jedoch erhebliche Herausforderungen für die effektive Lokalisierung verwandter Informationen und die Effizienz der Speichersuche im Speichermodul mit sich.

Um diese Herausforderungen zu bewältigen, besteht jede Speichereinheit im kontextuellen Speichermodul aus einem semantischen Block, und ein semantischer Block besteht aus mehreren aufeinanderfolgenden Token.

Konkret: (1) Um relevante Speichereinheiten effektiv zu lokalisieren, kann die kohärente Semantik jedes semantischen Blocks die Anforderungen verwandter Informationsabfragen effektiver erfüllen als fragmentierte Token.

Darüber hinaus wählt der Autor aus jedem semantischen Block das semantisch wichtigste Token aus, also das Token, das den höchsten Aufmerksamkeitswert erhält, als Darstellung des semantischen Blocks. Diese Methode hilft, Ungenauigkeiten bei der Korrelationsberechnung zu vermeiden . Störung durch wichtige Token.

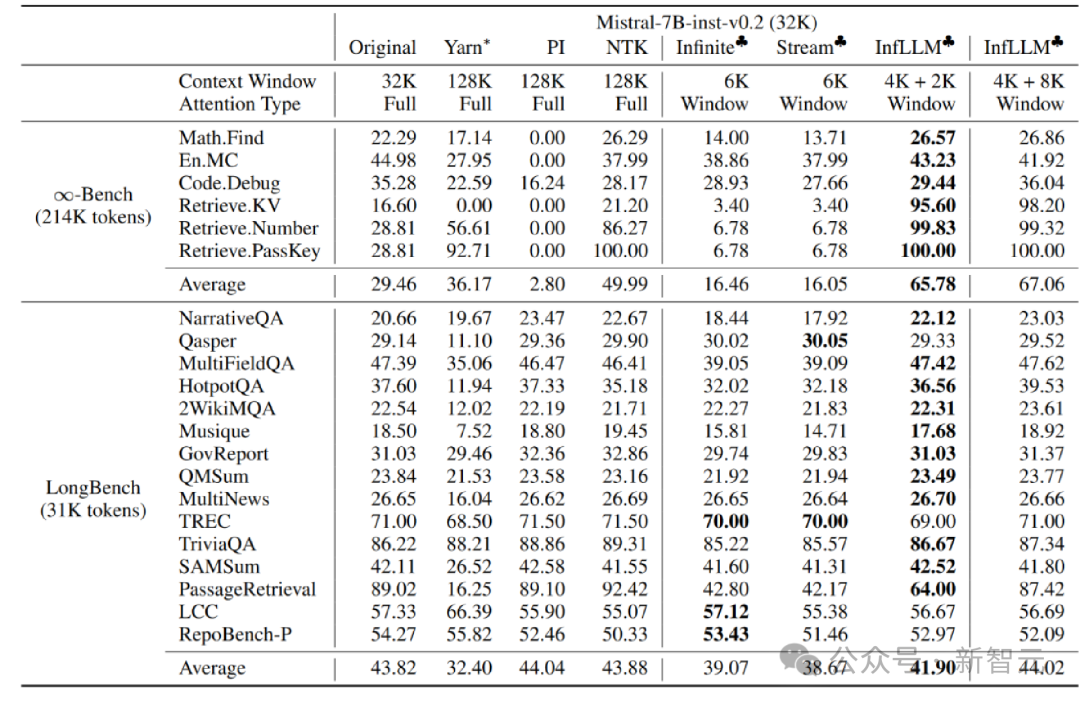

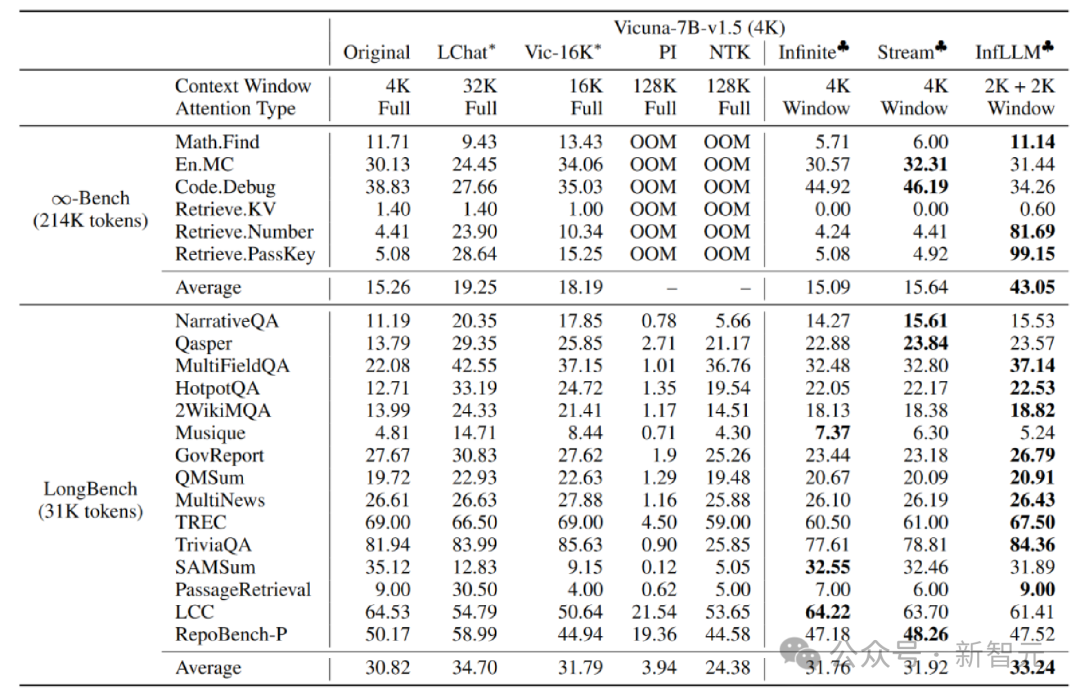

(2) Für eine effiziente Speichersuche vermeidet die Speichereinheit auf semantischer Blockebene Token-für-Token- und Aufmerksamkeit-für-Aufmerksamkeit-Korrelationsberechnungen, wodurch die Rechenkomplexität reduziert wird. Darüber hinaus sorgen semantische Speichereinheiten auf Blockebene für einen kontinuierlichen Speicherzugriff und reduzieren die Speicherladekosten. Dank dessen hat der Autor einen effizienten Offloading-Mechanismus (Offloading) für das Kontextspeichermodul entwickelt. Angesichts der Tatsache, dass die meisten Speichereinheiten selten verwendet werden, verlagert InfLLM alle Speichereinheiten in den CPU-Speicher und behält häufig verwendete Speichereinheiten dynamisch im GPU-Speicher bei, wodurch die Videospeichernutzung erheblich reduziert wird. InfLLM kann wie folgt zusammengefasst werden: 1. Fügen Sie basierend auf dem Schiebefenster ein Kontextspeichermodul mit großer Reichweite hinzu. 2. Teilen Sie den historischen Kontext in semantische Blöcke auf, um Speichereinheiten im Kontextspeichermodul zu bilden. Jede Speichereinheit bestimmt anhand ihrer Aufmerksamkeitsbewertung in der vorherigen Aufmerksamkeitsberechnung ein repräsentatives Token als Darstellung der Speichereinheit. Dadurch werden Rauschstörungen im Kontext vermieden und die Komplexität der Speicherabfrage reduziert , verwendet lokale Fenstergrößen von 4K bzw. 2K. Im Vergleich zum Originalmodell, der Positionskodierungsinterpolation, Infinite-LM und StreamingLLM wurden bei Langtextdaten Infinite-Bench und Longbench erhebliche Leistungsverbesserungen erzielt.

Experimentieren Sie mit sehr langen Texten Experimentelle Ergebnisse der Suche nach einer Nadel im Heuhaufen Zusammenfassung InfLLM fügt ein Speichermodul hinzu, das Kontextinformationen über große Entfernungen basierend auf dem Schiebefenster enthält, und verwendet den Cache- und Offload-Mechanismus, um Streaming-Langtext-Argumentation mit geringem Rechenaufwand und geringem Speicherverbrauch zu implementieren.

Darüber hinaus erforschte der Autor weiterhin die Generalisierungsfähigkeit von InfLLM bei längeren Texten, und es kann immer noch in der „Nadel im Heuhaufen“ funktionieren " Aufgabe mit einer Länge von 1024 KB. Behalten Sie eine Rückrufrate von 100 % bei.

Darüber hinaus erforschte der Autor weiterhin die Generalisierungsfähigkeit von InfLLM bei längeren Texten, und es kann immer noch in der „Nadel im Heuhaufen“ funktionieren " Aufgabe mit einer Länge von 1024 KB. Behalten Sie eine Rückrufrate von 100 % bei.  In diesem Artikel schlug das Team InfLLM vor, das die ultralange Textverarbeitung von LLM ohne Schulung erweitern und Langstreckensemantik erfassen kann Information .

In diesem Artikel schlug das Team InfLLM vor, das die ultralange Textverarbeitung von LLM ohne Schulung erweitern und Langstreckensemantik erfassen kann Information .

Das obige ist der detaillierte Inhalt vonDie Tsinghua NLP Group hat InfLLM veröffentlicht: Keine zusätzliche Schulung erforderlich, „1024K ultralanger Kontext' 100 % Rückruf!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!