Heim >Technologie-Peripheriegeräte >KI >Erkennung von KI-generierten Bildern mithilfe der Texturkontrasterkennung

Erkennung von KI-generierten Bildern mithilfe der Texturkontrasterkennung

- 王林nach vorne

- 2024-03-06 21:28:091146Durchsuche

In diesem Artikel stellen wir vor, wie man ein Deep-Learning-Modell entwickelt, um durch künstliche Intelligenz erzeugte Bilder zu erkennen.

Viele Deep-Learning-Methoden zur Erkennung von KI-generierten Bildern basieren auf der Art und Weise, wie das Bild generiert wird, oder auf den Eigenschaften/Semantik des Bildes. Typischerweise können diese Modelle nur bestimmte von KI generierte Objekte erkennen, beispielsweise Personen , Gesicht, Auto usw.

Die in dieser Studie mit dem Titel „Rich and Poor Texture Contrast: A Simple but Effective Approach for AI-generated Image Detection“ vorgeschlagene Methode überwindet jedoch diese Herausforderungen und ist breiter anwendbar. Wir werden uns mit diesem Forschungspapier befassen, um zu veranschaulichen, wie es Probleme effektiv löst, mit denen andere Methoden zur Erkennung von KI-generierten Bildern konfrontiert sind.

Generalisierungsproblem

Wenn wir ein Modell (wie ResNet-50) verwenden, um von künstlicher Intelligenz generierte Bilder zu erkennen, lernt das Modell anhand der Semantik des Bildes. Wenn wir ein Modell trainieren, um KI-generierte Autobilder zu erkennen, indem wir reale Bilder und verschiedene KI-generierte Autobilder für das Training verwenden, kann das Modell aus diesen Daten nur Informationen über Autos erhalten, nicht jedoch für andere Objekte Identifikation.

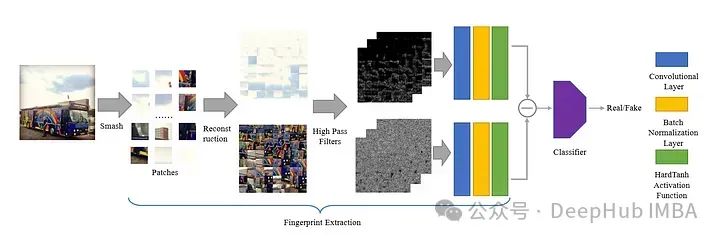

Obwohl das Training an Daten verschiedener Objekte durchgeführt werden kann, dauert diese Methode lange und kann bei unbekannten Daten nur eine Genauigkeit von etwa 72 % erreichen. Obwohl die Genauigkeit durch Erhöhen der Anzahl der Trainingszeiten und der Datenmenge verbessert werden kann, können wir nicht unbegrenzte Trainingsdaten erhalten. In diesem Artikel wird eine einzigartige Methode vorgestellt, mit der verhindert werden soll, dass das Modell während des Trainings KI-generierte Merkmale aus der Form des Bildes lernt. Um dieses Ziel zu erreichen, schlägt der Autor eine Methode namens Smash&Reconstruction vor.

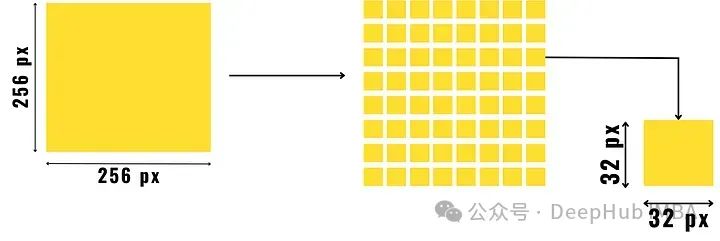

Bei dieser Methode wird das Bild in kleine Blöcke vorgegebener Größe unterteilt und dann neu angeordnet, um ein neues Bild zu erzeugen. Dies ist nur ein kurzer Überblick, da zusätzliche Schritte erforderlich sind, bevor das endgültige Eingabebild für das generative Modell erstellt wird.

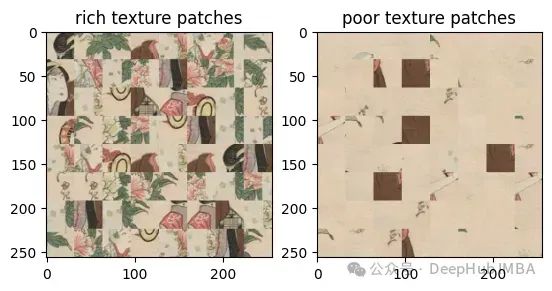

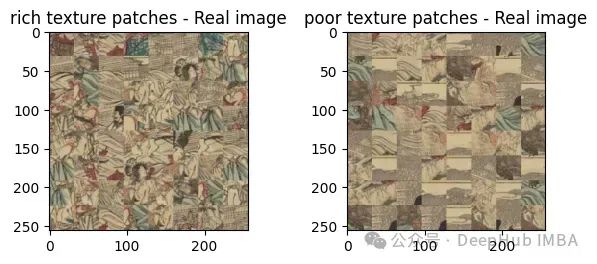

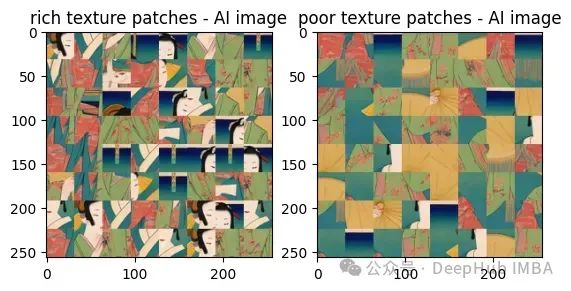

Nachdem wir das Bild in kleine Flecken unterteilt haben, unterteilen wir die Flecken in zwei Gruppen, eine sind die Flecken mit reichhaltiger Textur und die andere sind die Flecken mit schlechter Textur.

Ein detaillierter Bereich in einem Bild, z. B. ein Objekt oder die Grenze zwischen zwei Bereichen mit kontrastierender Farbe, wird zu einem reichhaltigen Texturfleck. Reich strukturierte Bereiche weisen im Vergleich zu strukturierten Bereichen, die hauptsächlich Hintergrund sind, wie z. B. der Himmel oder stilles Wasser, eine große Pixelvariation auf.

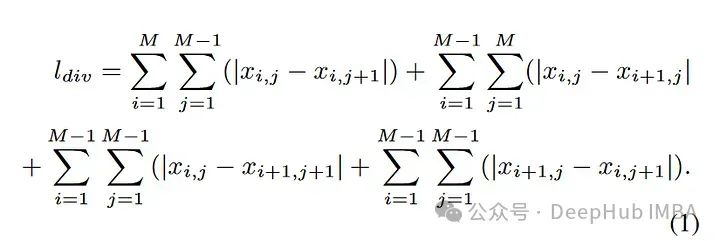

Berechnung der Texturreichtumsmetriken

Beginnen Sie damit, das Bild in kleine Stücke vorgegebener Größe zu unterteilen, wie im Bild oben gezeigt. Ermitteln Sie dann die Pixelverläufe dieser Bildfelder (d. h. ermitteln Sie die Differenz der Pixelwerte in horizontaler, diagonaler und antidiagonaler Richtung und addieren Sie sie) und unterteilen Sie sie in Felder mit reichhaltiger Textur und Felder mit schlechter Textur.

Im Vergleich zu Blöcken mit schlechter Textur weisen texturreiche Blöcke höhere Pixelgradientenwerte auf. Die Formel zur Berechnung des Bildgradientenwerts lautet wie folgt:

Trennen Sie das Bild anhand des Pixelkontrasts. Es werden zwei zusammengesetzte Bilder erhalten. Bei diesem Prozess handelt es sich um einen vollständigen Prozess, der in diesem Artikel als „Smash&Reconstruction“ bezeichnet wird.

Dadurch kann das Modell die Details der Textur anstelle der Inhaltsdarstellung des Objekts lernen.

Fingerabdruck Algorithmen können nur Bilder erkennen, die durch spezifische/ähnliche Methoden wie Diffusion, GAN oder andere CNN-basierte Bilderzeugungsmethoden generiert wurden.

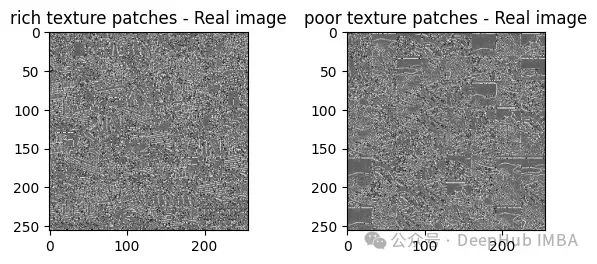

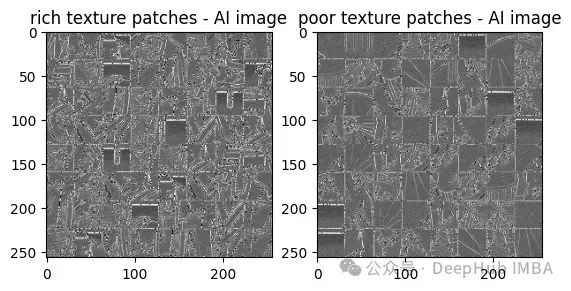

Um dieses Problem genau zu lösen, hat das Papier diese Bildfelder in reichhaltige und schlechte Texturen unterteilt. Anschließend schlug der Autor eine neue Methode zur Identifizierung von Fingerabdrücken in Bildern vor, die durch künstliche Intelligenz erzeugt wurden, so der Titel des Artikels. Sie schlugen vor, den Kontrast zwischen satten und texturarmen Bereichen im Bild nach Anwendung von 30 Hochpassfiltern zu ermitteln.

Wie hilft der Kontrast zwischen reichhaltigen und schlechten Texturblöcken?

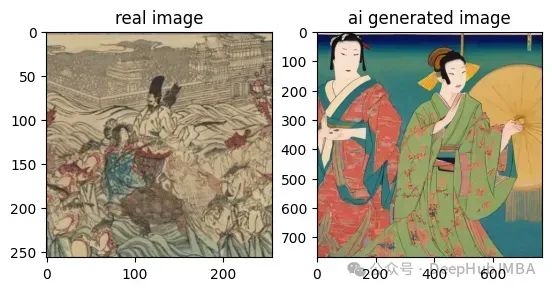

Zum besseren Verständnis vergleichen wir Bilder nebeneinander, echte Bilder und KI-generierte Bilder.

Diese beiden Bilder sind mit bloßem Auge auch sehr schwer zu erkennen, oder? Hochpassfilter, der Kontrast zwischen ihnen:

Aus diesen Ergebnissen können wir erkennen, dass die KI-generierten Bilder im Vergleich zu den realen Bildern reichhaltige Texturflecken und einen schlechten Kontrast aufweisen. Der Kontrast ist viel höher.

Auf diese Weise können wir den Unterschied mit bloßem Auge erkennen, sodass wir die Kontrastergebnisse in das trainierbare Modell einfügen und die Ergebnisdaten in den Klassifikator eingeben können:

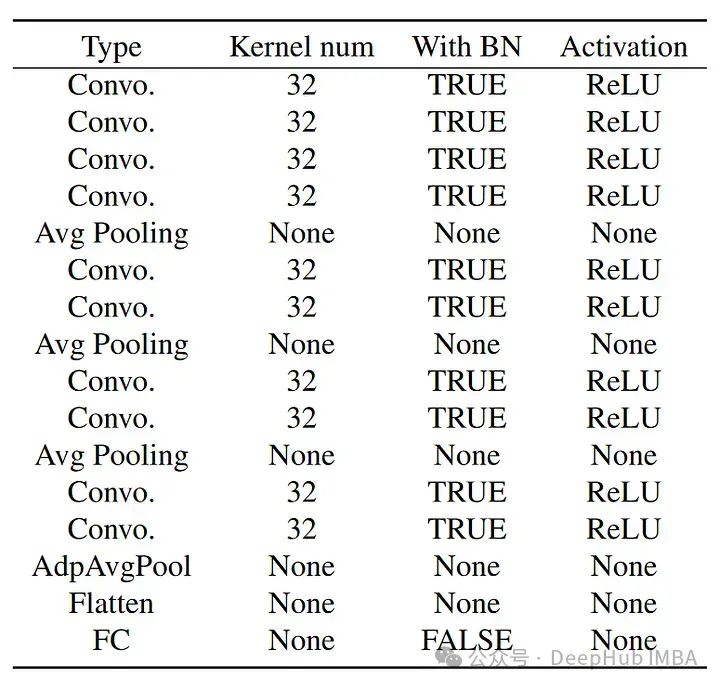

Die Struktur des Klassifikators ist wie folgt:

Die Struktur des Klassifikators ist wie folgt:

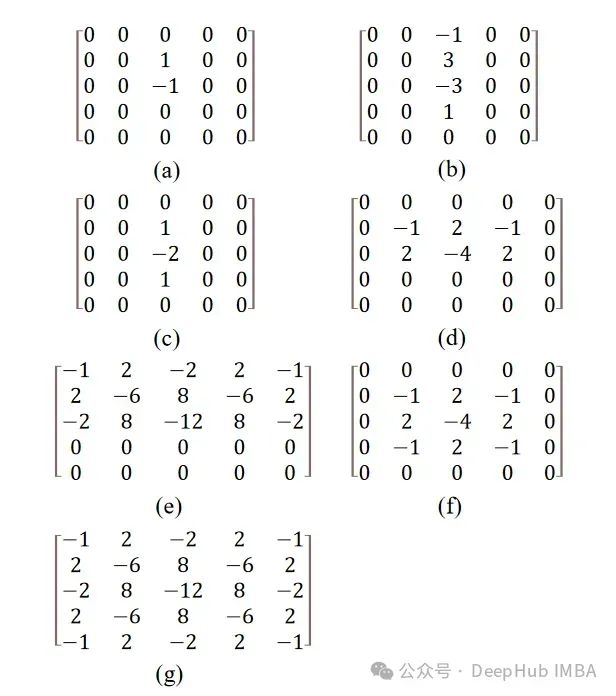

Das Papier erwähnt 30 Hochpassfilter, die ursprünglich für die Steganalyse eingeführt wurden.

Hinweis: Es gibt viele Möglichkeiten der Bildsteganografie. Im Großen und Ganzen kann man von Bildsteganographie sprechen, solange Informationen auf irgendeine Weise in einem Bild verborgen sind und mit herkömmlichen Methoden nur schwer zu entdecken sind. Interessierte können die relevanten Informationen überprüfen.

Hinweis: Es gibt viele Möglichkeiten der Bildsteganografie. Im Großen und Ganzen kann man von Bildsteganographie sprechen, solange Informationen auf irgendeine Weise in einem Bild verborgen sind und mit herkömmlichen Methoden nur schwer zu entdecken sind. Interessierte können die relevanten Informationen überprüfen.

Der Filter ist hier ein Matrixwert, der mithilfe einer Faltungsmethode auf das Bild angewendet wird. Der verwendete Filter ist ein Hochpassfilter, der nur die Hochfrequenzmerkmale des Bildes passieren lässt. Zu den Hochfrequenzmerkmalen gehören typischerweise Kanten, feine Details und schnelle Intensitäts- oder Farbänderungen.

Mit Ausnahme von (f) und (g) werden alle Filter um einen Winkel gedreht, bevor sie erneut auf das Bild angewendet werden, sodass insgesamt 30 Filter entstehen. Die Rotation dieser Matrizen erfolgt mithilfe affiner Transformationen, die mit SciPy durchgeführt werden.

Zusammenfassung

Die Ergebnisse der Arbeit haben eine Überprüfungsgenauigkeit von 92 % erreicht, und es heißt, dass man bessere Ergebnisse erzielt, wenn man mehr trainiert, und das habe ich auch festgestellt Den Schulungscode können Interessierte eingehend studieren:

Papier: https://arxiv.org/abs/2311.12397

Papier: https://arxiv.org/abs/2311.12397

Code: https://github.com/hridayK/Detection-of-AI-generated -Bilder

Das obige ist der detaillierte Inhalt vonErkennung von KI-generierten Bildern mithilfe der Texturkontrasterkennung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- So ordnen Sie 123456 Spalten in Excel automatisch an

- Der Zweck künstlicher Intelligenz besteht darin, Maschinen leistungsfähig zu machen

- Was sind die Anwendungsmerkmale der Technologie der künstlichen Intelligenz im Militär?

- Welche Speichermethoden und Elementanordnungsanforderungen gelten für Tabellen, die für die binäre Suche geeignet sind?

- Wie können Deep-Learning-Modelle mithilfe kleiner Datensätze verbessert werden?